圖像涂哪就動哪!Gen-2新功能“神筆馬良”爆火,網友:急急急

AI搞視頻生成,已經進化到這個程度了?!

對著一張照片隨手一刷,就能讓被選中的目標動起來!

明明是一輛靜止的卡車,一刷就跑了起來,連光影都完美還原:

原本只是一張火災照片,現在隨手一刷就能讓火焰直沖天際,熱度撲面而來:

這樣下去,哪還分得清照片和實拍視頻!

原來,這是Runway給AI視頻軟件Gen-2打造的新功能,一涂一刷就能讓圖像中的物體動起來,逼真程度不亞于神筆馬良。

雖然只是個功能預熱,不過效果一出就在網上爆火:

看得網友一個個變身急急國王,直呼“等不及想要嘗試一波”:

Runway同時還放出了更多功能預熱效果,一起來看看。

照片變視頻,指哪就動哪

這個Runway新出的功能,叫做運動筆刷(Motion Brush)。

顧名思義,只需要用這個筆刷對著畫面中的任意對象“涂”一下,就能讓他們動起來。

不僅可以是靜止的人,連裙擺和頭部的動作都很自然:

還可以是流動的液體如瀑布,連霧氣都能還原:

或者是一根還沒熄滅的煙:

一團正在眾人面前燃燒的篝火:

更大塊的背景也能做成動態的,甚至改變畫面的光影效果,例如正在飛速移動的烏云:

當然,上面這些都還是Runway“亮明牌”,主動告訴你他們對照片“做了手腳”。

下面這些沒有涂抹痕跡的視頻,更是幾乎完全看不出有AI修飾的成分在里面:

一連串效果炸出,也導致功能還沒正式放出來,網友已經迫不及待了。

不少人試圖理解這個功能究竟是怎么實現的。也有網友更關注功能啥時候出,希望到時候直接321上鏈接(手動狗頭)

確實可以期待一波了。

不過,不止是Runway推出的這個Motion Brush新功能。

最近一連串的AI生成進展似乎都在表明,視頻生成領域似乎真要迎來技術大爆發了。

AI生成視頻真要崛起了?

就像在這幾天,還有網友開發了很火的文生動畫軟件Animatediff的新玩法。

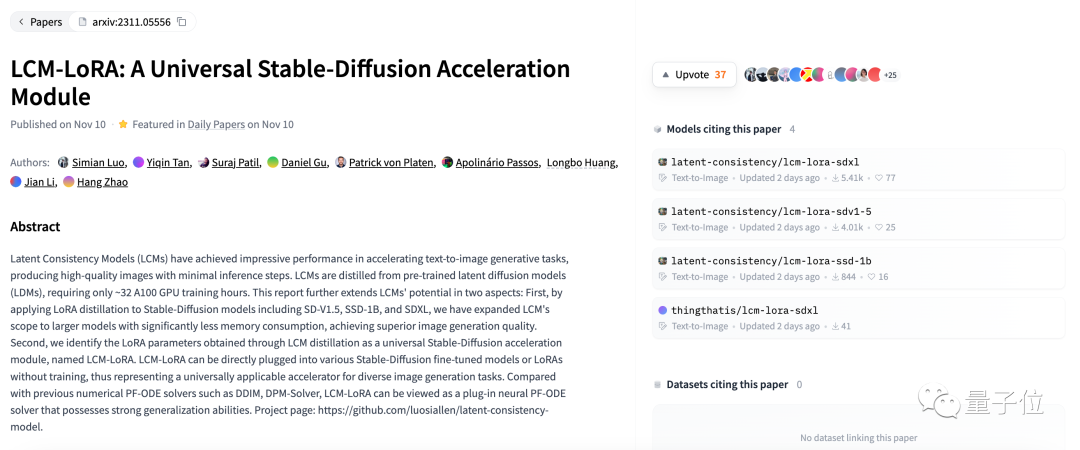

只需要結合最新的研究LCM-LORA,生成16幀的動畫視頻只需要7秒鐘的時間。

LCM-LORA是清華大學和Hugging Face新出的一個AI圖片生成技術,可以讓Stable Diffusion的圖片生成速度大幅提升。

其中,LCM(Latent Consistency Models)是基于今年早些時候OpenAI的“一致性模型”提出來的一種圖像生成新方法,能快速生成768×768的高分辨率圖片。

但LCM不兼容現有模型,因此清華和抱抱臉的成員又新出了一版LCM-LORA模型,可以兼容所有Stable Diffusion模型,加速出圖速度。

結合Animatediff軟件,生成一個這樣的動畫只需要7秒鐘左右:

目前LCM-LORA已經在抱抱臉上開源。

你感覺最近的AI視頻生成進展如何,距離可用上還有多遠?

參考鏈接:

[1]https://twitter.com/runwayml/status/1723033256067489937。

[2]https://twitter.com/op7418/status/1723016460220735748。