Sora是『神筆馬良』還是AI怪物?首篇綜述一探乾坤!

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

寫在前面&筆者的個人理解

Sora是一種文本到視頻生成的人工智能模型,由OpenAI于2024年2月發布。該模型經過訓練,能夠從文本指令中生成逼真或想象的場景視頻,并顯示出在模擬物理世界方面的潛力。基于公開的技術報告和逆向工程,本文對該模型的背景、相關技術、應用、尚存挑戰以及文本到視頻人工智能模型未來發展方向進行了全面審查。我們首先追溯了Sora的發展歷程,并調查了用于構建這個"世界模擬器"的基礎技術。然后,我們詳細描述了Sora在從電影制作、教育到營銷等多個行業中的應用和潛在影響。我們討論了需要解決的主要挑戰和限制,以廣泛部署Sora,例如確保視頻生成的安全和無偏見性。最后,我們討論了Sora和視頻生成模型的未來發展,以及該領域的進步如何可能促進人機交互的新方式,提升視頻生成的生產力和創造力。

相關介紹

自從ChatGPT于2022年11月發布以來,AI技術的出現標志著一個重大的轉變,深入融合到日常生活和行業的各個方面。借助這一勢頭,OpenAI于2024年2月發布了Sora,這是一個文本到視頻生成的AI模型,可以根據文本提示生成逼真或富有想象力的場景視頻。與先前的視頻生成模型相比,Sora的特點在于其能夠在保持對用戶文本指令的遵循的同時生成長達1分鐘的高質量視頻。Sora的這一進步體現了長期以來AI研究的使命,即賦予AI系統(或AI代理)理解和與動態物理世界交互的能力。這涉及開發既能夠解釋復雜用戶指令又能夠將這種理解應用于通過動態和具有豐富上下文的模擬解決現實問題的AI模型。

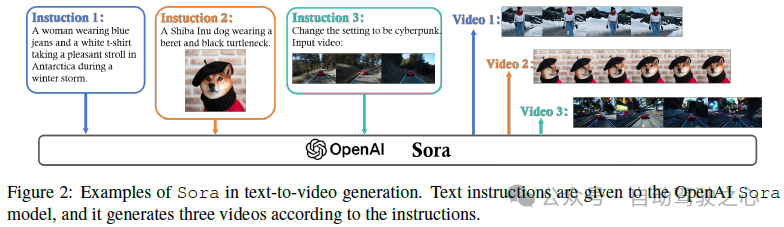

Sora展示了準確解釋和執行復雜人類指令的卓越能力,如圖2所示。該模型可以生成包含多個角色在錯綜復雜的背景中執行特定動作的詳細場景。研究人員將Sora的熟練歸因于其不僅處理用戶生成的文本提示,還辨別了情景中各個元素的復雜相互作用。Sora最引人注目的一個方面之一是其能夠生成長達一分鐘的視頻,同時保持高視覺質量和引人入勝的視覺連貫性。與以前只能生成短視頻剪輯的模型不同,Sora的一分鐘視頻創作具有從第一幀到最后一幀的連貫性和視覺一致性的進展。此外,Sora的進步體現在其能夠生成具有動態和交互細微描繪的擴展視頻序列上,克服了先前視頻生成模型的短片和簡單視覺呈現的限制。這一能力代表了AI驅動的創意工具的一大進步,允許用戶將文本敘述轉換為豐富的視覺故事。總的來說,這些進步展示了Sora作為一個世界模擬器在提供所描繪場景的物理和上下文動態的細微洞見方面的潛力。

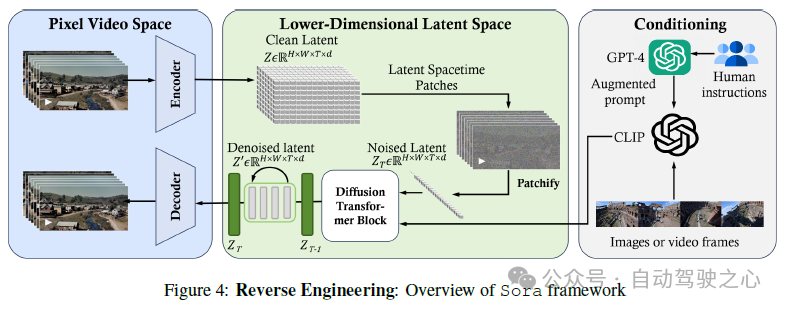

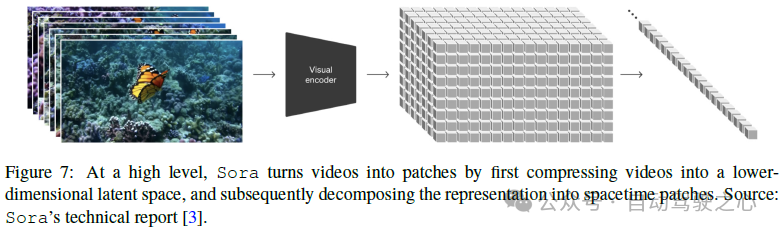

技術:Sora的核心是一個預訓練的擴散Transformer。Transformer模型已被證明在許多自然語言任務中具有可伸縮性和有效性。與諸如GPT-4等強大的大型語言模型(LLMs)相似,Sora可以解析文本并理解復雜的用戶指令。為了使視頻生成在計算上更有效,Sora采用時空潛在補丁作為其構建模塊。具體而言,Sora將原始輸入視頻壓縮成潛在時空表示。然后,從壓縮視頻中提取一系列潛在時空補丁,以概括短暫時間內的視覺外觀和運動動態。這些補丁類似于語言模型中的詞標記,為Sora提供了詳細的視覺短語,用于構建視頻。Sora的文本到視頻生成是通過擴散Transformer模型執行的。從一個充滿視覺噪聲的幀開始,模型迭代地去噪圖像,并根據提供的文本提示引入特定的細節。本質上,生成的視頻通過一個多步細化過程逐步呈現,每一步都使視頻更加與所需內容和質量保持一致。

Sora的亮點:Sora的能力在各個方面都具有深遠的影響:

- 提高模擬能力:訓練Sora的規模被歸因于其模擬物理世界各個方面的卓越能力。盡管缺乏顯式的3D建模,但Sora表現出具有動態攝像機運動和長距離連貫性的3D一致性,其中包括對象持續存在并模擬與世界的簡單交互。此外,Sora有趣地模擬數字環境,如Minecraft,由基本策略控制,同時保持視覺保真度。這些新出現的能力表明,擴展視頻模型在創建模擬物理和數字世界的AI模型方面是有效的。

- 提升創造力:想象通過文本勾勒一個概念,無論是簡單的對象還是完整的場景,并在幾秒鐘內看到一個逼真或高度風格化的視頻。Sora為更快的探索和完善想法提供了加速的設計過程,從而顯著提升了藝術家、電影制片人和設計師的創造力。

- 推動教育創新:視覺輔助長期以來一直是理解教育中重要概念的核心。有了Sora,教育者可以輕松地將課程計劃從文本轉換為視頻,以吸引學生的注意力并提高學習效率。從科學模擬到歷史戲劇化,可能性是無限的。

- 提升可訪問性:在視覺領域提高可訪問性至關重要。Sora通過將文本描述轉換為視覺內容提供了創新的解決方案。這種能力使所有個體,包括視覺障礙者,在內容創作和與他人更有效地互動方面能夠積極參與。因此,它為一個更具包容性的環境提供了可能,每個人都有機會通過視頻表達自己的想法。

- 促進新興應用:Sora的應用是廣泛的。例如,營銷人員可以使用它創建針對特定受眾描述的動態廣告。游戲開發人員可以使用它從玩家敘述中生成定制的視覺或甚至角色動作。

局限性和機會。雖然Sora的成就突顯了AI領域的重大進步,但仍存在挑戰。描繪復雜動作或捕捉微妙面部表情是模型可以改進的領域之一。此外,諸如減輕生成內容中的偏見和防止有害視覺輸出等道德考慮強調了開發者、研究人員和更廣泛社區負責任使用的重要性。確保Sora的輸出始終安全和公正是一項主要挑戰。視頻生成領域正在迅速發展,學術界和工業研究團隊正在不懈地取得進展。競爭性文本到視頻模型的出現表明,Sora很快可能成為一個動態生態系統的一部分。這種合作和競爭的環境促進了創新,導致了視頻質量的提高和新的應用,有助于提高工作者的生產力,并使人們的生活更加有趣。

基于已發布的技術報告和我們的逆向工程,本文介紹了Sora背后的首次全面審查,涉及相關技術、新興應用、當前局限性和未來機會。

關于Sora的背景

歷史回顧

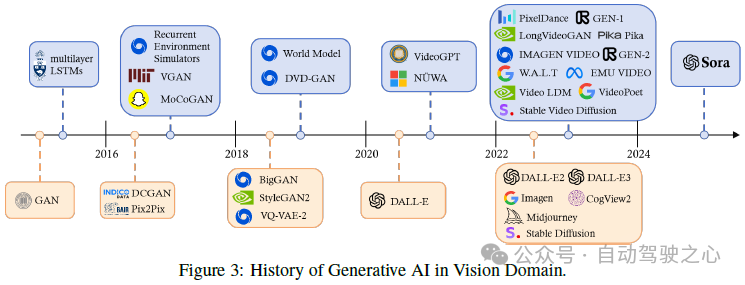

在計算機視覺(CV)領域,在深度學習革命之前,傳統的圖像生成技術依賴于諸如紋理合成和紋理映射等基于手工制作特征的方法。然而,這些方法在生成復雜和生動圖像的能力方面受到了限制。生成對抗網絡(GANs)和變分自動編碼器(VAEs)的引入標志著一個重大的轉折點,因為它們在各種應用中展現了顯著的能力。隨后的發展,如流模型和擴散模型,進一步增強了圖像生成的細節和質量。人工智能生成內容(AIGC)技術的最新進展使內容創作民主化,使用戶能夠通過簡單的文本指令生成所需的內容。

在過去的十年里,生成CV模型的發展已經采取了各種路線,如圖3所示。這個景觀在成功將Transformer架構應用于NLP中后開始顯著變化,如BERT和GPT所示。在CV中,研究人員進一步將這一概念發展,將Transformer架構與視覺組件結合起來,使其能夠應用于下游CV任務,如Vision Transformer(ViT)和Swin Transformer。與Transformer的成功并行的是,擴散模型在圖像和視頻生成領域也取得了顯著進展。擴散模型提供了一個數學上合理的框架,用于將噪聲轉換為帶有U-Nets的圖像,其中U-Nets通過學習在每個步驟預測和減輕噪聲來促進這一過程。

自2021年以來,人工智能的一個重要焦點是能夠解釋人類指令的生成語言和視覺模型,即多模型。例如,CLIP 是一種開創性的視覺語言模型,它將Transformer架構與視覺元素結合起來,促進了它在大量文本和圖像數據集上的訓練。通過從一開始就整合視覺和語言知識,CLIP可以在多模式生成框架內作為圖像編碼器運行。另一個值得注意的例子是Stable Diffusion,這是一種通用的文本到圖像AI模型,因其適應性和易用性而備受贊譽。它采用Transformer架構和潛在擴散技術來解碼文本輸入并生成各種風格的圖像,進一步說明了多模式AI的進步。

在2022年11月發布ChatGPT后,我們見證了2023年商業文本到圖像產品的出現,如Stable Diffusion,Midjourney,DALL-E 3。這些工具使用戶能夠通過簡單的文本提示生成高分辨率和高質量的新圖像,展示了AI在創造性圖像生成方面的潛力。然而,從文本到視頻的過渡在于視頻的時間復雜性而具有挑戰性。盡管工業界和學術界做出了大量努力,但大多數現有的視頻生成工具,如Pika和Gen-2,僅限于生成幾秒鐘的短視頻片段。在這種情況下,Sora代表了一個重大突破,類似于ChatGPT在NLP領域的影響。Sora是第一個能夠根據人類指令生成長達一分鐘的視頻的模型,標志著生成AI研究和發展中的一個里程碑。為了便于獲取最新的視覺生成模型的最新進展,最近的研究成果已經編譯并提供在附錄和我們的GitHub中。

概念解釋

視覺模型的規模定律。隨著LLMs的規模定律,自然會問視覺模型的發展是否遵循類似的規模定律。最近,翟等人表明,對于足夠的訓練數據,ViT模型的性能-計算邊界大致遵循(飽和)冪律。緊隨其后,谷歌研究提出了一種高效穩定地訓練22B參數ViT的方法。結果表明,可以使用凍結模型生成嵌入,并在其上訓練薄層以獲得良好的性能。作為一個大型視覺模型(LVM),Sora符合這些規模定律,揭示了文本到視頻生成中的幾個新能力。這一重大進展突顯了LVMs實現LLMs類似進展的潛力。

新興能力。LLMs中的新興能力是在某些尺度上表現出的復雜行為或功能------通常與模型參數的大小相關------這些能力并不是由其開發人員明確編程或預期的。這些能力被稱為"新興",因為它們源于模型在各種數據集上的

全面訓練,加上其大量的參數數量。這種組合使得模型能夠建立連接和進行推理,超越了簡單的模式識別或死記硬背。通常情況下,這些能力的出現不能通過從較小規模模型的性能推斷來直接預測。雖然許多LLMs,如Chat-GPT和GPT-4,都表現出了新興能力,但在Sora出現之前,展示出可比較能力的視覺模型卻很少。根據Sora的技術報告,它是第一個展示出確認的新興能力的視覺模型,標志著計算機視覺領域的一個重大里程碑。

除了其新興能力外,Sora還表現出其他顯著的能力,包括指令遵循、視覺提示工程和視頻理解。Sora功能的這些方面代表了視覺領域的重大進步,將在接下來的部分中探討和討論。

詳解SoRA技術

概述

從核心本質上講,Sora 是一個具有靈活采樣維度的擴散Transformer,如圖 4 所示。它分為三個部分:(1) 一個時間-空間壓縮器首先將原始視頻映射到潛在空間中。(2) 然后,一個 ViT 處理標記化的潛在表示,并輸出去噪的潛在表示。(3) 一個類似于 CLIP 的條件機制接收 LLM 增強的用戶指令和潛在的視覺提示,以指導擴散模型生成風格化或主題化的視頻。經過許多去噪步驟,生成視頻的潛在表示被獲取,然后與相應的解碼器映射回像素空間。

在本節中,我們旨在逆向工程 Sora 使用的技術,并討論一系列相關工作。

數據預處理

可變持續時間、分辨率、長寬比

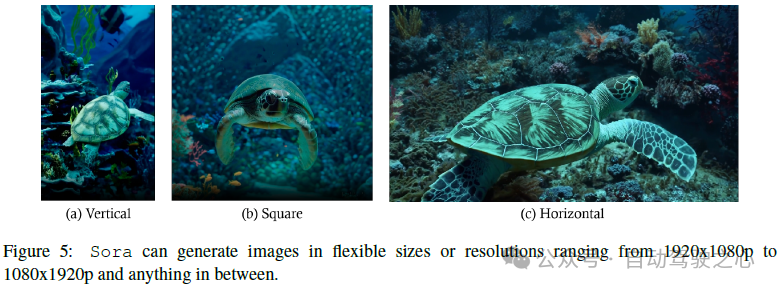

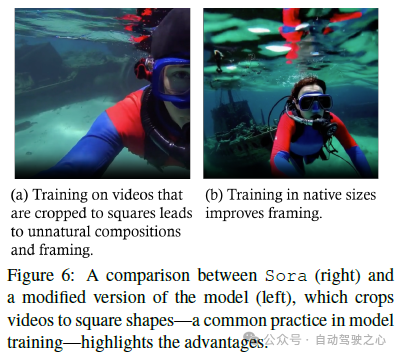

Sora 的一個顯著特點是其能夠訓練、理解和生成視頻和圖像,并以它們的原生尺寸,如圖 5 所示。傳統方法通常會調整視頻的大小、裁剪或調整長寬比以適應統一的標準------通常是具有固定低分辨率的正方形幀的短片。這些樣本通常是以更寬的時間步幅生成的,并依賴于分別訓練的幀插入和分辨率渲染模型作為最后一步,從而在視頻中產生不一致性。利用擴散Transformer架構(見第 3.2.4 節),Sora 是第一個接受視覺數據多樣性并且能夠在各種視頻和圖像格式中采樣的模型,范圍從寬屏 1920x1080p 視頻到豎屏 1080x1920p 視頻,以及所有介于兩者之間的內容,而不會損害其原始尺寸。

在其原生尺寸的數據上進行訓練顯著提高了生成視頻的構圖和構圖在生成的視頻中表現出更自然和連貫的視覺敘事。通過保持原始長寬比,Sora 實現了更自然和連貫的視覺敘事。如圖 6 所示,Sora 和模型在統一裁剪的正方形視頻上訓練的比較清楚地表明了其優勢。由 Sora 生成的視頻呈現出更好的構圖,確保主題完全出現在場景中,而不是由于正方形裁剪而導致有時截斷的視圖。

對原始視頻和圖像特征的這種微妙理解和保留標記了生成模型領域的一項重大進步。Sora 的方法不僅展示了更真實和吸引人的視頻生成的潛力,還突顯了訓練數據多樣性對于在生成 AI 中獲得高質量結果的重要性。Sora 的訓練方法與 Richard Sutton 的"苦澀教訓" 的核心理念一致,即利用計算能力而不是人類設計的特征可以實現更有效和靈活的 AI 系統。就像擴散Transformer的原始設計追求簡單和可擴展性一樣,Sora 在原始尺寸上訓練數據的策略放棄了傳統的 AI 對人類衍生抽象的依賴,而是更傾向于一種隨著計算能力擴展的通用方法。在本節的其余部分,我們嘗試逆向工程 Sora 的架構設計,并討論相關技術來實現這一令人驚嘆的功能。

統一的視覺表示

為了有效處理包括持續時間、分辨率和長寬比在內的各種形式的視覺輸入,特別是Transformer令牌的后處理和輸出去噪的潛在表示。一個類似于 CLIP 的條件機制接收經過 LLM 增強的用戶指令和潛在的視覺提示,以指導擴散模型生成風格化或主題化的視頻。經過許多去噪步驟,生成視頻的潛在表示被獲取,然后與相應的解碼器映射回像素空間。在本節中,我們旨在逆向工程 Sora 使用的技術,并討論一系列相關工作。

視頻壓縮網絡

Sora 的視頻壓縮網絡(或視覺編碼器)旨在減少輸入數據的維度,特別是原始視頻,并輸出一個壓縮的潛在表示,該表示在時間和空間上都被壓縮,如圖 7 所示。根據技術報告中的參考文獻,壓縮網絡建立在 VAE 或向量量化-VAE(VQ-VAE)上。然而,如果不使用調整大小和裁剪,VAE 將難以將任何大小的視覺數據映射到統一且固定大小的潛在空間中。我們總結了兩種不同的實現來解決這個問題:

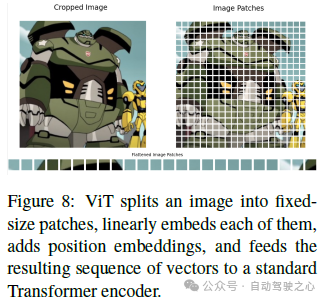

空間補丁壓縮。這涉及將視頻幀轉換為固定大小的補丁,類似于 ViT 和 MAE 中采用的方法(見圖 8),然后將它們編碼為潛在空間。這種方法對于容納各種分辨率和長寬比的視頻尤其有效,因為它通過處理單個補丁來編碼整個幀。隨后,這些空間令牌被組織成一個時空順序,以創建一個空間-時間潛在表示。這種技術突出了幾個關鍵考慮因素:

時間維度的可變性------鑒于訓練視頻的持續時間不同,潛在空間表示的時間維度不能固定。為了解決這個問題,可以采樣特定數量的幀(對于更短的視頻可能需要填充或時間插值),或者定義一個通用擴展(超長)的輸入長度以進行后續處理;利用預訓練的視覺編碼器------為了處理高分辨率視頻,大多數研究人員都建議利用現有的預訓練的視覺編碼器,例如來自 Stable Diffusion 的 VAE 編碼器,而 Sora 的團隊則預計通過訓練自己的壓縮網絡(視頻生成器)來獲得一個解碼器(視頻生成器)(通過訓練潛在擴散模型的方式)。這些編碼器可以高效地壓縮大尺寸的補丁(例如 256 × 256),便于管理大規模數據;時間信息聚合------由于這種方法主要側重于空間補丁壓縮,因此需要一種額外的機制來聚合模型內的時間信息。這一方面對于捕捉隨時間動態變化至關重要,并且在后續章節中進行了進一步的闡述。

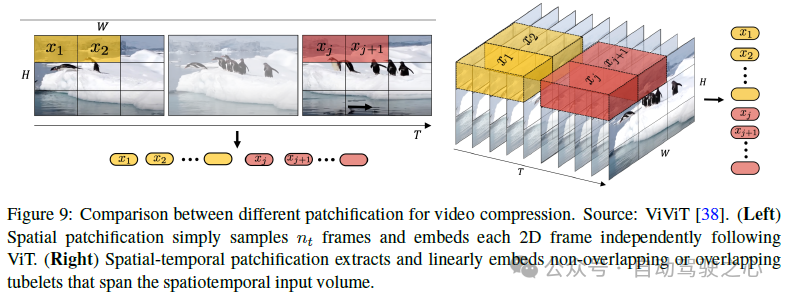

空間-時間補丁壓縮。這種技術旨在封裝視頻數據的空間和時間維度,提供全面的表示。這種技術不僅僅分析靜態幀,還考慮了幀間的運動和變化,從而捕捉視頻的動態方面。采用 3D 卷積出現為實現這種集成的一種直接而有效的方法。圖形說明和與純空間-補丁化的比較如圖 9 所示。與空間補丁壓縮類似,采用帶有預定卷積核參數的空間-時間補丁壓縮------例如固定的核大小、步幅和輸出通道------由于視頻輸入的特征不同而導致潛在空間維度的變化。這種變化主要受到正在處理的視頻的不同持續時間和分辨率的影響。為了緩解這一挑戰,采用的空間補丁化方法在這種情況下同樣適用且有效。

總而言之,我們根據 VAE 或其變體(如 VQ-VQE)對兩種補丁級壓縮方法進行了逆向工程,因為對補丁的操作更靈活,能夠處理不同類型的視頻。由于 Sora 的目標是生成高保真度的視頻,因此采用了較大的補丁大小或核大小以進行高效壓縮。在這里,我們期望使用固定大小的補丁以簡化、擴展和訓練穩定性。但也可以使用不同大小的補丁使潛在空間中的整體幀或視頻的維度保持一致。然而,這可能會導致無效的位置編碼,并且對于生成具有不同大小潛在補丁的視頻,會帶來挑戰。

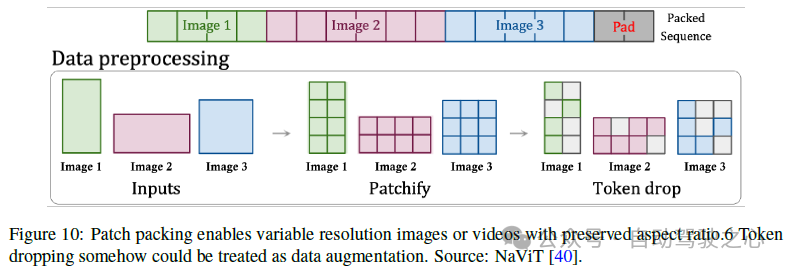

時空潛在補丁

在壓縮網絡部分仍存在一個關鍵問題:如何處理潛在空間維度的可變性(即來自不同視頻類型的潛在特征塊或補丁的數量),然后將這些補丁饋送到擴散Transformer的輸入層。在這里,我們討論了幾種解決方案。基于 Sora 的技術報告和相應的參考文獻,patch n' pack(PNP)可能是解決方案。PNP 將來自不同圖像的多個補丁打包到單個序列中,如圖 10 所示。這種方法受自然語言處理中使用的示例打包的啟發,通過丟棄標記來有效地訓練變長輸入。在這里,補丁化和標記嵌入步驟需要在壓縮網絡中完成,但 Sora 可能會進一步將潛在補丁化為Transformer標記,如擴散Transformer所做的。無論是否有第二輪的補丁化,我們都需要解決兩個問題,即如何以緊湊的方式打包這些標記以及如何控制哪些標記應該被丟棄。對于第一個問題,采用簡單的貪婪方法,該方法將示例添加到具有足夠剩余空間的第一個序列中。一旦沒有更多的示例可以適合,序列將用填充標記填充,產生需要進行批處理操作的固定序列長度。這樣簡單的打包算法可能會導致重大的填充,這取決于輸入長度的分布。另一方面,我們可以通過調整序列長度和限制填充來控制我們采樣的分辨率和幀數以確保有效的打包。對于第二個問題,一種直觀的方法是丟棄相似的標記或者像 PNP 一樣應用丟棄率調度器。然而,值得注意的是,時空一致性是 Sora 的一個很好的特性之一。丟棄標記可能會在訓練過程中忽略細粒度的細節。因此,我們相信 OpenAI 可能會使用一個超長的上下文窗口并將所有來自視頻的標記打包在一起,盡管這樣做是計算昂貴的,例如,多頭注意力操作符在序列長度方面表現出二次成本。具體來說,來自長時間視頻的時空潛在補丁可以打包在一個序列中,而來自幾個短時間視頻的補丁則連接在另一個序列中。

討論

我們討論了 Sora 可能使用的兩種數據預處理的技術解決方案。由于其靈活性和可擴展性的特點,在補丁級別執行這兩種解決方案。與先前的方法不同,先前的方法將視頻調整大小、裁剪或修剪到標準尺寸,Sora 在其原生尺寸上對數據進行訓練。盡管有幾個好處(詳見第 3.2.1 節中的詳細分析),但它帶來了一些技術挑戰,其中最重要的之一是神經網絡本質上無法處理可變持續時間、分辨率和長寬比的視覺數據。通過逆向工程,我們相信 Sora 首先將視覺補丁壓縮為低維潛在表示,并將這些潛在補丁或進一步的補丁化的潛在補丁排列成一個序列,然后在將其饋送到擴散Transformer的輸入層之前注入噪聲。Sora 采用空間-時間補丁化是因為它易于實現,并且可以通過具有高信息密度的令牌有效地減少上下文長度并降低后續建模的復雜性。對于研究界,我們建議使用成本效率更高的替代方案進行視頻壓縮和表示,包括利用預訓練檢查點(例如,壓縮網絡),縮短上下文窗口,使用輕量級建模機制(例如(分組)多查詢注意力)或高效架構(例如 Mamba),對數據進行降采樣并在必要時丟棄標記。在視頻建模的效果和效率之間的權衡是一個重要的研究課題。

建模

擴散Transformer

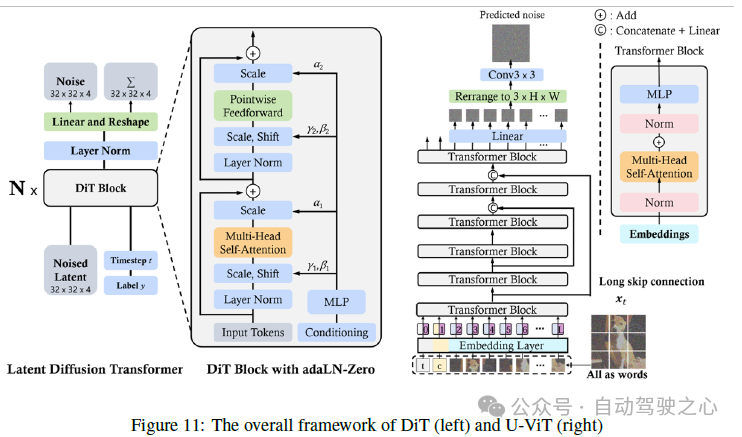

圖像擴散Transformer。傳統的擴散模型主要利用卷積 U-Net,該 U-Net 包括用于去噪網絡骨干的下采樣和上采樣塊。然而,最近的研究表明,U-Net 架構對擴散模型的良好性能并不關鍵。通過結合更靈活的Transformer架構,基于Transformer的擴散模型可以使用更多的訓練數據和更大的模型參數。沿著這條線,DiT 和 U-ViT 是首批采用視覺Transformer進行潛在擴散模型的作品之一。與 ViT 一樣,DiT 使用多頭自注意層和一個與一些層規范和縮放層交織的逐點前饋網絡。此外,如圖 11 所示,DiT 通過自適應層規范 (AdaLN) 來融合條件,其中還有一個額外的 MLP 層用于零初始化,它將每個殘差塊初始化為一個恒等函數,從而極大地穩定了訓練過程。DiT 的可擴展性和靈活性經過了經驗驗證。DiT 成為擴散模型的新骨干。在 U-ViT 中,如圖 11 所示,他們將所有輸入(包括時間、條件和嘈雜的圖像塊)都視為標記,并提出了淺層和深層Transformer層之間的長跳連線。結果表明,在基于 CNN 的 U-Net 中,下采樣和上采樣操作并不總是必要的,而 U-ViT 在圖像和文本到圖像生成中實現了創紀錄的 FID 分數。

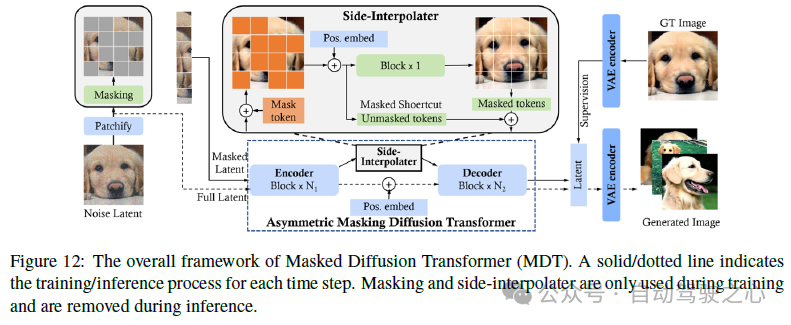

與掩碼自編碼器 (MAE)類似,掩碼擴散Transformer (MDT)將掩碼潛在建模整合到擴散過程中,以明確增強圖像合成中對象語義部分之間的上下文關系學習。具體而言,如圖 12 所示,MDT 在訓練期間使用側插值來進行額外的掩碼標記重構任務,以增強訓練效率,并為推理學習強大的上下文感知位置嵌入。與 DiT相比,MDT 實現了更好的性能和更快的學習速度。哈塔米扎德等人引入了擴散視覺Transformer (DiffiT),用于時序條件建模,而不是使用 AdaLN (即移位和縮放)。DiffiT 使用定時依賴自注意 (TMSA) 模塊來模擬在采樣時間步驟上的動態去噪行為。此外,DiffiT 分別在像素空間和潛在空間中使用了兩種混合分層體系結構進行高效去噪,并在各種生成任務中實現了新的最先進結果。總的來說,這些研究展示了采用視覺Transformer進行圖像潛在擴散的良好結果,為其他模態的未來研究鋪平了道路。

視頻擴散Transformer。在文本到圖像 (T2I) 擴散模型的基礎研究上,最近的研究集中于實現擴散Transformer在文本到視頻 (T2V) 生成任務中的潛力。由于視頻的時間性質,將 DiTs 應用于視頻領域的關鍵挑戰是:i) 如何將視頻在空間上和時間上壓縮到潛在空間以進行有效去噪;ii) 如何將壓縮的潛在空間轉換為塊并將其饋送到Transformer;以及 iii) 如何處理長期時間和空間依賴性,并確保內容的一致性。在本節中,我們將重點討論基于Transformer的去噪網絡架構,該架構設計用于在空間和時間上壓縮的潛在空間中運行。我們對 OpenAI Sora 技術報告參考列表中描述的兩項重要工作(Imagen Video和 Video LDM)進行了詳細審查。

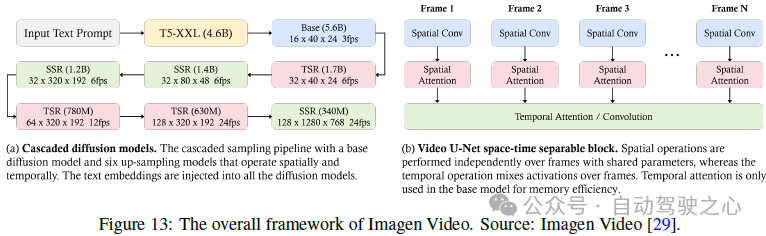

Imagen Video是谷歌研究開發的文本到視頻生成系統,它利用一系列擴散模型,包括 7 個子模型,執行文本條件視頻生成、空間超分辨率和時間超分辨率,將文本提示轉換為高清視頻。如圖 13 所示,首先,一個凍結的 T5 文本編碼器從輸入文本提示生成上下文嵌入。這些嵌入對于將生成的視頻與文本提示對齊至關重要,并且除了基礎模型之外,它們被注入到級聯的所有模型中。隨后,嵌入被饋送到基礎模型進行低分辨率視頻生成,然后通過級聯擴散模型進行細化以增加分辨率。基礎視頻和超分辨率模型以時空可分離的方式使用 3D U-Net 架構。

時間注意力和卷積層與空間對應層相結合,以有效捕獲幀間依賴關系。它使用 v-預測參數化來實現數值穩定性,并使用條件增強來促進跨模型的并行訓練。該過程涉及對圖像和視頻的聯合訓練,將每個圖像視為一幀以利用更大的數據集,并使用無分類器指導來增強提示的保真度。漸進蒸餾被應用于簡化采樣過程,顯著降低了計算負載,同時保持了感知質量。將這些方法和技術結合起來,使 Imagen Video 能夠生成不僅保真度高,而且可控性 remarkable 的視頻,如其產生多樣的視頻、文本動畫和各種藝術風格的內容所示。

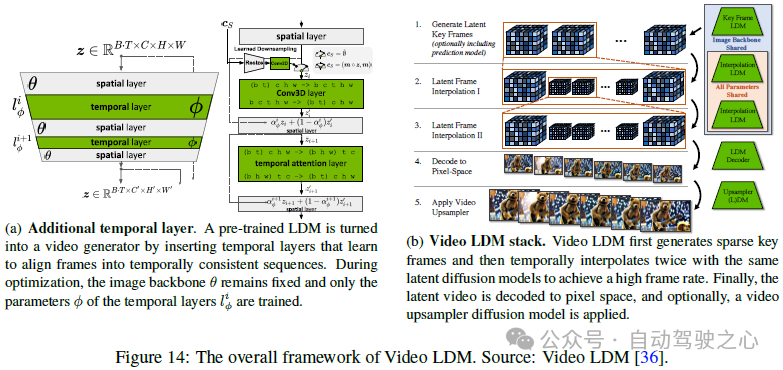

Blattmann 等人提出將 2D 潛在擴散模型轉變為視頻潛在擴散模型 (Video LDM)。他們通過在現有的空間層之間添加一些事后時間層,將編碼器和 VAE 解碼器中的現有空間層轉換為視頻 LDM。這些時間層在編碼的視頻數據上進行訓練,而空間層保持不變,使模型能夠利用大型圖像數據集進行預訓練。LDM 的解碼器被微調以在像素空間中保持時間一致性,并將擴散模型的上采樣器在增強空間分辨率方面進行時間對齊。為了生成非常長的視頻,模型被訓練以在給定一定數量的上下文幀的情況下預測未來幀,從而允許在采樣過程中無分類器指導。為了實現高時間分辨率,視頻合成過程被分為關鍵幀生成和這些關鍵幀之間的插值。在級聯的 LDM 之后,通過使用 DM 進一步將 Video LDM 的輸出擴大 4 倍,從而確保了高空間分辨率同時保持時間一致性。這種方法以高效的方式實現了生成全局一致的長視頻。此外,作者展示了將預訓練的圖像 LDMs(例如,穩定擴散)轉換為文本到視頻模型的能力,方法是僅訓練時間對齊層,實現了分辨率高達 1280 × 2048 的視頻合成。

討論

用于空間和時間上采樣的級聯擴散模型。Sora 能夠生成高分辨率視頻。通過審查現有作品和我們的逆向工程,我們推測 Sora 也利用了級聯擴散模型架構,它由一個基礎模型和許多時空精煉器模型組成。鑒于在高分辨率情況下使用注意力機制的高計算成本和有限的性能提升,基礎擴散模型和低分辨率擴散模型中不太可能大量使用注意力模塊。對于空間和時間場景一致性,由于先前的作品表明,對于視頻/場景生成,時間一致性比空間一致性更重要,因此 Sora 可能利用一種有效的訓練策略,即使用更長的視頻(用于時間一致性)以及更低的分辨率。此外,考慮到 v-參數化擴散模型相對于預測原始潛在變量 x 或噪聲 ? 的其他變體具有更優越的性能,Sora 可能使用 v-參數化擴散模型。

關于潛在編碼器。為了訓練效率,大多數現有作品利用穩定擴散的預訓練 VAE 編碼器作為初始化模型檢查點。然而,編碼器缺乏時間壓縮能力。即使一些作品提出僅微調解碼器以處理時間信息,但在壓縮潛在空間中處理視頻時間數據的解碼器性能仍然不夠優化。根據技術報告,我們的逆向工程顯示,與使用現有的預訓練 VAE 編碼器不同,Sora 可能使用從頭開始在視頻數據上訓練的時空 VAE 編碼器,這種編碼器在視頻導向的壓縮潛在空間方面表現更好。

語言指令跟隨

用戶主要通過自然語言指令與生成式人工智能模型互動,這些指令被稱為文本提示。模型指令調整旨在增強人工智能模型準確跟隨指令的能力。這種改進的提示跟隨能力使模型生成的輸出更接近人類對自然語言查詢的響應。我們從對大型語言模型(LLMs)和文本到圖像模型(如 DALL·E 3)的指令跟隨技術的回顧開始討論。為了增強文本到視頻模型跟隨文本指令的能力,Sora 采用了與 DALLE3 類似的方法。該方法涉及訓練一個描述性字幕生成器,并利用字幕生成器生成的數據進行微調。由于指令調整,Sora 能夠滿足各種用戶請求,確保對指令中的細節進行細致注意,并生成精確滿足用戶需求的視頻。

大型語言模型

對于LLMs的跟隨指令的能力已經得到了廣泛探討。這種能力使LLMs能夠閱讀、理解和適當地響應描述一個未見任務的指令,而無需示例。通過在格式化為指令的任務的混合上對LLMs進行微調,即所謂的指令調整,獲得和增強了提示跟隨能力。Wei 等人表明,經過指令調整的LLMs在未見任務上顯著優于未調整的LLMs。跟隨指令的能力將LLMs轉化為通用任務求解器,標志著人工智能發展史上的一次范式轉變。

文本到圖像

在DALL·E 3中,通過一種假設來解決指令跟隨問題,即模型訓練中的文本-圖像對質量決定了結果文本到圖像模型的性能。數據質量不佳,特別是嘈雜數據和短字幕的普遍存在,這導致了許多問題,如忽略關鍵字和詞序,并且誤解用戶意圖。通過重新為現有圖像制作詳細的、描述性的字幕來解決這些問題。該方法首先訓練一個圖像字幕生成器,即視覺語言模型,以生成精確和描述性的圖像字幕。然后,通過這些由字幕生成器生成的描述性圖像字幕對文本到圖像模型進行微調。具體來說,DALL·E 3遵循對比字幕生成器(CoCa),以共同訓練一個圖像字幕生成器與CLIP架構和語言模型目標。這個圖像字幕生成器包括一個圖像編碼器,一個用于提取語言信息的單模文本編碼器,和一個多模文本解碼器。它首先在單模圖像和文本嵌入之間使用對比損失,然后在多模解碼器的輸出上使用字幕損失。通過這一步,圖像字幕生成器能夠為圖像生成詳細的描述性字幕。文本到圖像模型的訓練數據集是由圖像字幕生成器生成的重新字幕數據集和地面真實人類編寫數據的混合,以確保模型捕獲用戶輸入。這種圖像字幕改進方法引入了一個潛在的問題:實際用戶提示與訓練數據中描述性圖像描述之間的不匹配。DALL·E 3通過上采樣來解決這個問題,即LLMs用于將短用戶提示重新撰寫成詳細和冗長的說明。這樣可以確保推理時模型接收到的文本輸入與模型訓練中的輸入一致。

文本到視頻

為了增強指令跟隨的能力,Sora采用了類似的字幕改進方法。首先通過訓練一個能夠為視頻生成詳細描述的視頻字幕生成器來實現此方法。然后,將此視頻字幕生成器應用于訓練數據中的所有視頻,以生成高質量的(視頻,描述性字幕)對,這些對用于微調Sora以提高其指令跟隨能力。Sora 的技術報告沒有透露視頻字幕生成器是如何訓練的細節。鑒于視頻字幕生成器是一個視頻到文本模型,有許多構建方法。一種直接的方法是利用 CoCa 架構進行視頻字幕生成,通過將視頻的多幀輸入到圖像編碼器,即 VideoCoCa。VideoCoCa 在 CoCa 的基礎上構建,并重新使用圖像編碼器預訓練權重,并獨立地應用于采樣視頻幀。結果幀令牌嵌入被展平并連接成視頻表示的長序列。然后,這些展平的幀令牌由生成池和對比池處理,它們與對比損失和字幕損失一起進行聯合訓練。構建視頻字幕生成器的其他替代方法包括 mPLUG-2、GIT、FrozenBiLM等。最后,為了確保用戶提示與訓練數據中的描述性字幕格式相一致,Sora 執行了額外的提示擴展步驟,其中 GPT-4V 用于將用戶輸入擴展到詳細的描述性提示。

討論

對于 Sora 來說,遵循指令的能力對于生成符合用戶意圖的復雜場景的一分鐘長視頻至關重要。根據 Sora 的技術報告,這種能力是通過開發一個能夠生成長而詳細的字幕的字幕生成器來獲得的,然后用于訓練模型。然而,收集用于訓練這樣一個字幕生成器的數據的過程是未知的,并且可能是耗時的,因為它可能需要視頻的詳細描述。此外,描述性視頻字幕生成器可能會產生視頻的重要細節幻覺。我們認為,如何改進視頻字幕生成器值得進一步研究,并且對于增強文本到圖像模型的指令跟隨能力至關重要。

提示工程

提示工程是指設計和完善輸入給人工智能系統的過程,特別是在生成模型的背景下,以實現特定或優化的輸出。提示工程的藝術和科學涉及以引導模型產生最準確、相關和連貫的響應的方式來制作這些輸入。

文本提示

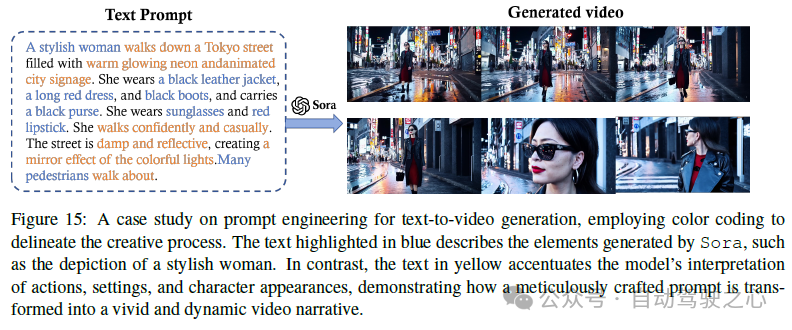

文本提示工程對于指導文本到視頻模型(例如 Sora)生成視覺上引人注目的視頻并精確滿足用戶要求至關重要。這涉及制作詳細描述來指導模型有效地彌合人類創造力與人工智能執行能力之間的差距。Sora 的提示涵蓋了各種情境。最近的研究(例如 VoP、Make-A-Video 和 Tune-A-Video)展示了提示工程如何利用模型的自然語言理解能力來解碼復雜的指令,并將其渲染成連貫、生動和高質量的視頻敘事。如圖 15 所示,"一位時尚的女性走在霓虹燈閃爍的東京街道上......"就是這樣一個精心制作的文本提示,它確保 Sora 生成與預期視覺相符的視頻。提示工程的質量取決于單詞的精心選擇、提供細節的具體性以及對其對模型輸出的影響的理解。例如,圖 15 中的提示詳細說明了場景的動作、設置、人物外貌,甚至是所需的心情和氛圍。

圖像提示

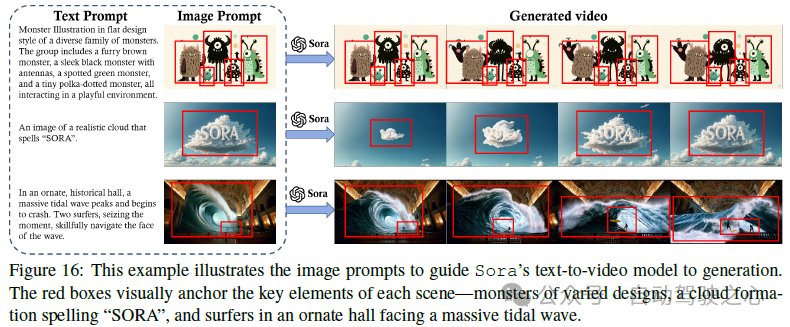

圖像提示作為待生成視頻內容的視覺錨點,還包括角色、設置和情緒等其他元素。此外,文本提示可以指示模型通過添加運動、互動和敘事發展的層次來使這些元素動畫化,從而使靜態圖像栩栩如生。使用圖像提示允許 Sora 利用視覺和文本信息將靜態圖像轉換為動態、敘事驅動的視頻。在圖 16 中,我們展示了"一只穿著貝雷帽和高領衫的柴犬"、"一個獨特的怪物家庭"、"一個云形成"SORA"字樣"和"沖浪者在歷史性大廳內航行潮水浪涌"的 AI 生成視頻。這些例子展示了通過向 Sora 提供由 DALL·E 生成的圖像可以實現的效果。

視頻提示

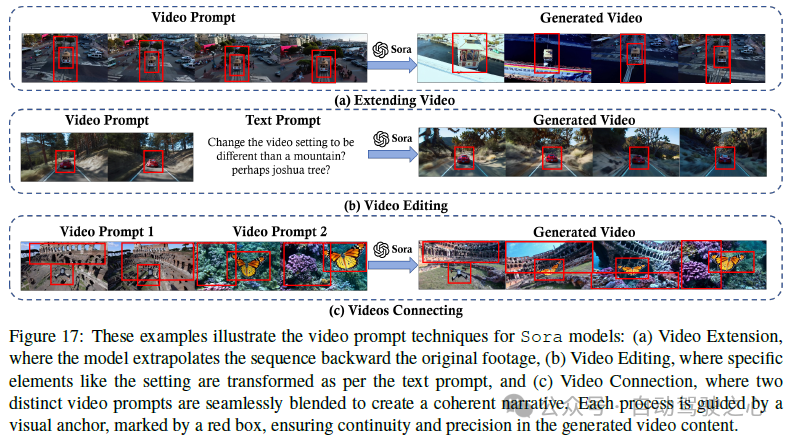

視頻提示也可以用于視頻生成。最近的研究(例如 Moonshot 和 Fast-Vid2Vid)表明,良好的視頻提示需要具體和靈活。這確保了模型在特定目標上獲得清晰的指導,例如特定對象和視覺主題的描繪,并且還允許最終輸出中具有想象力的變化。例如,在視頻擴展任務中,提示可以指定擴展的方向(時間向前或向后)以及擴展的上下文或主題。在圖 17(a) 中,視頻提示指示 Sora 將視頻向時間的反方向延伸以探索原始起始點之前發生的事件。在通過視頻提示進行視頻到視頻編輯時,如圖 17(b) 所示,模型需要清楚地理解所需的轉換,例如改變視頻的風格、設置或氛圍,或者改變細微的方面,如光線或心情。在圖 17(c) 中,提示指示 Sora 在確保不同場景中的對象之間實現平滑過渡的同時連接視頻。

討論

提示工程使用戶能夠引導 AI 模型生成符合其意圖的內容。例如,文本、圖像和視頻提示的結合使用使 Sora 能夠創建不僅在視覺上引人注目,而且與用戶的期望和意圖相契合的內容。雖然先前關于提示工程的研究集中在 LLMs 和 LVMs 的文本和圖像提示上,但我們預計視頻生成模型的視頻提示將引起越來越多的關注。

可信度

隨著諸如 ChatGPT、GPT4-V 和 Sora 等復雜模型的快速發展,這些模型的能力得到了顯著增強。這些發展對提高工作效率和推動技術進步做出了重要貢獻。然而,這些進步也引發了人們對這些技術潛在濫用的擔憂,包括虛假新聞的生成、隱私侵犯和道德困境。因此,大型模型的可信度問題引起了學術界和工業界的廣泛關注,成為當代研究討論的焦點之一。

安全性問題

一個主要關注的領域是模型的安全性,特別是其抵御濫用和所謂的"越獄"攻擊的韌性,用戶試圖利用漏洞生成被禁止或有害內容的情況。例如,引入了一種基于梯度技術的新穎且可解釋的對抗攻擊方法 AutoDAN ,以實現系統繞過。在一項最近的研究中,研究人員探討了語言模型為什么難以抵御越獄攻擊的兩個原因:競爭性目標和不匹配的泛化。除了文本攻擊,視覺越獄也威脅到多模型模型的安全性(例如,GPT-4V和 Sora)。一項最近的研究 發現,大型多模型模型更易受攻擊,因為額外的視覺輸入的連續和高維特性使其更脆弱,容易受到對抗性攻擊,代表了一個擴展的攻擊面。

其他利用

由于大型基礎模型的訓練數據集的規模和訓練方法(例如,ChatGPT和 Sora),這些模型的真實性需要加強,因為相關問題如幻覺已經廣泛討論。在這種情況下,幻覺指的是模型傾向于生成看似令人信服但毫無根據或錯誤的響應。這種現象引發了關于模型輸出的可靠性和可信度的關鍵問題,需要綜合方法來評估和解決這個問題。已經有大量研究致力于從各個角度剖析幻覺問題。這包括旨在評估不同模型和場景中幻覺程度和性質的努力。這些評估為理解幻覺發生的方式和原因提供了寶貴的見解,為開發減少其發生的策略奠定了基礎。與此同時,大量研究致力于設計和實施方法,以減少這些大型模型中的幻覺。

可信度的另一個重要方面是公平性和偏見。開發不會持續或加劇社會偏見的模型的重要性是一個重要關注點。這一重點來自于認識到這些模型中編碼的偏見可能會強化現有的社會不公平,導致歧視性結果。該領域的研究,正如 Gallegos 等人、Zhang 等人、Liang 等人和 Friedrich 等人的工作所證實的那樣,致力于對這些固有偏見進行仔細辨別和糾正。目標是培養公平運作的模型,對待所有個體時都不帶有種族、性別或其他敏感屬性的偏見。這不僅涉及在數據集中檢測和減輕偏見,還包括設計能夠積極抵制這些偏見傳播的算法。

隱私保護是這些模型部署時的另一個基本支柱。在數據隱私關切日益加劇的時代,保護用戶數據的重視程度從未如此關鍵。對于大型模型的嚴格評估日益引起公眾的關注和擔憂,這些評估側重于模型保護用戶數據的能力,確保個人信息保持機密,不會被無意間披露。Mireshghallah 等人、Plant 等人和 Li 等人的研究展示了推動隱私保護方法和技術的努力。

對齊

在應對這些挑戰時,確保大型模型的可信度已成為研究人員的主要關注點之一。其中最重要的技術之一是模型對齊,指的是確保模型的行為和輸出與人類設計者的意圖和道德標準一致的過程和目標。這涉及到技術的發展、其道德責任和社會價值。在大型語言模型領域,利用人類反饋的強化學習方法(RLHF)已被廣泛應用于模型對齊。該方法將強化學習(RL)與直接人類反饋結合,使模型能夠更好地與人類的期望和標準一致地理解和執行任務。

討論

從 Sora(特別是其技術報告)中,我們總結了一些有見地的發現,這些發現可能為未來的工作提供了信息性的指導:

(1)模型與外部安全的綜合保護:隨著模型變得更加強大,特別是在生成內容方面,確保它們不被濫用以生成有害內容(例如仇恨言論和虛假信息)已成為一個嚴重的挑戰。除了調整模型本身外,外部安全保護同樣重要。這包括內容過濾和審查機制、使用權限和訪問控制、數據隱私保護,以及透明度和可解釋性的增強。例如,OpenAI 現在使用檢測分類器來判斷給定視頻是否由 Sora 生成。此外,還部署了文本分類器來檢測潛在有害的文本輸入。

(2)多模型模型的安全挑戰:多模型模型,如文本到視頻模型(如 Sora),由于其理解和生成各種類型內容的能力(文本、圖像、視頻等),給安全帶來了額外的復雜性。多模型模型可以以各種形式生成內容,增加了濫用和版權問題的方式和范圍。由于多模型模型生成的內容更加復雜和多樣化,傳統的內容驗證和真實性方法可能不再有效。這需要開發新的技術和方法來識別和過濾這些模型生成的有害內容,增加了規范和管理的難度。

(3)跨學科合作的需求:確保模型的安全性不僅是一個技術問題,還需要跨學科合作。為了解決這些挑戰,需要來自法律和心理學等各個領域的專家共同合作,制定適當的規范(例如,什么是安全的,什么是不安全的?)、政策和技術解決方案。跨學科合作的需求顯著增加了解決這些問題的復雜性。

應用

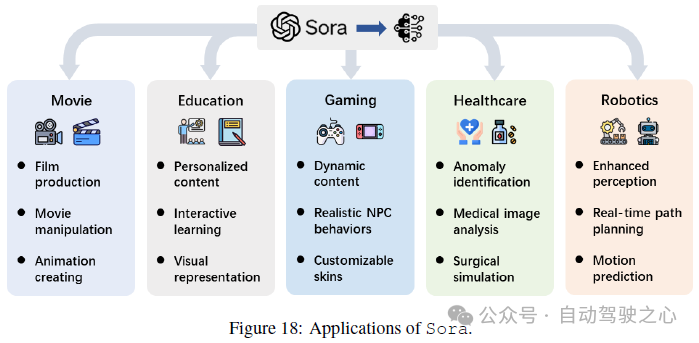

隨著以Sora為代表的視頻擴散模型成為前沿技術,它們在各個研究領域和行業中的應用正在迅速加速。這項技術的影響遠遠超出了僅僅視頻創作,為從自動化內容生成到復雜決策過程等任務提供了變革性潛力。在本節中,我們深入全面地審視了視頻擴散模型的當前應用,突出了Sora不僅展示了其能力,而且徹底改變了解決復雜問題的方法。我們旨在為實際部署場景提供廣泛的視角(見圖18)。

電影

傳統上,創作影視杰作是一個艱難且昂貴的過程,通常需要數十年的努力、尖端設備和大量的財政投資。然而,先進的視頻生成技術的出現預示著電影制作的新時代,其中一個夢想是從簡單的文本輸入自動產生電影正在成為現實。研究人員通過將視頻生成模型擴展到電影生成的領域,涉足了電影生成的領域。MovieFactory應用擴散模型生成電影風格的視頻,這些視頻由Chat-GPT生成的詳細腳本產生,代表了一個重大飛躍。隨后,MobileVidFactory可以根據用戶提供的簡單文本自動生成垂直移動視頻。Vlogger使用戶能夠撰寫一分鐘長的視頻日志。這些發展,以Sora輕松生成引人入勝的電影內容的能力為代表,標志著電影制作民主化的一個關鍵時刻。它們展示了一個未來的景象,那里任何人都可以成為電影制片人,顯著降低了進入電影行業的門檻,并在電影制作中引入了一個新穎的維度,將傳統敘事與人工智能驅動的創造力融合在一起。這些技術的影響超出了簡化。它們承諾重塑電影制作的格局,在不斷變化的觀眾偏好和分發渠道面前,使其更加可訪問和多樣化。

教育

長期以來,教育內容的景觀一直被靜態資源所主導,盡管它們具有價值,但往往無法滿足當今學生多樣化的需求和學習風格。視頻擴散模型站在教育革命的前沿,提供了前所未有的機會,以一種顯著增強學習者參與度和理解能力的方式定制和激活教育材料。這些先進技術使教育工作者能夠將文本描述或課程大綱轉化為動態、引人入勝的視頻內容,以適應個體學習者的特定風格和興趣。此外,圖像到視頻編輯技術提供了將靜態教育資產轉化為互動視頻的創新途徑,從而支持一系列學習偏好,并潛在地增加學生參與度。通過將這些模型整合到教育內容創作中,教育工作者可以在許多主題上制作視頻,使復雜概念對學生更加易于理解和引人入勝。Sora在革新教育領域方面的應用體現了這些技術的變革潛力。這種向個性化、動態教育內容的轉變標志著教育的新時代。

游戲

游戲行業不斷尋求推動現實感和沉浸感的界限,然而,傳統的游戲開發往往受制于預先渲染的環境和腳本化事件的限制。擴散模型實時生成動態、高保真視頻內容和逼真音效的能力,承諾克服現有的限制,為開發者提供工具,創造對玩家行動和游戲事件有機響應的不斷演變的游戲環境。這可能包括生成變化的天氣條件、改變地貌,甚至實時創建全新的環境,使游戲世界更加沉浸和響應。一些方法還從視頻輸入中合成逼真的撞擊聲音,增強游戲音頻體驗。通過將Sora整合到游戲領域,可以創造出引人入勝、吸引玩家的無與倫比的沉浸式體驗。游戲的開發、玩法和體驗將得到革新,同時為敘事、互動和沉浸體驗開辟新的可能性。

醫療保健

盡管具有生成能力,視頻擴散模型擅長理解和生成復雜的視頻序列,使其特別適用于識別體內的動態異常,例如早期細胞凋亡、皮膚病變進展和不規則的人體運動,這對于早期疾病的檢測和干預策略至關重要。此外,像MedSegDiff-V2和這樣的模型利用Transformer的力量以前所未有的精度對醫學圖像進行分割,使臨床醫生能夠在各種成像模式下精確地找出感興趣的區域。將Sora整合到臨床實踐中,不僅可以改進診斷過程,而且可以個性化患者護理,根據精確的醫學成像分析提供定制的治療方案。然而,這種技術整合也帶來了一系列挑戰,包括對健壯數據隱私措施的需求和解決醫療倫理問題。

機器人技術

視頻擴散模型現在在機器人技術中扮演著重要角色,展示了一個新時代,在這個時代,機器人可以生成和解釋復雜的視頻序列,以增強感知和決策制定。這些模型為機器人解鎖了新的能力,使它們能夠與環境交互,并以前所未有的復雜性和精度執行任務。將網絡規模的擴散模型應用到機器人技術展示了利用大規模模型增強機器人視覺和理解能力的潛力。潛在的擴散模型被用于語言指導的視頻預測,使機器人能夠通過預測視頻格式中的動作結果來理解和執行任務。此外,視頻擴散模型創新地解決了機器人研究中對模擬環境的依賴,這些模型能夠創建高度逼真的視頻序列。這使得為機器人生成多樣化的訓練場景成為可能,緩解了真實世界數據稀缺性所帶來的限制。我們相信,將Sora等技術整合到機器人領域,將帶來突破性的發展。通過利用Sora的力量,機器人的未來將迎來前所未有的進步,使機器人能夠無縫地在環境中導航和交互。

討論

Sora顯示出了從人類精確理解和實施復雜指令方面的卓越才能。這個模型擅長創作具有各種角色的詳細視頻,這些角色都設置在精心制作的場景中。Sora的一個特別令人印象深刻的特點是,它能夠在保持一致而引人入勝的敘述的同時制作長達一分鐘的視頻。這標志著與之前專注于較短視頻片段的嘗試相比,Sora的延長序列展示了清晰的敘述流程,并從頭到尾保持了視覺一致性。此外,Sora通過生成更長的視頻序列來區別于先前模型,這些視頻序列捕捉了復雜的動作和交互,推動了AI驅動的創造工具的重大進步,使用戶能夠將書面故事轉化為細節豐富、復雜的視頻,而這在以前是不可能實現的。

限制

物理真實性的挑戰。作為一個模擬平臺,Sora展示了一系列限制,這些限制削弱了其準確描繪復雜場景的效果。最重要的是,它在復雜場景中對物理原理的處理不一致,導致未能準確復制特定的因果示例。例如,吃掉一部分餅干可能不會導致相應的咬痕,這說明了系統偶爾脫離物理可信度。這個問題延伸到運動的模擬,Sora生成的運動挑戰現實的物理建模,比如物體的不自然變形或椅子等剛性結構的錯誤模擬,導致不真實的物理交互。在模擬物體和角色之間的復雜交互時,挑戰進一步加劇,有時產生的結果偏向于幽默。

空間和時間復雜性。Sora偶爾會誤解與給定提示中的對象和角色的放置或排列相關的指令,導致對方向的混淆(例如,將左右混淆)。此外,在保持事件的時間準確性方面存在挑戰,特別是在遵循指定的相機運動或序列時。這可能導致偏離場景的預期時間流。在涉及大量角色或元素的復雜情況下,Sora有時會插入不相關的動物或人物。這種添加可能會顯著改變最初設想的構圖和氛圍,偏離了計劃的敘述或視覺布局。這個問題不僅影響了模型準確重現特定場景或敘述的能力,還影響了其在生成內容方面與用戶期望和生成輸出的連貫性一致性。

人機交互的限制。盡管Sora在視頻生成領域顯示出潛力,但在人機交互方面面臨著重大限制。這些限制主要體現在用戶系統交互的一致性和效率上,尤其是在對生成內容進行詳細修改或優化時。例如,用戶可能會發現難以精確指定或調整視頻中特定元素的呈現方式,比如動作細節和場景過渡。此外,Sora在理解復雜語言指令或捕捉微妙語義差異方面的限制可能導致視頻內容未能完全滿足用戶的期望或需求。這些缺點限制了Sora在視頻編輯和增強方面的潛力,也影響了用戶體驗的整體滿意度。

使用限制。關于使用限制,OpenAI尚未為公眾訪問Sora設定具體的發布日期,強調在廣泛部署之前需要謹慎處理安全性和準備性。這表明,Sora在安全、隱私保護和內容審查等領域可能仍需要進一步改進和測試。此外,目前,Sora只能生成長達一分鐘的視頻,根據已發布的案例,大多數生成的視頻只有幾十秒長。這一限制限制了其在需要更長內容展示的應用中的使用,如詳細的教學視頻或深入的敘事。這一限制降低了Sora在內容創作中的靈活性。

機遇

學術。(1) OpenAI引入Sora標志著AI社區更深入地探索文本到視頻模型的轉變,利用擴散和Transformer技術。這一舉措旨在重新引導關注,將重點轉向直接從文本描述創建高度復雜和微妙的視頻內容的潛力,這是一片有望革新內容創作、敘事和信息共享的前沿。(2) 將Sora訓練在原始大小的數據上的創新方法,與傳統的調整或裁剪方法相比,為學術界提供了突破性的靈感。它通過突出利用未經修改的數據集的好處,為創建更先進的生成模型打開了新的途徑。

行業。(1) Sora目前的能力標志著視頻模擬技術進步的一個有希望的路徑,突出了在物理和數字領域內顯著增強逼真性的潛力。Sora通過文本描述使得創造高度逼真環境成為可能,這為內容創作開辟了一個充滿希望的未來。這一潛力延伸到了革新游戲開發,展示了一個未來的景象,即可以以前所未有的輕松和準確度打造沉浸式的虛擬世界。(2) 公司可以利用Sora制作能夠迅速適應市場變化并創建定制營銷內容的廣告視頻。這不僅降低了生產成本,還增強了廣告的吸引力和有效性。Sora僅憑文本描述就能生成高度逼真的視頻內容的能力,可能會徹底改變品牌與受眾互動的方式,使其能夠以前所未有的方式創造沉浸式和引人入勝的視頻,捕捉產品或服務的本質。

社會。(1) 雖然利用文本到視頻技術替代傳統電影制作的前景仍然遙遠,但Sora和類似的平臺對社交媒體內容創作具有變革性的潛力。目前視頻長度的限制并不減弱這些工具在使高質量視頻制作對每個人都可及的方面所能發揮的影響,使個人能夠在不需要昂貴設備的情況下制作引人入勝的內容。這代表了對TikTok和Reels等平臺上內容創作者的重大轉變,帶來了一個新的創造力和參與度的時代。(2) 編劇和創意專業人員可以利用Sora將書面劇本轉化為視頻,幫助他們更好地展示和分享他們的創意概念,甚至制作短片和動畫片。從劇本中創作詳細、生動的視頻可以從根本上改變電影和動畫制作的前期制作過程,讓未來的敘事者可以在其中進行創作、發展和完善他們的敘事構思。這項技術為更動態、更互動的劇本開發形式開辟了可能性,其中的想法可以實時可視化和評估,為創造力和協作提供了強大的工具。(3) 記者和新聞機構也可以利用Sora快速生成新聞報道或解釋性視頻,使新聞內容更加生動和引人入勝。這可以顯著增加新聞報道的報道范圍和受眾參與度。通過提供一個可以模擬真實環境和場景的工具,Sora為視覺敘事提供了強大的解決方案,使記者能夠通過引人入勝的視頻來傳達復雜的故事,這些故事以前很難或昂貴地制作。總的來說,Sora 在營銷、新聞和娛樂領域徹底改革內容創作的潛力是巨大的。

結論

這篇綜述提供了對 Sora 的全面評估,以幫助開發者和研究人員研究 Sora 的能力和相關工作。該評估基于對已發表的技術報告的調查和基于現有文獻的逆向工程。當 Sora 的 API 可用并且有關 Sora 的進一步細節被揭示時,作者將繼續更新本文。作者希望本綜述論文能成為開源研究社區的寶貴資源,并為社區共同在不久的將來開發一個開源版本的 Sora 打下基礎,以在 AIGC 時代使視頻自動生成民主化。為了實現這一目標,作者邀請各方進行討論、提出建議,并展開合作。