微軟推出 XOT 方法,提升語言模型推理能力

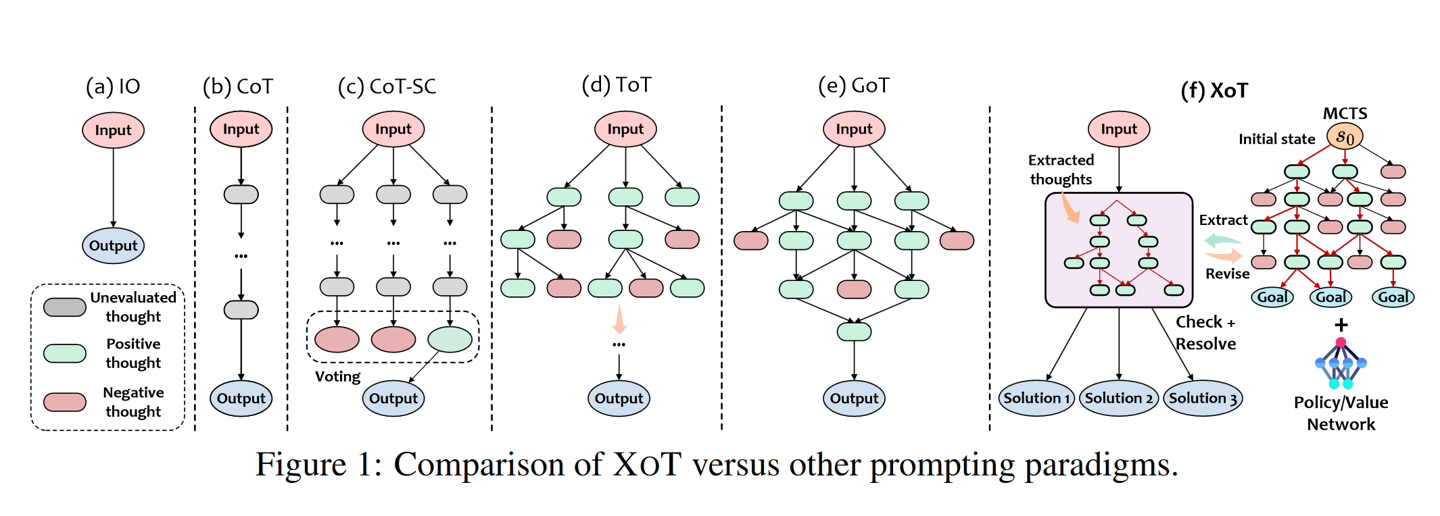

11 月 15 日消息,微軟近日推出了名為“Everything of Thought”(XOT)的方法,靈感來自谷歌 DeepMind 的 AlphaZero,利用緊湊的神經網絡,來增強 AI 模型推理能力。

微軟和佐治亞理工學院、華東師范大學合作開發了該算法,整合了強化學習(reinforcement learning)和蒙特卡洛樹搜索 (MCTS) 能力,在復雜決策環境中,進一步提高解決問題的有效性。

IT之家注:微軟研究團隊表示 XOT 方法可以讓語言模型擴展到不熟悉的問題上,在 Game of 24、8-Puzzle 和 Pocket Cube 嚴苛測試中提升明顯。結果表明,XOT 明顯優于其他方法,甚至解決了其他方法失敗的問題。但是,XOT 并沒有達到 100% 的可靠性。

XOT 框架包括以下關鍵步驟:

- 預訓練階段:MCTS 模塊在特定任務上進行預訓練,以學習有關有效思維搜索的領域知識。輕量級策略和價值網絡指導搜索。思想搜索: 在推理過程中,預訓練的 MCTS 模塊使用策略 / 價值網絡來有效地探索和生成 LLM 的思想軌跡。

- 思想修正:LLM 審查 MCTS 的思想并識別任何錯誤。修正的想法是通過額外的 MCTS 模擬產生的。

- LLM 推理: 將修改后的想法提供給 LLM 解決問題的最終提示。

IT之家在此附上論文 [PDF] 地址,感興趣的用戶可以深入閱讀。