LangChain應用開發(fā)指南——熟用LCEL語法掌握Chain的精髓

引言

LangChain的核心概念是Chain,它是一種由多個流程構件組成的有向圖,可以對輸入的文本進行各種轉換和處理,輸出你想要的結果。LangChain提供了一種專門的表達式語言,叫做LCEL(LangChain Expression Language),它可以讓你用簡潔和靈活的語法來定義和操作Chain,無需編寫復雜的代碼。

今天我將帶領大家使用LCEL語法來構建和組合Chain,實現(xiàn)強大的LLM應用。

LCEL語法基礎

LCEL是一個用于構建復雜鏈式組件的語言,它支持流式處理、并行化、日志記錄等功能。LCEL的基本語法規(guī)則是使用|符號將不同的組件連接起來,形成一個鏈式結構。|符號類似于Unix的管道操作符,它將一個組件的輸出作為下一個組件的輸入,從而實現(xiàn)數(shù)據(jù)的傳遞和處理。

LCEL的語法非常簡潔和靈活,它可以用于各種場景和任務。例如,我們可以使用LCEL來實現(xiàn)以下功能:

- 生成一個關于某個主題的笑話:我們可以將一個提示模板和一個語言模型組合起來,形成一個鏈式結構,如下所示:

prompt = BasePromptTemplate("tell me a short joke about {topic}")

model = ChatModel()

output_parser = StrOutputParser()

joke = ({"topic": RunnablePassthrough()} | prompt | model | output_parser)這個鏈式結構的作用是,首先根據(jù)用戶輸入的主題,生成一個提示,然后將提示傳遞給語言模型,讓它生成一個笑話,最后將笑話轉換為字符串,返回給用戶。我們可以用以下代碼來測試這個鏈式結構:

joke.invoke("ice cream")

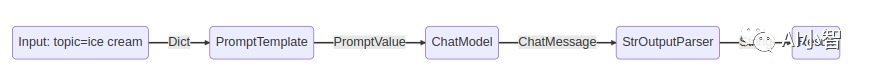

# > "Why did the ice cream go to therapy? \n\nBecause it had too many toppings and couldn't find its cone-fidence!"通過以上案例,我們能夠了解如何使用LCEL語言構建一個生成笑話的鏈式結構。我將為您解釋其中的每一步:

- 首先,我們傳入用戶想要的主題,例如 "ice cream",作為輸入。

- 通過{"topic": RunnablePassthrough()},將輸入轉化為字典類型{"topic": "ice cream"}

- 然后,我們使用提示模板組件,根據(jù)用戶輸入的主題,生成一個提示,例如"tell me a short joke about ice cream",并將其封裝為一個PromptValue類型的對象。這個對象可以適用于不同類型的語言模型,因為它可以生成字符串或消息序列。

- 接著,我們使用大語言模型,會根據(jù)提示模板生成的提示,生成一段文本,例如"Why did the ice cream go to therapy?\nBecause it had too many toppings and couldn't cone-trol itself!",并將其封裝為一個ChatMessage類型的對象。這個對象包含了生成者、內(nèi)容和時間等信息。

- 最后,我們使用輸出解析器組件,根據(jù)用戶的需求,將語言模型生成的文本轉換為不同的格式或類型,例如字符串。這樣,用戶就可以方便地獲取和使用生成的內(nèi)容。

為什么要用LCEL?

LCEL語法的核心思想是:一切皆為對象,一切皆為鏈。這意味著,LCEL語法中的每一個對象都實現(xiàn)了一個統(tǒng)一的接口:Runnable,它定義了一系列的調(diào)用方法(invoke, batch, stream, ainvoke, …)。這樣,你可以用同樣的方式調(diào)用不同類型的對象,無論它們是模型、函數(shù)、數(shù)據(jù)、配置、條件、邏輯等等。而且,你可以將多個對象鏈接起來,形成一個鏈式結構,這個結構本身也是一個對象,也可以被調(diào)用。這樣,你可以將復雜的功能分解成簡單的組件,然后用LCEL語法將它們組合起來,形成一個完整的應用。

LCEL語法還提供了一些組合原語,讓你可以更靈活地控制鏈式結構的行為,例如:

- 并行化:你可以使用

parallel原語將多個對象并行執(zhí)行,提高效率和性能。 - 回退:你可以使用

fallback原語為某個對象指定一個備選對象,當主對象執(zhí)行失敗時,自動切換到備選對象,保證應用的可用性和穩(wěn)定性。 - 動態(tài)配置:你可以使用

config原語為某個對象指定一個配置對象,根據(jù)運行時的輸入或條件,動態(tài)地修改對象的參數(shù)或屬性,增加應用的靈活性和適應性。

LCEL語法的優(yōu)勢

為了更好地理解LCEL語法的優(yōu)勢,我們可以將它與傳統(tǒng)的編程語言進行對比,看看如果不使用LCEL語法,我們需要做哪些額外的工作。我們?nèi)砸陨鲜鲂υ挼纳涉湠槔?/p>

這段代碼非常簡潔和清晰,只需要幾行就可以實現(xiàn)我們想要的功能。而且,這段代碼還具有很高的可擴展性和靈活性,例如:

- 如果我們想要以流式的方式獲取笑話,我們只需要改變調(diào)用方法,使用

stream代替invoke:

# 調(diào)用笑話對象,傳入一個主題字符串,得到一個笑話字符串的流

joke.stream("dog")- 如果我們想要同時處理多個主題,我們只需要改變調(diào)用方法,使用

batch代替invoke:

# 調(diào)用笑話對象,傳入一個主題字符串的列表,得到一個笑話字符串的列表

joke.batch(["dog", "cat", "banana"])- 如果我們想讓請求異步執(zhí)行只需要

joke.ainvoke("dog")- 模型的變更也十分簡單,只需要變更modal變量的定義即可

prompt = BasePromptTemplate("tell me a short joke about {topic}")

# 改用gpt-3.5-turbo的llm

model = OpenAI(model="gpt-3.5-turbo")

output_parser = StrOutputParser()

joke = ({"topic": RunnablePassthrough()} | prompt | model | output_parser)- 同時LCEL標準模型中的對象都可以直接增加同類型對象作為fallbacks,操作上只需要執(zhí)行with_fallbacks方法即可。由于整條鏈亦是LCEL標準模型,因而鏈亦可配置fallbacks

# 增加OpenAI的llm作為ChatModel的fallbacks

prompt = BasePromptTemplate("tell me a short joke about {topic}")

model = ChatModel()

fallback_llm = OpenAI(model="gpt-3.5-turbo")

modal_with_fallback = model.with_fallbacks([fallback_llm])

output_parser = StrOutputParser()

joke = ({"topic": RunnablePassthrough()} | prompt | modal_with_fallback | output_parser)以上只是一些簡單的例子,你可以根據(jù)自己的需求,使用LCEL語法提供的更多的組合原語,實現(xiàn)更復雜的功能和效果。

那么,如果我們不使用LCEL語法,而是使用傳統(tǒng)的編程語言,我們需要做哪些額外的工作呢?我們以Python為例,看看我們需要寫多少代碼,才能實現(xiàn)與LCEL語法相同的功能。

代碼對比

代碼對比

從上面的代碼可以看出,如果我們不使用LCEL語法,而是使用傳統(tǒng)的編程語言,我們需要寫很多的代碼,才能實現(xiàn)與LCEL語法相同的功能。而且,這些代碼還存在很多的問題,例如:

- 代碼的可讀性和可維護性很差,需要花費很多的時間和精力去理解和修改。

- 代碼的可擴展性和靈活性很低,需要對代碼進行大量的修改,才能實現(xiàn)不同的功能和效果。

- 代碼的可復用性和可移植性很差,需要對代碼進行大量的修改,才能適應不同的場景和平臺。

因此,我們可以看出,LCEL語法相比傳統(tǒng)的編程語言,具有很多的優(yōu)勢,它可以讓我們更高效、更簡單、更靈活地構建復雜的AI應用。

總結

在本文中,我們介紹了如何使用LangChain的LECL語法。我們介紹了LECL的基本語法以及基于LECL的流、異步等多種用法,并對比了不適用LECL語法開發(fā)的情況。

我們希望本文能夠幫助你了解LangChain中特色的LECL語法,鼓勵你嘗試使用LangChain開發(fā)自己的應用。

參考資料:

- [1] Why use LCEL.https://python.langchain.com/docs