一文搞懂什么是JMM重排序、內存屏障、順序一致性

基礎

并發編程模型的分類

在并發編程中,我們需要處理兩個關鍵問題:線程之間如何通信及線程之間如何同步(這里的線程是指并發執行的活動實體)。通信是指線程之間以何種機制來交換信息。在命令式編程中,線程之間的通信機制有兩種:共享內存和消息傳遞。

在共享內存的并發模型里,線程之間共享程序的公共狀態,線程之間通過寫 - 讀內存中的公共狀態來隱式進行通信。在消息傳遞的并發模型里,線程之間沒有公共狀態,線程之間必須通過明確的發送消息來顯式進行通信。

同步是指程序用于控制不同線程之間操作發生相對順序的機制。在共享內存并發模型里,同步是顯式進行的。程序員必須顯式指定某個方法或某段代碼需要在線程之間互斥執行。在消息傳遞的并發模型里,由于消息的發送必須在消息的接收之前,因此同步是隱式進行的。

Java 的并發采用的是共享內存模型,Java 線程之間的通信總是隱式進行,整個通信過程對程序員完全透明。如果編寫多線程程序的 Java 程序員不理解隱式進行的線程之間通信的工作機制,很可能會遇到各種奇怪的內存可見性問題。

Java 內存模型的抽象

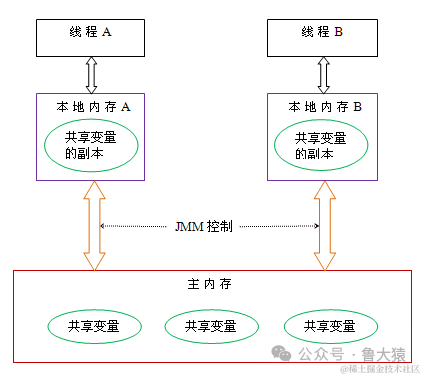

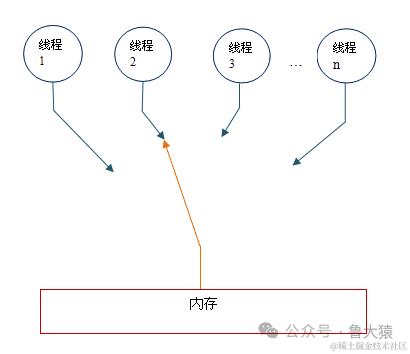

在 java 中,所有實例域、靜態域和數組元素存儲在堆內存中,堆內存在線程之間共享(本文使用“共享變量”這個術語代指實例域,靜態域和數組元素)。局部變量(Local variables),方法定義參數(java 語言規范稱之為 formal method parameters)和異常處理器參數(exception handler parameters)不會在線程之間共享,它們不會有內存可見性問題,也不受內存模型的影響。

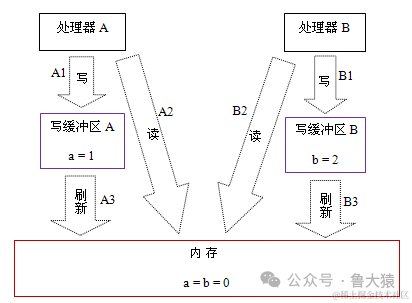

Java 線程之間的通信由 Java 內存模型(本文簡稱為 JMM)控制,JMM 決定一個線程對共享變量的寫入何時對另一個線程可見。從抽象的角度來看,JMM 定義了線程和主內存之間的抽象關系:線程之間的共享變量存儲在主內存(main memory)中,每個線程都有一個私有的本地內存(local memory),本地內存中存儲了該線程以讀 / 寫共享變量的副本。本地內存是 JMM 的一個抽象概念,并不真實存在。它涵蓋了緩存,寫緩沖區,寄存器以及其他的硬件和編譯器優化。Java 內存模型的抽象示意圖如下:

圖片

圖片

從上圖來看,線程 A 與線程 B 之間如要通信的話,必須要經歷下面 2 個步驟:

- 首先,線程 A 把本地內存 A 中更新過的共享變量刷新到主內存中去。

- 然后,線程 B 到主內存中去讀取線程 A 之前已更新過的共享變量。

下面通過示意圖來說明這兩個步驟:

圖片

圖片

如上圖所示,本地內存 A 和 B 有主內存中共享變量 x 的副本。假設初始時,這三個內存中的 x 值都為 0。線程 A 在執行時,把更新后的 x 值(假設值為 1)臨時存放在自己的本地內存 A 中。當線程 A 和線程 B 需要通信時,線程 A 首先會把自己本地內存中修改后的 x 值刷新到主內存中,此時主內存中的 x 值變為了 1。隨后,線程 B 到主內存中去讀取線程 A 更新后的 x 值,此時線程 B 的本地內存的 x 值也變為了 1。

從整體來看,這兩個步驟實質上是線程 A 在向線程 B 發送消息,而且這個通信過程必須要經過主內存。JMM 通過控制主內存與每個線程的本地內存之間的交互,來為 java 程序員提供內存可見性保證。

重排序

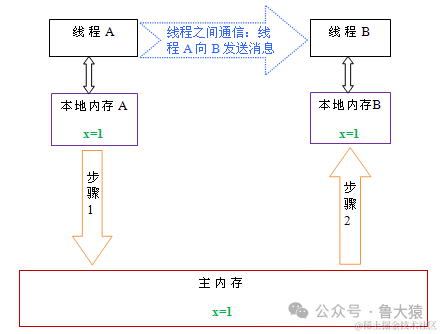

在執行程序時為了提高性能,編譯器和處理器常常會對指令做重排序。重排序分三種類型:

- 編譯器優化的重排序。編譯器在不改變單線程程序語義的前提下,可以重新安排語句的執行順序。

- 指令級并行的重排序。現代處理器采用了指令級并行技術(Instruction-Level Parallelism, ILP)來將多條指令重疊執行。如果不存在數據依賴性,處理器可以改變語句對應機器指令的執行順序。

- 內存系統的重排序。由于處理器使用緩存和讀 / 寫緩沖區,這使得加載和存儲操作看上去可能是在亂序執行。

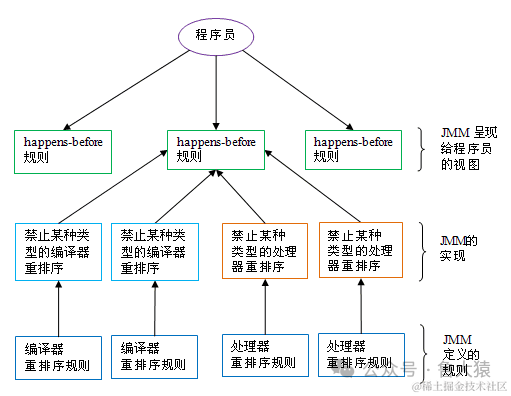

從 java 源代碼到最終實際執行的指令序列,會分別經歷下面三種重排序:

圖片

圖片

上述的 1 屬于編譯器重排序,2 和 3 屬于處理器重排序。這些重排序都可能會導致多線程程序出現內存可見性問題。對于編譯器,JMM 的編譯器重排序規則會禁止特定類型的編譯器重排序(不是所有的編譯器重排序都要禁止)。對于處理器重排序,JMM 的處理器重排序規則會要求 java 編譯器在生成指令序列時,插入特定類型的內存屏障(memory barriers,intel 稱之為 memory fence)指令,通過內存屏障指令來禁止特定類型的處理器重排序(不是所有的處理器重排序都要禁止)。

JMM 屬于語言級的內存模型,它確保在不同的編譯器和不同的處理器平臺之上,通過禁止特定類型的編譯器重排序和處理器重排序,為程序員提供一致的內存可見性保證。

處理器重排序與內存屏障指令

現代的處理器使用寫緩沖區來臨時保存向內存寫入的數據。寫緩沖區可以保證指令流水線持續運行,它可以避免由于處理器停頓下來等待向內存寫入數據而產生的延遲。同時,通過以批處理的方式刷新寫緩沖區,以及合并寫緩沖區中對同一內存地址的多次寫,可以減少對內存總線的占用。雖然寫緩沖區有這么多好處,但每個處理器上的寫緩沖區,僅僅對它所在的處理器可見。這個特性會對內存操作的執行順序產生重要的影響:處理器對內存的讀 / 寫操作的執行順序,不一定與內存實際發生的讀 / 寫操作順序一致!為了具體說明,請看下面示例:

// Processor A

a = 1; //A1

x = b; //A2

// Processor B

b = 2; //B1

y = a; //B2

// 初始狀態:a = b = 0;處理器允許執行后得到結果:x = y = 0假設處理器 A 和處理器 B 按程序的順序并行執行內存訪問,最終卻可能得到 x = y = 0 的結果。具體的原因如下圖所示:

圖片

圖片

這里處理器 A 和處理器 B 可以同時把共享變量寫入自己的寫緩沖區(A1,B1),然后從內存中讀取另一個共享變量(A2,B2),最后才把自己寫緩存區中保存的臟數據刷新到內存中(A3,B3)。當以這種時序執行時,程序就可以得到 x = y = 0 的結果。

從內存操作實際發生的順序來看,直到處理器 A 執行 A3 來刷新自己的寫緩存區,寫操作 A1 才算真正執行了。雖然處理器 A 執行內存操作的順序為:A1->A2,但內存操作實際發生的順序卻是:A2->A1。此時,處理器 A 的內存操作順序被重排序了(處理器 B 的情況和處理器 A 一樣,這里就不贅述了)。

這里的關鍵是,由于寫緩沖區僅對自己的處理器可見,它會導致處理器執行內存操作的順序可能會與內存實際的操作執行順序不一致。由于現代的處理器都會使用寫緩沖區,因此現代的處理器都會允許對寫 - 讀操做重排序。

下面是常見處理器允許的重排序類型的列表:

Load-Load | Load-Store | Store-Store | Store-Load | 數據依賴 | |

sparc-TSO | N | N | N | Y | N |

x86 | N | N | N | Y | N |

ia64 | Y | Y | Y | Y | N |

PowerPC | Y | Y | Y | Y | N |

上表單元格中的“N”表示處理器不允許兩個操作重排序,“Y”表示允許重排序。

從上表我們可以看出:常見的處理器都允許 Store-Load 重排序;常見的處理器都不允許對存在數據依賴的操作做重排序。sparc-TSO 和 x86 擁有相對較強的處理器內存模型,它們僅允許對寫 - 讀操作做重排序(因為它們都使用了寫緩沖區)。

- ※注 1:sparc-TSO 是指以 TSO(Total Store Order) 內存模型運行時,sparc 處理器的特性。

- ※注 2:上表中的 x86 包括 x64 及 AMD64。

- ※注 3:由于 ARM 處理器的內存模型與 PowerPC 處理器的內存模型非常類似,本文將忽略它。

- ※注 4:數據依賴性后文會專門說明。

為了保證內存可見性,java 編譯器在生成指令序列的適當位置會插入內存屏障指令來禁止特定類型的處理器重排序。JMM 把內存屏障指令分為下列四類:

屏障類型 | 指令示例 | 說明 |

LoadLoad Barriers | Load1; LoadLoad; Load2 | 確保 Load1 數據的裝載,之前于 Load2 及所有后續裝載指令的裝載。 |

StoreStore Barriers | Store1; StoreStore; Store2 | 確保 Store1 數據對其他處理器可見(刷新到內存),之前于 Store2 及所有后續存儲指令的存儲。 |

LoadStore Barriers | Load1; LoadStore; Store2 | 確保 Load1 數據裝載,之前于 Store2 及所有后續的存儲指令刷新到內存。 |

StoreLoad Barriers | Store1; StoreLoad; Load2 | 確保 Store1 數據對其他處理器變得可見(指刷新到內存),之前于 Load2 及所有后續裝載指令的裝載。 |

StoreLoad Barriers 會使該屏障之前的所有內存訪問指令(存儲和裝載指令)完成之后,才執行該屏障之后的內存訪問指令。

StoreLoad Barriers 是一個“全能型”的屏障,它同時具有其他三個屏障的效果。現代的多處理器大都支持該屏障(其他類型的屏障不一定被所有處理器支持)。執行該屏障開銷會很昂貴,因為當前處理器通常要把寫緩沖區中的數據全部刷新到內存中(buffer fully flush)。

happens-before

從 JDK5 開始,java 使用新的 JSR -133 內存模型(本文除非特別說明,針對的都是 JSR- 133 內存模型)。JSR-133 提出了 happens-before 的概念,通過這個概念來闡述操作之間的內存可見性。如果一個操作執行的結果需要對另一個操作可見,那么這兩個操作之間必須存在 happens-before 關系。這里提到的兩個操作既可以是在一個線程之內,也可以是在不同線程之間。與程序員密切相關的 happens-before 規則如下:

- 程序順序規則:一個線程中的每個操作,happens- before 于該線程中的任意后續操作。

- 監視器鎖規則:對一個監視器鎖的解鎖,happens- before 于隨后對這個監視器鎖的加鎖。

- volatile 變量規則:對一個 volatile 域的寫,happens- before 于任意后續對這個 volatile 域的讀。

- 傳遞性:如果 A happens- before B,且 B happens- before C,那么 A happens- before C。

注意,兩個操作之間具有 happens-before 關系,并不意味著前一個操作必須要在后一個操作之前執行!happens-before 僅僅要求前一個操作(執行的結果)對后一個操作可見,且前一個操作按順序排在第二個操作之前(the first is visible to and ordered before the second)。happens- before 的定義很微妙,后文會具體說明 happens-before 為什么要這么定義。

happens-before 與 JMM 的關系如下圖所示:

圖片

圖片

image.png

如上圖所示,一個 happens-before 規則通常對應于多個編譯器重排序規則和處理器重排序規則。對于 java 程序員來說,happens-before 規則簡單易懂,它避免程序員為了理解 JMM 提供的內存可見性保證而去學習復雜的重排序規則以及這些規則的具體實現。

重排序

數據依賴性

如果兩個操作訪問同一個變量,且這兩個操作中有一個為寫操作,此時這兩個操作之間就存在數據依賴性。數據依賴分下列三種類型:

名稱 | 代碼示例 | 說明 |

寫后讀 | a = 1;b = a; | 寫一個變量之后,再讀這個位置。 |

寫后寫 | a = 1;a = 2; | 寫一個變量之后,再寫這個變量。 |

讀后寫 | a = b;b = 1; | 讀一個變量之后,再寫這個變量。 |

上面三種情況,只要重排序兩個操作的執行順序,程序的執行結果將會被改變。

前面提到過,編譯器和處理器可能會對操作做重排序。編譯器和處理器在重排序時,會遵守數據依賴性,編譯器和處理器不會改變存在數據依賴關系的兩個操作的執行順序。

注意,這里所說的數據依賴性僅針對單個處理器中執行的指令序列和單個線程中執行的操作,不同處理器之間和不同線程之間的數據依賴性不被編譯器和處理器考慮。

as-if-serial 語義

as-if-serial 語義的意思指:不管怎么重排序(編譯器和處理器為了提高并行度),(單線程)程序的執行結果不能被改變。編譯器,runtime 和處理器都必須遵守 as-if-serial 語義。

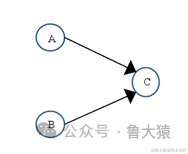

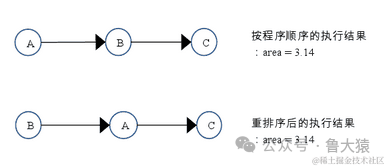

為了遵守 as-if-serial 語義,編譯器和處理器不會對存在數據依賴關系的操作做重排序,因為這種重排序會改變執行結果。但是,如果操作之間不存在數據依賴關系,這些操作可能被編譯器和處理器重排序。為了具體說明,請看下面計算圓面積的代碼示例:

double pi = 3.14; //A

double r = 1.0; //B

double area = pi * r * r; //C上面三個操作的數據依賴關系如下圖所示:

圖片

圖片

如上圖所示,A 和 C 之間存在數據依賴關系,同時 B 和 C 之間也存在數據依賴關系。因此在最終執行的指令序列中,C 不能被重排序到 A 和 B 的前面(C 排到 A 和 B 的前面,程序的結果將會被改變)。但 A 和 B 之間沒有數據依賴關系,編譯器和處理器可以重排序 A 和 B 之間的執行順序。下圖是該程序的兩種執行順序:

圖片

圖片

as-if-serial 語義把單線程程序保護了起來,遵守 as-if-serial 語義的編譯器,runtime 和處理器共同為編寫單線程程序的程序員創建了一個幻覺:單線程程序是按程序的順序來執行的。as-if-serial 語義使單線程程序員無需擔心重排序會干擾他們,也無需擔心內存可見性問題。

程序順序規則

根據 happens- before 的程序順序規則,上面計算圓的面積的示例代碼存在三個 happens- before 關系:

- A happens- before B;

- B happens- before C;

- A happens- before C;

這里的第 3 個 happens- before 關系,是根據 happens- before 的傳遞性推導出來的。

這里 A happens- before B,但實際執行時 B 卻可以排在 A 之前執行(看上面的重排序后的執行順序)。在第一章提到過,如果 A happens- before B,JMM 并不要求 A 一定要在 B 之前執行。JMM 僅僅要求前一個操作(執行的結果)對后一個操作可見,且前一個操作按順序排在第二個操作之前。這里操作 A 的執行結果不需要對操作 B 可見;而且重排序操作 A 和操作 B 后的執行結果,與操作 A 和操作 B 按 happens- before 順序執行的結果一致。在這種情況下,JMM 會認為這種重排序并不非法(not illegal),JMM 允許這種重排序。

在計算機中,軟件技術和硬件技術有一個共同的目標:在不改變程序執行結果的前提下,盡可能的開發并行度。編譯器和處理器遵從這一目標,從 happens- before 的定義我們可以看出,JMM 同樣遵從這一目標。

重排序對多線程的影響

現在讓我們來看看,重排序是否會改變多線程程序的執行結果。請看下面的示例代碼:

class ReorderExample {

int a = 0;

boolean flag = false;

public void writer() {

a = 1; //1

flag = true; //2

}

Public void reader() {

if (flag) { //3

int i = a * a; //4

……

}

}

}flag 變量是個標記,用來標識變量 a 是否已被寫入。這里假設有兩個線程 A 和 B,A 首先執行 writer() 方法,隨后 B 線程接著執行 reader() 方法。線程 B 在執行操作 4 時,能否看到線程 A 在操作 1 對共享變量 a 的寫入?

答案是:不一定能看到。

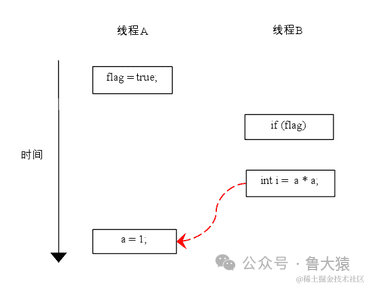

由于操作 1 和操作 2 沒有數據依賴關系,編譯器和處理器可以對這兩個操作重排序;同樣,操作 3 和操作 4 沒有數據依賴關系,編譯器和處理器也可以對這兩個操作重排序。讓我們先來看看,當操作 1 和操作 2 重排序時,可能會產生什么效果? 請看下面的程序執行時序圖:

圖片

圖片

如上圖所示,操作 1 和操作 2 做了重排序。程序執行時,線程 A 首先寫標記變量 flag,隨后線程 B 讀這個變量。由于條件判斷為真,線程 B 將讀取變量 a。此時,變量 a 還根本沒有被線程 A 寫入,在這里多線程程序的語義被重排序破壞了!

※注:本文統一用紅色的虛箭線表示錯誤的讀操作,用綠色的虛箭線表示正確的讀操作。

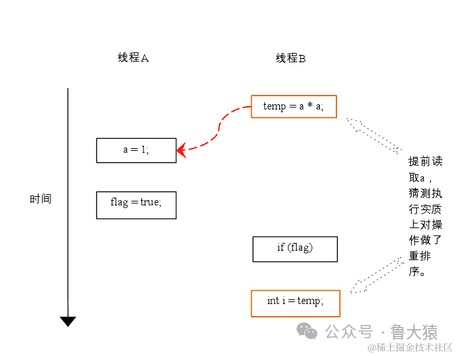

下面再讓我們看看,當操作 3 和操作 4 重排序時會產生什么效果(借助這個重排序,可以順便說明控制依賴性)。下面是操作 3 和操作 4 重排序后,程序的執行時序圖:

圖片

圖片

image.png

在程序中,操作 3 和操作 4 存在控制依賴關系。當代碼中存在控制依賴性時,會影響指令序列執行的并行度。為此,編譯器和處理器會采用猜測(Speculation)執行來克服控制相關性對并行度的影響。以處理器的猜測執行為例,執行線程 B 的處理器可以提前讀取并計算 a*a,然后把計算結果臨時保存到一個名為重排序緩沖(reorder buffer ROB)的硬件緩存中。當接下來操作 3 的條件判斷為真時,就把該計算結果寫入變量 i 中。

從圖中我們可以看出,猜測執行實質上對操作 3 和 4 做了重排序。重排序在這里破壞了多線程程序的語義!

在單線程程序中,對存在控制依賴的操作重排序,不會改變執行結果(這也是 as-if-serial 語義允許對存在控制依賴的操作做重排序的原因);但在多線程程序中,對存在控制依賴的操作重排序,可能會改變程序的執行結果。

順序一致性

數據競爭與順序一致性保證

當程序未正確同步時,就會存在數據競爭。java 內存模型規范對數據競爭的定義如下:

- 在一個線程中寫一個變量,

- 在另一個線程讀同一個變量,

- 而且寫和讀沒有通過同步來排序。

當代碼中包含數據競爭時,程序的執行往往產生違反直覺的結果(前一章的示例正是如此)。如果一個多線程程序能正確同步,這個程序將是一個沒有數據競爭的程序。

JMM 對正確同步的多線程程序的內存一致性做了如下保證:

- 如果程序是正確同步的,程序的執行將具有順序一致性(sequentially consistent)-- 即程序的執行結果與該程序在順序一致性內存模型中的執行結果相同(馬上我們將會看到,這對于程序員來說是一個極強的保證)。這里的同步是指廣義上的同步,包括對常用同步原語(lock,volatile 和 final)的正確使用。

順序一致性內存模型

順序一致性內存模型是一個被計算機科學家理想化了的理論參考模型,它為程序員提供了極強的內存可見性保證。順序一致性內存模型有兩大特性:

- 一個線程中的所有操作必須按照程序的順序來執行。+(不管程序是否同步)所有線程都只能看到一個單一的操作執行順序。在順序一致性內存模型中,每個操作都必須原子執行且立刻對所有線程可見。順序一致性內存模型為程序員提供的視圖如下:

圖片

圖片

在概念上,順序一致性模型有一個單一的全局內存,這個內存通過一個左右擺動的開關可以連接到任意一個線程。同時,每一個線程必須按程序的順序來執行內存讀 / 寫操作。從上圖我們可以看出,在任意時間點最多只能有一個線程可以連接到內存。當多個線程并發執行時,圖中的開關裝置能把所有線程的所有內存讀 / 寫操作串行化。

為了更好的理解,下面我們通過兩個示意圖來對順序一致性模型的特性做進一步的說明。

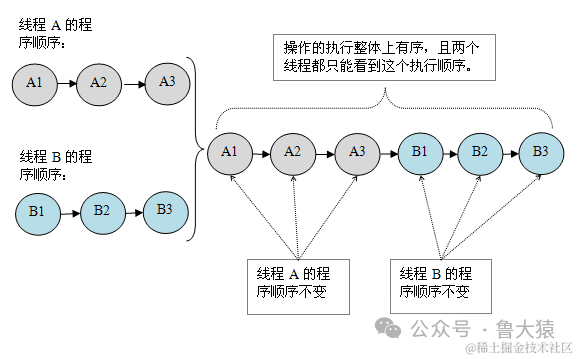

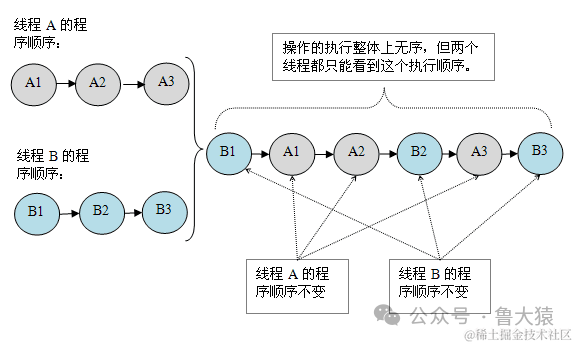

假設有兩個線程 A 和 B 并發執行。其中 A 線程有三個操作,它們在程序中的順序是:A1->A2->A3。B 線程也有三個操作,它們在程序中的順序是:B1->B2->B3。

假設這兩個線程使用監視器來正確同步:A 線程的三個操作執行后釋放監視器,隨后 B 線程獲取同一個監視器。那么程序在順序一致性模型中的執行效果將如下圖所示:

圖片

圖片

現在我們再假設這兩個線程沒有做同步,下面是這個未同步程序在順序一致性模型中的執行示意圖:

圖片

圖片

未同步程序在順序一致性模型中雖然整體執行順序是無序的,但所有線程都只能看到一個一致的整體執行順序。以上圖為例,線程 A 和 B 看到的執行順序都是:B1->A1->A2->B2->A3->B3。之所以能得到這個保證是因為順序一致性內存模型中的每個操作必須立即對任意線程可見。

但是,在 JMM 中就沒有這個保證。未同步程序在 JMM 中不但整體的執行順序是無序的,而且所有線程看到的操作執行順序也可能不一致。比如,在當前線程把寫過的數據緩存在本地內存中,且還沒有刷新到主內存之前,這個寫操作僅對當前線程可見;從其他線程的角度來觀察,會認為這個寫操作根本還沒有被當前線程執行。只有當前線程把本地內存中寫過的數據刷新到主內存之后,這個寫操作才能對其他線程可見。在這種情況下,當前線程和其它線程看到的操作執行順序將不一致。

同步程序的順序一致性效果

下面我們對前面的示例程序 ReorderExample 用監視器來同步,看看正確同步的程序如何具有順序一致性。

請看下面的示例代碼:

class SynchronizedExample {

int a = 0;

boolean flag = false;

public synchronized void writer() {

a = 1;

flag = true;

}

public synchronized void reader() {

if (flag) {

int i = a;

……

}

}

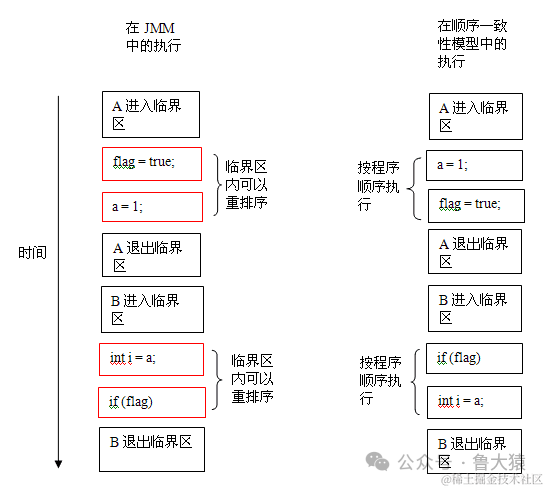

}上面示例代碼中,假設 A 線程執行 writer() 方法后,B 線程執行 reader() 方法。這是一個正確同步的多線程程序。根據 JMM 規范,該程序的執行結果將與該程序在順序一致性模型中的執行結果相同。下面是該程序在兩個內存模型中的執行時序對比圖:

圖片

圖片

在順序一致性模型中,所有操作完全按程序的順序串行執行。而在 JMM 中,臨界區內的代碼可以重排序(但 JMM 不允許臨界區內的代碼“逸出”到臨界區之外,那樣會破壞監視器的語義)。JMM 會在退出監視器和進入監視器這兩個關鍵時間點做一些特別處理,使得線程在這兩個時間點具有與順序一致性模型相同的內存視圖(具體細節后文會說明)。雖然線程 A 在臨界區內做了重排序,但由于監視器的互斥執行的特性,這里的線程 B 根本無法“觀察”到線程 A 在臨界區內的重排序。這種重排序既提高了執行效率,又沒有改變程序的執行結果。

從這里我們可以看到 JMM 在具體實現上的基本方針:在不改變(正確同步的)程序執行結果的前提下,盡可能的為編譯器和處理器的優化打開方便之門。

未同步程序的執行特性

對于未同步或未正確同步的多線程程序,JMM 只提供最小安全性:線程執行時讀取到的值,要么是之前某個線程寫入的值,要么是默認值(0,null,false),JMM 保證線程讀操作讀取到的值不會無中生有(out of thin air)的冒出來。為了實現最小安全性,JVM 在堆上分配對象時,首先會清零內存空間,然后才會在上面分配對象(JVM 內部會同步這兩個操作)。因此,在以清零的內存空間(pre-zeroed memory)分配對象時,域的默認初始化已經完成了。

JMM 不保證未同步程序的執行結果與該程序在順序一致性模型中的執行結果一致。因為未同步程序在順序一致性模型中執行時,整體上是無序的,其執行結果無法預知。保證未同步程序在兩個模型中的執行結果一致毫無意義。

和順序一致性模型一樣,未同步程序在 JMM 中的執行時,整體上也是無序的,其執行結果也無法預知。同時,未同步程序在這兩個模型中的執行特性有下面幾個差異:

- 順序一致性模型保證單線程內的操作會按程序的順序執行,而 JMM 不保證單線程內的操作會按程序的順序執行(比如上面正確同步的多線程程序在臨界區內的重排序)。這一點前面已經講過了,這里就不再贅述。

- 順序一致性模型保證所有線程只能看到一致的操作執行順序,而 JMM 不保證所有線程能看到一致的操作執行順序。這一點前面也已經講過,這里就不再贅述。

- JMM 不保證對 64 位的 long 型和 double 型變量的讀 / 寫操作具有原子性,而順序一致性模型保證對所有的內存讀 / 寫操作都具有原子性。

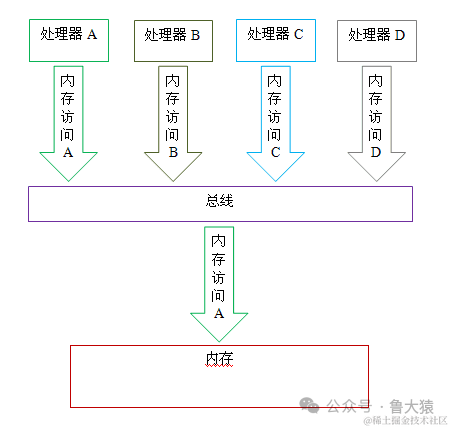

第 3 個差異與處理器總線的工作機制密切相關。在計算機中,數據通過總線在處理器和內存之間傳遞。每次處理器和內存之間的數據傳遞都是通過一系列步驟來完成的,這一系列步驟稱之為總線事務(bus transaction)。總線事務包括讀事務(read transaction)和寫事務(write transaction)。讀事務從內存傳送數據到處理器,寫事務從處理器傳送數據到內存,每個事務會讀 / 寫內存中一個或多個物理上連續的字。這里的關鍵是,總線會同步試圖并發使用總線的事務。在一個處理器執行總線事務期間,總線會禁止其它所有的處理器和 I/O 設備執行內存的讀 / 寫。下面讓我們通過一個示意圖來說明總線的工作機制:

圖片

圖片

如上圖所示,假設處理器 A,B 和 C 同時向總線發起總線事務,這時總線仲裁(bus arbitration)會對競爭作出裁決,這里我們假設總線在仲裁后判定處理器 A 在競爭中獲勝(總線仲裁會確保所有處理器都能公平的訪問內存)。此時處理器 A 繼續它的總線事務,而其它兩個處理器則要等待處理器 A 的總線事務完成后才能開始再次執行內存訪問。假設在處理器 A 執行總線事務期間(不管這個總線事務是讀事務還是寫事務),處理器 D 向總線發起了總線事務,此時處理器 D 的這個請求會被總線禁止。

總線的這些工作機制可以把所有處理器對內存的訪問以串行化的方式來執行;在任意時間點,最多只能有一個處理器能訪問內存。這個特性確保了單個總線事務之中的內存讀 / 寫操作具有原子性。

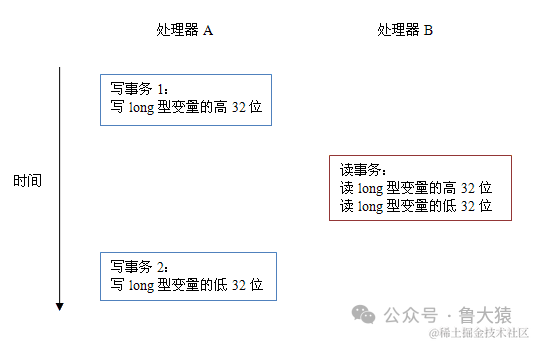

在一些 32 位的處理器上,如果要求對 64 位數據的讀 / 寫操作具有原子性,會有比較大的開銷。為了照顧這種處理器,java 語言規范鼓勵但不強求 JVM 對 64 位的 long 型變量和 double 型變量的讀 / 寫具有原子性。當 JVM 在這種處理器上運行時,會把一個 64 位 long/ double 型變量的讀 / 寫操作拆分為兩個 32 位的讀 / 寫操作來執行。這兩個 32 位的讀 / 寫操作可能會被分配到不同的總線事務中執行,此時對這個 64 位變量的讀 / 寫將不具有原子性。

當單個內存操作不具有原子性,將可能會產生意想不到后果。請看下面示意圖:

圖片

圖片

如上圖所示,假設處理器 A 寫一個 long 型變量,同時處理器 B 要讀這個 long 型變量。處理器 A 中 64 位的寫操作被拆分為兩個 32 位的寫操作,且這兩個 32 位的寫操作被分配到不同的寫事務中執行。同時處理器 B 中 64 位的讀操作被拆分為兩個 32 位的讀操作,且這兩個 32 位的讀操作被分配到同一個的讀事務中執行。當處理器 A 和 B 按上圖的時序來執行時,處理器 B 將看到僅僅被處理器 A“寫了一半“的無效值。

總結

處理器內存模型

順序一致性內存模型是一個理論參考模型,JMM 和處理器內存模型在設計時通常會把順序一致性內存模型作為參照。JMM 和處理器內存模型在設計時會對順序一致性模型做一些放松,因為如果完全按照順序一致性模型來實現處理器和 JMM,那么很多的處理器和編譯器優化都要被禁止,這對執行性能將會有很大的影響。

根據對不同類型讀 / 寫操作組合的執行順序的放松,可以把常見處理器的內存模型劃分為下面幾種類型:

- 放松程序中寫 - 讀操作的順序,由此產生了 total store ordering 內存模型(簡稱為 TSO)。

- 在前面 1 的基礎上,繼續放松程序中寫 - 寫操作的順序,由此產生了 partial store order 內存模型(簡稱為 PSO)。

- 在前面 1 和 2 的基礎上,繼續放松程序中讀 - 寫和讀 - 讀操作的順序,由此產生了 relaxed memory order 內存模型(簡稱為 RMO)和 PowerPC 內存模型。

注意,這里處理器對讀 / 寫操作的放松,是以兩個操作之間不存在數據依賴性為前提的(因為處理器要遵守 as-if-serial 語義,處理器不會對存在數據依賴性的兩個內存操作做重排序)。

下面的表格展示了常見處理器內存模型的細節特征:

內存模型名稱 | 對應的處理器 | Store-Load 重排序 | Store-Store 重排序 | Load-Load 和 Load-Store 重排序 | 可以更早讀取到其它處理器的寫 | 可以更早讀取到當前處理器的寫 |

TSO | sparc-TSO X64 | Y | Y | |||

PSO | sparc-PSO | Y | Y | Y | ||

RMO | ia64 | Y | Y | Y | Y | |

PowerPC | PowerPC | Y | Y | Y | Y | Y |

在這個表格中,我們可以看到所有處理器內存模型都允許寫 - 讀重排序,原因在第一章以說明過:它們都使用了寫緩存區,寫緩存區可能導致寫 - 讀操作重排序。同時,我們可以看到這些處理器內存模型都允許更早讀到當前處理器的寫,原因同樣是因為寫緩存區:由于寫緩存區僅對當前處理器可見,這個特性導致當前處理器可以比其他處理器先看到臨時保存在自己的寫緩存區中的寫。

上面表格中的各種處理器內存模型,從上到下,模型由強變弱。越是追求性能的處理器,內存模型設計的會越弱。因為這些處理器希望內存模型對它們的束縛越少越好,這樣它們就可以做盡可能多的優化來提高性能。

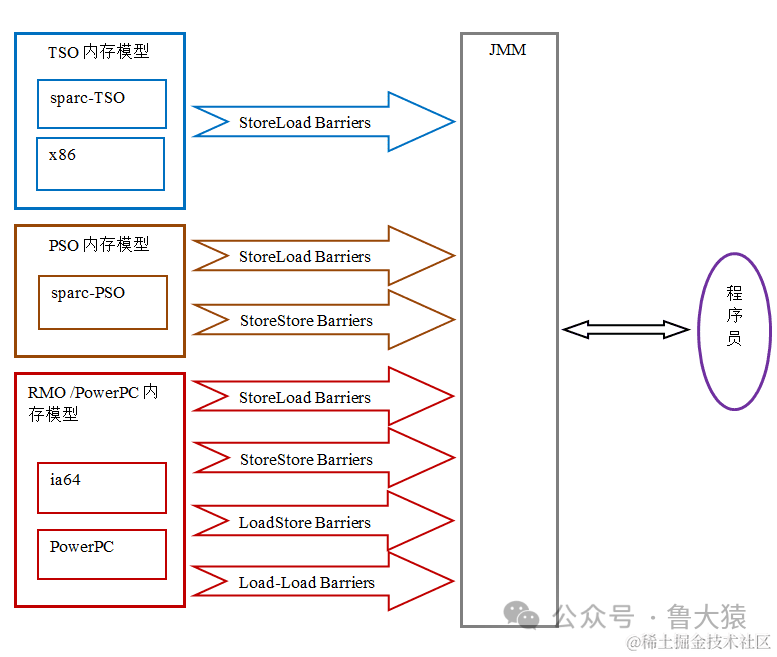

由于常見的處理器內存模型比 JMM 要弱,java 編譯器在生成字節碼時,會在執行指令序列的適當位置插入內存屏障來限制處理器的重排序。同時,由于各種處理器內存模型的強弱并不相同,為了在不同的處理器平臺向程序員展示一個一致的內存模型,JMM 在不同的處理器中需要插入的內存屏障的數量和種類也不相同。下圖展示了 JMM 在不同處理器內存模型中需要插入的內存屏障的示意圖:

圖片

圖片

如上圖所示,JMM 屏蔽了不同處理器內存模型的差異,它在不同的處理器平臺之上為 java 程序員呈現了一個一致的內存模型。

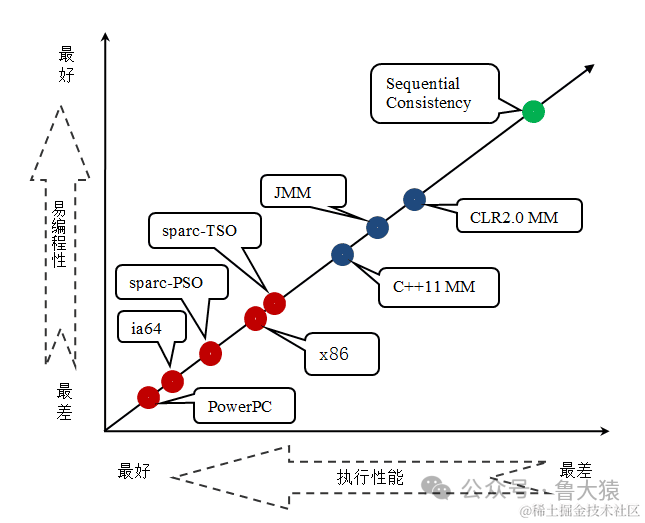

JMM,處理器內存模型與順序一致性內存模型之間的關系

JMM 是一個語言級的內存模型,處理器內存模型是硬件級的內存模型,順序一致性內存模型是一個理論參考模型。下面是語言內存模型,處理器內存模型和順序一致性內存模型的強弱對比示意圖:

圖片

圖片

從上圖我們可以看出:常見的 4 種處理器內存模型比常用的 3 中語言內存模型要弱,處理器內存模型和語言內存模型都比順序一致性內存模型要弱。同處理器內存模型一樣,越是追求執行性能的語言,內存模型設計的會越弱。

JMM 的設計

從 JMM 設計者的角度來說,在設計 JMM 時,需要考慮兩個關鍵因素:

- 程序員對內存模型的使用。程序員希望內存模型易于理解,易于編程。程序員希望基于一個強內存模型來編寫代碼。

- 編譯器和處理器對內存模型的實現。編譯器和處理器希望內存模型對它們的束縛越少越好,這樣它們就可以做盡可能多的優化來提高性能。編譯器和處理器希望實現一個弱內存模型。

由于這兩個因素互相矛盾,所以 JSR-133 專家組在設計 JMM 時的核心目標就是找到一個好的平衡點:一方面要為程序員提供足夠強的內存可見性保證;另一方面,對編譯器和處理器的限制要盡可能的放松。下面讓我們看看 JSR-133 是如何實現這一目標的。

為了具體說明,請看前面提到過的計算圓面積的示例代碼:

double pi = 3.14; //A

double r = 1.0; //B

double area = pi * r * r; //C上面計算圓的面積的示例代碼存在三個 happens- before 關系:

- A happens- before B;

- B happens- before C;

- A happens- before C;

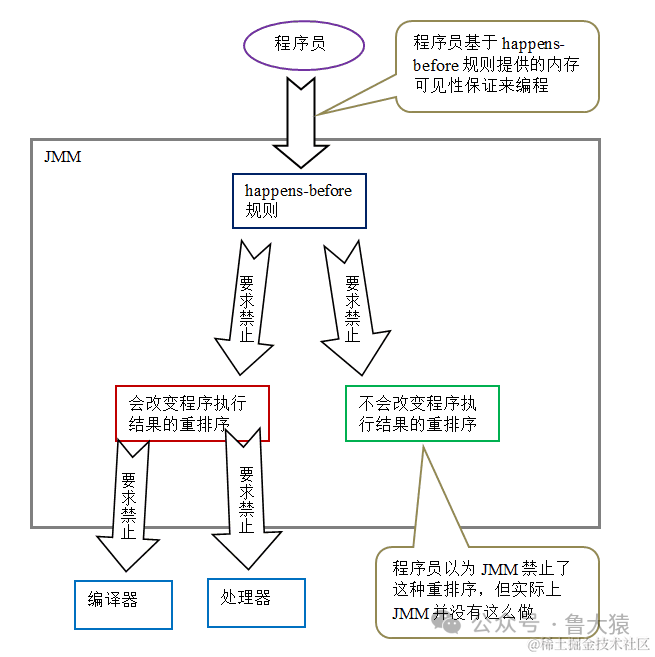

由于 A happens- before B,happens- before 的定義會要求:A 操作執行的結果要對 B 可見,且 A 操作的執行順序排在 B 操作之前。但是從程序語義的角度來說,對 A 和 B 做重排序即不會改變程序的執行結果,也還能提高程序的執行性能(允許這種重排序減少了對編譯器和處理器優化的束縛)。也就是說,上面這 3 個 happens- before 關系中,雖然 2 和 3 是必需要的,但 1 是不必要的。因此,JMM 把 happens- before 要求禁止的重排序分為了下面兩類:

- 會改變程序執行結果的重排序。

- 不會改變程序執行結果的重排序。

JMM 對這兩種不同性質的重排序,采取了不同的策略:

- 對于會改變程序執行結果的重排序,JMM 要求編譯器和處理器必須禁止這種重排序。

- 對于不會改變程序執行結果的重排序,JMM 對編譯器和處理器不作要求(JMM 允許這種重排序)。

下面是 JMM 的設計示意圖:

圖片

圖片

從上圖可以看出兩點:

- JMM 向程序員提供的 happens- before 規則能滿足程序員的需求。JMM 的 happens- before 規則不但簡單易懂,而且也向程序員提供了足夠強的內存可見性保證(有些內存可見性保證其實并不一定真實存在,比如上面的 A happens- before B)。

- JMM 對編譯器和處理器的束縛已經盡可能的少。從上面的分析我們可以看出,JMM 其實是在遵循一個基本原則:只要不改變程序的執行結果(指的是單線程程序和正確同步的多線程程序),編譯器和處理器怎么優化都行。比如,如果編譯器經過細致的分析后,認定一個鎖只會被單個線程訪問,那么這個鎖可以被消除。再比如,如果編譯器經過細致的分析后,認定一個 volatile 變量僅僅只會被單個線程訪問,那么編譯器可以把這個 volatile 變量當作一個普通變量來對待。這些優化既不會改變程序的執行結果,又能提高程序的執行效率。

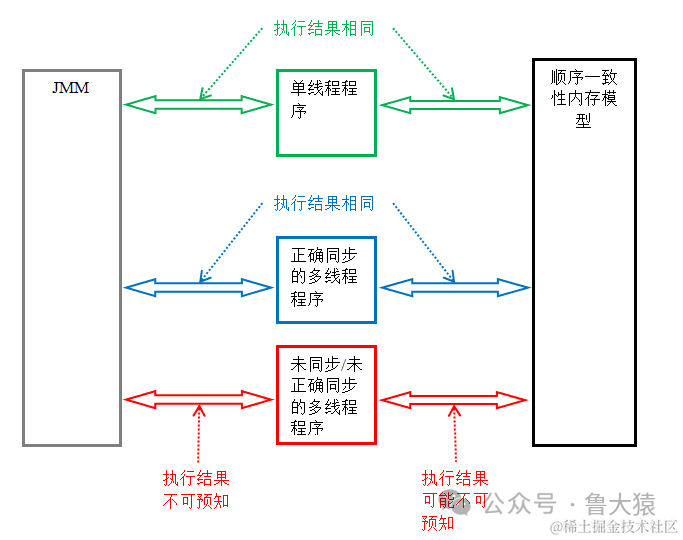

JMM 的內存可見性保證

Java 程序的內存可見性保證按程序類型可以分為下列三類:

- 單線程程序。單線程程序不會出現內存可見性問題。編譯器,runtime 和處理器會共同確保單線程程序的執行結果與該程序在順序一致性模型中的執行結果相同。

- 正確同步的多線程程序。正確同步的多線程程序的執行將具有順序一致性(程序的執行結果與該程序在順序一致性內存模型中的執行結果相同)。這是 JMM 關注的重點,JMM 通過限制編譯器和處理器的重排序來為程序員提供內存可見性保證。

- 未同步 / 未正確同步的多線程程序。JMM 為它們提供了最小安全性保障:線程執行時讀取到的值,要么是之前某個線程寫入的值,要么是默認值(0,null,false)。

下圖展示了這三類程序在 JMM 中與在順序一致性內存模型中的執行結果的異同:

圖片

圖片

只要多線程程序是正確同步的,JMM 保證該程序在任意的處理器平臺上的執行結果,與該程序在順序一致性內存模型中的執行結果一致。

JSR-133 對舊內存模型的修補

JSR-133 對 JDK5 之前的舊內存模型的修補主要有兩個:

- 增強 volatile 的內存語義。舊內存模型允許 volatile 變量與普通變量重排序。JSR-133 嚴格限制 volatile 變量與普通變量的重排序,使 volatile 的寫 - 讀和鎖的釋放 - 獲取具有相同的內存語義。

- 增強 final 的內存語義。在舊內存模型中,多次讀取同一個 final 變量的值可能會不相同。為此,JSR-133 為 final 增加了兩個重排序規則。現在,final 具有了初始化安全性。