奧特曼籌數十億美元建全球晶圓廠網絡,自造AI芯片

據彭博社消息,OpenAI CEO 薩姆?奧特曼(Sam Altman)近日再次為一家人工智能芯片企業籌集了數十億美元的資金,希望建立一個范圍覆蓋全球的晶圓廠「企業網絡(network of factories)」,并計劃與未具名的頂級芯片制造商合作。

報道稱,奧特曼已與幾家大型潛在投資者進行了談判,希望能籌集到晶圓廠所需的巨額資金。

在生成式 AI 快速爆發的時代,運行 AI 模型面臨的主要困難是算力限制。在 ChatGPT 、 DALL-E 等生成式 AI 模型的背后,研究者們投入了大量的算力資源和時間。隨著各大公司、研究機構對 AI 芯片需求的持續上升,芯片巨頭英偉達的價值更是水漲船高,去年市值首次突破 1 萬億美元,部分原因是它在芯片行業的壟斷地位 —— 眾所周知,GPT-4、Gemini、Llama 2 和其他模型嚴重依賴 H100 GPU。

日趨旺盛的高性能 AI 芯片需求正在催生出一些新的芯片創業公司。然而在更上游的位置,高端芯片的晶圓廠數量也是有限的,這促使微軟、Meta 這樣的公司需要提前數年預定產能,才能獲得足夠的新型芯片。而要與科技巨頭公司競爭,就需要大量資金來承擔費用,這是 OpenAI 所不具備的。

據報道,軟銀集團和總部位于阿布扎比的人工智能控股公司 G42 已經在討論為奧特曼的項目籌集資金的事宜。但談判仍處于早期階段,參與合作伙伴和資助者的完整名單尚未確定。

其他開發 AI 模型的公司也開始嘗試制造自己的芯片。OpenAI 的主要投資者微軟就是其中一個,該公司于去年 11 月宣布開始制造定制芯片 —— 而且它們都與人工智能有關。

由于對英偉達 H100 GPU 的需求激增,微軟的自研替代品 Azure Maia AI 芯片和 Arm 架構的 Azure Cobalt CPU 將于今年上市,該 GPU 將廣泛用于生成圖像工具和大型語言模型。當前,H100 GPU 持續處于供不應求的狀態,以至于有些 GPU 在 eBay 上的售價甚至超過了 4 萬美元。

微軟為其云基礎設施設計的兩個定制硅芯片。

緊隨其后,亞馬遜發布了新版本的 Trainium 芯片,該芯片旨在構建和運行人工智能應用程序。

此外,還有谷歌的芯片設計團隊正在使用運行在谷歌云服務器上的 DeepMind AI 來設計其張量處理單元(TPU)等人工智能處理器。

與此同時,AWS、Azure 和谷歌也使用英偉達的 H100 處理器。本周,Meta 首席執行官馬克?扎克伯格告訴 The Verge,「Meta 將購買超過 35 萬塊英偉達的 H100 GPU」,致力于開發通用人工智能,以驅動計劃中的下一代智能服務。

有第三方投資機構的研究估算,英偉達面向 Meta 的 H100 出貨量在 2023 年能達到 15 萬塊,這個數字與向微軟的出貨量持平,并且至少是其他公司的三倍。扎克伯格表示,如果算上英偉達 A100 和其他人工智能芯片,到 2024 年底,Meta 的 GPU 算力將達到等效近 60 萬 H100。

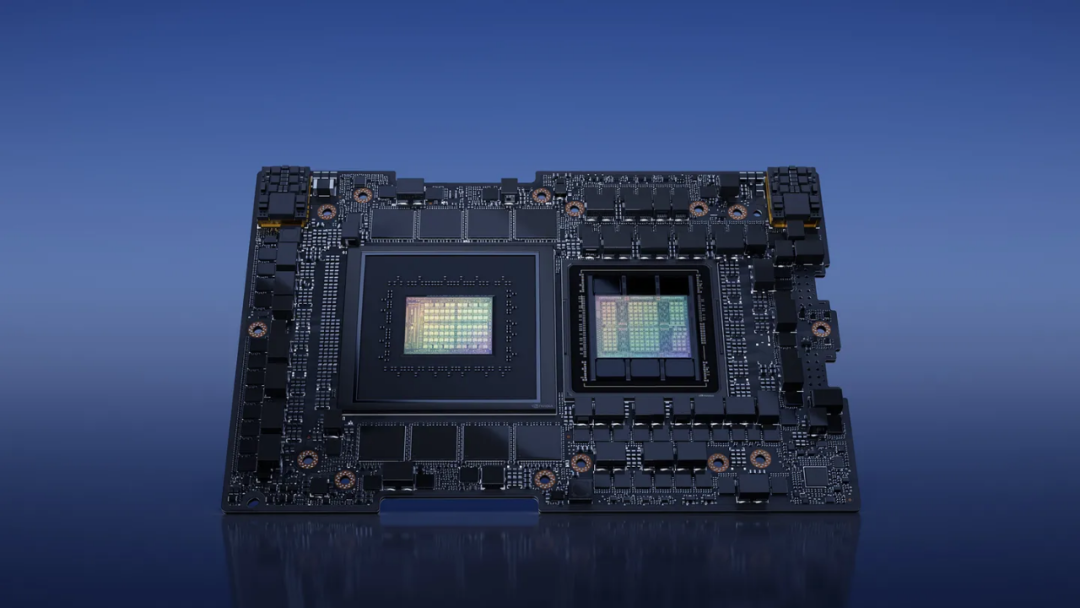

英偉達 GH200 Grace Hopper 超級芯片

面向生成式 AI 的計算,英偉達已經發布了下一代 GH200 Grace Hopper 芯片,以擴大其在該領域的主導地位,而競爭對手 AMD、高通和英特爾也推出了旨在為筆記本電腦、手機和其他設備上運行的人工智能模型提供支持的處理器。