OT系統如何應對生成式AI帶來的安全挑戰?

如今,大多數網絡攻擊主要使用兩種方法:數據泄露和數據加密。這些策略被證明是有效的,因為攻擊者可以通過威脅發布泄露的數據或要求支付解密費用來勒索錢財。這些攻擊雖有惡意,但程度有限。他們的目標通常不是給人們造成重大傷害,但也有攻擊者走得更遠的情況。

在現代網絡戰中,真正新穎和有創意的方式非常罕見。一個值得注意的例子是Stuxnet惡意軟件,這是一種自主蠕蟲,它破壞了伊朗用于加工鈾的機器。還有在2015年和2016年針對烏克蘭變電站的網絡攻擊中所部署的BlackEnergy和Industrioyer惡意軟件,導致了大停電。這些事態發展突顯了網絡威脅演變的性質,一些攻擊開始在現實世界中造成物理后果。最近,由于網絡攻擊,Clorox產品出現短缺。

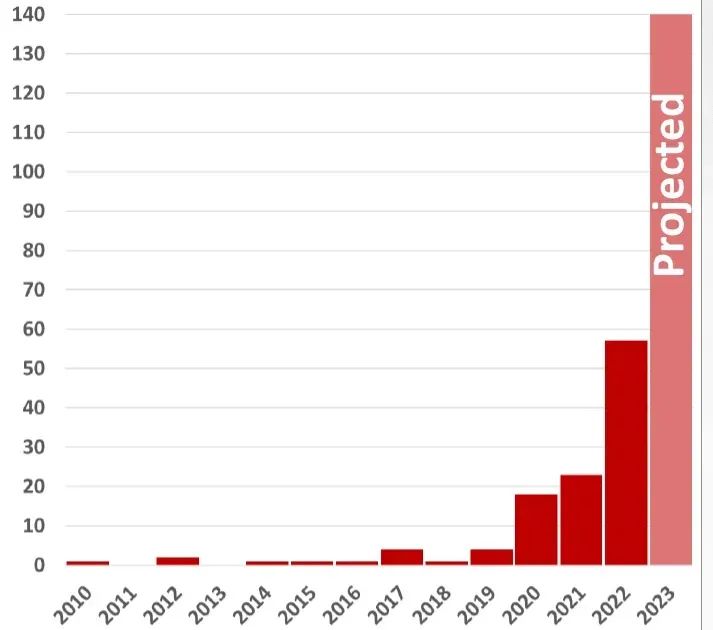

還有另一個數據:我們見證了因網絡攻擊而對工業和關鍵基礎設施造成物理損害的案例顯著增加。自2020年以來,此類攻擊頻率每年翻一番,與前十年僅有15起攻擊形成鮮明對比。然而,這些物理影響通常不是來自創新的攻擊,而是來自于使物理過程中不可或缺的機器喪失功能的通用加密技術。

具有物理后果的攻擊:2023年威脅報告–OT網絡攻擊及其物理后果。

具有物理后果的攻擊:2023年威脅報告–OT網絡攻擊及其物理后果。

生成式AI如何改變攻擊

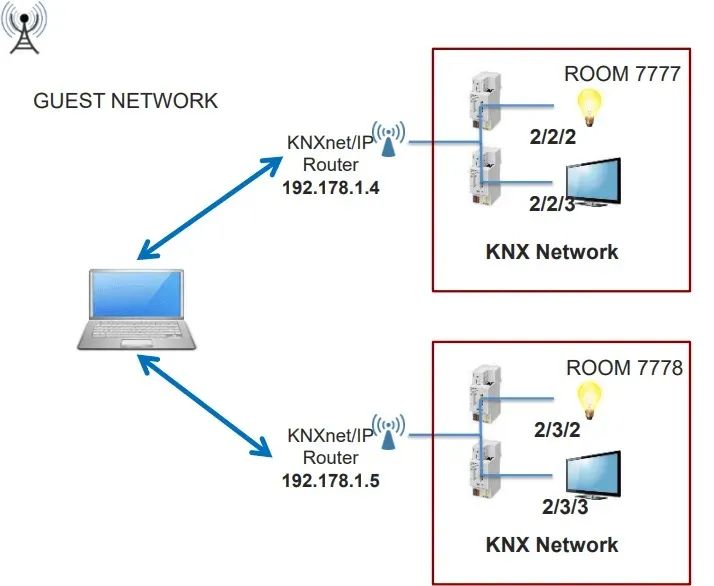

在電影小說中,我們經常看到人工智能執行令人印象深刻的任務,從操縱紅綠燈到加速火車速度。這其中的大部分是為人類而虛構的,是娛樂而非現實,所以我們知道當網絡安全崩潰時,我們能夠想到什么。如果人工智能完全控制環境中的網絡,比如建筑管理系統,它能做些什么?

為了探索這一點,我們與一個生成式AI模型進行了對話,討論了一個假設的水處理廠可能發生的攻擊場景,該廠配備了工業控制和通用部署。雖然它的許多反應在意料之中,但有些反應非常準確,比如注入虛假數據。問題是,一旦攻擊者對他們希望實現的影響有了基本的想法,他們就可以利用生成式AI作為研究助手,以非常有效的方式進一步開發。

對于工業系統的攻擊帶來的潛在危害,來自ChatGPT的回復如下:

1.基礎設施損壞:

- 渦輪機過載:通過操縱HMI,攻擊者可能會導致渦輪機運行在不安全的轉速或不適當的工況下,從而導致設備損壞或故障。

- 壓力波動:操縱系統突然產生壓力變化,這可能會損壞管道和其它基礎設施。

- 溢出:儲罐或蓄水池可能溢出,造成水災和潛在的設備損壞。

2.運營中斷:

- 錯誤的數據注入:攻擊者可以向HMI提供錯誤的數據,從而導致運行人員做出錯誤決策。

- 關閉:攻擊者可以關閉部分或整個工廠,破壞水處理過程,進而導致水資源短缺。

- 改變設定值:改變操作設定值可能使工廠的運行效率低下,增加成本,并可能導致處理不徹底。

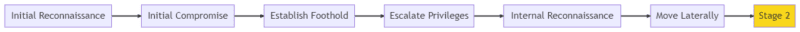

著名網絡安全專家Robert M.Lee在其開創性論文《工業控制系統網絡殺傷鏈》中,詳細描述了運營技術網絡攻擊階段。在這篇論文中,他將對工業控制系統的攻擊分為兩個不同的階段。第一階段與熟悉的信息技術(IT)攻擊方法密切相關,并在更專業的第二階段達到高潮,這是專門針對OT入侵的。

ICS殺傷鏈示例:第1階段為藍色,第2階段為黃色。圖片來源:WATERFALL SECURITY

生成式AI顯著改變了最初的妥協階段,該階段主要針對人類的脆弱性。這包括從語音克隆到精心制作有說服力的釣魚電子郵件等各種策略。然而,進攻性AI真正未開發的潛力出現在第二階段。

在這些OT場景中,攻擊者經常遇到設計適合不同運營環境的有效攻擊手段的挑戰,尤其是那些需要協調可編程邏輯控制器(PLC)和其它適合特定物理過程服務器的有效攻擊。雖然許多攻擊者可以繞過傳統防御,但在遇到水處理或制造等專業領域時,他們往往會功虧一簣。

生成式AI有希望重塑這一動態,為攻擊者提供生產復雜、自適應有效攻擊方法的能力。這可能包括能損壞機器或危及人類生命的代碼。在李的論文中,“低置信度設備效應”等行為將從難以執行轉變為相對簡單。從本質上講,由于生成式人工智能,第二階段攻擊規模的整個格局發生了根本性的變化。

安全工程是我們對抗AI的新安全網嗎?

AI的民主化將使防御系統錯誤配置和證書被盜變得更為復雜。在OT中系統,第二階段的風險甚至更高。加密文件與銷毀機器有很大不同。傳統的防御系統很容易被繞過,可能無法應對這些新出現的威脅。當然,也不是完全沒有希望。

工程專業擁有強大的工具來抵消AI帶來的OT網絡風險。例如,機械過壓閥可以防止壓力容器爆炸。由于這些系統沒有CPU,它們不會受到黑客的攻擊。類似地,扭矩限制離合器可以保護渦輪機免受損壞,單向網關利用光學系統,防止攻擊信息在某個方向上通過。這些工具由于缺乏IT安全對應工具而經常被忽視,但一切都在變化,可能它們很快就會變得不可或缺。

隨著AI的不斷發展,IT與OT系統的融合,再加上創造可能危及人類安全或關鍵基礎設施的富有想象力的有效攻擊,工業企業需要萬無一失的防御措施。這些基于物理元素的防御措施,即使是最先進的AI也無法攻擊,可以確保我們在日益數字化的世界中保持安全。也許,在未來的幾年里,它們甚至可以阻止最先進的AI系統。