火山引擎 live4D 體積視頻方案入選 SIGGRAPH Asia 2023,支持互動(dòng)體驗(yàn)

近期,SIGGRAPH Asia 2023(The 16th ACM SIGGRAPH Conference and Exhibition on Computer Graphics and Interactive Techniques in Asia)會(huì)議在澳大利亞悉尼舉辦。來(lái)自火山引擎多媒體實(shí)驗(yàn)室三維視頻團(tuán)隊(duì)的論文成功入選、并在大會(huì)上做展示匯報(bào):

Live4D: A Real-time Capture System for Streamable Volumetric Video (https://dl.acm.org/doi/10.1145/3610543.3626178)

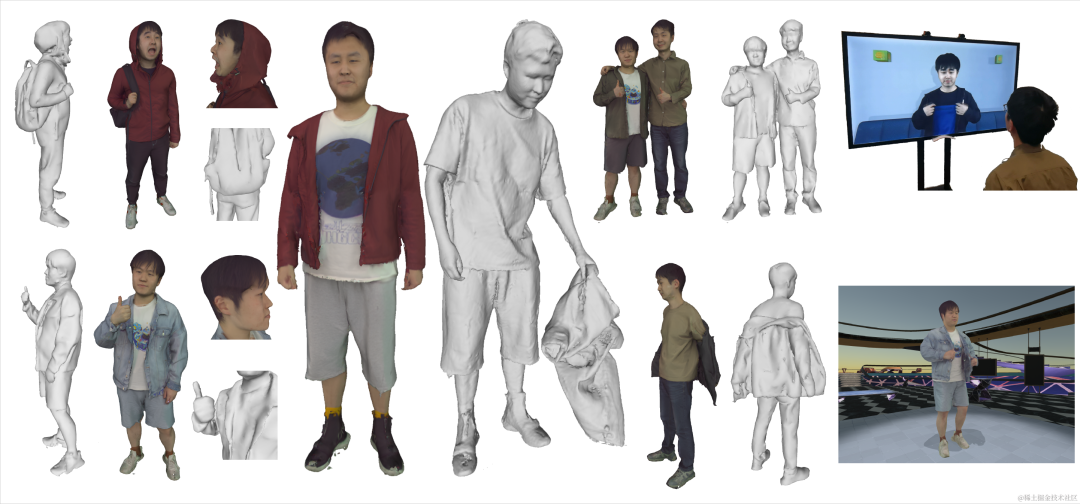

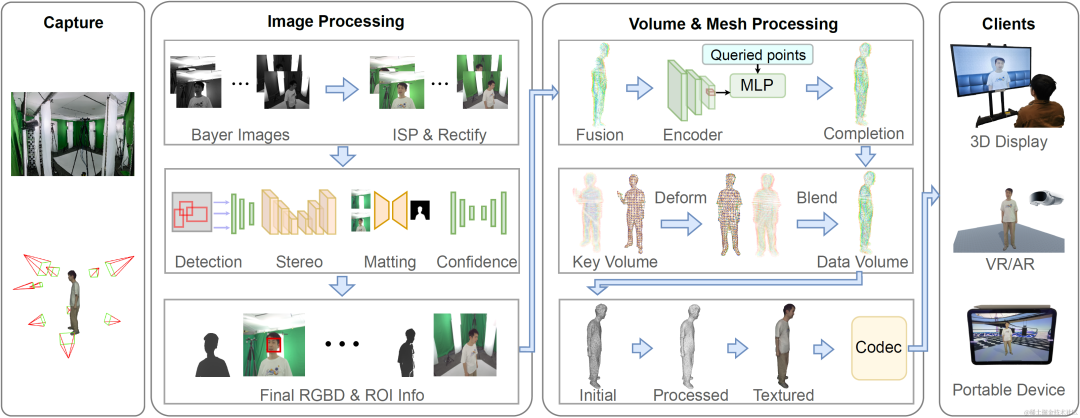

該論文介紹了一種可傳輸?shù)膶?shí)時(shí)體積視頻解決方案:Live4D。該技術(shù)利用了深度學(xué)習(xí)和計(jì)算機(jī)視覺(jué)技術(shù),通過(guò)將多個(gè)攝像機(jī)的圖像進(jìn)行同步處理,重建出捕獲對(duì)象帶有紋理信息的網(wǎng)格模型,將其進(jìn)行壓縮編碼傳輸后分發(fā)給各個(gè)客戶端進(jìn)行渲染顯示。

Live4D可以根據(jù)應(yīng)用場(chǎng)景和精度需求配置不同數(shù)量和位置的雙目RGB相機(jī),能以更低的成本實(shí)現(xiàn)體積捕獲系統(tǒng),并能夠?qū)崟r(shí)地將重建出的數(shù)據(jù)發(fā)送給用戶;同時(shí)還支持互動(dòng)和沉浸式體驗(yàn),用戶可以通過(guò)與視頻進(jìn)行互動(dòng),獲得更加身臨其境的體驗(yàn)。該技術(shù)在全息通信、虛擬現(xiàn)實(shí)、增強(qiáng)現(xiàn)實(shí)和遠(yuǎn)程教育等領(lǐng)域具有廣泛的應(yīng)用前景。

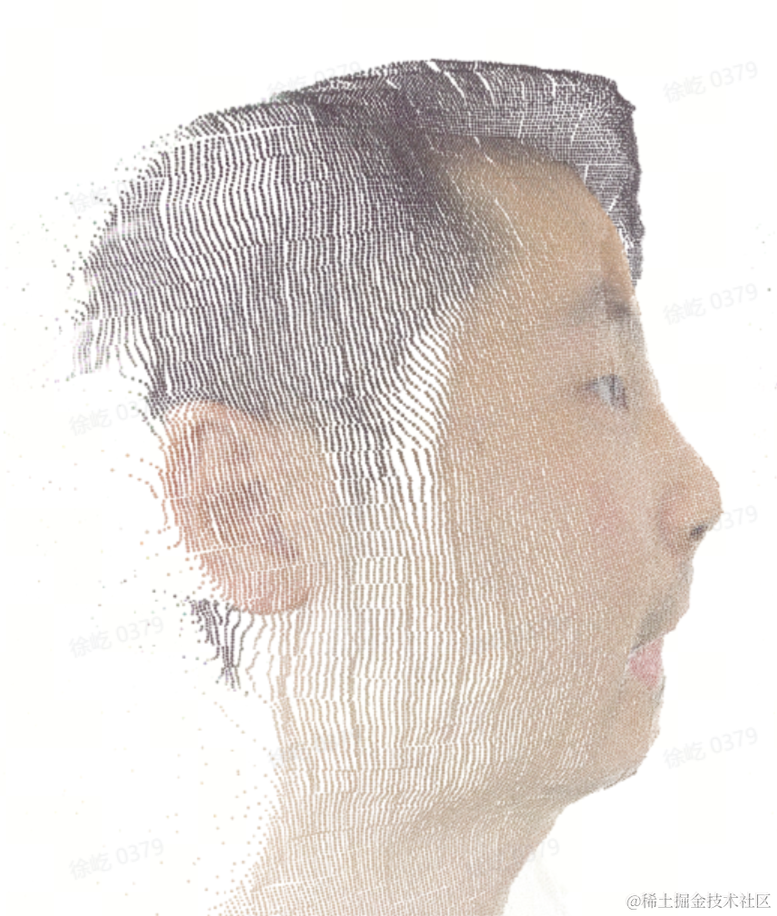

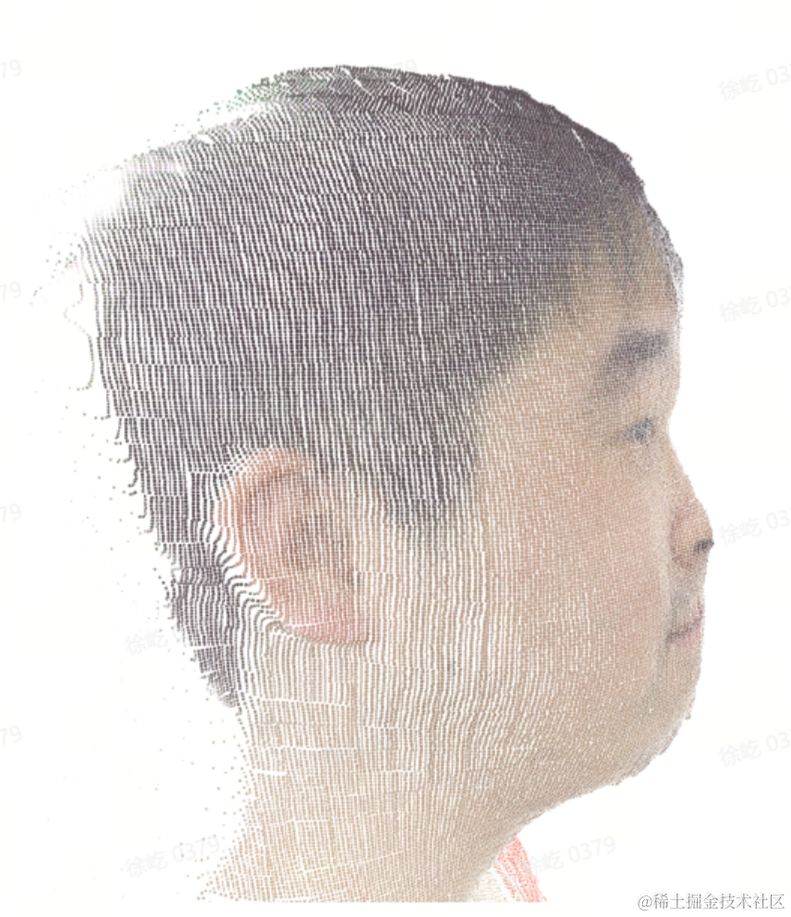

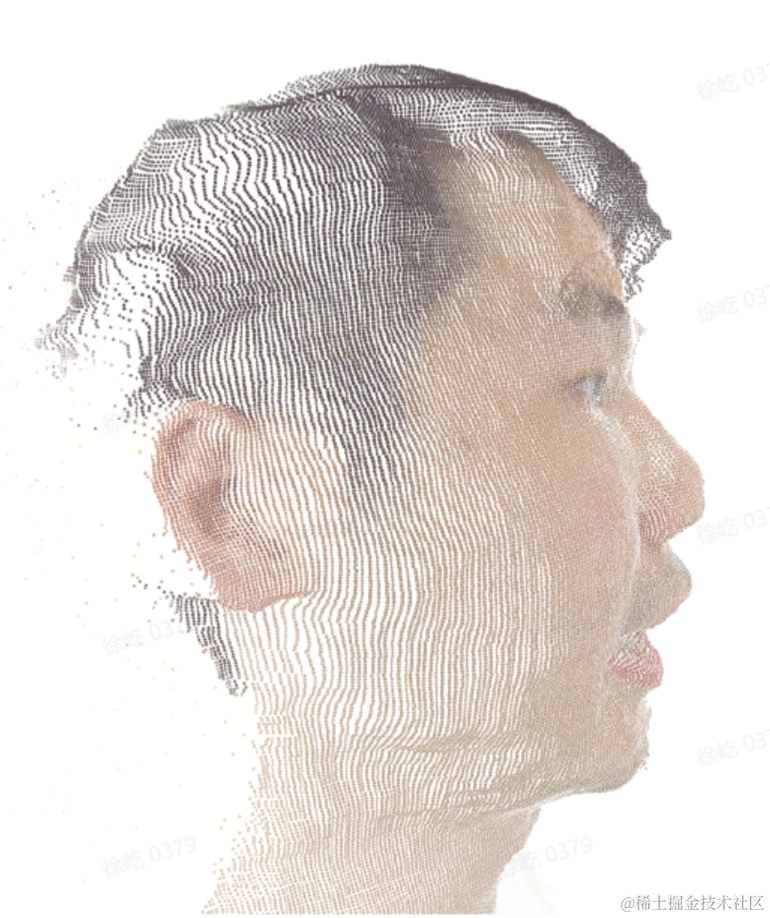

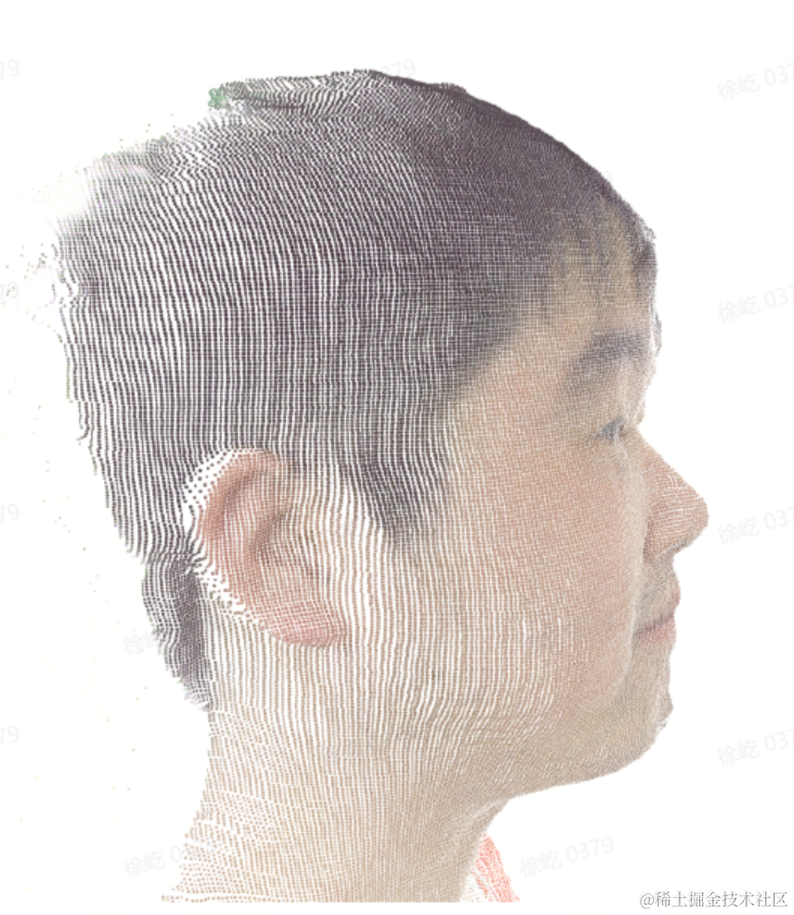

Live4D Showcase

Live4D Showcase

技術(shù)挑戰(zhàn)

體積視頻可以看做是傳統(tǒng)視頻的升級(jí)。傳統(tǒng)視頻播放每秒30幀的畫面,而體積視頻則播放每秒30個(gè)3D模型。因此,觀眾可以自由選擇從任意視角、任意距離(6 degrees of freedom,即6Dof)觀看體積視頻中的內(nèi)容;可以在手機(jī)或電腦屏幕上觀看、也可以通過(guò)VR/AR眼鏡觀看。

當(dāng)前已有的一些體積視頻方案,其場(chǎng)景設(shè)置需要上百個(gè)相機(jī)同時(shí)捕獲數(shù)據(jù),成本高昂且大部分實(shí)時(shí)重建方案效果仍有較大瑕疵。

Live4D解決方案

三維數(shù)據(jù)的獲取

在實(shí)驗(yàn)配置中,技術(shù)團(tuán)隊(duì)使用了10組雙目RGB相機(jī)來(lái)同步捕獲全身數(shù)據(jù),以此來(lái)獲取實(shí)驗(yàn)數(shù)據(jù)。為了獲取相機(jī)視角下的深度信息,團(tuán)隊(duì)采用了基于深度學(xué)習(xí)的雙目立體匹配方法,這是目前常用的方法之一。由于現(xiàn)有的方法在耗時(shí)和質(zhì)量上不能完全滿足技術(shù)團(tuán)隊(duì)的要求,團(tuán)隊(duì)基于RAFT-Stereo[1] 對(duì)其進(jìn)行了蒸餾訓(xùn)練,以此來(lái)獲取實(shí)時(shí)推理中更準(zhǔn)確的深度。同時(shí),技術(shù)團(tuán)隊(duì)還利用TensorRT和自定義的CUDA算子對(duì)整個(gè)框架進(jìn)行加速,以此來(lái)達(dá)到所需的時(shí)間和精度。

Live4D Pipeline

Live4D Pipeline

為了進(jìn)一步提升人臉區(qū)域的深度精度,在雙目立體匹配中,技術(shù)團(tuán)隊(duì)設(shè)計(jì)了一種基于強(qiáng)化感興趣區(qū)域 (Region of Interest, ROI)的方法來(lái)更精細(xì)地獲取該區(qū)域的深度信息,并將其與原先圖像進(jìn)行融合,以得到質(zhì)量更高的深度圖。技術(shù)團(tuán)隊(duì)還設(shè)計(jì)了背景摳圖和深度置信度檢測(cè)的方法,將背景和不可信的深度進(jìn)行過(guò)濾,以此來(lái)得到最終的深度圖,并將其與對(duì)應(yīng)的RGB一起送入后續(xù)的重建流程。

無(wú)ROI |

|

|

強(qiáng)化ROI |

|

|

TSDF重建與補(bǔ)全

獲取多個(gè)視角的RGB和深度圖后,技術(shù)團(tuán)隊(duì)在空間中構(gòu)建一個(gè)容器,離散化分割成更小的體素。為了獲取更精細(xì)的結(jié)果,需要大量且細(xì)小的體素,但身體等非ROI區(qū)域會(huì)浪費(fèi)較多空間和計(jì)算資源。因此,團(tuán)隊(duì)采取了層級(jí)式的數(shù)據(jù)結(jié)構(gòu),讓ROI區(qū)域有更細(xì)粒度的體素分布,而在其他區(qū)域每個(gè)體素可以有更大的物理尺寸。這樣可以在減少資源消耗的情況下增加ROI區(qū)域的細(xì)節(jié)表達(dá)。

![圖片 Left: Same Voxel@[8mm], Right: Hierarchy Voxel@[4m](https://s8.51cto.com/oss/202401/31/d43bdf4754da60884dc501fd3d02d9d4e6e10d.png) Left: Same Voxel@[8mm], Right: Hierarchy Voxel@[4m

Left: Same Voxel@[8mm], Right: Hierarchy Voxel@[4m

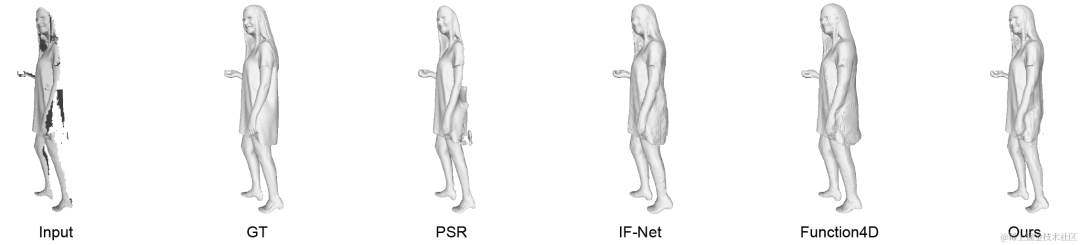

技術(shù)團(tuán)隊(duì)將多個(gè)視角的深度圖反投到容器中,將其轉(zhuǎn)換為截?cái)喾?hào)距離,并通過(guò)多視角融合和幾何一致性校驗(yàn)等方式,將這些深度圖轉(zhuǎn)換為基于截?cái)喾?hào)距離的表示,即截?cái)喾?hào)距離場(chǎng)(Truncated Signed Distance Field, TSDF)。由于視角稀疏、觀測(cè)模型存在自遮擋等問(wèn)題,重建出的TSDF場(chǎng)存在很多缺失。因此,技術(shù)團(tuán)隊(duì)提出了一種基于TSDF Volume的補(bǔ)全方法,利用在構(gòu)造的數(shù)據(jù)集中預(yù)訓(xùn)練好的三維深度神經(jīng)網(wǎng)絡(luò),快速地對(duì)缺失的區(qū)域進(jìn)行補(bǔ)全。相比于其他基于Occupancy的方法,該團(tuán)隊(duì)的方法擁有更好的補(bǔ)全效果,并且相比于Function4D[2] 等提取圖片信息處理的方案來(lái)說(shuō),該團(tuán)隊(duì)提出的方法速度也有所提升。

補(bǔ)全方法對(duì)比

補(bǔ)全方法對(duì)比

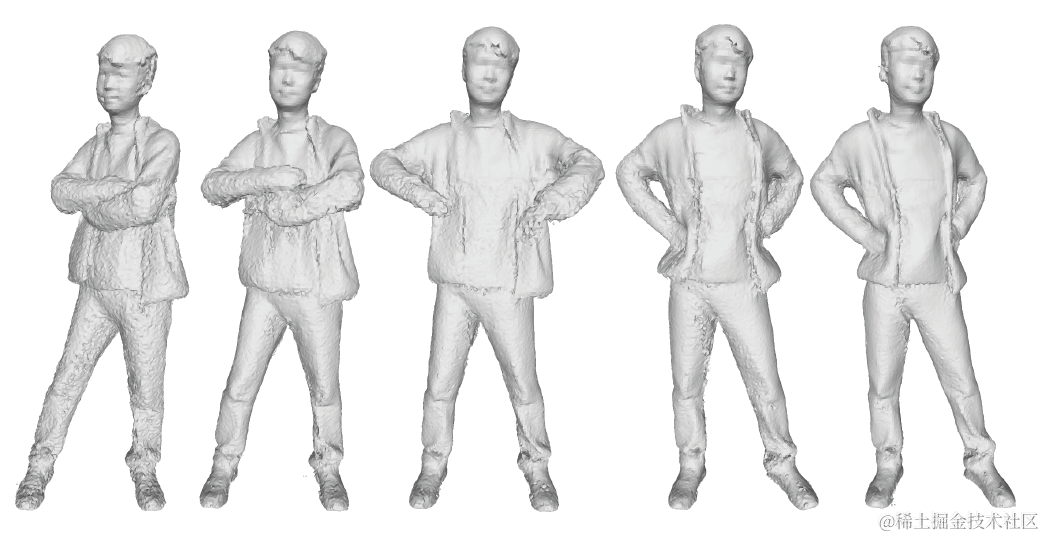

非剛性追蹤

體積視頻和視頻一樣,也需要追求其時(shí)域穩(wěn)定性。由于體積視頻每一幀實(shí)際上是一個(gè)包含貼圖的三維網(wǎng)格模型,因此技術(shù)團(tuán)隊(duì)利用非剛性追蹤 (Non-Rigid Tracking) 的方法來(lái)保持三角形網(wǎng)格在時(shí)序上的一致性。

技術(shù)團(tuán)隊(duì)基于嵌入形變關(guān)鍵點(diǎn)(Embedded Deformation Nodes (EDNodes))[3] 來(lái)表達(dá)重建物體表面整體的形變場(chǎng)(deformation field)。整個(gè)計(jì)算過(guò)程通過(guò)在GPU上使用LM(Levenberg-Marquard)算法來(lái)求解局部ICP問(wèn)題來(lái)高效地計(jì)算。利用形變場(chǎng),技術(shù)團(tuán)隊(duì)將每個(gè)體素拆分成的四面體 (Tetrahedra) 柵格,進(jìn)行時(shí)域上的TSDF場(chǎng)的混合,來(lái)完成時(shí)域的均值濾波,使得隱表面重建在時(shí)域穩(wěn)定。

Left->Right: 隨時(shí)序Mesh變穩(wěn)定

Left->Right: 隨時(shí)序Mesh變穩(wěn)定

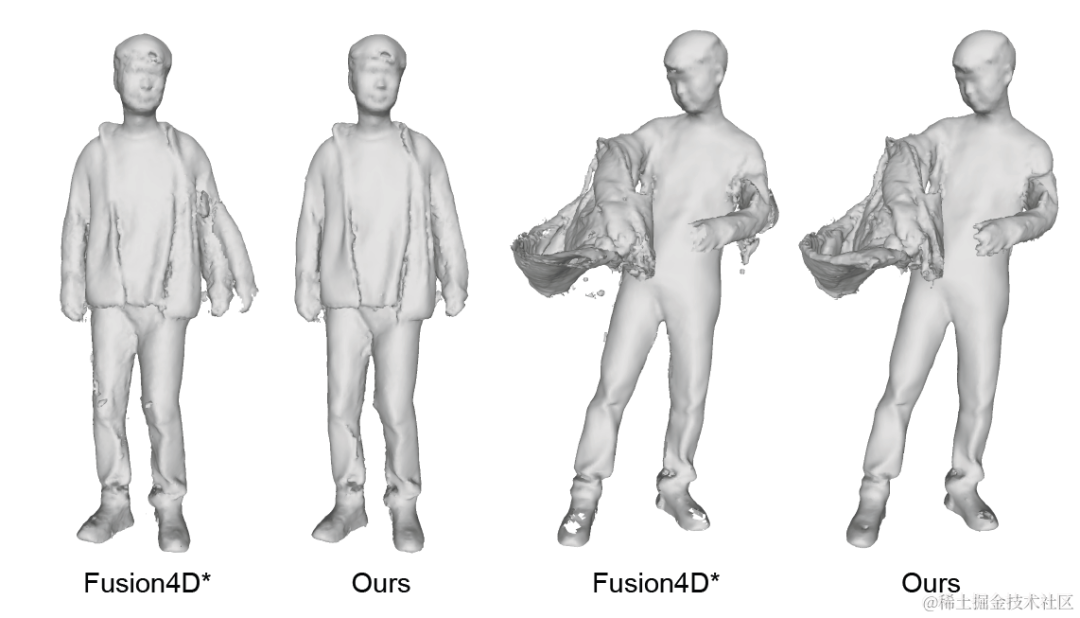

另一個(gè)問(wèn)題是如Fusion4D[4] 等tracking方法在前后幀運(yùn)動(dòng)差距過(guò)大時(shí)會(huì)出現(xiàn)tracking失敗的情況,而出現(xiàn)這種情況會(huì)導(dǎo)致最終重建出的三角形網(wǎng)格有非常嚴(yán)重的錯(cuò)誤。具體來(lái)說(shuō),技術(shù)團(tuán)隊(duì)會(huì)評(píng)估變形后的TSDF場(chǎng)與補(bǔ)全后的TSDF場(chǎng)之間的每個(gè)體素對(duì)齊誤差,對(duì)于未對(duì)齊的voxel認(rèn)為其是追蹤失敗的部份,對(duì)于這些voxel,團(tuán)隊(duì)更信賴補(bǔ)全的結(jié)果而不是tracking的結(jié)果。用這種融合方式,對(duì)于上述提到的運(yùn)動(dòng)差距過(guò)大導(dǎo)致追蹤失敗的場(chǎng)景也能有較好的結(jié)果。

追蹤失敗情況與Fusion4D方法的對(duì)比

追蹤失敗情況與Fusion4D方法的對(duì)比

紋理生成

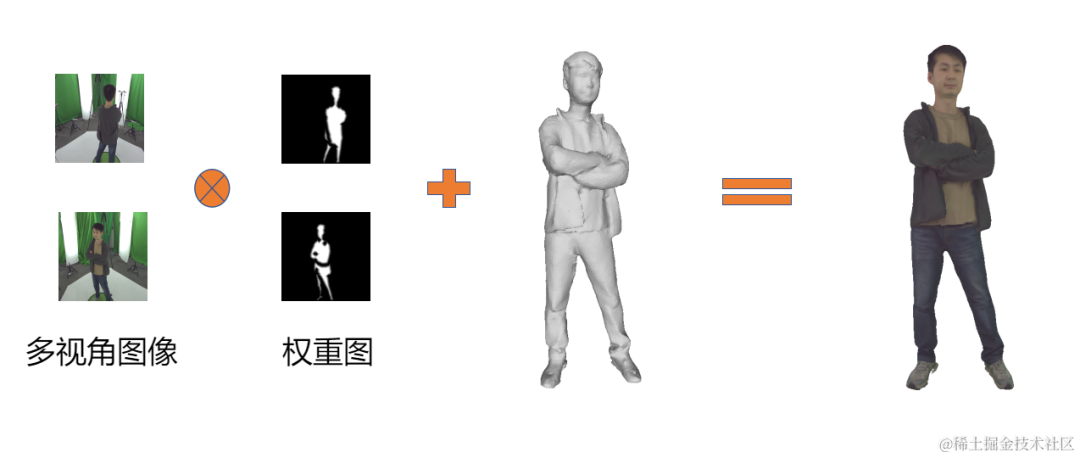

紋理生成需要解決兩個(gè)問(wèn)題,一個(gè)是計(jì)算出網(wǎng)格模型表面任意一點(diǎn)的顏色;另外就是計(jì)算出三維網(wǎng)格到二維圖像的映射,將計(jì)算出的顏色存放在二維圖像上便于傳輸與圖形管線的渲染。

多視圖紋理混合

多視圖紋理混合

首先是計(jì)算網(wǎng)格模型表面的顏色。技術(shù)團(tuán)隊(duì)使用多視圖混合算法來(lái)計(jì)算紋理,綜合考慮著色邊界及法線方向來(lái)設(shè)計(jì)了一種混合權(quán)重,消除了多視角混合中的色差、接縫等紋理生成質(zhì)量的問(wèn)題。

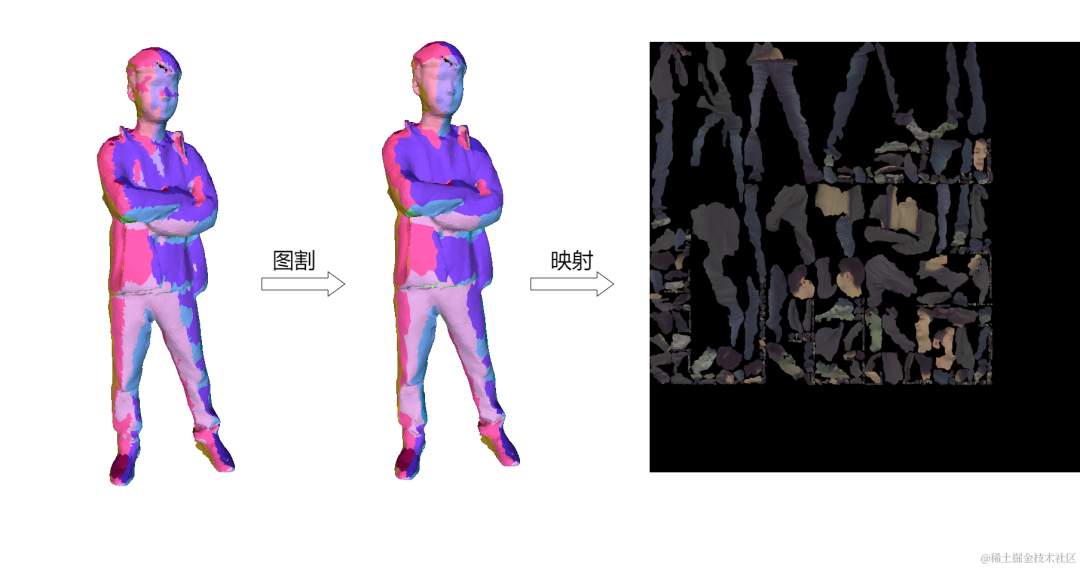

曲面重參數(shù)化圖片

曲面重參數(shù)化圖片

同時(shí)技術(shù)團(tuán)隊(duì)設(shè)計(jì)了一個(gè)可并行的高效重參數(shù)化算法,通過(guò)對(duì)球面采樣來(lái)預(yù)設(shè)正交投影方向,重建模型執(zhí)行深度剝離(depth peeling)算法來(lái)劃分可視層級(jí)。通過(guò)投影方向和可視層級(jí)來(lái)標(biāo)記面片所屬的標(biāo)簽。對(duì)所有面片的所有候選標(biāo)簽執(zhí)行圖割(Graph-cut)算法來(lái)劃分網(wǎng)格模型表面的連通域。團(tuán)隊(duì)對(duì)網(wǎng)格模型構(gòu)建半邊結(jié)構(gòu),并實(shí)現(xiàn)并行帶環(huán)信念傳播(Loopy blief propagation)算法來(lái)優(yōu)化求得近似最優(yōu)解。對(duì)于所有連通域,技術(shù)團(tuán)隊(duì)使用平面重參數(shù)方法并將其映射并排列得到最終的紋理貼圖。

壓縮及傳輸

直接重建出的網(wǎng)格點(diǎn)面數(shù)量巨大,可達(dá)百萬(wàn)面片, 為了便于網(wǎng)絡(luò)傳輸,減少帶寬占用,需要對(duì)三維重建結(jié)果進(jìn)行簡(jiǎn)化和壓縮。除了簡(jiǎn)化的時(shí)候盡量保持原有的幾何特征要求以外,在當(dāng)前場(chǎng)景下,對(duì)簡(jiǎn)化算法的實(shí)時(shí)性,臉部等ROI區(qū)域的幾何特征保持都有著要求。

- 團(tuán)隊(duì)開發(fā)了一套帶ROI信息的GPU簡(jiǎn)化算法, 并行取多組邊評(píng)估其二次方度量誤差,選出每組中誤差最小的邊進(jìn)行坍縮。同時(shí)提高ROI區(qū)域內(nèi)的邊的誤差等級(jí)以減少ROI區(qū)域的簡(jiǎn)化損失。

- Draco&H265壓縮傳輸,網(wǎng)格信息同步于SEI中

采用Draco[5] ,利用連通性、量化、熵編碼等手段,進(jìn)一步對(duì)簡(jiǎn)化的mesh的面和點(diǎn)的信息壓縮成二進(jìn)制流。紋理貼圖則采用H.265進(jìn)行圖像編碼。技術(shù)團(tuán)隊(duì)將同步的網(wǎng)格信息存放在視頻流的SEI中,復(fù)用現(xiàn)在的RTC管線就可以完成三維數(shù)據(jù)的傳輸。

幀率 | 整體帶寬 | Mesh帶寬 | 紋理帶寬 | 算法延時(shí) |

~30fps | 15~20Mbps | ~12Mbps | ~8Mbps | ~100ms |

應(yīng)用落地和展望

該技術(shù)方案支持多種終端設(shè)備實(shí)時(shí)觀看,有著廣泛的落地前景,如基于3D電視實(shí)現(xiàn)全息通信,提升遠(yuǎn)程辦公、遠(yuǎn)程交流的效率與沉浸感;如自由視角直播,加強(qiáng)主播與觀眾的聯(lián)系,創(chuàng)造各種互動(dòng)玩法;在文娛、教育等場(chǎng)景中也提供了新的媒體形式。

關(guān)于火山引擎多媒體實(shí)驗(yàn)室

火山引擎多媒體實(shí)驗(yàn)室是字節(jié)跳動(dòng)旗下的研究團(tuán)隊(duì),致力于探索多媒體領(lǐng)域的前沿技術(shù),參與國(guó)際標(biāo)準(zhǔn)化工作,其眾多創(chuàng)新算法及軟硬件解決方案已經(jīng)廣泛應(yīng)用在抖音、西瓜視頻等產(chǎn)品的多媒體業(yè)務(wù),并向火山引擎的企業(yè)級(jí)客戶提供技術(shù)服務(wù)。實(shí)驗(yàn)室成立以來(lái),多篇論文入選國(guó)際頂會(huì)和旗艦期刊,并獲得數(shù)項(xiàng)國(guó)際級(jí)技術(shù)賽事冠軍、行業(yè)創(chuàng)新獎(jiǎng)及最佳論文獎(jiǎng)。

Reference

[1] RAFT-Stereo: Multilevel Recurrent Field Transforms for Stereo Matching, 3DV 2021

[2] Function4D: Real-time Human Volumetric Capture from Very Sparse Consumer RGBD Sensors, CVPR 2021

[3] Embedded Deformation for Shape Manipulation, SIGGRAPH 2007

[4] Fusion4D: Real-time Performance Capture of Challenging Scenes, ToG 2016

[5] Draco, https://github.com/google/draco