魚眼相機與超聲波傳感器融合實現鳥瞰近場障礙物感知

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

- 論文鏈接:https://browse.arxiv.org/pdf/2402.00637.pdf

- 視頻鏈接:https://youtu.be/JmSLBBL9Ruo

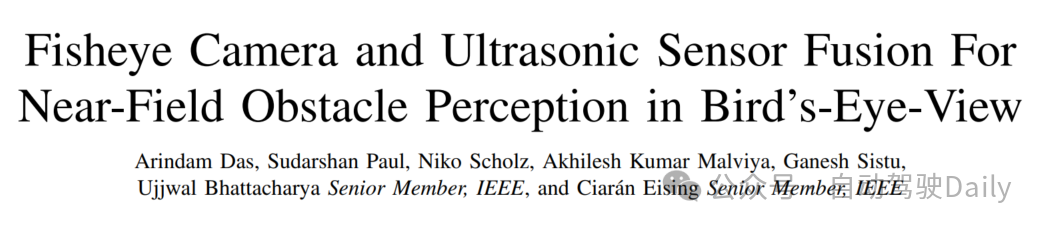

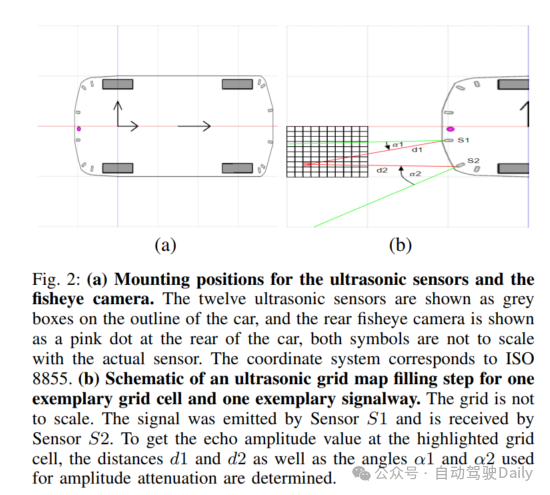

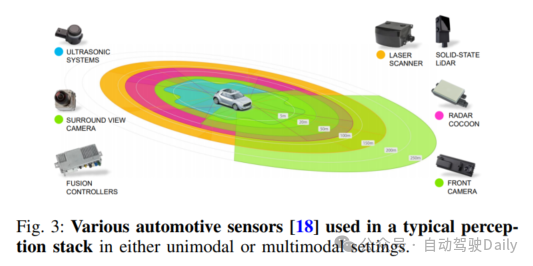

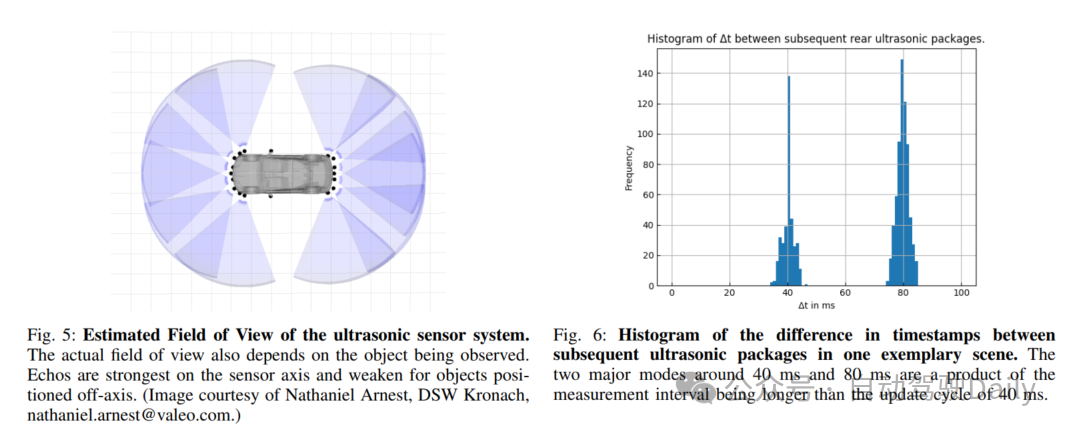

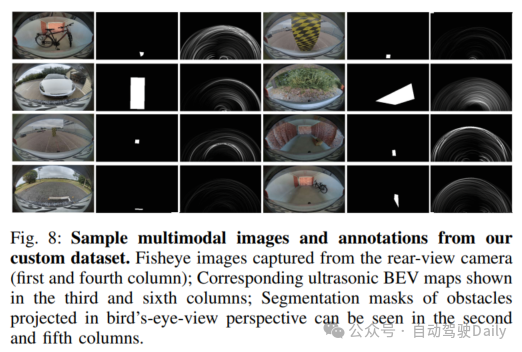

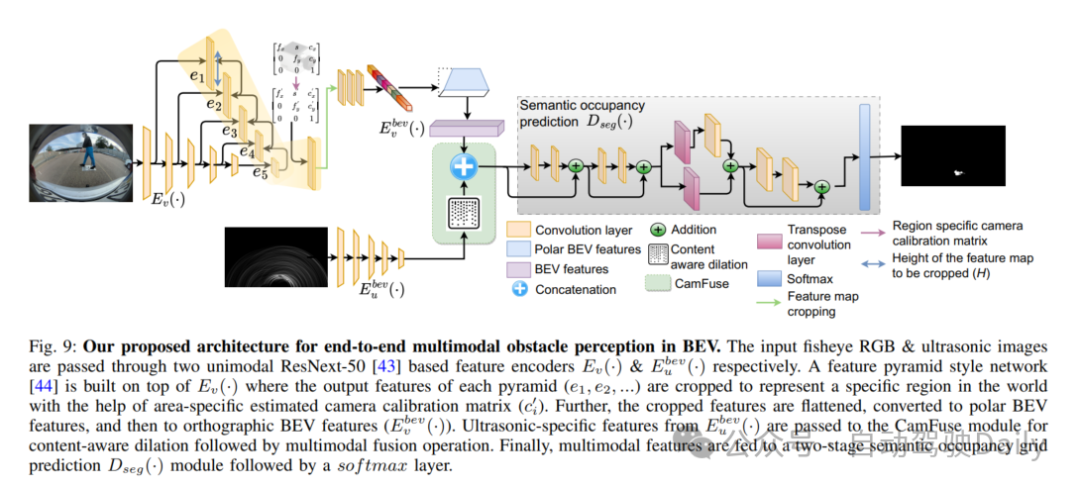

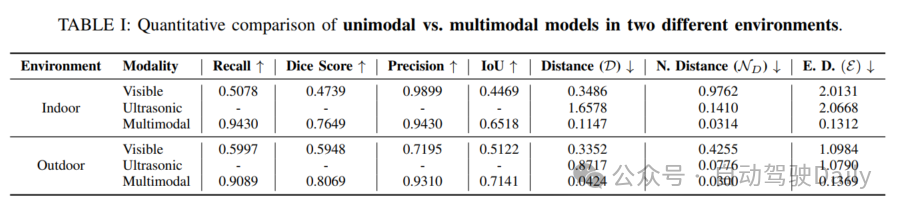

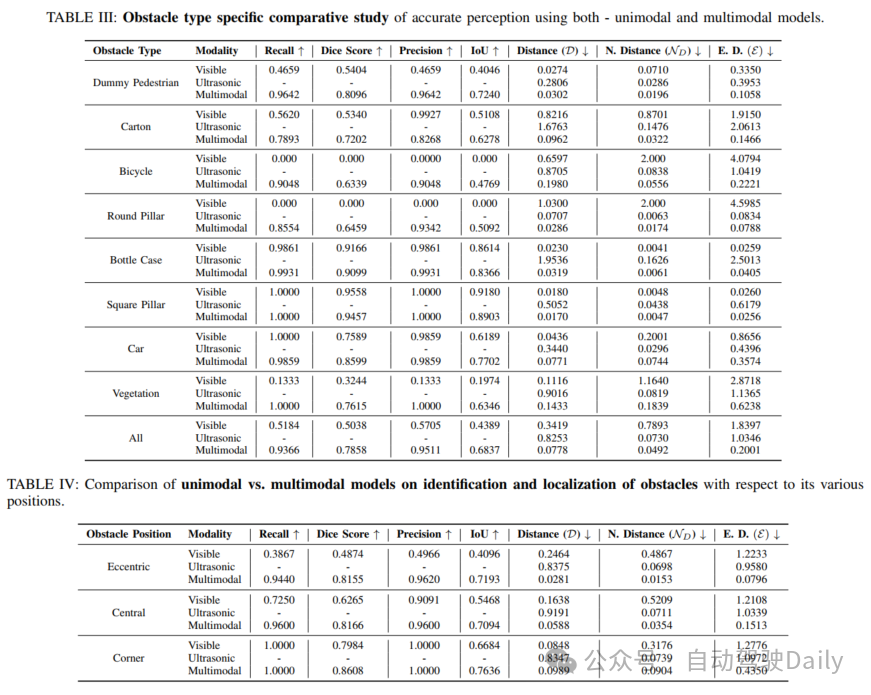

本文介紹了魚眼相機與超聲傳感器融合實現鳥瞰圖中近場障礙物感知。準確的障礙物識別是自動駕駛近場感知范圍內的一項基本挑戰。傳統上,魚眼相機經常用于全面的環視感知,包括后視障礙物定位。然而,這類相機的性能在弱光照條件、夜間或者受到強烈陽光照射時會顯著下降。相反,像超聲傳感器這類成本較低的傳感器在這些條件下基本不受影響。因此,本文提出了首個端到端的多模態融合模型,其利用魚眼相機和超聲傳感器在鳥瞰圖(BEV)中實現高效的障礙物感知。最初,采用ResNeXt-50作為一組單模態編碼器,以提取每個模態特有的特征。隨后,與可見光譜相關聯的特征空間被轉換為BEV。這兩種模態的融合是通過級聯來實現的。同時,基于超聲頻譜的單模態特征圖通過內容感知的空洞卷積,用于緩解融合特征空間中兩種傳感器之間的傳感器錯誤對齊。最后,融合的特征被兩階段語義占用編碼器用來生成用于精確障礙物感知的逐網格預測。本文進行了系統性研究,以確定兩種傳感器多模態融合的最優策略。本文深入展示了數據集創建過程、標注指南,并且進行全面的數據分析,以確保充分覆蓋所有場景。當應用于本文數據集時,結果證明了本文所提出的多模態融合方法的魯棒性和有效性。

本文主要貢獻

- 引入了一種新型的多傳感器深度網絡,其專門為鳥瞰圖中的近場障礙物感知而設計。本文所提出的網絡結合了魚眼相機和超聲傳感器系統,這是首次朝著該方向努力;

- 建立了構建包括魚眼相機和超聲傳感器數據的多傳感器數據集的策略。本文定義了標注規則,并且提供了相關的數據統計,這對于構建適用于類似應用的多模態模型是至關重要的;

- 本文描述了一個實現非常高精度的端到端可訓練網絡的實現過程。此外,本文還提出了對proposal進行重構,以支持具有單模態輸入的相同特征,從而對基于多模態解決方案的優勢進行深入分析;

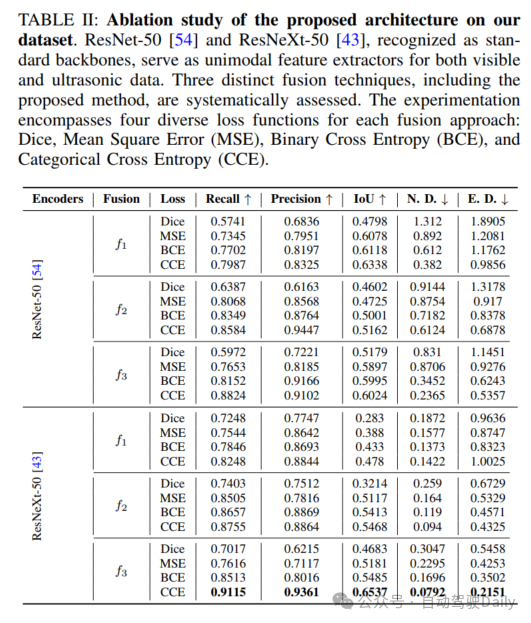

- 本文進行了全面的消融研究,涉及各種提出的網絡組件、不同的特征融合技術、不同的增強方法和各種損失函數。

原文鏈接:https://mp.weixin.qq.com/s/B0zQZ2_SapKuynG2qis1ug