國內公司有望做出Sora嗎?這支清華系大模型團隊給出了希望

2023 年年底,很多人都預測,未來一年將是視頻生成快速發展的一年。但出人意料的是,農歷春節剛過,OpenAI 就扔出了一個重磅炸彈 —— 能生成 1 分鐘流暢、逼真視頻的 Sora。它的出現讓很多研究者擔心:國內外 AI 技術的差距是不是又拉大了?

根據 OpenAI 披露的技術報告,Sora 的核心技術點之一是將視覺數據轉化為 patch 的統一表示形式,并通過 Transformer 和擴散模型結合,展現了卓越的 scale 特性。無獨有偶,最近發布的 Stable Diffusion 3 也采用了同樣的架構。

其實,這兩項工作都是基于 Sora 核心研發成員 William Peebles 和紐約大學計算機科學助理教授謝賽寧合著的一篇論文《Scalable Diffusion Models with Transformers》。這篇論文提出了一種基于 Transformer 架構的新型擴散模型 ——DiT,用對潛在 patch 進行操作的 Transformer 替換常用的 U-Net 主干網絡,把大語言模型的可擴展性、涌現性復制到了視覺任務上。

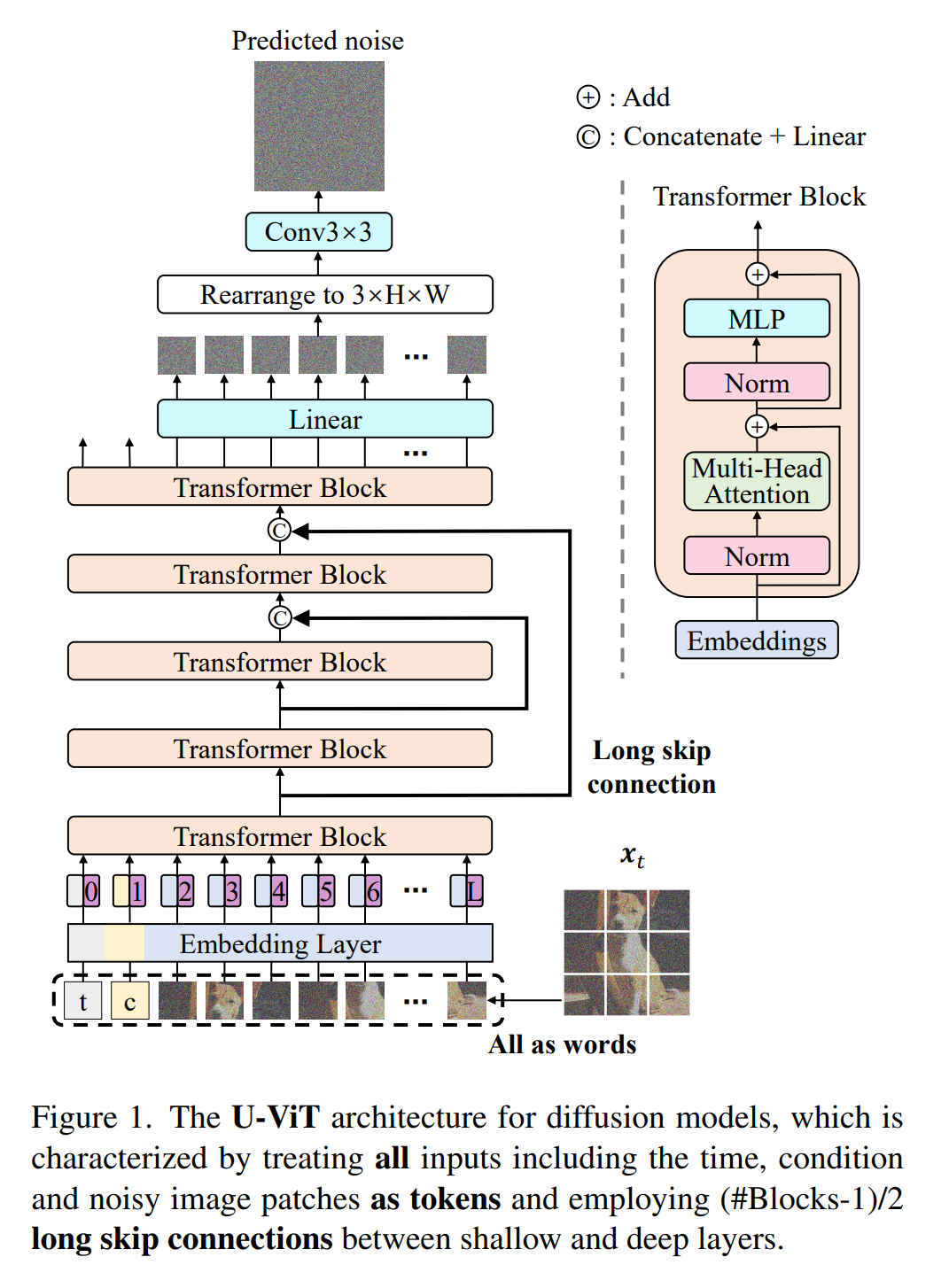

我們關注到,其實早在 2022 年 9 月,清華團隊就提交了一篇名為《All are Worth Words: A ViT Backbone for Diffusion Models》的論文(比 DiT 早兩個月)。這篇論文提出了用基于Transformer 的網絡架構 U-ViT替代基于CNN的U-Net。對比來看,兩項工作在架構路線上完全一致:均是提出了將 Transformer 與擴散模型融合的思路;并且在具體的實驗路徑上也一致,比如采用了相同的 patch embedding、patch size;都得出了同樣的結論 ——patch size 為 2*2 是最理想的;在模型參數量上,兩者都在 50M-500M 左右的參數量上做了實驗,最終都證實了 scale 特性。

不過 DiT 僅在 ImageNet 上做了實驗,U-ViT 在小數據集(CIFAR10、CelebA)、ImageNet、圖文數據集 MSCOCO 上均做了實驗。此外,相比傳統的 Transformer,U-ViT 提出了一項「長連接」的技術,大大提升了訓練收斂速度。這篇論文后被 CVPR 2023 收錄。

基于 U-ViT 架構,2023 年 3 月,該團隊再次發布了一項 UniDiffuser 的工作(參見《清華朱軍團隊開源首個基于 Transformer 的多模態擴散大模型,文圖互生、改寫全拿下》),在開源的大規模圖文數據集 LAION-5B 上訓練了 10 億參數量的多模態模型。同一時期,主攻通用多模態大模型賽道的生數科技正式成立(參見《專訪生數科技唐家渝:清華系團隊拿到上億融資,用Transformer來做多模態大模型》)。區別也在此刻發生,生數科技出于算力資源、技術成熟度等方面的考量,優先嘗試將 U-ViT 應用于圖文任務,而 OpenAI 則是利用其算力優勢跨越式地直接將 DiT 應用于視頻任務。

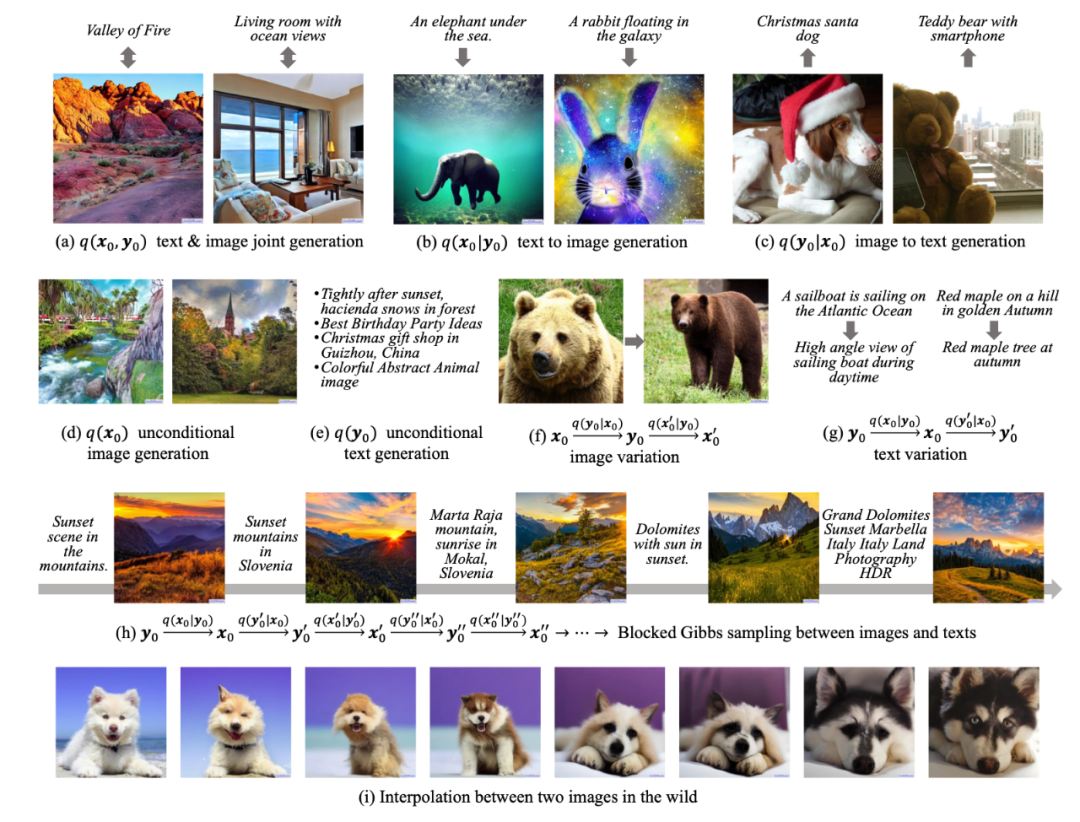

雖然主攻的任務不同,但 U-ViT 同樣展示了在視覺任務下的優異能力。與當時同階段的 SD1.5 比較,UniDiffuser 效果是基本持平的。更重要的是,UniDiffuser 擴展性更強,能基于一個底層模型完成圖文之間的任意生成。簡單來講,除了單向的文生圖,還能實現圖生文、圖文聯合生成、無條件圖文生成、圖文改寫等多種功能。

Unidiffuser開源版效果

Unidiffuser當前效果圖

有了這些對于架構的早期探索,生數科技其實在視頻生成上頗具潛力,有望成為最接近 Sora 的中國團隊。而且,他們也早已在視頻生成方向進行了一些探索。

那么,未來的路怎么走?在視頻生成這個問題上,有哪些棘手的問題需要解決?Sora 又將帶來哪些商業機遇?在近期的一次訪談中,生數科技 CEO 唐家渝、首席科學家朱軍向機器之心透露了自己的看法。

Sora 的出現比預期早半年

機器之心:首先想請兩位回憶一下,第一次看到 Sora 的時候是什么感覺?有沒有印象比較深刻的 demo?

唐家渝:我印象最深的是它的流暢性和時間長度。之前 AI 生成的短視頻,大家都戲稱為 GIF—— 變動小,視頻短,只有幾秒。Sora 生成的視頻長得多,流暢度、自然度又明顯好了一個層次,我覺得這是最直觀的一個視覺上的沖擊。

朱軍:如果回頭看大家之前對視頻生成長度的預判,Sora 的出現其實是超前了。之前能夠預測到今年視頻生成會快速發展,但當時在技術原理上,大家沒有看到特別大的技術突破,所以當時就覺得短視頻(幾秒鐘那種)會是一個主流形式。但 Sora 一下子做到了這么長,還是一個比較 surprise 的事情。原本預計今年年中或年底能做到這個水平,Sora 提前了大概有半年的時間。

用 Transformer 替代 U-Net 是一個自然想法,區別在于誰先做出效果

機器之心:最近關于 Sora 核心創新點的討論比較多,而且大家提及最多的是它的架構。朱老師能否通俗地解釋一下 Sora 的 Diffusion Transformer 架構是怎么一回事,「用 Transformer 替換常用的 U-Net 主干網絡」有何必要性?

朱軍:以視頻數據為例,擴散模型的原理就是在數據上做加噪和去噪。這里很關鍵的問題,就是能不能準確地預測噪聲,設計一個噪聲預測網絡。過去大家會用傳統的 U-Net 去做,但是 Transformer 被證明在可擴展性等方面有很大的優勢,所以用 Transformer 去替代 U-Net 是一個很自然的想法,區別就在于誰先做出來效果。

Sora 用到的 DiT 是 2022 年底發布出來的。其實早在 2022 年 9 月份,我們發布了一個叫 U-ViT 的模型。這個模型的主要思想是用 Vision Transformer 去替代 U-Net,和 DiT 核心的想法是一樣的,就是用 Transformer 去增強擴散模型。這后來被證明非常有效,特別是在視覺數據的生成上。它一方面保持了擴散模型的優勢,另一方面又利用了 Transformer 的可擴展性以及對不同模態的兼容性。相比于傳統的 Transformer,我們自己的設計(U-ViT)里面還包括了長連接,它可以讓計算效率變得更高,能看到很顯著的效果提升。

U-ViT 架構

機器之心:我們可以從哪些指標上看到這些效果?

朱軍:其實在 22 年的時候,大家就已經看到了,用 Vision Transformer 這種架構可以提高生成質量,實現更高的分辨率,也可以更有效地訓練更大規模的模型。現在,我們可以看到更多的例子,包括 Sora、Stable Diffusion 3。這些例子一次又一次地證明了,這個架構的潛力是巨大的。

機器之心:在生數的產品里面,這份工作展現出了什么樣的效果?

朱軍:我們從一開始就堅持用擴散加 Transformer 的融合架構,也就是多模態原生的架構。之前,很多團隊在做多模態的時候,會想說什么模態都對到語言上。但我們認為這種架構不是最優,因為從原理和計算效率上來看,這種方法存在天然的不足,所以從一開始我們就在走擴散加 Transformer 這種路線。

2022 年我們提出 U-ViT 架構的時候對標的是 Stable Diffusion,當時 Stable Diffusion 剛開源。所以在 U-ViT 架構的基礎上,我們又在 2023 年 3 月份開源了一個叫 UniDiffuser 的大模型。這個模型也是基于擴散加 Transformer 的融合架構,可以在文、圖兩種模態之間進行任意的轉換。

從底層架構的訓練到優化到支撐上層的圖像、3D、視頻的生成,生數一直在堅持這個架構,一直在堅持這種融合的路線。

機器之心:您的意思是說,這種融合的路線相比那種單純地用 Diffusion 或者單純地用 Transformer 效果都要好,是嗎?

朱軍:是的。與單純地用 Diffusion 相比,融合架構的主要優勢就是 Transformer 的可擴展性。與單純地用 Transformer 相比,融合架構在生成視覺數據的效率,包括模型的表示效率和計算效率等方面有很大的優勢。

對于 Transformer 這個架構來說,你把所有東西都放到里邊,好處就是簡單直接。但是,就目前對視覺數據的處理和生成效果來看,擴散還是占優勢的。在我們看來,融合模型更符合原生多模態的定位。因為不同類型的數據,它的特點是不一樣的,所以應該針對不同模態選擇最合適的一種處理方式。從實際的視覺生成效果來看,現在主流的方法也是用擴散模型去做生成,因為用 Transformer 這個架構直接去做生成的話,到目前為止效果還是落后的。

機器之心:你們的 U-ViT 和 DiT 是同一時期提出的,但是你們選擇優先用它去做圖文任務,而不是視頻生成,是基于什么考量?

朱軍:實際上我們也在做視頻生成,只是當時基于算力的考慮排了一個優先級。這里面也有我們基于技術成熟度的一個預判。去年,我們是優先從 2D 的圖像開始,然后緊接著到 5 月份的時候,我們就做了 3D 生成(從 2D 到 3D),后來我們又做了視頻和 4D( 參見《一鍵實景轉動畫,清華系初創公司全球首發4D骨骼動畫框架》)。實際上就是在有了基礎的基座之后,我們可以做不同維度的擴增,3D、4D 其實分別是空間、時間上的一個擴展。

視頻實際上是圖像的流,它相當于在時間軸上做了一個擴增。所以我們的架構實際上可以很自然地支持短視頻的生成,只是當時我們主要聚焦在幾秒鐘的短視頻的生成,沒有像 OpenAI 的 Sora 那樣一下子做到幾十秒、一分鐘。這里邊有很多原因,但其中一個很重要的原因是,我們手頭的資源相對來說確實受限很多。但是,從 2D 圖像到視頻生成,很多東西是一脈相承的,很多經驗(比如大規模訓練的經驗)是可以復用的。

復現 Sora,還有很多難題需要解決

機器之心:生成幾秒的視頻和 1 分鐘的視頻之間的技術差異是巨大的。根據您的經驗,除了算力,做到這一點的關鍵是什么?

朱軍:這里面很重要的一塊是,針對比較長的視頻,怎么有效地表示它的時空信息,怎么有效地去壓縮視頻數據,學到一個嵌入的表示,然后在上面再去做擴散、生成。

另外,要讓這種架構能夠有效訓練,數據也很重要。基于之前的 DALL?E 3 等積累的優勢,OpenAI 可以對視頻數據做到比較有效的語義理解。這在訓練數據里是非常關鍵的。因為在創作的時候,你輸入的語言通常是比較有限的、簡單的,所以如果想去生成豐富的視頻內容,中間需要一個比較強的語義理解過程。

當然,可能還有很多我們不知道的因素。Sora 的成功不光是一個生成的問題,里面包括語義理解、數據標注、數據清洗、大規模訓練以及工程優化等等。這些問題如果沒有做過是不知道的,由于 OpenAI 做過很多成功的案例,所以他們做成一個新項目的成功率會更高。

機器之心:同樣的架構用來做圖像任務和視頻任務,會有什么不同嗎?對生數團隊而言,下一步計劃如何將該架構從圖像任務拓展至視頻任務?

朱軍:主要的不同在于,視頻里面包含很多的時空信息。怎么抓住里面關鍵的運動、保持住長時間的一致性?這是單張圖片不會涉及到的。二者從原理上來說是相通的,我們從去年下半年開始也一直在做視頻相關的工作。

生數底層擁有自主訓練的架構,所以在上面我們能夠很自然地做各種生成。圖像生成是一個基礎,圖像生成的質量會影響到視頻生成的質量。此外,3D 生成我們也持續在做。只是,Sora 比我們預期出現得要早,所以后續我們會加強視頻生成這一塊。

打造通用多模態,需要通用架構提供支撐

機器之心:Sora 的發布讓我們看到 OpenAI「all in AGI」的野心。他們的技術路線有兩個關鍵點:一是多模態,二是通用化架構。生數科技也是「通用多模態路線」的堅持者,在您看來,通用化架構有何必要性?

朱軍:如果想讓模型實現更強的通用性,就需要更加通用的模型架構來支撐。以 Sora 為例,在架構上它肯定要融合文字和視覺數據。換句話說,如果你只做視覺或只做文本的話,你在多模態的任務上就不是最優,或者說有些模態不能處理。這是一個很直接的相互支撐的關系。

機器之心:做這種通用架構的難點體現在哪幾個方面?

朱軍:難點就在于,不同模態的數據,特點是不一樣的,你是不是直接簡單粗暴地用一種方式表示所有數據?這種方式目前來看可能并不是最優,所以需要針對不同數據的特點去分析考慮。另外,不同模態的數據,它的數據量是不一樣的,或者說不均衡。在訓練過程中,這可能會對你的優化過程產生實際的影響。還有不同模態之間的對齊理解也是問題。

機器之心:Sora 出現后,有種聲音說,國內外的差距進一步拉大了,您怎么看待這個問題?

朱軍:差距是否拉大,這是一個可以辯論的問題。但我覺得,Sora 出來之后,國內外并沒有像當初 ChatGPT 出來時那樣形成很明顯的代差。只是大家現在在工程技術上可能會落后一些。視頻生成這個問題,國內也很重視,而且國內做圖像、視頻相關任務的基礎還是比較好的。從當前的結果來看,實際情況可能比想象中要樂觀一些。

來自 OpenAI 的啟發:

技術自信和資源都很重要

機器之心:如果從商業和產品的角度來看,您如何看待 Sora 的成功?

唐家渝:OpenAI 整體的模式是朝著 AGI 的目標,從底層模型能力提升的層面不斷地往前跑,模型本身就可以看作是他們最核心的產品。據說 Sora 這個小組也并沒有去考慮太多關于商業和產品的事情,所以可能他們在最開始的時候主要還是聚焦在如何實現真正好的視頻生成能力,然后去相信說只要我有這么強的能力,上面一定能搭出更多的商業化產品。對外賦能底層 API 的能力,然后在上層去創建一個繁榮的 AI 生態,是 OpenAI 已經驗證成功的一種商業模式了。

從這個維度來講,我覺得他們成功因素中很重要的一點已經寫在了他們公司的價值觀里,也就是所謂的 “Scale”,他們整個公司都是相信 scale up 的,官網原話是「如果對此產生了懷疑,就進一步 scale it up」。所以我覺得這也是他們對于自己的技術路線的充分自信和堅持,然后衍生出了現在的成功。

機器之心:這對生數科技有什么啟發?

唐家渝:首先是觀念上的。我覺得我們在設計了 Diffusion 融合 Transformer 這樣一個好的架構,并且已經看到它有巨大的潛力的情況下,應該要更有技術上的自信。這和 OpenAI 去相信 scale up 是類似的。

第二點是,在有自信的同時,如果你要去做 scale up,尤其是基于視頻數據,就要去卷入更多的資源。因為像我們或者國內的其他創業公司,其實相比 OpenAI 所擁有的資源還是差很多的。所以我們得敢想敢做地去卷入更多資源,和更多資源方去合作,這樣才能把技術自信轉變為技術實現,然后變成產品實現。

視頻生成:生數的過去與未來

機器之心:生數之前上線過一些文生視頻的能力,可以介紹一下之前的探索工作嗎?

唐家渝:我們的技術探索最終是為產品服務的。從產品層面來看,我們之前發布的能力和業界是差不多的,就是幾秒的短視頻生成和編輯。那個時候主要受限于算力等因素,沒有利用已有的架構在視頻數據上去完成 scale up。從產品使用角度來看,我們其實看到這種幾秒的視頻已經能夠幫用戶去做一些創意的工作,即使要制作長視頻,其實也可以通過設計腳本來拼接短視頻實現。

但 Sora 的出現讓我們看到,原生長視頻生成的能力不僅從內容創作的角度,可以幫助我們去進行長鏡頭等更加藝術化的表達,也能外顯出一定的物理世界理解能力,使得生成的視頻更加自然。這也大大增強了我們加大視頻生成研發投入的信心和決心。

此外,我們之前的這些探索其實也是為了牽引內部的一些工程基礎建設,比如為視頻數據的收集、清洗、標注以及模型的高效訓練積累經驗。這些積累和最接近Sora的架構,使得我們在做長視頻生成時,對最終的效果更加抱有期待。

機器之心:據您所知,Sora 的開發、應用成本有多高?如果要做類似產品,生數要如何應對隨之而來的成本問題?

唐家渝:就開發成本來說,業界估計資源比較充分的狀態需要達到萬卡(英偉達 A 系列)的水平。由于我們之前在大規模訓練上做了很多加速的工作,所以我們的需求實際評估下來會少一些。

如果估算一下 Sora 的應用成本,目前生成 60 秒的高清視頻大概需要幾塊到幾十塊人民幣。所以 OpenAI 現在還沒有完全放出來這個東西,估計也是有算力、成本方面的顧慮。此外,模型生成視頻的成功率也是未知數,這可能也是一個顧慮。

要降低應用成本,肯定要在這個過程中做一些模型壓縮的工作,包括一些分布式的操作 —— 比如在手機、筆記本端去做一些推理,也會是大家去做的一個衍生方向。另外,架構層面的一些優化肯定也會持續去做。所以應用成本的問題,我們覺得相對來說還是比較樂觀的。

什么叫「原生多模態模型」?

機器之心:根據您公司的描述,你們走的是「原生多模態大模型」賽道,能否介紹一下這個賽道和其他賽道的區別,以及該賽道國內外玩家的具體情況。

唐家渝:其實定位原生多模態這個賽道是說,我們從第一天就堅持做一個完整的通用多模態大模型,而不是訓練多個模型,對這些模型的能力做排列組合式的使用。我們的做法是從底層的架構出發,天然地去考慮通過一個模型支撐不同數據的輸入輸出,它的特點是模型學到的知識會更加充分,而且在使用的時候,不用調用不同的模型去做組合應用,因此推理效率會更高。

舉個具體的例子,GPT-4支持文本-文本,DALL·E 3支持文本-圖像,GPT-4V可同時輸入文本和圖像,但輸出僅文本,在應對開放的視覺任務時,是通過調用DALL·E 3或者GPT-4V的接口來實現,而原生的技術路線是基于一個底層架構實現「GPT-4V + DALL·E 3」的統一,能應對廣泛開放域的文本和視覺交互類的復雜場景。

這個領域的國外玩家主要是谷歌(Gemini)和 OpenAI(Sora)。國內的話,我們是最早、也可能是唯一堅持做通用性的多模態大模型的公司。

機器之心:從產品的角度,您如何定義「原生」?

唐家渝:從產品角度來看,其實我們更多的是考慮有了原生多模態模型的加持之后,產品所帶來的用戶體驗有沒有指數級的提升,像「所想即所得、所說即所得」就是一種指數級的提升。我們所做的事情,無論是圖像、3D 還是視頻的生成,其實都是朝著這個目標在努力的。就是讓一個即使沒有任何專業能力的人,都可以去創作出他想要的畫面,或者說在數字世界或物理世界具象化出想象中的某個東西。我個人心中的標準之一就是,自己的親戚朋友最終會不會喜歡去用這么一個產品。

Sora 所帶來的商業機遇

機器之心:在關于 Sora 是否理解物理世界的爭論中,Keras 之父 Fran?ois Chollet 曾提到,這個問題之所以重要,是因為它決定了生成圖像、視頻的應用范圍 —— 是僅限于媒體生產,還是可以用作現實世界的可靠模擬。如果分兩種情況去討論,Sora 的發布將分別帶來哪些新的商業機遇?

唐家渝:我覺得前者主要對應的是數字世界里的內容生產。在數字世界中,我們平時接觸到的內容涉及電視電影、廣告、教育、社交娛樂等多個行業。因為視頻形態在我們日常生活中用得太多了,所以即使只看跟視頻相關的場景,它的應用前景就已經非常不可限量了。

如果它能理解物理世界,那應用范圍就不止局限在數字世界了,而是可以和物理世界產生交互。比如,它可以和機器人結合實現具身智能,也可以用于自動駕駛,用于數字孿生。之前一個一個構建小模型的方法可能有很多 corner case 照顧不到,如果模型真能了解到物理世界的規則,我們就能使用一個通用模型來處理所有的關于物理世界的認知和仿真任務,這可能會極大地推動社會運行方式的進化。