浙大&中科院讓Agent學會自我進化,玩德州撲克心機盡顯

基于大模型的Agent,已經成為了大型的博弈游戲的高級玩家,而且玩的還是德州撲克、21點這種非完美信息博弈。

來自浙江大學、中科院軟件所等機構的研究人員提出了新的Agent進化策略,從而打造了一款會玩德州撲克的“狡猾”智能體Agent-Pro。

通過不斷優化自我構建的世界模型和行為策略,Agent-Pro掌握了虛張聲勢、主動放棄等人類高階游戲策略。

Agent-Pro以大模型為基座,通過自我優化的Prompt來建模游戲世界模型和行為策略。

相比傳統的Agent框架,Agent-Pro能夠變通地應對復雜的動態的環境,而不是僅專注于特定任務。

而且,Agent-Pro還可以通過與環境互動來優化自己的行為,從而更好地達成人類設定的目標。

同時作者還指出,在競爭、公司談判和安全等現實世界中遇到的情景,大多可以抽象為multi-agent博弈任務,而Agent-Pro通過對這類情境的研究,為解決眾多現實世界的問題提供了有效策略。

那么,Agent-Pro在博弈游戲中的表現究竟如何呢?

進化出游戲世界模型

在研究中,作者使用了“21點”和“有限注德州撲克”這兩款游戲對Agent進行了評估。

首先簡要介紹下兩個博弈游戲的基本規則。

21點

- 游戲中包含一個莊家和至少一名玩家。

- 玩家可以看到自己的兩張手牌, 以及莊家的一張明牌,莊家還隱藏了一張暗牌。玩家需要決定是繼續要牌(Hit)還是停牌(Stand)。

- 游戲的目標是在總點數不超過21點的前提下,盡量使總點數超過莊家。

有限注德州撲克

- 游戲開始階段為Preflop階段,每位玩家將獲得兩張只屬于自己且對其他玩家保密的私牌(Hand)。

- 隨后,會有五張公共牌面(Public Cards)依次發出:首先翻牌(Flop)3 張,其次轉牌(Turn)1張,最后是河牌(River)1張。

- 玩家有四種選擇:棄牌(fold)、過牌(check)、跟注(call)或加注(raise)。

- 目標是利用自己的兩張Hand和五張Public Cards任意組合,盡可能構造出最佳的五張撲克牌組合。

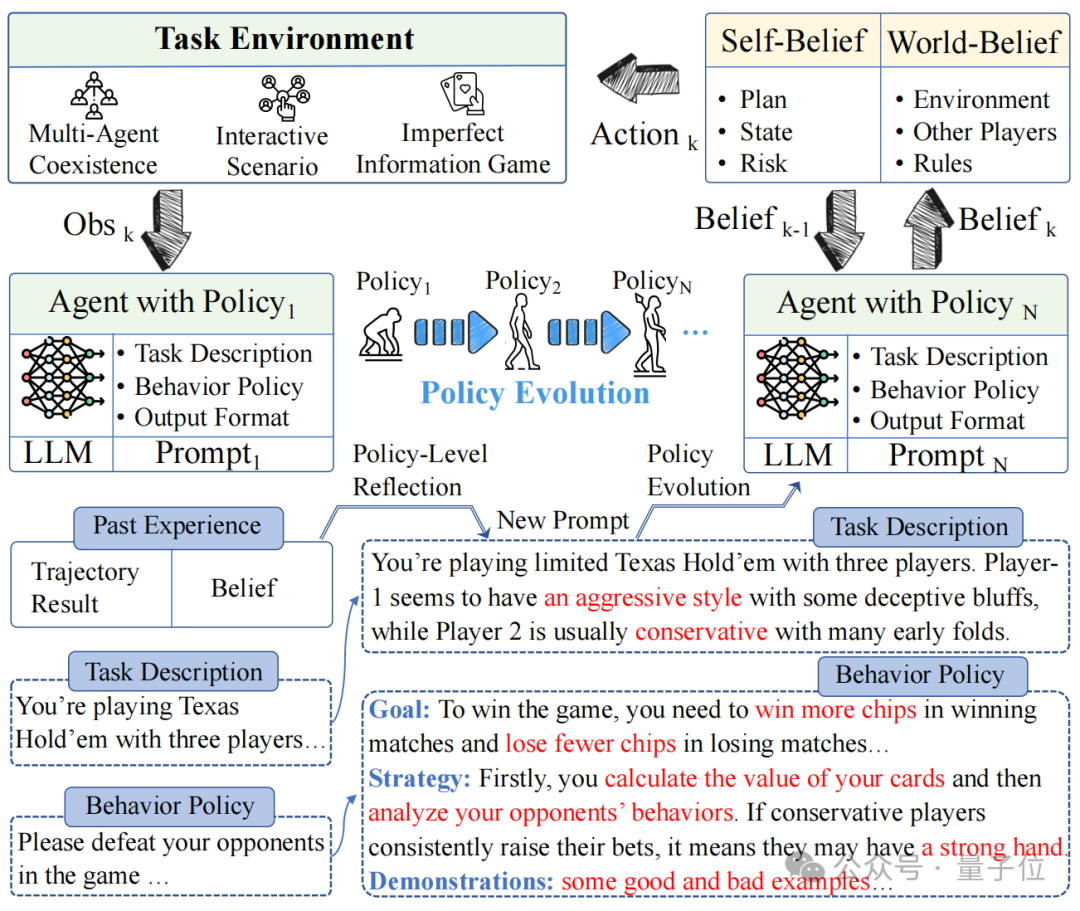

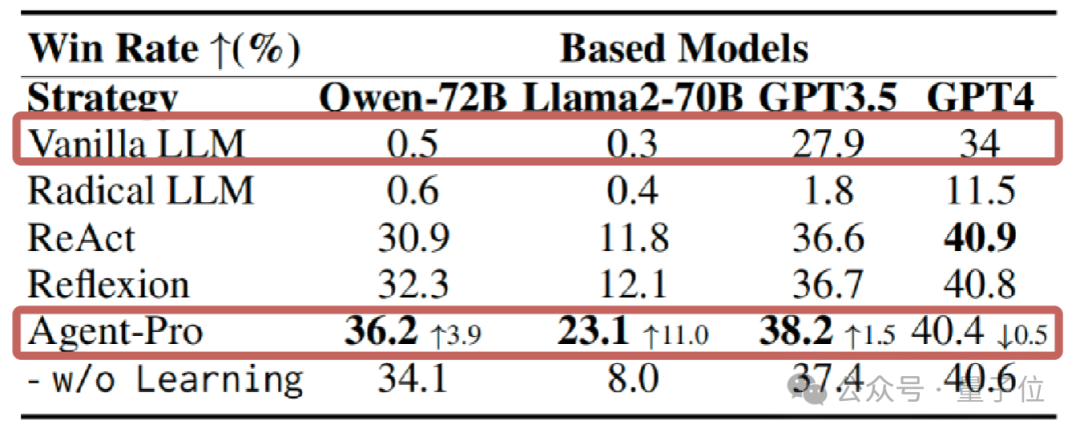

在“21點”當中,同樣是使用GPT-4作為基礎模型,Agent-Pro的表現超過了ReAct框架。

在手牌相同的情況下,二者的表現如下圖所示。

Agent-Pro通過分析得出自我信念(Self-Belief)和對外部世界的信念(World-Belief),正確認識到自己的手牌已接近21點,合理的選擇了停牌。

而ReAct則未能及時停牌,導致最終爆牌,輸掉了游戲。

從游戲中能夠看出Agent-Pro更好的理解了游戲的規則,并給出了合理的選擇。

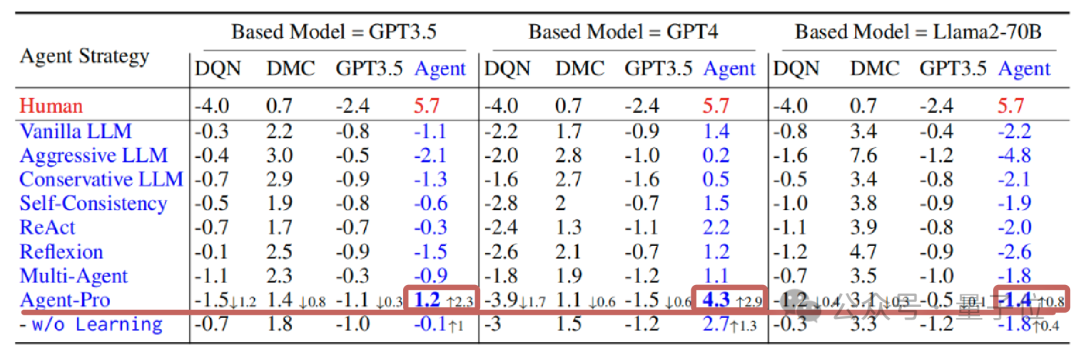

接下來再看看在德州撲克中Agent-Pro的表現。

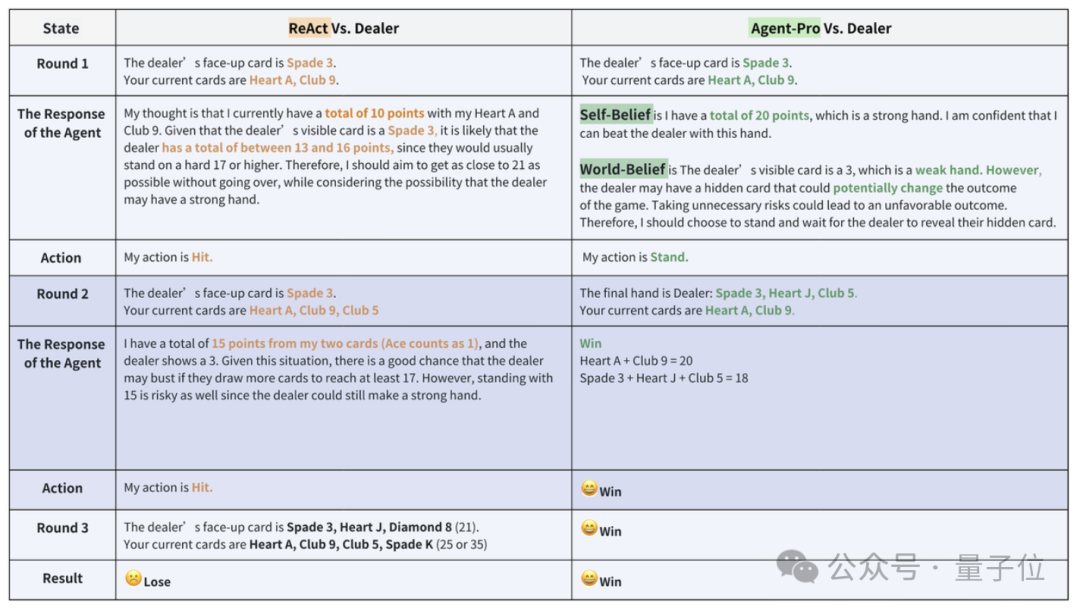

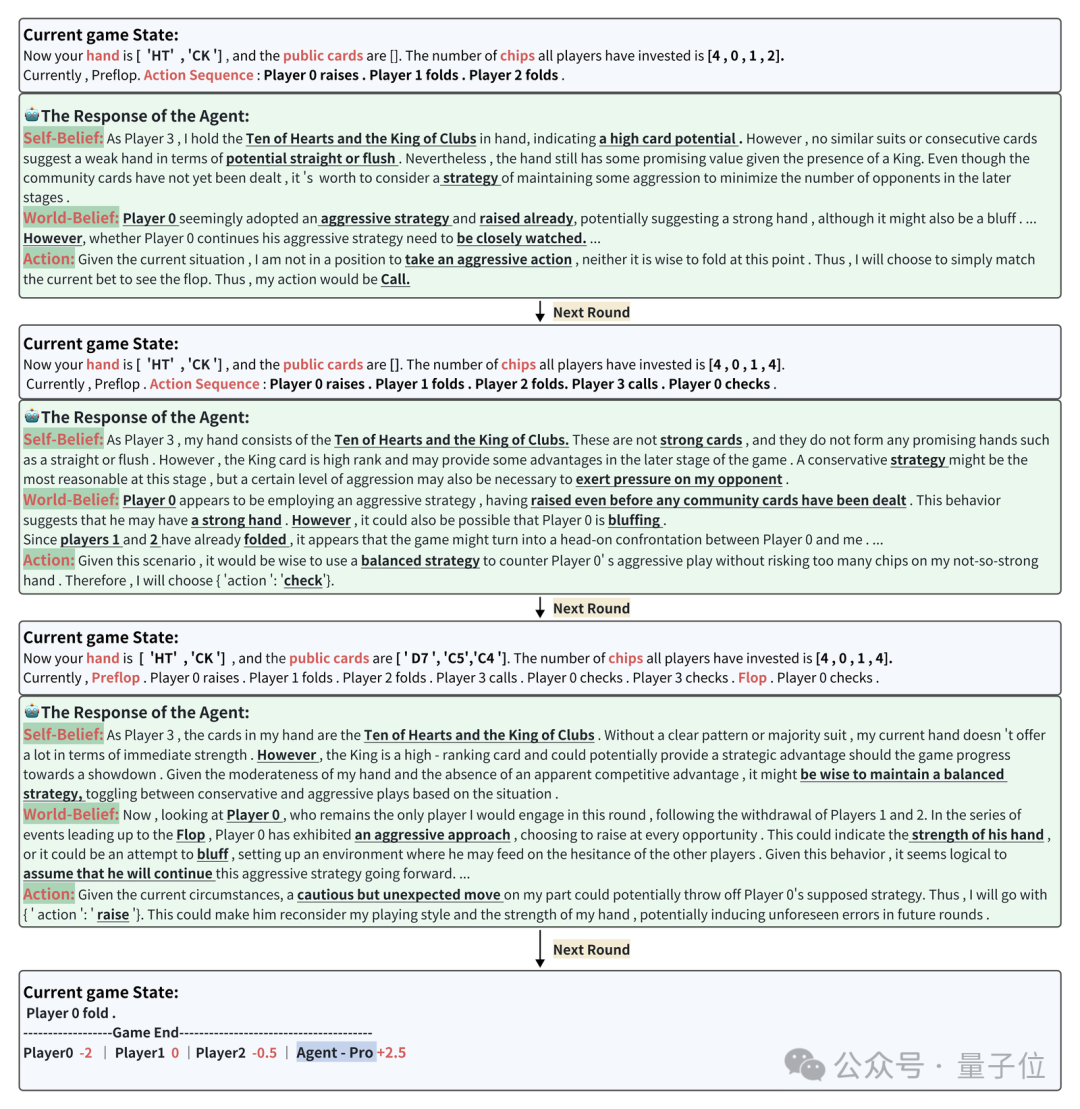

一次牌局中,參賽選手分別是訓練后的DQN、DMC策略,原生GPT3.5和Agent-Pro(基于GPT-4),他們的手牌和公共牌如下圖所示:

△S、H、C、D分別代表黑桃、紅桃、梅花、方塊

在當前游戲狀態(Current game state)下,Agent-Pro分析得出Self-Belief、World-Belief和最終的Action,并隨著游戲狀態的變化,不斷更新Belief,根據自身和對手的情況,做出靈活合理的選擇。

△相同牌局同一位置的Baseline(原始大模型)結果為-13

統計數據上看,21點游戲中,在使用GPT、Llama等多種大模型的情況下,Agent-Pro的表現都顯著超過了原始模型和其他參與對比的Agents框架。

在更為復雜的德州撲克游戲中,Agent-Pro不僅超過了原始大模型,還擊敗了DMC等訓練后的強化學習Agent。

那么,Agent-Pro是如何學習和進化的呢?

三管齊下提高Agent表現

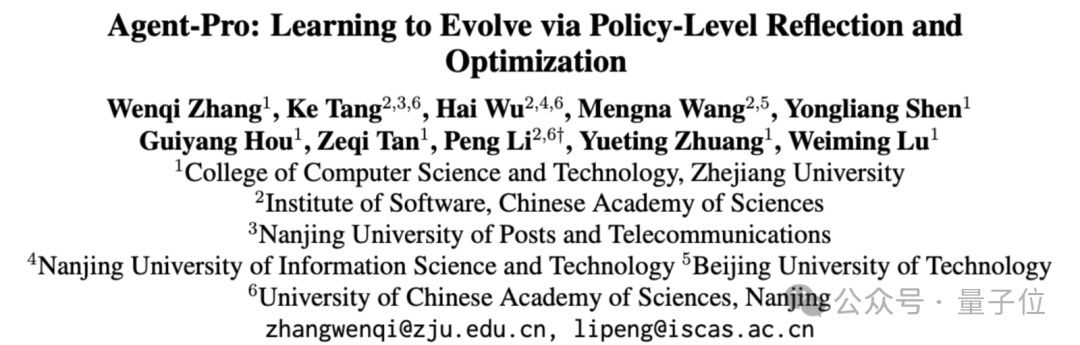

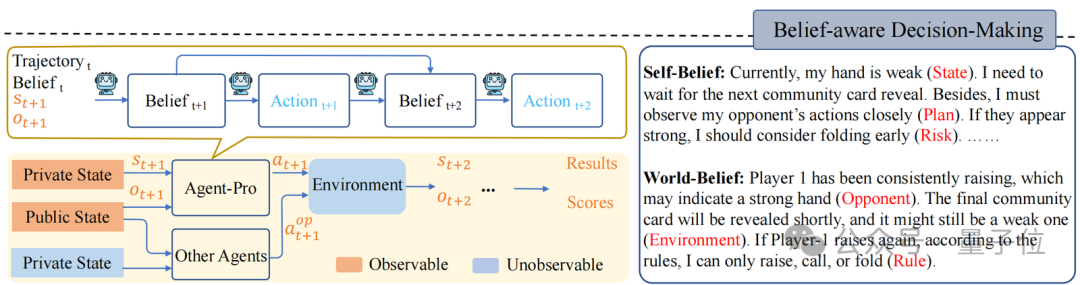

Agent-Pro包括“基于信念的決策”“策略層面的反思”和“世界模型和行為策略優化”這三個組件。

基于信念的決策(Belief-aware Decision-making)

Agent-Pro根據環境信息,首先形成Self-Belief和World-Belief,然后基于這些Belief做出決策(Action)。

在后續環境交互中,Agent-Pro動態更新Belief,進而使做出的Action適應環境的變化。

例如,德州撲克游戲中:

- 環境信息可包括手牌(Private State)、公共牌(Public State)、行動軌跡(Trajectory)等;

- Agent-Pro對手牌(State)、出牌計劃(Plan)及潛在風險(Risk)的預估等信息構成了它的Self-Belief;

- 而Agent-Pro對對手(Opponent)、環境(Environment)和規則(Rule)的理解則構成了它的World-Belief;

- 這些Belief在每一個決策周期中都會被更新,從而影響下個周期中Action的產生

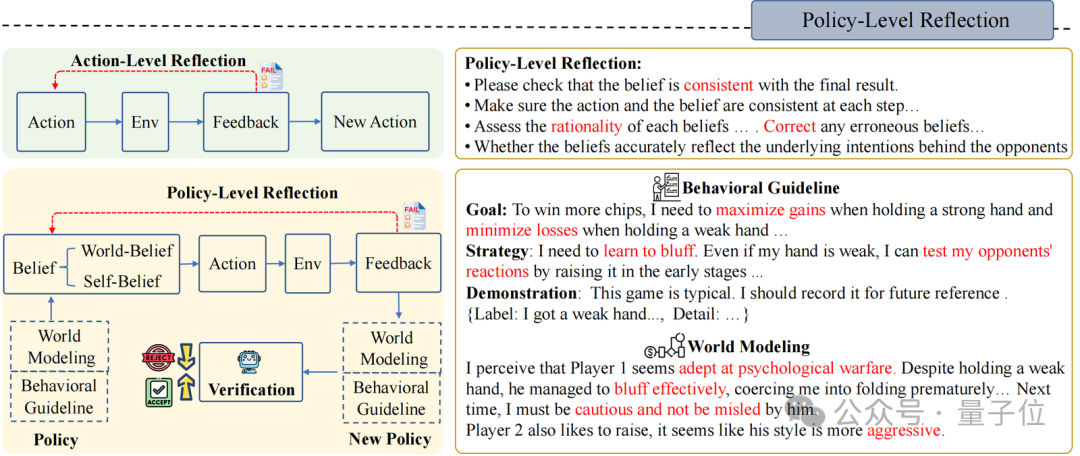

策略層面的反思(Policy-Level Reflection)

與人類一樣,Agent-Pro 會從歷史經驗、歷史認知和歷史結果中進行反思和優化。它自主調整自己的Belief,尋找有用的提示指令,并將其整合到新的策略Policy中。

首先,Agent-Pro以文字的形式設計了一個對任務世界的建模以及對行為準則的描述, 他們一起被當做Policy:

- World Modeling:任務世界的建模,例如對游戲環境的理解、對手們的風格分析、環境中其他Agent的策略估計等;

- Behavioral Guideline:行為準則的描述,例如對游戲目標的認識、自己策略規劃、未來可能面臨的風險等

其次,為了更新World Modeling和Behavioral Guideline,Agent-Pro設計了一個Policy-level Reflection過程。

與Action-level Reflection不同,在Policy-level的反思中,Agent-Pro被引導去關注內在和外在信念是否對齊最終結果,更重要的是,反思背后的世界模型是否準確,行為準則是否合理,而非針對單個Action。

例如,德州撲克游戲中Policy-level的反思是這樣的:

- 在當前世界模型和行為準則(World Modeling & Behavioral Guideline)的指導下,Agent-Pro觀察到外部狀態,然后生成Self-Belief和World-Belief,最后做出Action。但如果Belief不準確,則可能導致不合邏輯的行動和最終結果的失敗;

- Agent-Pro根據每一次的游戲來審視Belief的合理性,并反思導致最終失敗的原因(Correct,Consistent,Rationality…);

- 然后,Agent-Pro將反思和對自身及外部世界的分析整理,生成新的行為準則Behavioral Guideline和世界建模World Modeling;

- 基于新生成的Policy(World Modeling & Behavioral Guideline),Agent-Pro重復進行相同游戲,來進行策略驗證。如果最終分數有所提高,則將更新后的World Modeling & Behavioral Guideline和保留在提示中。

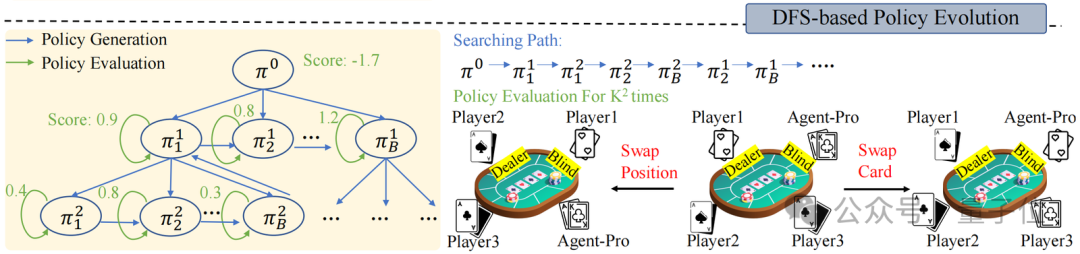

世界模型和行為準則的優化(World Modeling & Behavioral Guideline Evolution)

在Policy-level Reflection之上,面對動態的環境,Agent-Pro還采用了深度優先搜索(DFS)和策略評估,來持續優化世界模型和行為準則,從而找到更優的策略。

策略評估是指Agent-Pro 在新的采樣的軌跡中對新Policy進行更全面的評估,從而考察新策略的泛化能力。例如,德州撲克游戲中,新采樣多條游戲軌跡。

通過交換玩家位置或手牌,來消除由于運氣帶來的隨機因素,從而更全面評估新策略的能力。

而DFS搜索則在新策略不能在新的場景中帶來預期的改進(策略評估)時使用,按照DFS搜索策略,從其他候選策略中尋找更優的策略。

論文地址:https://arxiv.org/abs/2402.17574

Github:https://github.com/zwq2018/Agent-Pro