CVPR 2024滿分論文,英偉達開源BOP排行榜6D物體姿態第一名方法

物體姿態估計對于各種應用至關重要,例如機器人操縱和混合現實。實例級方法通常需要紋理 CAD 模型來生成訓練數據,并且不能應用于測試時未見過的新物體;而類別級方法消除了這些假設(實例訓練和 CAD 模型),但獲取類別級訓練數據需要應用額外的姿態標準化和檢查步驟。

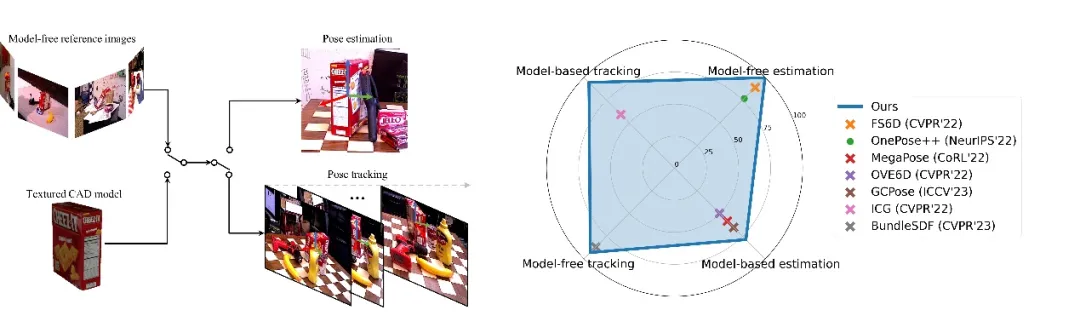

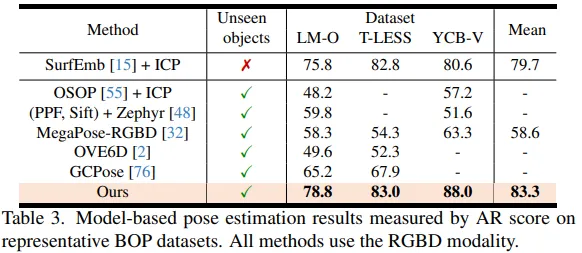

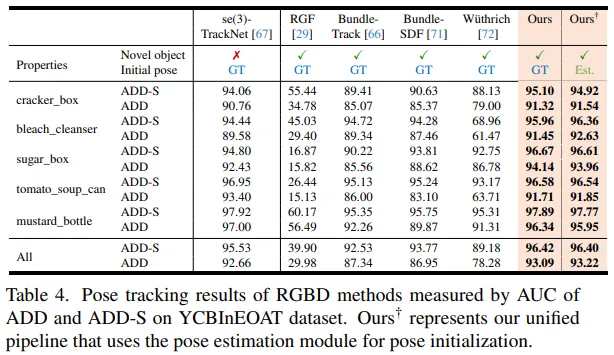

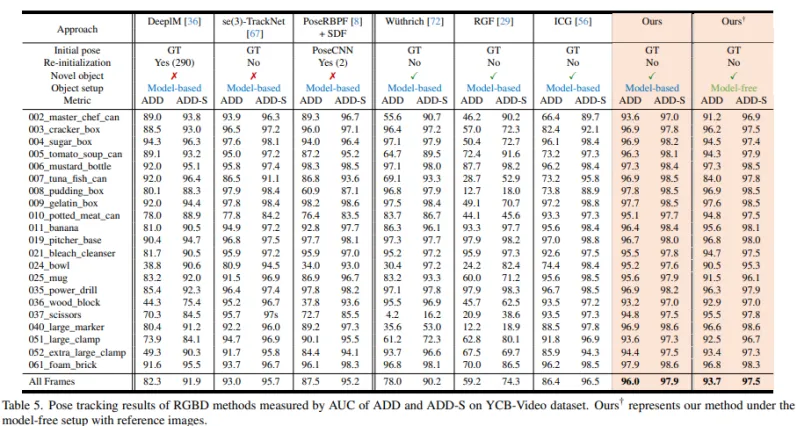

為了解決這些問題,來自英偉達的研究團隊提出了一個統一的框架,稱為 FoundationPose,它在基于模型和無模型設置下,使用 RGBD 圖像對新穎物體進行姿態估計和跟蹤。如下圖所示,FoundationPose 優于現有專門針對這四項任務中每一項的 SOTA 方法。FoundationPose 通過大規模合成訓練實現了強大的泛化能力,輔以大型語言模型(LLM)、以及一種新穎的基于 Transformer 的架構和對比學習。該研究利用神經隱式表示填補了基于模型和無模型設置之間的差距,使得 FoundationPose 可以使用少量(約 16 張)參考圖像進行有效的新穎視圖合成,實現了比之前的渲染與比較方法 [32, 36, 67] 更快的渲染速度。研究論文被評為 CVPR 2024 滿分論文,代碼已開源。

- 論文:FoundationPose: Unified 6D Pose Estimation and Tracking of Novel Objects

- 論文地址:https://arxiv.org/abs/2312.08344

- 項目主頁:https://nvlabs.github.io/FoundationPose/

- 項目代碼:https://github.com/NVlabs/FoundationPose

總的來說,該研究的主要貢獻包括:

- 提出了一個統一的框架,用于新穎物體的姿態估計和跟蹤,支持基于模型和無模型設置。一種以物體為中心的神經隱式表示用于有效的新穎視圖合成,彌合了這兩種設置之間的差距。

- 提出了一種 LLM 輔助的合成數據生成流程,通過多樣的紋理增強擴展了 3D 訓練資源的種類。

- 提出新穎的基于 Transformer 的網絡架構設計和對比學習公式在僅使用合成數據進行訓練時實現了強大的泛化能力。

- FoundationPose 方法在多個公共數據集上大幅優于針對每個任務專門化的現有方法。即使減少了假設,它甚至實現了與實例級方法可比的結果。

方法介紹

FoundationPose 是一個用于 6D 物體姿態估計和跟蹤的統一大模型,支持基于模型和無模型設置。該方法可以立即應用于新穎的物體上,無需微調,只要給出其 CAD 模型,或者拍攝少量參考圖像即可。FoundationPose 通過神經隱式表示來彌合這兩種設置之間的差距,這種表示允許有效的新視圖合成,并在同一統一框架下保持下游姿態估計模塊的不變性。

通過大規模合成訓練、大型語言模型(LLM)、一種新穎的基于 Transformer 的架構和對比學習公式的輔助,FoundationPose 實現了強大的泛化能力。在涉及挑戰性場景和物體的多個公共數據集上進行了廣泛評估,結果表明 FoundationPose 在性能上大幅優于現有的針對每個任務專門化的方法。此外,盡管減少了假設,但 FoundationPose 達到了與實例級方法相當的結果。

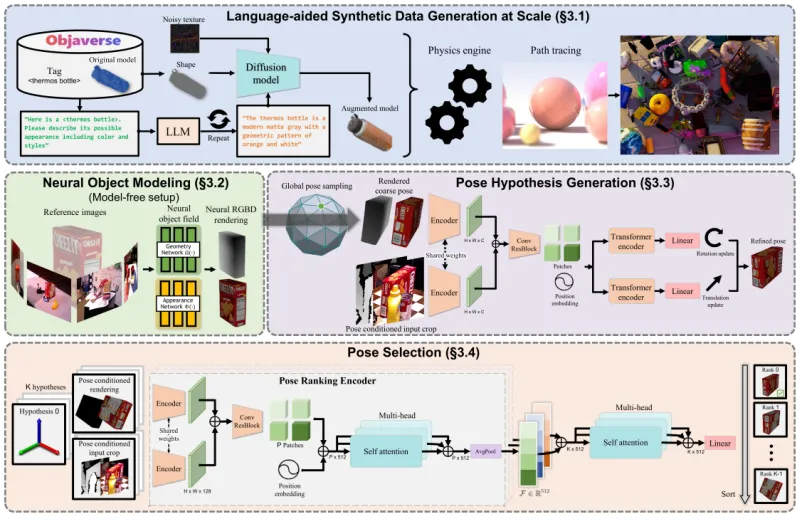

FoundationPose的框架概述如下圖所示,為了減少大規模訓練的手動工作,該研究利用最近出現的技術和資源,包括 3D 模型數據庫、大型語言模型和擴散模型,開發了一種新穎的合成數據生成流程。為了彌合無模型和基于模型的設置之間的差距,該研究利用一個以物體為中心的神經場進行新穎視圖的 RGBD 渲染,以便后續進行渲染與比較。對于姿態估計,該研究首先在物體周圍均勻初始化全局姿態,然后通過精細化網絡對其進行改進,最后將改進后的姿態傳遞給姿態選擇模塊,該模塊預測它們的得分。具有最佳得分的姿態被選為輸出。

3.1 大語言模型輔助的大規模數據生成

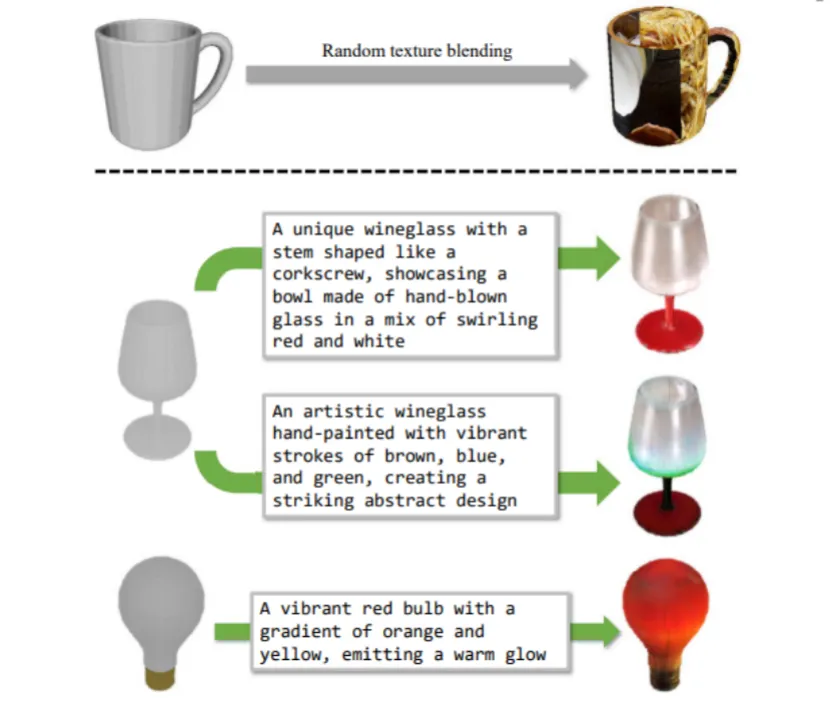

為了實現強大的泛化能力,需要大量不同的物體和場景用于訓練。在現實世界中獲取這樣的數據,并標注準確的地面真值 6D 姿態是耗時且成本高昂的。另一方面,合成數據通常缺乏 3D 模型的規模和多樣性。該研究開發了一個新穎的合成數據生成流程用于訓練,借助了最近出現的資源和技術:大規模 3D 模型數據庫 [6, 10],大型語言模型(LLM)和擴散模型 [4, 24, 53]。與之前的工作 [22, 26, 32] 相比,這種方法顯著提高了數據量和多樣性。

頂部:FS6D [22] 中提出的隨機紋理混合。底部:LLM 輔助的紋理增強使外觀更加逼真。最左邊是原始的 3D 模型。其中文本提示由 ChatGPT 自動生成。

3.2 神經輻射場物體建模

對于無模型設置,當 3D CAD 模型不可用時,一個關鍵挑戰是有效地表示物體,以便為下游模塊生成具有足夠質量的圖像。神經隱式表示對于新穎視圖合成和在 GPU 上可并行化均非常有效,因此在為下游姿態估計模塊渲染多個姿態假設時提供了高計算效率,如圖 2 所示。為此,該研究引入了一個以物體為中心的神經場表示來進行物體建模,靈感來自先前的工作 [45, 65, 71, 74]。一旦訓練完成,神經場可以被用作傳統圖形管線的替代品,以執行對物體的高效渲染,用于后續的渲染和比較迭代。除了原始 NeRF [44] 中的顏色渲染之外,還需要深度渲染來進行基于 RGBD 的姿態估計和跟蹤。

為此,該研究執行 Marching Cubes [41] 來從 SDF 的零級集中提取一個帶有紋理的網格,并與顏色投影結合。這只需要為每個物體執行一次。在推斷時,給定任意物體姿態假設,然后按照光柵化過程來渲染 RGBD 圖像。另外,也可以直接使用神經場做 online 和球追蹤 [14] 來渲染深度圖像;然而,研究團隊發現這樣做效率較低,特別是在需要并行渲染大量姿態假設時。

3.3 姿態假設生成

給定 RGBD 圖像,可以使用類似于 Mask RCNN [18] 或 CNOS [47] 這樣的現成方法來檢測物體。該研究使用在檢測到的 2D 邊界框內位于中位深度處的 3D 點來初始化平移。為了初始化旋轉,該研究從以物體為中心的球體上均勻采樣 Ns 個視點,相機朝向球心。這些相機姿態還通過 Ni 個離散化的平面旋轉進行增強,從而產生 Ns?Ni 個全局姿態初始化,這些姿態被發送到姿態精化器作為輸入。姿態精化網絡架構如總覽圖所示。

該研究首先使用單個共享的 CNN 編碼器從兩個 RGBD 輸入分支中提取特征圖。特征圖被級聯起來,通過帶有殘差連接的 CNN 塊進行處理,并通過位置嵌入進行分塊化。最后,網絡預測平移更新?t ∈ R^3 和旋轉更新?R ∈ SO (3),每個都由一個 Transformer 編碼器 [62] 單獨處理,并線性投影到輸出維度。更具體地說,?t 代表了物體在相機坐標系中的平移移動,?R 代表了物體在相機坐標系中表示的方向更新。在實踐中,旋轉是用軸 - 角度表示進行參數化的。該研究還嘗試了 6D 表示 [78],它達到了類似的結果。然后該研究更新了輸入的粗略姿態 [R | t] ∈ SE (3)。

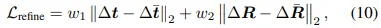

其中 ? 表示在 SO (3) 上的更新。與使用單一的齊次姿態更新不同,這種分離表示在應用平移更新時消除了對更新后方向的依賴性。這統一了相機坐標系中的更新和輸入觀察,從而簡化了學習過程。網絡訓練由 L2 損失監督:

其中 ˉt 和 Rˉ 是地面真實值;w1 和 w2 是平衡損失的權重,根據經驗設置為 1。

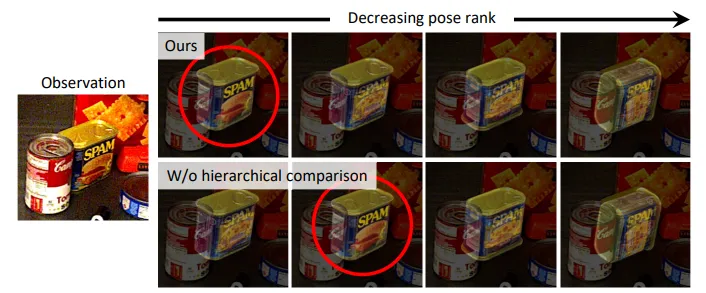

3.4 最終輸出姿態選取

給定一系列經過精化的姿態假設,該研究使用一個分層姿態排名網絡來計算它們的得分。得分最高的姿態被選為最終估計值。下圖顯示姿態排序可視化。該研究提出的分層比較利用了所有姿態假設之間的全局上下文,以更好地預測整體趨勢,使形狀和紋理都能對齊。真正的最佳姿態用紅色圓圈標注。

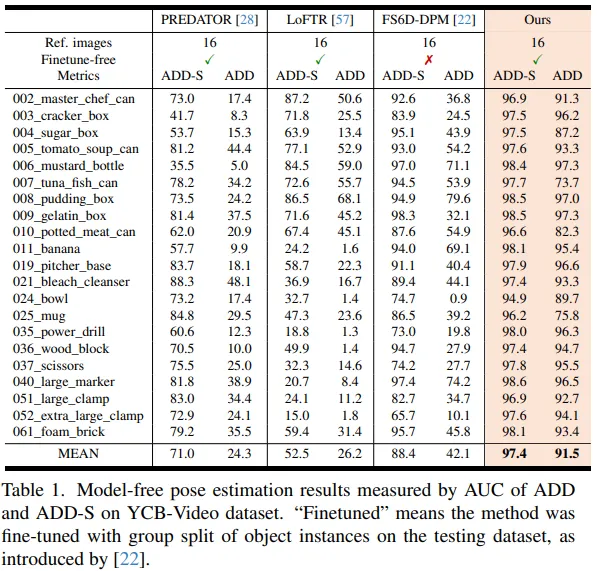

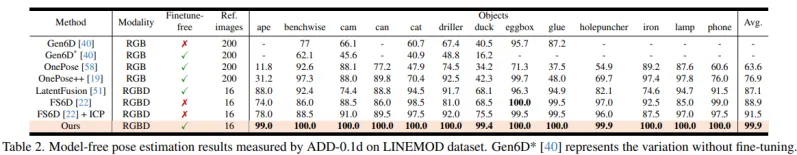

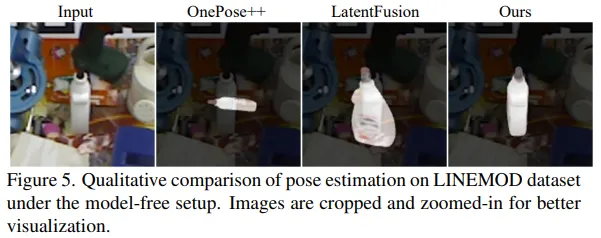

實驗和結果

該研究采用 5 個數據集對 FoundationPose 方法進行了實驗評估:LINEMOD [23],OccludedLINEMOD [1],YCB-Video [73],T-LESS [25] 和 YCBInEOAT [67]。這些數據集涉及各種具有挑戰性的場景(密集雜亂、多實例、靜態或動態場景、桌面或機器人操作),以及具有不同屬性的物體(無紋理、閃亮、對稱、尺寸變化)。

由于 FoundationPose 是一個統一的框架,該研究考慮了兩種設置(無模型和基于模型)以及兩個姿態預測任務(6D 姿態估計和跟蹤)之間的組合,總共有 4 個任務。對于無模型設置,從數據集的訓練集中選擇了一些捕獲新穎物體的參考圖像,并配備了物體姿態的地面真值注釋,按照 [22] 的方法。對于基于模型的設置,為新穎物體提供了 CAD 模型。

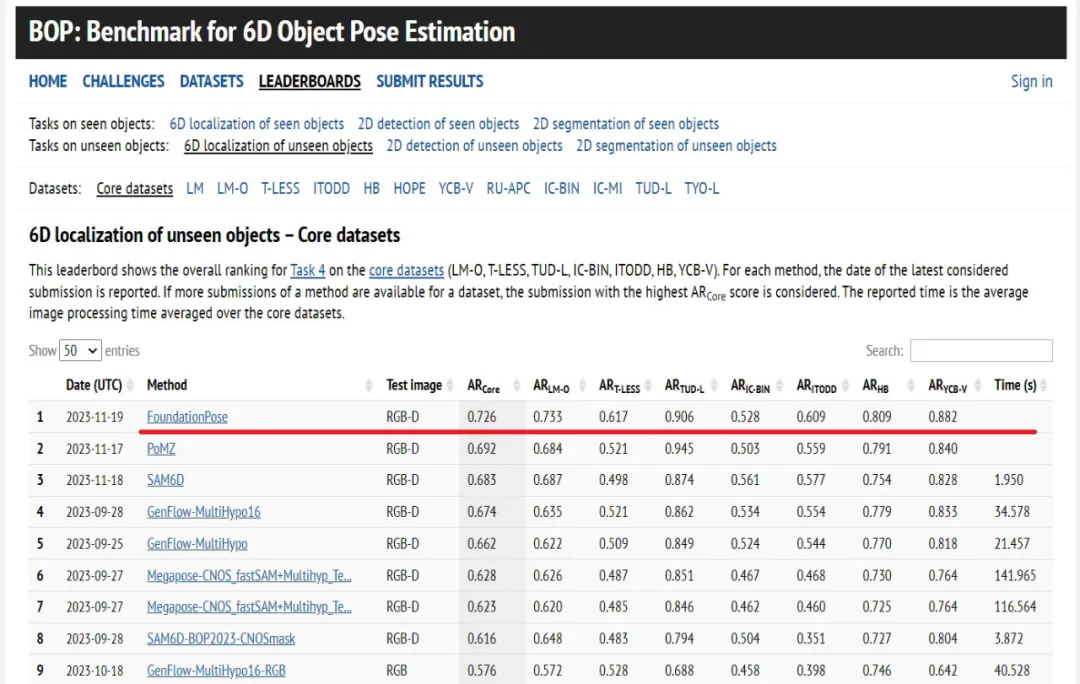

除了消融實驗外,在所有評估中,FoundationPose 始終使用相同的訓練模型和配置進行推斷,而無需任何微調。此外該研究還提交了結果至 BOP 排行榜并取得了第一名的成績。

團隊介紹

該論文來自于英偉達研究院。其中論文一作華人溫伯文博士,任研究員。他的研究方向為機器人感知和 3D 視覺,此前曾在谷歌 X、Facebook Reality Labs、亞馬遜和商湯實習,獲得過 RSS 最佳論文獎提名。

個人主頁:https://wenbowen123.github.io/