為什么大型語言模型都在使用 SwiGLU 作為激活函數?

如果你一直在關注大型語言模型的架構,你可能會在最新的模型和研究論文中看到“SwiGLU”這個詞。SwiGLU可以說是在大語言模型中最常用到的激活函數,我們本篇文章就來對他進行詳細的介紹。SwiGLU其實是2020年谷歌提出的激活函數,它結合了SWISH和GLU兩者的特點。

我們一個一個來介紹:

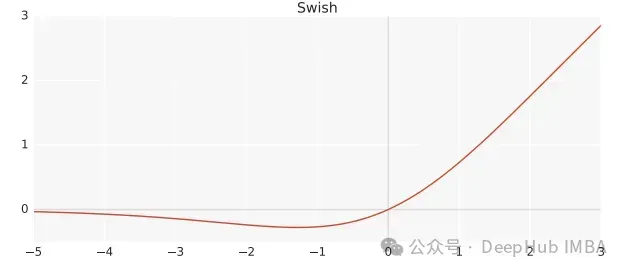

Swish

Swish是一個非線性激活函數,定義如下:

Swish(x) = x*sigmoid(?x)

其中,? 為可學習參數。Swish可以比ReLU激活函數更好,因為它在0附近提供了更平滑的轉換,這可以帶來更好的優化。

Gated Linear Unit

GLU(Gated Linear Unit)定義為兩個線性變換的分量積,其中一個線性變換由sigmoid激活。

GLU(x) = sigmoid(W1x+b)?(Vx+c)

GLU可以有效地捕獲序列中的遠程依賴關系,同時避免與lstm和gru等其他門控機制相關的一些梯度消失問題。

SwiGLU

上面我們已經說到SwiGLU是兩者的結合。它是一個GLU,但不是將sigmoid作為激活函數,而是使用?=1的swish,因此我們最終得到以下公式:

SwiGLU(x) = Swish(W1x+b)?(Vx+c)我們用SwiGLU函數構造一個前饋網絡

FFNSwiGLU(x) = (Swish1(xW)?xV)W2Pytorch的簡單實現

如果上面的數學原理看著比較麻煩枯燥難懂,我們下面直接使用代碼解釋。

class SwiGLU(nn.Module):

def __init__(self, w1, w2, w3) -> None:

super().__init__()

self.w1 = w1

self.w2 = w2

self.w3 = w3

def forward(self, x):

x1 = F.linear(x, self.w1.weight)

x2 = F.linear(x, self.w2.weight)

hidden = F.silu(x1) * x2

return F.linear(hidden, self.w3.weight)我們代碼使用的F.silu函數與?=1時的swish相同的,所以就直接拿來使用了。

代碼可以看到,我們的激活函數中也有3個權重是可以訓練的,這就是來自于GLU公式里的參數。

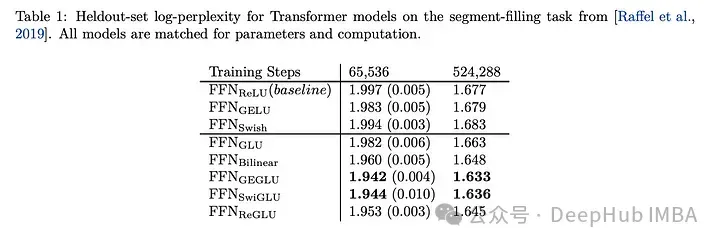

SwiGLU的效果對比

SwiGLU與其他GLU變體進行比較,我們可以看到SwiGLU在兩種預訓練期間都表現得更好。

下游任務

效果表現得最好,所以現在的llm,如LLAMA, OLMO和PALM都在其實現中采用SwiGLU。但是為什么SwiGLU比其他的好呢?

論文中只給了測試結果而且并沒有說明原因,而是說:

We offer no explanation as to why these architectures seem to work; we attribute their success, as all else, to divine benevolence.

作者說煉丹成功了。

但是現在已經是2024年了我們可以強行的解釋一波:

1、Swish對于負值的響應相對較小克服了 ReLU 某些神經元上輸出始終為零的缺點

2、GLU 的門控特性,這意味著它可以根據輸入的情況決定哪些信息應該通過、哪些信息應該被過濾。這種機制可以使網絡更有效地學習到有用的表示,有助于提高模型的泛化能力。在大語言模型中,這對于處理長序列、長距離依賴的文本特別有用。

3、SwiGLU 中的參數 W1,W2,W3,b1,b2,b3W1,W2,W3,b1,b2,b3 可以通過訓練學習,使得模型可以根據不同任務和數據集動態調整這些參數,增強了模型的靈活性和適應性。

4、計算效率相比某些較復雜的激活函數(如 GELU)更高,同時仍能保持較好的性能。這對于大規模語言模型的訓練和推理是很重要的考量因素。

選擇 SwiGLU 作為大語言模型的激活函數,主要是因為它綜合了非線性能力、門控特性、梯度穩定性和可學習參數等方面的優勢。在處理語言模型中復雜的語義關系、長依賴問題、以及保持訓練穩定性和計算效率方面,SwiGLU 表現出色,因此被廣泛采用。

論文地址