基于因果推斷的推薦系統:回顧和前瞻

本次分享的主題為基于因果推斷的推薦系統,回顧過去的相關工作,并提出本方向的未來展望。

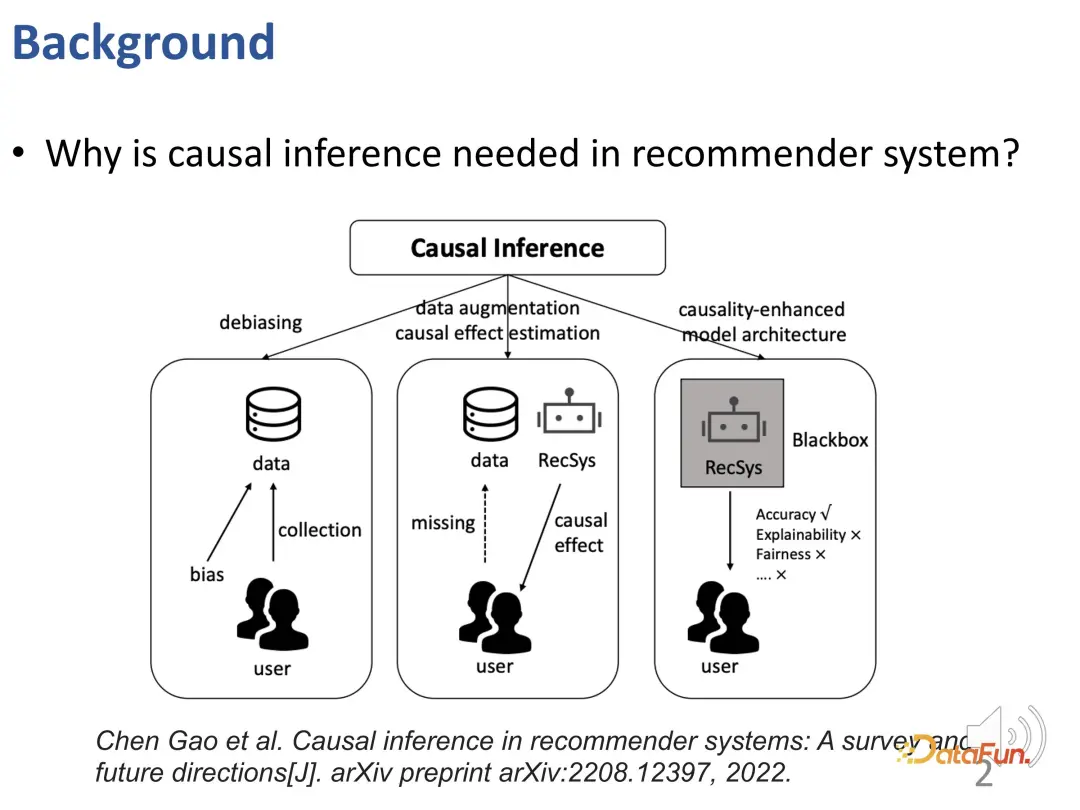

為什么在推薦系統中需要使用因果推斷技術?現有的研究工作用因果推斷來解決三類問題(參見 Gao et al.的 TOIS 2023 論文 Causal Inference in Recommender Systems: A Survey and Future Directions):

首先,在推薦系統中存在各種各樣的偏差(BIAS),因果推斷是一種有效去除這些偏差的工具。

其次,推薦系統可能面臨數據稀疏和無法準確估計因果效應的問題。為了解決這一問題,可以采用基于因果推斷的數據增強或因果效應估計的方法,來有效解決數據稀疏性、因果效應難估計的問題。

最后,借助因果知識或因果先驗知識指導推薦系統的設計,可以更好地構建推薦模型。這種方法使得推薦模型超越傳統的黑盒模型,不僅在準確性方面有提升,在可解釋性、公平性等方面更有顯著改善。

從這三種思路出發,本次分享展開介紹下面三部分工作:

- 用戶興趣和從眾性的解糾纏學習(Y. Zheng, Chen Gao, et al. Disentangling user interest and conformity for recommendation with causal embedding[C]//Proceedings of the Web Conference 2021. 2021: 2980-2991.)

- 長期興趣和短期興趣的解糾纏學習(Y. Zheng, Chen Gao*, et al. Disentangling long and short-term interests for recommendation[C]//Proceedings of the ACM Web Conference 2022. 2022: 2256-2267.)

- 短視頻推薦的去偏(Y. Zheng, Chen Gao*, et al. DVR: micro-video recommendation optimizing watch-time-gain under duration bias[C]//Proceedings of the 30th ACM International Conference on Multimedia. 2022: 334-345.)

一、用戶興趣和從眾性的解糾纏學習

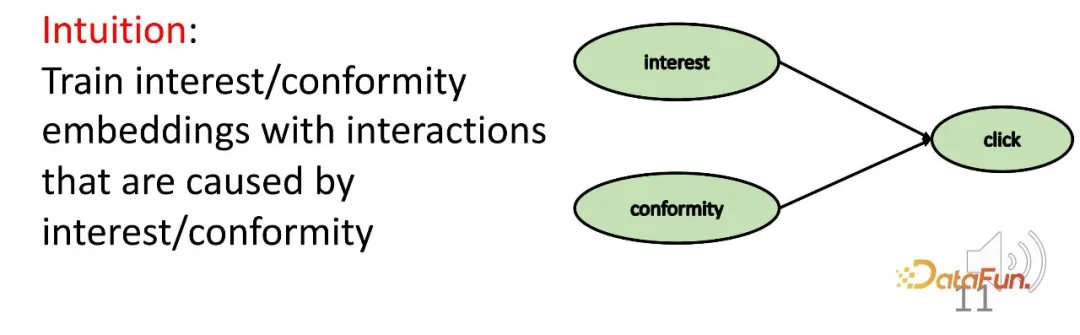

首先,通過因果推斷方法為用戶的興趣以及從眾性分別學習相應的表征。這屬于前述分類框架中的第三部分,即在有因果先驗知識的情況下,使模型更具可解釋性。

回到研究背景。可以觀測到用戶和商品的交互背后存在深層次的、不同方面的原因。一方面是用戶本身的興趣,另一方面用戶可能會傾向于追隨其他用戶的做法(從眾性/Conformity)。在具體的系統中,這可能表現為銷量或流行度。例如,現有推薦系統會將銷量較高的商品展示在靠前的位置,這就導致了用戶自身興趣之外的流行度影響交互、帶來偏差。所以,為了進行更精準的推薦,需要分別學習和解糾纏這兩部分的表征。

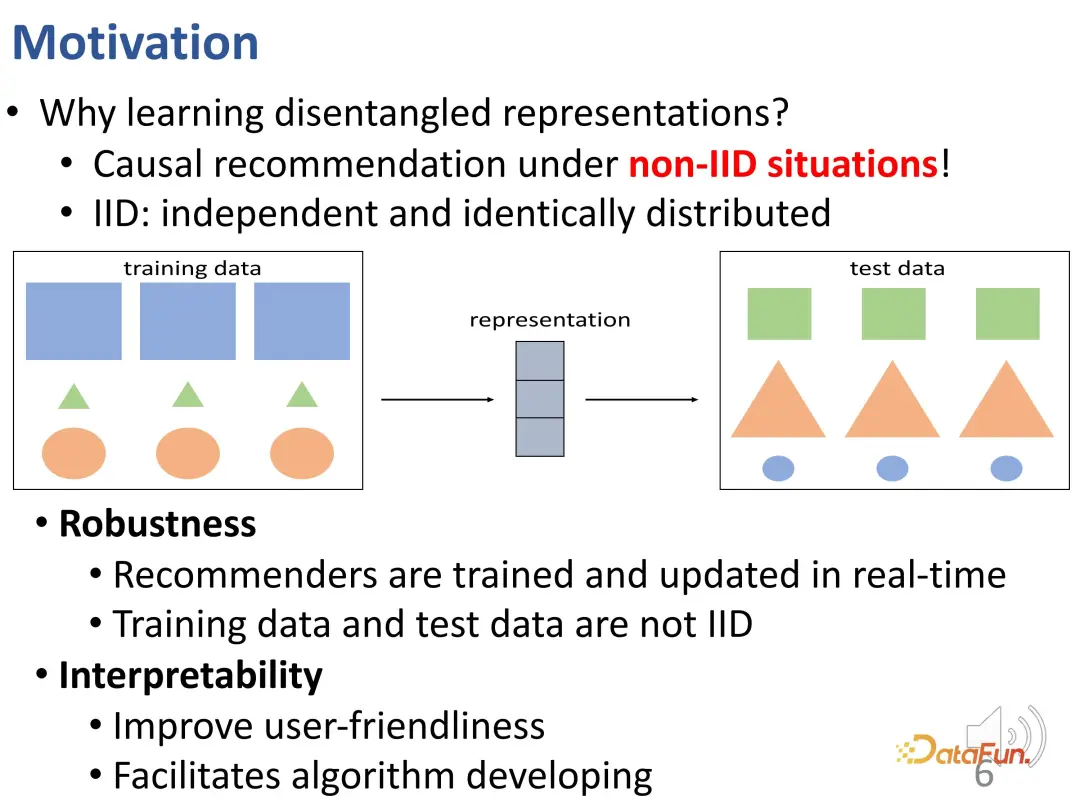

為什么需要學習解糾纏表征呢?在這里,進一步做一個更深入的解讀。解糾纏表征可以幫助克服離線訓練數據和線上實驗數據分布不一致(OOD)的問題。在真實的推薦系統中,如果在某一個數據分布下訓練了一個離線推薦系統模型,需要考慮到部署到線上時數據分布可能發生變化。用戶最終的行為是由從眾性和興趣共同作用產生的,這兩部分的相對重要性在線上和線下環境存在區別,可能導致數據分布發生變化;而如果分布發生變化,無法保證學習的興趣仍然有效。這是一個跨分布的問題。下圖可以形象化地說明這個問題。在這個圖中,訓練數據集和測試數據集存在分布差異:同樣的形狀,其大小和顏色發生了變化。而對形狀的預測,傳統模型在訓練數據集上可能會依據大小和顏色來推斷形狀,比如矩形都是藍色的和最大的,但是對于測試數據集推斷并不成立。

如果要更好地克服這個困難,就需要有效地確保每個部分的表征是由相應的因子決定的。這是學習解糾纏表征的一個動機。能夠將潛在因子解糾纏出來的模型,在類似上圖的跨分布情況下可以取得更好的效果:比如解糾纏學習到輪廓、顏色和大小等因子,并偏向使用輪廓預測形狀。

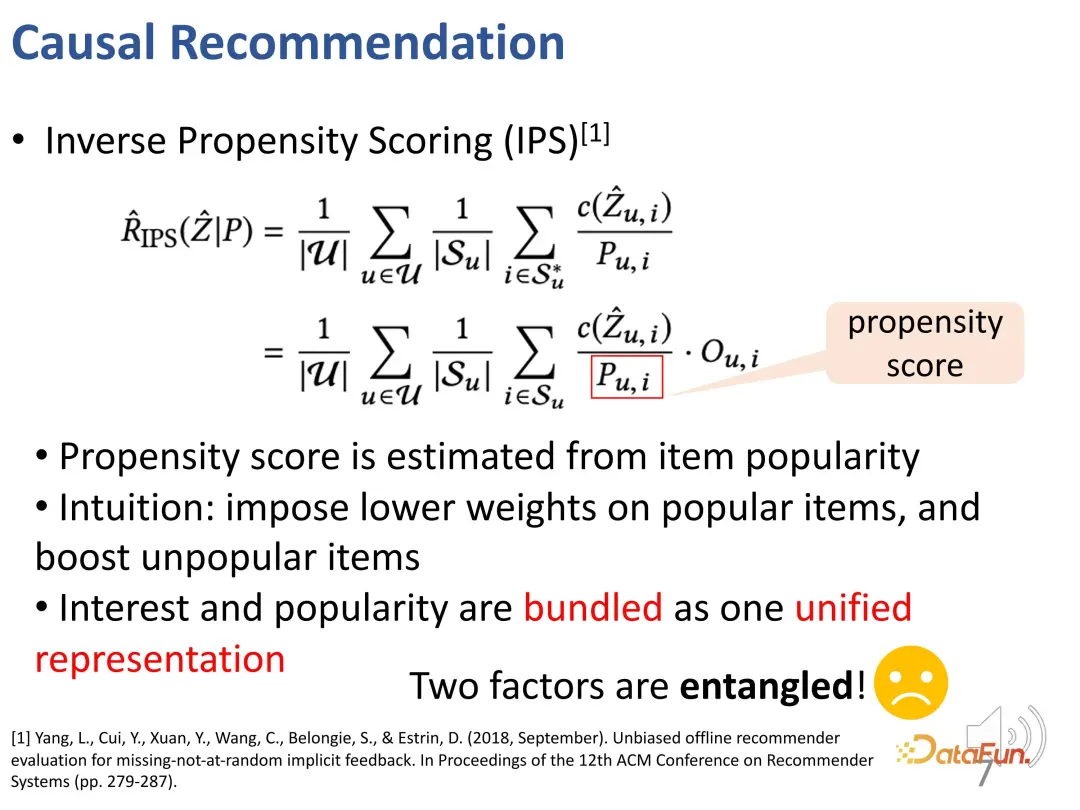

傳統做法是使用 IPS 方法來平衡商品的流行度。這種方法在推薦系統模型學習的過程中,懲罰過于流行的商品(這些商品在從眾上具有更大的權重)。但這種做法將興趣和從眾性捆綁在一起,沒有有效地將它們分開。

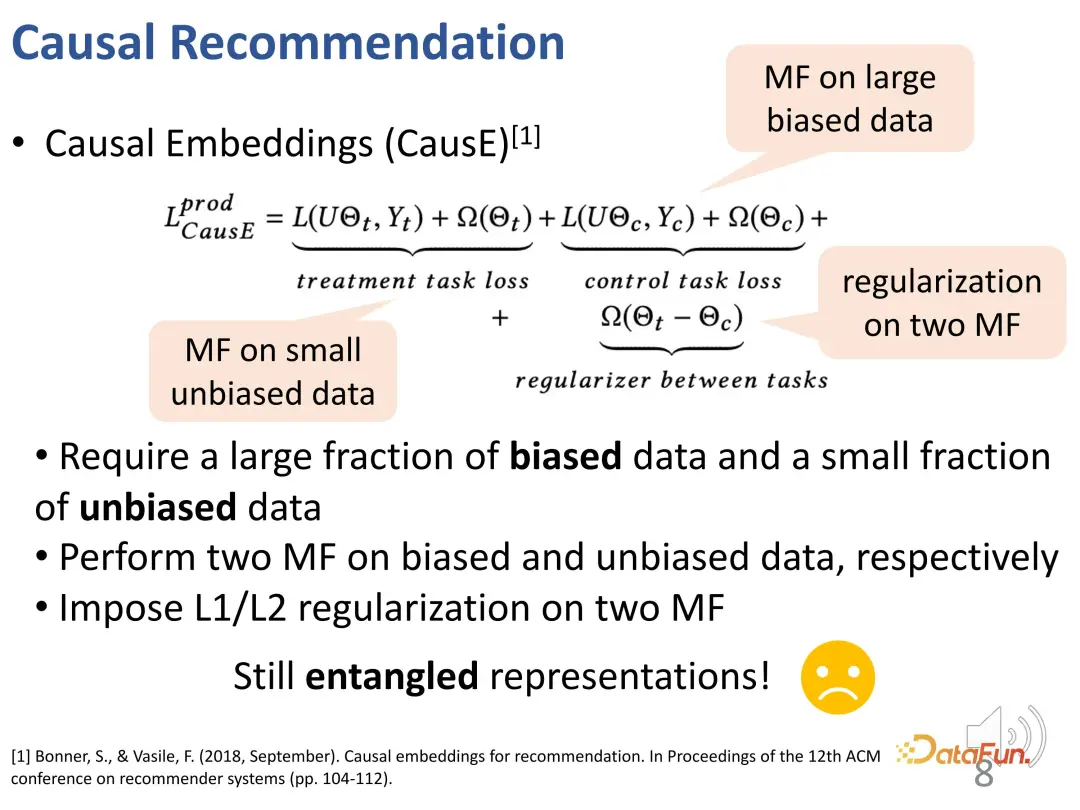

早期還有一些工作,通過因果推斷的方法來學習因果表征(Causal embedding)。這類工作的缺點是必須依賴于一些無偏的數據集,通過無偏數據集來約束有偏數據集的學習過程。雖然不需要太多,但仍然需要一小部分無偏數據來學習解糾纏的表征。因此,在真實系統中,其適用性相對有限。

如果想對興趣和從眾性解糾纏,需要解決三個挑戰:

- 多變的從眾性:從眾性實際上是一個更加泛化或者說更加普遍的概念,它涉及到流行度偏差。從眾性是由用戶和物品共同決定的,一個用戶在不同物品上的從眾性可能是不同的,反之亦然。

- 解糾纏的困難性:直接去學習一個解糾纏表征是頗具挑戰性的。只能得到觀測數據(一個受到興趣和從眾性兩者影響之后的行為),而沒有對用戶興趣的一個 ground truth,即對于興趣和從眾性兩者本身各自沒有顯式的標簽。

- 用戶行為的多因性:用戶的某次交互可能來自單個因子作用,也可能來自兩個因子共同作用,推薦系統需要細致的設計來有效綜合兩個因子。

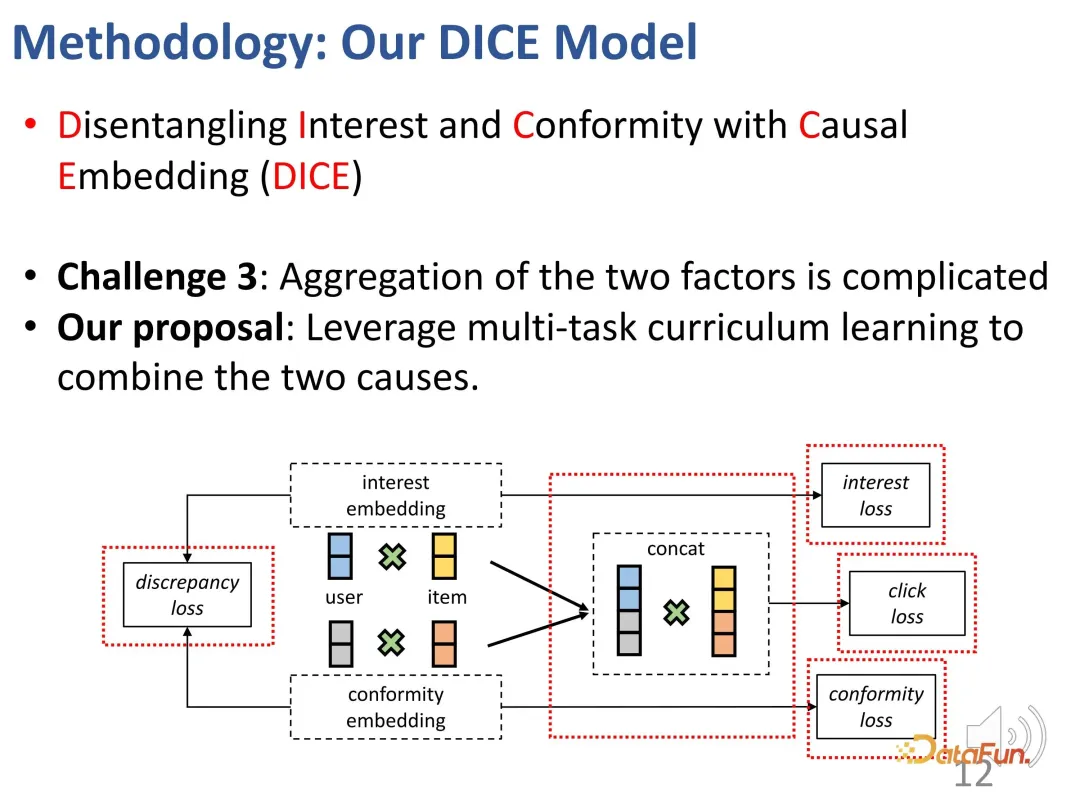

為了針對性解決上述挑戰,我們提出了 DICE 方法(Disentangling Interest and Conformity with Causal Embedding (DICE))。

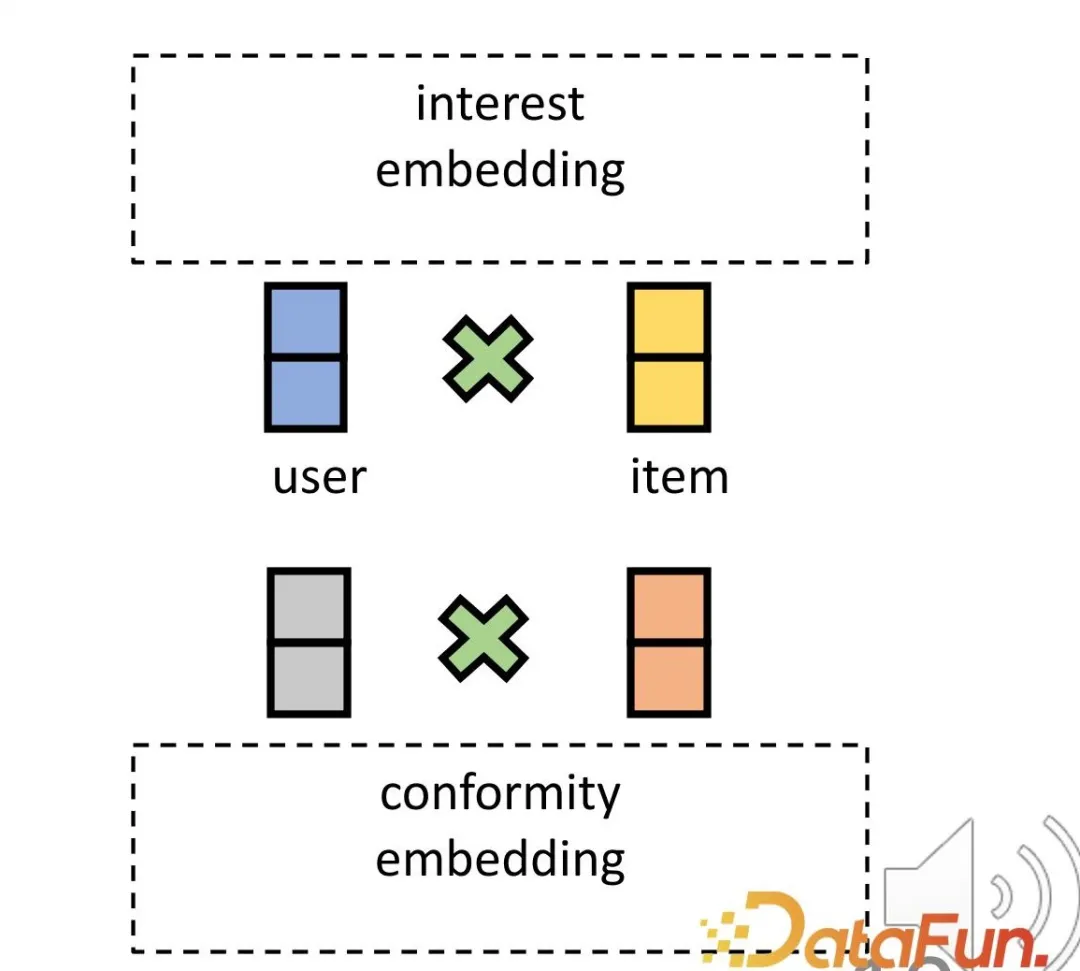

- 為了解決第一個挑戰,為用戶和商品在興趣和從眾性上各自設置了相應的表征。首先,高維空間上的用戶和商品的 embedding 交互,能有效表達多樣化的從眾性。其次,這個方法能夠有效地在高維空間上直接解開興趣和從眾性,而不再依賴于一個共同的表征,實現了這兩者的獨立性。

- 為了解決第二個挑戰,利用了因果推斷中的對撞關系。興趣和從眾共同導致行為,存在對撞關系,則利用這個關系獲取特定因果的數據來為兩部分分別學習相應的表征。

- 為了解決用戶行為多因性挑戰,使用一個多任務的漸進式學習(Curriculum learning, CL)方法來有效地結合這兩個因子,實現最后的推薦。

接下來對這三部分設計(即因果 embedding、解糾纏表征學習、多任務課程學習)具體展開介紹。

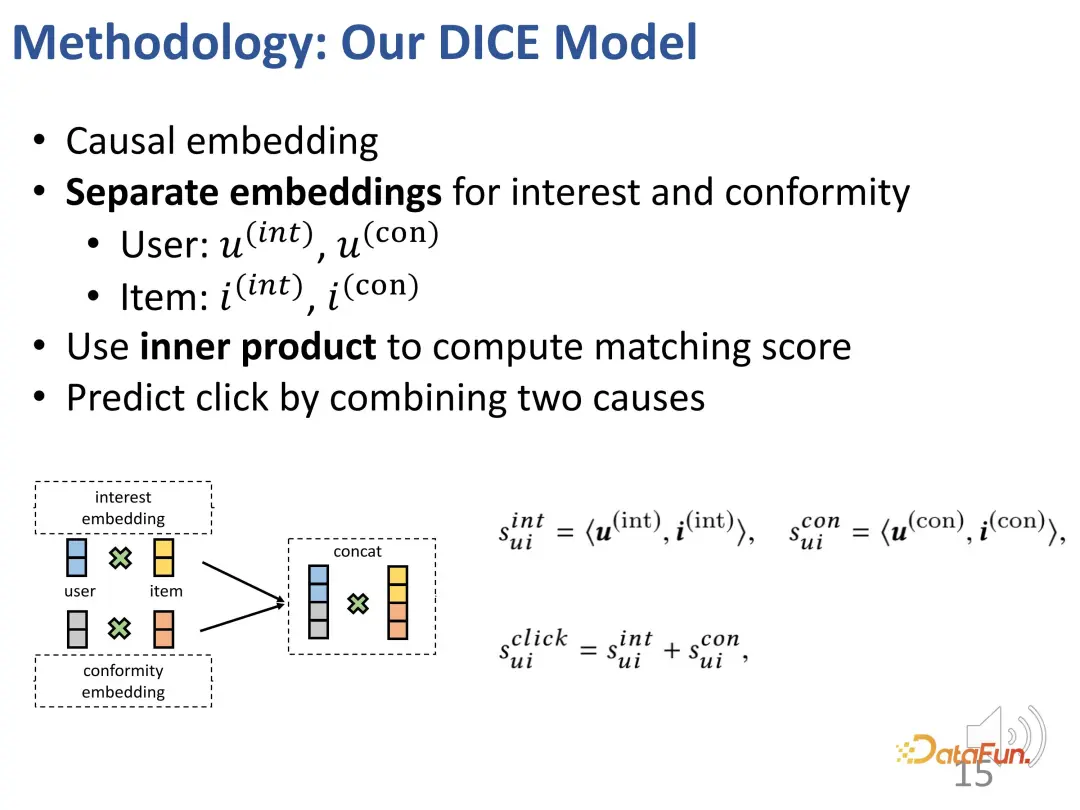

1. 因果 embedding

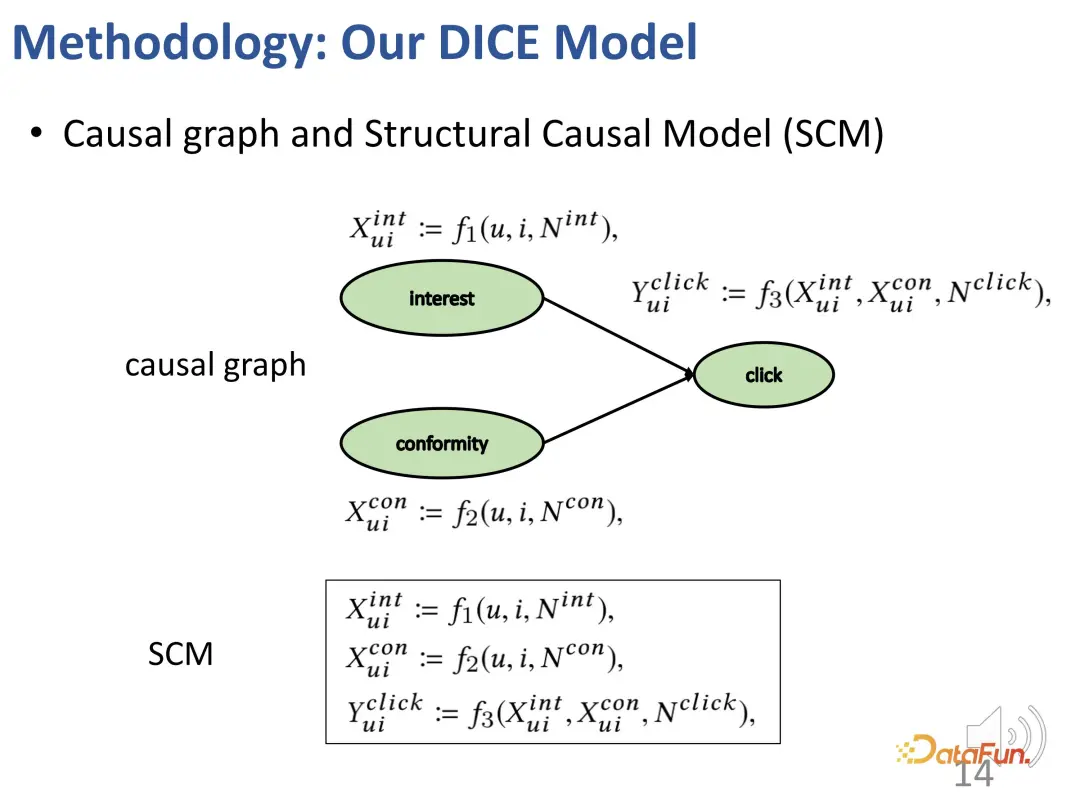

首先,構建一個結構因果模型,包括興趣和從眾行為。

為這兩個因素分別分配相應的獨立表征,用戶側和物品側每側都有兩部分表征。使用經典的點積來計算匹配分數。在最后的預測任務中,綜合考慮兩部分的內積分數。

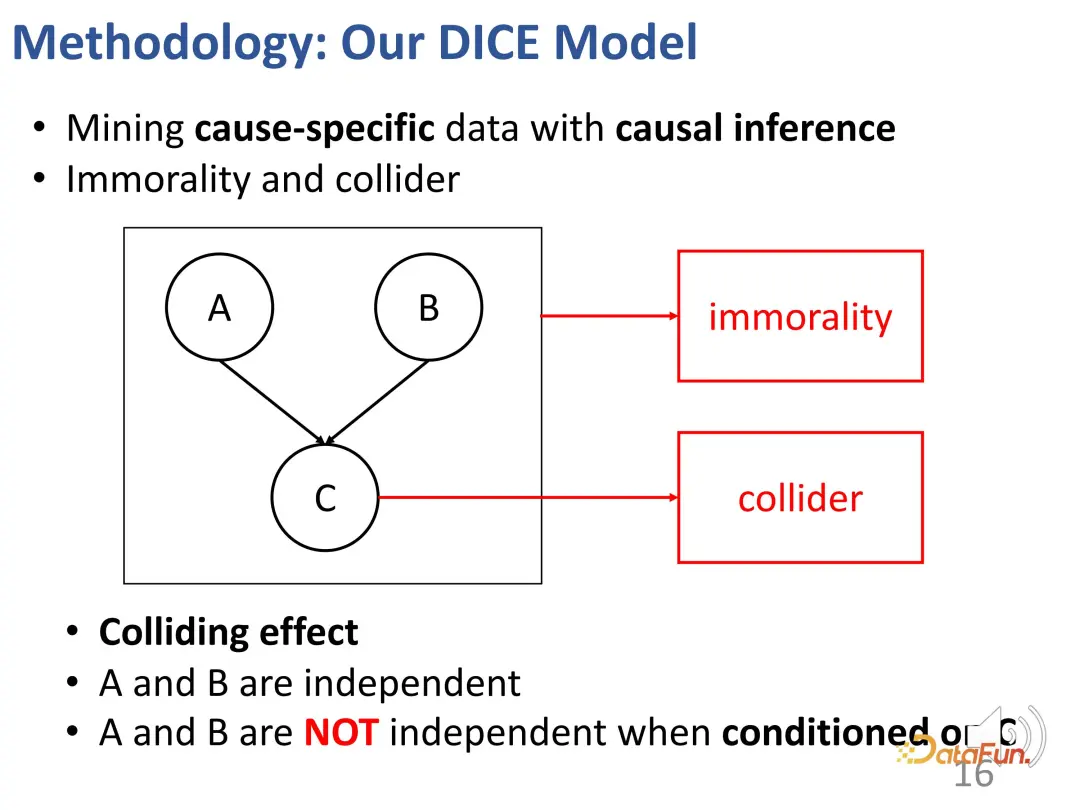

2. 解糾纏表征學習

在給定上述這樣一個對撞結構后,當固定條件 c 時,a 和 b 實際上是不獨立的。舉一個例子來解釋這個效應:比如,a 代表一個學生的天賦,b 代表這個學生的勤奮程度,c 代表這個學生是否能夠通過一個考試。如果這個學生通過考試,而且他沒有特別強的天賦,那么他一定是很努力的。另外一個學生,他沒有通過考試,但是他卻非常有天賦,那么這個同學可能不太努力。

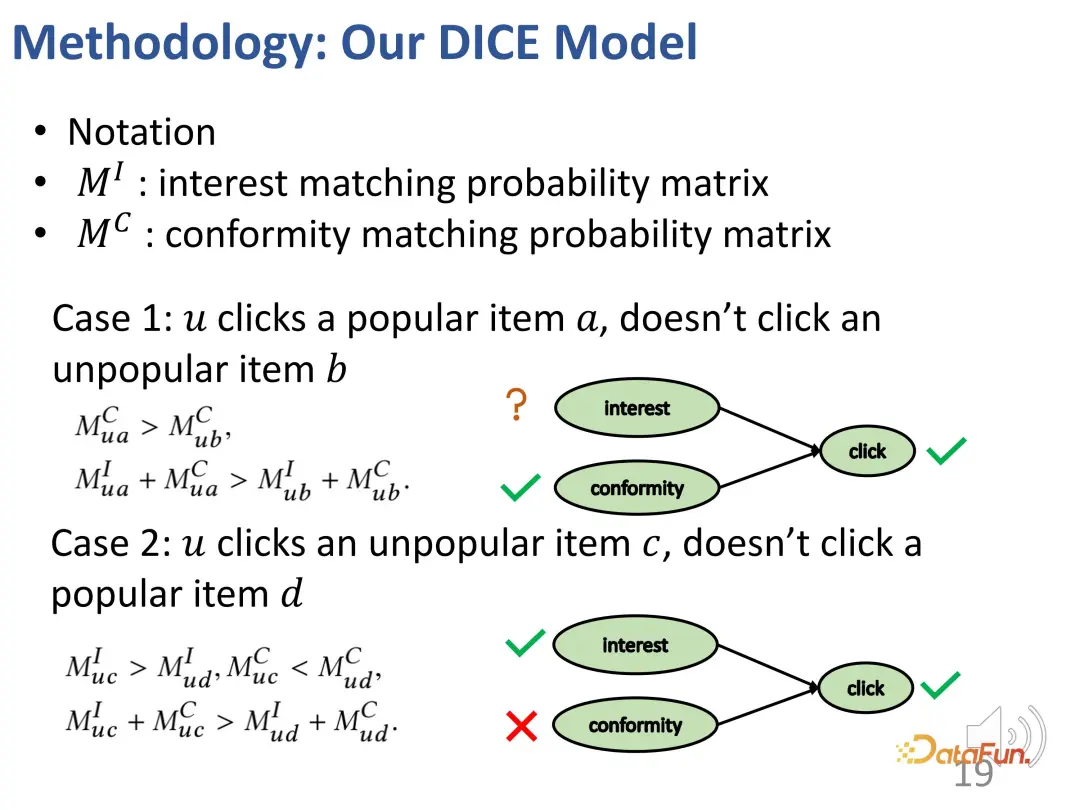

基于這樣的思想,進行方法設計,分有興趣的匹配和從眾度的匹配,并使用商品流行程度作為從眾性的代理。

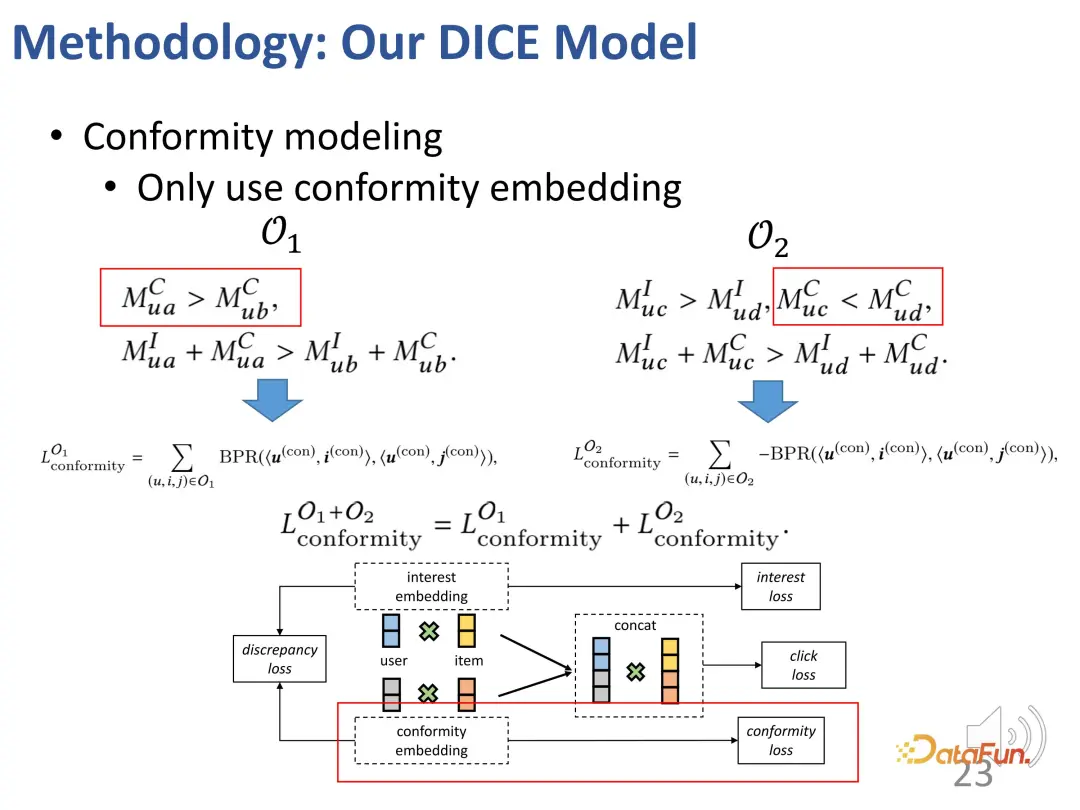

第一個案例:如果一個用戶點擊了一個比較流行的項目 a,而沒有點擊另外一個不那么流行的項目 b,類似剛才的例子,會有下圖這樣的興趣關系:a 對用戶的從眾性大于 b(因為 a 比 b 更流行),且 a 對用戶的總體吸引力(興趣+從眾性)大于 b(因為用戶點擊了 a 而沒有點擊 b)。

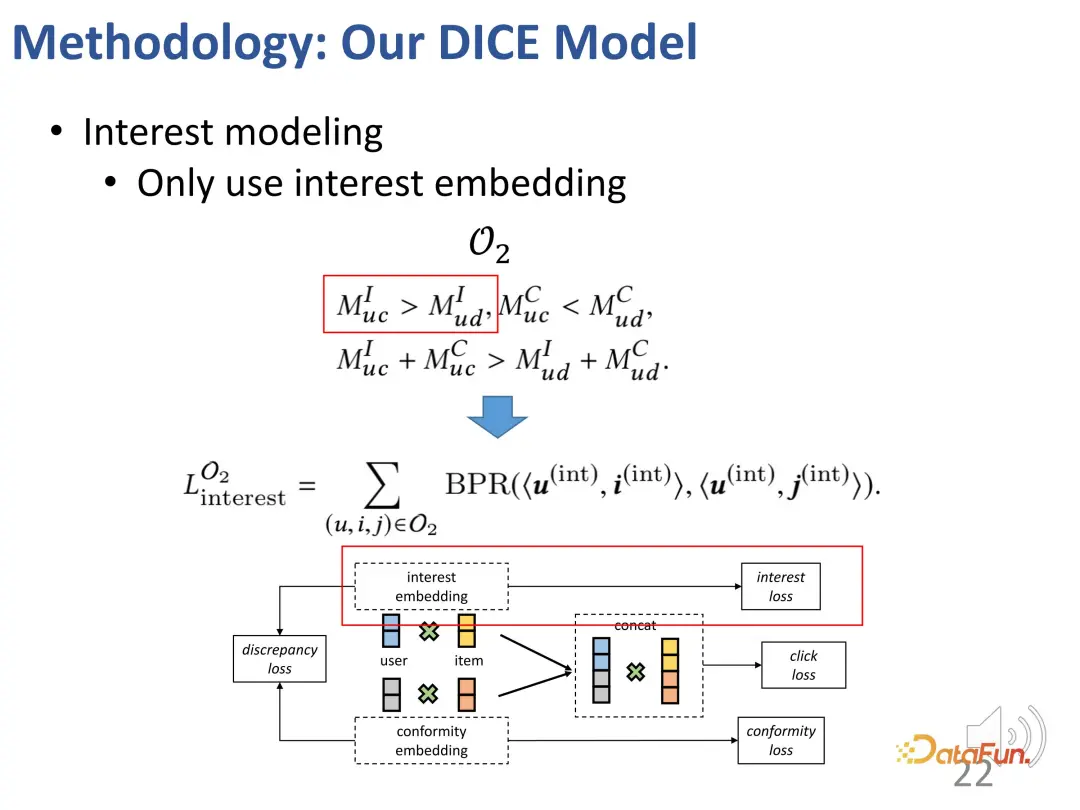

第二個案例:一個用戶點擊了一個不流行的項目 c,但是沒有點擊一個流行的項目 d,產生如下的一個關系:c 對用戶的從眾性小于 d(因為 d 比 c 更流行),但 c 對用戶的總體吸引力(興趣+從眾性)大于 d(因為用戶點擊了 c 而沒有點擊 d),從而用戶對 c 的興趣大于 d(因為對撞關系,如前述)。

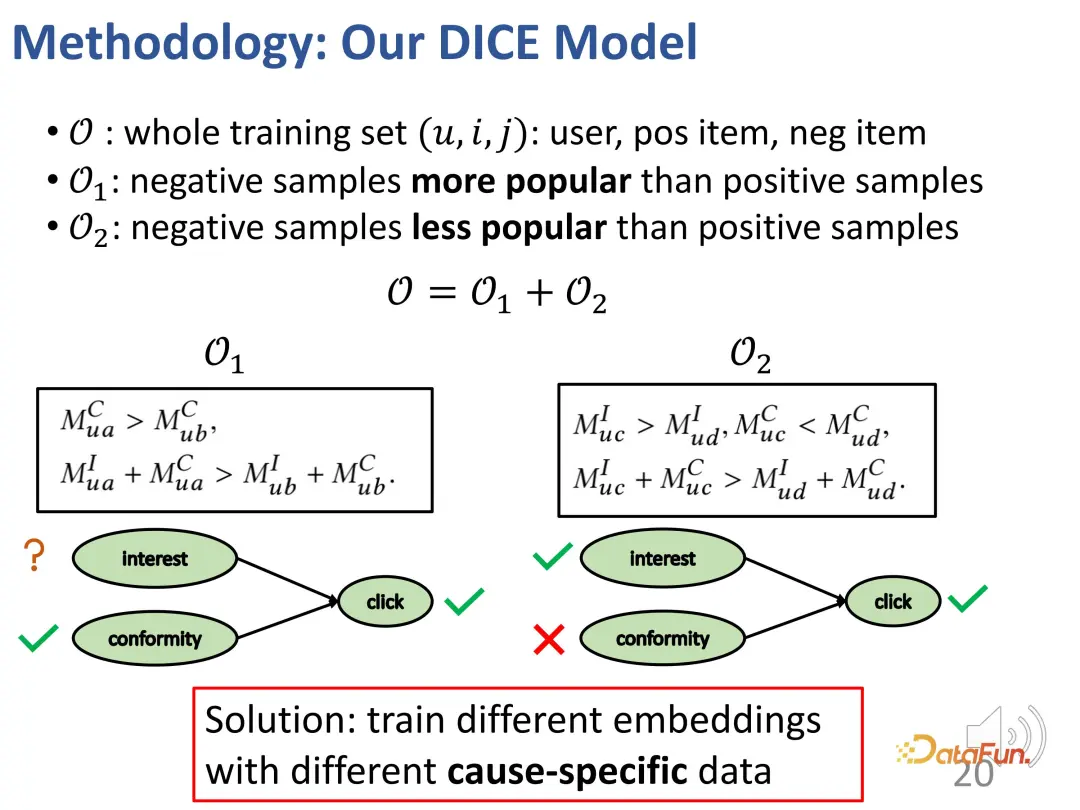

總體而言,通過上述方法構造了兩個集合:一是那些比正樣本不流行的負樣本(用戶對正負樣本的興趣的對比關系未知),二是那些比正樣本更流行的負樣本(用戶對正樣本的興趣大于負樣本)。在這兩個部分上,都可以構建對比學習的關系,從而有針對性地訓練兩個部分的表征向量。

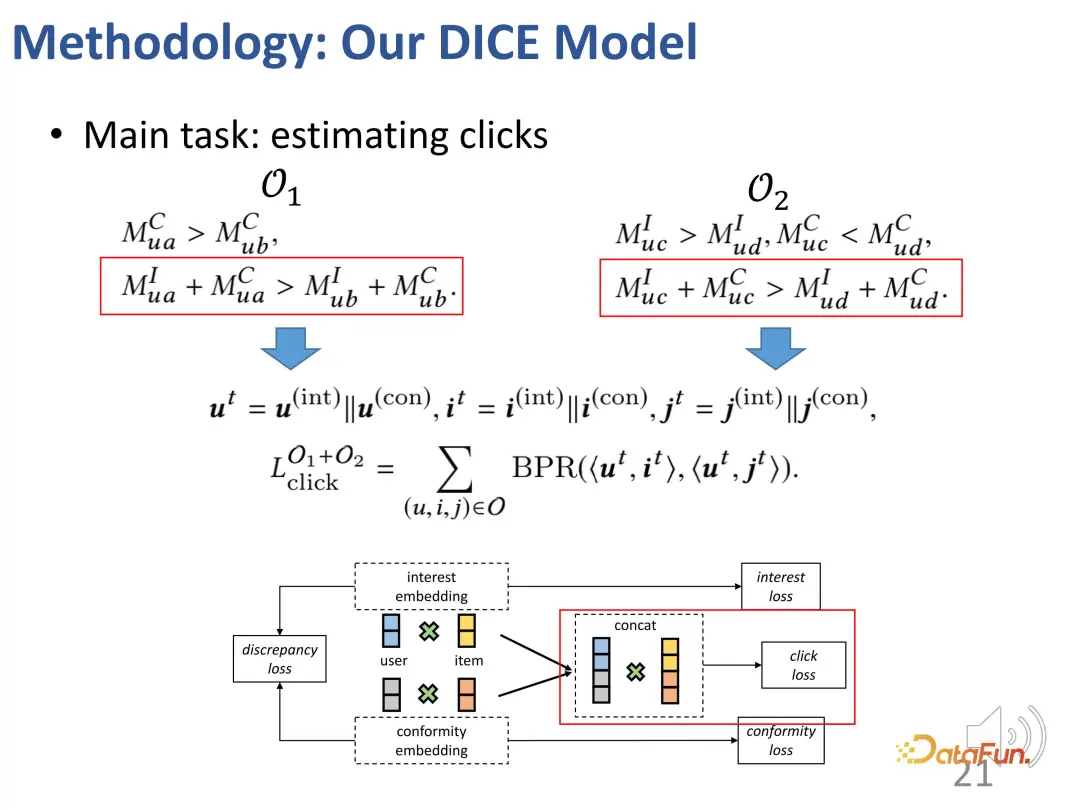

當然,在實際訓練過程中,最主要的目標仍然是擬合觀測到的交互行為。和大多數推薦系統工作相同,使用 BPR loss預測點擊行為。(u: 用戶,i:正樣本商品,j:負樣本商品)。

另外基于上述思想,還分別設計了兩個部分的對比學習方法,并引入對比學習的損失函數,額外引入兩部分表征向量的約束,來優化這兩部分的表征向量

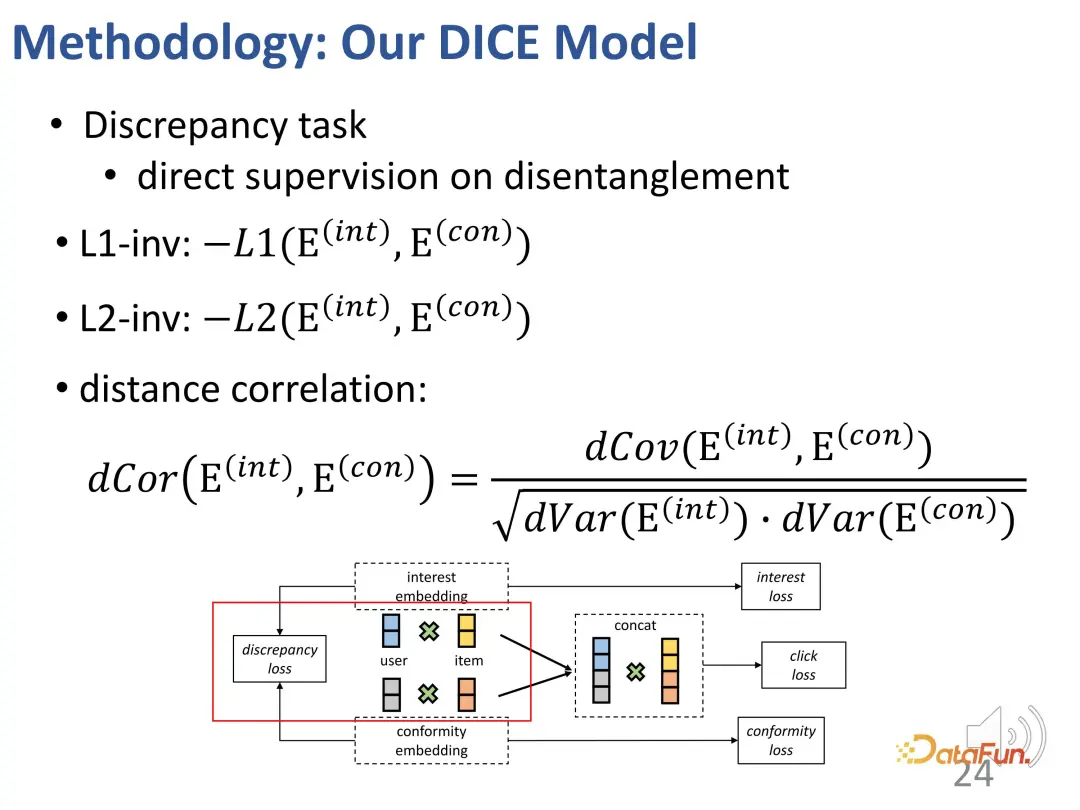

此外,還要約束這兩部分的表征向量盡可能地遠離彼此。這是因為如果距離過近,它們可能會失去區分度。因此,額外引入了一個損失函數來約束兩部分表征向量之間的距離。

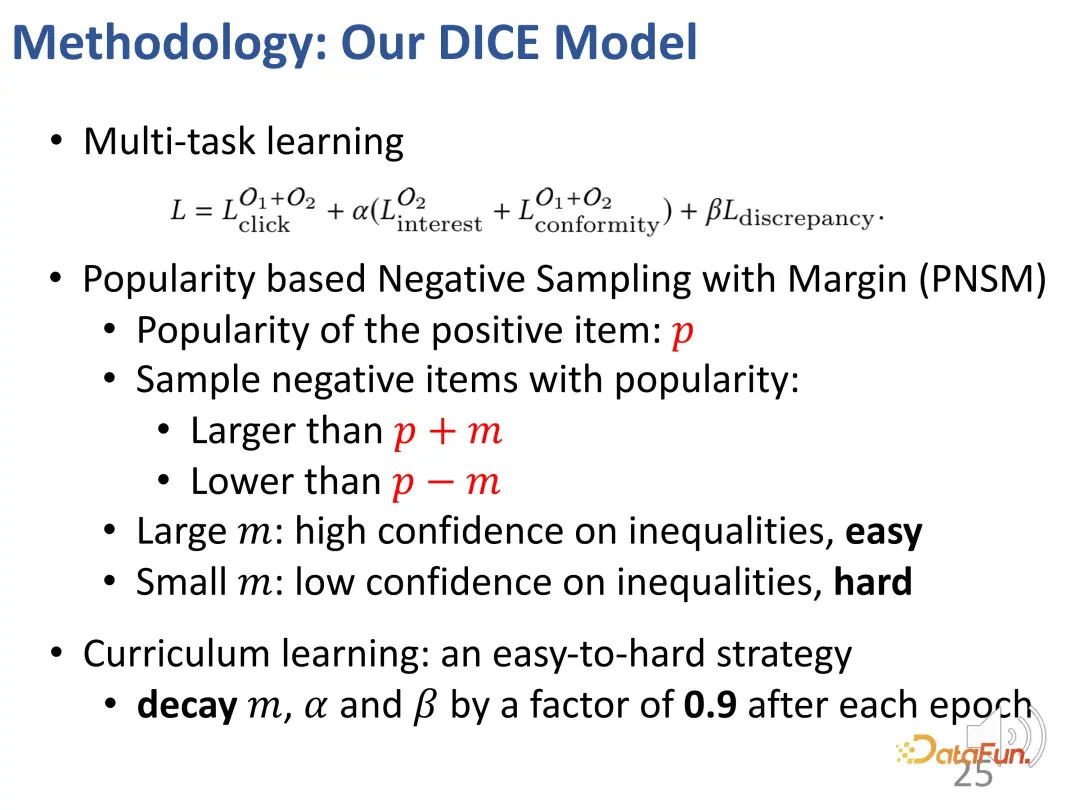

3. 多任務課程學習

最終,多任務學習將把多個目標整合在一起。在這個過程中,設計了一種策略,確保能夠從學習的難度上逐漸從簡單過渡到困難。在訓練的開始,使用區分度較小的樣本,來引導模型參數在正確的大方向上進行優化,然后逐漸尋找困難樣本進行學習,進一步精細調整模型參數。(將和正樣本的流行度差異大的負樣本視為簡單樣本,差異小的視為困難樣本)。

4. 方法效果

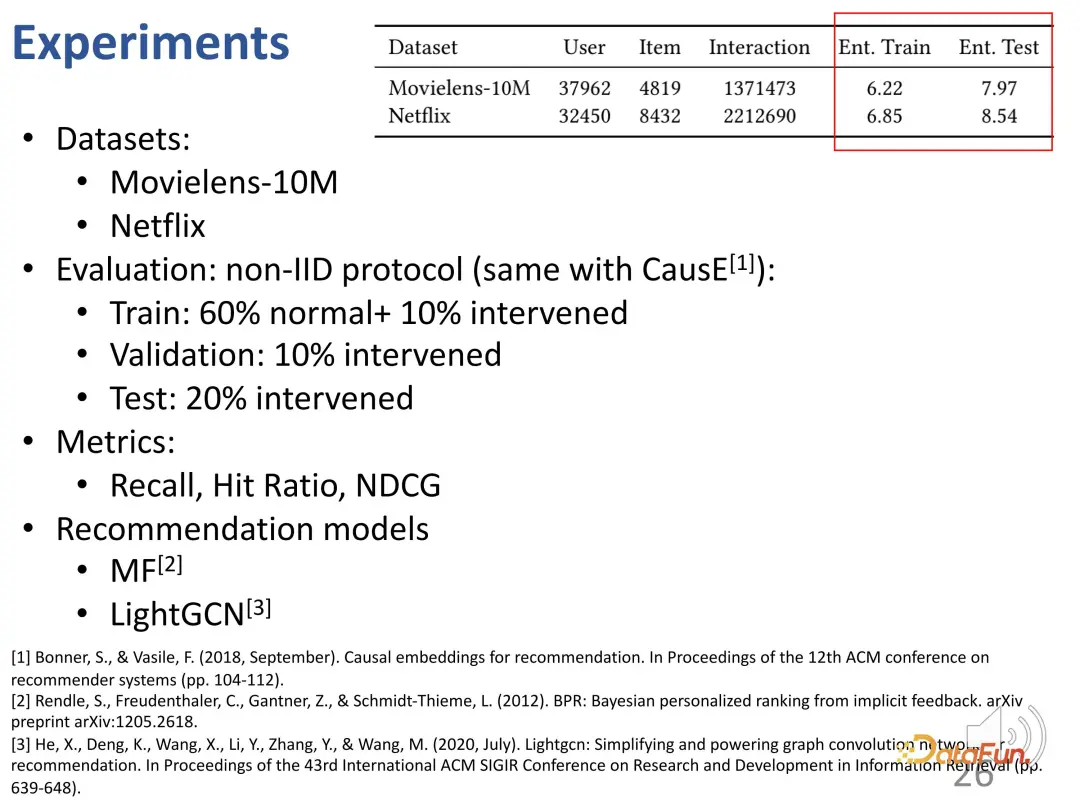

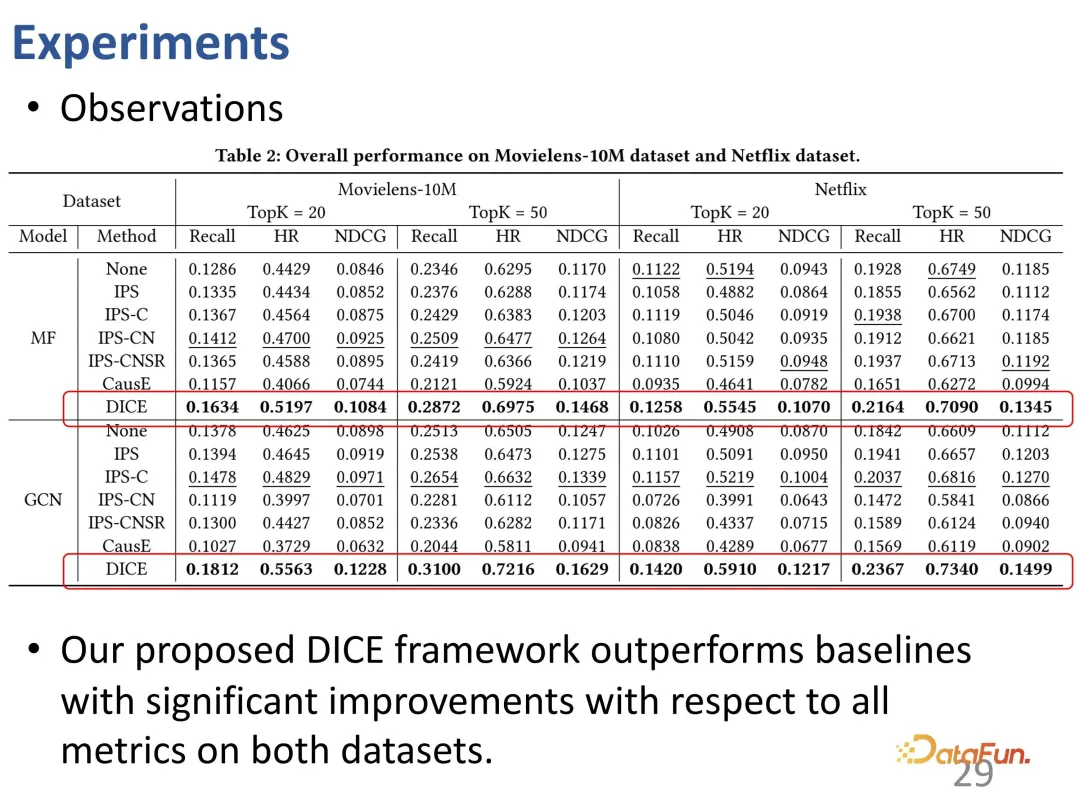

在常見的數據集上,進行了測試,檢驗方法在主要排序指標上的性能。由于 DICE 是一個通用的框架,不依賴于具體的推薦模型,因此可以將不同模型視為一種 backbone,并將 DICE 作為一種即插即用的框架。

首先是主角 DICE。可以看到在不同的 backbone 上,DICE 的提升比較穩健,因此可以認為它是能帶來性能提升的通用框架。

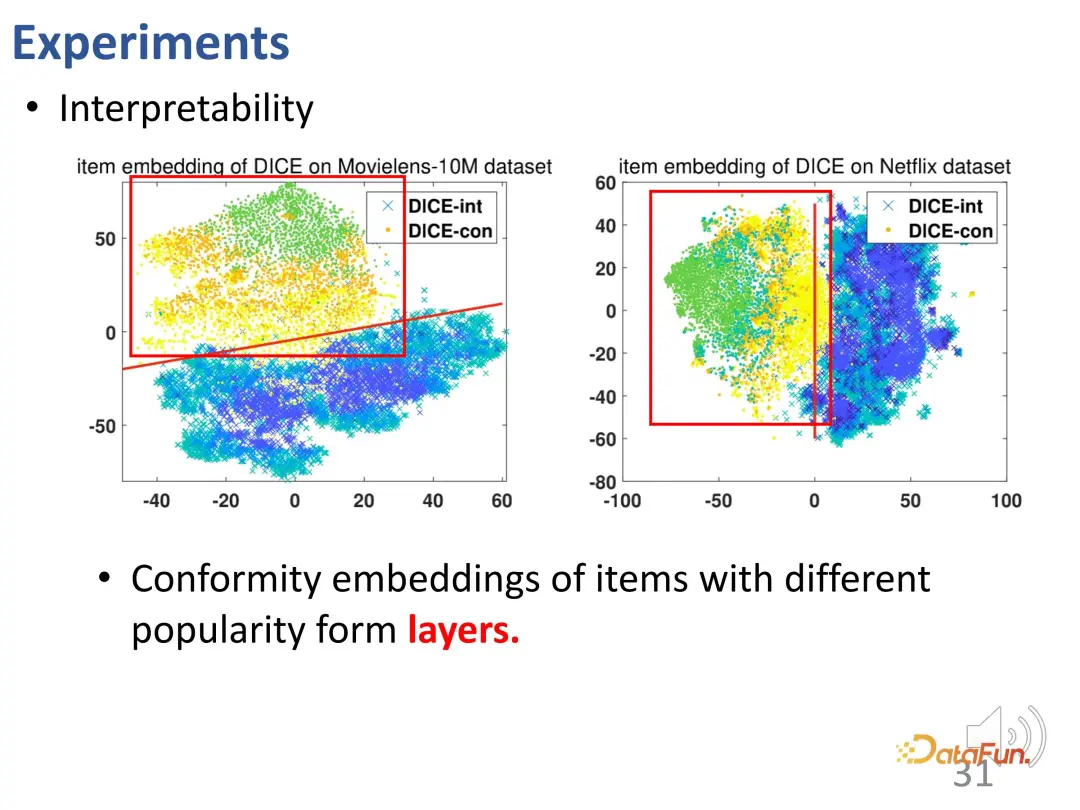

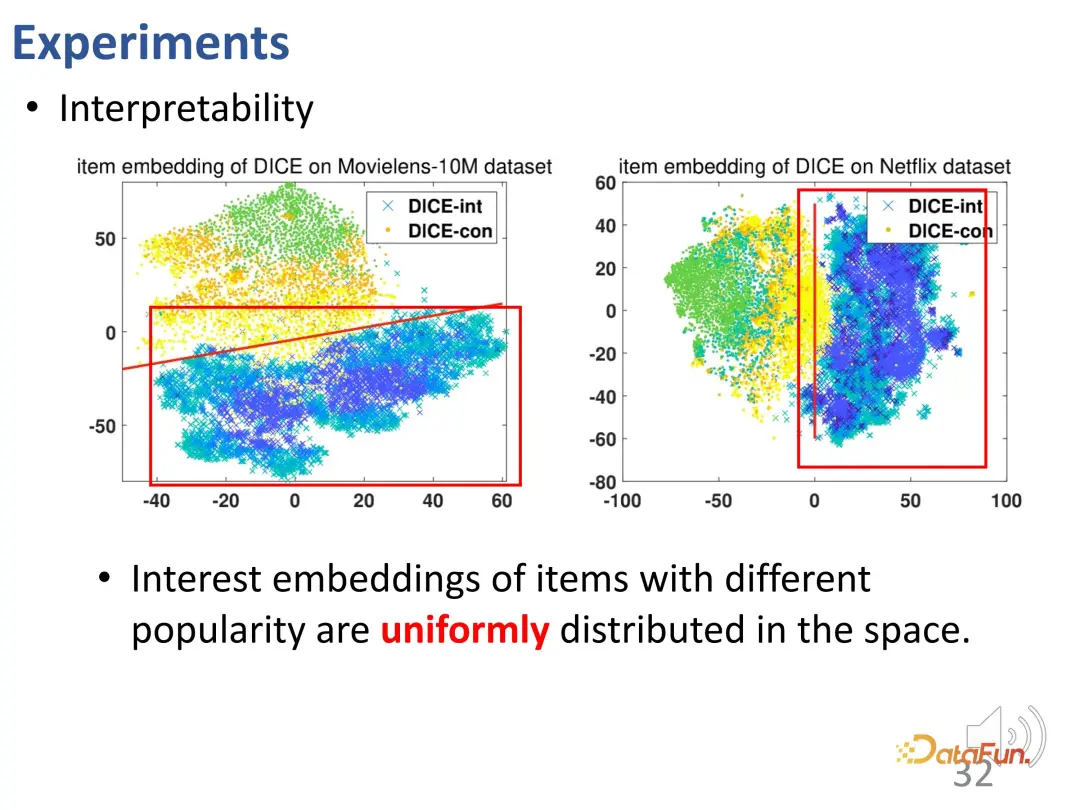

DICE 學習到的表征是可解釋的,為興趣和從眾度分別學習表征之后,從眾部分的向量蘊含了商品的流行度。通過進行可視化,發現它確實與流行度有關系(不同流行度的表征呈現明顯的分層:綠橙黃色的點)。

并且,不同流行度的商品的興趣向量表征均勻散布在空間中(青紫色叉)。從眾性向量表征和興趣向量表征也各自占有不同的空間,解糾纏區隔開來。這個可視化驗證了 DICE 學習到的表征具有實際意義。

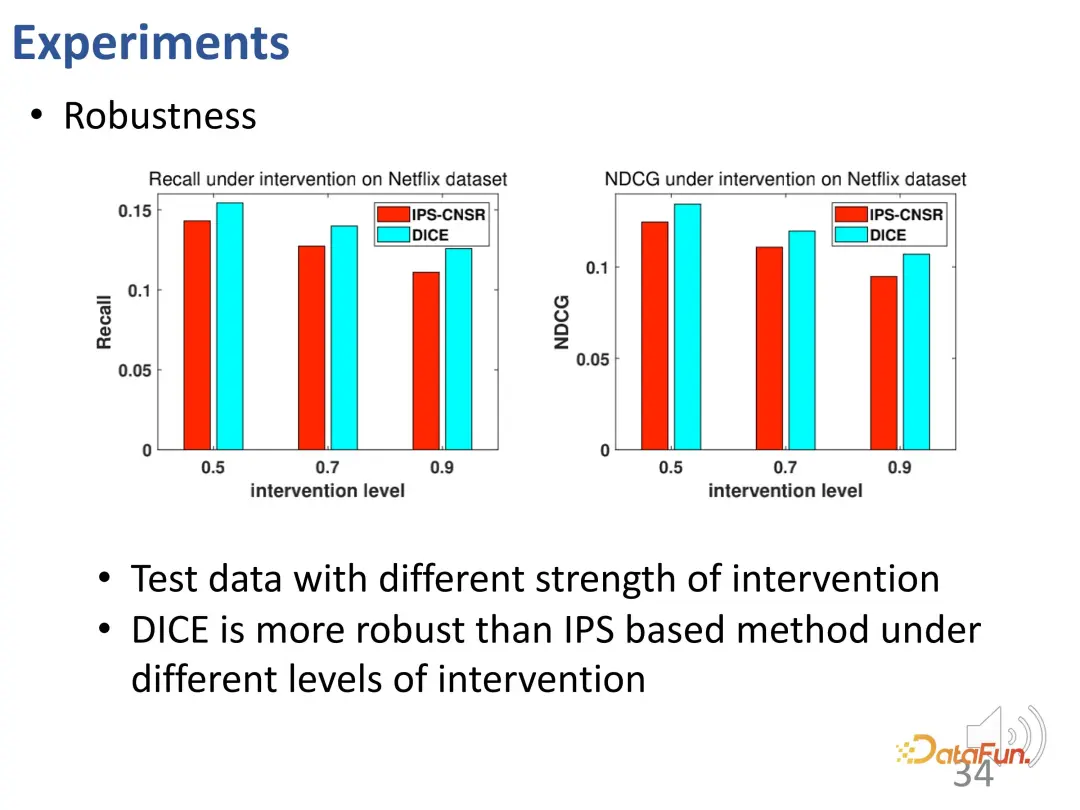

DICE 達到了設計的預期效果。進一步在不同干預強度的數據上進行了測試,結果顯示 DICE 的性能在不同實驗組上都要好于 IPS 方法。

總結一下,DICE 通過因果推斷工具,為興趣和從眾性分別學習相應的表征向量,在非 IID 情形下提供了良好的魯棒性和可解釋性。

二、長期興趣和短期興趣的解糾纏學習

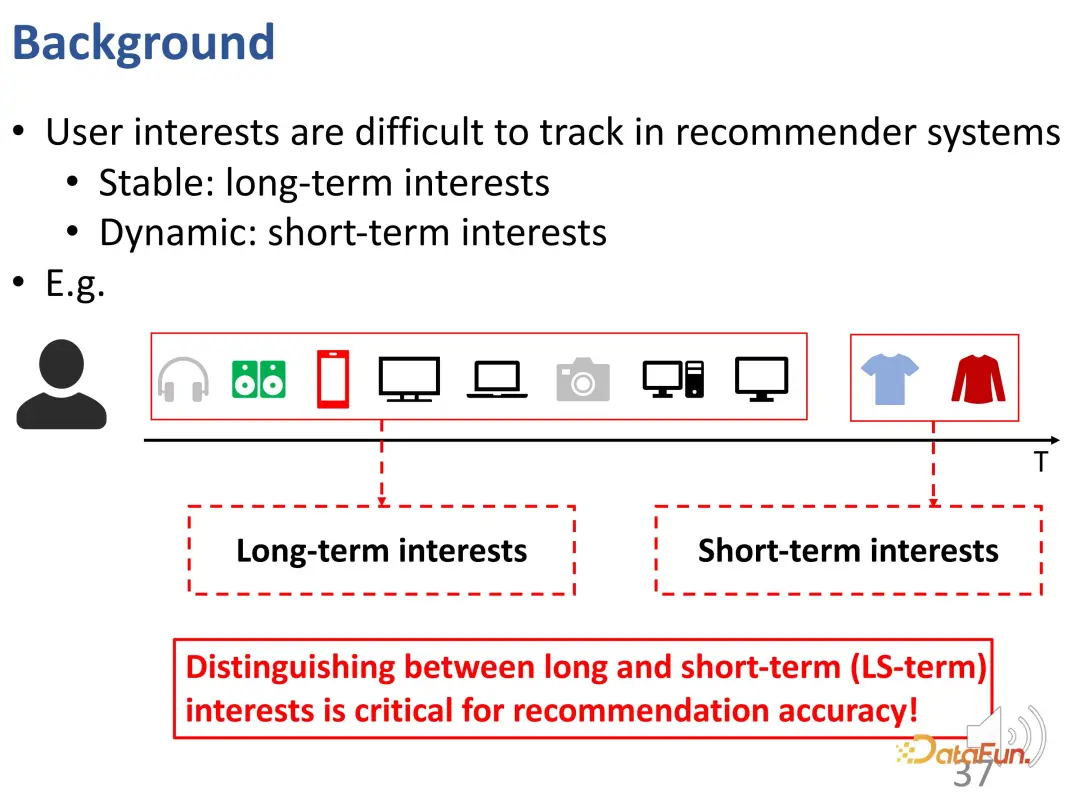

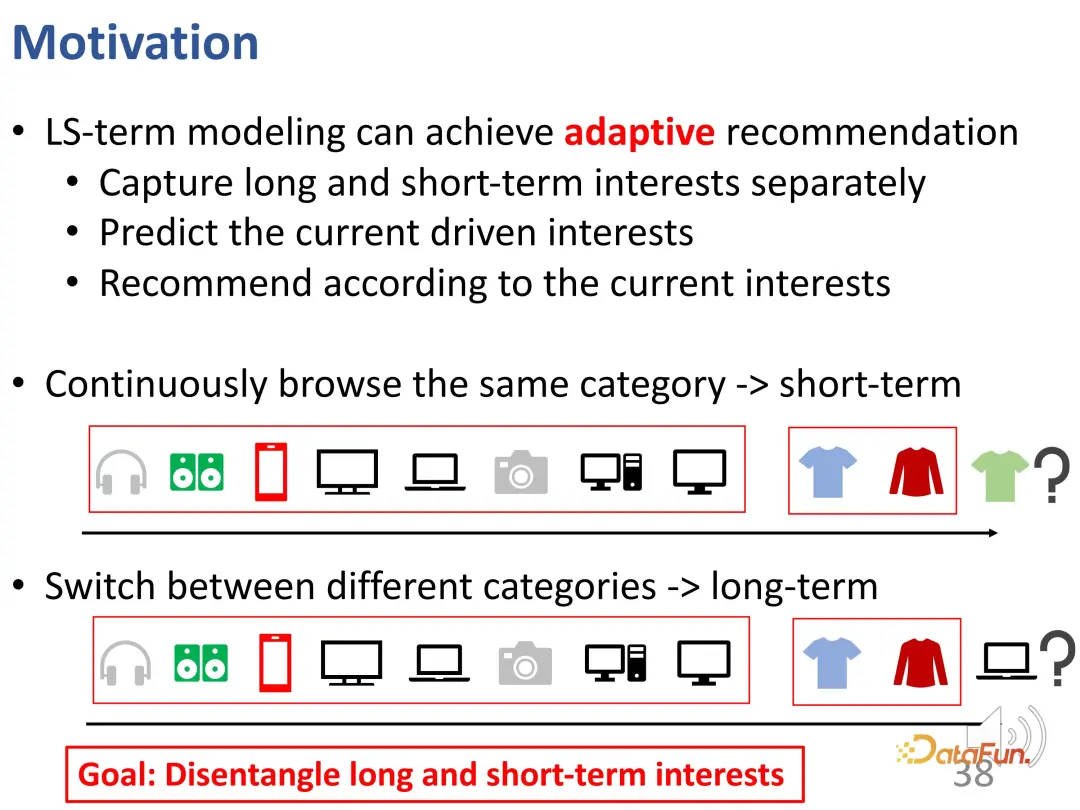

第二項工作主要解決序列推薦中長期興趣和短期興趣的解糾纏問題,具體而言,用戶興趣是復雜的,一部分興趣可能相對穩定,被稱為長期興趣,而另一部分興趣可能是突發的,被稱為短期興趣。在下圖這個例子中,用戶長期對電子產品感興趣,但短期內想買一些衣服。如果能夠很好地識別這些興趣,就能更好地解釋每次行為產生的原因,并提升整個推薦系統的性能。

這樣的問題可以稱為長短時興趣的建模,即能夠自適應地分別建模長時興趣和短時興趣,并且進一步推斷用戶當前的行為主要由哪一部分驅動。如果能夠識別當前驅動行為的興趣,就能更好地根據當前興趣進行推薦。例如,如果用戶在短時間內瀏覽相同的類別,那可能是一種短時興趣;如果用戶在短時間內廣泛探索,那么可能需要更多地參考以前觀測到的長期興趣,而不局限于當前興趣。總的來說,長期興趣和短期興趣性質相異,需要很好地解決長期需求和短期需求的解糾纏。

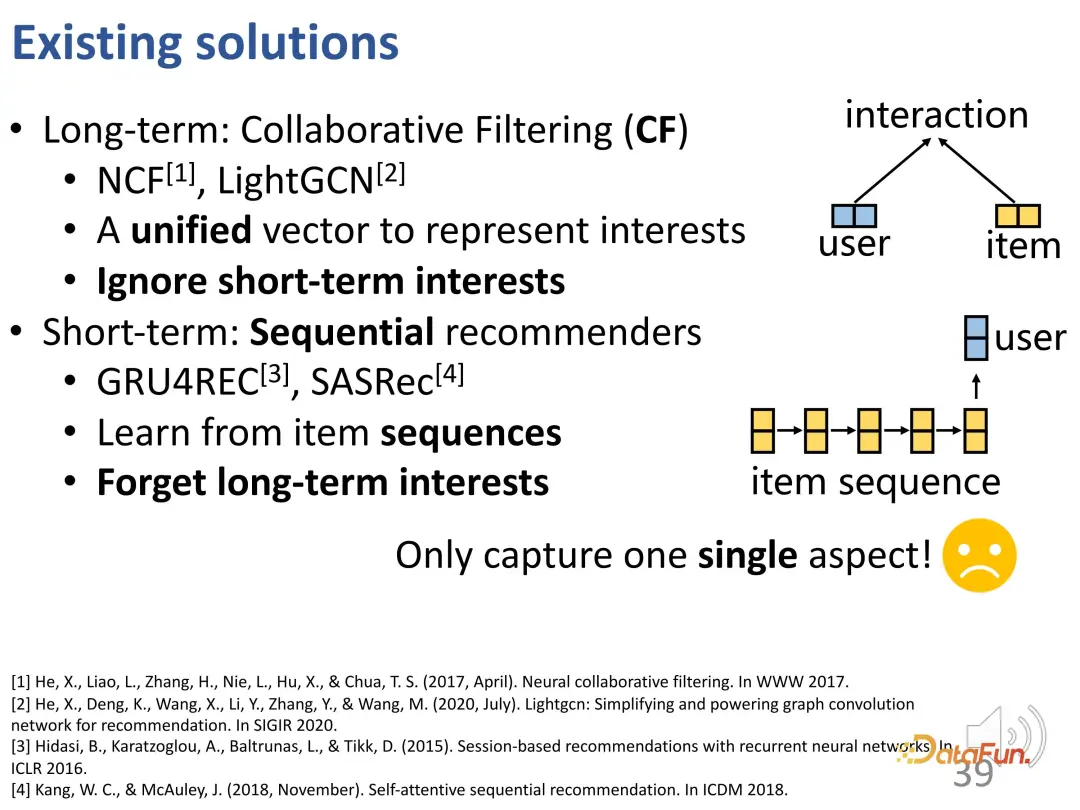

一般而言,可以認為協同過濾實際上是一種捕捉長期興趣的方法,因為它忽略了興趣的動態變化;而現有的序列推薦更多關注短期興趣建模,這導致了長期興趣的遺忘,即使考慮到了長期興趣,它在建模時仍主要依賴于短期興趣。因此,現有方法在結合這兩種興趣學習方面仍有所欠缺。

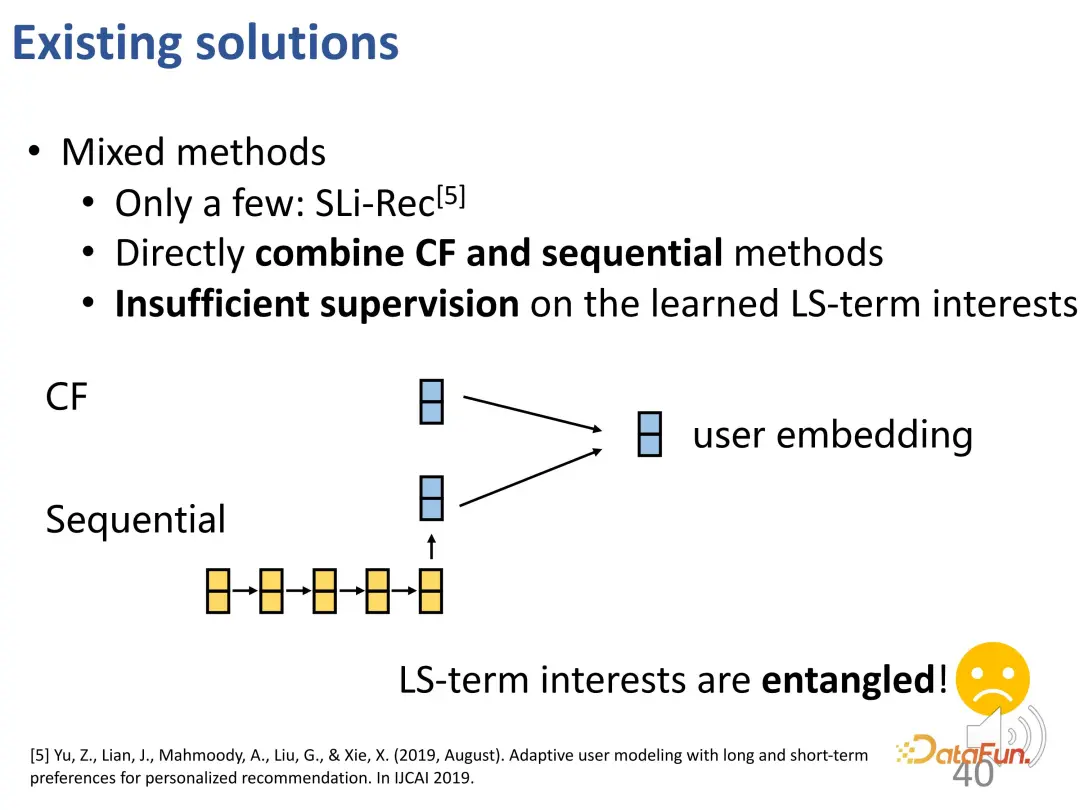

一些最近的工作開始考慮長期和短期興趣的建模,分別設計短期模塊和長期模塊,然后將它們直接結合在一起。但這些方法中,最終學習的用戶向量只有一個,同時包含短期信號和長期信號,兩者依然糾纏在一起,需要進一步改進。

然而,解耦長短時興趣依然是具有挑戰性的:

- 首先,長期和短期興趣實際上反映了用戶可能相當不同的偏好差異,它們的特征也不同。長期興趣是一種相對穩定的通用興趣,而短期興趣是動態的,并且會迅速演化。

- 其次,長短時興趣沒有顯式的標簽。最終收集的數據中大部分數據其實是最終行為,對于到底屬于哪一種興趣,并沒有一個 ground truth。

- 最后,對于當前的行為到底由長短期興趣的哪一部分驅動,哪一部分的重要性更高,同樣是不確定的。

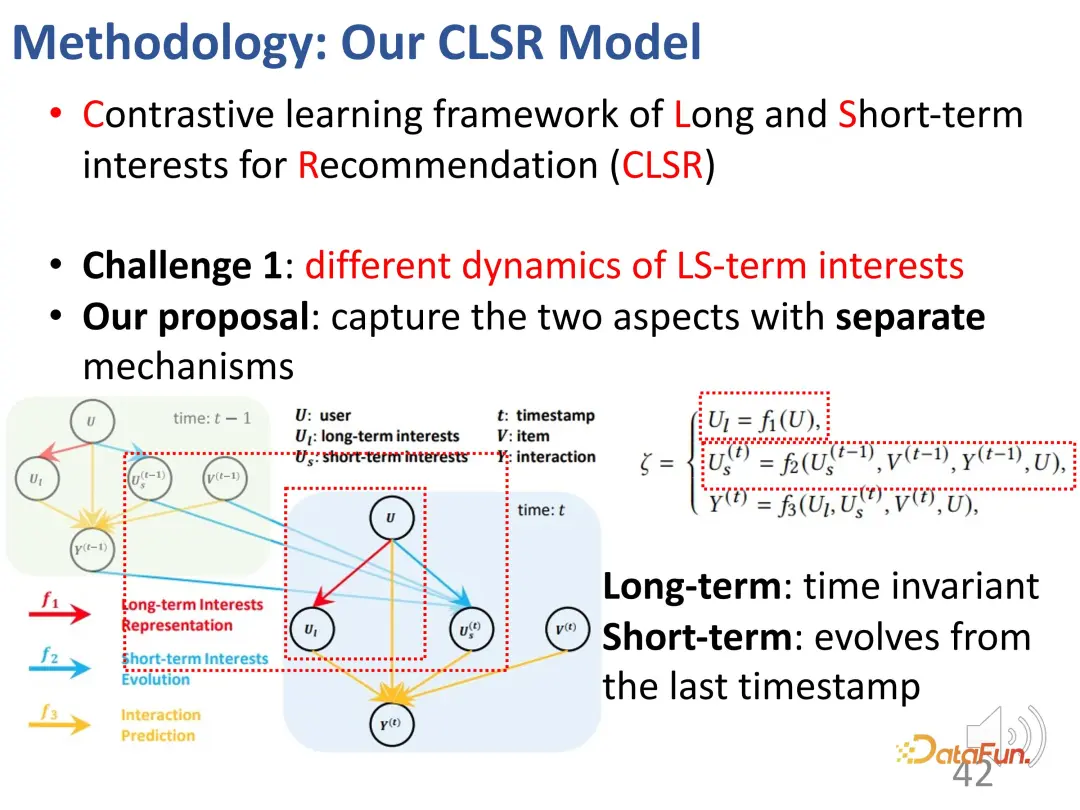

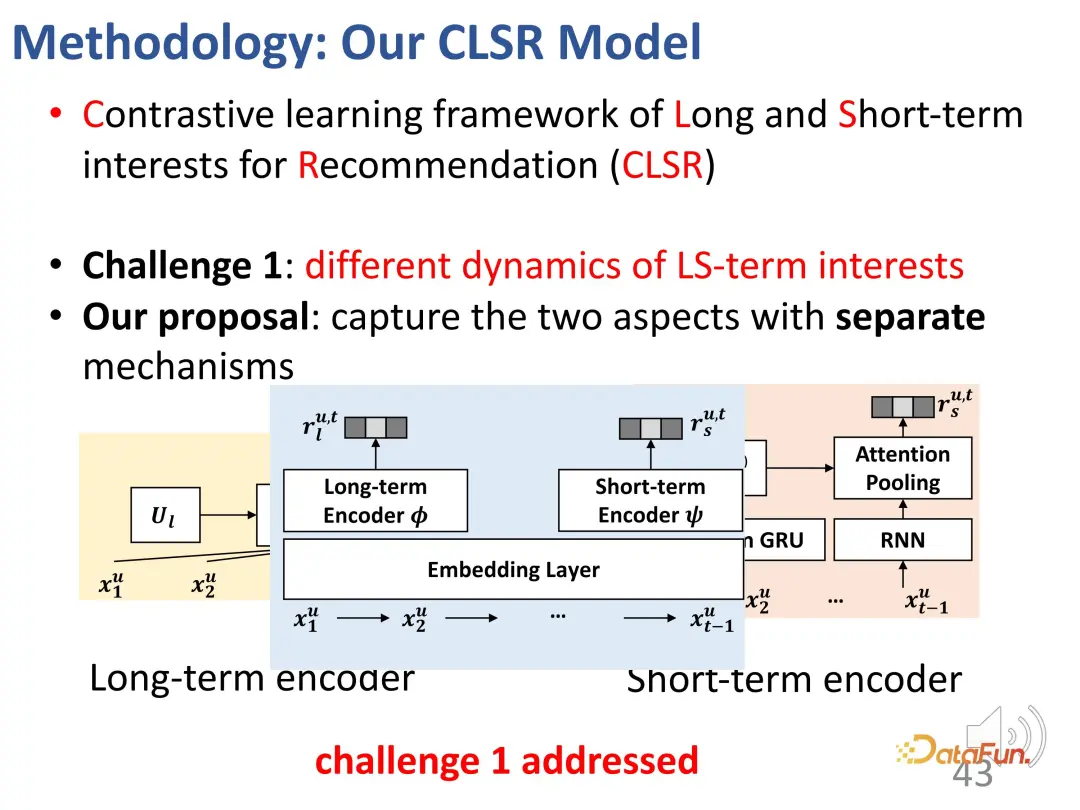

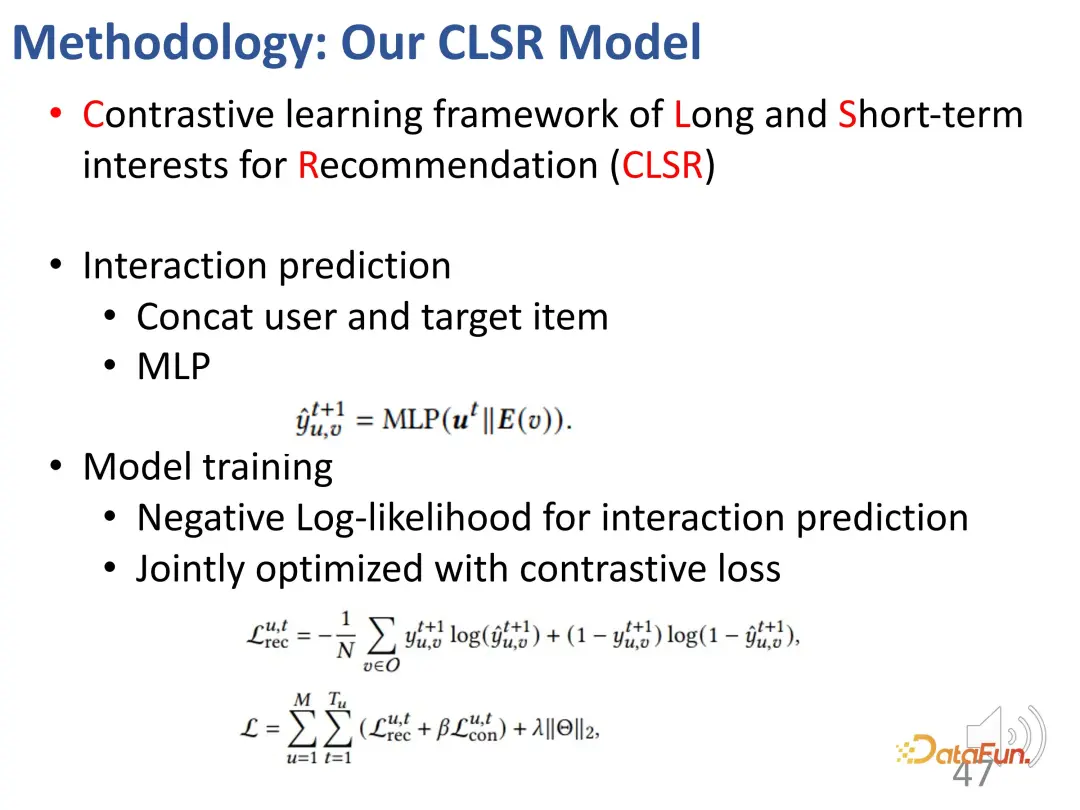

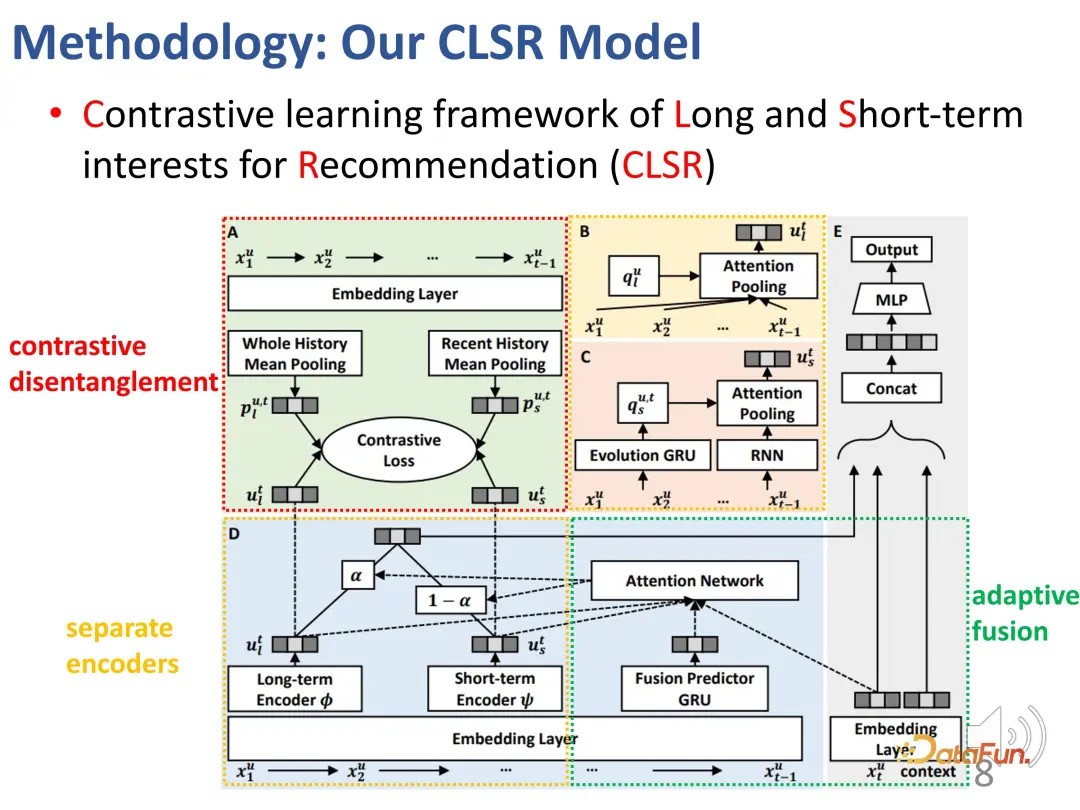

針對這個問題,提出了對比學習的方法,來同時建模長短期興趣。(Contrastive learning framework of Long and Short-term interests for Recommendation (CLSR))

1. 長短期興趣分離

對于第一個挑戰——長期興趣和短期興趣分離,我們為長期和短期興趣分別建立相應的演化機理。在結構因果模型中,設置和時間無關的長期興趣,以及由上一個時刻的短期興趣和通用的長期興趣決定的短期興趣。即在建模過程中長期興趣是比較穩定的,而短期興趣則是實時變化的。

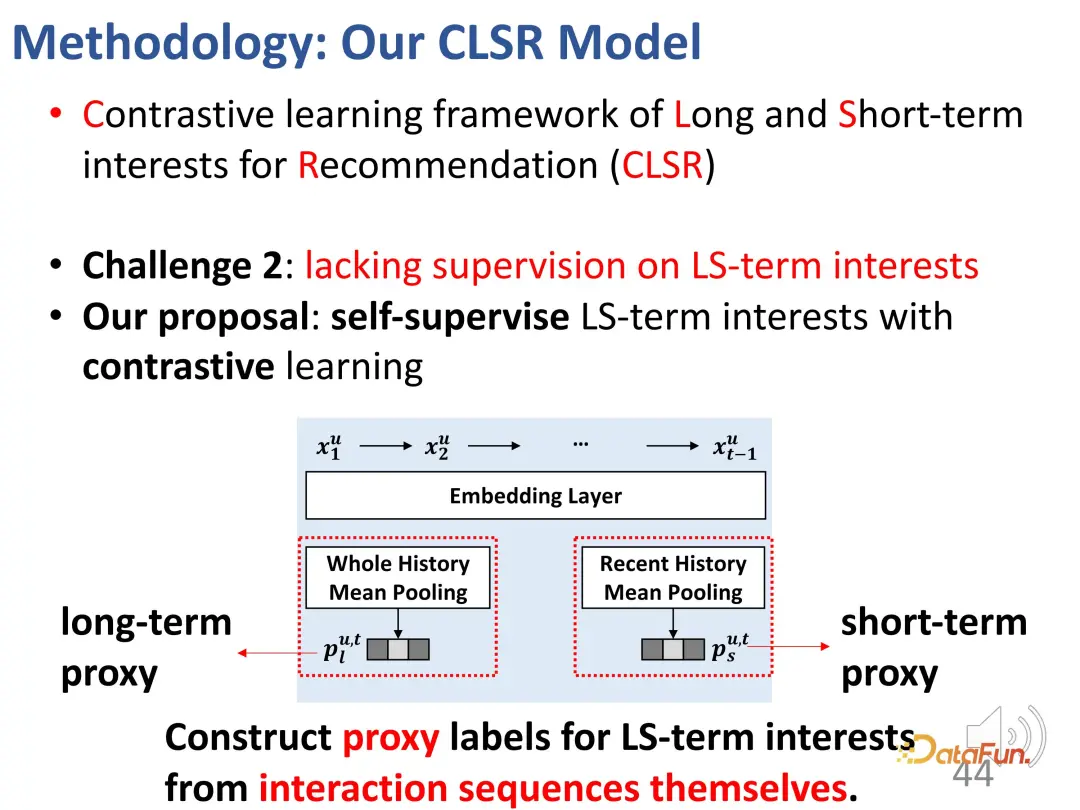

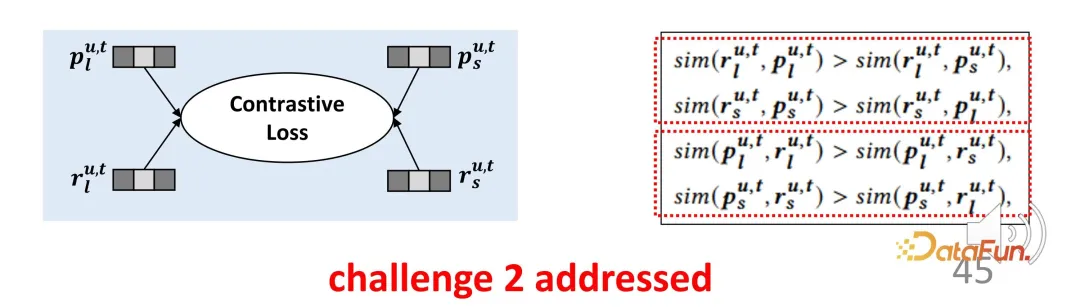

2. 對比學習解決缺乏顯式監督信號

第二個挑戰是對于兩部分興趣缺乏顯式的監督信號。為了解決這個問題,引入對比學習方法來進行監督,構建代理標簽來替代顯式標簽。

代理標簽分為兩部分,一部分是對于長期興趣的代理,另一部分是對于短期興趣的代理。

使用整個歷史的 pooling 作為長期興趣的代理標簽,在長期興趣的學習中,使編碼器學習的表征更多地朝向這個方向優化。

對于短期興趣也是類似的,對用戶最近若干次行為的平均 pooling,作為短期的代理;同樣地,雖然它不直接代表用戶興趣,但是在用戶短期興趣的學習過程中,盡可能地朝這個方向進行優化。

這樣的代理表征,雖然并不嚴格代表興趣,但是它們代表了一個優化方向。對于長期興趣表征和短期興趣表征而言,它們會盡可能地接近相應的表征,而遠離另外一個方向的表征,從而構建一個對比學習的約束函數。反過來同理,因為代理表征也要盡可能地接近實際的編碼器輸出,所以它是一個對稱的兩部分損失函數,這樣的設計有效地彌補了剛剛提到的缺乏監督信號的問題。

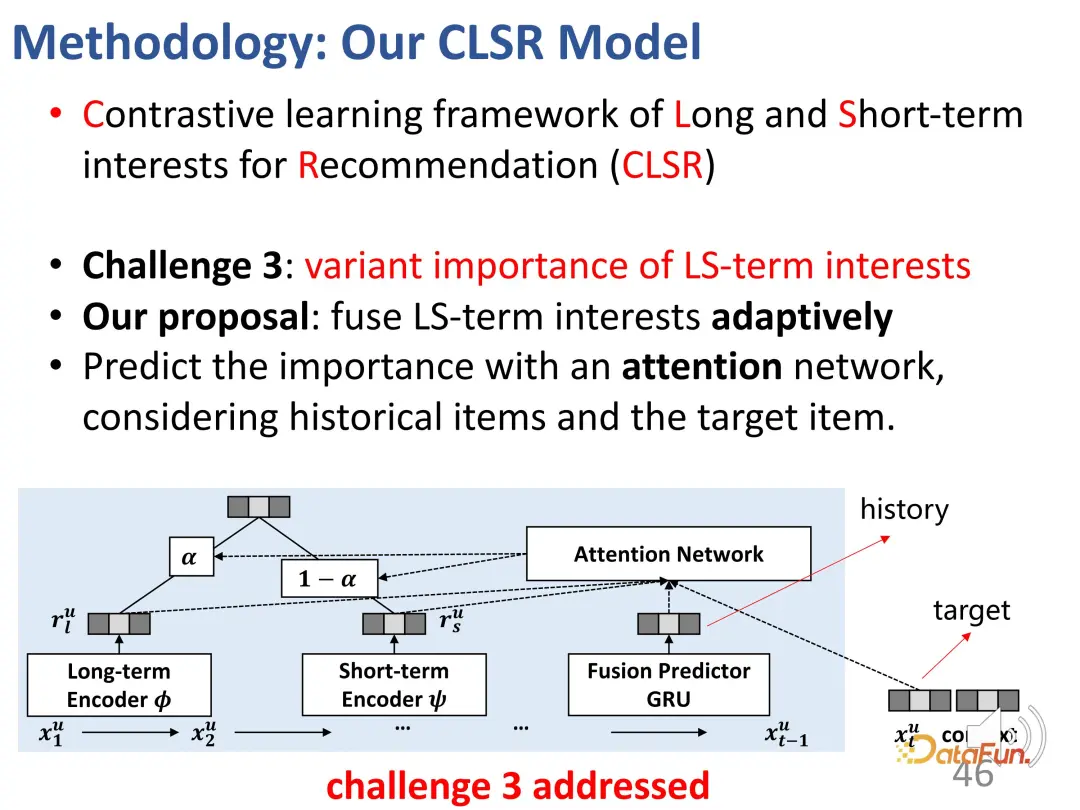

3. 長短期興趣權重判別

第三個挑戰是對于給定的行為,判斷兩部分興趣的重要性,解決方法是自適應地融合兩塊興趣。這一部分的設計比較簡單直接,因為前面已經有了兩部分的表征向量,將它們混合在一起就并不困難了。具體而言,需要計算一個權重 α 來平衡兩部分的興趣,當 α 比較大時,當前的興趣主要由長期興趣主導;反之亦然。最后得到對交互行為的預估。

對于預測,一方面是前面提到的通用推薦系統的損失,另一方面以加權的形式將對比學習的損失函數加入其中。

以下是整體的框圖:

這里有兩個分離的編碼器(BCD),相應的代理表征以及對比學習的目標(A),以及自適應地混合融合兩部分的興趣。

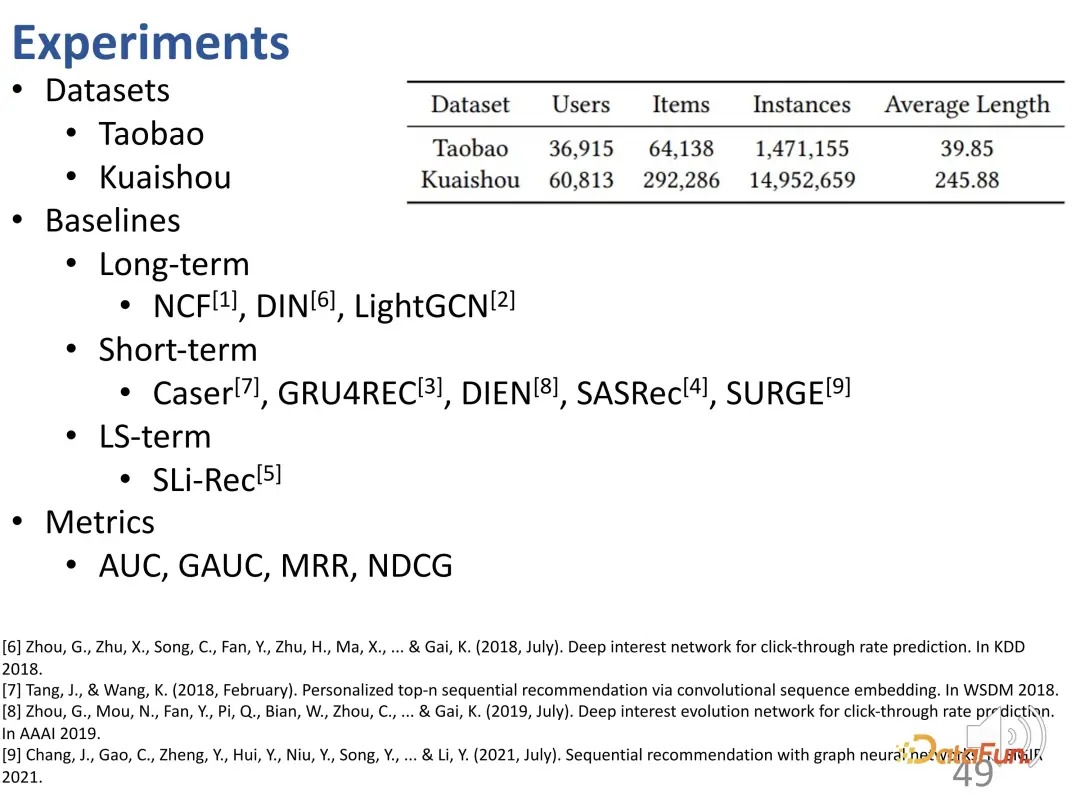

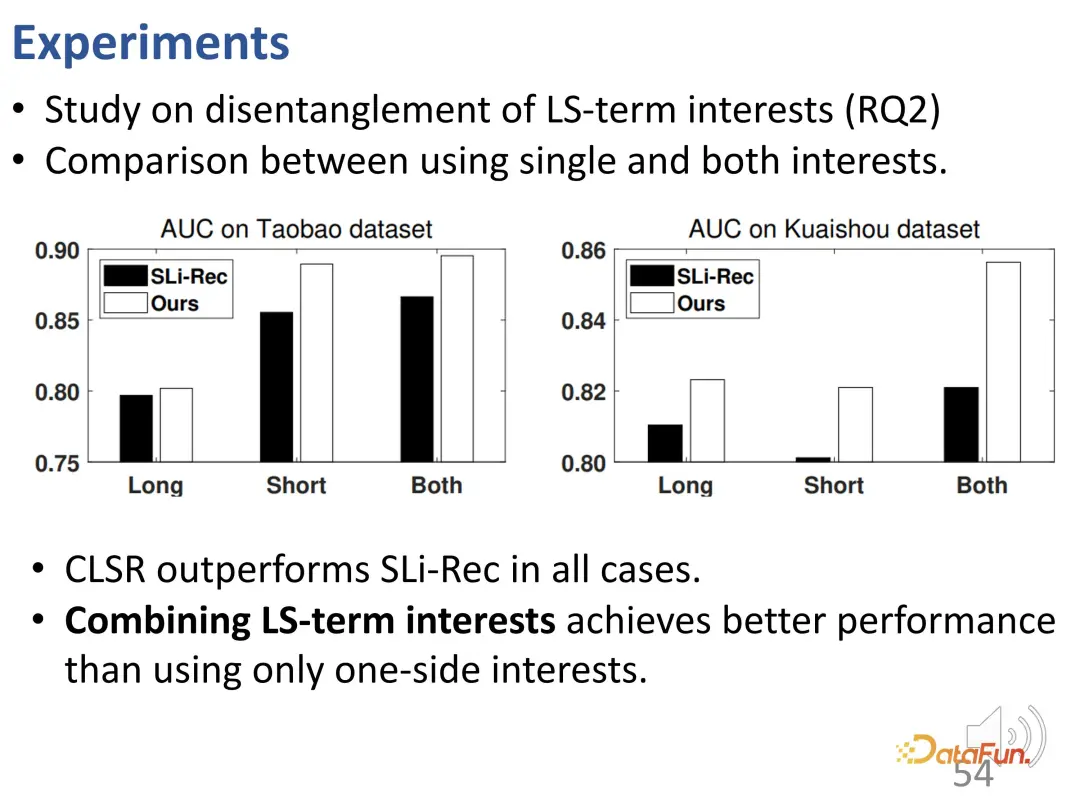

在這個工作中,使用了序列推薦的數據集,包括淘寶的電商數據集和快手的短視頻數據集。將方法分為長期、短期和長短期結合三種。

4. 實驗效果

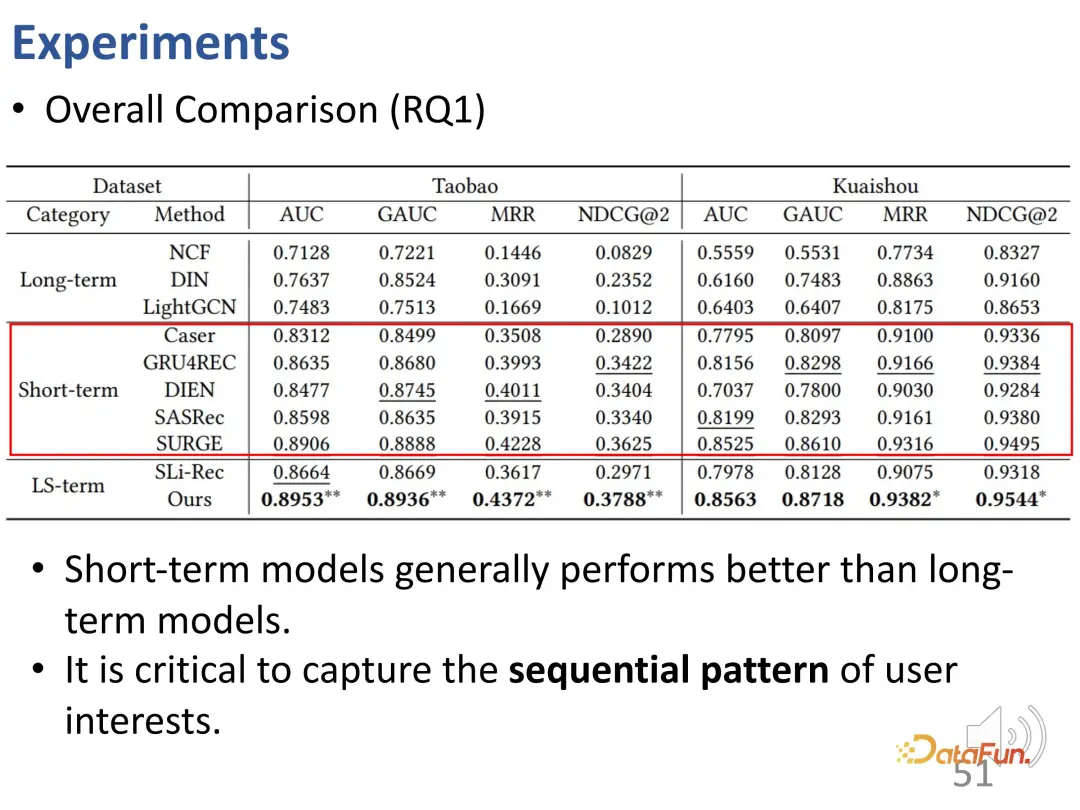

觀察整體實驗結果可以看到,只考慮短期興趣的模型比只考慮長期興趣的模型表現更好,也就是說,序列推薦模型通常比純靜態的協同過濾模型更好。這是合理的,因為短期興趣建模可以更好地識別當前最近的一些興趣,而這些最近的行為對當前行為的影響最大。

第二個結論是同時建模長期和短期興趣的 SLi-Rec 模型,并不一定比傳統的序列推薦模型更好。這突出了現有工作的不足。原因是,如果只是簡單地混合兩種模型,可能會引入偏差或噪音;從這里可以看出,最好的 baseline 實際上是一種序列短期興趣模型。

我們提出的長短期興趣解耦方法解決了長期和短期興趣之間的解糾纏建模問題,在兩個數據集和四個指標上都能夠取得穩定的最佳效果。

為了進一步研究這種解糾纏效果,為長短期興趣相應的兩部分表征進行實驗。將 CLSR 學習的長期興趣、短期興趣和 Sli-Rec 學習的兩種興趣進行對比。實驗結果表明,在每個部分上我們的工作(CLSR)都能夠穩定地取得更好的效果,而且也證明了將長期興趣建模和短期興趣建模融合在一起的必要性,因為使用兩種興趣進行融合效果是最好的。

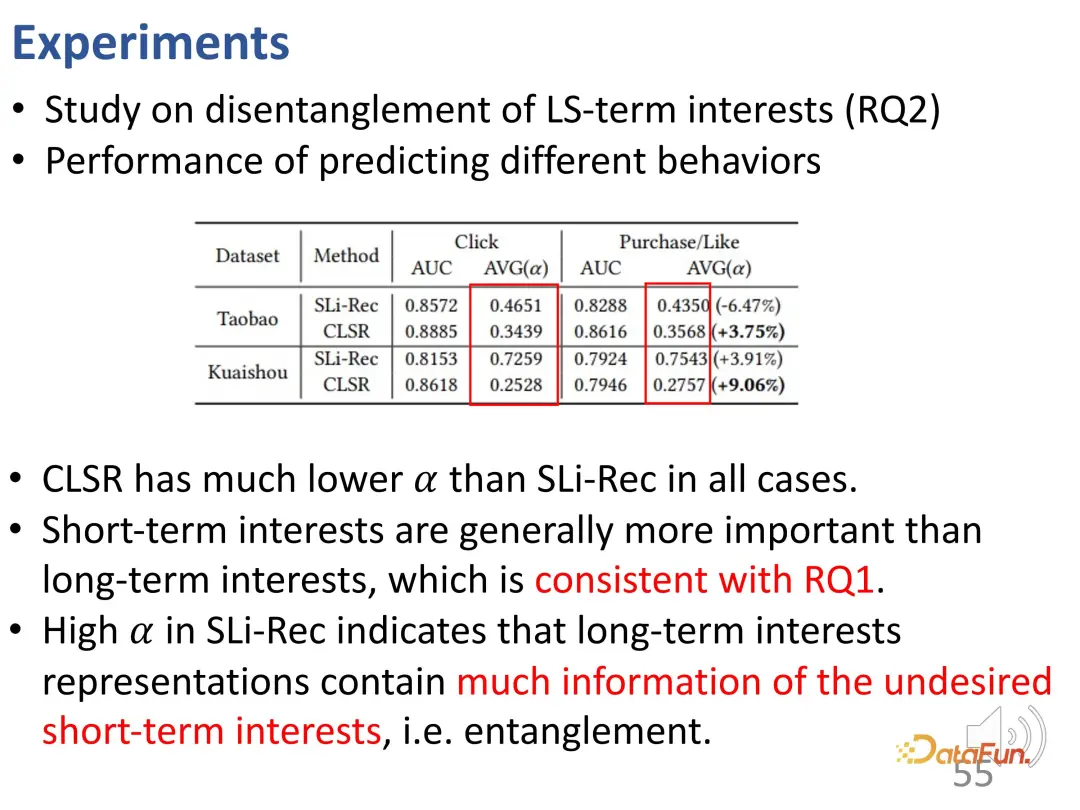

進一步,使用購買行為和點贊行為來對比研究,因為這些行為的成本比點擊更高:購買需要花錢,點贊需要一定的操作成本,因此這些興趣實際上反映了更強的偏好,更偏向于穩定的長期興趣。首先,在性能對比方面,CLSR 取得了更好的效果。此外,建模的兩個方面的權重更加合理。對于更偏向于長期興趣的行為,CLSR 能夠分配相比 SLi-Rec 模型更大的權重,這與之前的動機相吻合。

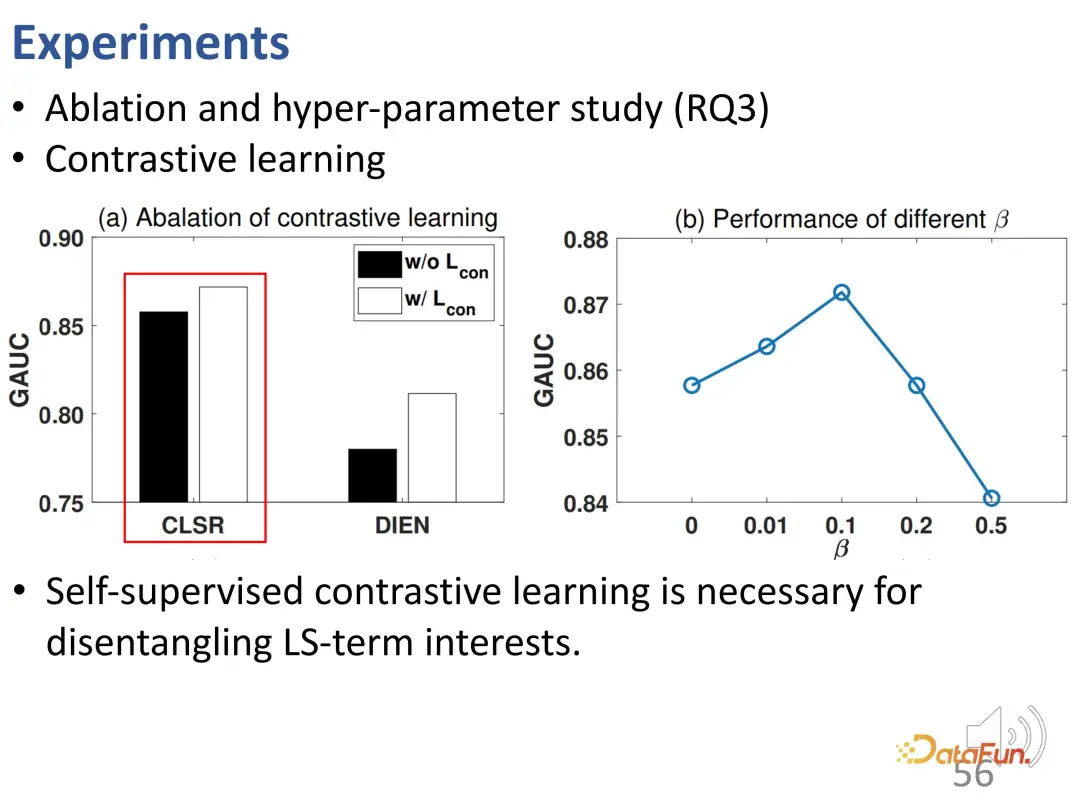

進一步進行了消融實驗和超參數實驗。首先,去掉了對比學習的損失函數,發現性能下降,說明對比學習對于解糾纏長期興趣和短期興趣是非常必要的。這個實驗進一步證明了 CLSR 是一個更好的通用框架,因為它在現有方法的基礎上也能發揮作用(自監督對比學習可以提升 DIEN 的性能),是一個即插即用的方法。對 β 的研究發現,一個比較合理的值是 0.1。

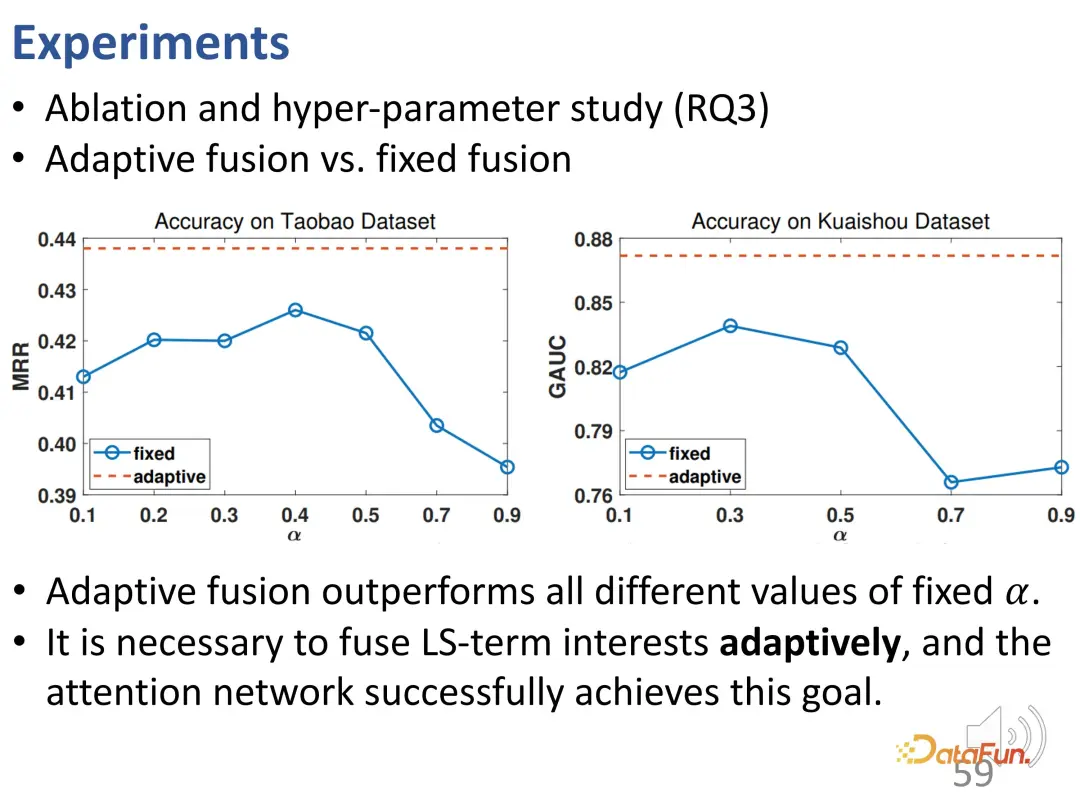

接下來進一步研究自適應融合和簡單融合的關系。自適應權重融合相比固定權重融合在所有不同的 α 取值上都表現穩定更好,這驗證了每次交互行為可能都由不同大小的權重決定,并且驗證了通過自適應融合實現興趣融合以及最后行為預測的必要性。

這項工作提出了一種對比學習方法來建模序列興趣中的長期興趣和短期興趣,分別學習相應的表征向量,實現解糾纏。實驗結果證明了該方法的有效性。

三、短視頻推薦的去偏

前面介紹了兩個工作,關注在興趣的解糾纏。第三個工作則關注興趣學習的行為糾偏。

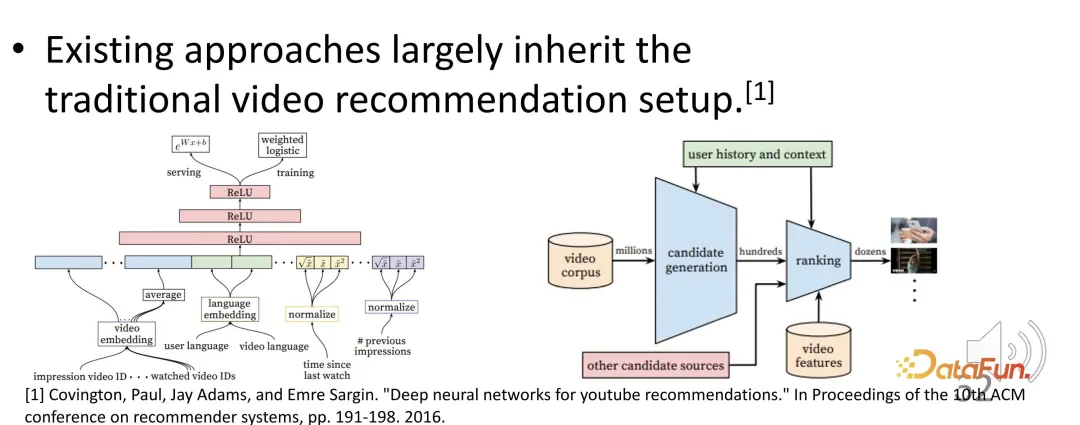

短視頻推薦成為了推薦系統中一個非常重要的組成部分。然而,現有的短視頻推薦系統仍然遵循以前長視頻推薦的范式,可能存在一些問題。

例如,如何評估在短視頻推薦中用戶的滿意程度和活躍度?優化目標又是什么?常見的優化目標是觀看時間或觀看進度。那些被預估為可能具有更高完播率和觀看時長的短視頻,可能會被推薦系統排在更前的位置。在訓練時可能基于觀看時長進行優化,在服務時根據預估的觀看時長進行排序,推薦那些觀看時長更高的視頻。

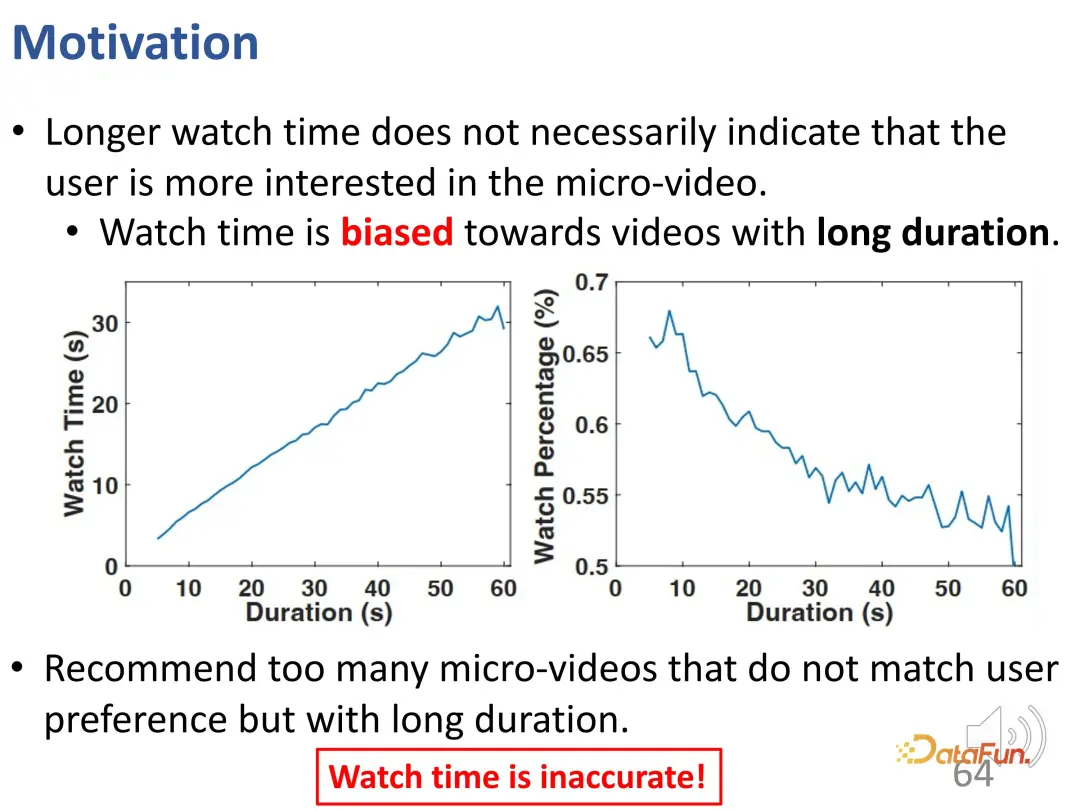

然而,在短視頻推薦中存在一個問題是更長的觀看時間并不一定代表用戶對該短視頻很感興趣,即短視頻的時長本身就是一個很重要的偏差。在使用上述優化目標(觀看時間或觀看進度)的推薦系統中,更長的視頻天然具有優勢。推薦過多這種長視頻,很可能與用戶的興趣不匹配,但由于用戶跳過視頻的操作成本,實際的線上測試或離線訓練得到的評估都會很高。因此,僅依靠觀看時長是不夠的。

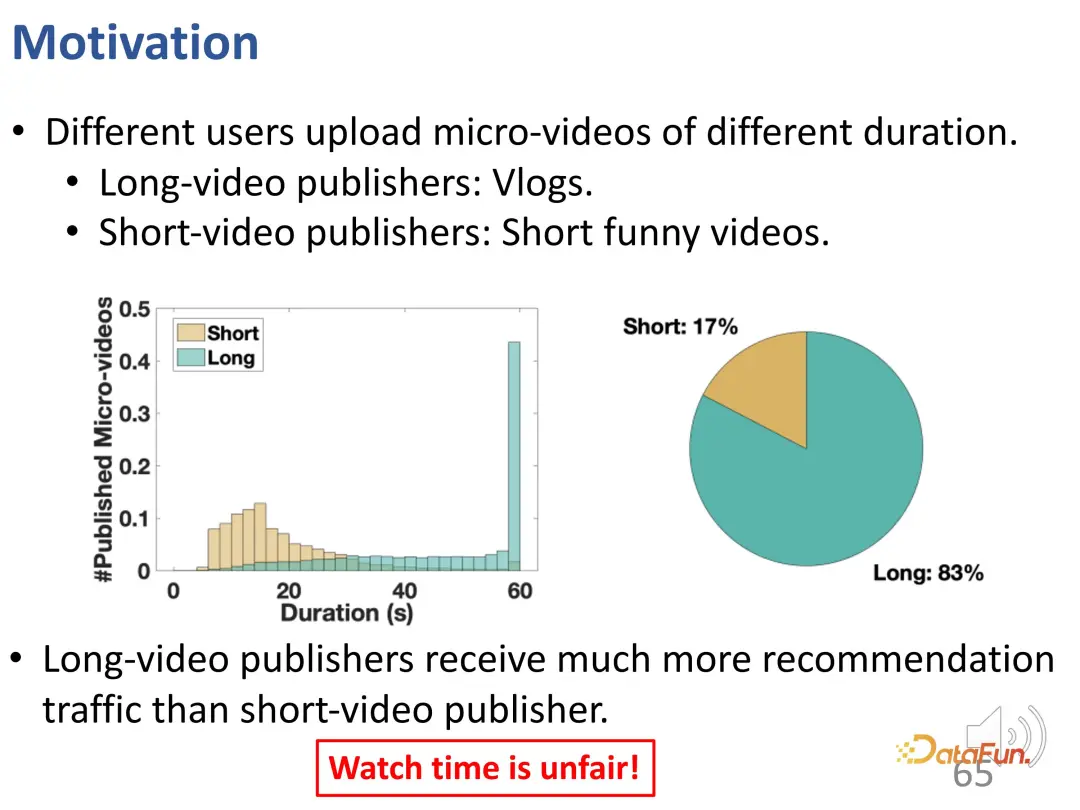

可以看到,在短視頻中存在兩種形態。一種是比較長的視頻,比如 vlog,而另一種是較短的娛樂視頻。對真實的流量進行分析后發現,發布長視頻的用戶基本上能夠獲得更多的推薦流量,這個比例非常懸殊。僅僅使用觀看時長來評估不僅不能滿足用戶的興趣,也可能存在不公平的問題。

在本工作中,希望解決兩個問題:

- 如何更好地無偏地評估用戶的滿意程度。

- 如何學習這種無偏的用戶興趣來提供良好的推薦。

實際上,核心挑戰是不同時長的短視頻無法直接進行比較。由于這個問題是天然且普遍存在于不同的推薦系統中的,而且不同推薦系統的結構差異很大,所以設計的方法需要與模型無關。

首先,選擇了幾個具有代表性的方法,并使用觀看時長進行了模擬訓練。

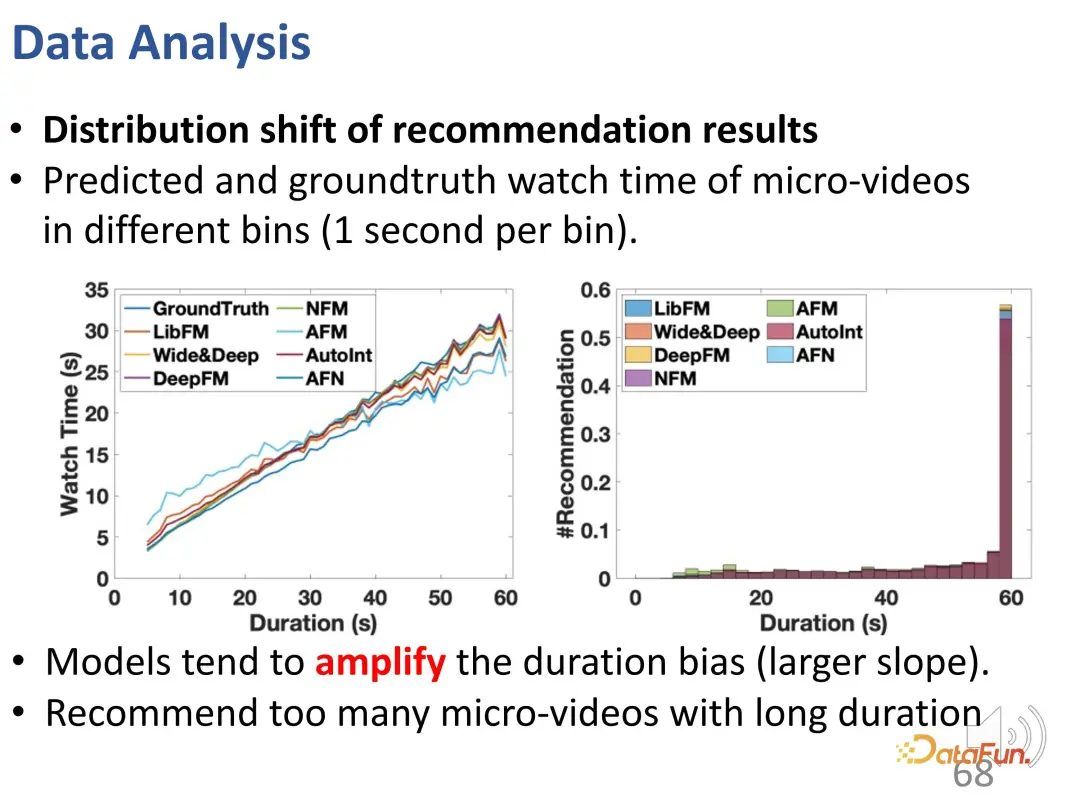

可以從曲線中看到時長偏差被增強了:對比 ground truth 的曲線,推薦模型在長視頻的觀看時間預測結果上明顯偏高。在預測模型中,對于長視頻的推薦過多是有問題的。

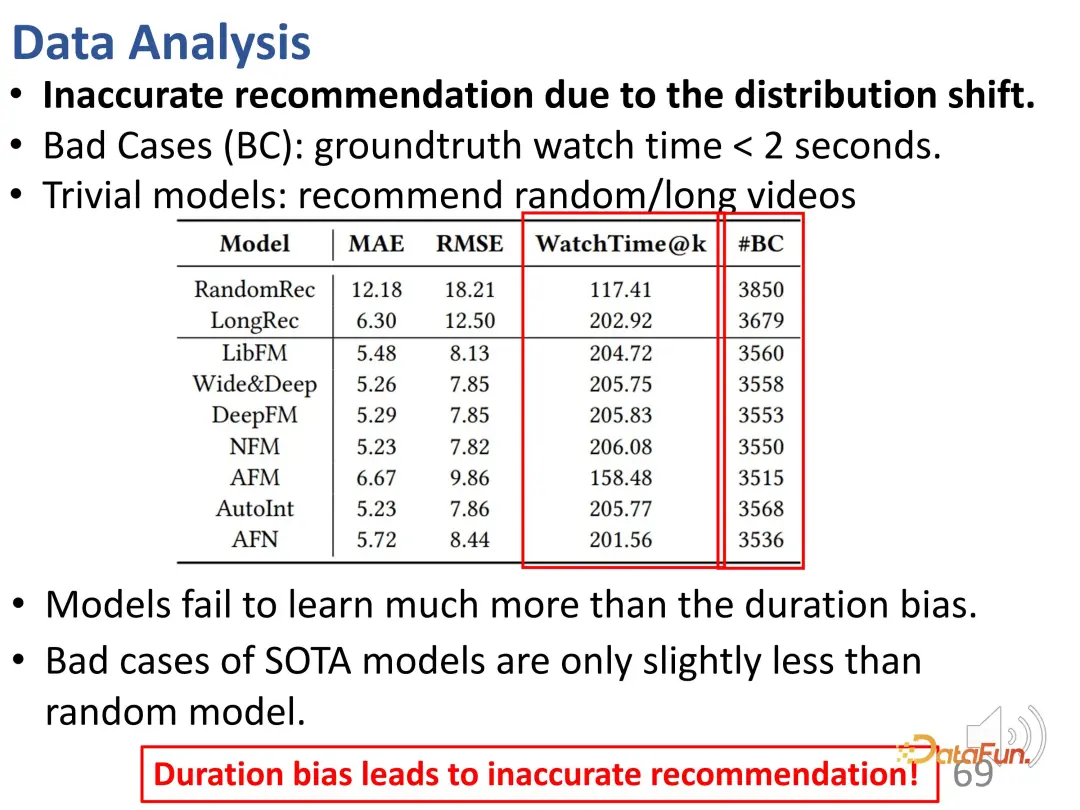

此外,還發現推薦結果中存在許多不準確的推薦(#BC)。

我們可以看到一些 bad case,即觀看時間小于 2 秒且用戶很不喜歡的視頻。然而,由于偏差的影響,這些視頻被錯誤地推薦。換而言之,模型只學習到了推薦視頻的時長差異,基本上只能區分視頻的長短。因為想要預測的結果是推薦更長的視頻,以增加用戶的觀看時長。所以模型選擇的是長視頻,而不是用戶喜歡的視頻。可以看到,這些模型在 bad case 的數量上甚至與隨機推薦一樣,因此這種偏差導致了非常不準確的推薦。

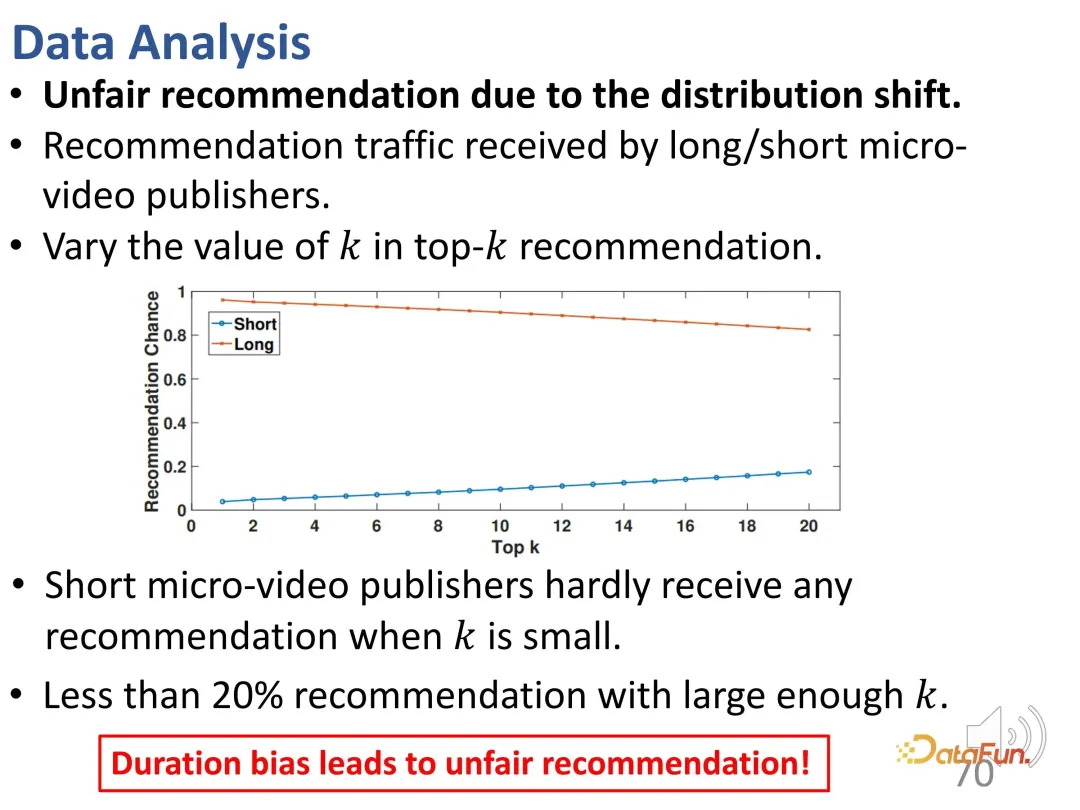

進一步說,這里存在不公平性問題。當控制 top k 值較小時,較短的視頻發布者很難被推薦;即使 k 值足夠大,這種推薦的比例也小于 20%。

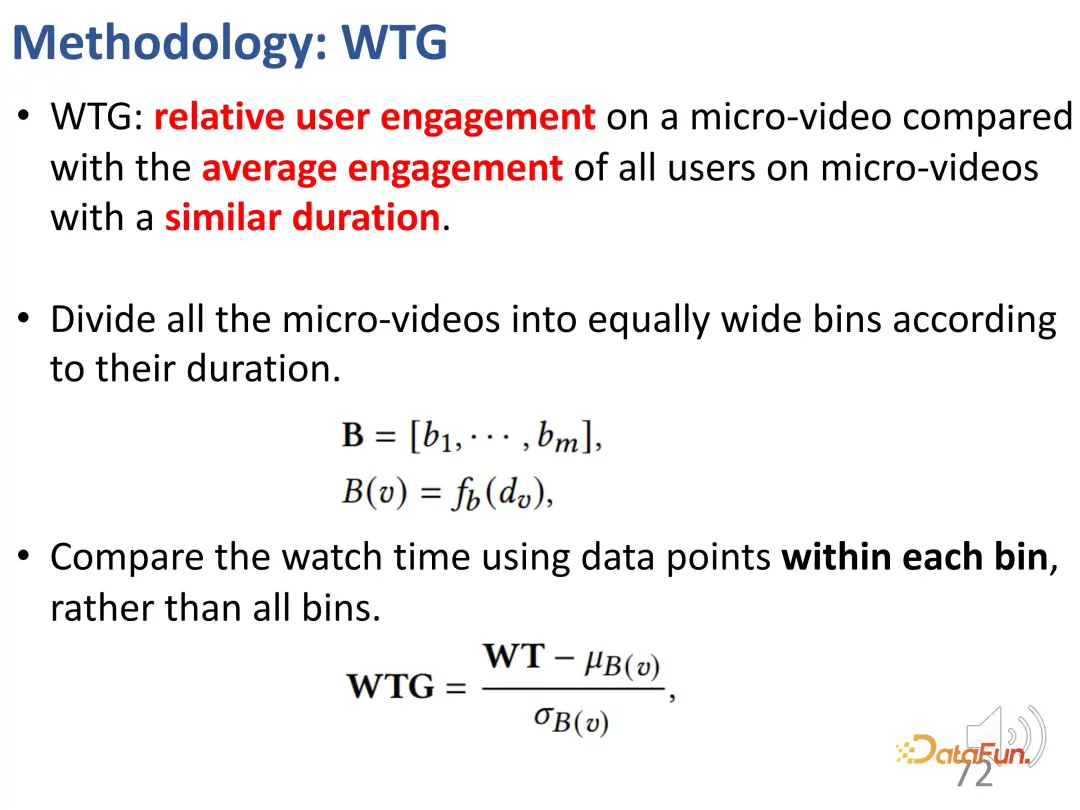

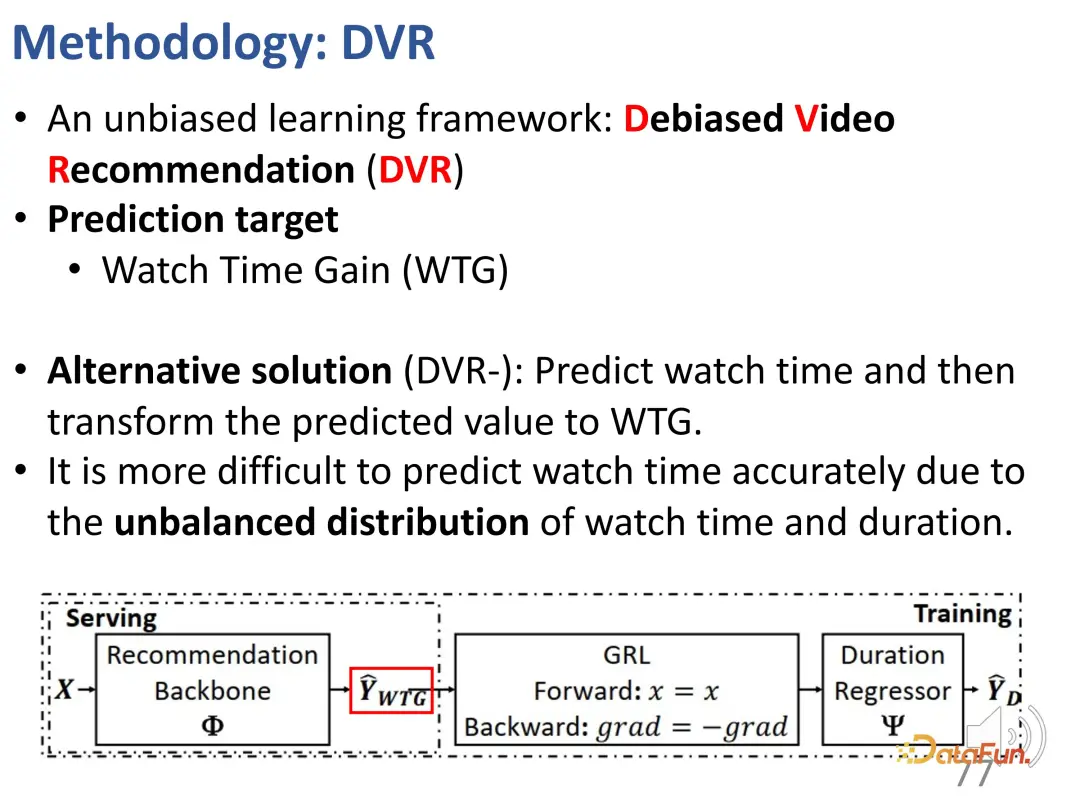

1. WTG 指標

為了解決這個問題,我們首先提出了一個叫 WTG(Watch Time Gain)的新指標,考慮了觀看時長,以嘗試實現無偏。例如,一個用戶觀看了一個 60 秒的視頻達 50 秒;另一個視頻也是 60 秒,但只看了 5 秒。顯然,如果控制在 60 秒的視頻上,這兩個視頻的興趣差異就很明顯。這是一個簡單但有效的想法,只有當其他視頻數據的時長相近時,觀看時長才具有比較的意義。

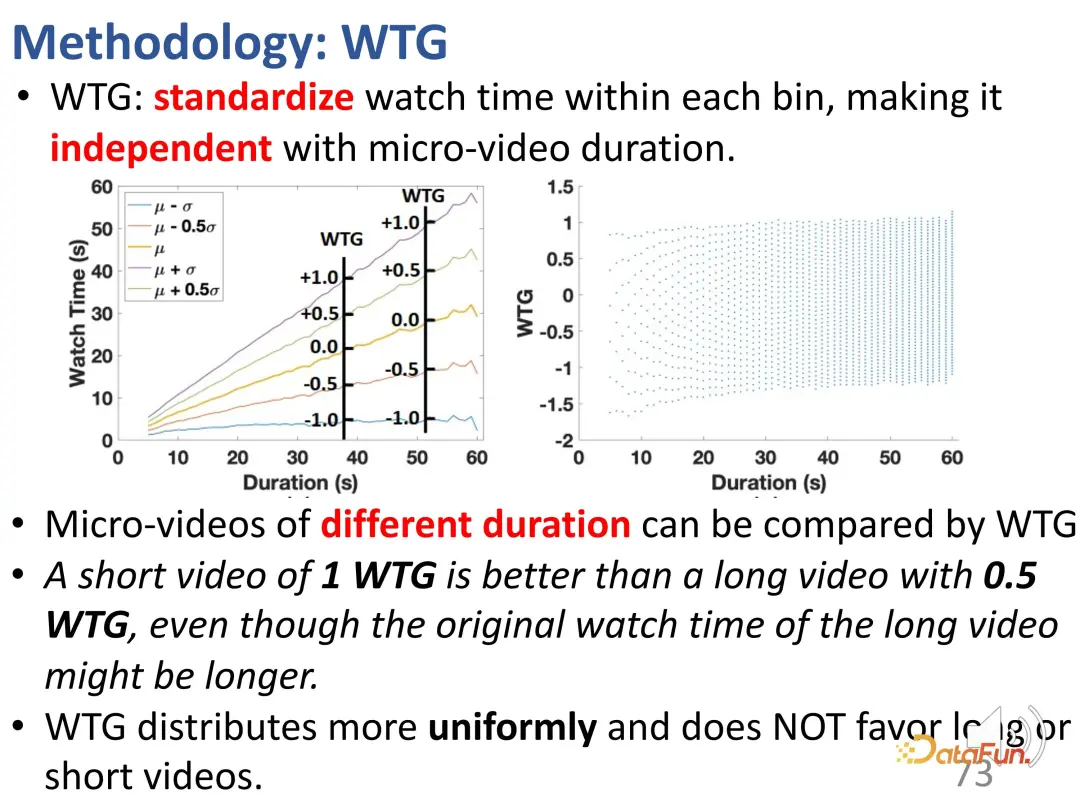

首先將所有的視頻等間距地劃分到不同的時長組中,然后在每個時長組中比較用戶的興趣強度。在固定的時長組中,用戶的興趣可以由時長來代表。引入了 WTG 之后,實際上就是直接使用 WTG 來表示用戶的興趣強度,不再關注原始的時長。在 WTG 的評價下,分布就更加均勻了。

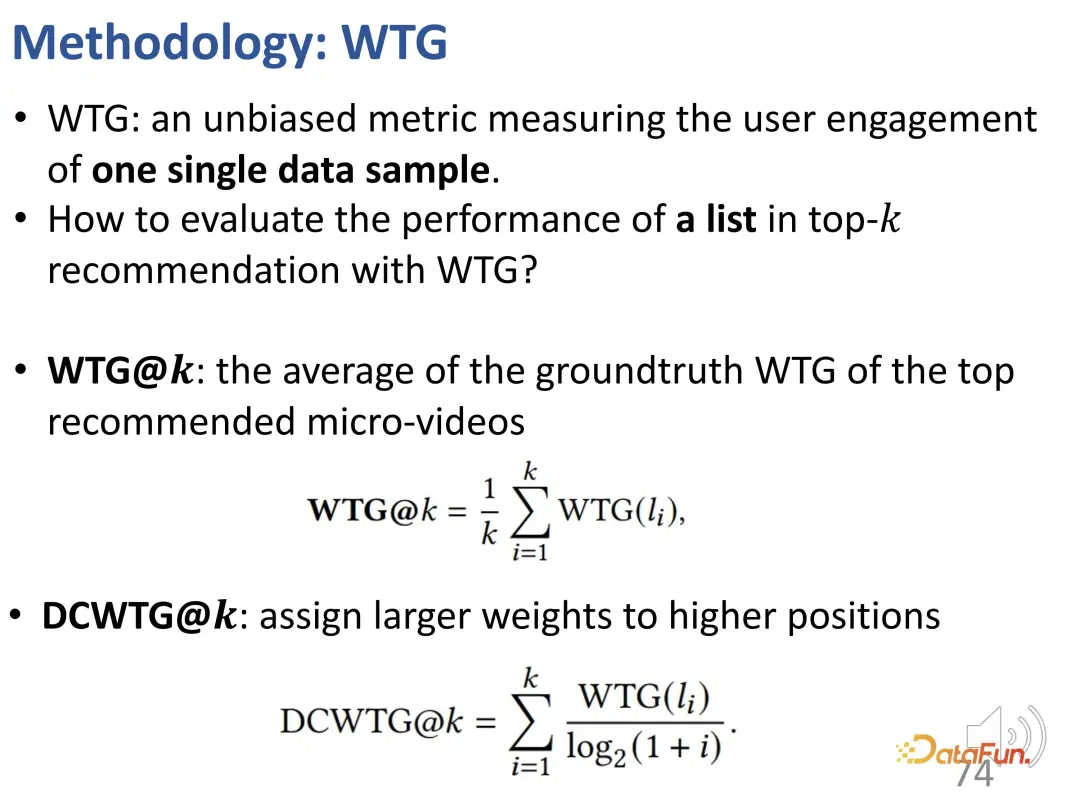

在 WTG 的基礎上,進一步考慮了排序位置的重要性。因為 WTG 只考慮了一個指標(單一點),進一步地將這種累計效應考慮進來。即在計算排序列表中各個元素的指標時,還要考慮到每一個數據點的相對位置。這個思路與 NDCG 類似。因此,在此基礎上,定義了 DCWTG。

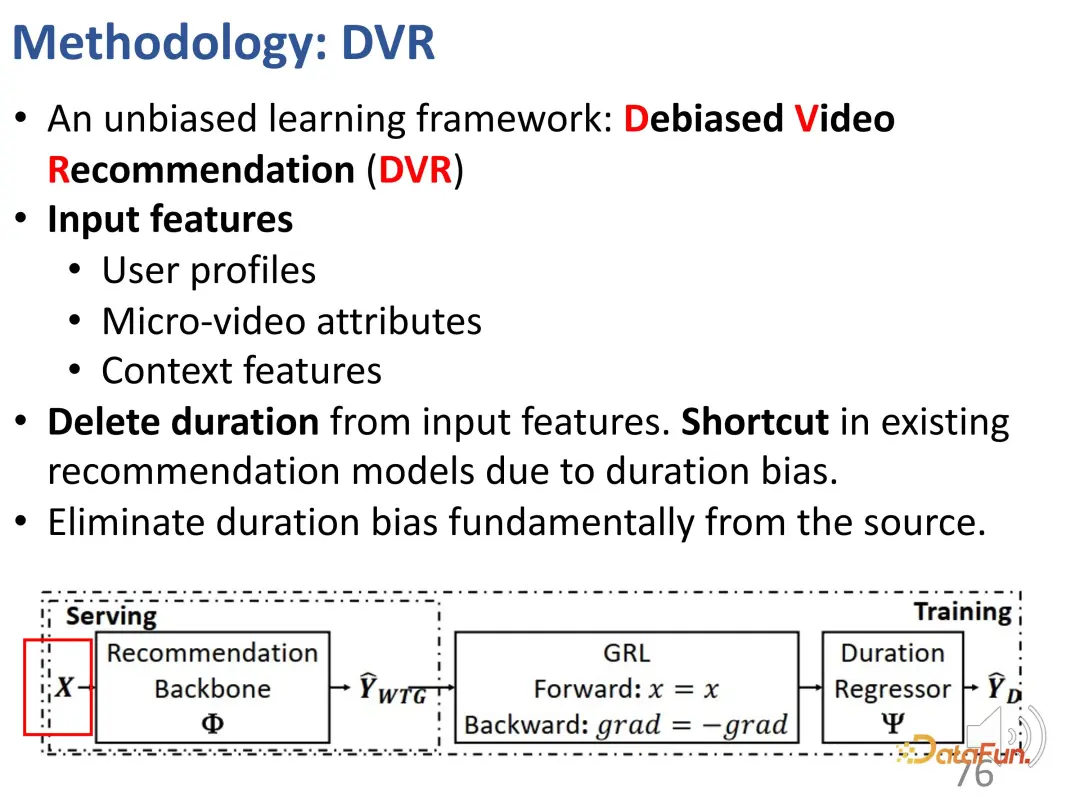

2. 消除偏差的推薦方法

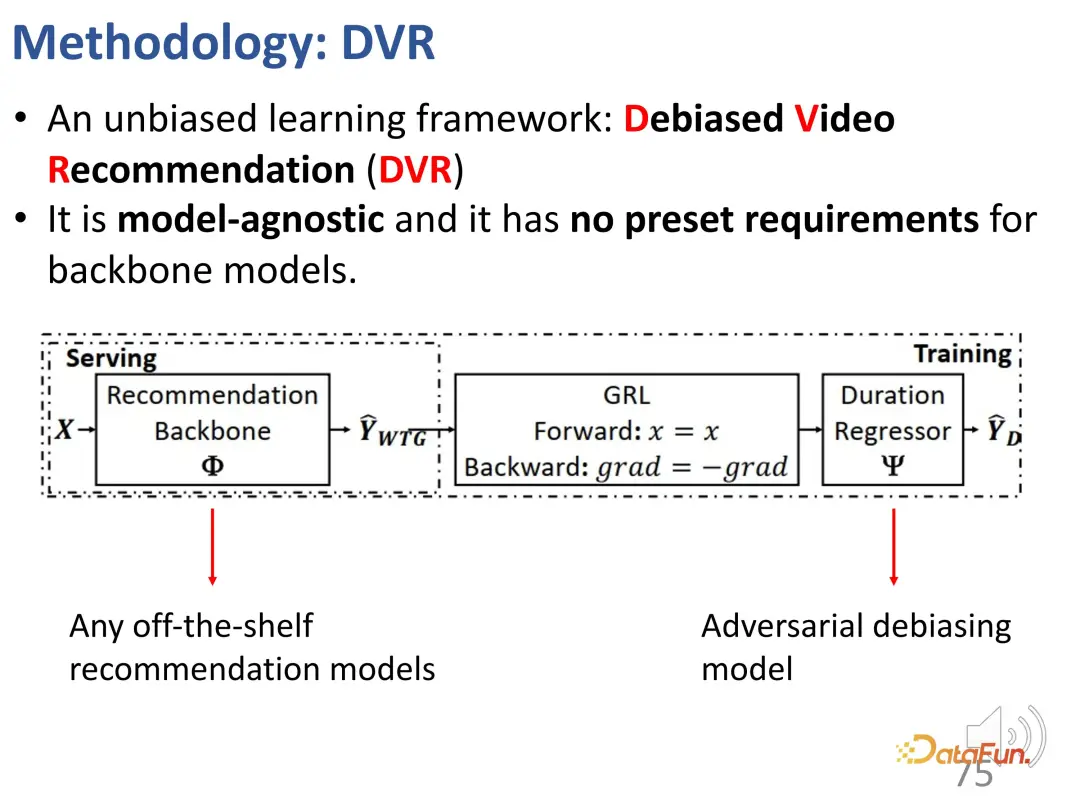

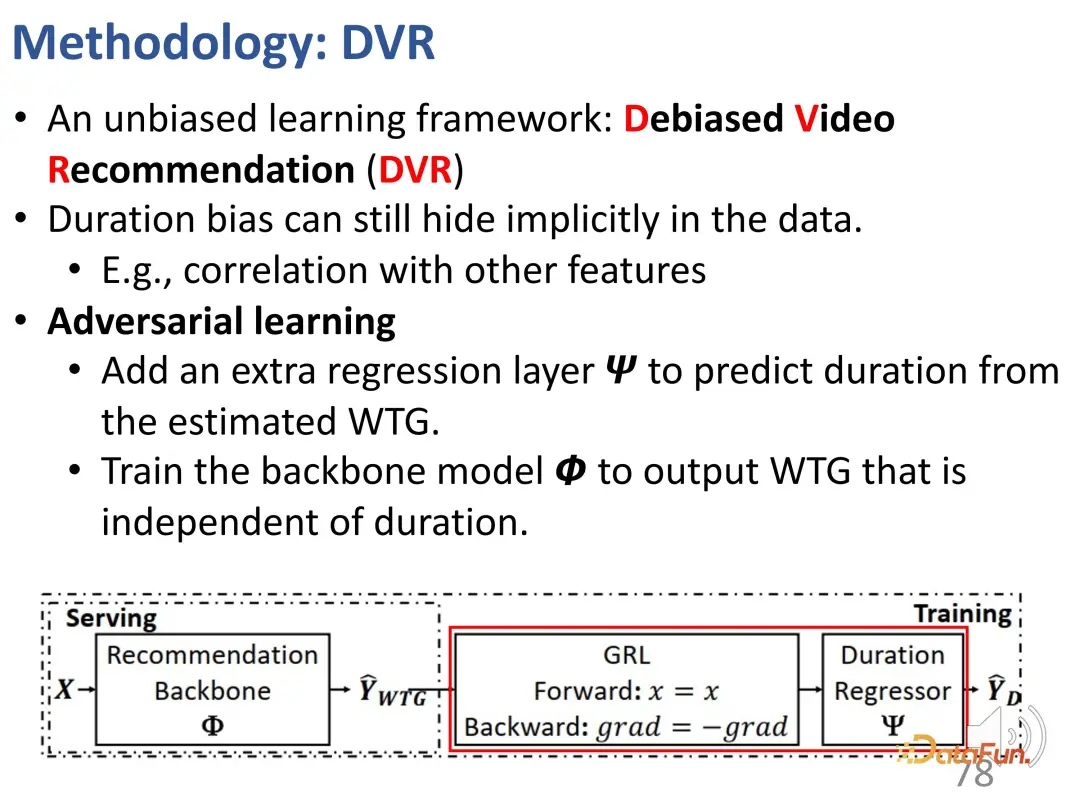

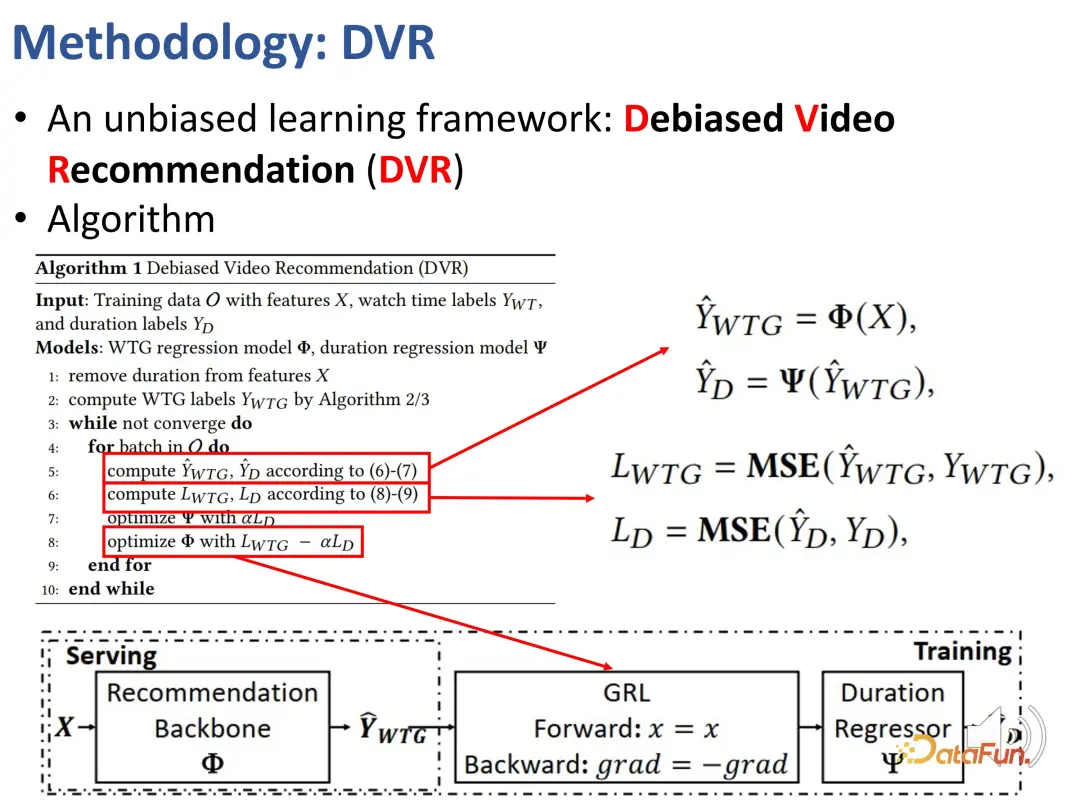

我們之前定義了能夠反映時長無關的用戶興趣的指標,即 WTG 和 NDWTG。接下來,設計一個能夠消除偏差的推薦方法,該方法與具體模型無關,并且適用于不同的 backbone。提出方法 DVR(Debiased Video Recommendation),核心思想是,在推薦模型中,如果能夠去除與時長相關的特征,即使輸入的特征很復雜,其中可能包含與時長有關的信息,只要在學習過程中能夠使模型的輸出忽略這些時長特征,那么可以認為它本身是無偏的,也就是讓模型能夠過濾掉時長相關的特征,從而實現無偏推薦。這里涉及一種對抗的思想,需要另一個模型,基于推薦模型的輸出來預測時長,如果它無法精確預測時長,那么認為前一個模型的輸出就不包含時長特征。因此,采用對抗學習方法,在推薦模型上加入一個回歸層,該回歸層基于預測出的 WTG 來預測原始的時長。如果 backbone 模型確實能夠實現沒有偏差的效果,那么回歸層就無法重新預測還原出原始的時長。

以上是該方法的細節,用于實現對抗學習。

3. 實驗效果

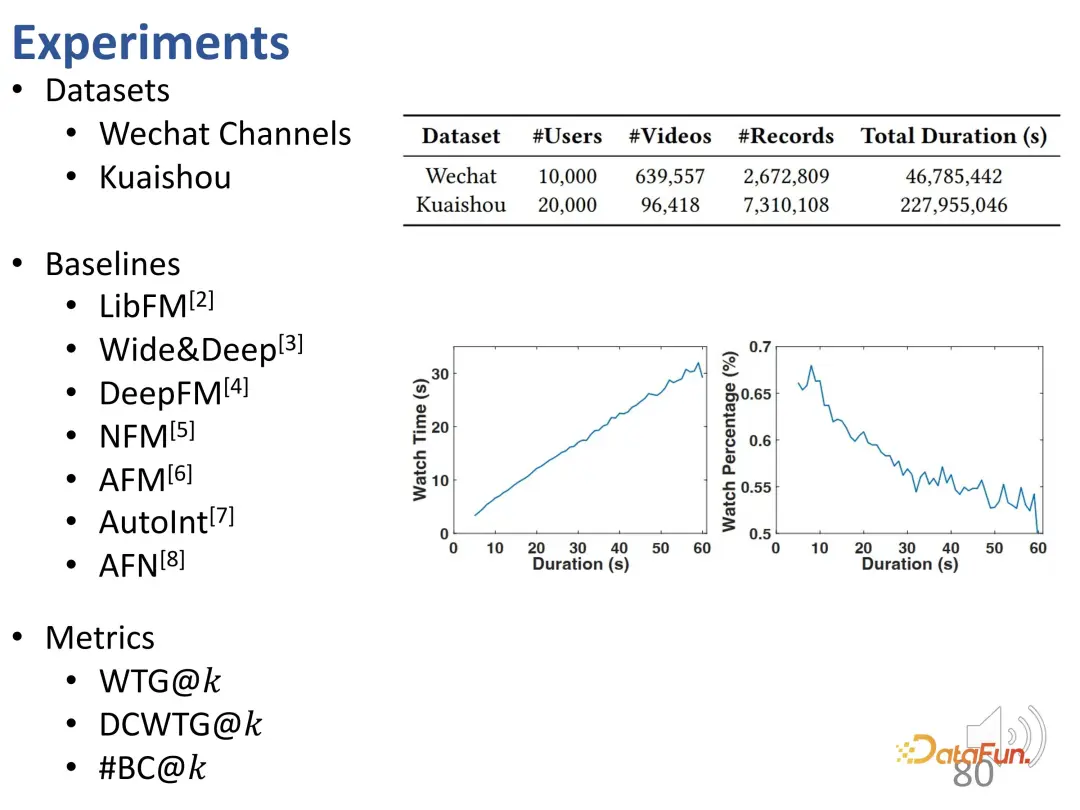

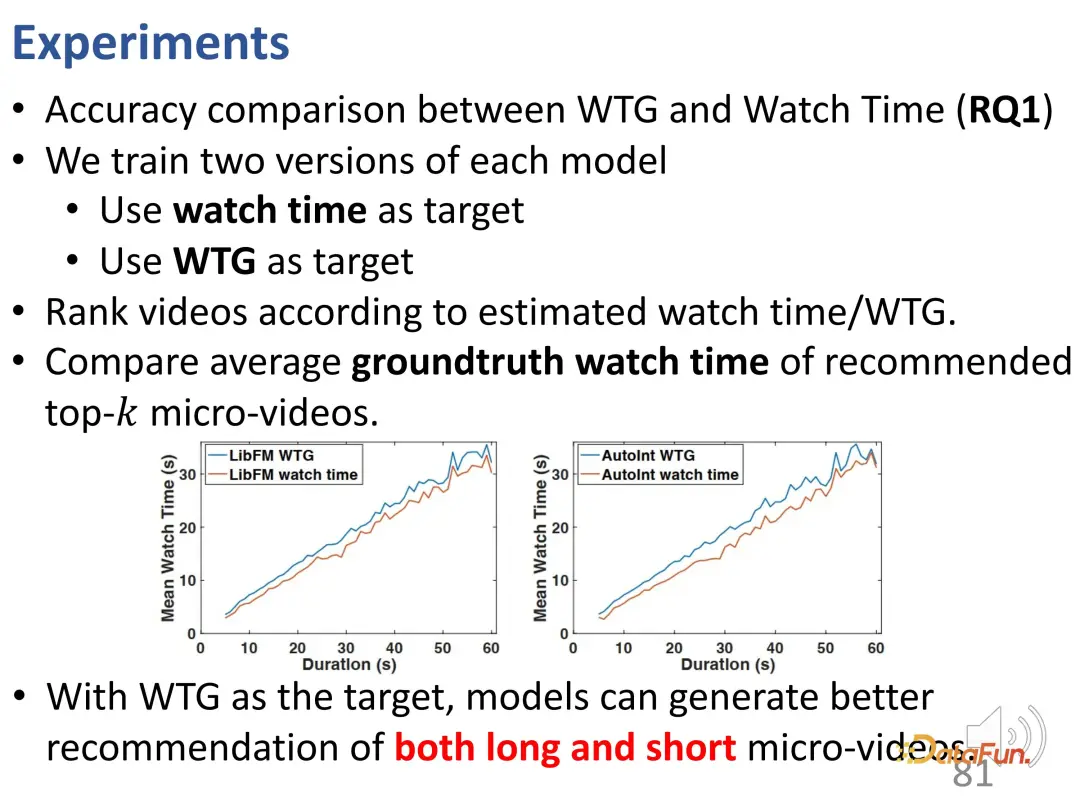

在微信和快手的兩個數據集上進行了實驗。首先是 WTG 和觀看時長的對比。可以看到,分別使用了這兩個優化目標,并與 ground truth 中的觀看時長進行比較。使用 WTG 作為目標后,模型在短視頻和長視頻上的推薦效果都更好,WTG 曲線穩定地位于觀看時長曲線上方。

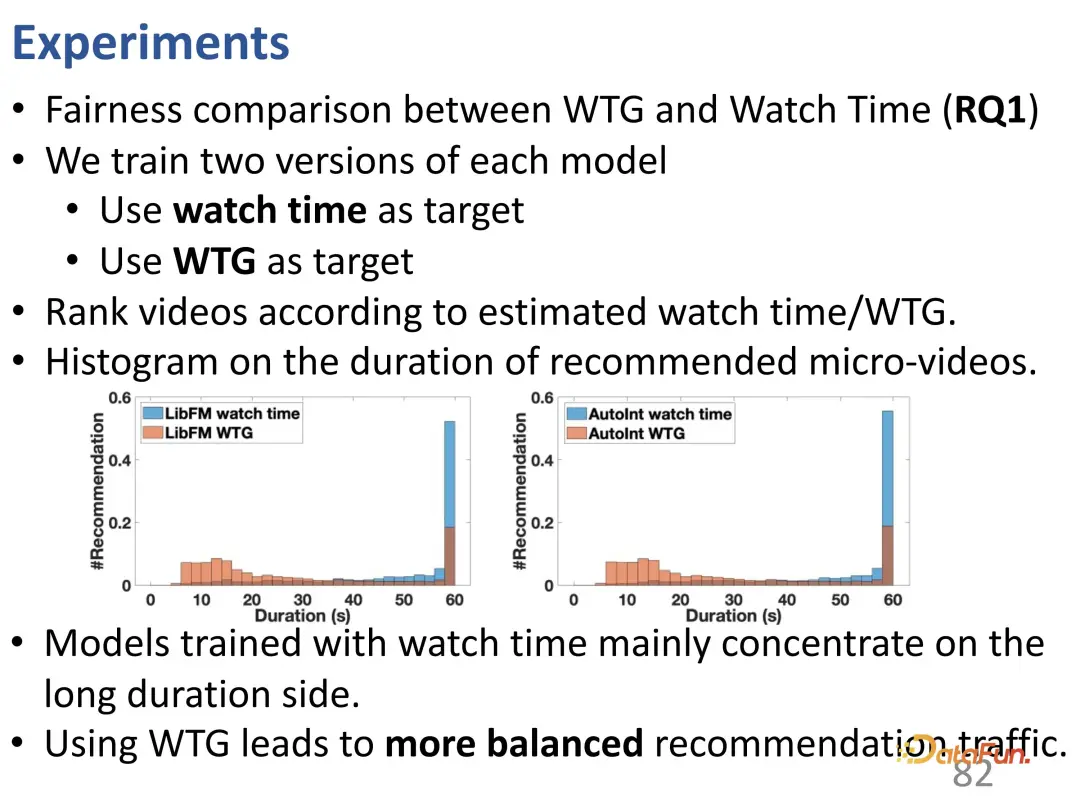

此外,使用 WTG 作為目標后,帶來了更平衡的長短視頻推薦流量(傳統模型中長視頻的推薦份額顯然更多)。

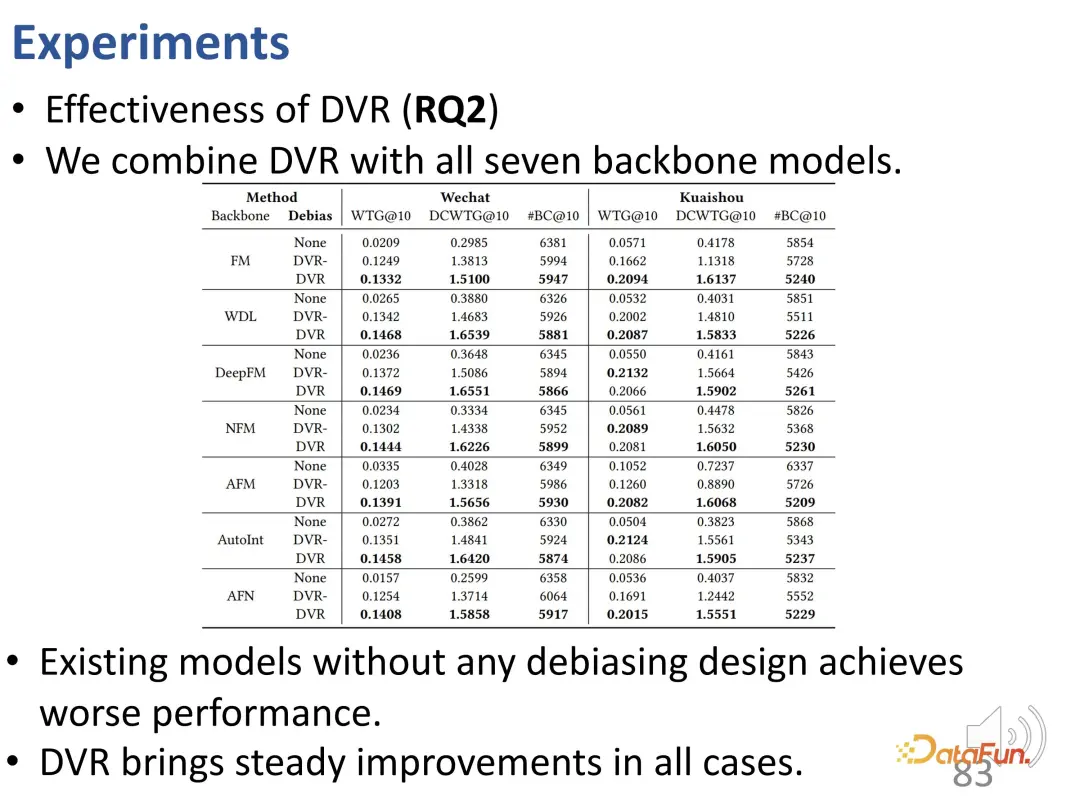

提出的 DVR 方法適用于不同的 backbone 模型:測試了 7 種常見的 backbone 模型,結果顯示沒有使用去偏方法的性能較差,而 DVR 在所有的 backbone 模型和所有指標上都有一定的提升。

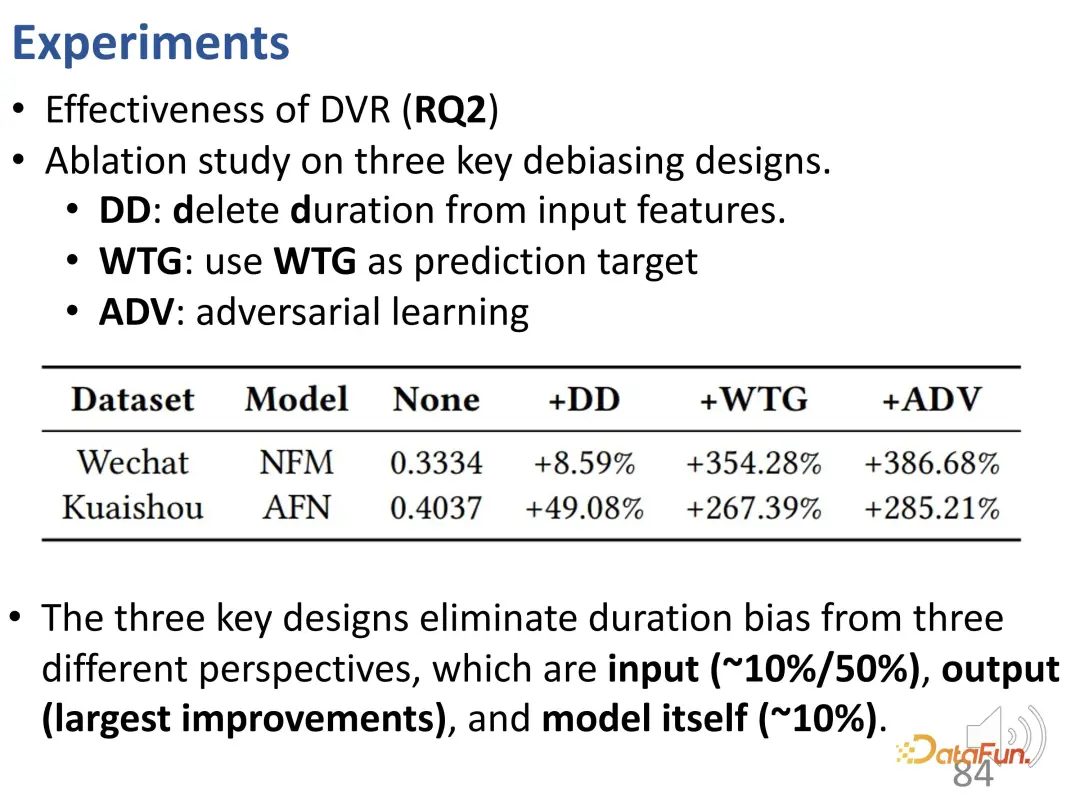

進一步做了一些消融實驗。前文中提到,這個方法有三部分設計,分別去掉了這三個部分。第一個是將時長作為輸入特征去掉,第二個是將 WTG 作為預測目標去掉,第三個是去掉對抗學習的方法。可以看到每個部分的去掉都會導致性能下降。因此,這三個設計都至關重要。

總結我們的工作:從削減偏差的思路來研究短視頻推薦,關注時長偏差。首先,提出了一種新的指標:WTG。它能夠很好地消除實際行為中(用戶興趣和時長)時長的偏差。第二,提出了一種通用的方法,使模型不再受視頻時長的影響,從而產生無偏的推薦。

最后對本次分享進行總結。首先,對用戶興趣和從眾度進行了解糾纏學習。接下來,在序列行為建模方面,研究了長期興趣和短期興趣的解糾纏。最后,針對短視頻推薦中觀看時長優化的問題,提出了一種消偏的學習方法。

以上就是本次分享的內容,謝謝大家。

相關文獻:

[1] Gao et al. Causal Inference in Recommender Systems: A Survey and Future Directions, TOIS 2024

[2] Zheng et al. Disentangling User Interest and Conformity for Recommendation with Causal Embedding, WWW 2021.

[3] Zheng et al. DVR:Micro-Video Recommendation Optimizing Watch-Time-Gain under Duration Bias, MM 2022

[4] Zheng et al. Disentangling Long and Short-Term Interests for Recommendation, WWW 2022.