Al Agent--大模型時代重要落地方向

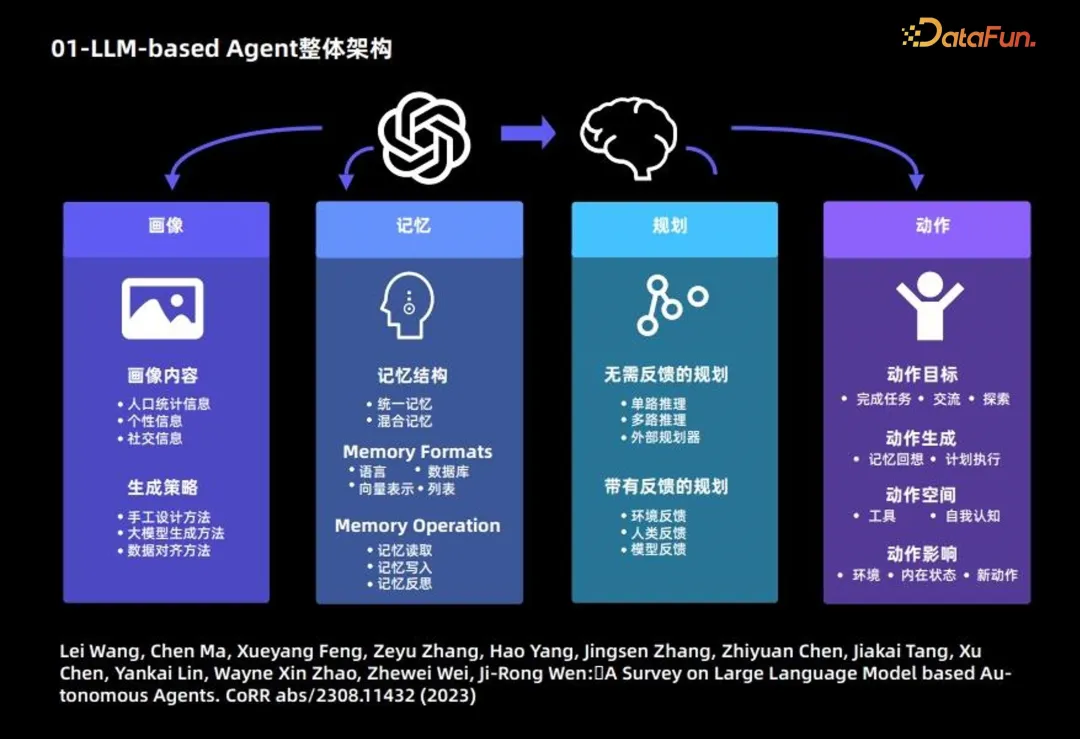

一、LLM-based Agent 整體架構

大語言模型 Agent 的構成,主要分為以下 4 個模塊:

1. 畫像模塊:主要描述 Agent 的背景信息

下面介紹畫像模塊的主要內容和生成策略。

畫像內容,主要基于 3 種信息:人口統計信息、個性信息和社交信息。

生成策略:主要采用 3 種策略來生成畫像內容:

- 手工設計方法:自行通過指定的方式,將用戶畫像的內容寫入大模型的 prompt 中;適用于 Agent 數量比較少的情況;

- 大模型生成方法:首先指定少量畫像,并將其作為示例,進而使用大語言模型生成更多的畫像;適用于大量 Agent 的情況;

- 數據對齊方法:需要根據事先指定的數據集中人物的背景信息作為大語言模型的 prompt,進而做相應的預測。

2. 記憶模塊:主要目的是記錄 Agent 行為,并為未來 Agent 決策提供支撐

記憶結構:

- 統一記憶:僅考慮短期記憶,不考慮長期記憶。

- 混合記憶:長期記憶和短期記憶相結合。

記憶形式:主要基于以下 4 種形式。

- 語言

- 數據庫

- 向量表示

- 列表

記憶內容:常見以下 3 種操作:

- 記憶讀取

- 記憶寫入

- 記憶反思

3. 規劃模塊

- 無需反饋的規劃:大語言模型在做推理的過程中無需外界環境的反饋。這類規劃進一步細分為三種類型:基于單路的推理,僅使用一次大語言模型就可以完整輸出推理的步驟;基于多路的推理,借鑒眾包的思想,讓大語言模型生成多個推理路徑,進而確定最佳路徑;借用外部的規劃器。

- 帶有反饋的規劃:這種規劃方式需要外界環境提供反饋,而大語言模型需要基于環境的反饋進行下一步以及后續的規劃。這類規劃反饋的提供者來自三個方面:環境反饋、人類反饋和模型反饋。

4. 動作模塊

- 動作目標:有些 Agent 的目標是完成某個任務,有些是交流,有些是探索。

- 動作生成:有些 Agent 是依靠記憶回想生成動作,有些是按照原有計劃執行特定的動作。

- 動作空間:有些動作空間是工具的集合,有些是基于大語言模型自身知識,從自我認知的角度考慮整個動作空間。

- 動作影響:包括對環境的影響、對內在狀態的影響,以及對未來新動作的影響。

以上是 Agent 的整體框架,更多內容可參考下述論文:

Lei Wang, Chen Ma, Xueyang Feng, Zeyu Zhang, Hao Yang, Jingsen Zhang, Zhiyuan Chen, Jiakai Tang, Xu Chen, Yankai Lin, Wayne Xin Zhao, Zhewei Wei, Ji-Rong Wen:A Survey on Large Language Model based Autonomous Agents. CoRR abs/2308.11432 (2023)

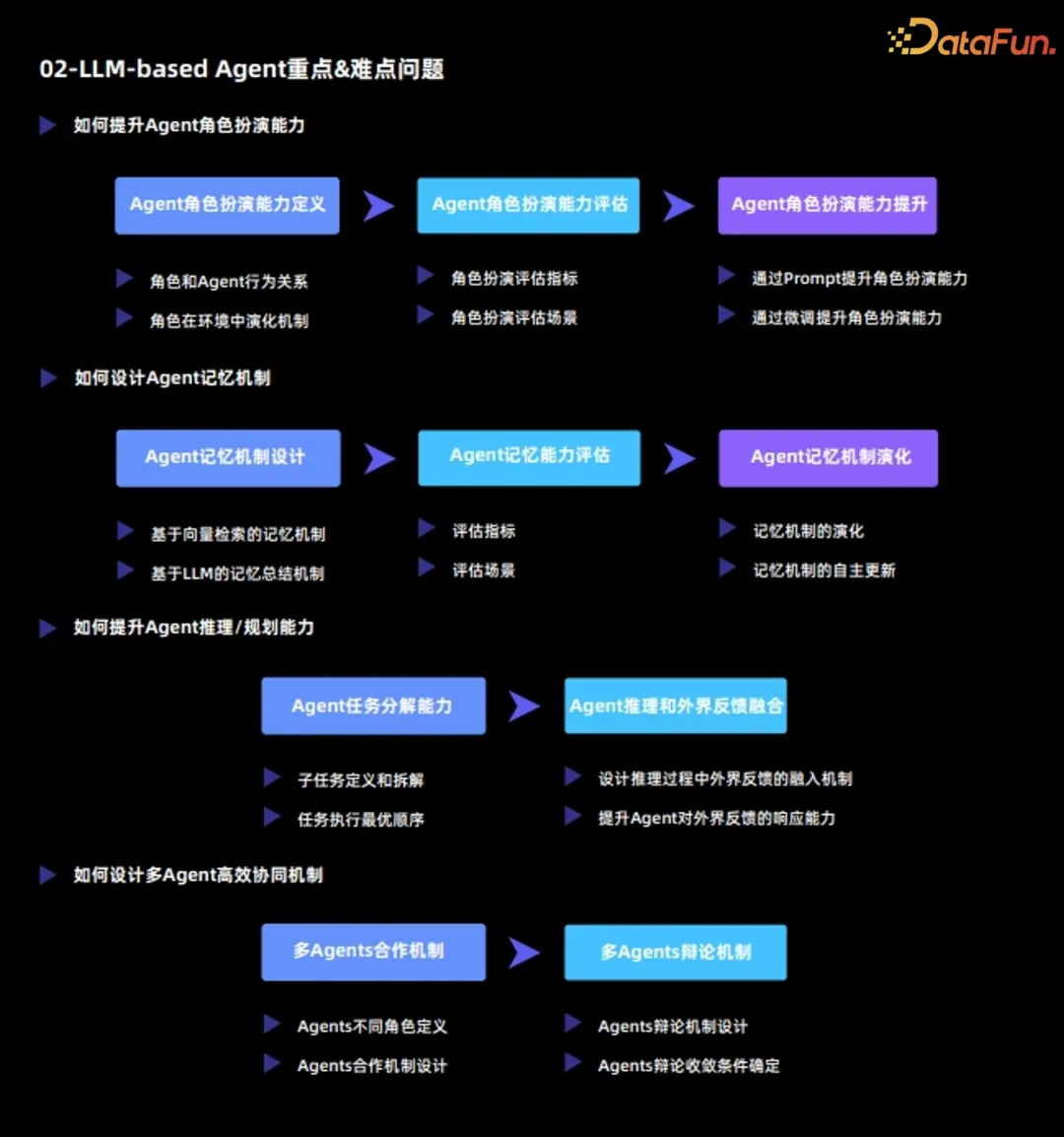

二、LLM-based Agent 重點&難點問題

當前大語言模型 Agent 的重點和難點問題主要包括:

1. 如何提升 Agent 的角色扮演能力

Agent 最重要的功能是通過扮演某種角色,來完成特定的任務,或者完成各種各樣的模擬,因此 Agent 的角色扮演能力至關重要。

(1)Agent 角色扮演能力定義

Agent 角色扮演能力分為兩個維度:

- 角色和 Agent 行為關系

- 角色在環境中演化機制

(2)Agent 角色扮演能力評估

定義了角色扮演能力之后,接下來要對 Agent 角色扮演能力,從以下兩個方面進行評估:

- 角色扮演評估指標

- 角色扮演評估場景

(3)Agent 角色扮演能力提升

在評估的基礎上,需要進一步對 Agent 的角色扮演能力進行提升,有如下兩種方法:

- 通過 Prompt 提升角色扮演能力:該方法本質是通過設計 prompt 來激發原有大語言模型的能力;

- 通過微調提升角色扮演能力:該方法通常是基于外部的數據,重新對大語言模型進行 finetune,來提升角色扮演能力。

2. 如何設計 Agent 記憶機制

Agent 和大語言模型最大的不同在于,Agent 能夠在環境中不斷進行自我演化和自我學習;而這其中,記憶機制扮演了非常重要的角色。從 3 個維度來分析 Agent 的記憶機制:

(1)Agent 記憶機制設計

常見有以下兩種記憶機制:

- 基于向量檢索的記憶機制

- 基于 LLM 總結的記憶機制

(2)Agent 記憶能力評估

對 Agent 記憶能力的評估,主要需要確定以下兩點:

- 評估指標

- 評估場景

(3)Agent 記憶機制演化

最后需要對 Agent 記憶機制演化進行分析,包括:

- 記憶機制的演化

- 記憶機制的自主更新

3. 如何提升 Agent 推理/規劃能力

(1)Agent 任務分解能力

- 子任務定義和拆解

- 任務執行最優順序

(2)Agent 推理和外界反饋融合

- 設計推理過程中外界反饋的融入機制:讓 Agent 和環境形成互相交互的整體;

- 提升 Agent 對外界反饋的響應能力:一方面需要 Agent 真實應對外界環境,另一方面需要 Agent 能夠對外界環境提出問題并尋求解答方案。

4. 如何設計多 Agent 高效協同機制

(1)多 Agents 合作機制

- Agents 不同角色定義

- Agents 合作機制設計

(2)多 Agents 辯論機制

- Agents 辯論機制設計

- Agents 辯論收斂條件確定

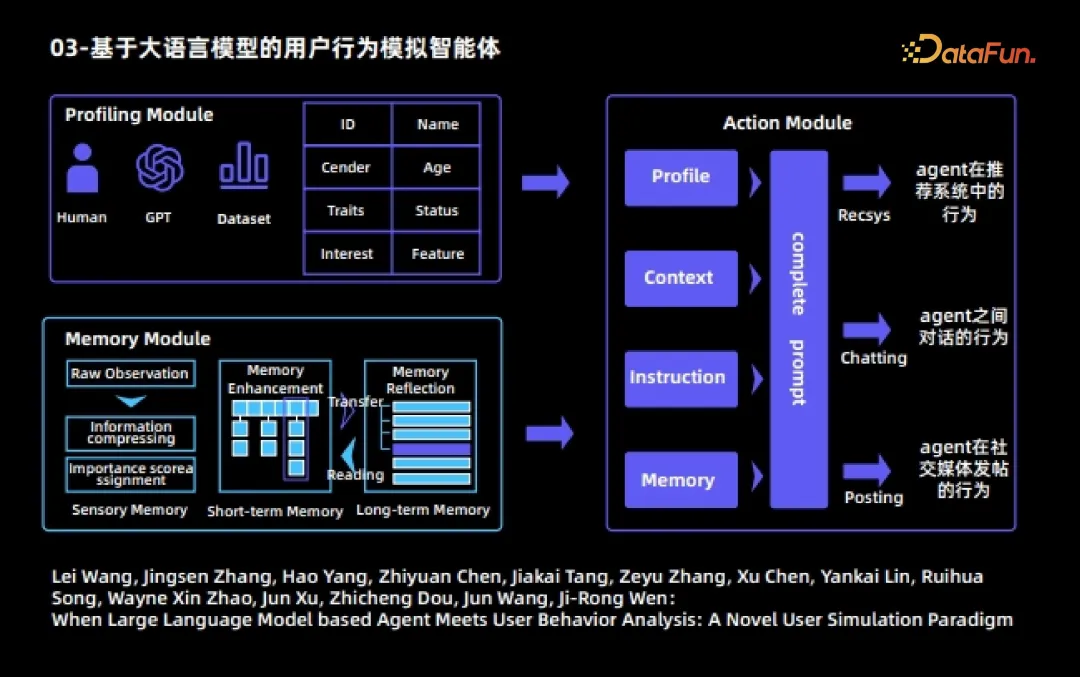

三、基于大語言模型的用戶行為模擬智能體

下面會舉幾個 Agent 的實際案例。首先是基于大語言模型的用戶行為模擬智能體。該智能體也是大語言模型智能體與用戶行為分析相結合的早期工作。該工作中,每個 Agent 分為三個模塊:

1. 畫像模塊

對不同的 Agent 指定不同的屬性,比如 ID、姓名、職業、年齡、興趣以及特征等。

2. 記憶模塊

記憶模塊包括三個子模塊

(1)感受記憶

(2)短期記憶

- 將客觀觀測到的 raw observation 進行處理后,生成信息量更高的觀測,將其存放到短期記憶中;

- 短期記憶內容的存儲時間比較短

(3)長期記憶

- 短期記憶的內容經過反復的觸發和激活后,會自動傳入到長期記憶中

- 長期記憶內容的存儲時間比較長

- 長期記憶的內容會根據現有的記憶進行自主的反思以及升華提煉。

3. 動作模塊

每個 Agent 可以執行三種動作:

- Agent 在推薦系統中的行為,包括看電影、查找下一頁以及離開推薦系統等;

- Agent 之間的對話行為;

- Agent 在社交媒體發帖的行為。

在整個模擬過程中,一個 Agent 在每一輪動作中均可自由地、不受外界干預地選擇三種動作;我們可以看到不同 Agent 之間會相互對話,也會在社交媒體或者推薦系統中自主地產生各種各樣的行為;通過多輪模擬之后,可以觀察到一些有趣的社會現象,以及用戶在網絡上行為的規律。

更多內容可參考下述論文:

Lei Wang, Jingsen Zhang, Hao Yang, Zhiyuan Chen, Jiakai Tang, Zeyu Zhang, Xu Chen, Yankai Lin, Ruihua Song, Wayne Xin Zhao, Jun Xu, Zhicheng Dou, Jun Wang, Ji-Rong Wen:When Large Language Model based Agent Meets User Behavior Analysis: A Novel User Simulation Paradigm

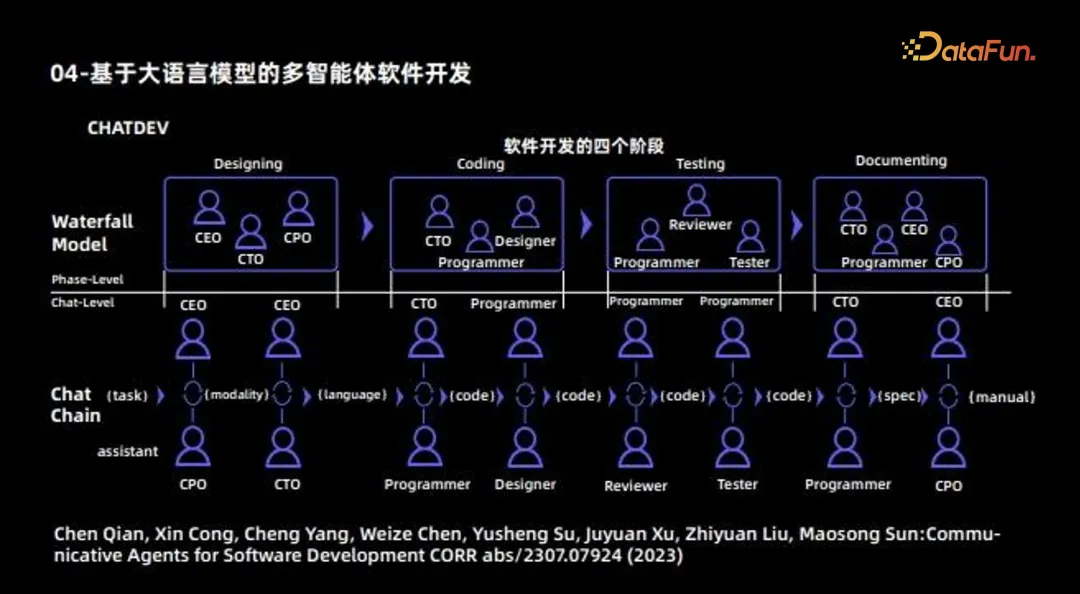

四、基于大語言模型的多智能體軟件開發

下一個 Agent 的例子是使用多 Agent 進行軟件開發。這篇工作也是早期多Agent 合作的工作,其最主要的目的是利用不同 Agent 開發一款完整的軟件。因此可將其看作一個軟件公司,不同的 Agent 會扮演不同的角色:一部分 Agent 負責設計,包括 CEO、CTO、CPO 等角色;一部分Agent 負責編碼,還有一部分 Agent 主要負責測試;此外,還會有一部分 Agent 負責撰寫文檔。這樣,不同 Agent 負責不同的工作;最后再將 Agent 之間的合作機制,通過交流的方式進行協同和更新,最終完成一個軟件完整的開發過程。

五、LLM-based Agent 未來方向

大語言模型的 Agent 目前可以分為兩大方向:

- 解決特定任務,如 MetaGPT、ChatDev、Ghost、DESP 等

這類 Agent 最終應是一個和人類正確價值觀對齊的“超人”,其中有兩個“限定詞”:

對齊正確的人類價值觀;

超越常人能力。 - 模擬現實世界,如 Generative Agent、Social Simulation、RecAgent等

這類 Agent 所需要的能力,和第一類是截然相反的。

允許 Agent 呈現多樣的價值觀;

希望 Agent 盡量符合普通人,而不是超越常人。

此外,目前大語言模型 Agent 存在以下兩個痛點:

- 幻覺問題

由于 Agent 需要跟環境進行不斷交互,因此每個步驟的幻覺都會被累加,即會產生累積效應,讓問題變得更加嚴重;因此大模型的幻覺問題在這里需要得到進一步的重視。其解決辦法包括:

設計高效的人機協作框架;

設計高效的人類干預機制。 - 效率問題

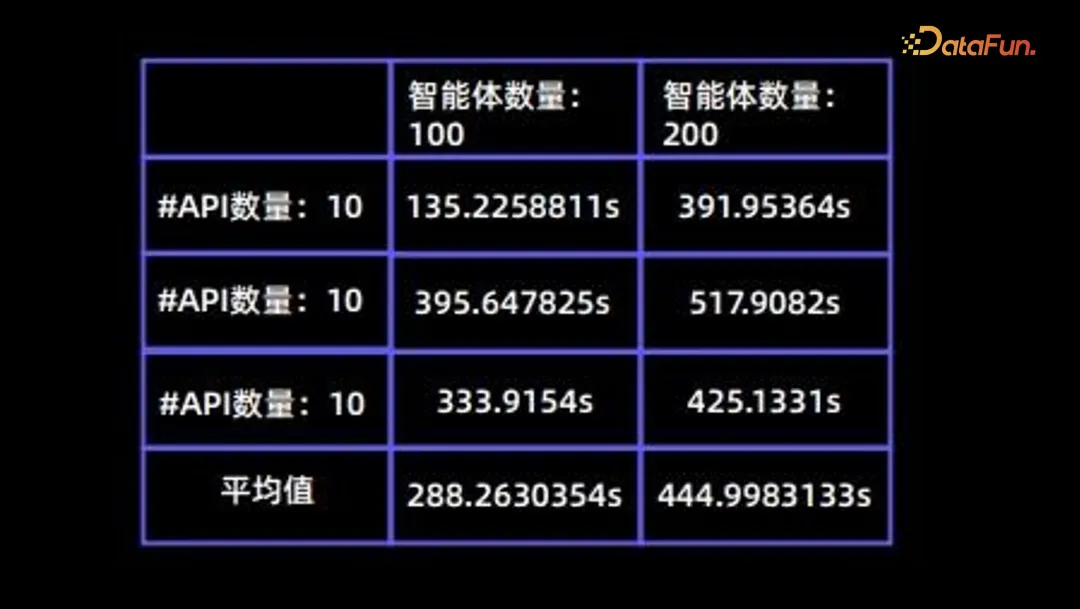

在模擬過程中,效率是個非常重要的問題;下表總結了不同 Agent 在不同API 數量下的耗時。

以上就是本次分享的內容,謝謝大家。