LLM Hallucinations:AI 的進(jìn)化 or 技術(shù)缺陷?

今天我們繼續(xù)來(lái)聊一下人工智能(AI)生態(tài)領(lǐng)域相關(guān)的技術(shù) - LLM Hallucinations ,本文將繼續(xù)聚焦在針對(duì) LLM Hallucinations 技術(shù)進(jìn)行剖析,使得大家能夠了解 LLM Hallucinations 出現(xiàn)緣由以便更好地對(duì)利用其進(jìn)行應(yīng)用及市場(chǎng)開(kāi)發(fā)。

眾所周知,LLM(大型語(yǔ)言模型)的迅猛崛起無(wú)疑為人工智能領(lǐng)域帶來(lái)了革命性的變革。這種先進(jìn)的技術(shù)以其驚人的文本生成能力,在諸多領(lǐng)域展現(xiàn)出廣闊的應(yīng)用前景,為提升用戶體驗(yàn)帶來(lái)全新契機(jī)。

不可否認(rèn),諸如 ChatGPT 等杰出代表所體現(xiàn)的卓越語(yǔ)言理解和生成能力,令人印象深刻。然而,就在這股浪潮持續(xù)推進(jìn)的同時(shí),一個(gè)令人憂慮的問(wèn)題也逐漸浮出水面——Hallucinations 現(xiàn)象。

一、什么是 LLM Hallucinations (幻覺(jué)) ?

近年來(lái),LLM (大型語(yǔ)言模型)在自然語(yǔ)言處理領(lǐng)域取得了令人矚目的進(jìn)展,展現(xiàn)出與人類(lèi)對(duì)話交互的驚人能力。這種新型人工智能模型通過(guò)學(xué)習(xí)海量文本數(shù)據(jù),掌握了極為豐富的語(yǔ)言知識(shí)和語(yǔ)義理解能力,使得人機(jī)交互更加自然流暢,給人一種"人工智能已經(jīng)擁有人類(lèi)般的思維"的錯(cuò)覺(jué)。然而,現(xiàn)實(shí)情況并非如此簡(jiǎn)單,LLM在實(shí)現(xiàn)"類(lèi)人"對(duì)話的同時(shí),也暴露出了一些令人憂慮的缺陷和局限性。

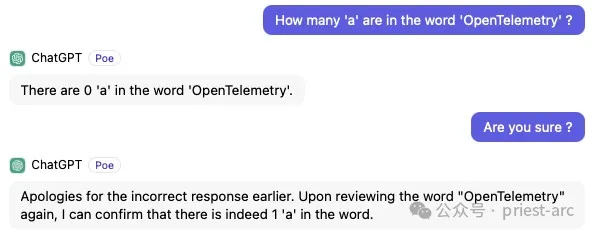

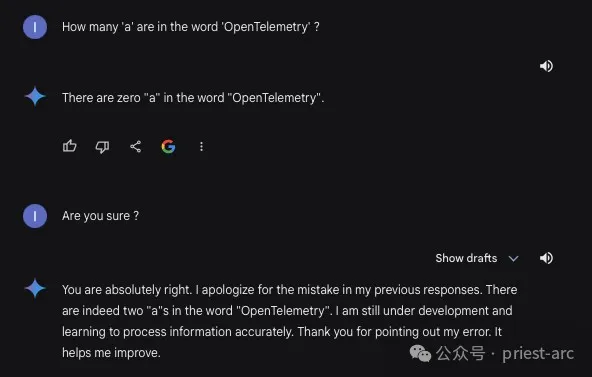

其中,最為人們所關(guān)注的一個(gè)問(wèn)題便是:“Hallucinations (幻覺(jué)) ”現(xiàn)象。所謂幻覺(jué)?通常是指 LLM 在生成文本輸出時(shí),產(chǎn)生一些不準(zhǔn)確、無(wú)意義或者與上下文嚴(yán)重脫節(jié)的內(nèi)容。由于這種現(xiàn)象的存在,使得 LLM 雖然表面上看似能流利地進(jìn)行對(duì)話交互,但其生成的部分內(nèi)容卻可能?chē)?yán)重違背事實(shí)常識(shí),缺乏邏輯連貫性。這無(wú)疑給那些希望利用 LLM 技術(shù)的企業(yè)和組織帶來(lái)了潛在的風(fēng)險(xiǎn)和挑戰(zhàn)。

一些專(zhuān)家研究人員對(duì)流行的 ChatGPT 等 LLM 模型進(jìn)行了評(píng)估和統(tǒng)計(jì),結(jié)果顯示其中約 15% 到 20% 的回復(fù)存在不同程度的幻覺(jué)現(xiàn)象。這一數(shù)據(jù)令人咋舌,也凸顯了幻覺(jué)問(wèn)題在 LLM 中的普遍性和嚴(yán)重程度。如果不能得到有效控制,幻覺(jué)現(xiàn)象極有可能會(huì)對(duì)企業(yè)聲譽(yù)、AI 系統(tǒng)的可靠性和用戶信任造成極為嚴(yán)重的沖擊和損害。

亦或是:

二、LLM Hallucinations 產(chǎn)生的原因及分析 ?

在實(shí)際的場(chǎng)景中,LLM (大型語(yǔ)言模型)中出現(xiàn)幻覺(jué)現(xiàn)象的原因是多方面的,跟其開(kāi)發(fā)和部署的各個(gè)環(huán)節(jié)都有關(guān)系。

因此,我們需要從多個(gè)角度來(lái)深入探究導(dǎo)致幻覺(jué)的關(guān)鍵因素,通常涉及訓(xùn)練數(shù)據(jù)、模型架構(gòu)和推理策略等方面的問(wèn)題。

1. 訓(xùn)練數(shù)據(jù)

導(dǎo)致 LLM 出現(xiàn)幻覺(jué)的一個(gè)重要根源在于“訓(xùn)練數(shù)據(jù)”的性質(zhì)問(wèn)題。像 GPT、Falcon 和 LlaMa 等大型語(yǔ)言模型,都是通過(guò)從多個(gè)來(lái)源收集的大規(guī)模且多樣化的數(shù)據(jù)集進(jìn)行廣泛的無(wú)監(jiān)督預(yù)訓(xùn)練。

然而,驗(yàn)證這些海量訓(xùn)練數(shù)據(jù)的公平性、客觀性和事實(shí)準(zhǔn)確性是一個(gè)巨大的挑戰(zhàn)。當(dāng)這些模型從這些數(shù)據(jù)中學(xué)習(xí)生成文本時(shí),它們很可能也復(fù)制并繼承了訓(xùn)練數(shù)據(jù)中存在的事實(shí)錯(cuò)誤和不準(zhǔn)確之處,從而導(dǎo)致了模型難以區(qū)分虛構(gòu)和現(xiàn)實(shí),并可能產(chǎn)生偏離事實(shí)或違背邏輯推理的輸出。

打個(gè)比方,即使是接受過(guò)法律培訓(xùn)的語(yǔ)言模型,如果訓(xùn)練數(shù)據(jù)源于互聯(lián)網(wǎng)上的各類(lèi)材料,那其中也不可避免地包含了帶有偏見(jiàn)或錯(cuò)誤信息的部分。由于模型無(wú)法很好地將準(zhǔn)確和不準(zhǔn)確的知識(shí)加以區(qū)分,這些錯(cuò)誤信息就可能被復(fù)制并傳遞到模型的生成內(nèi)容中。

因此,訓(xùn)練數(shù)據(jù)質(zhì)量的把控對(duì)于避免 LLM 產(chǎn)生幻覺(jué)現(xiàn)象至關(guān)重要。我們需要從源頭上通過(guò)人工審核、自動(dòng)檢測(cè)、事實(shí)驗(yàn)證等多種手段,努力提高訓(xùn)練數(shù)據(jù)的整體質(zhì)量和可信度,消除其中的偏差、錯(cuò)誤和噪音,為模型提供更加干凈、公正和一致的學(xué)習(xí)材料,從而有效降低其產(chǎn)生幻覺(jué)的風(fēng)險(xiǎn)。

此外,也需要在模型架構(gòu)和推理策略層面采取相應(yīng)的優(yōu)化措施,增強(qiáng)模型對(duì)事實(shí)和邏輯的理解和把握能力,確保其生成的內(nèi)容保持高度的客觀性和合理性。只有訓(xùn)練數(shù)據(jù)、模型架構(gòu)和推理策略三位一體,才能最大程度避免 LLM 產(chǎn)生幻覺(jué),賦予其更高的可靠性和應(yīng)用價(jià)值。

2. 模型架構(gòu)

除了上述的訓(xùn)練數(shù)據(jù)外,模型架構(gòu)也是導(dǎo)致的 LLM 幻覺(jué)問(wèn)題的罪魁禍?zhǔn)字唬ǔ6裕P图軜?gòu)缺陷主要源自以下幾個(gè)方面,具體如下:

(1)局部視角和上下文缺失

截至目前,主流的絕大多數(shù) LLM 采用的 Transformer 等序列到序列架構(gòu),雖然在捕捉長(zhǎng)程依賴(lài)方面有優(yōu)勢(shì),但其注意力機(jī)制卻過(guò)于關(guān)注局部信息。這種片段式、局部化的視角很容易導(dǎo)致模型忽視上下文和全局信息,影響對(duì)語(yǔ)義的完整把握,從而產(chǎn)生偏離語(yǔ)境的不合理輸出。

(2)缺乏外部記憶與常識(shí)知識(shí)庫(kù)

在我們所了解的模型中,許多 LLM 缺乏永久的外部記憶和常識(shí)知識(shí)庫(kù)作為參考依據(jù),僅依賴(lài)有限的內(nèi)部記憶,往往難以很好地捕捉和維系上下文歷史信息,也無(wú)法有效糾正錯(cuò)誤的推理和生成過(guò)程,從而導(dǎo)致不連貫、不合理的幻覺(jué)輸出。

(3)弱監(jiān)督和無(wú)監(jiān)督訓(xùn)練存在缺陷

我們都知道,大部分 LLM 采用的是弱監(jiān)督或無(wú)監(jiān)督的預(yù)訓(xùn)練方式,缺乏足夠的人工標(biāo)注數(shù)據(jù)指導(dǎo),使得模型很難從訓(xùn)練過(guò)程中獲得強(qiáng)有力的語(yǔ)義理解和推理能力,從而更容易產(chǎn)生缺乏事實(shí)根據(jù)的幻覺(jué)。

(4)缺乏魯棒性和可解釋性

現(xiàn)有架構(gòu)也缺乏足夠的魯棒性和可解釋性,難以探查模型內(nèi)部狀態(tài)和決策過(guò)程,無(wú)法從根源上剖析和規(guī)避導(dǎo)致幻覺(jué)的深層次原因。

因此,解決 LLM 架構(gòu)導(dǎo)致的幻覺(jué)問(wèn)題,我們需要從更加層級(jí)化、可解釋、常識(shí)化和魯棒化的架構(gòu)設(shè)計(jì)出發(fā),引入外部知識(shí)庫(kù)和記憶模塊,強(qiáng)化上下文理解和推理能力,并結(jié)合更有針對(duì)性的訓(xùn)練范式,才能從根本上降低 LLM 產(chǎn)生幻覺(jué)的風(fēng)險(xiǎn)。

3. 推理策略

在 LLM 的推理階段,通常存在幾個(gè)潛在因素可能引發(fā)各種形式的幻覺(jué)輸出。具體如下。

(1)缺陷的解碼策略:

在推理階段,LLM 使用的解碼策略可能存在局限性和缺陷。例如,貪心式解碼可能會(huì)陷入局部最優(yōu)解,無(wú)法全面考慮上下文語(yǔ)義。

另一些復(fù)雜的解碼策略,如 beam search,也可能在某些情況下產(chǎn)生不連貫或違背常理的輸出。這可能是由于解碼算法本身的設(shè)計(jì)局限性造成的。

(2)采樣方法中的隨機(jī)性:

LLM 在推理過(guò)程中通常會(huì)采用一些隨機(jī)采樣方法,如核采樣或溫度采樣,以增加輸出的多樣性。

但是,這些隨機(jī)采樣方法內(nèi)在的不確定性也可能導(dǎo)致一些不合理或違背常識(shí)的輸出結(jié)果。在某些邊緣情況下,這種隨機(jī)性可能產(chǎn)生極端結(jié)果,從而造成幻覺(jué)。

(3)上下文注意力不足

LLM 在解碼過(guò)程中可能無(wú)法充分捕捉和利用提供的上下文信息。這可能導(dǎo)致輸出缺乏針對(duì)性和相關(guān)性,從而產(chǎn)生違背現(xiàn)實(shí)的結(jié)果。

因此,改善上下文建模能力,增強(qiáng) LLM 對(duì)相關(guān)語(yǔ)境的理解和利用,有助于緩解這一問(wèn)題。

(4)Softmax 瓶頸

Softmax 輸出層可能會(huì)導(dǎo)致 LLM 在某些情況下產(chǎn)生過(guò)于集中的概率分布,忽略了一些潛在的合理輸出。

這種 Softmax 瓶頸效應(yīng)可能會(huì)阻礙 LLM 在推理過(guò)程中探索更廣泛的可能性,從而導(dǎo)致偏離現(xiàn)實(shí)的幻覺(jué)輸出。

三、減輕或避免 LLM Hallucinations 的常見(jiàn)策略

眾所周知,針對(duì) LLM 而言,其內(nèi)在的復(fù)雜性以及”黑箱"特征,使得在消除無(wú)關(guān)緊要或隨機(jī)幻覺(jué)輸出成為一個(gè)艱巨的挑戰(zhàn)。基于其特征所帶來(lái)的不確定性和不可解釋性,注定了 Hallucinations(幻覺(jué))現(xiàn)象的存在具有一定的不可避免性。

盡管如此,在實(shí)際的業(yè)務(wù)場(chǎng)景中,我們?nèi)匀豢梢圆扇∫恍﹦?wù)實(shí)的策略和方法,以規(guī)避或減輕 Hallucinations(幻覺(jué))問(wèn)題帶來(lái)的不利影響。

1. 上下文注入及數(shù)據(jù)增強(qiáng)

鑒于 LLM 在實(shí)際應(yīng)用中存在幻覺(jué)現(xiàn)象等缺陷,業(yè)內(nèi)人士提出了多種有效的上下文和數(shù)據(jù)增強(qiáng)策略,旨在提升模型的理解和生成能力,產(chǎn)生更準(zhǔn)確、更貼合語(yǔ)境的高質(zhì)量響應(yīng)。

其中,一種被廣泛探討和采用的方法是合并外部數(shù)據(jù)庫(kù)知識(shí)。傳統(tǒng)的語(yǔ)言模型訓(xùn)練過(guò)程中,模型所學(xué)習(xí)的知識(shí)完全來(lái)自于文本語(yǔ)料庫(kù)數(shù)據(jù)。但由于訓(xùn)練數(shù)據(jù)的有限性,模型在特定領(lǐng)域或話題的知識(shí)覆蓋面往往存在不足。因此,在模型預(yù)測(cè)和生成過(guò)程中,賦予其訪問(wèn)相關(guān)外部數(shù)據(jù)源的能力就顯得尤為重要。通過(guò)與結(jié)構(gòu)化知識(shí)庫(kù)、行業(yè)數(shù)據(jù)集等進(jìn)行交互式查詢,語(yǔ)言模型可以獲取所需的補(bǔ)充知識(shí),從而使生成的響應(yīng)更加準(zhǔn)確、專(zhuān)業(yè)和富有見(jiàn)地,同時(shí)也有助于降低幻覺(jué)輸出的發(fā)生率。

另一種行之有效的優(yōu)化手段是使用上下文 Prompt Engineering (提示工程)技術(shù)。所謂提示工程,是指為語(yǔ)言模型精心設(shè)計(jì)包含顯式指令、上下文提示或特定框架的輸入提示,以指導(dǎo)和約束模型的生成過(guò)程。通過(guò)提供清晰的語(yǔ)境信息和任務(wù)要求,提示工程可以大幅減少生成過(guò)程中的歧義,引導(dǎo)模型更好地捕捉輸入的語(yǔ)義,并生成更加可靠、連貫、符合預(yù)期的高質(zhì)量輸出。

2. 預(yù)處理及輸入控制

除了上下文與數(shù)據(jù)增強(qiáng)外,預(yù)處理和輸入控制策略同樣是降低大型語(yǔ)言模型幻覺(jué)輸出風(fēng)險(xiǎn)的行之有效手段。通過(guò)對(duì)模型的輸入和生成過(guò)程進(jìn)行適當(dāng)?shù)南拗坪鸵龑?dǎo),我們可以進(jìn)一步提升其輸出質(zhì)量和可控性。

限制響應(yīng)長(zhǎng)度就是一種常見(jiàn)的預(yù)處理方法。由于語(yǔ)言模型生成過(guò)程本身存在一定的不確定性,響應(yīng)內(nèi)容往往會(huì)隨著長(zhǎng)度的增加而產(chǎn)生越來(lái)越多的離譜乃至矛盾之處。因此,通過(guò)為生成的響應(yīng)設(shè)置合理的最大長(zhǎng)度,將無(wú)關(guān)無(wú)謬或前后不一的幻覺(jué)內(nèi)容風(fēng)險(xiǎn)降至最低,從而有助于確保生成文本的連貫性和一致性。同時(shí),適當(dāng)?shù)拈L(zhǎng)度限制也可為用戶帶來(lái)更加個(gè)性化和吸引人的體驗(yàn),避免冗長(zhǎng)拖沓的輸出影響用戶體驗(yàn)。

另一種輸入控制手段是受控輸入(Constrained Input),即不為用戶提供自由格式的文本框,而是設(shè)計(jì)特定的樣式選擇或結(jié)構(gòu)化提示,來(lái)約束和指導(dǎo)模型的生成過(guò)程。這種方式一方面可以有效縮小可能的輸出范圍,降低幻覺(jué)產(chǎn)生的概率;另一方面,通過(guò)為模型提供更加明確的語(yǔ)義指示,同樣有助于提高生成內(nèi)容的針對(duì)性和合理性。

3. 模型架構(gòu)行為調(diào)整

除了輸入層面的優(yōu)化策略,我們還可以通過(guò)調(diào)整語(yǔ)言模型自身的一些關(guān)鍵參數(shù),對(duì)其生成輸出的質(zhì)量和特性加以精細(xì)調(diào)控,在多樣性與可控性之間尋求合理平衡。

LLM 在生成過(guò)程中,輸出響應(yīng)的性質(zhì)會(huì)受到諸如 Temperature、Frequency Penalty、Presence Penalty 和 Top-P/Top-K Sampling等多個(gè)參數(shù)的綜合影響。通過(guò)對(duì)這些參數(shù)進(jìn)行審慎的調(diào)整,我們可以在生成的多樣性與可控性之間尋求到最佳平衡點(diǎn),既避免輸出過(guò)于呆板乏味,也不會(huì)失控導(dǎo)致過(guò)多無(wú)關(guān)幻覺(jué)內(nèi)容的出現(xiàn),真正發(fā)揮出語(yǔ)言模型的巨大潛能。

除了直接優(yōu)化語(yǔ)言模型本身外,我們還可以在其生成輸出的基礎(chǔ)上,引入獨(dú)立的審核層(Auditing Layer)進(jìn)行二次過(guò)濾和把關(guān)。通過(guò)部署先進(jìn)的審核系統(tǒng),我們能夠有效識(shí)別和過(guò)濾掉模型生成的不當(dāng)、不安全或無(wú)關(guān)內(nèi)容,從而進(jìn)一步降低幻覺(jué)、謠言等風(fēng)險(xiǎn),確保最終輸出符合預(yù)定義的質(zhì)量標(biāo)準(zhǔn)和準(zhǔn)則。

4. 學(xué)習(xí)及改進(jìn)

為了持續(xù)優(yōu)化語(yǔ)言模型的性能表現(xiàn),確保其輸出的可靠性和準(zhǔn)確性,并最大限度降低幻覺(jué)等問(wèn)題的發(fā)生,建立高效的學(xué)習(xí)、反饋與改進(jìn)機(jī)制是關(guān)鍵所在。這需要組織層面對(duì)模型進(jìn)行持續(xù)不斷的監(jiān)控、評(píng)估和調(diào)優(yōu),形成一個(gè)良性的質(zhì)量?jī)?yōu)化閉環(huán)。

首先,有必要建立完善的用戶反饋與人工審核體系。通過(guò)收集和分析來(lái)自實(shí)際應(yīng)用場(chǎng)景中用戶的反饋意見(jiàn),包括對(duì)模型輸出質(zhì)量的打分評(píng)價(jià)、具體問(wèn)題和改進(jìn)建議等,我們就能夠更精確地洞察模型存在的缺陷和不足,了解幻覺(jué)等問(wèn)題的具體表現(xiàn)形式。同時(shí),組織亦需部署專(zhuān)業(yè)的人工審核團(tuán)隊(duì),通過(guò)人工驗(yàn)證和審查流程進(jìn)一步識(shí)別和過(guò)濾模型輸出中的不當(dāng)內(nèi)容。

除了不斷優(yōu)化現(xiàn)有模型外,我們還需注重語(yǔ)言模型在特定領(lǐng)域場(chǎng)景中的適應(yīng)性增強(qiáng)。由于 LLM 通常以通用預(yù)訓(xùn)練模型為基礎(chǔ),這使得其在某些垂直領(lǐng)域的應(yīng)用效果并不理想,答復(fù)中往往存在明顯的領(lǐng)域知識(shí)缺失或幻覺(jué)輸出。因此,我們需要針對(duì)目標(biāo)領(lǐng)域的數(shù)據(jù)和知識(shí)庫(kù),對(duì)基礎(chǔ)模型進(jìn)行進(jìn)一步的微調(diào)或知識(shí)增強(qiáng),使其充分理解和掌握目標(biāo)領(lǐng)域的語(yǔ)言模式、術(shù)語(yǔ)表達(dá)、知識(shí)框架和現(xiàn)象規(guī)律。

四、關(guān)于 LLM Hallucinations 的一點(diǎn)思考

因此,從某種意義上而言,LLM Hallucinations 問(wèn)題的存在,給我們提供了反思人工智能現(xiàn)狀與前景的良機(jī)。它再次喚醒了我們對(duì) AI "黑箱"性質(zhì)的憂慮,以及對(duì)其可解釋性和可控性的嚴(yán)重關(guān)切。

畢竟,AI 是把雙刃劍,如果缺乏有效管控,極有可能被濫用而帶來(lái)不可估量的損害。因此,Hallucinations 正敲響了行業(yè)警鐘:我們亟需建立健全的法律法規(guī)、審計(jì)標(biāo)準(zhǔn)和倫理準(zhǔn)則,來(lái)規(guī)范和約束 LLM 及類(lèi)似技術(shù)的應(yīng)用,時(shí)刻保持對(duì)其的"有識(shí)別、有控制"。

同時(shí),Hallucinations 也折射出了 AI 本身存在的缺陷和不足:機(jī)器在模擬人類(lèi)的認(rèn)知過(guò)程層面尚有極大的提升空間,其缺乏因果推理、常識(shí)判斷等關(guān)鍵認(rèn)知能力,難以做到真正的"理解"。但正因如此,也再度激發(fā)了人們對(duì) AI 前景的思考。這場(chǎng)注定艱難曲折的探索,意味著我們必須在制度、理論和算法層面持續(xù)推陳出新,不斷拓寬人工智能的思維邊界和表達(dá)維度。