編輯|伊風

出品 | 51CTO技術棧(微信號:blog51cto)

谷歌終于出手了!我們將不再忍受大模型的“健忘癥”。

TransformerFAM橫空出世,放話要讓大模型擁有無限記憶力!

話不多說,先來看看TransformerFAM的“療效”:

圖片

圖片

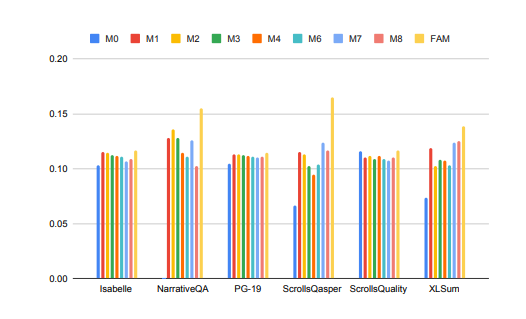

大模型在處理長上下文任務時的性能得到了顯著提升!

上圖中,Isabelle、NarrativeQA等任務要求模型理解和處理大量上下文信息,并對特定問題給出準確的回答或摘要。在所有任務中,F(xiàn)AM配置的模型都優(yōu)于所有其他BSWA配置,并且能看到當超過某個點時,BSWA記憶段數(shù)量的增加已經(jīng)無法繼續(xù)提升其記憶能力。

看來,在卷長文本、長對話的路上,F(xiàn)AM這顆大模型的“忘不了”確實有點東西。

Google 的研究人員介紹,F(xiàn)AM這種新穎的 Transformer 架構——Feedback Attention Memory,它利用反饋循環(huán)使網(wǎng)絡能夠關注其自身的潛在表示,促進 Transformer 內(nèi)部工作記憶的出現(xiàn),并使其能夠處理無限長的序列。

簡單點說,這個策略有點像我們?nèi)斯勾竽P汀笆洝钡牟呗裕好看魏痛竽P蛯υ捛岸荚佥斎胍淮蝡rompt。只不過FAM的做法更高階一些,在模型處理新的數(shù)據(jù)塊時,它會將之前處理過的信息(即FAM)作為一個動態(tài)更新的上下文,再次整合到當前的處理過程中。

這樣就能很好地應對“愛忘事”的問題了。更妙的是,盡管引入了反饋機制來維持長期的工作記憶,但FAM的設計旨在保持與預訓練模型的兼容性,不需要額外的權重。所以理論上說,大模型的強大記憶力,沒有使其變得遲鈍或者消耗更多的算力資源。

那么,這么妙的TransformerFAM是如何被探索出來的?相關技術又是啥?

一、從挑戰(zhàn)中來,TransformerFAM為何能幫助大模型“記住更多”?

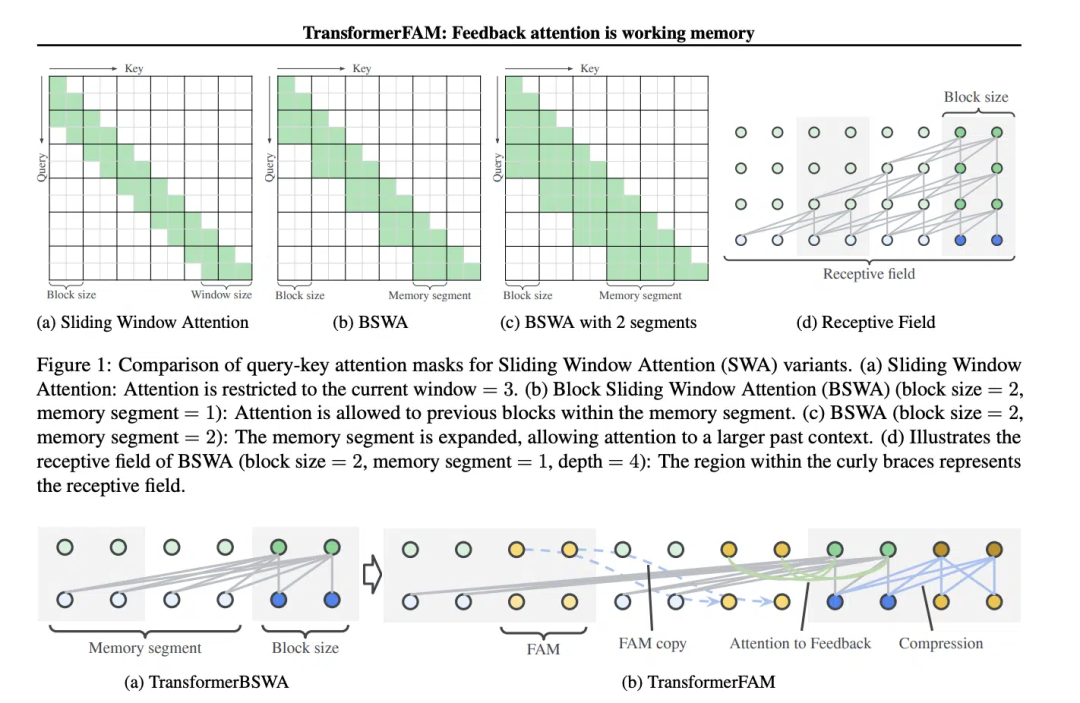

滑動窗口注意力(Sliding Window Attention, SWA)這個概念,對TransformerFAM的設計至關重要。

在傳統(tǒng)的Transformer模型中,自注意力(Self-Attention)的復雜度隨著序列長度的增加而呈二次方增長,這限制了模型處理長序列的能力。

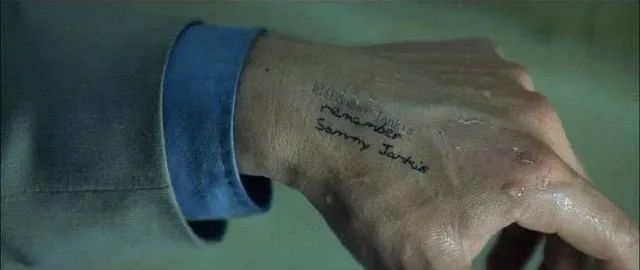

“在電影《記憶碎片》(2000 年)中,主角患有順行性遺忘癥,這意味著他無法記住過去 10 分鐘發(fā)生的事情,但他的長期記憶是完好的,他不得不將重要信息紋在身上以記住它們。這與當前大型語言模型(LLMs)的狀態(tài)類似,”論文中這樣寫道。

《記憶碎片》電影截圖,圖片源于網(wǎng)絡

《記憶碎片》電影截圖,圖片源于網(wǎng)絡

滑動窗口注意力(Sliding Window Attention),它是一種改進的注意力機制,用于處理長序列數(shù)據(jù)。它受到了計算機科學中滑動窗口技術(sliding window technique)的啟發(fā)。在處理自然語言處理(NLP)任務時,SWA允許模型在每個時間步驟上只關注輸入序列的一個固定大小的窗口,而不是整個序列。因此,SWA的優(yōu)點在于它可以顯著減少計算量。

圖片

圖片

但是SWA有局限性,因為它的注意力范圍受限于窗口大小,這導致模型無法考慮到窗口之外的重要信息。

TransformerFAM通過添加反饋激活,將上下文表示重新輸入到滑動窗口注意力的每個區(qū)塊中,從而實現(xiàn)了集成注意力、區(qū)塊級更新、信息壓縮和全局上下文存儲。

在TransformerFAM中,改進通過反饋循環(huán)實現(xiàn)。具體來說,模型在處理當前序列塊時,不僅關注當前窗口內(nèi)的元素,還會將之前處理過的上下文信息(即之前的“反饋激活”)作為額外的輸入重新引入到注意力機制中。這樣,即使模型的注意力窗口在序列上滑動,它也能夠保持對之前信息的記憶和理解。

于是,經(jīng)過這番改進,TransformerFAM就給了LLMs能夠處理無限長度序列的潛力!

二、有了工作記憶的大模型,繼續(xù)向AGI邁進

TransformerFAM在研究中展現(xiàn)出了積極的前景,這將毫無疑問地提升AI在理解和生成長文本任務中的性能,例如處理文檔摘要、故事生成、問答等工作。

圖片

圖片

同時,無論是智能助手還是情感陪伴,一個有無限記憶力的AI聽起來都更有吸引力。

有趣的是,TransformerFAM的設計靈感來源于生物學中的記憶機制,這一點與AGI追求的自然智能模擬不謀而合。這篇論文正是一個來自神經(jīng)科學的概念——基于注意力的工作記憶——整合到深度學習領域的嘗試。

TransformerFAM通過反饋循環(huán)為大模型引入了工作記憶,使得模型不僅能夠記住短期的信息,還能夠在長期序列中維持對關鍵信息的記憶。

通過大膽的想象,研究人員在現(xiàn)實世界與抽象概念間假設起橋梁。隨著TransformerFAM這樣的創(chuàng)新成果繼續(xù)涌現(xiàn)出來,技術的瓶頸會一次次被突破,一個更加智能、互聯(lián)的未來正向我們徐徐地展開畫卷。