谷歌Gemini 1.5技術報告:輕松證明奧數題,Flash版比GPT-4 Turbo快5倍

今年 2 月,谷歌上線了多模態大模型 Gemini1.5,通過工程和基礎設施優化、MoE 架構等策略大幅提升了性能和速度。擁有更長的上下文,更強推理能力,可以更好地處理跨模態內容。

本周五,Google DeepMind 正式發布了 Gemini 1.5 的技術報告,內容覆蓋 Flash 版等最近升級,該文檔長達 153 頁。

技術報告鏈接:https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

在本報告中,谷歌介紹了 Gemini 1.5 系列模型,它是代表了下一代高計算效率的多模態大模型,能夠從數百萬 token 上下文中調用細粒度信息并進行推理,包括多個長文檔、數小時的視頻。

該系列包括兩個新型號:

- 更新的 Gemini 1.5 Pro,其大部分功能和基準都超過了 2 月份的版本

- Gemini 1.5 Flash,一種更輕量級的變體,專為提高效率而設計,并且在性能方面的減益很小。

有關本周谷歌 I/O 大會上提到的 Flash 版,報告中表示,Gemini 1.5 Flash 是一個 Transformer 解碼器模型,具有與 Gemini 1.5 Pro 相同的 2M+ 上下文和多模態功能,旨在高效利用張量處理單元 (TPU),并具有較低的模型服務延遲。例如,Gemini 1.5 Flash 可以并行計算注意力和前饋分量,并且也是擁有更大網絡在線提取能力的 Gemini 1.5 Pro 模型。它使用高階預處理方法進行訓練以提高質量。

報告評估了從 Gemini 1.5 和 Vertex AI 流 API 中獲取的英語、中文、日語和法語查詢的每個輸出字符的平均時間。

英語、中文、日語和法語響應的每個輸出字符的時間(毫秒),在輸入 1 萬個字符的情況下,Gemini 1.5 Flash 在所有測試的語言中實現了最快生成速度。

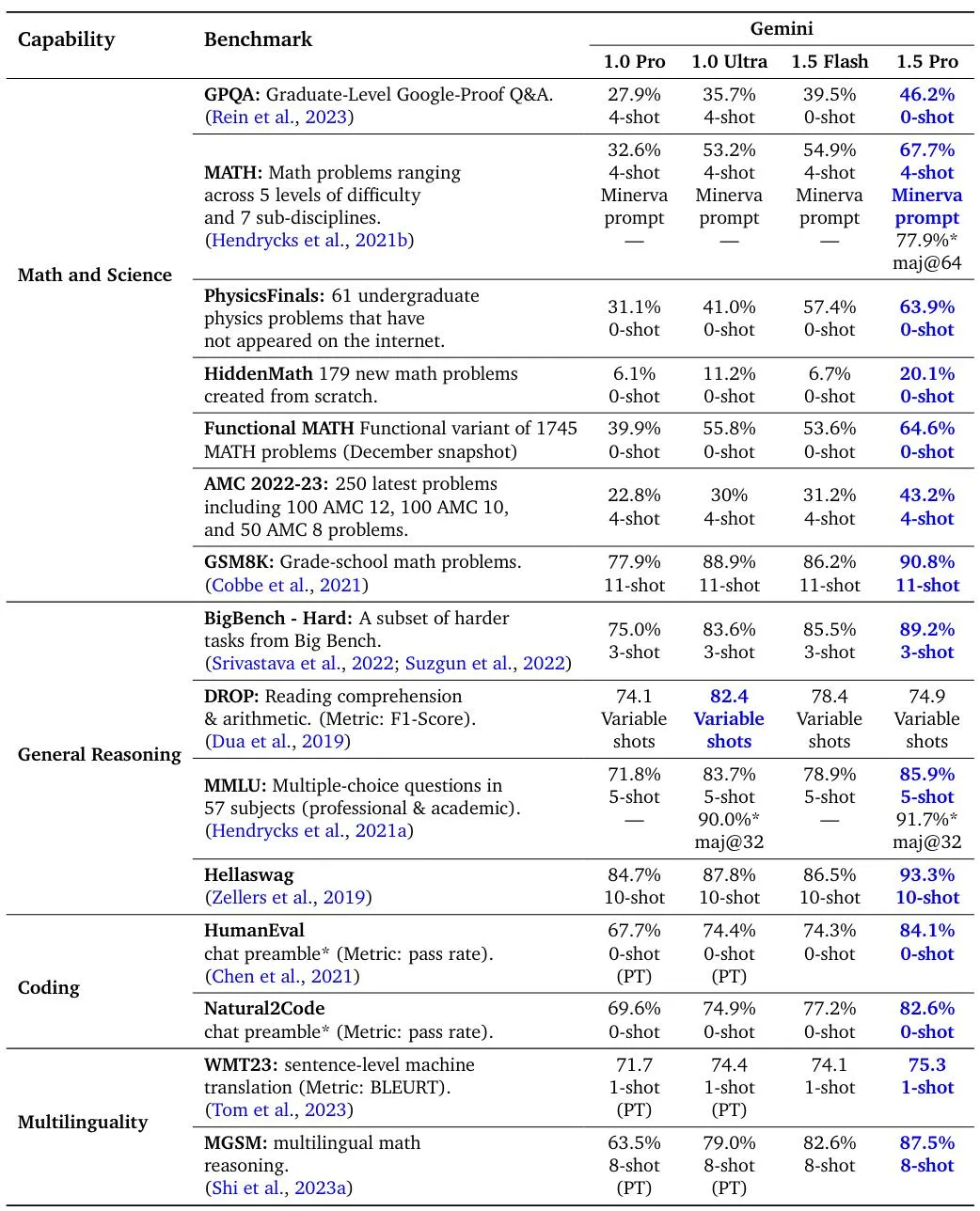

Gemini 1.5 Pro、1.5 Flash 和 Gemini 1.0 模型在標準編碼、多語言以及數學、科學和推理基準上的評估結果。1.5 Pro 和 1.5 Flash 的所有數字都是在指令調整后獲得的。

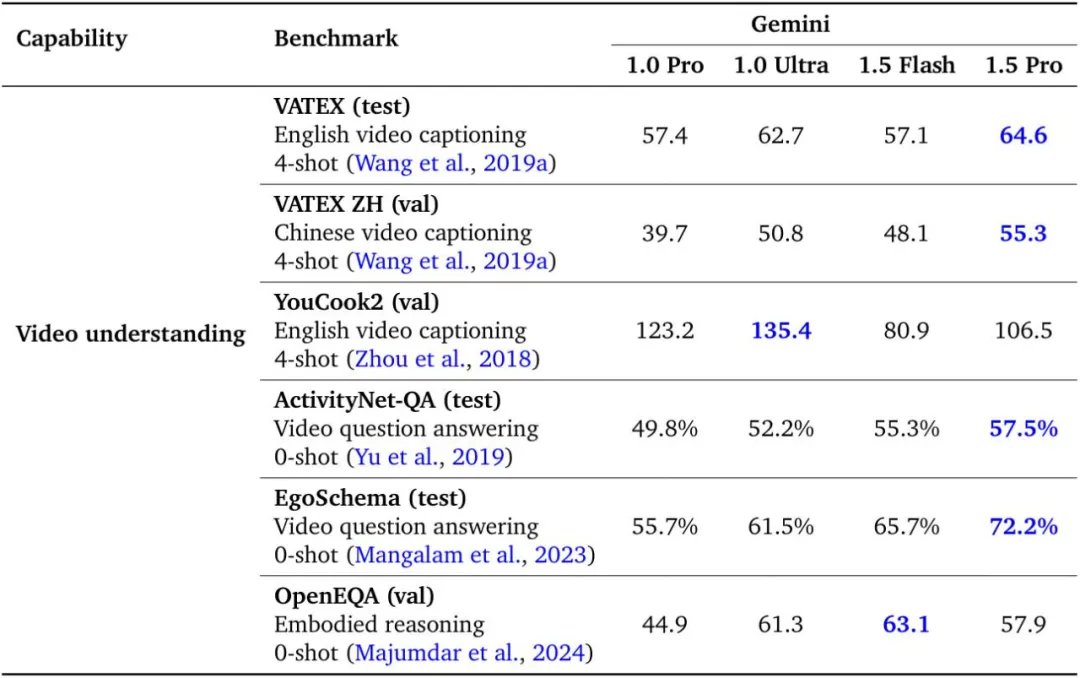

Gemini 1.5 Pro 與 Gemini 1.0 Pro 和 Ultra 在視頻理解基準上的比較。

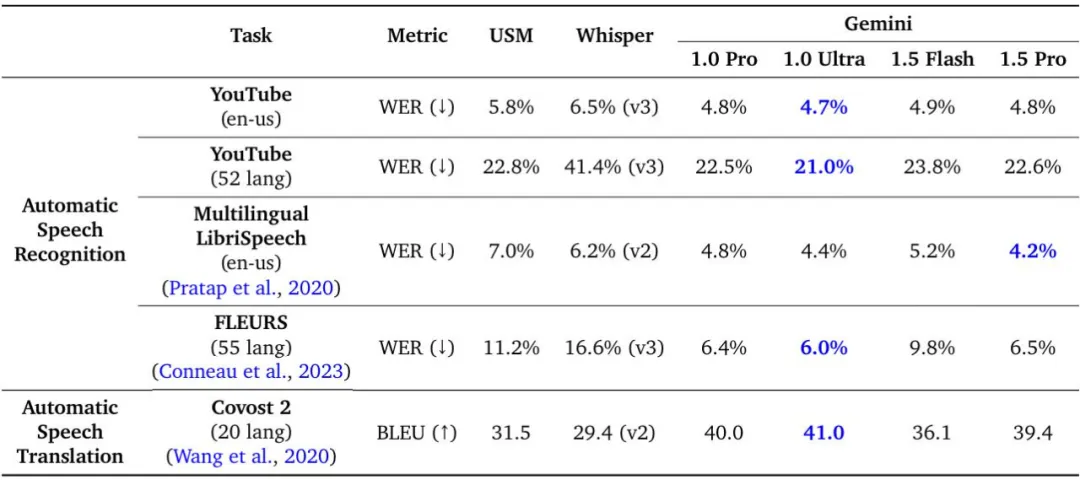

Gemini 1.5 Pro 與 USM、Whisper、Gemini 1.0 Pro 和 Gemini 1.0 Ultra 在音頻理解任務上的比較。

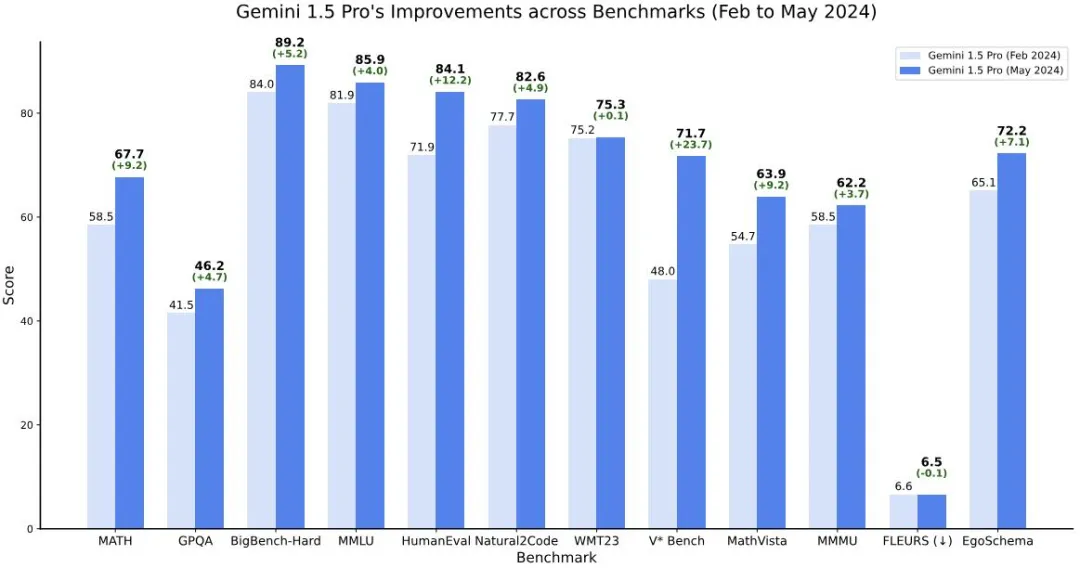

Gemini 1.5 模型在跨模態的長上下文檢索任務上實現了近乎完美的召回,提高了長文檔 QA、長視頻 QA 和長上下文 ASR 的最優水平,并匹配或超越 Gemini 1.0 Ultra 在一系列廣泛的基準測試中表現出最先進的性能。此外,谷歌也表示,到今年 5 月,Gemini 1.5 的性能相比 2 月份已有明顯提升。

Gemini 1.5 Pro(5 月)與初始版本(2 月)在多個基準測試中的比較。最新的 Gemini 1.5 Pro 在所有推理、編碼、視覺和視頻基準測試中進行了改進,而音頻和翻譯性能保持不變。注意,對于 FLEURS,分數越低越好。

Google DeepMind 副總裁,Gemini 項目聯合負責人 Oriol Vinyals 總結道,Gemini 1.5 Pro > 1.0 Ultra、1.5 Flash(目前最快型號) ~= 1.0 Ultra。

通過研究 Gemini 1.5 的長上下文能力的極限,我們可以看到在下一個 token 預測和近乎完美的檢索(>99%)方面持續改進。相比 Claude 3.0 (200k) 和 GPT-4 Turbo (128k) 等現有模型實現了一代的飛躍。

在報告的第七章節,谷歌介紹了 Gemini 1.5 Pro 數學增強版本的跑分,它在競賽級數學問題上表現出色,包括在未使用工具的情況下在 Hendryck 的 MATH 基準測試中取得了 91.1% 的突破級性能。

以下是該模型解決亞太數學奧林匹克(APMO)題目的一些示例,這些問題是此前模型顯然無法解決的。Oriol Vinyals 表示,這個回答相當棒,因為它是一個證明(而不是計算),解決方案切中要害,而且「很漂亮」。

最后,谷歌重點介紹了大模型在現實世界的用例,例如 Gemini 1.5 與專業人士合作完成任務并實現目標,在 10 個不同的工作類別中可節省 26-75% 的時間。

這種前沿大語言模型也展示出了一些令人驚訝的新功能。當給定 Kalamang(一種巴布亞新幾內亞西部不到 200 人使用的語言)的語法手冊時,該模型可以學會將英語翻譯成 Kalamang,與從相同內容中學習的人類處于相似的水平。