原來這才是生成式AI!

隨著ChatGPT、文心一言等AI產品的火爆,生成式AI已經成為了大家茶余飯后熱議的話題。

可是,為什么要在AI前面加上“生成式”這三個字呢?

難道還有別的AI嗎?

且聽文檔君慢慢道來~

1.生成式AI究竟是個啥?

如果將人工智能按照用途進行簡單分類的話,AI其實要被劃分為兩類:決策式AI和生成式AI。

- 決策式AI:專注于分析情況并做出決策。它通過評估多種選項和可能的結果,幫助用戶或系統選擇最佳的行動方案。例如,在自動駕駛車輛中,就是通過決策式AI系統決定何時加速、減速或變換車道。

圖片

圖片

- 生成式AI:專注于創造全新內容。它可以根據學習到的數據自動生成文本、圖像、音樂等內容。例如,你可以將幾篇論文發給生成式AI,他可以生成一篇文獻綜述,囊括了這幾篇論文的關鍵思想、重要結論。

圖片

圖片

看到這里,你就知道為什么ChatGPT、文心一言屬于生成式AI了吧?

接下來,讓我們正式走入生成式AI的世界。

2.生成式AI的前世今生

其實,生成式AI的并不是這幾年剛剛誕生,它實際已經經歷了三個階段:

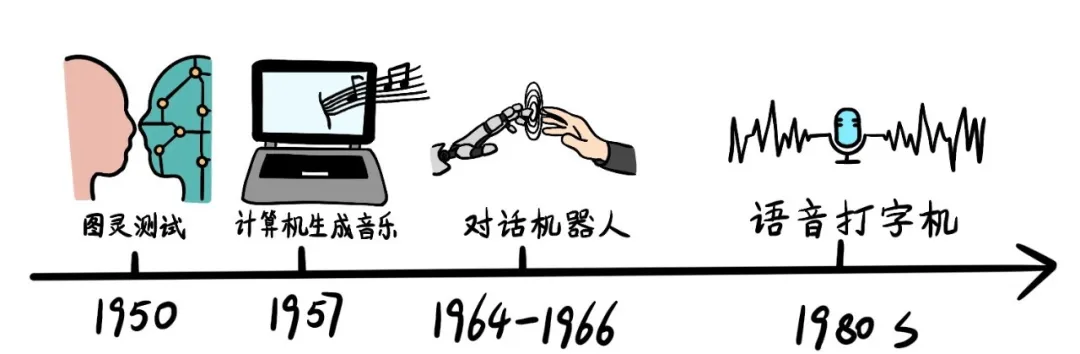

早期萌芽階段

- 1950年,Alan Turing提出了著名的“圖靈測試”,這是生成式AI領域的一個里程碑,預示了AI內容生成的可能性。

- 1957年,Lejaren Hiller和Leonard Isaacson完成了歷史上第一首完全由計算機“作曲”的音樂作品《Illiac Suite》。

- 1964年至1966年間,Joseph Weizenbaum開發了世界上第一款可人機對話的機器人“Eliza”,它通過關鍵字掃描和重組完成交互任務。

- 1980年代,IBM公司基于隱形馬爾科夫鏈模型,創造了語音控制打字機“Tangora”。

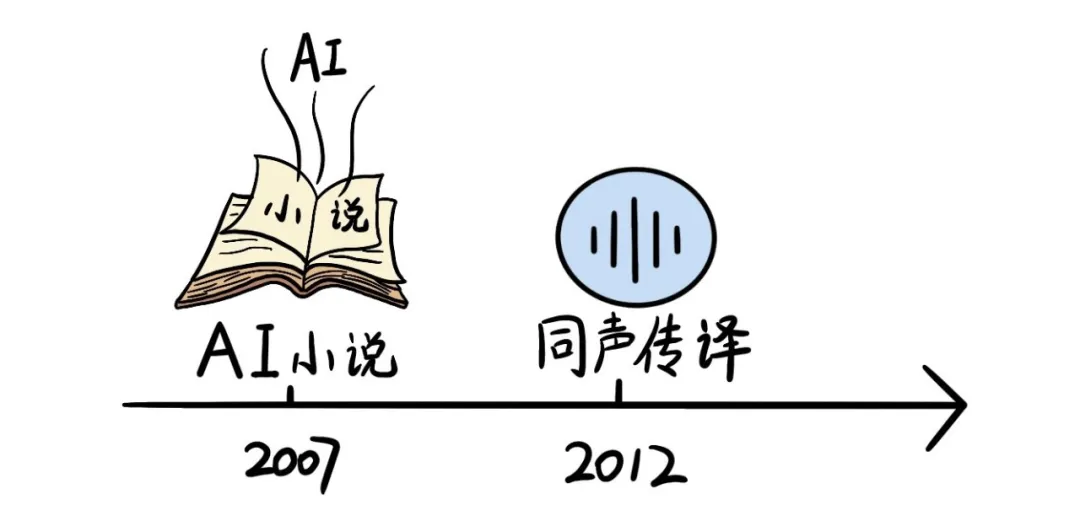

沉淀積累階段

隨著互聯網的發展,數據規模快速膨脹,為人工智能算法提供了海量訓練數據。但是由于硬件基礎有限,此時的發展并不迅猛。

- 2007年,紐約大學人工智能研究員Ross Goodwin的人工智能系統撰寫了小說《1 The Road》,這是世界第一部完全由人工智能創作的小說。

- 2012年,微軟公司公開展示了一個全自動同聲傳譯系統,可以自動將英文演講者的內容通過語音識別、語言翻譯、語音合成等技術生成中文語音。

圖片

圖片

快速發展階段

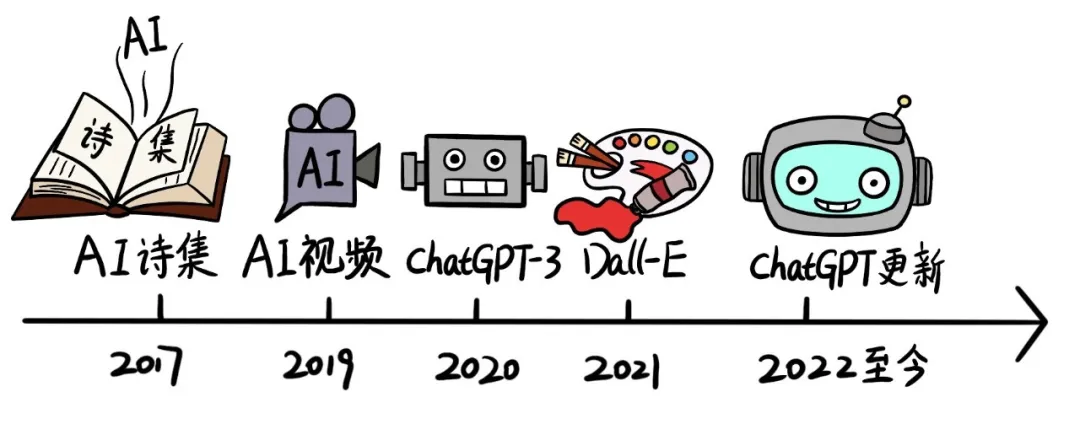

2014年起,大量深度學習方法的提出和迭代更新,標志著生成式AI的新時代。

- 2017年,微軟人工智能少女“小冰”推出了世界首部100%由人工智能創作的詩集《陽光失了玻璃窗》。

- 2019年,谷歌DeepMind團隊發布了DVD-GAN架構用以生成連續視頻。

- 2020年,OpenAI發布ChatGPT3,標志著自然語言處理(NLP)和AIGC領域的一個重要里程碑。

- 2021年,OpenAI推出了DALL-E,主要應用于文本與圖像的交互生成內容。

- 自2022年開始到現在,OpenAI多次發布ChatGPT新型號,掀起了AIGC又一輪的高潮,它能夠理解和生成自然語言,與人類進行復雜的對話。

圖片

圖片

自此,生成式AI已經到了一個井噴式狀態。那么,生成式AI究竟是基于什么樣的原理呢?

3.輕松搞懂“生成式AI”原理

在剛剛的介紹中,大家應該都對生成式AI有了一個表象的認知:學習知識+生成新知識。

但它是如何學習的呢?又是如何生成的呢?

這時候,我們就得來看看生成式AI更深層次的定義了:

定義

以ChatGPT為代表的生成式AI,是對已有的數據和知識進行向量化的歸納,總結出數據的聯合概率。從而在生成內容時,根據用戶需求,結合關聯字詞的概率,生成新的內容。

是不是一下子懵了?

不急,這就觸及到生成式AI的原理了。待文檔君給你慢慢解析。

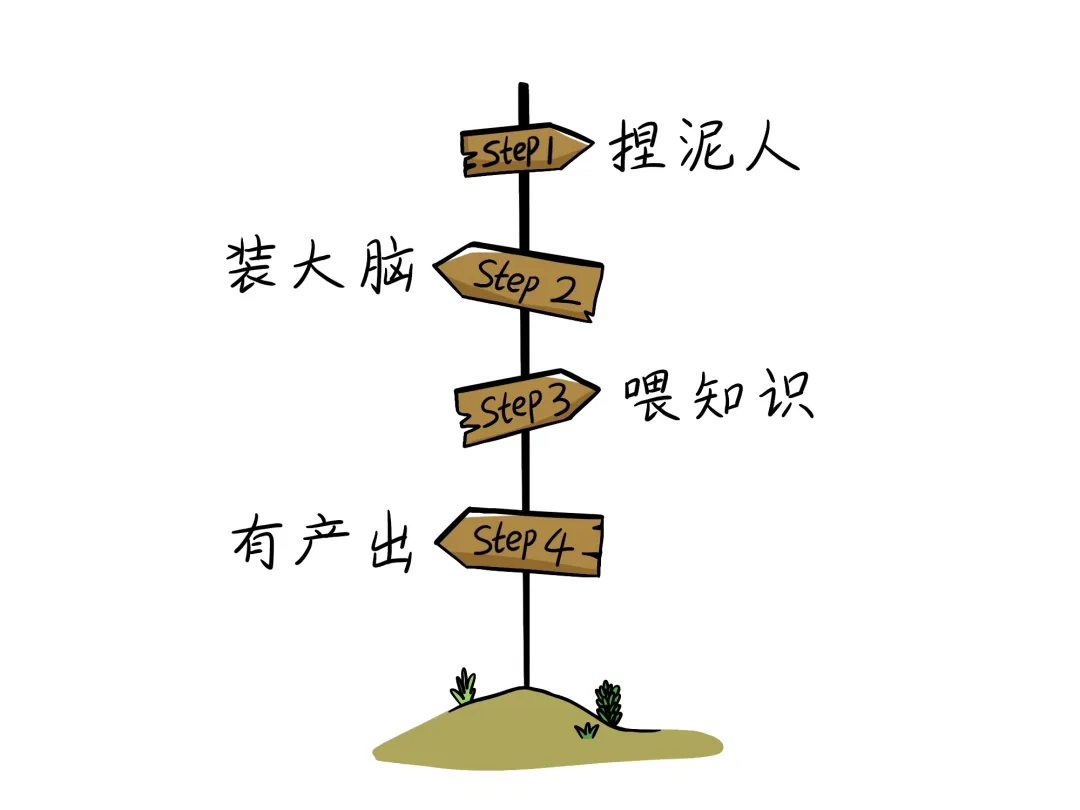

其實制作一個生成式AI,就像把一個泥人變成天才,一共需要四步:捏泥人→裝大腦→喂知識→有產出。

圖片

圖片

Step1:捏泥人——硬件架構的搭建

要打造一個生成式AI的“泥人”,首先要考慮的就是底層硬件。底層硬件構成了生成式AI的算力和存力。

算力——泥人的骨架

生成式AI需要進行大量的計算,尤其是在處理如圖像和視頻時。大規模計算任務離不開下面這些關鍵硬件:

- GPU(圖形處理單元):提供強大的并行計算能力。通過成千上萬個小處理單元并行工作,大幅提高了計算效率。

- TPU(張量處理單元):專門為加速人工智能學習而設計的硬件,能夠顯著加快計算速度,進一步增強了骨架的強度。

存力——泥人的血液

生成式AI需要處理和存儲大量的數據。

以GPT-3為例,光是訓練參數就達到了1750億個,訓練數據達到45TB,每天會產生45億字內容。

這些數據的存放離不開下面這些硬件設施:

- 大容量RAM:在訓練生成式AI模型時,大量的中間計算結果和模型參數需要存儲在內存中,大容量的RAM能夠顯著提高數據處理速度。

- SSD(固態硬盤):大容量的SSD具有高速讀取和寫入能力,可以快速加載和保存數據,使泥人能夠高效地存儲信息。

泥人捏好了,但是現在只能是一個提線木偶,沒有任何能力,所以我們就要給他裝上大腦。

Step2:裝大腦——軟件架構構建

軟件架構是泥人的大腦,它決定了這個泥人將以什么樣的方式對數據進行思考推理。

從仿生學的角度,人類希望AI能夠模仿人腦的運行機制,對知識進行思考推理——這就是通常所說的深度學習。

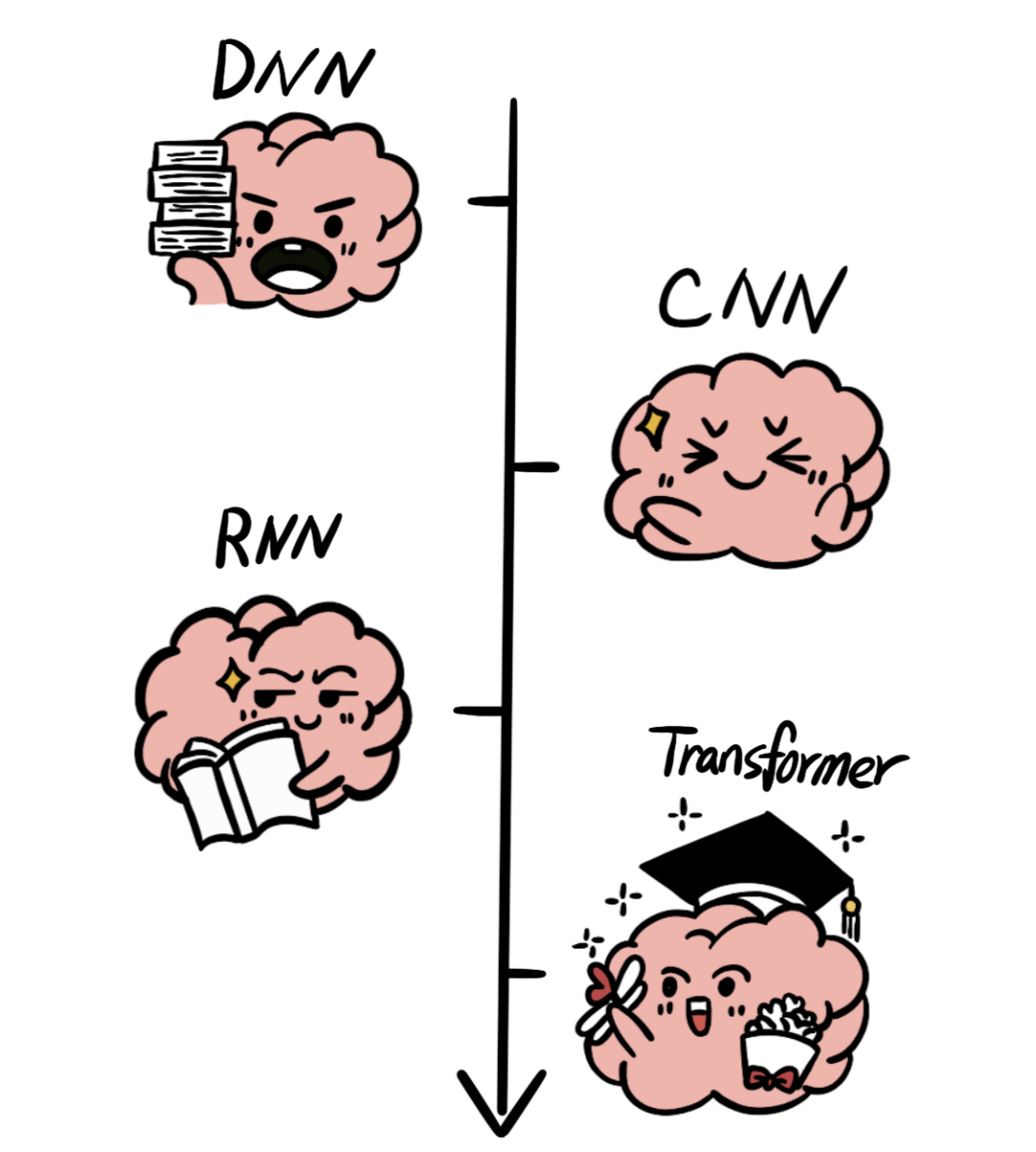

為了實現深度學習,學者們提出了大量的神經網絡架構:

- 深度神經網絡(DNN)是最普遍的神經網絡架構,但是隨著數據對于網路架構的要求越來越復雜,這種方法逐漸有些吃力。

- 卷積神經網絡(CNN)是一種專門為處理圖像數據而設計的神經網絡架構,能夠有效地處理圖像數據,但是需要對輸入數據進行復雜的預處理。

- 隨著任務復雜度的增加,循環神經網絡(RNN)架構成為處理序列數據的常用方法。

- 由于RNN在處理長序列時容易遇到梯度消失和模型退化問題,著名的Transformer算法被提出。

圖片

圖片

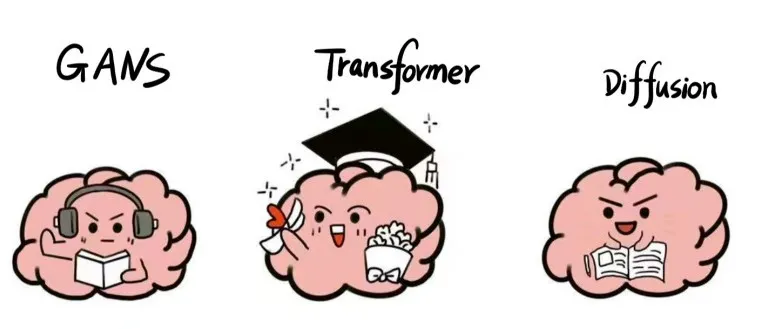

隨著算力的發展,生成式AI的網絡架構發展越來越成熟,也開始各有側重:

- Transformer架構:是目前文本生成領域的主流架構,GPT、llama2等LLM(大語言模型)都是基于Transformer實現了卓越的性能。

- GANs架構:在圖像生成、視頻生成等領域有廣泛應用,能夠生成高質量的圖像和視頻內容。

- Diffusion架構:在圖像生成、音頻生成等領域取得了很好的效果,能夠生成高質量、多樣化的內容。

圖片

圖片

網絡架構搭建好了,腦子是有了,但是腦子里空空如也呀。所以我們通過數據訓練給這個人造大腦喂知識。

Step3:喂知識——數據訓練

目前有兩種訓練方式:預訓練和SFT(有監督微調)

- 預訓練:是指將一個大型、通用的數據集作為知識喂給AI進行初步學習。經過預訓練的模型叫作“基礎模型”,它對每個領域都有所了解,但是無法成為某個領域的專家。

- SFT:SFT是指在預訓練之后,將一個特定任務的數據集喂給AI,進一步訓練模型。例如,在已經預訓練的語言模型基礎上,用專門的醫學文本來微調模型,使其更擅長處理醫學相關的問答或文本生成任務。

但是,無論是預訓練還是SFT,AI的大腦是如何吸收這些知識的呢?

這就涉及到“理解”能力了,我們以Transformer架構為例,講講AI對于文本的理解。

對于AI來說,理解分兩步:理解詞語和理解句子。

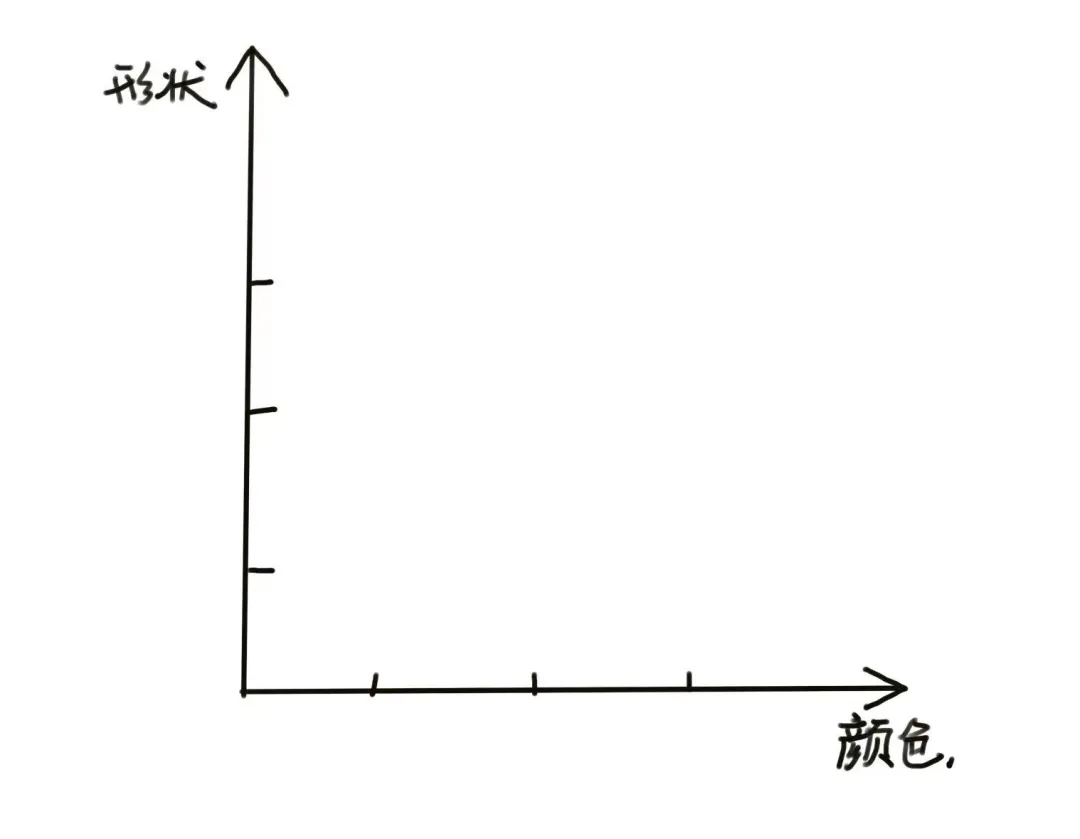

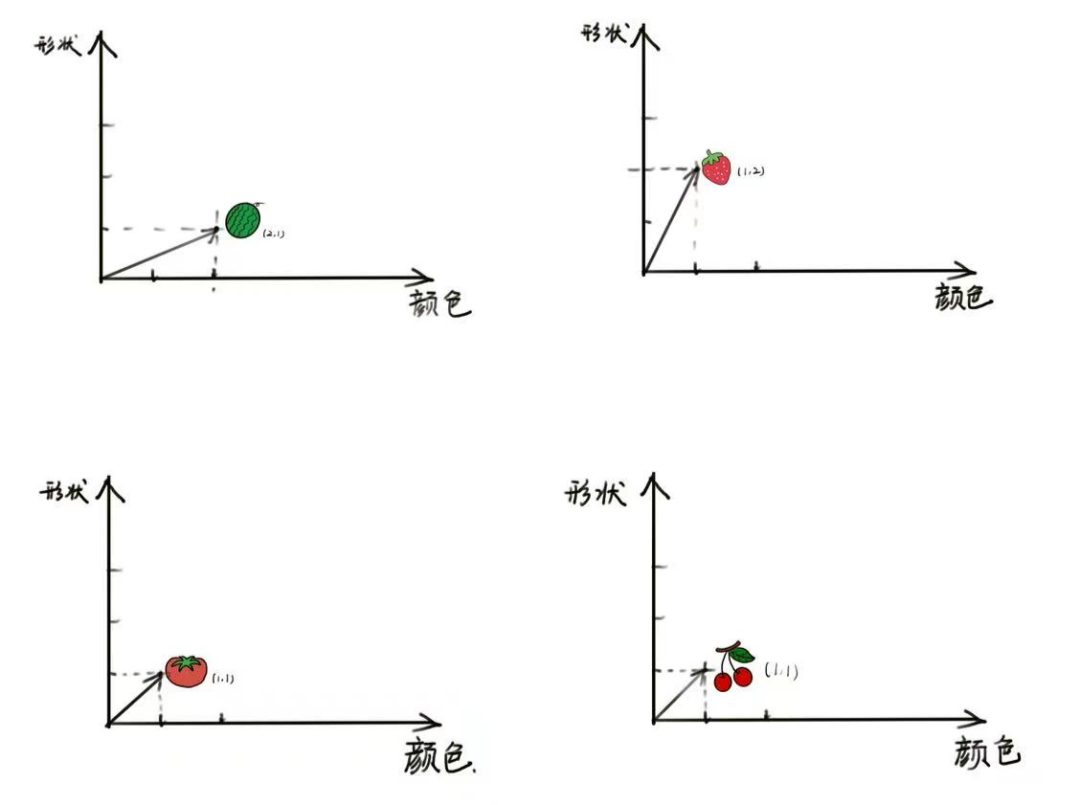

理解詞語的本質就是詞語的歸類。研究人員提出了一種方法:將詞語在不同維度上進行拆解,從而對詞語進行歸類。

假設有四個詞語:西瓜、草莓、番茄和櫻桃。AI在兩個維度上對這些詞語拆解:

- 顏色維度:用1代表紅色,2代表綠色。

- 形狀維度:用1代表圓形,2代表橢圓形。

圖片

圖片

基于這個維度,AI對詞語進行打分歸類。

- 西瓜:顏色=2(綠色),形狀=1(圓形)

- 草莓:顏色=1(紅色),形狀=2(橢圓形)

- 番茄:顏色=1(紅色),形狀=1(圓形)

- 櫻桃:顏色=1(紅色),形狀=1(圓形)

圖片

圖片

通過這些打分,我們可以看到詞語在不同維度上的分類。

例如,“番茄”和“櫻桃”在顏色和形狀維度上都是相同的,說明它們在這兩個維度上的含義相同;“草莓”和“西瓜”在顏色和形狀維度上都有所不同,說明它們在這兩個維度上的含義不同。

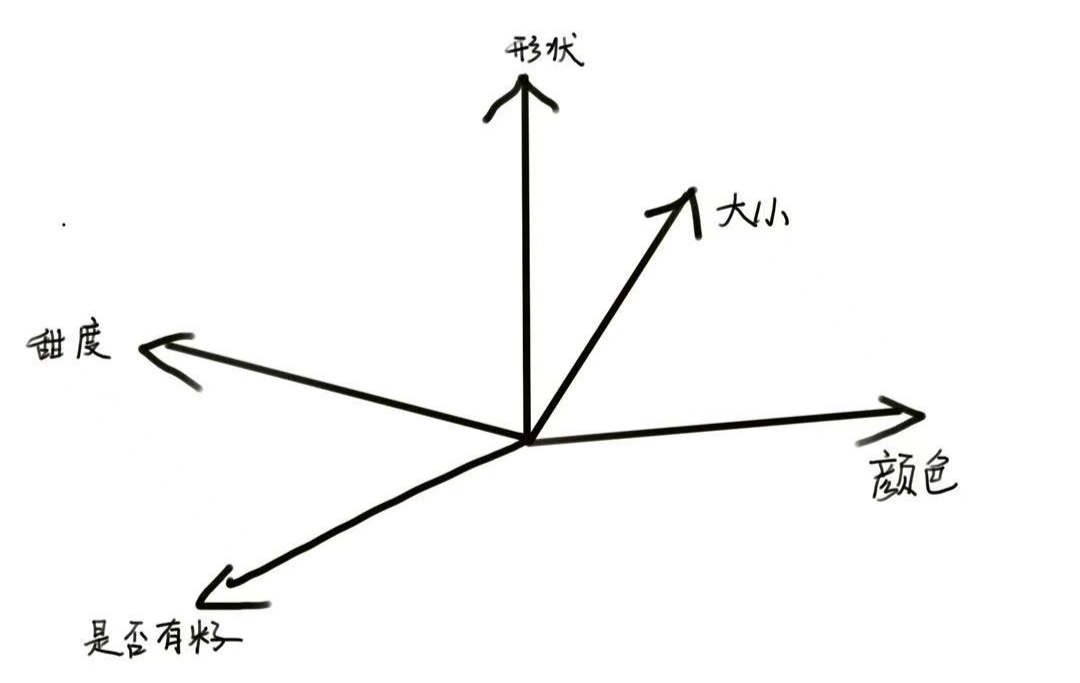

當然,區分他們的維度不僅僅只有兩個,AI還可以從大小、甜度、是否有籽等大量維度對他們進行打分,從而分類。

只要維度足夠多、打分足夠準確,AI模型就可以越精準地理解一個詞語的含義。

圖片

圖片

對于目前較為先進的AI模型來說,通常維度的數量可以達到上千個。

學習詞語并理解為量化的結果只完成了第一步,接下來 AI 就需要進一步理解一組詞語的合集:句子。

我們知道即使同一個詞語在不同語句中,也會具備不同的含義。

例如:

- 這是一頂綠色的帽子。

- 某某公司致力于打造綠色機房。

在不同句子中,“綠色”這個詞含義不同,AI是如何知道他們有不同的含義呢?

這就得益于transformer架構的“自注意力(Self Attention)”機制。

簡單來說,當 AI 理解包含了一組詞語的句子時,除了理解詞語本身,還會“看一看”身邊的詞。單個詞語和句子中其他詞語之間的關聯性,稱之為“注意力”,由于是和同一個句子自身的詞語結合理解,所以稱之為“自注意力”。

因此,在Transformer架構中,可以分為以下兩步:

- 將每個詞語轉換為一個向量。這個向量表示詞語在多維空間中的位置,反映了詞語的各種特征。

- 使用自注意力機制來關注句子中的不同部分。它能夠在處理每個詞語時,同時考慮句子中其他詞語的信息。

Step4:有產出——內容生成

在理解完大量詞語、句子之后,AI就可以生成內容了。它是如何生成內容的呢?

這就是一個概率的問題了。

問大家一個問題:

我在餐廳吃×。

×填個字,你會填什么?

根據你既往的經驗,大概率你會填“飯”。

其實,×還可以是“餅”、“面”、“蛋”等等。

圖片

圖片

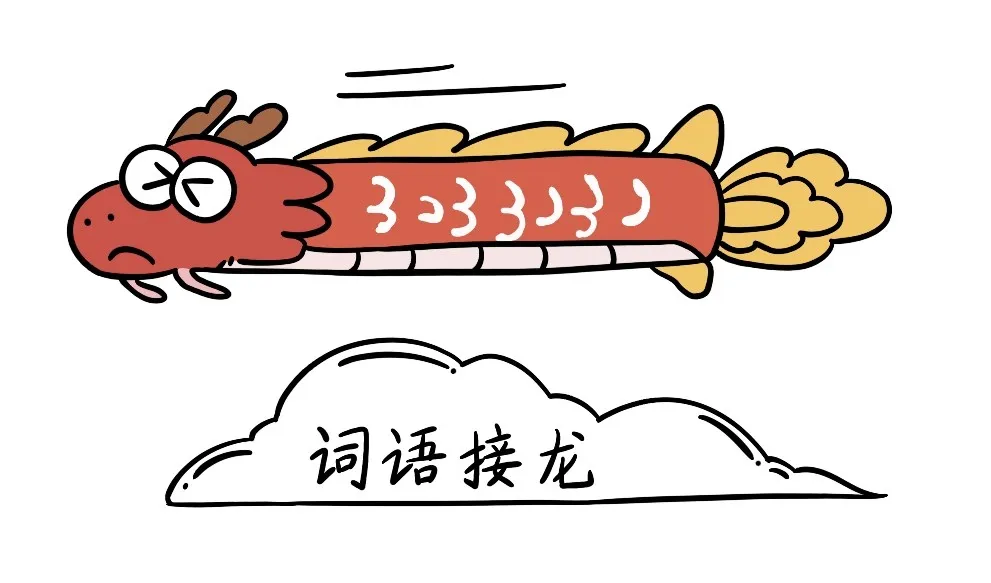

像人一樣,生成式AI也會根據它第三步中學到的經驗,給這些字加上概率。然后選擇概率高的詞作為生成的內容。接著,AI 將重復這一過程,選擇下一個可能性最高的詞語,從而生成更多內容。

但有的時候,我們希望答案是豐富多彩的,回到剛剛那個例子,我們現在不希望AI接的下一個字是“飯”,那要怎么辦呢?

AI提供了一個調節參數,叫溫度,范圍從0到1。

- 在溫度為0時,說明匹配概率要選盡量大的,在以上例子中,AI很可能選擇“飯”;

- 在溫度為1時,說明匹配概率要選盡量小的,在以上例子中,AI很可能選擇“餅”。

數值越接近1,得到的內容越天馬行空。

比如,溫度設為0.8,那么AI生成的句子可能是:

我在餐廳吃餅,這個餅又大又圓,我想把它套在脖子上......

但是,我們看到大多數AI產品,只有一個對話框,如何修改溫度參數呢?

答案是“提示詞”,也就是我們通常所說的prompt。

- 如果你輸入是“你是一名某某領域的專家,請用嚴謹的口吻寫一篇關于xx的文獻綜述。”這時AI的溫度接近0,就會選擇匹配概率盡量高的詞語生成句子。

- 如果你輸入是“請你請暢想一下xx的未來。”這時AI的溫度接近1,就會選擇匹配概率盡量低的詞語組成句子,生成意想不到的內容。

現在知道prompt的重要性了吧!

所以,我們可以認為,AI生成的本質就是一場詞語接龍:AI根據當前字,聯系它之前記錄的下個字的出現概率以及你的期望,選擇接下來的字。

圖片

圖片

當然,生成式AI的內部原理遠比小編講的要復雜,小編這里只能算一個基礎的科普。

3.“生成式AI”去向何方?

那么生成式AI真的會實現通用人工智能,從而替代人類嘛?目前,有兩種看法:

- 積極派:以OpenAI的CEO Altman、英偉達CEO黃仁勛為首的積極派,非常看好生成式AI的未來,他們曾表示“再過幾年,人工智能將會比現在更加強大和成熟;而再過十年,它定將大放異彩“,“AI可能在5年內超越人類智能”。

- 消極派:以深度學習先驅楊立昆為首的消極派,一直認為生成式AI無法通向用人工智能。他在多個場合表示“像ChatGPT這樣的大型語言模型將永遠無法達到人類的智能水平”,“人類訓練的人工智能,難以超越人類”。

那么對于我們普通人來說,我們要怎么對待生成式AI呢?

文檔君覺得,我們普通人不妨就把它當做一個工具,學會使用它,提高我們的工作效率,豐富我們的日常生活, 保持對世界的好奇心,充分享受科技帶來的便利就好啦!

你還想知道關于AI的什么知識?