奧特曼百萬年薪挖角谷歌TPU人才,欲砸7萬億實現(xiàn)「芯片自由」?OpenAI自研芯片最新進展曝光

OpenAI在芯片方面的野心傳聞已久。

目睹了近年來PC和AI行業(yè)兩次重大的半導體供應危機之后,Sam Altman似乎認為臺積電、三星代工和英特爾代工這些傳統(tǒng)的芯片制造商沒有足夠的產(chǎn)能,不能滿足全球對AI芯片迅猛增長的需求。

不僅僅是OpenAI的算力需要減少對英偉達芯片的依賴,奧特曼甚至還希望建造更多的晶圓廠,可以穩(wěn)定供給其他公司。

根據(jù)華爾街日報的報道,今年2月,奧特曼會見軟銀CEO和臺積電的談判代表,討論合資事宜,計劃在未來幾年內(nèi)共同建造和運營數(shù)十座芯片制造工廠。

TSMC在亞利桑那州的在建工廠

然而,造芯片要燒的錢相比訓練大模型,只會多不會少。

根據(jù)奧特曼本人的估計,要建造新的半導體制造設備和相關基礎設施,成本可能高達5-7萬億美元。

由于傳統(tǒng)的私人風投很難一下子拿出這么多資金,奧特曼曾經(jīng)找到美國商務部長討論,甚至遠赴新加坡和阿聯(lián)酋會見當?shù)毓賳T,想尋求國有資本的支持。

經(jīng)過了半年多的籌備和發(fā)酵,OpenAI的芯片事業(yè)似乎真的要起步了!

芯片人才大戰(zhàn),谷歌 vs. OpenAI

據(jù)SemiAnalysis的最新報道,OpenAI最近開始大規(guī)模招募,計劃將只有幾個人的芯片團隊擴展到幾十個人。

而且,他們延續(xù)了招聘人才的一貫策略——挖角谷歌。

新近招募的幾乎所有研究人員,都是現(xiàn)任或前任的谷歌TPU團隊成員。

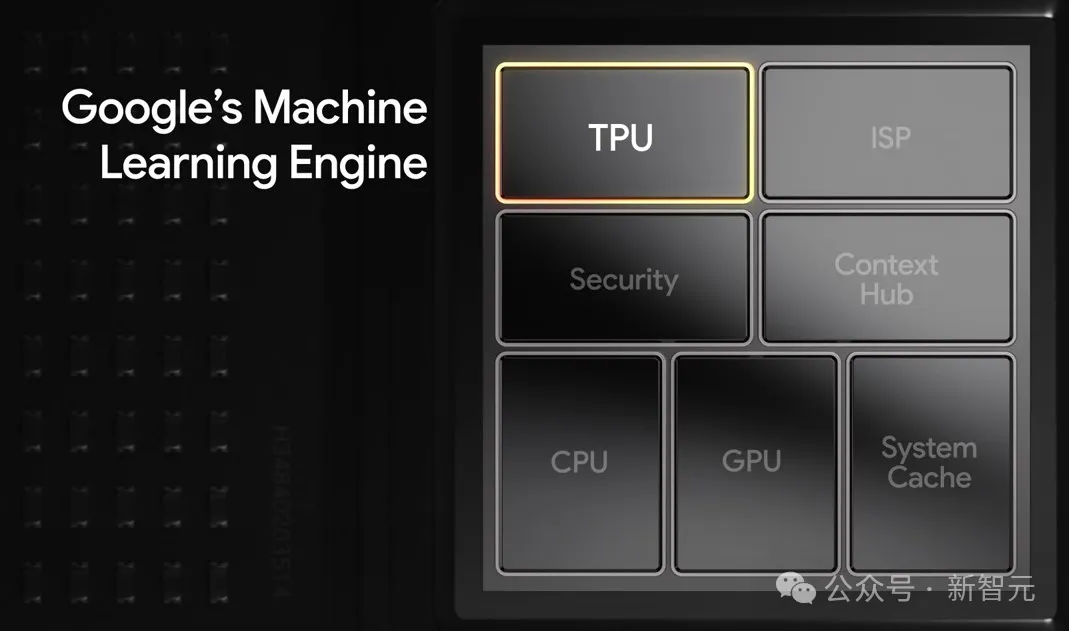

不同于最初為圖形處理和實時渲染設計的GPU,TPU是谷歌從頭設計的,專門用于加速機器學習和神經(jīng)網(wǎng)絡的計算,能夠更出色地解決張量運算問題。

GPU以ALU(高級算術邏輯單元)作為核心組件,而TPU的核心是矩陣乘法器單元(MXU),能夠以很高的吞吐量執(zhí)行矩陣乘法和累加。

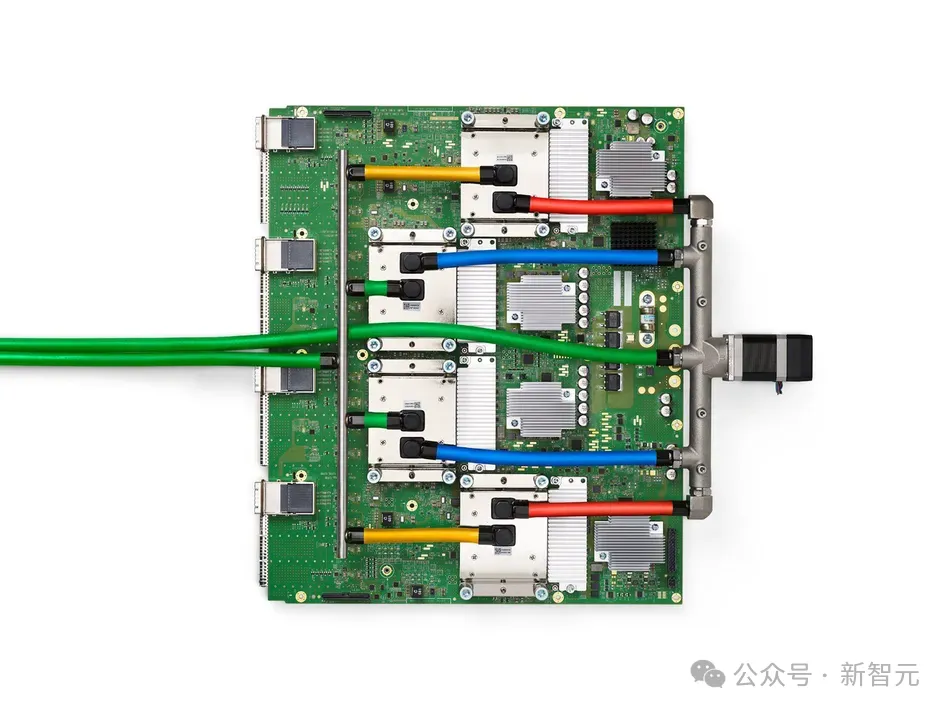

谷歌TPUv4

雖然TPU的任務通用性不如GPU,尤其是沒有CUDA這樣的編程接口,但在運算性能和能源效率方面表現(xiàn)出色,尤其是那些經(jīng)過谷歌團隊特別優(yōu)化的任務。

因此可以說,TPU是世界上性能/TCO(總體擁有成本)最優(yōu)的機器學習基礎設施。

雖然谷歌的TPU已經(jīng)有如此高的成就,但是OpenAI芯片團隊的工作機會依舊有多方面的吸引力。

首先是大公司和創(chuàng)業(yè)公司在發(fā)展速度上的本質差異。

TPU首次發(fā)布是在2013年,到今年5月最新推出的TPUv6,團隊已經(jīng)有了十多年開發(fā)經(jīng)驗。珠玉在前,系統(tǒng)設計和微架構很難有較大變動,更多的是迭代性、漸進式的改進。

加入OpenAI則不同,在從頭開始設計、開發(fā)的過程中,成員們有機會嘗試更創(chuàng)新、更激進的方法。

而且OpenAI一向雄心勃勃,他們的目標是構建由數(shù)百萬個加速器組成的系統(tǒng),這比GPT-4的訓練還要大好幾個數(shù)量級。

此外,團隊合作模式也有很大的區(qū)別。

在尾大不掉的谷歌,雖然TPU團隊也會和DeepMind合作,但依舊會遇到不少非技術方面的障礙。

相比之下,OpenAI內(nèi)部的芯片和模型團隊之間,交流與合作會更為緊密順暢。

除了這些,當然也有薪酬的差異。

實際上,Google TPU團隊已經(jīng)是半導體設計領域中薪酬最高的團隊之一,工程師的平均收入遠高于AMD、英特爾、高通等大多數(shù)半導體公司,能和行業(yè)龍頭英偉達比肩。

OpenAI的基本工資雖然沒那么豐厚,但作為未上市的創(chuàng)業(yè)團隊,每年向高級工程師提供的價值數(shù)百萬美元的股權更加誘人。

有了這幾重因素的疊加,再加上CEO奧特曼本人親自參與了大部分的招聘工作,OpenAI招募到的人才質量令人驚嘆。

GPT-4o和Sora模型發(fā)布時,團隊成員背景、能力之強悍總能驚艷到網(wǎng)友。

GPT-4o 17人Omni金牌團隊首揭秘!清北上交中科大6位華人領銜

SemiAnalysis的記者向同行打聽這些被挖角的TPU人才時,總能得到這樣的回答,「他們是我合作過的最好的工程師之一」。

OpenAI之所以瞄準谷歌的TPU團隊,既是希望得到最先進的技術和人才,也同樣有商業(yè)競爭上的考量。

在硅谷的眾多科技巨頭中,只有谷歌研發(fā)的TPU能成功替代英偉達的芯片,并部署在公司內(nèi)部的云服務中。

Meta、亞馬遜和微軟等公司雖然也在自研芯片方面做了很多努力,但依舊嚴重依賴英偉達。

在未來相當長的時間內(nèi),AMD和英偉達等半導體公司將依舊是OpenAI的合作伙伴,因此輕易得罪不起。

只有面對天生的死對頭——谷歌,OpenAI才敢如此肆無忌憚地挖角。(連發(fā)布會都要搶在谷歌I/O大會前一天開)

雖然已經(jīng)獲得了如此強大的人才團隊,但是芯片研發(fā)依舊需要付出巨大的努力。

預計要到2027年底,OpenAI才能推出第一代自研芯片。在那之前,他們依舊會完全依賴商用芯片。

與微軟關系逐漸微妙

OpenAI自研芯片的決策有些讓人摸不到頭腦。背靠微軟的資金和Azure云服務的強大算力,為什么要燒錢自研芯片?

實際上,OpenAI的與微軟之間的關系已經(jīng)愈發(fā)緊張,因為對于微軟而言,OpenAI是一家結構非常怪異的公司。

目前,它本質上依舊是一家完全獨立的非營利組織,由OpenAI Nonprofit管理。微軟作為無投票權的董事會觀察員,幾乎無法控制OpenAI的發(fā)展走向。

如果因為AGI安全問題,OpenAI董事會要求中止協(xié)議、收回模型的使用權,微軟就只能乖乖聽命,毫無還手之力。

AGI從所有的商業(yè)和知識產(chǎn)權許可協(xié)議中分割開來。

董事會決定我們何時實現(xiàn)AGI。再次強調(diào),AGI指的是一種高度自治的系統(tǒng),在最具經(jīng)濟價值的工作中優(yōu)于人類表現(xiàn)。此類系統(tǒng)不包括在與微軟簽訂的IP許可和其他商業(yè)條款中,這些條款僅適用于AGI之前的技術。

因此,兩方面都在施行自己的「脫鉤」計劃。

OpenAI需要在芯片和算力方面逐漸獨立,微軟在試圖減少對OpenAI模型的依賴。

比如微軟近期投資Inflection AI,以及自行組建團隊開發(fā)Phi-3、MAI-1等模型,都是出于這方面的考量。

目前,許多企業(yè)用戶通過Azure使用OpenAI的技術,包括超過65%的《財富》500強公司。

微軟希望擁有自研的GPT-4級別LLM,以及滿足不同用戶需求的一系列模型,以便在Azure的推理服務中替換掉OpenAI。

對于OpenAI來說,想要在算力方面自給自足,購買英偉達芯片的成本過高,并不是最好的選擇。因此,自研芯片似乎是唯一出路。

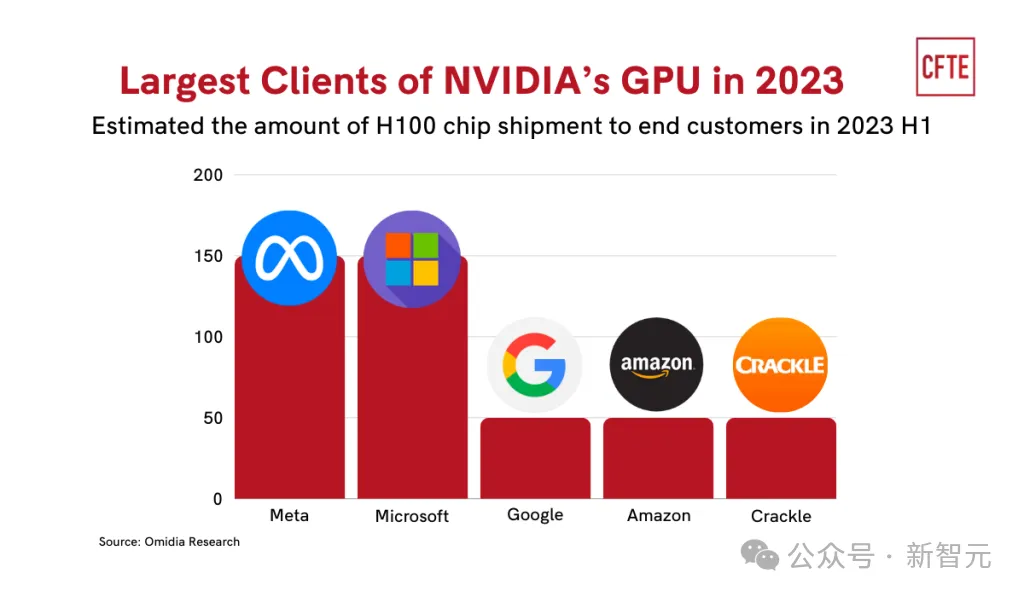

實際上,不僅僅是OpenAI,Meta、微軟、谷歌和亞馬遜等公司也都在大力投資,開發(fā)自己的AI加速器。

這些AI巨頭一邊是英偉達最大的客戶,一邊也成為最有力的競爭對手。

畢竟,在模型訓練的過程中,算力已經(jīng)幾乎成為占比最大的支出。如果能將購置芯片的資金轉變?yōu)閮?nèi)部投入,以制造成本部署GPU或TPU,模型的成本也將大幅下降。