降低AIGC應用門檻,網宿科技推出一站式邊緣智能解決方案

以AIGC(生成式人工智能)和大模型為代表的新一代智能技術在全球引發了新一輪創新熱潮。在大模型競相涌現的背景下,如何讓AIGC更加便捷、廣泛地應用到垂直場景,成為業界重點關注的方向。

日前,在全球邊緣計算大會上,網宿科技宣布已經推出了面向AIGC的一站式邊緣智能解決方案,從Serverless GPU、AI網關、模型微調與推理服務三個層面,大大降低AIGC應用的落地門檻,旨在幫助用戶以低成本、高效率的方式輕松實現AI應用創新。

網宿科技邊緣智能平臺資深架構師陳云輝

網宿科技邊緣智能平臺資深架構師陳云輝

網宿科技邊緣智能平臺資深架構師陳云輝在會上指出,盡管國內基礎大模型百花齊放,為用戶提供了豐富的模型選擇,但用戶在實際落地中仍面臨較高門檻。

具體而言,從0開始實現AI應用落地的過程中,企業用戶必須綜合考慮多個關鍵因素,包括對比開源模型和云服務商的推理成本與性能評估,重視系統的安全性、敏感詞過濾等,特別是在與現有業務的改造整合中,更是問題多多。對于對數據隱私和模型控制有嚴格要求的應用場景,還需考慮針對特定垂直場景的私有模型微調。這些都使得整個實施周期漫長且成本高昂。

邊緣計算擁有高效的數據處理能力、實時的響應速度、更低的帶寬要求等優勢,可以在AIGC應用過程中發揮關鍵價值。業界的普遍共識也是,未來AI模型的推理與內容生產將呈云側、邊緣側、端側的梯度分布。

網宿科技憑借在邊緣計算領域的深厚積累,近年來對AIGC展開了持續探索,逐步形成了涵蓋Serverless GPU、AI網關、模型微調與推理服務的一站式邊緣智能解決方案。

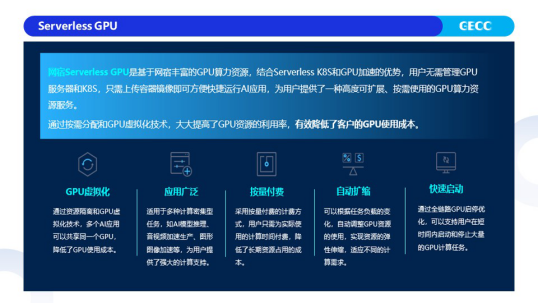

據介紹,網宿Serverless GPU為用戶提供高度可擴展、按需使用的GPU算力資源服務,主要適用于多種計算密集型任務,如AI模型推理、音視頻加速生產、圖形加速等。基于網宿豐富的GPU算力資源,結合Serverless K8S和GPU加速的優勢,用戶無需管理GPU服務器和K8S,只需上傳容器鏡像即可方便快捷運行AI應用。“Serverless GPU除了擁有免運維的特性外,相較集中部署,由于GPU資源是放在邊緣側,離用戶更近,更貼近業務邊緣,具有低時延優勢。并且,通過按需分配和GPU虛擬化技術,大大提高GPU資源的利用率,可以有效降低用戶的GPU使用成本。”陳云輝表示。

網宿AI網關則是一款針對大語言模型的統一API接口,可以用在應用程序和托管的大語言模型(LLM)之間,允許通過一個統一的API接口將API請求轉發給各個云廠商以及自有部署的大模型。網宿AI網關可以用于個人開發者和企業級AI應用,幫助管理和整合多個后端大模型接口,提高AI應用的穩定性和可靠性,并降低后端模型的調用成本。

此外,對數據隱私、模型可控性有強要求的企業往往選擇部署自有開源模型,對此,網宿邊緣模型訓練推理平臺可以提供最經濟可靠的模型推理服務。

網宿邊緣模型訓練推理平臺不僅為用戶提供一個全球性的邊緣推理運行環境,還提供模型微調環境、配備所需的GPU資源和完整的工具鏈,并支持將微調好的模型一鍵部署到網宿全球的邊緣節點上。通過不斷優化的推理性能,邊緣模型訓練推理平臺可以支撐用戶高效地訓練、推理和使用大模型。

會上,陳云輝還談及了AIGC的發展,其判斷,大模型未來會演變成基礎設施,就像現在的操作系統、大數據平臺一樣,雖然用戶感知不明顯,但為各種應用提供基礎性和通用性的支持。與此同時,開源能力也會越來越強。

值得一提的是,除了上述三大產品,網宿科技還在積極探索AIGC工作流引擎和AI營銷創意平臺兩個新方向,以進一步豐富自身的邊緣智能方案能力。

其中,AIGC工作流引擎旨在幫助用戶更高效地管理和執行AI應用的工作流程,通過將當前復雜的業務流程分解成單個小任務,降低單一任務的復雜度,既可以減少對提示詞以及大模型推理能力的依賴,還能提升大模型處理復雜任務的性能和容錯能力,同時,在大模型性能不足的環節,AI工作流引擎還可以使用傳統的處理方法。基于工作流引擎搭建的AI應用開發平臺,能有效結合AIGC與傳統方式,更好實現AI應用的落地。而AI營銷創意平臺則面向最終用戶提供開箱即用的AI產品,旨在為用戶的營銷工作賦能。

“未來,我們希望能持續為客戶提供更低成本模型推理、更高質量內容生成的邊緣智能解決方案。”陳云輝表示。