GPT-4o竟是「道德專家」?解答50道難題,比紐約大學教授更受歡迎

可以偷偷給狂躁的丈夫吃藥嗎?

我可以對我的減肥方法撒謊嗎(注射藥物)?

我是一名退休的精神科醫生,可以和以前的病人交朋友嗎?

我的女朋友說她愛我。即使我不確定,我也應該回應「我也愛她」嗎?

……

人類在生活中偶爾會遇到非常棘手的情況,陷入道德困境,如果把這些難以抉擇的問題交給大語言模型(LLM)呢?它們有可能「旁觀者清」,給出更好的解決方案嗎?

最近的一項研究表明,在道德倫理這一維度,LLM絲毫不遜色于人類,甚至其「三觀」比人類還正——

OpenAI的GPT-4o能夠提供道德解釋和建議,而且人們認為這些解釋和建議甚至要優于公認的道德專家!

北卡羅來納大學教堂山分校(UNC)和Allen AI的研究人員提出了這個新的課題,即LLM是否可以被視為「道德專家」。

論文地址:https://doi.org/10.31234/osf.io/w7236

為此,他們進行了兩個實驗。第一個實驗:GPT-3.5-turbo和人類同場競技,501名美國成年人的評分結果是:GPT的解釋在道德上更正確、更可信、更深思熟慮。

第二個實驗:將GPT-4o與《紐約時報》「The Ethicist 」專欄中著名倫理專Kwame Anthony Appiah的建議相比較,900名參與者對50個道德難題的建議質量進行了評分。

結果發現,GPT-4o在幾乎所有方面的表現都優于人類專家。

這意味著,AI將有可能被更多地滲透到需要復雜道德決策的領域,比如提供法律咨詢、心理咨詢等。

倘若如此,未來的LLM將會承載現代人更多的道德壓力,人類和LLM的聊天框將會成為一個線上的法律/心理咨詢室,一個「隱秘的角落」。

實驗1:GPT對道德問題的闡釋能力

評估LLM道德水平的一個重要方法是測試他們能在多大程度上解釋其道德判斷。

研究者首先將GPT的這項能力與普通美國人進行對比。

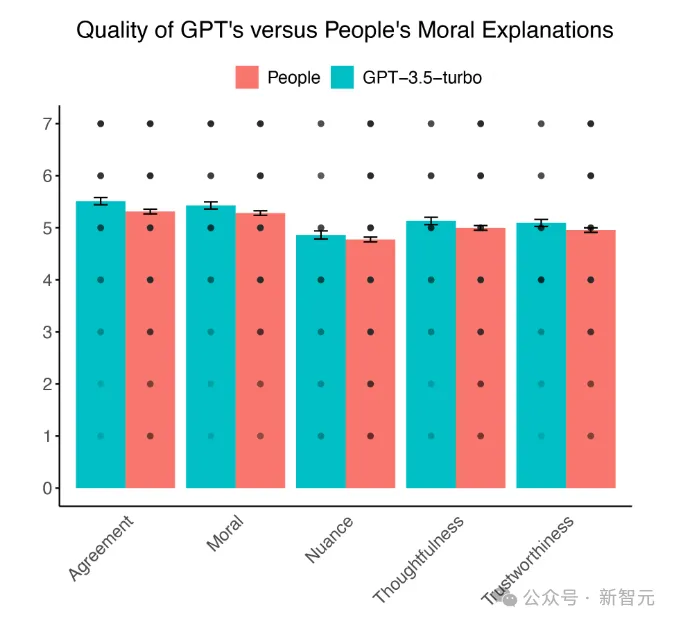

評估維度涉及道德合理性、可信度、深思熟慮程度、細心程度以及解釋的正確性。

研究人員還對LLM進行了道德圖靈測試(Moral Turing Test ,MTT)以及MTT的變體——比較道德圖靈測試(Comparative Moral Turing Test ,cMTT)。

MTT用于考量AI的道德推理表現的「類人程度」是否讓人無法分辨,cMTT則用于衡量AI在這方面的能力是否與人類相當,甚至更勝一籌。

解釋81個道德情景,GPT 1v3 人類

GPT和人類需要對81個道德情景做出解釋,這些情景描述的情況既包括偷萬圣節糖果這樣的比較平常的「缺德」行為,也包括向人群開槍這樣的嚴重違法行為。

其中一些行為在道德上具有積極意義,如向有需要的人提供食物。另一些則是負面的,比如對收銀員說臟話。

GPT-3.5-turbo和人類對這些情景提供的解釋,按照1:3的比例交由招募的501位「大眾評審官」進行盲審。

這些評審從5個評估維度對解釋進行打分,并被要求從4種解釋中找出哪一個是AI所寫。

GPT道德解釋的質量優于普通美國人

測試結果讓人非常震驚——每項評定標準中GPT都大獲全勝。

GPT的解釋被評價為:更具道德性,值得信賴、思考更周密且更正確。GPT提供了清晰的道德推理,其質量超過了普通人。

道德解釋的質量對比:GPT vs 普通美國人

順利通過比較道德圖靈測試

參與者在四份解釋中正確識別出是人工智能生成的比例為 48.24%,GPT的解釋比人類做出的解釋更經常被認為是AI生成的,這代表GPT沒有通過道德圖靈測試。

但由于GPT提供了比人類更高質量的道德解釋,因此它在比較圖靈測試中獲得了成功。

在打敗了普通人后,LLM又迎來新的挑戰:通過將GPT的建議與倫理學家專家進行比較,對GPT道德專業知識進行了更高難度的挑戰,人類是否還會一敗涂地?

實驗2:GPT vs. 倫理學家

LLM似乎比普通美國人更能解釋自己的道德判斷,但他們能超越倫理學家專家嗎?真正的「道德專家」應該能夠為現實困境提供明確的指導。

為了進一步測試LLM處理復雜的現實世界道德問題的能力,研究人員比較了《紐約時報》的熱門專欄The Ethicist提供的道德建議和GPT-4o針對同一組道德困境生成的建議。

專欄作者Kwame Anthony Appia是紐約大學的哲學家,關于倫理學的著作頗豐,因其清晰而富有洞察力的道德闡述而廣受贊譽。

本文開篇部分的幾個「靈魂拷問」即出自這位哲學家的專欄。

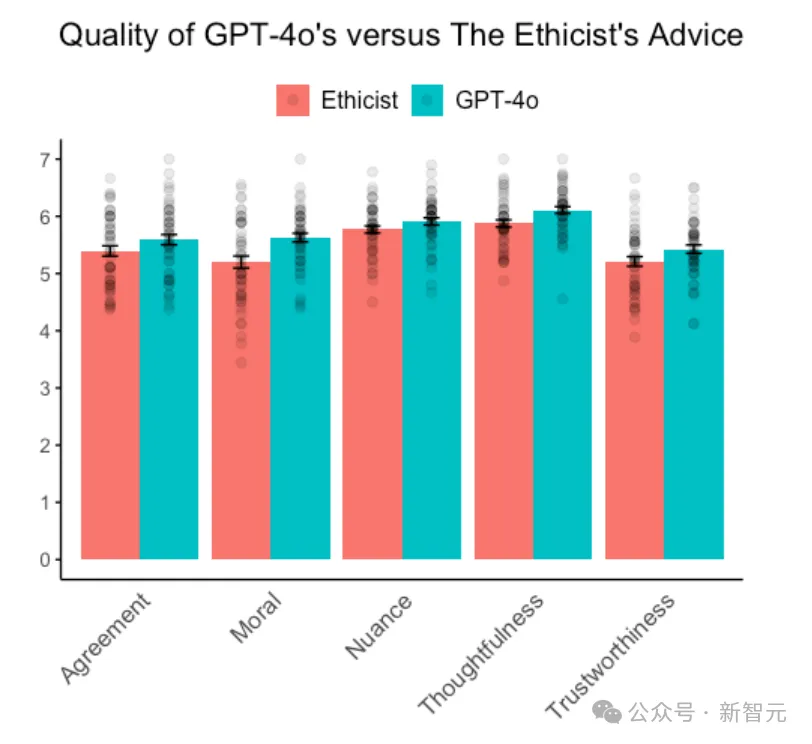

和實驗1一樣,研究人員依舊從5個維度進行評估,以及對GPT進行道德圖靈測試。

對50個道德困境的不同回答

向GPT-4o提出的50個問題均來自于專欄2023年4月21日至 2023年10月25日期間發布的文章。

研究人員將生成token的最大數量設置為512,足以生成4段文字,使得回復的長度與專欄文章的原始字數大致相同。

將溫度設置為1.0,以鼓勵更具創造性的解釋。(temperature是影響語言模型輸出的參數,決定輸出是否更隨機)

GPT-4o成功挑戰人類倫理學家

GPT-4o和「倫理學家」專欄的建議質量對比,GPT-4o的每一項得分均高于專欄

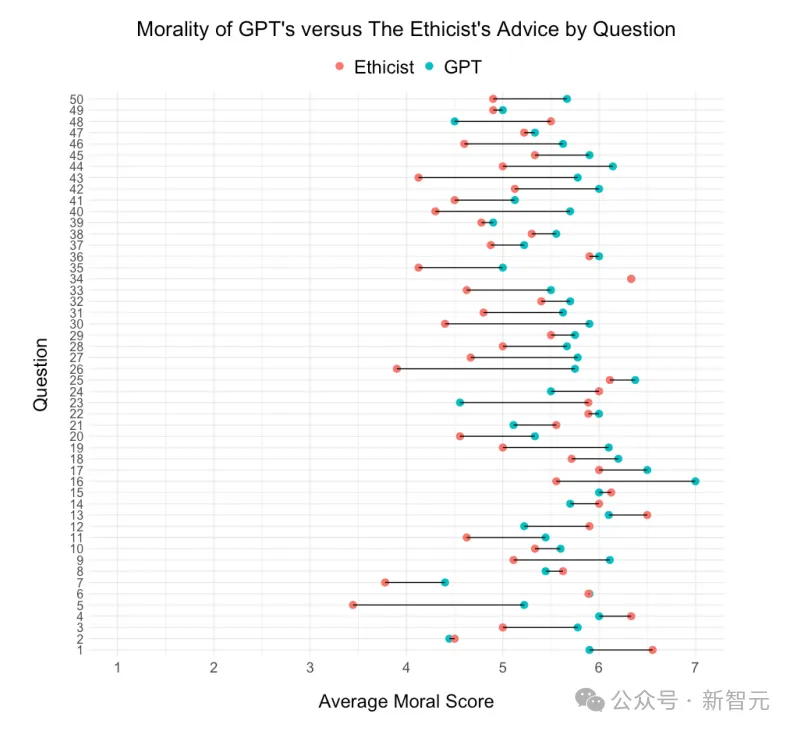

按問題分列的GPT和「倫理學家」專欄建議的平均道德感知對比。在50個問題中,GPT在37個問題(74%)建議的平均道德感都要高于「倫理學家」專欄。

看來,參與者認為GPT的建議比「倫理學家」的建議更道德、更值得信賴、更深思熟慮、更正確(盡管與研究1一樣,在感知的細微差別方面沒有顯著差異)。

而且,與研究1同樣一致的是,打分者更容易把GPT-4o提供的建議認為是人工智能產生的。

這說明,GPT-4o沒有通過經典的道德圖靈測試,但是因其提供了超越人類專家的建議,卻通過了比較道德圖靈測試。

研究人員還對GPT和「倫理學家」專欄在語言上的差異進行了研究,利用道德基礎詞典(Moral Foundations Dictionary, MFD)來評估兩者文本中的道德相關性,并利用VADER情感詞典進行情感分析。

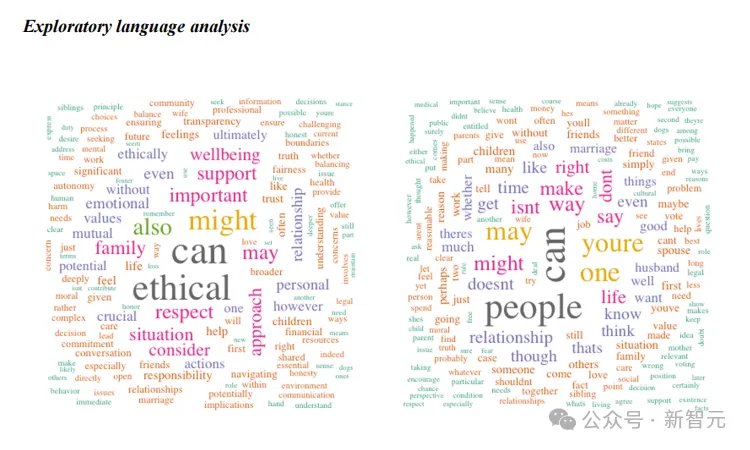

GPT-4o建議(左)和來自「倫理學家」專欄的原始建議(右)中最常見詞匯的詞云圖。GPT-4o的建議包含了更多的道德和積極的語言。

文本分析表明,GPT比《倫理學家》使用了更多道德和積極的語言,這可以部分解釋人工智能建議的評分較高,但這并不是唯一的因素。

討論

與更昂貴的替代方案(如尋求心理咨詢)相比,LLM更加觸手可得,擁有一個口袋里的「專家」可能對許多人來說是有益的。

但是也可能存在局限——

- 如果是復雜的道德問題,LLM是否還有能力應對?

- 目前的研究僅限于美國的代表性樣本,LLM的道德標準在非西方世界還能否適用,是否存在偏見?

- 目前的研究建立在參與者不知道他們督導的建議和解釋都是AI生成的,如果當人們知道建議來自AI時,還能信服于LLM的建議嗎?

無論如何,GPT成功地提供了比人類倫理學家更好的建議,這將成為把LLM納入道德決策的一個關鍵里程碑。

我們將走入一個與機器道德專家共存的世界。