Anthropic CEO:大模型訓練成本暴漲,2027年將達1000億美元!

AI行業巨大的收支鴻溝近日引起了廣泛討論,僅僅按照現在的訓練成本計算,已經達到了5000億美元的天文數字,許多人都在擔憂AI泡沫被戳破之后,有可能會導致新的經濟危機。

目前來看,能夠商業化落地并實現大額盈利的「巨物」還未誕生,但是AI訓練的成本卻還在攀升,并且會逐年呈指數級增長。

Anthropic首席執行官Dario Amodei在In Good Company播客節目中表示,目前正在開發的人工智能模型的訓練成本高達10億美元。

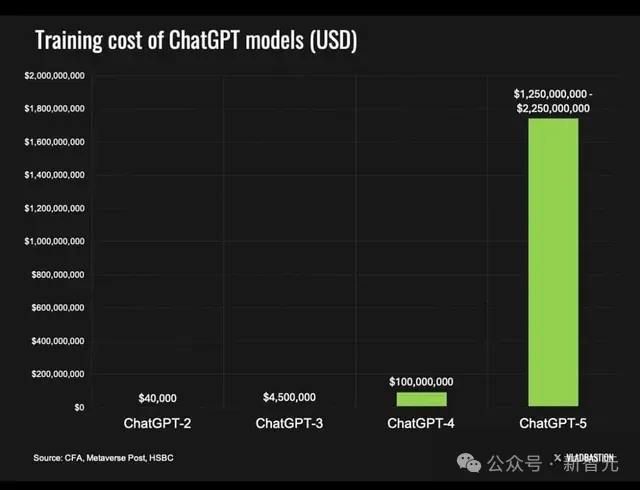

GPT-4o已經成為了歷史,因為像它這樣的模型「僅」需花費約1億美元,跟現在正在開發的模型相比,可謂是小巫見大巫了。

Dario Amodei預計,從現在開始,短短三年內,AI模型的訓練成本將上升到100億美元甚至1000億美元。

Dario Amodei,OpenAI前研究副總裁,2021年創立Claude大模型母公司Anthropic

預測來自于Amodei在討論AI如何從生成式人工智能(GenAI)發展到通用人工智能(AGI)時的一段分析。

他說,「我們不會在某一點上突然達到 AGI,這將是一個循序漸進的發展過程,模型建立在過去模型發展的基礎上,就像人類兒童的學習方式一樣」。

如果人工智能模型每年強大十倍,我們可以合理地預期訓練它們所需的硬件也至少強大十倍。

因此,硬件可能是人工智能訓練中最大的成本驅動因素。「賣鏟子」的英偉達又要賺得盆滿缽滿了。

早在2023年,就有報道稱ChatGPT將需要超過30000個GPU,Sam Altman證實GPT-4的訓練成本為1億美元。

去年,超過380萬個GPU交付給數據中心。鑒于英偉達最新的B200 AI芯片的成本約為 30000-40000 美元,兩個數字相乘,我們就能明白Dario所言非虛——2024年AI訓練成本已經高達10億美元。

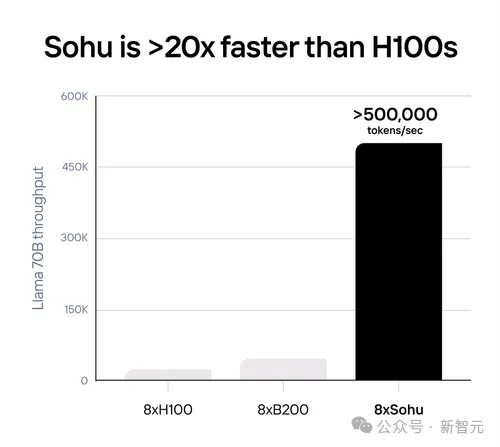

如果模型繼續以當前的指數速度增長,那硬件資源也得跟上,缺口會越來越大,除非像Sohu人工智能芯片這樣更高效的技術變得更加普遍。

我們已經可以看到這種指數級增長的發生。

埃隆·馬斯克計劃采購30萬個B200 AI芯片,據報道OpenAI和微軟正在計劃建造一個價值1000億美元的 AI 數據中心。

考慮到所有這些需求,如果英偉達和其他供應商能夠跟上市場的步伐,明年GPU數據中心的交付量將激增至3800萬個,是去年的10倍!

芯片硬件不是唯一掣肘的因素,電力和相關基礎設施也是重要的成本損耗之一。

據估計,去年售出的所有數據中心GPU的總耗電量可為130萬戶家庭供電。

如果數據中心的電力需求繼續呈指數級增長,那么當前足夠的價格經濟的電力將會被消耗殆盡。

此外,這些數據中心不僅需要發電廠,它們還需要一個完全升級的電網,以處理耗電量巨大的人工智能芯片運行所需的所有電子。

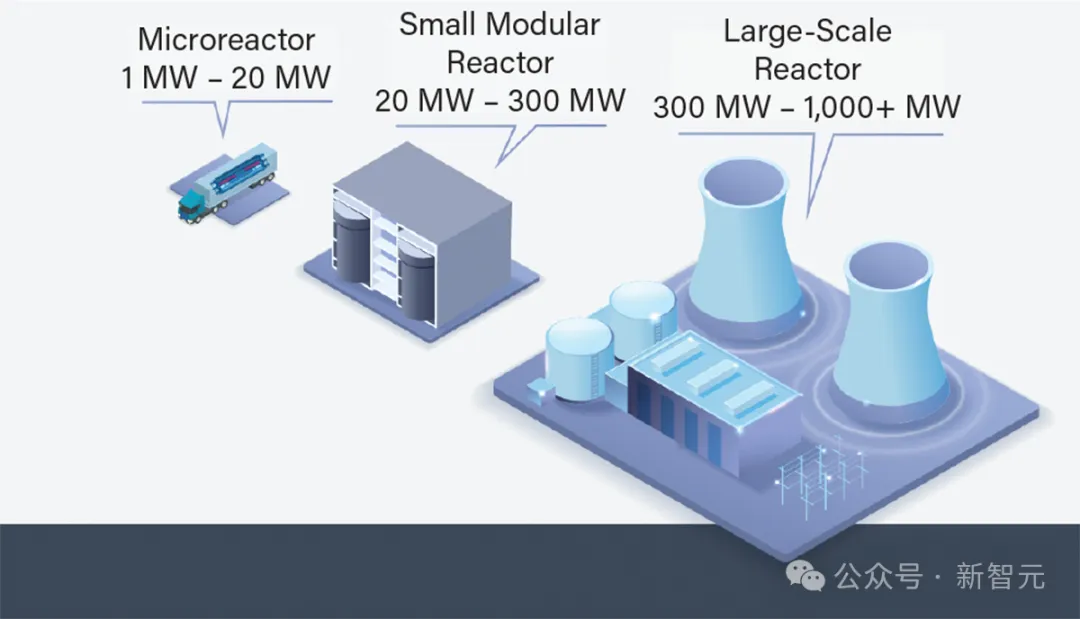

因此,包括微軟在內的許多科技公司現在都在考慮為其數據中心采用模塊化核電,微軟正在尋找一位關鍵人物來領導其核技術戰略,重點是為其數據中心實施小型模塊化反應堆 (SMR) 和微反應堆。

那么,3年之內,AI訓練成本真的會達到Anthropic所預測的1000億美元嗎?有沒有更多的證據支撐呢?我們一起來算筆賬看看——

1000億美元怎么花?

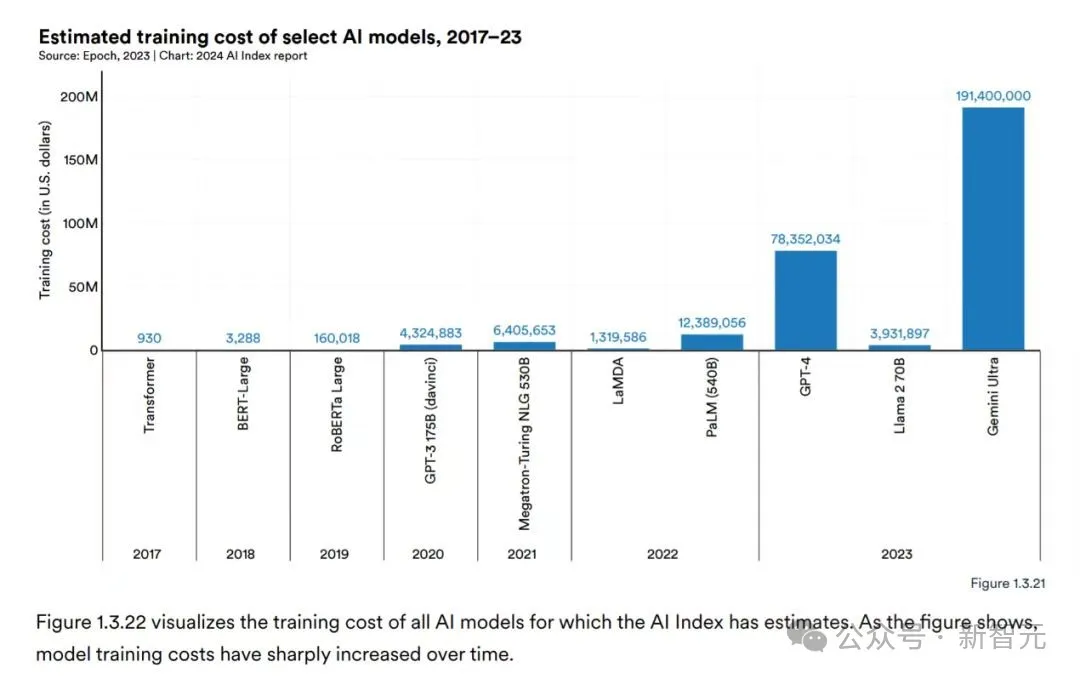

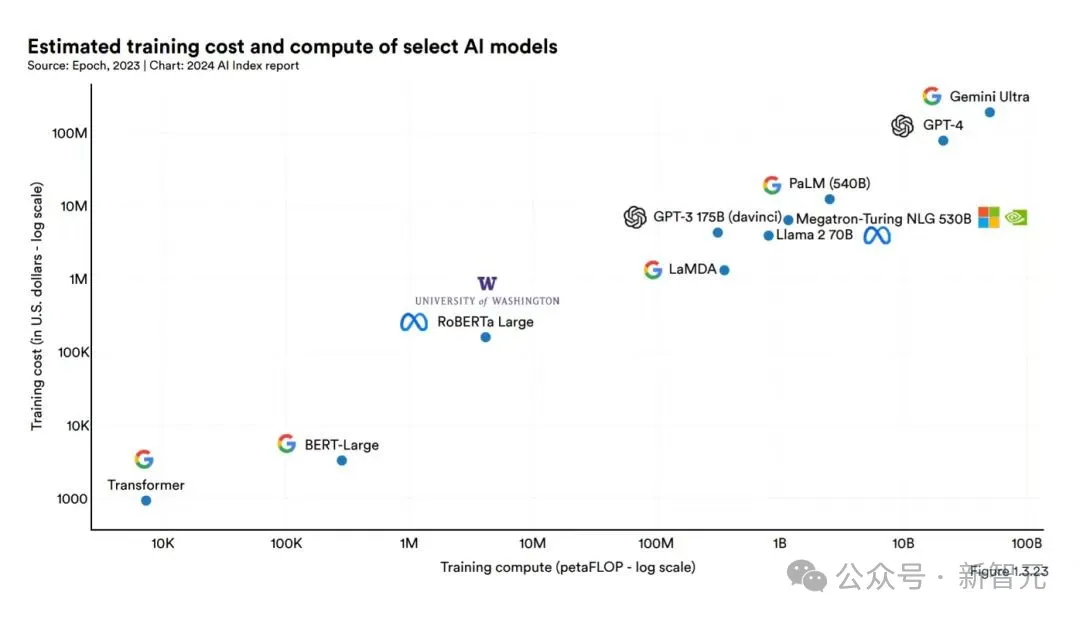

根據斯坦福大學《人工智能指數數據報告2024》顯示,AI模型的訓練成本呈現飛速增長,短短幾年間從四位數躍升至九位數。

例如,2017年訓練最初的Transformer模型的成本僅為約900美元,而到了2019年,RoBERTa Large模型的訓練成本已經升至約160000美元。

到了2023年,OpenAI的GPT-4和Google的Gemini Ultra的訓練成本更是分別達到了約7800萬美元和近2億美元。

報告指出,隨著AI模型參數數量的激增,其訓練所需的算力和能耗也隨之水漲船高。

大參數模型通常意味著更高的訓練成本,因為它們需要更強大的硬件設施、更長的訓練時間以及更大的數據集來支撐。

這種關聯性在報告中通過圖表清晰地顯示出參數數量與訓練成本之間成正比例關系,參數越大,訓練成本越高。

2億已經數額頗為驚人了,那么十個指頭都數不過來的千億美刀會怎么花?

首先大頭必定花在硬件成本上。

主要包括購置和維護高性能計算設備(如GPU、TPU、CPU集群等)的費用。這些設備是執行大量計算以訓練大規模模型所必需的。

硬件成本占比較高,尤其是在需要大規模并行計算和高吞吐量存儲的情況下。

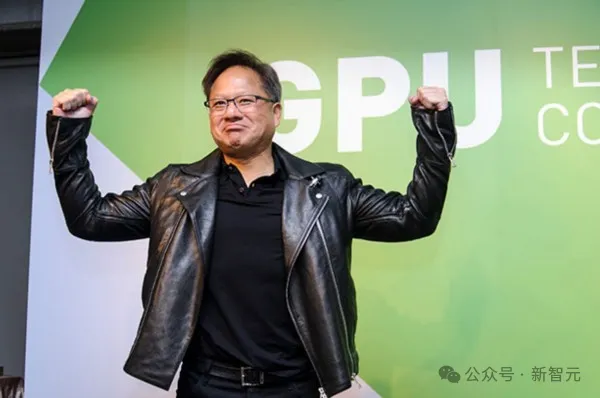

前幾天馬斯克剛透露花40億美元購買10萬張H100訓練Grok 3,這會兒Amodei預言千億訓練模型,老黃屏幕背后微微一笑,又可以靠賣鏟子買新皮衣了!

reddit網友也指出,千億美元一大半要被老黃賺走。

黃仁勛:(興奮地搓手手)

老黃家GPU產生的熱量,把億萬資金燒的付之一炬。

也有網友打趣到,不管是GPU燒的熱量還是未來百億大單讓人想想就紅溫,皮衣戰神可以脫下他的經典皮膚散散熱。

其次成本的重頭還在于能源消耗。

有數據顯示,全美AI數據中心的耗電量占全美總用電量的2.5%,足以點亮整個紐約市。

GPT-3的訓練約消耗1300兆瓦時電力,如果連續播放視頻可持續播放約186年。

由此可見,AI模型訓練是一個高度能源密集的過程,涉及到大量的計算操作和數據交換。

數據中心的電力消耗、冷卻設施運行以及潛在的碳排放成本構成了能源成本。隨著對可持續性和碳中和目標的關注增加,這部分成本的重要性愈發凸顯。

奧特曼曾經就表示,AGI的盡頭可能是能源問題,核聚變或是AI能源戰的最終方案。

微軟已經表示,他們正在考慮建造一座價值1000億美元的設施,其中最令人震驚的是對電力的投入。

首先需要解決能源問題,否則就不會有 AGl。大腦使用約20瓦特的功率,而粗放的使用方法消耗的功率相當于一個國家的使用量。

第三是人力資源的支出。

訓練AI模型需要一支專業的工程師和科學家團隊,包括數據工程師、AI研究員、軟件工程師等。他們的薪資、福利、培訓和發展成本構成了人力資源成本。

AI人才也是AI軍備競賽中一個不可忽視的兵家必爭之地。大佬們紛紛開百萬年薪,親自發郵件挖人,親自打電話留人等等,只為獲得AI人才青睞。

第四就是數據成本的花銷,高質量、大規模的訓練數據對于AI模型的性能至關重要。

數據采集、標注、清洗、存儲和傳輸等環節會產生相應的成本,包括人力、工具、平臺使用費等。

對于某些特定領域的數據(如醫療影像、金融交易數據),數據獲取可能涉及購買許可證、支付版權費等額外支出。

例如,Scale AI CEO就開出時薪40美元招聘高學歷博士訓練AI數據標注,只為獲得專業性強的高質量數據。

最后要考慮運行維護和管理成本。

包括數據中心運維、網絡帶寬、安全防護、故障恢復、備份系統等的建設和維護費用。

隨著模型規模的擴大和模型復雜度的提升,對基礎設施的穩定性和可靠性要求更高。

其中,硬件成本和能源消耗占比較大,特別是在訓練超大規模模型時,這兩部分成本可能會占到總成本的大頭。

隨著AI技術的發展和應用規模的擴大,能源消耗問題的解決迫在眉睫。許多研究和實踐已經開始探討如何通過優化算法、提高硬件能效、采用可再生能源、采用液冷系統等方式降低AI訓練的能源成本。

總體來說,資金在未來大規模流向AI領域早就可以預見,不過也有人懷疑如此大規模的千億巨單錢從哪兒來?投入產出比又會如何?

雖說AI被類比為人類兒童的學習方式,但它可比「訓練」人類小孩花費多得多,網友在投入產出比這塊兒調侃道「請訓練我好不好」。

誰在我身上花一千億我搞不好也能達到一樣的目標,訓的比大多數人厲害呢。