AI慢思考蒸餾進(jìn)快思考,Llama2躍升至GPT-4水平,不寫過(guò)程也能做對(duì)題

《思考快與慢》中人類的兩種思考方式,屬實(shí)是被Meta給玩明白了。

研究人員通過(guò)把AI的“慢思考”結(jié)果蒸餾進(jìn)“快思考”,讓Llama2表現(xiàn)提升了257%,變得比GPT4還能打,同時(shí)還能降低推理成本。

這里的快慢兩種思考方式,指的就是2002年諾貝爾經(jīng)濟(jì)學(xué)獎(jiǎng)得主丹尼爾·卡尼曼推廣的系統(tǒng)1和系統(tǒng)2——

簡(jiǎn)單說(shuō),系統(tǒng)1是簡(jiǎn)單無(wú)意識(shí)的直覺(jué),速度更快;系統(tǒng)2則是復(fù)雜有意識(shí)的推理,準(zhǔn)確性更強(qiáng)。

Meta所做的“蒸餾”,就是用系統(tǒng)2生成數(shù)據(jù),然后對(duì)用系統(tǒng)1推理的模型進(jìn)行微調(diào)。

有網(wǎng)友看了后表示,這種模式和人類很像,一旦解決了一個(gè)難題,再解決(相似的問(wèn)題)就變得簡(jiǎn)單了。

將系統(tǒng)2蒸餾到系統(tǒng)1

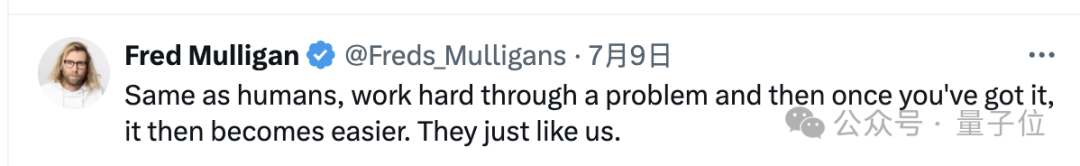

對(duì)于大模型而言,模仿人類的“系統(tǒng)2”的方式有很多種,在模型中所處的環(huán)節(jié)也不盡相同,這里作者一共研究了四種:

- CoT,即Chain of Thought,思維鏈,從提示詞入手讓模型逐步思考。

- S2A,即System 2 Attention,由Meta自己提出,直接修改了模型的注意力機(jī)制,屏蔽與任務(wù)無(wú)關(guān)的信息。

- RaR,即Rephase and Respond,先對(duì)問(wèn)題進(jìn)行重新表述,再根據(jù)重述后的問(wèn)題生成答案。

- BSM,即Branch-Solve-Merge,將復(fù)雜任務(wù)分解為多個(gè)分支,針對(duì)每個(gè)分支獨(dú)立生成評(píng)分,再將各個(gè)分支的評(píng)分綜合。

但從整體流程上看則是殊途同歸,各種“系統(tǒng)2方法”都會(huì)在未標(biāo)注數(shù)據(jù)集上生成推理結(jié)果。

在這過(guò)程當(dāng)中,模型會(huì)在給出結(jié)果的同時(shí)生成詳細(xì)的中間推理步驟,但研究人員只保留最終的輸出結(jié)果。

然后就得到了輸入-系統(tǒng)2輸出的數(shù)據(jù)對(duì),可以視為一種無(wú)監(jiān)督的“偽標(biāo)簽”,將這些數(shù)據(jù)對(duì)收集起來(lái),就形成初步的蒸餾數(shù)據(jù)集。

當(dāng)然了,這步得到的數(shù)據(jù)還不能直接拿來(lái)微調(diào)系統(tǒng)1模型,需要進(jìn)行過(guò)濾以確保其擁有足夠高的質(zhì)量。

過(guò)濾的具體依據(jù),是一致性和魯棒性。

一致性篩選當(dāng)中,對(duì)每個(gè)輸入樣本,都會(huì)用系統(tǒng)2模型采樣生成多個(gè)輸出,然后通過(guò)多數(shù)投票等方法進(jìn)行比較,如果大多數(shù)都一致,則認(rèn)為該輸出是可靠的;

魯棒性篩選是對(duì)一個(gè)輸入樣本進(jìn)行適當(dāng)?shù)臄_動(dòng),如改變無(wú)關(guān)細(xì)節(jié)、調(diào)整詞序等,然后觀察系統(tǒng)2模型在擾動(dòng)前后的輸出是否一致。

篩選后的高質(zhì)量蒸餾數(shù)據(jù),就可以對(duì)系統(tǒng)1模型進(jìn)行無(wú)監(jiān)督微調(diào)了。

微調(diào)過(guò)程可以看作是一種知識(shí)蒸餾,但又與與傳統(tǒng)的知識(shí)蒸餾不同,這里兩種系統(tǒng)使用的是同一個(gè)基礎(chǔ)模型。

系統(tǒng)1模型的目標(biāo)是直接學(xué)到系統(tǒng)2模型的輸出行為,而不是中間的復(fù)雜推理過(guò)程,在后續(xù)推理時(shí)也不需要執(zhí)行系統(tǒng)2的推理步驟,而是直接生成輸出。

但從輸出質(zhì)量上來(lái)看,表現(xiàn)卻能接近系統(tǒng)2模型,也就是實(shí)現(xiàn)了系統(tǒng)2能力向系統(tǒng)1的轉(zhuǎn)移。

那么,為什么要專門收集數(shù)據(jù)去微調(diào)系統(tǒng)1模型,而不直接用系統(tǒng)2模型推理呢,作者也給出了解釋。

道理其實(shí)很簡(jiǎn)單,從系統(tǒng)2的另一個(gè)名字“慢系統(tǒng)”當(dāng)中,很容易就能看出答案:

因?yàn)橄到y(tǒng)2的速度慢,在實(shí)時(shí)交互、移動(dòng)設(shè)備部署等場(chǎng)景下,模型的延遲可能是無(wú)法接受的。

另外,由于需要輸出完整的推理過(guò)程,系統(tǒng)2輸出的token長(zhǎng)度也是系統(tǒng)1的數(shù)百倍。

就像開(kāi)頭那位網(wǎng)友說(shuō)的,系統(tǒng)2把復(fù)雜的推理解決了,再將數(shù)據(jù)喂給系統(tǒng)1,問(wèn)題對(duì)其而言也會(huì)變得容易。

從表現(xiàn)上看,這樣的模式也確實(shí)讓系統(tǒng)1模型的表現(xiàn)大幅進(jìn)步,甚至超過(guò)了真·系統(tǒng)2模型。

讓Llama2超越GPT-4

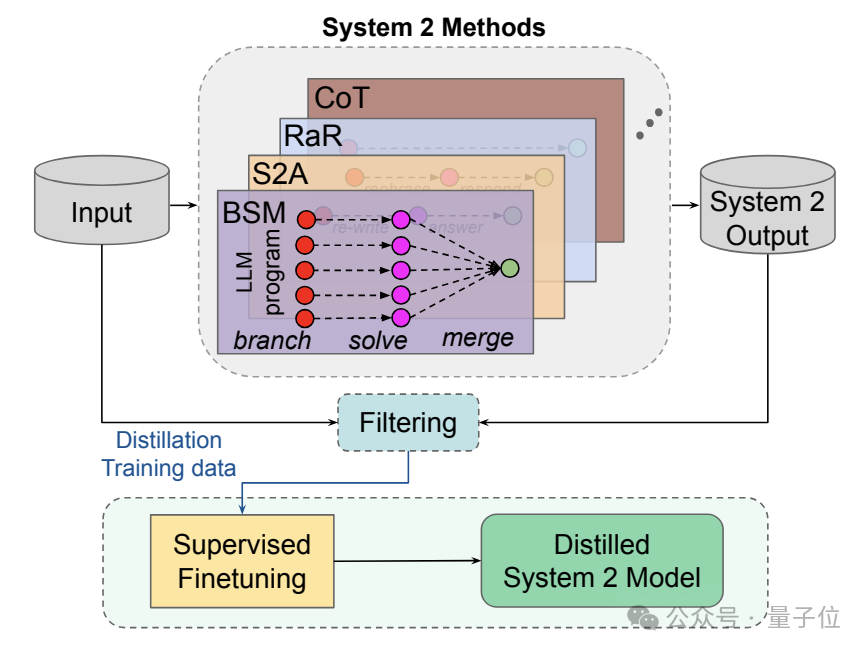

針對(duì)前面四種不同的系統(tǒng)2方法,研究人員分別使用不同的數(shù)據(jù)集,在不同的任務(wù)上進(jìn)行了測(cè)試。

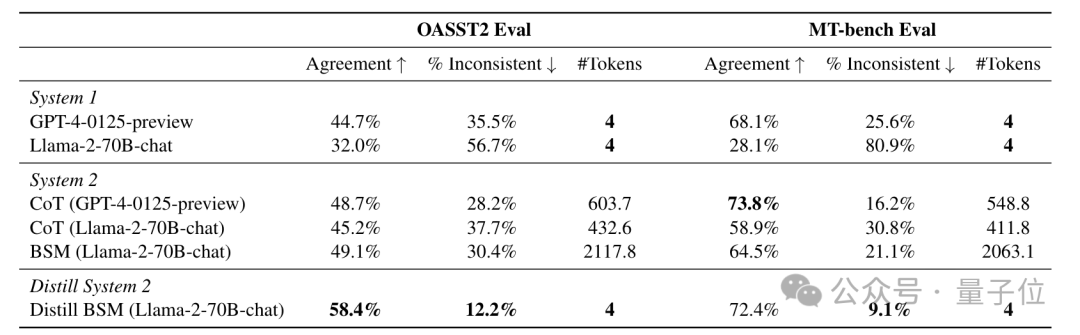

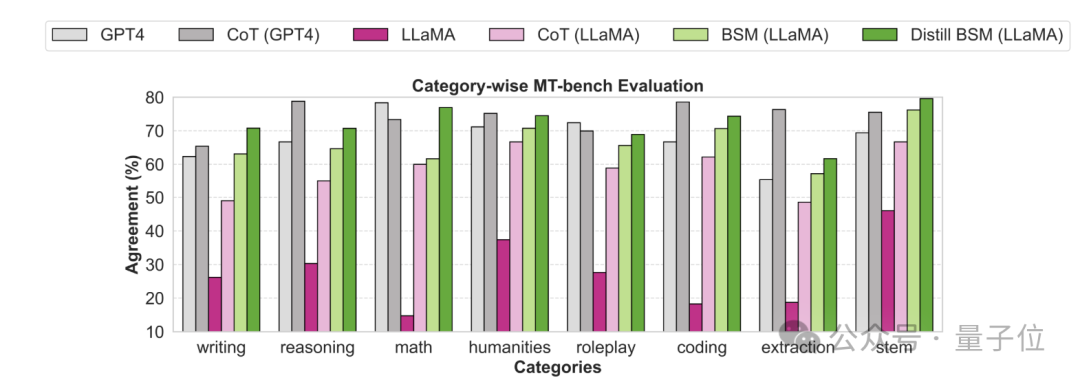

針對(duì)BSM方法,作者采用的數(shù)據(jù)集是Open Assistant 2和MT-bench,評(píng)估了模型作為“評(píng)判者”時(shí)的表現(xiàn)。

可以看到,在兩個(gè)數(shù)據(jù)集中,Llama-2的表現(xiàn)(人類一致性)分別從32.0%和28.1%,提高到了58.4%和72.4%,最高增幅達(dá)到了257%,比CoT方法更加有效。

而且,微調(diào)后的模型均超過(guò)了系統(tǒng)1版的GPT-4,甚至達(dá)到了GPT-4配合CoT的水準(zhǔn)。

同時(shí)(改變選項(xiàng)位置后的)不一致性也大幅降低,而且和系統(tǒng)2相比,Token數(shù)量少到幾乎可以忽略不計(jì)。

同時(shí)針對(duì)MT-Bench不同的子類任務(wù),作者也分別分析了各種方法的人類一致性。

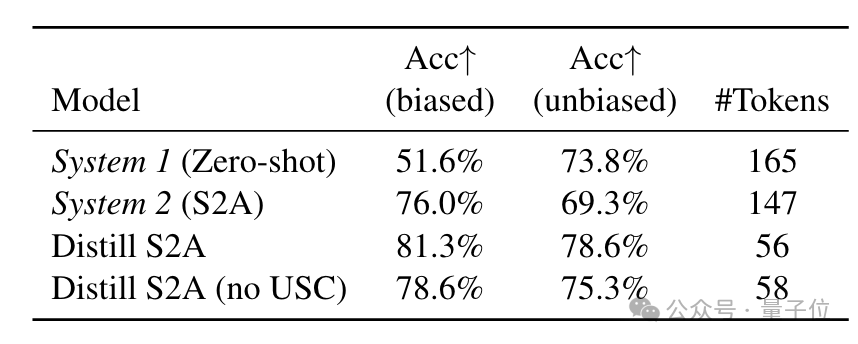

接下來(lái)是S2A方法,它主要解決的是模型偏見(jiàn)問(wèn)題,因此評(píng)估時(shí)采用了帶偏見(jiàn)的TriviaQA任務(wù)。

結(jié)果蒸餾后的準(zhǔn)確率達(dá)到81.3%,超過(guò)了原始S2A的76%,生成的token數(shù)量也從147個(gè)減少到了56個(gè)。

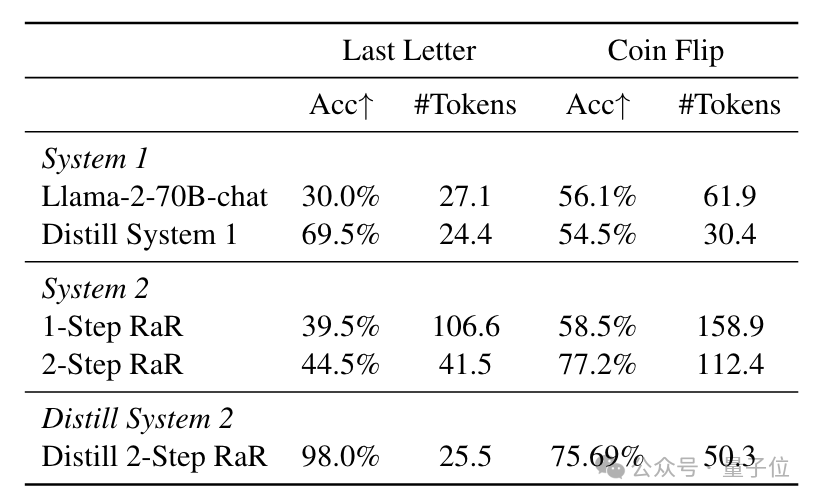

RaR的測(cè)試目標(biāo)則是完成一些推理任務(wù),這里作者測(cè)試了Last letter concatenation和Coin flip。

在Letter任務(wù)中,蒸餾后的系統(tǒng)模型準(zhǔn)確率從30%飛升到了98%,也超過(guò)了系統(tǒng)1自蒸餾的69.5%,同時(shí)也優(yōu)于原始的RaR方式。

而在Coin flip任務(wù)里,蒸餾后的準(zhǔn)確率達(dá)到 75.69%,也與接近2-步原始RaR的77.2%接近,但生成的token數(shù)量大幅減少。

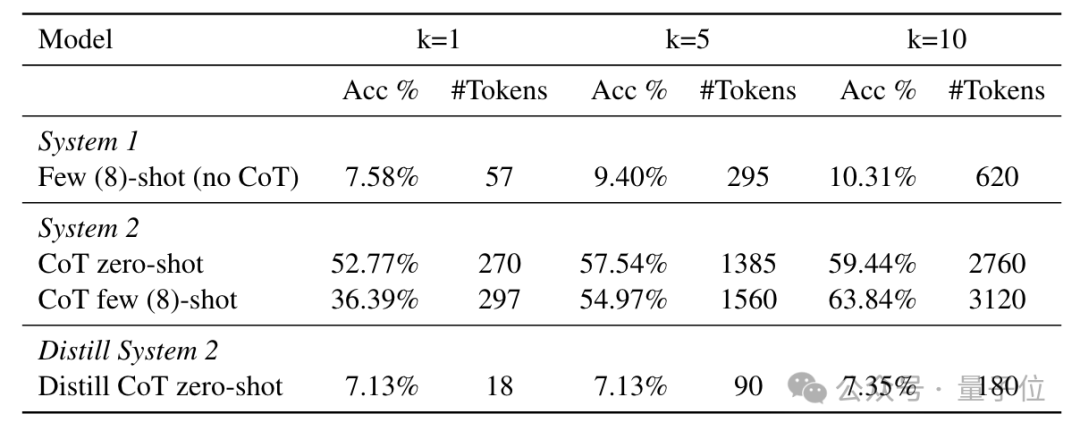

不足的一點(diǎn)是,CoT的蒸餾效果與另外三種大相徑庭,作者發(fā)現(xiàn),在數(shù)學(xué)推理任務(wù)上,CoT的推理能力很難遷移到系統(tǒng)1當(dāng)中。

在GSM8K數(shù)據(jù)集上,蒸餾后的模型在k=1時(shí)準(zhǔn)確率僅為7.13%,k=10時(shí)也只有7.35%,甚至不如沒(méi)蒸餾之前的版本。

所以,作者認(rèn)為,接下來(lái)的研究目標(biāo)是進(jìn)一步明確這種蒸餾的應(yīng)用場(chǎng)合,找到更類似于人類學(xué)習(xí)的方式。

論文地址:https://arxiv.org/abs/2407.06023

參考鏈接:https://x.com/emollick/status/1810659417634869610。