斯坦福炒蝦機器人原班人馬新作!最強大腦Gemini加持,機器人炫技導航玩出新花樣

時隔半年,原班人馬聯合谷歌研究人員,重磅推出全新機器人自主導航的基礎模型——Mobility VLA。

圖片

圖片

與以往不同的是,新架構得到了谷歌迄今為止最強Gemini 1.5 Pro大模型的加持。

Gemini 1.5 Pro不僅擁有100k長上下文,還具備了強大的多模態能力。給機器人安上「最強大腦」,可想而知,用在RT-2機器人身上有多么無敵。

通過觀看9000平方英尺谷歌辦公室視頻之后,RT-2機器人建立起了對整個環境感知的概念。

接下來,就是讓RT-2炫技的時刻了。

首先,讓RT-2帶自己去一個能畫東西的地方。

戴著一個可愛的的黃色領結機器人回應道,「好的,給我一分鐘,讓我用Gemini稍加思考」。

圖片

圖片

不一會兒功夫,它就把人類帶到一塊墻壁大小的白板前。

圖片

圖片

然后,它再次收到新的命令,按照白板上指示的路線圖,抵達「藍色區域」。

RT-2再次思考了片刻,然后走了很長一段路,最終來到了機器人測試區。

圖片

圖片

不僅如此,研究人員主動帶領RT-2參觀了Lewis的辦公桌,以及臨時辦公桌區域之后,再要求RT-2帶路。

可見,RT-2有著強大的記憶能力,能夠準確識別位置。

50條指令,完成率90%

RT-2能夠流暢完成以上任務的奧秘就在于,利用Genimi訓練機器人的導航系統。

具體做法是,拍攝指定區域(如家庭或辦公空間)的視頻導覽,讓Gemini 1.5 Pro加持的機器人「觀看」視頻以了解環境。

接下來,利用Mobility VLA將環境理解和常識推理能力結合起來。

然后,機器人可以根據觀察和學習到的情況,對書寫和語音的指令以及手勢做出反應。

例如,在用戶展示一部手機并詢問「在哪里可以充電」后,機器人會引導用戶找到電源插座。

DeepMind表示,在一定空間內,用Gemini驅動的機器人,在發出50多條用戶指令后,完成指令成功率高達90%。

研究人員還發現,Gemini 1.5 Pro能讓機器人規劃如何完成導航以外的指令。

例如,一位小哥桌上擺放著兩排喝光了的肥宅快樂水罐子,還想再來一瓶,于是向機器人詢問他最喜歡的飲料是否有貨。

研究小組說,Gemini指引機器人應該導航到冰箱,檢查是否有可樂,然后返回用戶處報告結果。

圖片

圖片

DeepMind表示,團隊將進一步研究這些機器人反饋的結果。

目前,機器人處理這些指令需要10-30秒的時間,對于實際應用來說太慢了,在響應速度方面仍有提升空間。

Mobility VLA

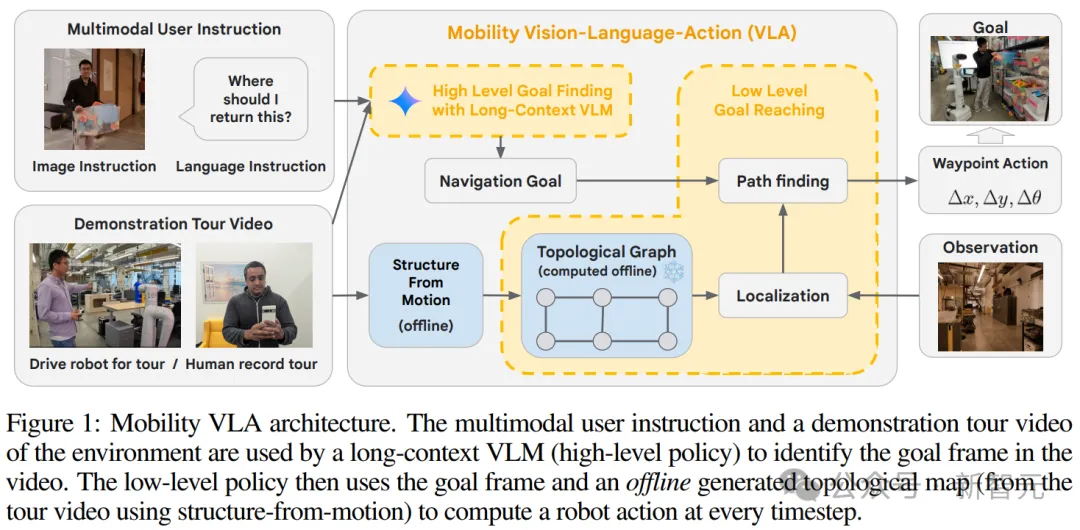

在導航研究領域,一個難以實現的目標是構建一個能夠理解自然語言和圖像等多模態指令,并執行有效導航的智能體。

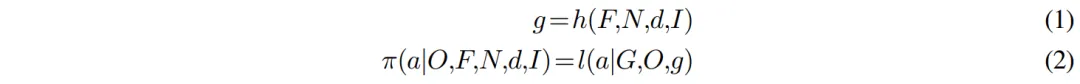

為了達成這一目標,研究人員提出了一類廣泛應用的導航任務——帶有演示路線的多模態指令導航(Multimodal Instruction Navigation with demonstration Tours,MINT)。

在這種任務中,環境信息通過預先錄制的演示視頻提供。

圖片

圖片

論文地址:https://arxiv.org/abs/2407.07775v1

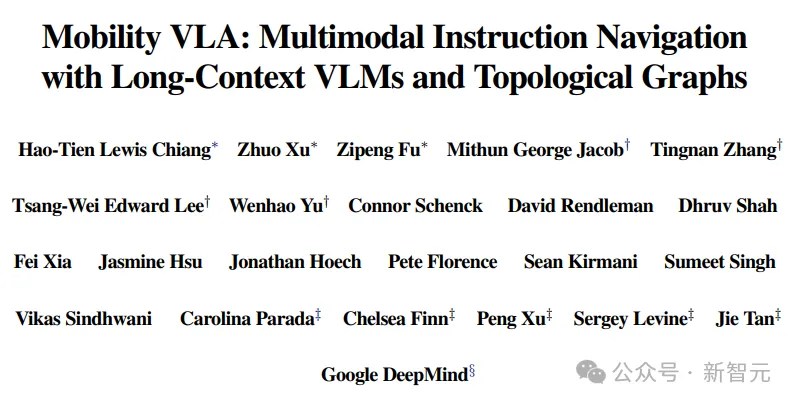

為了解決MINT任務,研究人員進一步提出了一種分層的視覺-語言-行動(Vision-Language-Action,VLA)導航策略——Mobility VLA。它結合了長上下文VLMs的環境理解和常識推理能力,以及基于拓撲圖的強大低層導航策略。

其中,高層策略使用長上下文VLM,將演示路線視頻和多模態用戶指令作為輸入,在演示視頻中找到目標幀。接下來,低層策略利用目標幀和離線構建的拓撲圖,在每個時間步生成機器人動作。

在一個836平方米的真實環境中的評估結果表明,Mobility VLA在以前未解決的多模態指令上,具有很高的端到端成功率。(例如,「我應該把這個放在哪里?」同時拿著一個塑料箱)

圖片

圖片

如圖1所示,Mobility VLA是一種分層導航策略,包含在線和離線兩個部分。

離線階段,會從演示路線(N,F)中生成一個拓撲圖G。在線上,高層策略會使用演示路線和多模態用戶指令(d,I)來找到導航目標幀的索引g。

接下來,低層策略會利用拓撲圖、當前相機觀測O和目標幀索引g,為機器人在每個時間步生成一個路徑點動作a,以便機器人執行。

圖片

圖片

演示路線和離線拓撲圖生成

首先需要的是環境演示路線,這個可以由人類用戶通過遠程操作提供,或者只需在環境中行走時用智能手機錄制視頻即可。

然后,Mobility VLA會離線構建一個拓撲圖G=(V, E),其中每個頂點vi∈V對應于演示路線視頻(F, N)中的幀fi。

通過使用COLMAP這個現成的結構-從-運動(structure-from-motion)管線來確定每幀的近似六自由度(6-Degree-of-Freedom)相機姿態,并將其存儲在頂點中。

接下來,如果目標頂點「在源頂點前面」(距離源頂點的姿態小于90度)并且在2米以內,則向G中添加一個有向邊。

與傳統的導航管線相比(例如,先映射環境,再識別可通行區域,最后構建PRM),撲圖方法要簡單得多,因為它能根據游覽軌跡捕捉環境的一般連通性。

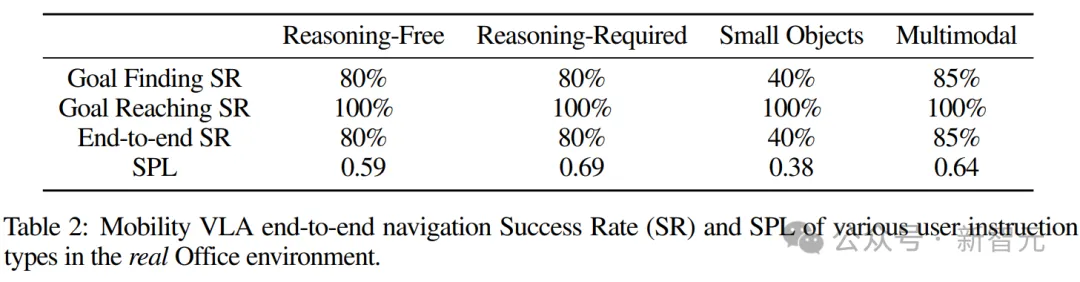

使用長上下文多模態VLM進行高層目標查找

在在線執行過程中,高層策略利用VLMs的常識推理能力,從演示路線中識別出符合各種多模態、口語化且通常模糊的用戶指令的導航目標。

為此,研究人員準備了一個由交錯文本和圖像組成的提示P(F,N,d,I)。

圖片

圖片

以下是表1中關于多模態用戶指令「我應該把這個放在哪里?」的具體P示例:

You are a robot operating in a building and your task is to respond to the user command about going to a specific location by finding the closest frame in the tour video to navigate to .

These frames are from the tour of the building last year .

[ Frame 1 Image f1]

Frame 1. [ Frame narrative n1]

...

[ Frame k Image fk ]

Frame k . [ Frame narrative nk ]

This image is what you see now . You may or may not see the user in this image . [ Image Instruction I]

The user says : Where should I return this ?

How would you respond ? Can you find the closest frame ?此時,VLM會返回一個整數形式的目標幀索引g。

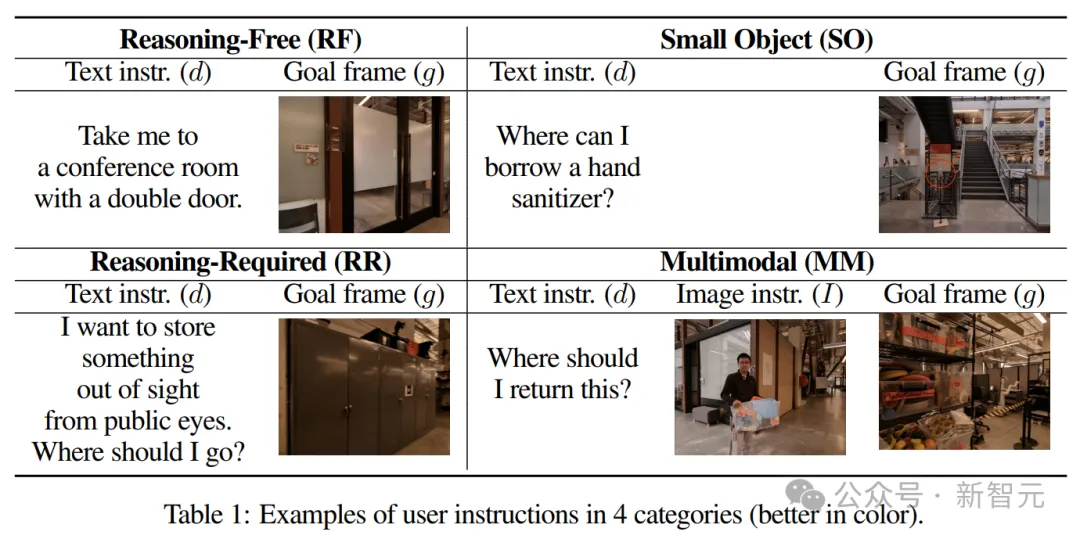

使用拓撲圖實現低層目標到達

一旦高層策略識別出目標幀索引g,低層策略(算法1)就會接管,并在每個時間步生成一個路徑點動作(公式1)。

圖片

圖片

對于每個時間步,使用一個實時的分層視覺定位系統,來基于當前的相機觀測O,來估計機器人的姿態T和最近的起始頂點vs∈G。

這個定位系統會根據全局描述符找到拓撲圖G中的k個最近候選幀,然后通過PnP計算出機器人的姿態T。

接下來,通過Dijkstra算法(第9行)在拓撲圖上找到從起始頂點vs到目標頂點vg(即目標幀索引g對應的頂點)之間的最短路徑S。

最后,低層策略會返回一個路徑點動作,該動作只是路徑S中下一個頂點v1相對于當前姿態T的位移?x,?y和旋轉角度?θ(第10行)。

實驗

為了探究Mobility VLA的性能,研究人員針對以下三個問題進行了實驗設計。

RQ1:Mobility VLA在現實世界的MINT中表現如何?

RQ2:Mobility VLA是否因為使用了長上下文VLM而優于其他方案?

RQ3:拓撲圖是否必要?VLM能否直接生成動作?

演示路線:通過使用游戲手柄遠程操作機器人來收集演示路線。所有走廊都從相反方向走了兩次。最終的路線大約16分鐘長(每秒1幀,共948幀),并且在路線中添加了「每個人的臨時辦公桌」和「Lewis的辦公桌」的敘述,分別在5:28和7:14幀,以實現個性化導航。

多模態用戶指令:收集了4個類別共57條用戶指令。包括:20條無須推理的指令(RF),15條需要推理的指令(RR),12條關于小物件的指令(SO),以及10條多模態指令(MM)。

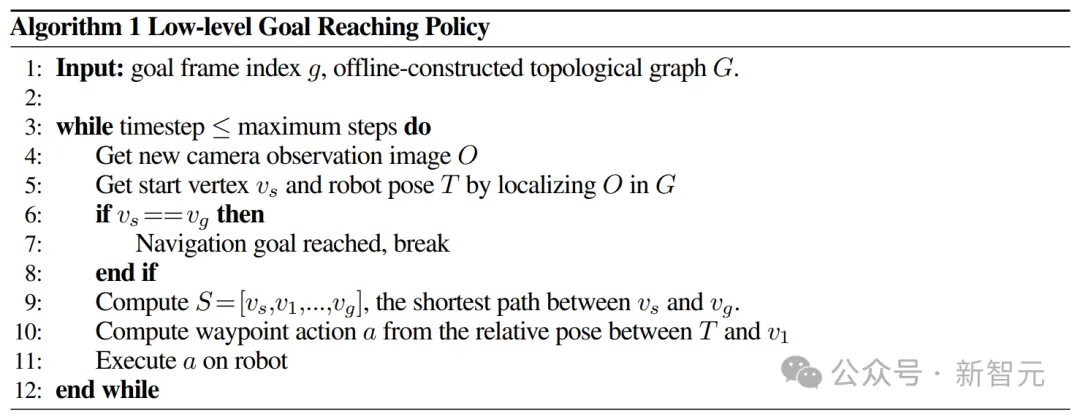

RQ1:Mobility VLA在真實環境中強大的端到端性能

- 極高的端到端成功率

表2顯示,Mobility VLA 在大多數用戶指令類別中具有高端到端導航成功率,包括以前難以實現的需要推理和多模態指令,并且還具有合理的SPL(成功率加權路徑長度)。

然而,在小物件類別中的成功率顯著較低。

最后,Mobility VLA 成功地在演示路線中加入了個性化敘述。在響應基本相同但來自不同用戶的指令時,它能夠正確地導航到不同的位置。

圖片

圖片

- 穩健的低層目標到達能力

表2還顯示了Mobility VLA在現實世界中低級目標到達策略的穩健性,其成功率達到了100%。

值得注意的是,演示路線是在實驗前幾個月錄制的,當時許多物體、家具和光照條件都與實驗時不同。

- 大規模仿真確認高端到端成功率

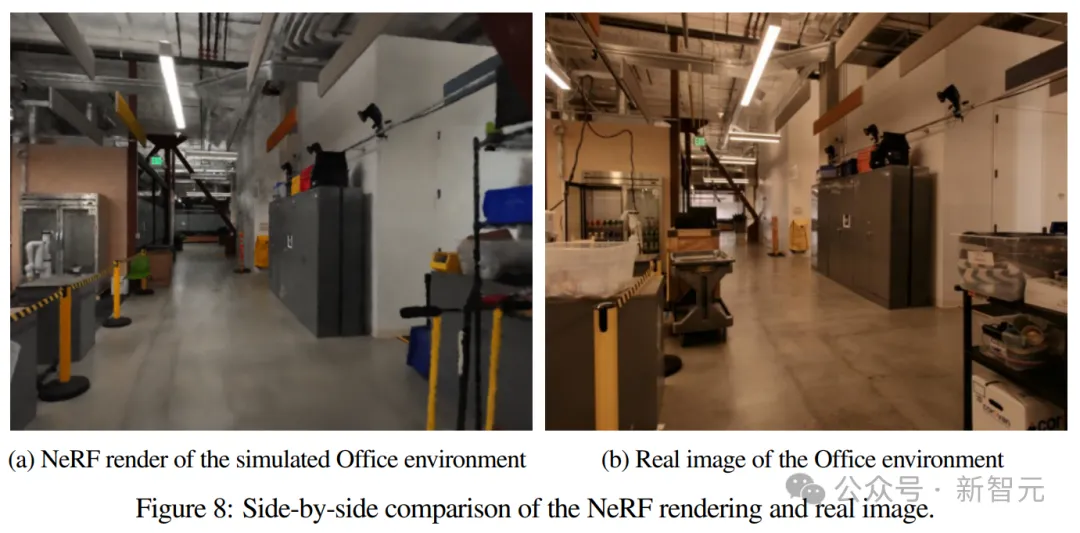

為了進一步探索端到端性能,研究人員利用仿真來擴大評估數量。

具體來說,通過使用NeRF創建辦公室環境的高保真仿真重建,并針對20個語言指令任務進行評估,每個任務有50個隨機起始姿態。

實驗結果顯示,高層目標找到率為90%,低層目標到達率為100%,總共成功執行了900次端到端操作。

圖片

圖片

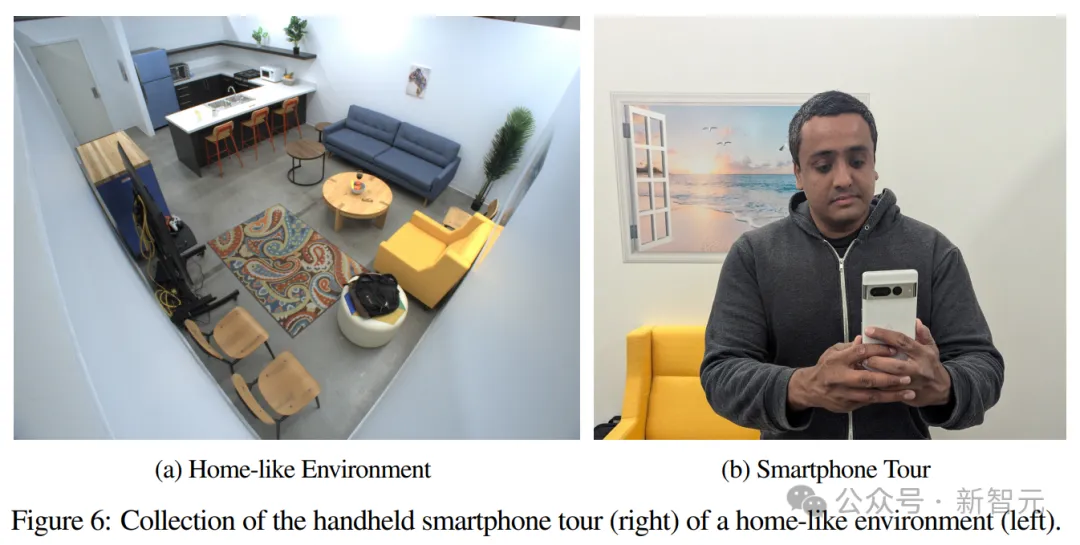

- 使用手機導航進行家庭環境的泛化

為了展示Mobility VLA的通用性和易用性,研究人員在一個真實的類家庭環境中進行了概念驗證實驗。其中,演示是通過Google Pixel 6手機錄制的。

結果顯示,成功率為100%,SPL為0.87。這表明Mobility VLA:

1. 無論在什么環境下都表現良好;

2. 極易于部署。(用戶只需使用手機錄制環境導航,上傳給機器人后即可開始下達命令)

研究人員表示,這種通用性和易用性在機器人導航中是前所未見的。

圖片

圖片

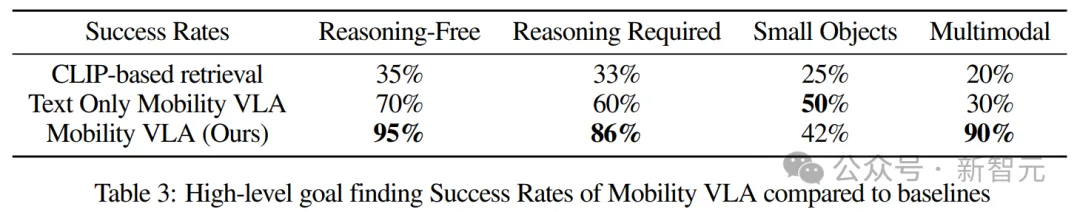

RQ2:長上下文多模態VLM在高層目標尋找方面更優

- Mobility VLA優于其他方法

表3顯示,Mobility VLA在高層目標找到成功率方面顯著高于其他方法。

鑒于其低層目標到達成功率為100%,這些高層目標找到成功率也代表了端到端的整體成功率。

圖片

圖片

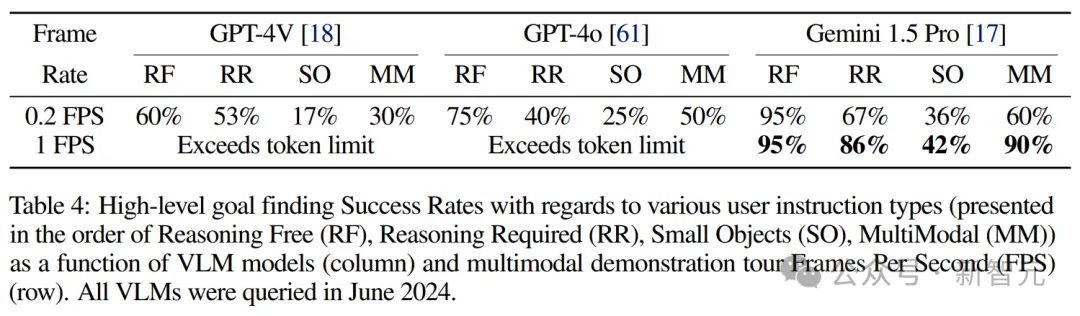

- 使用長上下文VLM處理高幀率導航視頻是成功的關鍵

表4顯示,隨著視頻幀率的降低,高層目標找到的成功率也隨之下降。(因為較低的幀率會錯過重要的導航目標幀)

此外,在比較最先進的VLM時,只有上下文長度高達1M token的Gemini 1.5 Pro,才取得了令人滿意的成功率。

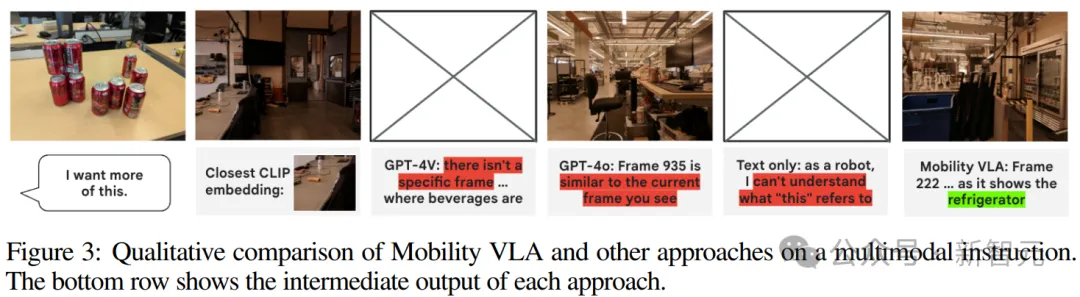

圖3展示了,在給出「我想要更多這個」的多模態指令和桌子上幾個可樂罐的圖片時,Mobility VLA能夠正確識別出包含冰箱的幀,并引導用戶前往。

而基于CLIP的檢索方法則找到一個包含水瓶和一些雜物的桌子區域,認為其最接近完整指令圖像,因為使用Owl-ViT很難從指令圖像中提取出「用戶想要什么」。

GPT-4o錯誤地嘗試找到最接近指令圖像的幀,而GPT-4V因無法找到包含飲料的幀而拒絕給出幀號。

最后,純文本方法無法理解「這個」是指可樂罐還是辦公室環境,因為它僅依賴于指令圖像的文字說明。

圖片

圖片

RQ3:拓撲圖對成功至關重要

- 拓撲圖對導航成功至關重要

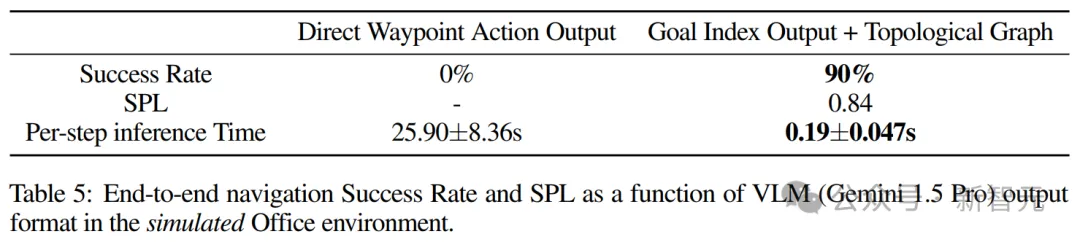

表5展示了Mobility VLA與直接提示VLM輸出路徑點動作相比,在模擬中的端到端表現。

0%的端到端成功率表明,如果沒有拓撲圖,Gemini 1.5 Pro無法在零樣本(Zero-shot)情況下導航機器人。而且,Gemini 1.5 API需要在每次推理調用時上傳所有948張圖像,導致每步運行時間高達26秒,而機器人僅移動1米。

相比之下,Mobility VLA的高層VLM需要花費10-30秒找到目標索引,然后機器人使用低層拓撲圖導航到目標,從而形成一個高度穩健且高效(每步0.19秒)的MINT解算系統。

圖片

圖片

谷歌的十年血淚史

「機器人時代已經到來,AI的下一波浪潮將是物理AI,機器人將日益融入我們的日常生活中,一切都將機器人化。」

老黃在6月的演講中已經預判了未來人形機器人發展的大好前景。

炫酷的賽博朋克風人形機器人正在吸引亞馬遜、谷歌、Nvidia和微軟等巨頭科技公司的密切關注和數億元的投資。

馬斯克也將特斯拉的未來押注在機器人上,預測機器人Optimus「擎天柱」可能會把市值推向25億美元。

「或許未來不到十年內,人們就可以給父母買一個機器人作為生日禮物了。」

馬斯克此話一出,想到自己頂著烈日取外賣、辛辛苦苦做家務或者滿世界找鑰匙的你是不是感覺腰桿一松?

其實,谷歌的機器人制造并不是一路順利。

早在2012到2013年間,谷歌就一口氣收購了包括波士頓動力在內的11家機器人公司。

當時,正是安卓系統創始人Andy Rubin在管理谷歌機器人產品線,意識到機器人發展前途無限的谷歌試圖加速AI機器人的商業布局。

在當時以軟件見長的谷歌在并不擅長的硬件領域,選擇用收購的方式來最大程度整合技術資源。

谷歌也一度認為,只要有了硬件基礎,再加以最拿手的軟件一結合,就能解決機器人領域的技術壁壘。

然而現實運作中卻殘酷地發現,機器人的運行準確度遠遠達不到要求。

比如你是一位公司大老板,一位成熟技工工作準確率能達到98%,而機器人只有不到90%。

這時你會選擇雇傭一位成熟技工還是購買昂貴且易出錯的機器人,并再雇傭一個人監督調整機器人的工作?

當前機器人的準確度可以達到80%-90%,為了最后的10%投入大量資金和人力,卻看不到回報。

Andy Rubin爆出丑聞后離開了谷歌,當初收購的企業也分崩離析,波士頓更是以低于當時收購估值三倍的價格賣出。

由此可見,軟件和硬件設施的制造以及兩者的結合,成為機器人制作領域最為頭疼的難題。

那么,在AI大模型熱潮之下,這是否會為機器人制造帶來曙光?有學習能力的機器人能否實現?

參考資料:

https://techcrunch.com/2024/07/11/watch-a-robot-navigate-the-google-deepmind-offices-using-gemini/

https://www.theverge.com/2024/7/11/24196402/google-deepmind-gemini-1-5-pro-robot-navigation