豆包大模型團隊發(fā)布全新Detail Image Caption評估基準,提升VLM Caption評測可靠性

當前的視覺語言模型(VLM)主要通過 QA 問答形式進行性能評測,而缺乏對模型基礎理解能力的評測,例如 detail image caption 性能的可靠評測手段。

針對這一問題,中科院、北大和字節(jié)豆包大模型團隊發(fā)布了 DetailCaps-4870 數(shù)據(jù)集,并提出了一種有效的評估指標 CAPTURE,取得了開源評估指標中最高的專家評價一致性,并低成本實現(xiàn)了與 GPT-Eval 可比的效果。

- 論文:https://arxiv.org/abs/2405.19092

- 數(shù)據(jù)集:https://huggingface.co/datasets/foundation-multimodal-models/DetailCaps-4870

- 代碼:https://github.com/foundation-multimodal-models/CAPTURE

簡介

當前的 LVLM(large vision-language model)評測存在以下問題:

- 現(xiàn)有的 LVLM 評測方案主要采用 VQA 形式,很大程度受到指令遵循(instruction following)能力的影響,且 QA prompt 的設計容易引入人類的偏見(bias)。

- Image caption 任務可以有效評估模型理解能力,但現(xiàn)有的 caption benchmark 多使用短 caption 作為 ground truth,這在 lvlm 時代完全過時。

- 同時,現(xiàn)有的 image caption 評測指標與人類、GPT 等專家評價結果的一致性較差,常用的 bleu、rouge 等指標抽取 n-gram 進行匹配,對關鍵信息的準確性不夠敏感。而 GPT-Eval 雖然和專家評價較為一致,但是會帶來高昂的評測成本。

針對這些問題,該研究提出了新的 Detail image caption benchmark 和 evaluation metric,以在較低的成本下實現(xiàn)了對 LVLM 圖像理解能力的準確評估。

在所提出的評測數(shù)據(jù)集 & 指標的指導下,該研究還探索了發(fā)掘 LVLM 自身能力進行 detail image caption 的數(shù)據(jù)構造方法,有效提升了 detail caption 數(shù)據(jù)質量。

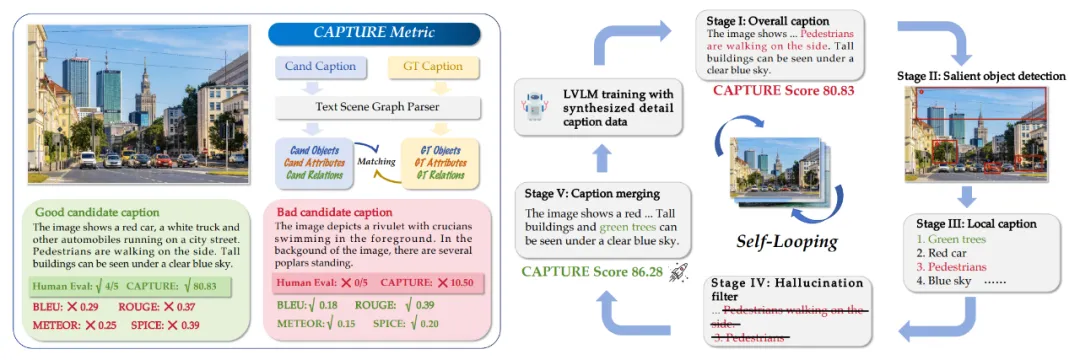

圖一:左側為 CAPTURE metric 實例展示,右側為 detail caption construction 方法展示

數(shù)據(jù)集

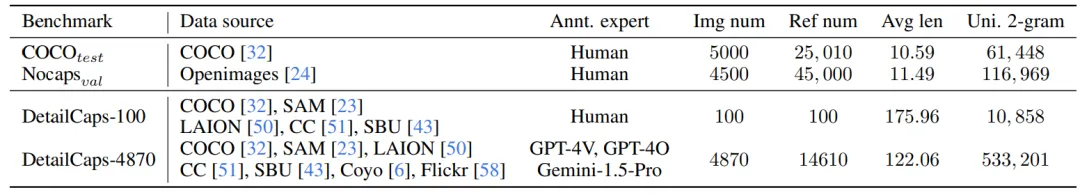

相比類似大小的評測數(shù)據(jù)集,該研究提出的 Detail image caption benchmark 文本長度更長,無重復的 2-gram 數(shù)量明顯更多,包含更豐富的視覺信息:

表一:DetailCaps benchmark 統(tǒng)計信息

評估指標

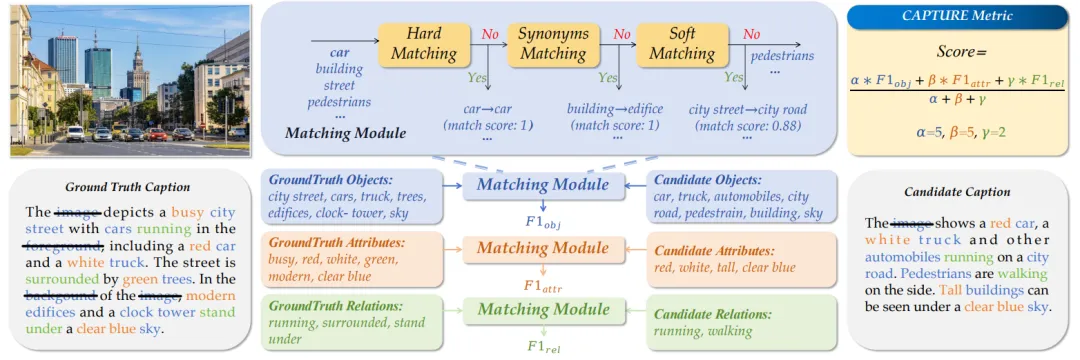

該研究所提出的 CAPTURE (CAPtion evaluation by exTracting and coUpling coRE information) 指標通過 4 步進行 caption 質量評估。如下圖所示,首先使用 Factual praser [1] 抽取 detail caption 中的 object, attribute, relation 元素,緊接著過濾掉沒有實際意義的 objects。之后,通過三階段匹配(精確匹配、近義詞匹配、embedding 匹配)分別計算 obj、attr、rel 元素的匹配得分(F1 分數(shù)),加權作為最終結果。

圖二:CAPTURE metric 詳細計算步驟

Detail caption 數(shù)據(jù)合成

在 DetailCaps benchmark 和 CAPTURE metric 的指導下,該研究提出了一種基于 divide-and-conquer 思想發(fā)掘 LVLM 潛力進行數(shù)據(jù)合成的方法,有效提升了 detail caption 數(shù)據(jù)質量。該方案首先使用 LVLM 進行全圖 caption 生成,之后使用分割模型(SAM [2])和聚類等過濾方法找到圖中的關鍵位置并將其裁剪出來進行局部 caption 生成。文章使用一種 word-level 的過濾方法來減少 caption 中的幻覺,該方法首先解析(parse)出描述圖中視覺元素的詞和短語,再通過目標檢測模型(Owlv2 [3])過濾掉得分低的元素。最后,將過濾后的全圖 caption、局部 caption 送入 LLM(LLaMA2 [4])融合為最終的圖像描述。

實驗

CAPTURE 指標

(1)CAPTURE vs 其他 caption 指標

該研究在 DetailCaps-100(人工標注 reference caption,人工評估模型生成 caption 得分)和 DetailCaps-4870(GPT 標注 reference caption,GPT-4 評估模型生成 caption 得分)上,對 LLaVA-1.5 [5]、CogVLM [6] 和 ShareCaptioner [7] 三個模型生成的 caption 進行了專家打分,并計算各個評估指標與專家評價的一致性:

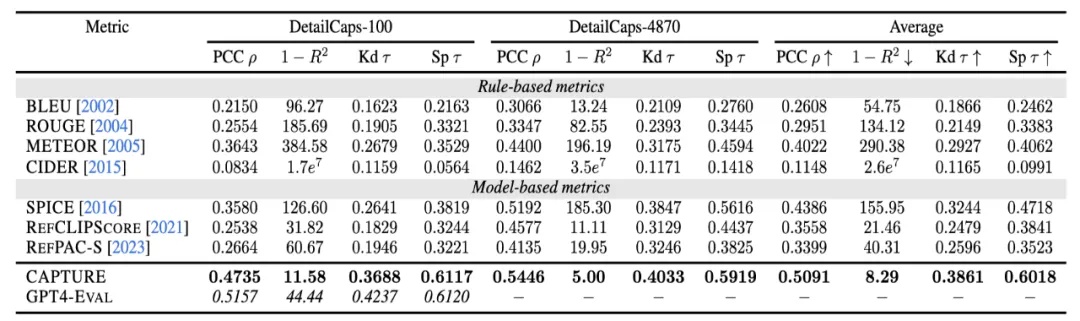

表二:CAPTURE 與其他 detail image caption 評估指標的專家評價一致性對比

各 caption 評估指標和專家評價的一致性通過 pearson correlation(線性相關性)、 R^2(絕對值大小)、 Kendall's tau(排序偏序對一致性)和 (Per-) Sample (Kendall's) tau(每個樣本單獨計算取平均)指標進行衡量。

結果顯示,CAPTURE 在各種指標上都取得了最優(yōu)的專家評價一致性。在這些指標中,Sample tau 與實際 detail image caption 評估的計算方式最為接近,CAPTURE 也是唯一在這個指標上取得與 GPT4-Eval 接近的方法,在評估的準確率、成本上取得了良好的平衡。

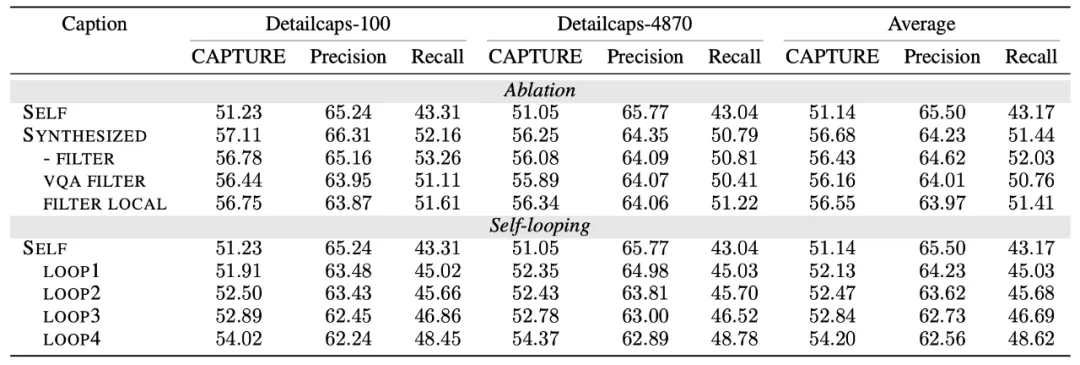

(2)消融分析

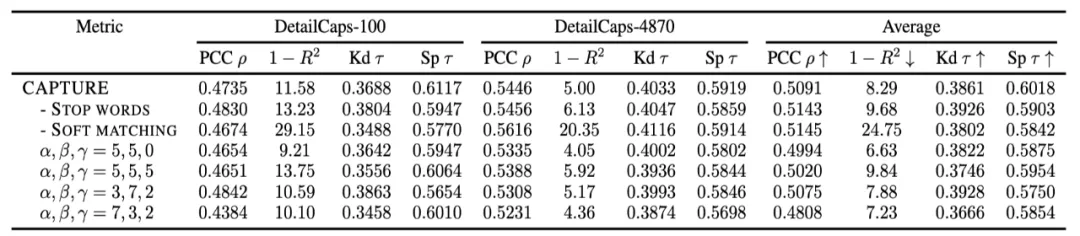

研究者還對 CAPTURE 中的各個模塊進行了消融分析,并驗證其有效性:

表三:CAPTURE 各模塊的消融分析

實驗結果顯示,Stop words 有效提升了 Sample tau,說明了該模塊的有效性。但是 stop words filtering 會對不同樣例的 detail caption 造成不同的影響,從而導致 pcc、kendall tau 微降。Soft matching 也提升了 sample tau,同時在 1-R2 分數(shù)上有明顯增益作用,將 CAPTURE 預測分數(shù)和專家打分的絕對分值對齊。在加權計算最終得分時,obj:attr:rel 比例取 default 的 5:5:2 最好,提升或降低各元素的比重都會造成性能下降。

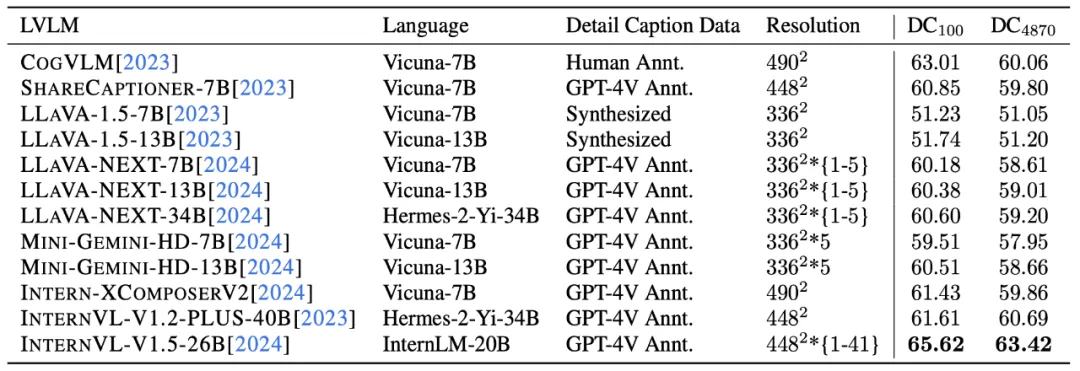

(3)開源 LVLM 的 detail caption 性能

表四:開源 LVLM 的 detail caption 性能對比

總體來看,InternVL-1.5 是當前表現(xiàn)最好的開源 LVLM。從 LLaVA、MiniGemini 結果可以看出,LLM 參數(shù)量的提升對模型 detail caption 能力有一致的提升作用。同時,分辨率較高、使用高質量 detail caption 進行訓練的模型,性能會更好。

Detail caption 數(shù)據(jù)構造

基于 detail caption 評估數(shù)據(jù)集和評測指標,研究者驗證了所提出的 detail caption 數(shù)據(jù)合成方案的有效性。

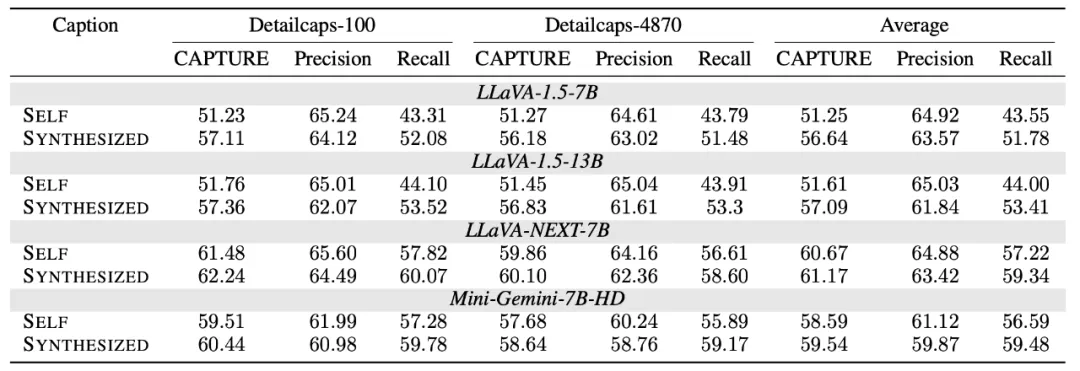

(1)Detail caption 合成方法在不同 LVLM 上的有效性

如下表所示,該研究提出的 detail caption 合成方法在 LLaVA-1.5-7B、LLaVA-1.5-13B、LLaVA-NEXT-7B 和 Mini-Gemini-7B-HD 上取得了一致的 detail caption 質量提升:

表五:不同 LVLM 使用該研究提出的 detail caption 合成方法效果

(2)通過 Self-loop 進一步提升 detail caption 性能

研究者還嘗試通過數(shù)據(jù)打標 -> 模型訓練 -> 重新打標的訓練流程進行 Self-loop 來進一步提升 LVLM detail caption 性能,在四輪 loop 中都取得了正面效果。同時,對比開源方案 [8] 與本文所提出的 word-level 幻覺過濾方案,證明了其設計的有效性:

表六:Detail caption 合成方案的 self-looping 效果和消融分析

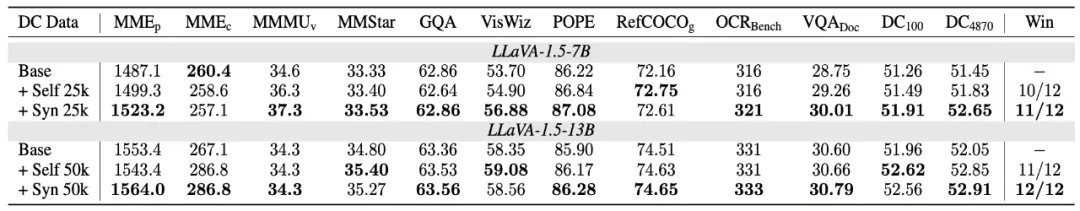

(3)LVLM 自身打標的 detail caption 可提升其整體性能

該研究使用 LLaVA-1.5 按照給出的 detail caption 構造方案對 sharegpt4v-100k 數(shù)據(jù)進行了重新打標,并將打標數(shù)據(jù)用于 LLaVA-1.5 的 SFT 訓練,在多個 benchmark 上取得了一致的性能提升:

表七:合成 detail caption 數(shù)據(jù)在 LLaVA-1.5-7B 模型訓練中的作用