LLama+Mistral+…+Yi=? 免訓練異構大模型集成學習框架DeePEn來了

本文的主要作者為黃毅翀。黃毅翀是哈爾濱工業大學社會計算與信息檢索研究中心博士生,鵬城實驗室實習生,師從秦兵教授和馮驍騁教授。研究方向包括大語言模型集成學習、多語言大模型,相關論文發表于自然語言處理頂級會議 ACL、EMNLP、COLING。

隨著大語言模型展現出驚人的語言智能,各大 AI 公司紛紛推出自己的大模型。這些大模型通常在不同領域和任務上各有所長,如何將它們集成起來以挖掘其互補潛力,成為了 AI 研究的前沿課題。

近期,哈工大和鵬城實驗室的研究人員提出了「Training-free 的異構大模型集成學習框架」DeePEn。

不同于以往方法訓練外部模塊來篩選、融合多個模型生成的回復,DeePEn 在解碼過程中融合多個模型輸出的概率分布,聯合決定每一步的輸出 token。相較而言,該方法不僅能快速應用于任何模型組合,還允許被集成模型訪問彼此的內部表示(概率分布),實現更深層次的模型協作。

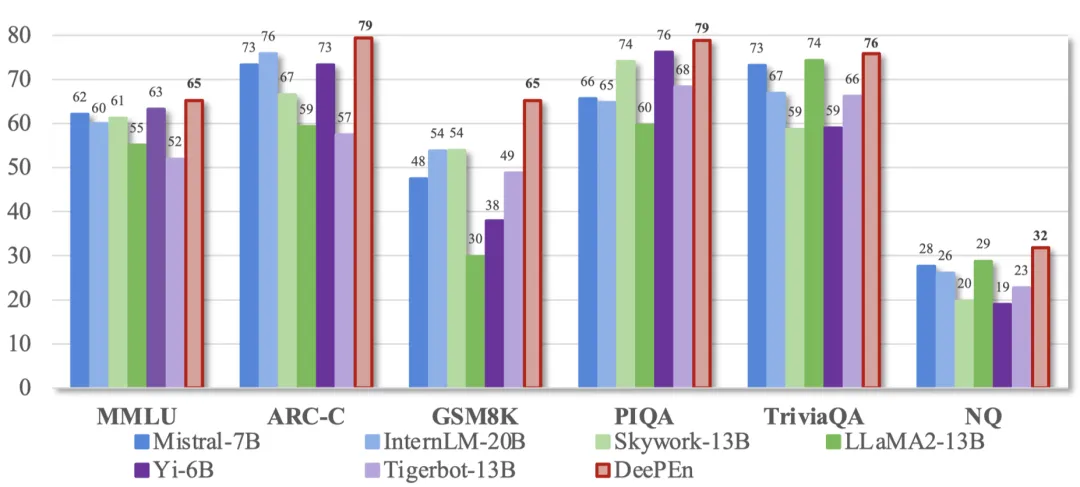

結果表明, DeePEn 在多個公開數據集上均能取得顯著提升,有效擴展大模型性能邊界:

目前論文及代碼均已公開:

- 論文標題:Ensemble Learning for Heterogeneous LargeLanguage Models with Deep Parallel Collaboration

- 論文地址:https://arxiv.org/abs/2404.12715

- 代碼地址:https://github.com/OrangeInSouth/DeePEn

方法介紹

異構大模型集成的核心難點在于如何解決模型間的詞表差異問題。為此,DeePEn 基于相對表示理論,構建由多個模型詞表之間的共享 token 構成的統一相對表示空間。在解碼階段,DeePEn 將不同大模型輸出的概率分布映射到該空間進行融合。全程無需參數訓練。

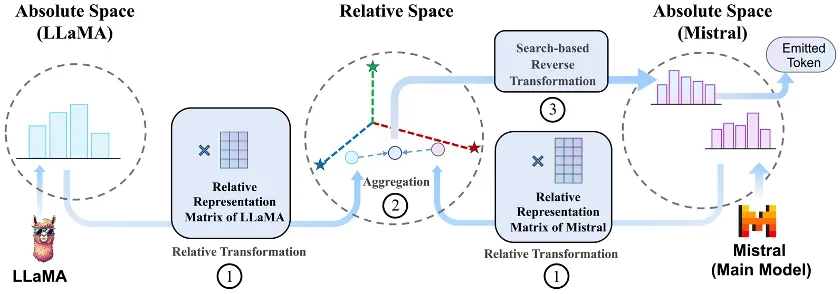

下圖中展示了 DeePEn 的方法。給定 N 個模型進行集成,DeePEn 首先構建它們的轉換矩陣(即相對表示矩陣),將來自多個異構絕對空間的概率分布映射到統一的相對空間中。在每個解碼步驟中,所有模型進行前向計算并輸出 N 個概率分布。這些分布被映射到相對空間并進行聚合。最后,聚合結果被轉換回某個模型(主模型)的絕對空間,以確定下一個 token。

圖 1:方法示意圖。其中,相對表示轉換矩陣是通過計算詞表中每個 token 與模型間共享的錨點 token 之間的詞嵌入相似度得到的。

構建相對表示轉換

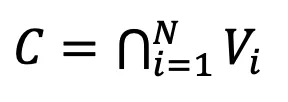

給定 N 個要集成的模型,DeePEn 首先找出所有模型詞表的交集,即共享詞集 ,并從中抽取一個子集 A?C 或使用全部共享詞作為錨點詞集合 A=C。

,并從中抽取一個子集 A?C 或使用全部共享詞作為錨點詞集合 A=C。

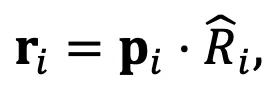

對于每個模型 ,DeePEn 計算詞表中每個 token 與錨點 token 的嵌入相似度,得到相對表示矩陣

,DeePEn 計算詞表中每個 token 與錨點 token 的嵌入相似度,得到相對表示矩陣 。最后,為了克服離群詞的相對表示退化問題,論文作者對相對表示矩陣進行行歸一化,通過對矩陣的每一行進行 softmax 操作,得到歸一化相對表示矩陣

。最后,為了克服離群詞的相對表示退化問題,論文作者對相對表示矩陣進行行歸一化,通過對矩陣的每一行進行 softmax 操作,得到歸一化相對表示矩陣 。

。

相對表示融合

在每個解碼步驟中,一旦模型 輸出概率分布

輸出概率分布 ,DeePEn 使用歸一化相對表示矩陣將

,DeePEn 使用歸一化相對表示矩陣將 轉換為相對表示

轉換為相對表示 :

:

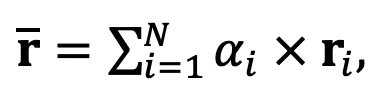

并將所有相對表示進行加權平均以獲得聚合的相對表示:

其中 是模型

是模型 的協作權重。作者嘗試了兩種確定協作權重值的方法:(1) DeePEn-Avg,對所有模型使用相同的權重;(2) DeePEn-Adapt,根據各個模型的驗證集性能成比例地為每個模型設置權重。

的協作權重。作者嘗試了兩種確定協作權重值的方法:(1) DeePEn-Avg,對所有模型使用相同的權重;(2) DeePEn-Adapt,根據各個模型的驗證集性能成比例地為每個模型設置權重。

相對表示逆映射

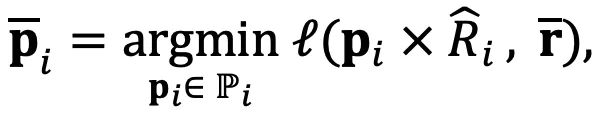

為了根據聚合的相對表示決定下一個 token,DeePEn 將其從相對空間轉換回主模型(開發集上性能最好的模型)的絕對空間。為了實現這種逆轉換,DeePEn 采用了基于搜索的策略,找出相對表示與聚合后的相對表示相同的絕對表示:

其中 表示模型

表示模型 的絕對空間,

的絕對空間, 是衡量相對表示之間距離的損失函數(KL 散度)。

是衡量相對表示之間距離的損失函數(KL 散度)。

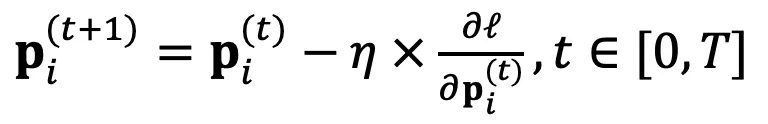

DeePEn 利用損失函數 相對于絕對表示

相對于絕對表示 的梯度來指導搜索過程,并迭代地進行搜索。具體來說,DeePEn 將搜索的起始點

的梯度來指導搜索過程,并迭代地進行搜索。具體來說,DeePEn 將搜索的起始點 初始化為主模型的原始絕對表示,并進行更新:

初始化為主模型的原始絕對表示,并進行更新:

其中 η 是稱為相對集成學習率的超參數,T 是搜索迭代步數。

最后,使用更新后的絕對表示 來確定下一步輸出的 token。

來確定下一步輸出的 token。

實驗

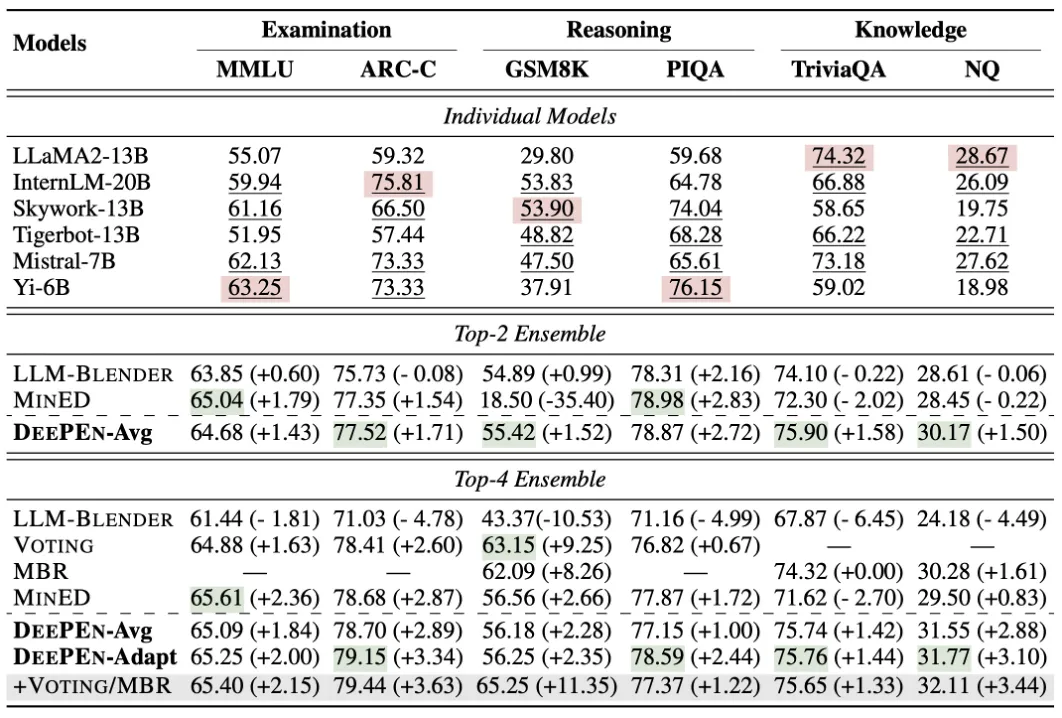

表 1:主實驗結果。第一部分為單模型的性能,第二部分為分別對每個數據集上的 top-2 模型進行集成學習,第三部分為 top-4 模型集成。

通過實驗,論文作者得出了以下結論:

(1) 大模型在不同任務上各有所長。如表 1 所示,不同大模型在不同數據集上的表現存在顯著差異。例如 LLaMA2-13B 在知識問答 TriviaQA 和 NQ 數據集上取得了最高的結果,但是其他四個任務上的排名并未進入前四。

(2) 分布融合在各個數據集上取得了一致性的提升。如表 1 所示,DeePEn-Avg 和 DeePEn-Adapt 在所有數據集上均取得了性能提升。在 GSM8K 上,通過與投票法組合使用,最終取得了 + 11.35 的性能提升。

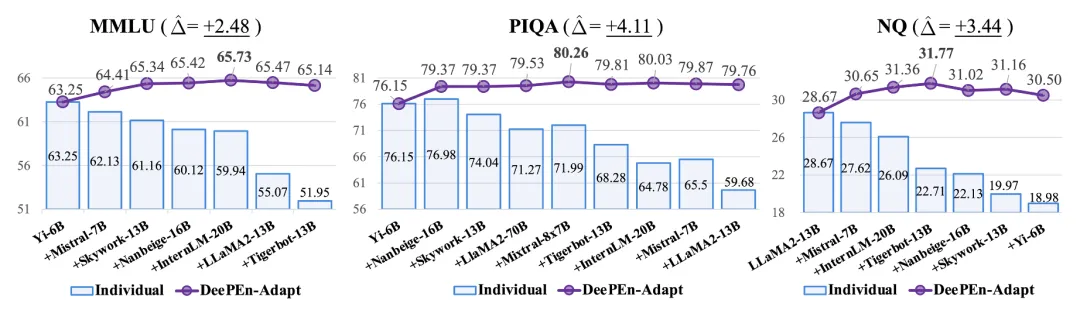

表 2:不同模型數量下的集成學習性能。

(3) 隨著集成模型數量的增加,集成性能先增后減。作者在根據模型性能由高到低,依次將模型加入集成,然后觀察性能變化。如表 2 所示,不斷引入性能較差的模型,集成性能先增后減。

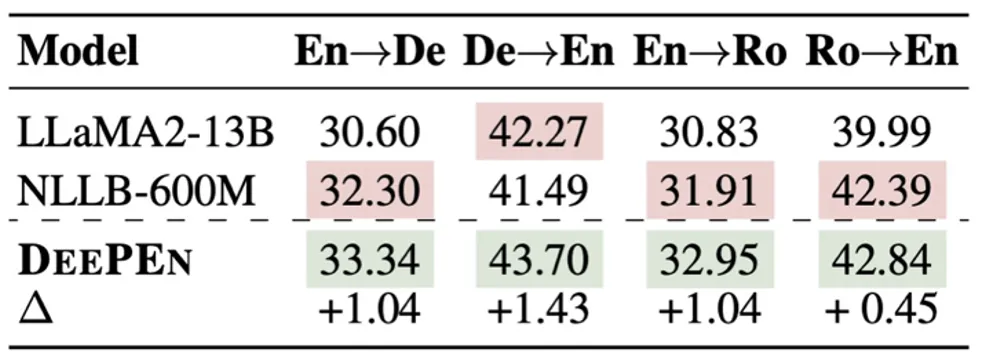

表 3:在多語言機器翻譯數據集 Flores 上,大模型與翻譯專家模型之間的集成學習。

(4) 集成大模型與專家模型有效提升特定任務性能。作者還在機器翻譯任務上對大模型 LLaMA2-13B 和多語言翻譯模型 NLLB 進行集成。如表 3 所示,通用大模型與任務特定的專家模型之間的集成,可以顯著提升性能。

結論

當前的大模型層出不窮,但很難有一個模型能在所有任務上全面碾壓其他模型。因此,如何利用不同模型之間的互補優勢,成為一個重要的研究方向。本文介紹的 DeePEn 框架,解決了不同大模型在分布融合時的詞表差異問題,且無需任何參數訓練。大量實驗表明,DeePEn 在不同任務、不同模型數量及不同模型架構的集成學習設置中,均取得了穩定的性能提升。