免訓練大模型知識編輯,吸收新數據更高效|EMNLP'24

讓大模型能快速、準確、高效地吸收新知識!

被EMNLP 2024收錄的一項新研究,提出了一種檢索增強的連續提示學習新方法,可以提高知識終身學習的編輯和推理效率。

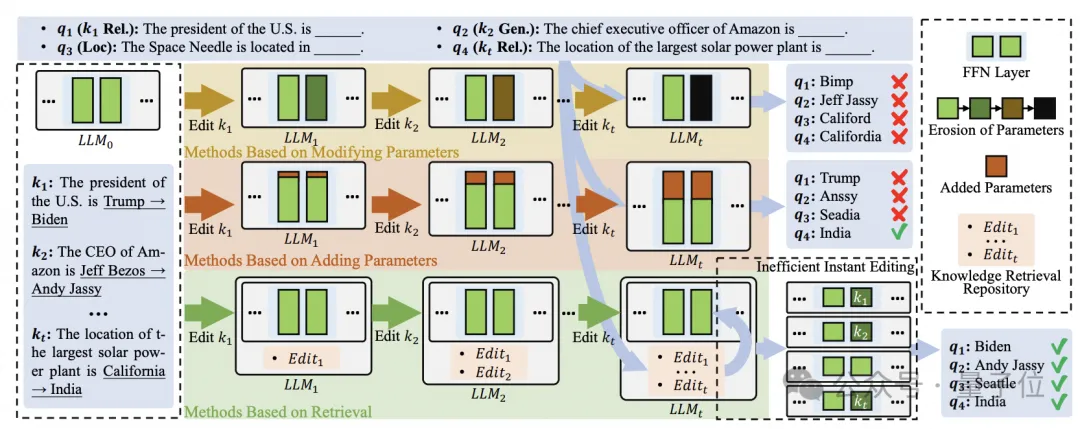

模型編輯旨在糾正大語言模型中過時或錯誤的知識,同時不需要昂貴的代價進行再訓練。終身模型編輯是滿足LLM持續編輯要求的最具挑戰性的任務。

之前的工作主要集中在單次或批量編輯上,由于災難性的知識遺忘和模型性能的下降,這些方法在終身編輯場景中表現不佳。盡管基于檢索的方法緩解了這些問題,但它們受到將檢索到的知識集成到模型中的緩慢而繁瑣的過程的阻礙。

而名為RECIPE的最新方法,它首先將知識描述轉換為簡短且信息豐富的連續提示的token表示,作為LLM輸入查詢嵌入的前綴,有效地細化基于知識的生成過程。

它還集成了知識哨兵機制,作為計算動態閾值的媒介,確定檢索庫是否包含相關知識。

檢索器和提示編碼器經過聯合訓練,以實現知識編輯屬性,即可靠性、通用性和局部性。

在多個權威基座模型和編輯數據集上進行終身編輯對比實驗,結果證明了RECIPE性能的優越性。

這項研究由阿里安全內容安全團隊與華東師范大學計算機科學與技術學院、阿里云計算平臺針對大語言模型知識編輯的聯合推出。

研究背景

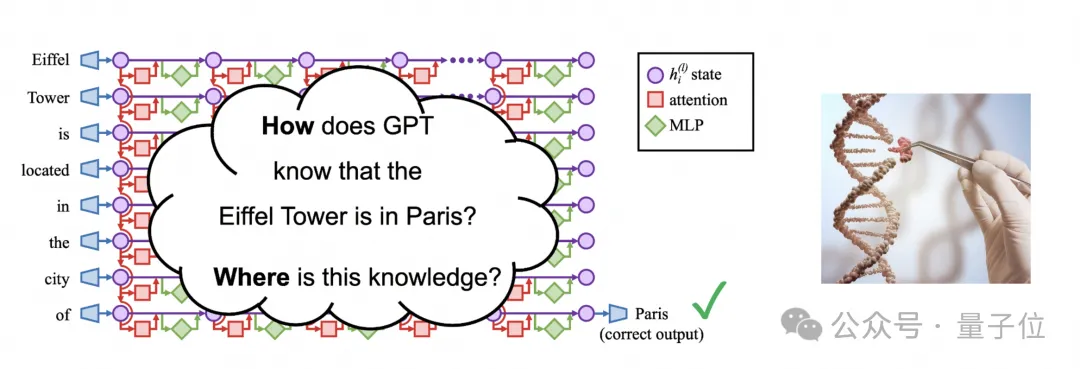

即使有非常強大的語言理解能力,像ChatGPT這樣的大型語言模型(LLM)也并非沒有挑戰,特別是在保持事實準確性和邏輯一致性方面。

一個重要的問題是,是否能夠有效地更新這些LLM以糾正不準確之處,而無需進行全面的繼續預訓練或持續訓練過程,這些操作帶來的機器資源開銷大且耗時。

編輯LLM模型提供了一種有前景的解決方案,允許在特定感興趣的模型中進行修改,同時在各任務中保持模型整體性能。

之前各種知識編輯的模型方法和架構包括類似于:修改模型內部參數、增加額外參數和基于檢索方法都會有冗長的編輯前綴影響推理效率。對模型本身進行微調可能會導致過擬合,從而影響其原始性能。

為了解決上述問題,研究人員期望探索更有效的檢索和即時編輯方式,以及對模型進行更小的干預,以避免在編輯數據集上過度擬合。

模型方法

知識編輯相關背景

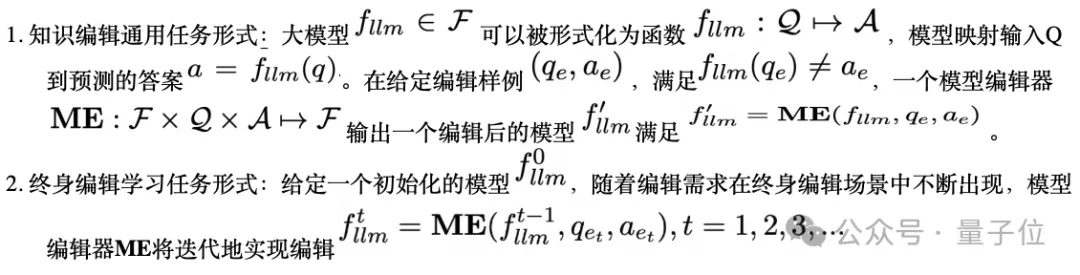

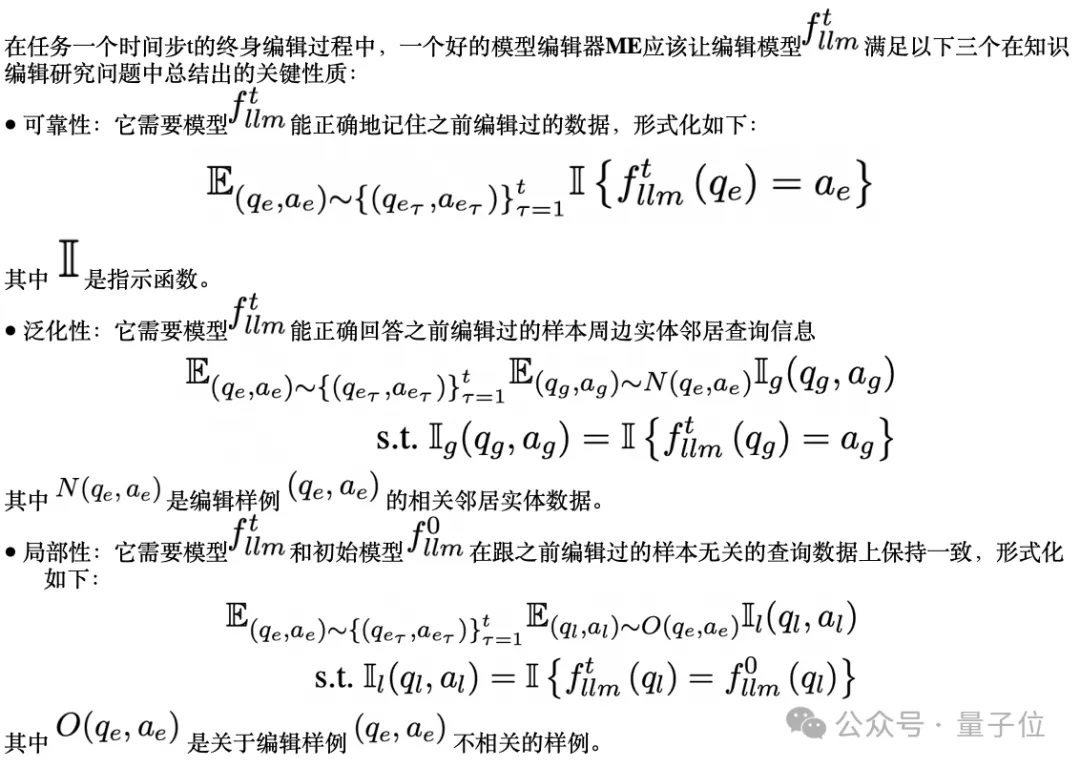

在本文中,研究團隊首先形式化模型編輯任務在終身學習場景中的任務定義形式,然后介紹模型編輯中的重要評估屬性。

任務定義

任務屬性

RECIPE終身編輯方法

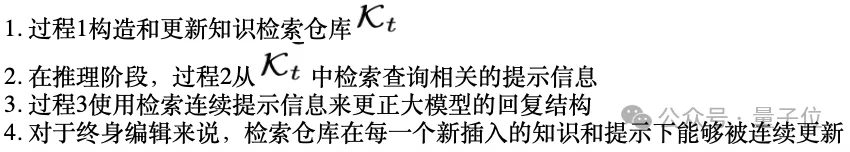

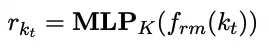

總體模型框架如下:

構造和更新知識檢索倉庫

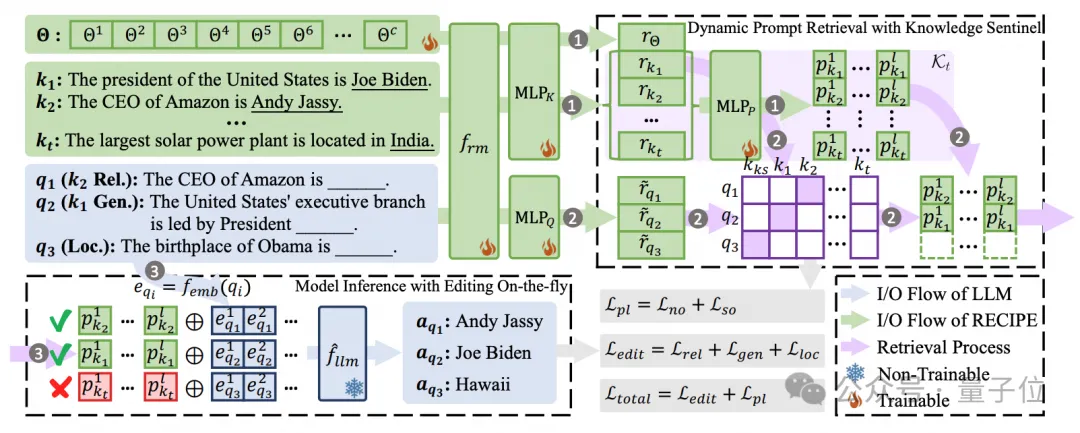

在第t個時間步,給定一個新的知識描述kt,則新知識表示通過編碼器frm中的MLP層可以獲得:

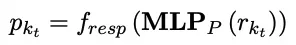

其中frm編碼器將輸出token表示的最大、最小、平均的池化級聯到一個向量空間中作為新知識表示。然后連續prompt表示pkt可以被其他初始化的MLP層實現:

最終知識檢索倉庫被從Kt-1更新到Kt

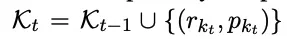

基于知識哨兵的動態prompt檢索

動態編輯模型的推理

研究人員認為LLM將被編輯為:

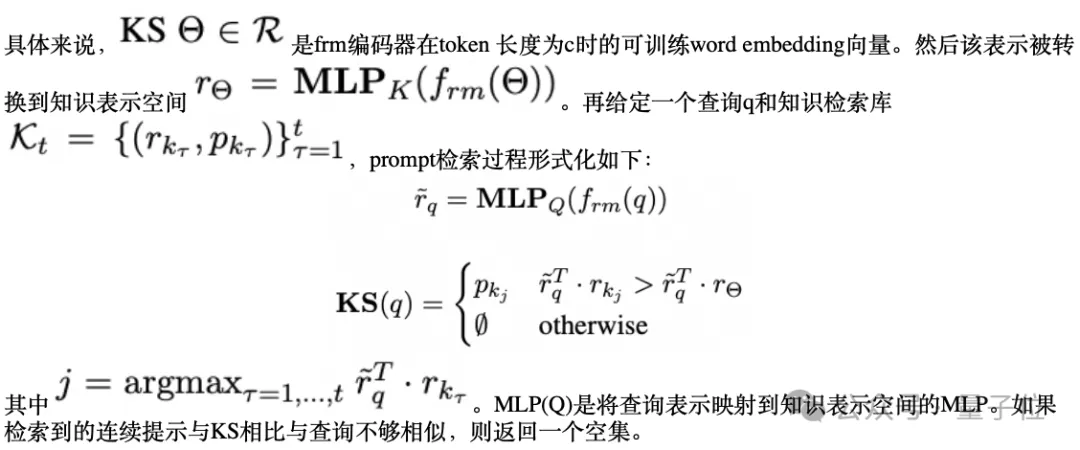

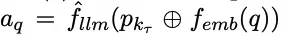

給定輸入查詢q和連續檢索prompt p(kr) = KS(q), 推理過程可以被重新形式化為:

其中⊕表示檢索到的連續提示矩陣和q的單詞嵌入矩陣的連接。

本文方法的可行性得到了P-Tuning等先前工作的支持,該工作證明了訓練連續提示嵌入可以提高LLM在下游任務上的性能有效性。

在RECIPE中,研究人員將每個知識陳述的編輯視為一項小任務,沒有為每個小任務微調特定的提示編碼器,而是通過訓練生成連續提示的RECIPE模塊來實現這些小任務的目標,確保LLM遵守相應的知識。

模型訓練

制定損失是為了確保對生成的連續提示進行編輯,并有效檢索LLM的查詢相關知識。給定包含b個編輯樣例的訓練數據:

對應的泛化性和局部性數據為:

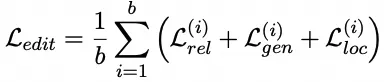

因此損失形式化如下:

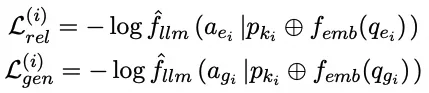

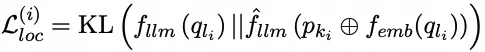

- 編輯損失訓練:編輯損失旨在確保生成的連續提示引導LLM遵循可靠性、通用性和局部性的特性。基于輸入的編輯數據,對應于這三個屬性的樣本損失定義如下:

模型編輯的批量損失函數推導如下:

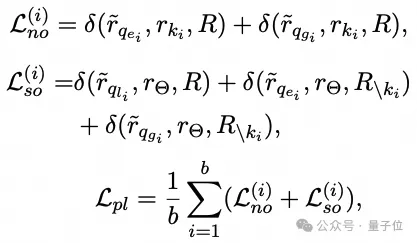

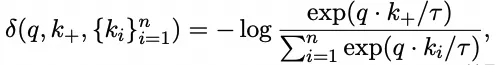

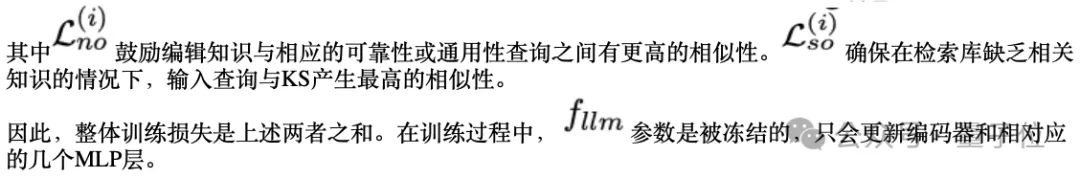

- prompt損失訓練:prompt學習的訓練損失是基于對比學習,并與可靠性、通用性和局部性的特性相一致。對于一批樣本,學習連續提示的損失函數形式化如下:

實驗結果

實驗設置

- 測試編輯能力的數據集:研究人員使用了三個公共模型編輯數據集,包括ZSRE、CounterFact(CF)和Ripple Effect(RIPE)作為實驗數據集。

ZSRE是通過BART問答和手動過濾生成的,包括162555個訓練和19009個測試樣本。每個樣本包括一個編輯樣本及其改寫和不相關的對應樣本,與可靠性、通用性和局部性編輯屬性相匹配。

CF數據集的特點是編輯虛假事實,包括10000個訓練樣本和10000個測試樣本。這些虛假事實更有可能與LLM中的原始知識相沖突,使編輯過程更具挑戰性,從而對編輯執行的能力進行強有力的評估。

RIPE將通用性和局部性屬性分為細粒度類型,包括3000個訓練樣本和1388個測試樣本。每個樣本的一般性包括邏輯泛化、組合I、組合II和主題混疊,而局部數據則包括遺忘和關系特異性。

- 測試通用能力的數據集:為了評估編輯對LLM總體性能的損害,研究人員選擇了四個流行的基準來評估LLM的總體通用能力。分別是用于評估常識知識的CSQA、用于推理能力的ANLI、用于衡量考試能力的MMLU和用于理解技能的SQuAD-2。PromptBench被用作本實驗的評估框架。

- 模型baseline:除了微調(FT)作為基本基線外,研究人員還將RECIPE方法與各種強大的編輯基線進行了比較。

MEND訓練MLP,以轉換要編輯的模型相對于編輯樣本的梯度的低秩分解。ROME首先使用因果中介分析來定位對編輯樣本影響最大的層。MEMIT基于ROME將編輯范圍擴展到多層,從而提高了編輯性能并支持批量編輯。T-Patcher(TP)在要編輯的模型最后一層的FFN中附著并訓練額外的神經元。MALMEN將參數偏移聚合表述為最小二乘問題,隨后使用正態方程更新LM參數。WILKE根據編輯知識在不同層之間的模式匹配程度來選擇編輯層。

研究人員還利用基于檢索的編輯方法來進一步驗證其有效性。

GRACE提出了用于連續編輯的檢索適配器,它維護一個類似字典的結構,為需要修改的潛在表示構建新的映射。RASE利用事實信息來增強編輯泛化,并通過從事實補丁存儲器中檢索相關事實來指導編輯識別。

在基線設置中,研究人員使用ROME模型作為RASE的特定基本編輯器來執行名為R-ROME的編輯任務。LTE激發了LLM遵循知識編輯指令的能力,從而使他們能夠有效地利用更新的知識來回答查詢。

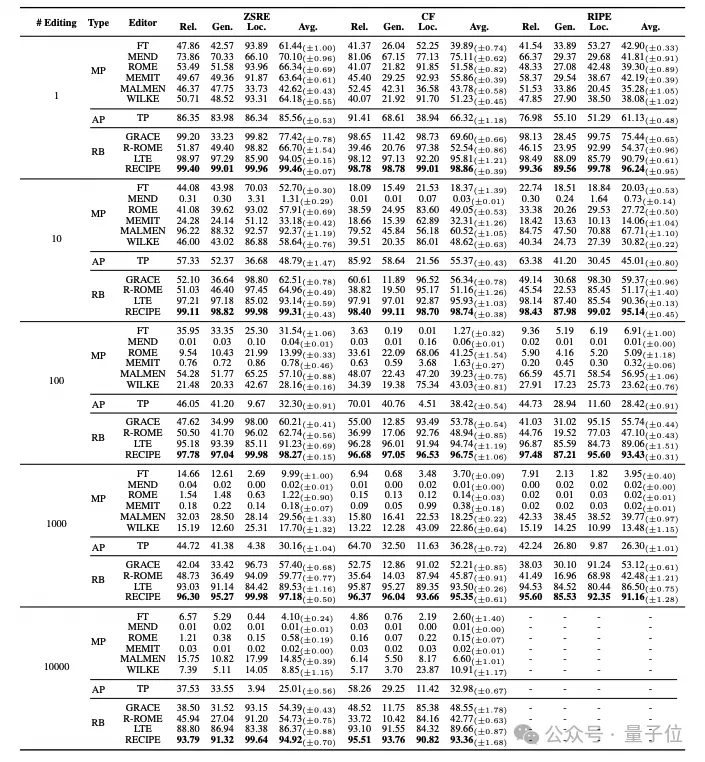

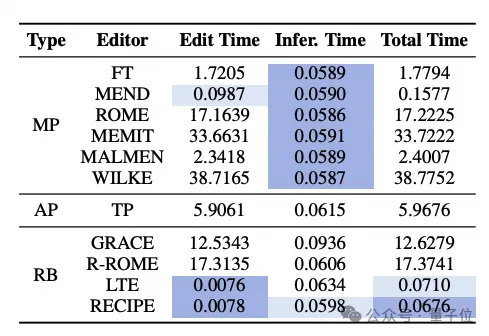

編輯能力的實驗效果

下面兩個表格分別表示在LLAMA2和GPT-J模型上的編輯效果對比。

從單次編輯的角度來看,本文方法在大多數測試場景中表現出最佳性能。

在終身編輯場景中,研究人員有以下觀察結果:

- 修改LLM參數的方法在單次編輯中顯示出出色的編輯性能。然而,隨著編輯次數的增加,它們的編輯性能顯著下降。這一趨勢與已有工作強調的毒性積累問題相一致;

- 引入額外參數的方法在終身編輯過程中保持了一定程度的可靠性和通用性。然而,在ZSRE中觀察到的局部性明顯惡化證明,額外參數的累積添加會損害原始推理過程;

- 基于檢索的方法對越來越多的編輯表現出魯棒性。其中,本文方法取得了最好的結果,肯定了檢索的優勢,也驗證了策略的有效性。

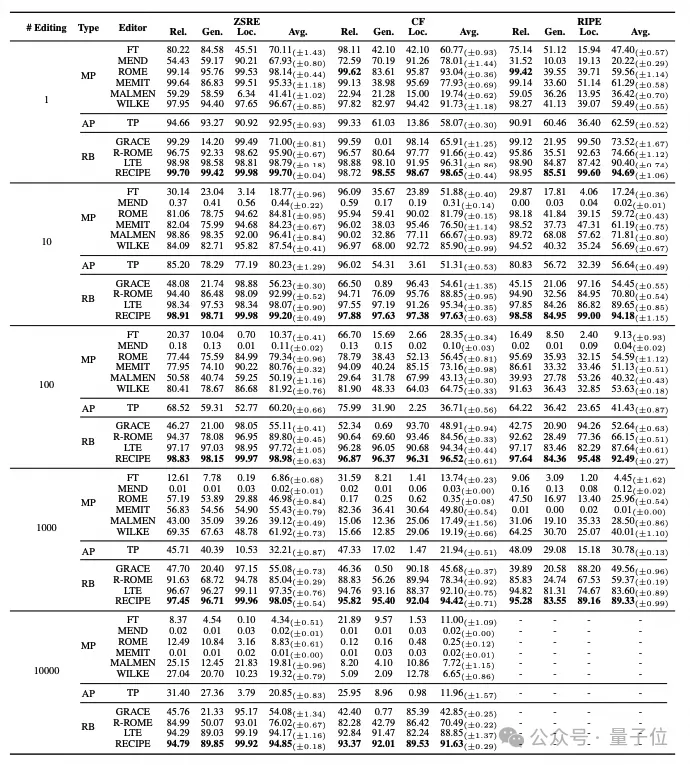

通用能力的實驗效果

雖然這三個編輯指標有效地展示了編輯性能,但研究人員進一步研究了這些編輯器在多大程度上影響了模型的通用能力。

通過實驗可以看出,非基于檢索的方法會導致通用能力的顯著降低。這可以歸因于編輯的外部干預造成的模式不匹配的累積。在基于檢索的方法中,LTE也表現出性能下降。

相比之下,RECIPE不涉及對LLM參數的直接干預,而是依賴于連接一個簡短的提示來指導LLM對知識的遵守。它展示了對通用性能的最佳保護,表明它對模型造成的傷害最小。

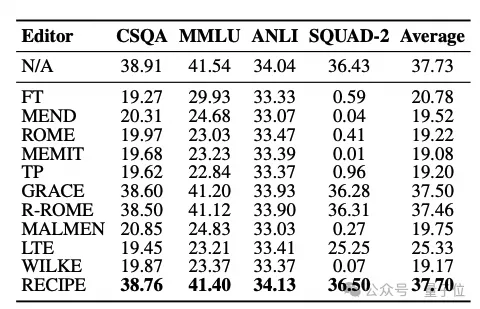

模型編輯效率對比

通過下方表格可以看出,在利用MEND、MALMEN、LTE和RECIPE等編輯特定訓練的方法中,與在編輯過程中需要多次迭代反向傳播的技術相比,編輯時間顯著減少。

對于推理速度,修改模型參數的方法保持一致的速度,因為它們不會改變原始的推理pipeline。T-Patcher由于神經元的積累而減慢了推理速度。

在基于檢索的方法中,GRACE由于其獨特的字典配對機制,降低了模型推理的并行性。R-ROME和LTE需要動態計算編輯矩陣并分別連接長編輯指令。

相比之下,RECIPE通過連接連續的短提示進行編輯,有效地保留了LLM的原始推理速度。最短的總時間也突顯了RECIPE的效率優勢。

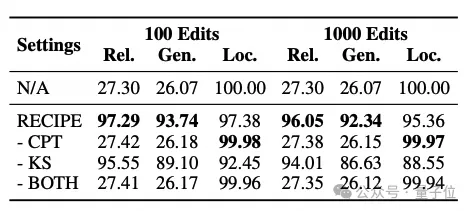

消融實驗效果對比

研究人員使用LLAMA-2對ZSRE、CF和RIPE進行消融研究。在沒有CPT的情況下,研究人員求助于使用知識語句的單詞嵌入作為從知識庫中檢索的提示。排除KS涉及應用傳統的對比學習損失,使可靠性和通用性樣本表示更接近編輯知識,同時與局部樣本的表示保持距離。

在訓練完成后,研究人員采用絕對相似性閾值決策策略來過濾無關知識。盡管局部性很高,但省略CPT會嚴重損害RECIPE的可靠性和通用性。

可以觀察到,結果與完全不使用編輯器獲得的結果幾乎相同。

這強調了僅使用原始連接的知識前綴無法使LLM符合編輯指令。相反,CPT有助于LLM遵守指定的編輯。此外,丟棄KS會導致編輯效率下降,特別是影響普遍性和局部性。原因是絕對相似性閾值無法充分解決不同查詢所需的不同閾值。