對比學習濫用隱私數據!中科院等發布「多步誤差最小化」方法 | ACM MM2024

多模態對比學習(如CLIP)通過從互聯網上抓取的數百萬個圖像-字幕對中學習,在零樣本分類方面取得了顯著進展。

然而,這種依賴帶來了隱私風險,因為黑客可能會未經授權地利用圖像-文本數據進行模型訓練,其中可能包括個人和隱私敏感信息。

最近的工作提出通過向訓練圖像添加難以察覺的擾動來生成不可學習樣本(Unlearnable Examples),可以建立帶有保護的捷徑.

然而,這些方法是為單模態分類任務設計的,在多模態對比學習中仍未得到充分探索。本文首通過評估現有方法在圖像-標題對上的性能來探索這一背景,由于在該場景中缺乏標簽,之前的無法有效地推廣到多模態數據,并且在建立捷徑方面的效果有限。

在本文中提出了多步誤差最小化(MEM),這是一種用于生成多模態不可學習樣本的新穎優化過程。它擴展了誤差最小化(EM)框架,以優化圖像噪聲和額外的文本觸發器,從而擴大了優化空間,并有效地誤導模型學習噪聲特征和文本觸發器之間的捷徑。

論文鏈接: https://arxiv.org/abs/2407.16307

代碼鏈接: https://github.com/thinwayliu/Multimodal-Unlearnable-Examples

具體來說,采用投影梯度下降來解決噪聲最小化問題,并使用HotFlip方法來近似梯度和替換單詞,以找到最佳的文本觸發器。

大量實驗證明了方法的有效性,保護后的檢索結果幾乎是隨機猜測的一半,并且它在不同模型之間具有高度的遷移性。本篇工作的論文和代碼均已開源。

研究背景

近年來,隨著多模態學習的興起,研究者們對結合文本、圖像和音頻等多種數據類型的模型產生了濃厚的興趣。

其中,多模態對比學習成為了這一領域的重要方法,如CLIP和ALIGN等模型利用對比損失訓練,以增強圖像和文本的相關性,進而減少人工標注的需求,并展示了在圖像分類、生成等任務中的潛力。

然而,這些模型的訓練依賴于大量的多模態數據,這些數據常常來自公開的數據集,如CC12M、YFCC100M和LAION5B,但這些數據集可能仍然不足,且可能包含大量敏感的個人信息,引發了對隱私泄露的擔憂。

我們考慮了一個專注于生成多模態不可學習樣本以應對與多模態對比學習相關的隱私風險的場景。在這種場景下,我們專注于圖像-文本對作為代表性的多模態數據集。假設用戶經常在社交媒體平臺(如Facebook)上分享帶有文本的個人照片,包括一些私人身份信息,如面孔、姓名、電話號碼和地址。

目前,黑客試圖從互聯網上收集大量此類圖像-文本對,并利用多模態對比學習技術訓練或微調大模型,如圖1的左半部分所示。

這些模型無意中捕獲了用戶的私人信息和面部特征,導致潛在的隱私泄露。保護者旨在通過對多模態數據進行不可學習的方法來防止這些敏感數據被未經授權利用。這些方法使在這種多模態不可學習樣本上訓練的模型無法訪問用戶的隱私特征,同時不妨礙用戶在發布圖像和文本后的社交互動,如圖1的右半部分所示。

圖1:Facebook上的帖子無意中會泄露了個人信息(如圖左),但利用多模態不可學習樣本可以保護數據可以防止未經授權的模型訪問私人特征(如圖右)

動機

最近的研究致力于通過不可學習樣本(Unlearnable Examples)來防止圖像分類中的數據未經授權使用。這些方法通過對數據施加細微擾動來阻礙模型學習圖像特征,也被稱為可用性攻擊(availability attacks)或無差別的中毒攻擊(indiscriminate poisoning attacks)。

它主要分為無代理模型攻擊和基于代理模型的攻擊,其中無代理模型攻擊通過在像素級別生成噪聲,而基于代理模型的攻擊則通過代理模型生成特征級別的噪聲。

然而,所有用于分類的無代理模型方法在多模態場景下都無法生成圖像噪聲,因為這些方法旨在為與某個特定類別相關的圖像找到一系列特定的噪聲模式,而圖像-文本對數據中沒有標簽。

因此,只有基于代理模型的方法可以應用,我們擴展了兩種典型的方法來生成不可學習的多模態示例(EM和UAP)。

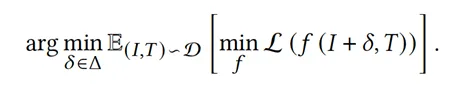

The Error-minimizing Noise(EM)方法:

Untargeted Adversarial Perturbation.(UAP)方法:

盡管EM和UAP可以應用于圖像-字幕對,但它們未能實現高效的保護,尤其是UAP。我們探討了這些方法從圖像分類到多模態對比學習有效性下降的原因。

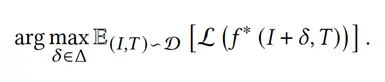

在圖像分類中,EM和UAP優化具有相同標簽的圖像,使其在特征空間中收斂,導致模型容易捕獲這些附加噪聲并學習與標簽的相關性,如圖2(a)所示。

圖2:不同方法在傳統分類和多模態對比學習中的比較。??表示圖像,??是配對的標題。藍色區域是在不可學習樣本上訓練的模型的預期決策邊界

但在多模態對比學習中,為了有效地應用EM和UAP方法,優化的圖像噪聲的方向必須與文本的特征相關,導致圖像特征變得要么接近要么遠離這些特征。

然而,不同對的文本特征可能在圖像–文本數據集中廣泛分散。如圖2(b)和(c)所示,與分類不同,模型更難捕捉字幕和EM和UAP生成的噪聲之間的相關性。

在圖2(c)中,UAP的學習決策空間更加復雜,因此其保護效果不佳。

方法

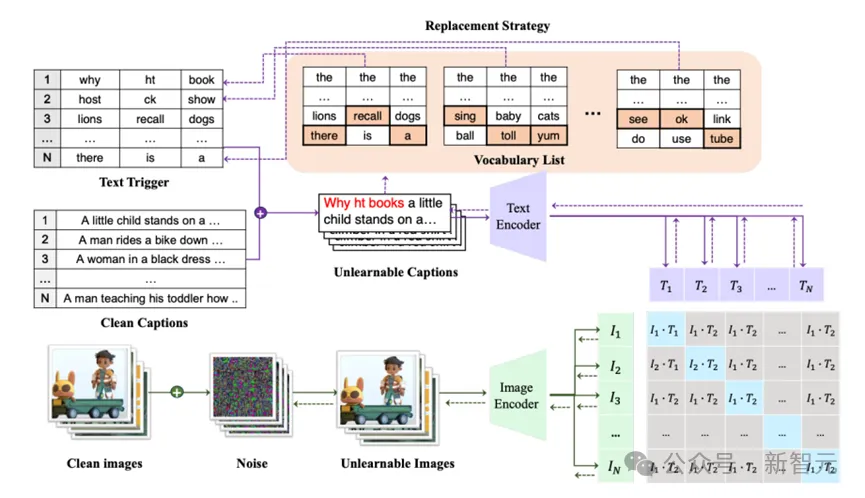

圖3:多步誤差最小化方法(MEM)的框架

由于圖像-文本對的分散,基于代理模型的方法仍然無法實現有效的保護。一個直觀的增強策略是同時優化圖像和文本,以獲得更大的優化空間,促進它們在特征空間中不同對的收斂。

因此,圖像和文本集的優化特征表示呈現出相似的分布,便于模型學習它們的捷徑,如圖2(d)所示。

為此,我們以EM方法為基本框架,并提出在字幕前添加額外的短文本觸發器來最小化對比損失,遵循對文本任務的對抗攻擊的設置。我們的方法可以被概念化為一個三層迭代優化問題,類似于EM的多步過程。

具體來說,我們依次優化噪聲δ和文本觸發器t,以減少優化圖像I + δ和優化文本T ⊕ t之間的對比損失,其中⊕表示可以在不同位置插入干凈文本T的觸發器。

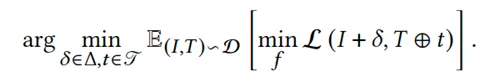

為了簡單起見,我們在本文中選擇在文本的開頭添加文本觸發器。因此,我們的多步誤差最小化(MEM)方法可以表述為:

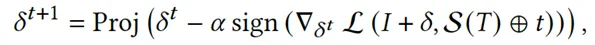

通過參考EM中的方法依次迭代優化上述問題。使用投影梯度下降(PGD)來解決式中的噪聲最小化問題。

值得注意的是,為了減輕噪聲對干凈字幕的過擬合,我們通過在批處理中打亂干凈字幕并添加正確匹配的文本觸發器來增強它們。因此,當面對語義錯誤的字幕時,這種生成的噪聲可以更多地關注文本觸發器而不是部分字幕。因此,我們可以根據以下迭代公式獲得最優的δ:

對于文本觸發器最小化問題,首先通過在所有輸入的前面重復單詞「the」或「a」來初始化觸發序列。

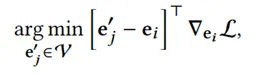

此外,基于HotFlip優化文本觸發器,通過梯度近似替換標記的效果。通過更新每個觸發標記的嵌入,以最小化當前標記嵌入周圍的CLIP損失的一階泰勒近似:

最后,我們可以在候選標記的集合中使用束搜索來搜索每個最優文本觸發器。我們考慮來自上式的前k個候選者,并在觸發器的每個位置從前到后搜索,并使用當前批處理上的損失對每個束進行評分。

我們遵循Wallace等人的方法,并使用小的束大小進行高效計算。在圖3中,我們可以看到使用我們的MEM生成多模態不可學習樣本的框架。

實驗效果

有效保護性

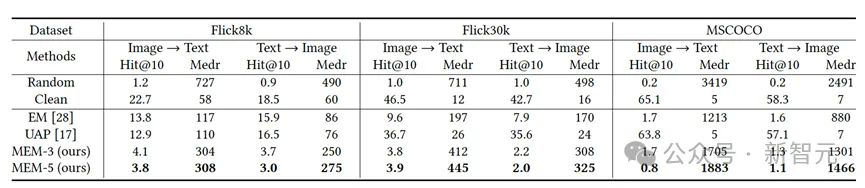

表1:在不同數據集上幾種方法生成的不可學習樣本的有效性比較

表1展示了它們在不同數據集上的檢索結果。顯然,UAP幾乎無法為多模態數據提供任何保護,而EM則表現出一定程度的保護。

然而,我們的MEM始終為多模態數據提供強大的保護,將檢索性能降低到幾乎是隨機猜測的一半。特別是MEM-5,由于其文本觸發器更長,與MEM-3相比,在降低黑客模型性能方面取得了更大的效果。

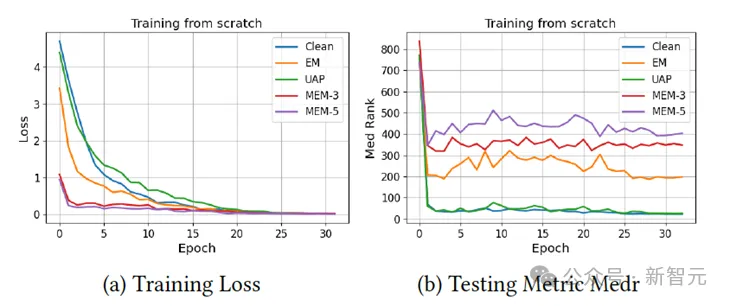

圖4展示了由不同方法生成的不可學習樣本訓練的訓練損失下降曲線和在干凈測試集上的檢索Medr。從(a)中可以觀察到,盡管EM使損失比正常訓練下降得更快,但我們的方法MEM-3和MEM-5在第一個epoch時損失更小,這表明模型可以快速學習到捷徑。

從(b)中我們發現,所有模型的Medr都比隨機猜測時降低,但在不可學習樣本上訓練的模型停止學習得最快,達到了最差的檢索結果,并且隨著epoch的增加不會進一步學習得更好。以上觀察結果與表1中的結果一致。

圖4:訓練損失和測試指標Medr的曲線變化記錄

跨模型遷移性

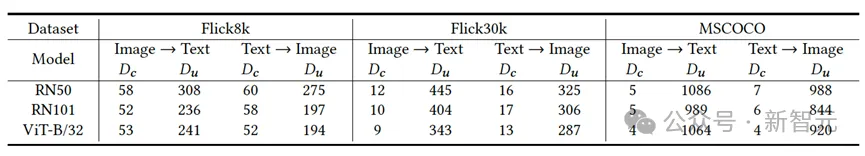

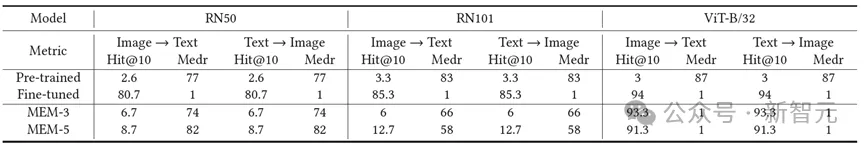

表2:在不同模型架構上,基于ResNet50模型的MEM-3方法生成的不可學習樣本的可轉移性

我們假設數據保護是一個完全黑盒的設置,其中保護者不知道黑客模型的架構。因此,我們評估了在ResNet50代理模型上生成的MEM在不同黑客模型上的性能,包括ResNet101和ViT。結果如表2所示。我們發現這些樣本可以成功地在不同模型之間轉移,并能降低CLIP模型的性能。

可視化分析

圖5:注意力圖可視化:比較四種模型在干凈數據和不同方法的不可學習樣本上的情況

圖5展示了在干凈數據和不同方法生成的不可學習樣本上訓練的模型的注意力熱圖。對于圖像,我們使用Grad-CAM來可視化模型的注意力,而對于文本,我們使用Integrated Gradients來可視化注意力。顏色越淺表示模型的注意力越高。

值得注意的是,對于圖5(1),(2)和(3)中的模型都關注中心區域,這與字幕相關。

然而,圖5(4)中由MEM - 3生成的樣本訓練的模型由于只學習了噪聲特征,無法準確識別干凈圖像。同樣在文本中,前三者中的模型都關注關鍵詞「glass」,而后者中的模型將注意力放在前三個單詞上,這可能是因為MEM-3總是優化噪聲和前三個文本觸發器來創建捷徑。

這些可視化結果表明,EM和UAP在保護多模態數據方面效果不佳,而MEM具有明顯的有效性。

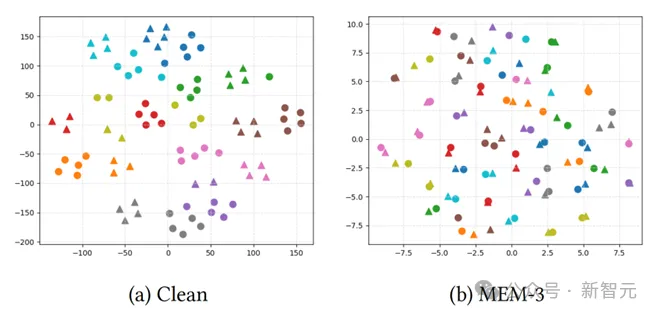

圖6:干凈樣本和MEM-3優化的不可學習樣本在干凈模型和中毒模型下的t-SNE可視化

我們在圖6中可視化了正常模型下干凈樣本的特征分布以及MEM3在中毒模型上優化的不可學習樣本的特征分布。我們用三角形表示圖像特征,用圓圈表示文本特征,相同顏色表示數據集中五個相同但經過變換的圖像及其對應的不同描述。

從(a)中我們可以觀察到,在干凈模型下,相同的圖像和文本在內部聚集在一起,并且相應的圖像-文本對彼此接近。

然而,在(b)中,相同的圖像和文本出現了分歧,只有成對的圖像和文本彼此接近。這表明我們的方法有效地促進了模型學習噪聲和文本觸發器之間的捷徑。

案例探討:人臉隱私保護

我們進行了一個案例研究,將我們的MEM噪聲應用于一個現實世界的場景:保護社交媒體平臺上的個人人臉圖像和相關信息,如姓名。

我們使用PubFig數據庫進行了實驗,這是一個大型的現實世界人臉數據集,包含從互聯網上收集的200個個體的58,797張圖像。對于檢索評估,我們隨機選擇每個名人的一張照片作為測試集,并使用所有剩余的圖像進行訓練。

為了進行真實的微調,我們更改了他們的名字,并提供了一組與該名字相關的文本模板用于字幕生成。隨后,我們使用MEM生成不可學習的樣本,并使用不同的黑客模型進行評估。結果如表3所示。

MEM可以防止這些微調模型學習人臉和姓名特征之間的相關性,從而阻礙在測試集上的準確人員檢索。

表3:在不同預訓練模型上,ResNet50微調生成的不可學習樣本的保護效果

結語

在本文中,我們探索了多模態數據保護,特別關注圖像-文本對,我們生成了多模態不可學習樣本來防止被多模態對比學習利用。我們將先前的分類方法擴展到這個背景下,揭示了由于模態增加和數據分散而存在的局限性。

鑒于這些發現,我們引入了一種名為多步誤差最小化(MEM)的新穎生成方法,它基于EM框架。MEM有效地在噪聲和文本觸發器之間建立了捷徑,并展示了在不同黑客模型之間的可轉移性。

此外,我們使用各種可視化工具驗證了我們方法的有效性。我們的工作開辟了一個新的方向,預計將適用于其他模態對,如音頻-文本和音頻-圖像對。

作者介紹

本文作者來自中科院信工所、南洋理工大學、新加坡國立大學和中山大學。作者列表:劉心瑋,加小俊,尋源,梁思源,操曉春。

其中,第一作者劉心瑋是中科院信工所博士生。通訊作者中山大學操曉春教授和和南洋理工大學的加小俊博士后研究。