曝Bengio新動向:世界模型+數學證明,確保AI系統正常運作

深度學習三巨頭之一Yoshua Bengio的下一步動向公開了,關于AI安全——

加入了一個名為Safeguarded AI(受保護的人工智能)的項目,擔任科學總監。

據介紹,Safeguarded AI旨在:

通過結合科學的世界模型和數學證明,構建一個負責理解和降低其它AI Agent風險的AI系統。

主打的就是一個量化安全保障。

該項目由英國高級研究與發明局(ARIA)提供支持,據說未來ARIA將投入共5900萬英鎊(約合RMB5.37億)。

Bengio表示:

如果你計劃部署某種技術,鑒于AI行為異常或誤用可能帶來非常嚴重的后果,你需要提出充分的理由,最好能提供強有力的數學保證,確保你的AI系統將正常運作。

“受保護的AI”

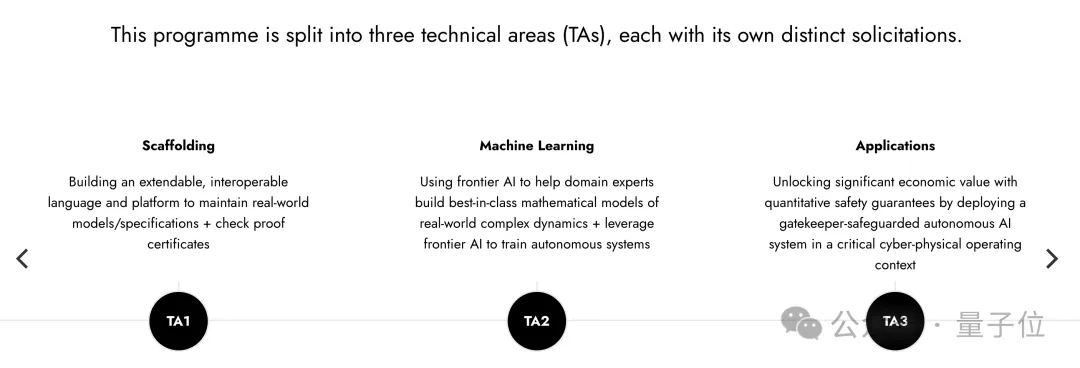

Safeguarded AI項目被劃分為三個技術領域,每個領域都有特定的目標和預算:

- 支架(Scaffolding),構建一個可擴展、可互操作的語言和平臺,用于維護現實世界模型/規范并檢查證明文件。

- 機器學習(Machine Learning),使用前沿AI幫助領域專家構建一流的復雜現實世界動力學的數學模型,并利用前沿AI訓練自主系統。

- 應用(Applications),在關鍵的網絡-物理操作環境中部署一個由“把關AI”保護的自主AI系統,通過量化的安全保障釋放重要的經濟價值。

官方表示,Bengio加入后將特別關注TA3和TA2,在整個計劃中提供科學戰略建議。

ARIA還計劃投入1800萬英鎊(約合RMB1.64億)成立一個非營利組織,領導TA2的研發工作。

Safeguarded AI項目總監是前Twitter高級軟件工程師David “davidad” Dalrymple,去年9月份加入ARIA。

對于Bengio的到來,Dalrymple還在X(原推特)上傳了倆人的合照:

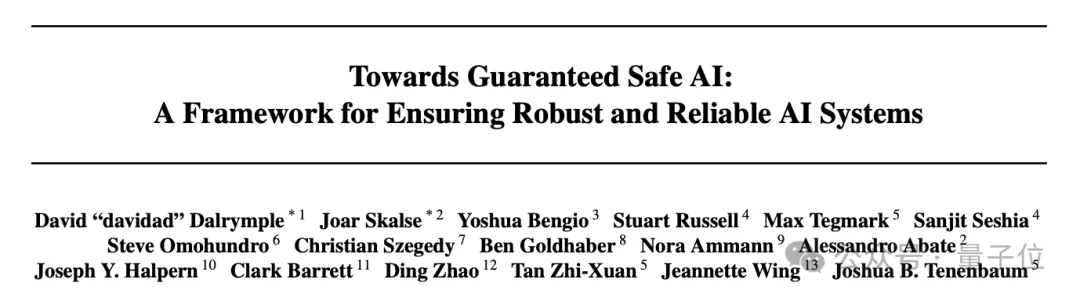

關于“構建一個負責理解和降低其它AI Agent風險的AI系統”的具體方法,David “davidad” Dalrymple、Yoshua Bengio等人寫了份文件。

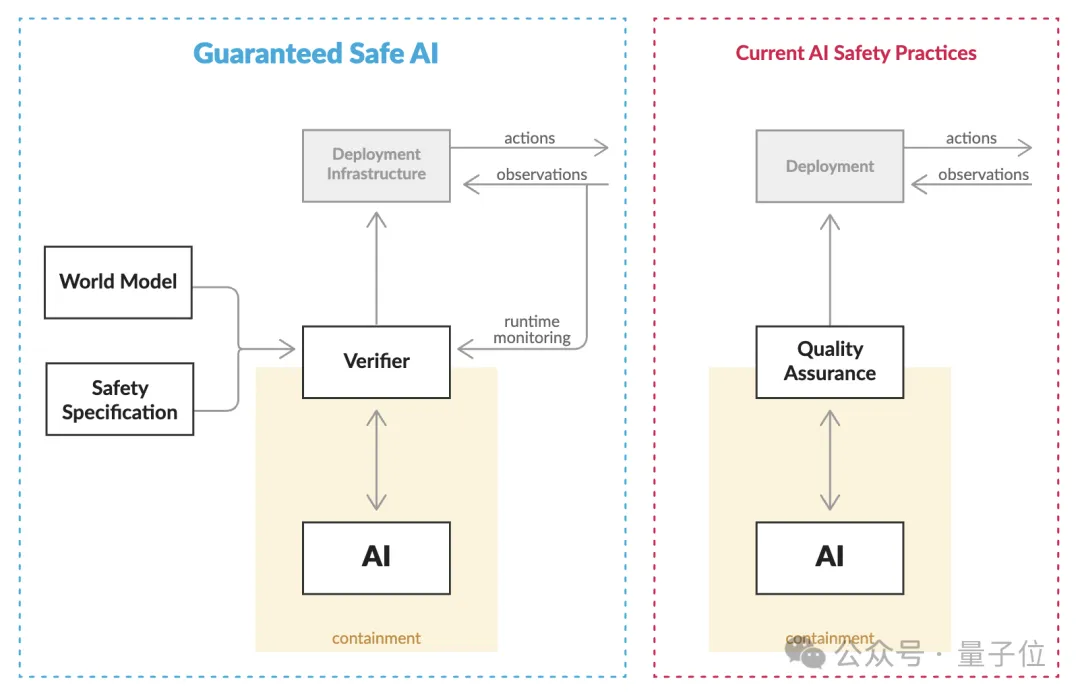

其中提出了一套稱為“Guaranteed Safe AI(保證安全的AI)”的模式,主要是通過三個核心相互作用量化AI系統的安全保障:

- 世界模型,提供數學描述,闡述AI系統如何影響外部世界,并妥善處理貝葉斯和奈特不確定性

- 安全規范,定義哪些效果是可接受的數學描述

- 驗證器,提供證明AI符合安全規范的可審計證書

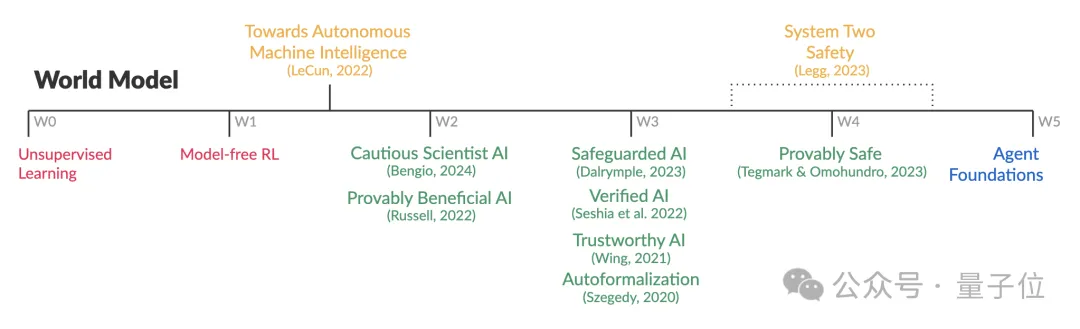

他們還為創建世界模型的策略,劃分了L0-L5安全等級:

- Level 0:沒有明確的世界模型。關于世界的假設隱含在AI系統的訓練數據和實現細節中。

- Level 1:使用經過訓練的黑盒世界模擬器作為世界模型。

- Level 2:使用機器學習生成的概率因果模型的生成模型,可以通過檢查它是否為特定的人類制作的模型(例如科學文獻中提出的模型)分配足夠的可信度來進行測試。

- Level 3:使用(一個或多個)概率因果模型(或它們的分布),可能在機器學習的幫助下生成,這些模型經過人類領域專家的全面審核。

- Level 4:使用關于真實世界現象的世界模型,這些模型被正式驗證為基本物理定律的合理抽象。

- Level 5:不依賴具體的世界模型,而是使用覆蓋所有可能世界的全局性安全規范。

“AI風險”備受學術圈關注

“AI風險”一直是行業大佬們關注的焦點話題之一。

Hinton離職谷歌,就是為了自由地討論AI風險問題。

之前,更是有吳恩達、Hinton、LeCun、哈薩比斯等AI巨佬們線上“對噴”的大型場面。

吳恩達曾表示:

對AI的最大擔憂其實是,AI風險被過度鼓吹,導致開源和創新被嚴苛規定所壓制。

某些人傳播(AI滅絕人類的)恐懼,只是為了搞錢。

DeepMind CEO哈薩比斯則認為:

這不是恐嚇。AGI的風險如果不從現在就開始討論,后果可能會很嚴重。

我不認為我們會想在危險爆發之前才開始做防范。

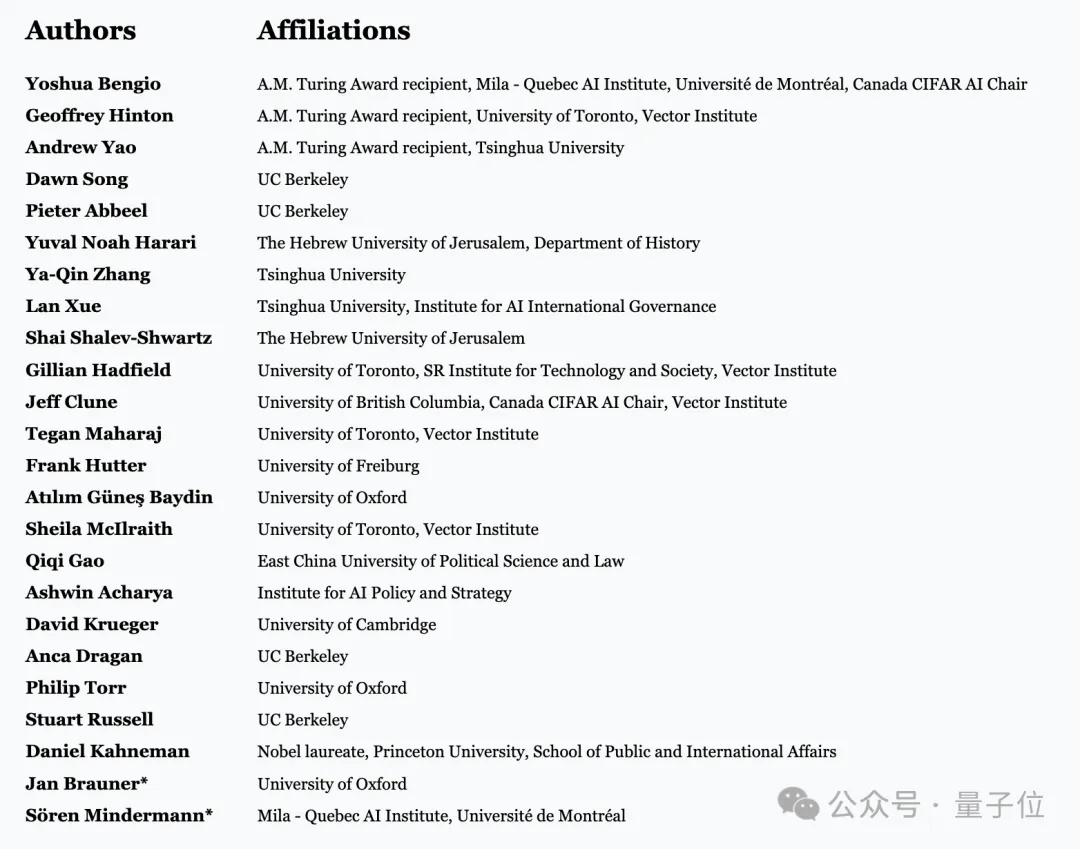

Bengio之前還和Hinton、姚期智、張亞勤等人工智能大拿,發表了一封公開信《在快速進步的時代管理人工智能風險(Managing AI RIsks in an Era of Rapid Progress)》。

其中就指出人類必須認真對待AGI在這10年或下一個10年內在許多關鍵領域超越人類能力的可能。建議監管機構應該對AI發展全面洞察,尤其警惕那些在價值數十億美元的超級計算機上訓練出來的大模型。

就在一個月前,Bengio還以“Reasoning through arguments against taking AI safety seriously(回應反對認真對待AI安全的觀點)”為題寫了一篇文章,其中分享了他的最新想法,感興趣的家人可以康康~

https://yoshuabengio.org/2024/07/09/reasoning-through-arguments-against-taking-ai-safety-seriously/

Guaranteed Safe AI:

https://arxiv.org/abs/2405.06624