開閉源模型「大亂斗」:看看哪個智能體最能窺見人類真實意圖

本文第一作者為清華大學計算機系本科生錢成,何秉翔。兩人均為 THUNLP 成員。錢成主要研究興趣為工具學習,大模型驅動智能體,即將就讀 UIUC 博士。何秉翔主要研究興趣為大模型對齊與安全,即將就讀清華大學博士。本文通訊作者為從鑫與林衍凱,指導教師為劉知遠副教授。

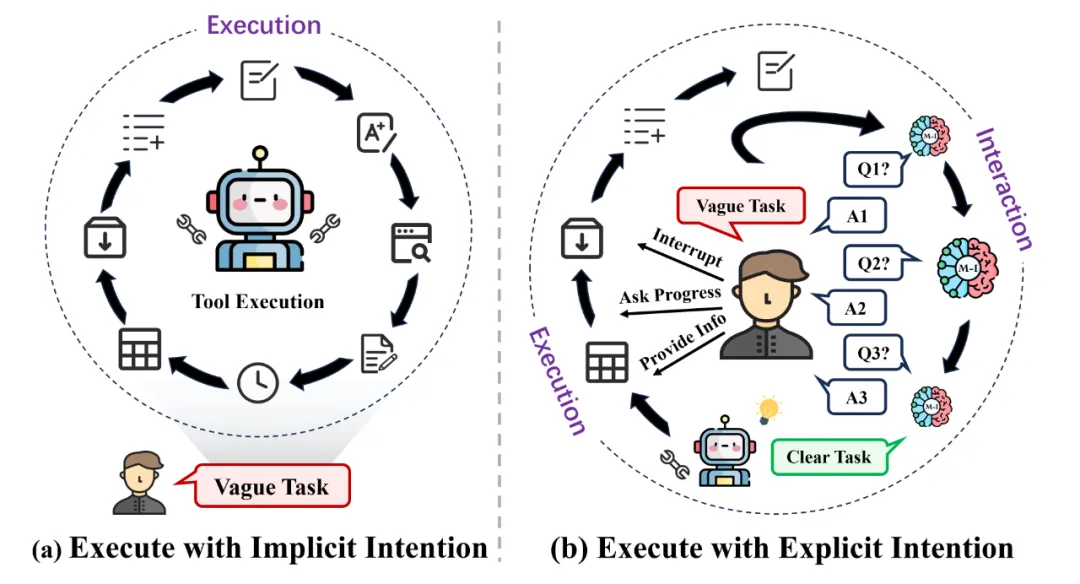

在人工智能迅猛發展的今天,我們不斷探索著機器的智能化,但卻往往忽視了這些智能體如何深層地理解我們 —— 它們的創造者。我們人類在生活中的每一次互動,每一句話語,每一個行為,都充斥著意圖和情感。但真正的挑戰在于:這些隱式的意圖如何被智能體捕捉、解析并作出反應?傳統的智能體對明確的命令反應迅速,然而在理解復雜的人類隱式意圖上,它們往往顯得力不從心。

近年來,GPT 和 LLaMA 等語言模型展示了在解決復雜任務上的驚人能力。然而,盡管以它們作為核心的智能體擅長制定策略、執行任務,卻很少兼顧魯棒的用戶交互策略。用戶給出的任務通常是模糊和簡短的,這就需要智能體不僅能理解我們的字面請求,更要能透視我們的隱式意圖。

因此,讓新一代的智能體落地并為大眾所用,需要以人為中心,不僅僅關注于任務執行的精確度,更關注于如何與人類建立起一種更加自然、流暢而富有洞察力的溝通方式。

為了彌補這一缺失,近期來自清華大學、人民大學、以及騰訊的聯合團隊提出了一種全新的智能體交互設計方案。該工作首先引入了 Intention-in-Interaction(IN3)這一全新的基準測試,旨在通過與用戶明確的交互來理解用戶的隱式意圖。

以 Mistral-7B 為框架,基于 IN3 訓練的 Mistral-Interact 能主動評估任務的模糊性,詢問用戶意圖,并在啟動下游智能體任務執行之前將其細化為可操作的目標。將該模型嵌入 XAgent 框架后,文章對完全態的智能體系統進行了全面評估。

結果顯示,這套方案在識別模糊用戶任務、恢復和總結關鍵缺失信息、設定精確且必要的智能體執行目標、以及減少冗余工具使用等諸多方面有著突出表現。這一創新的方法,不僅填補了智能體與用戶交互的空白,將人類真正置于智能體設計的中心,同時意味著我們正在向著設計更加符合人類意圖的智能體的目標邁進一步。

- 論文標題:Tell Me More! Towards Implicit User Intention Understanding of Language Model Driven Agents

- 論文鏈接:https://arxiv.org/abs/2402.09205

- 代碼倉庫:https://github.com/HBX-hbx/Mistral-Interact

- 開源模型:https://huggingface.co/hbx/Mistral-Interact

- 開源數據集:https://huggingface.co/datasets/hbx/IN3

智能體系統對于模糊任務和清晰任務執行的對比

Intention-in-Interaction 基準測試

當前的智能體基準測試通常假設給定的任務是清晰的,并沒有把用戶意圖理解當作評估的重要方面。鑒于評估指標的不完備性,該工作制定了 Intention-in-Interaction(IN3)基準測試,旨在通過明確的任務模糊性判斷和用戶意圖理解來評測智能體的交互能力。

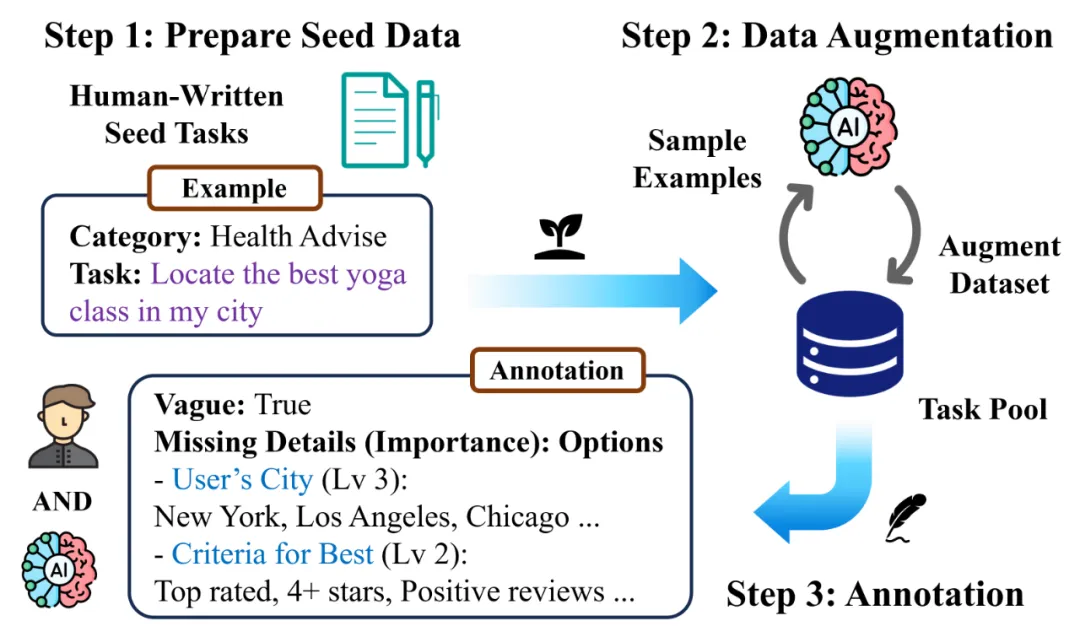

IN3 基準數據的構造過程

如上圖所示,基于人類編寫的種子任務為 Step 1,模型迭代生成新任務以增強數據集,同時從數據集中采樣以作為下一輪生成的新示例(Step 2)。在這種 Self-Instruct 的生成方式后,再對每個任務的模糊度、缺失細節以及每個細節的重要程度和潛在的選項進行人工標注(Step 3)。

Mistral-Interact 訓練過程

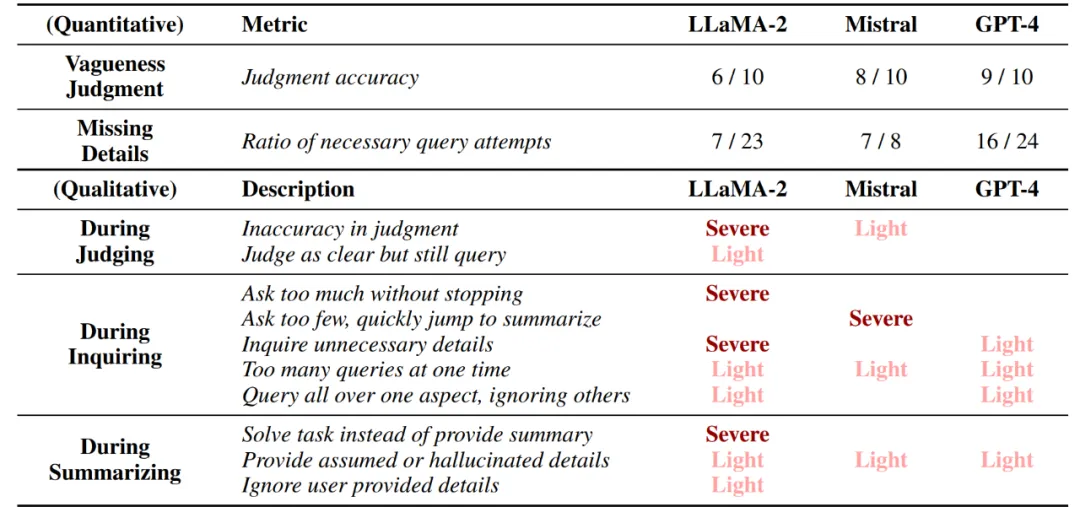

由于大語言模型處于智能體設計的核心位置,該工作首先進行了一項初步研究,評估當前開源和閉源模型在交互過程中的隱式意圖理解能力。

具體地,文章從 IN3 中隨機抽取了十個任務,將它們應用于測試 LLaMA-2-7B-Chat、Mistral-7B-Instruct-v0.2 和 GPT-4 并指示這些模型 i)判斷任務的模糊度,ii)在任務模糊時詢問用戶缺失的細節,iii)總結詳細的用戶任務。

隱式意圖理解初步研究中各個模型的定量與定性結果展示

由結果可見,Mistral 在一定程度上表現更好,但仍然存在對人類意圖理解不足的問題。相比之下,GPT-4 在任務模糊度和重要缺失細節方面與人類意圖最為接近。同時,初步探索也表明,為了進一步提升智能體在交互中的隱式意圖理解能力,單純的提示工程(prompt engineering)是不夠的,有必要以當前開源模型為基礎,進一步訓練,以達到可以在智能體落地應用的程度。

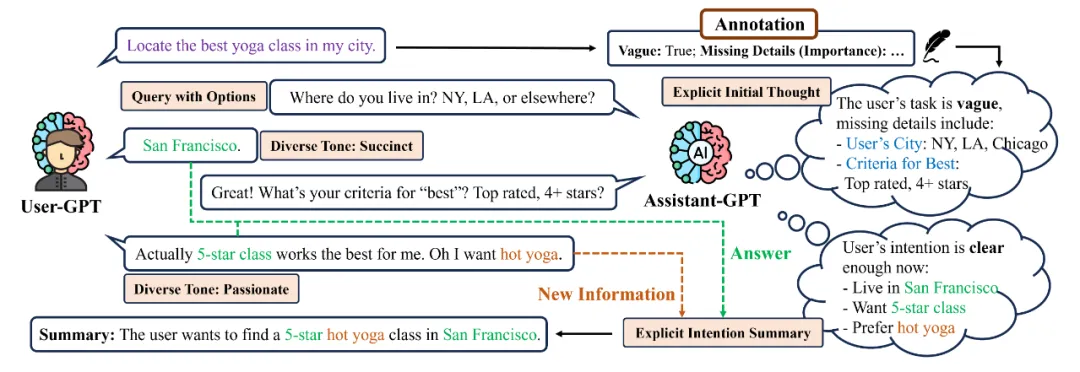

訓練數據(IN3 對話記錄)的構造過程

參照上圖,根據 IN3 關于任務模糊度、缺失細節和潛在選項的標注,文章在構建對話記錄過程中應用了若干策略(橙色框),其中包括:清晰初始推理鏈的構造、帶有建議選項的詢問構造、不同用戶回答語氣的構造、以及清晰總結推理鏈的構造。這幾種對話構造策略將更好地激發目標模型的詢問以及推理能力。

智能體交互能力全面評估

智能體的隱式意圖理解能力既可以通過用戶交互來直接評估,也可以通過智能體執行下游任務來間接評估。其中,用戶交互關注意圖理解本身,而任務執行關注意圖理解的最終目的,即增強智能體處理任務的能力。

因此,為了全面評估可交互智能體設計,文章將實驗分為兩個部分:i)指令理解:評估智能體在用戶交互期間的意圖理解能力;ii)指令執行:評估集成了交互模型后智能體的任務執行表現。

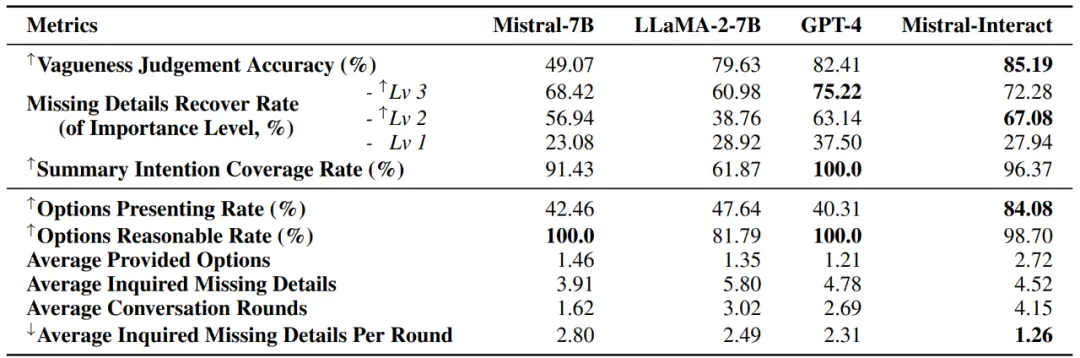

指令理解并不涉及任何實時的智能體執行,因此文章直接評估了不同語言模型在交互過程中的表現,以判斷其作為智能體設計中的上游模塊的交互能力,結果如下表所示:

指令理解測試結果,其中箭頭代表得分越高 / 越低則能力更強

結果表明,Mistral-Interact 能夠更好地理解用戶的意圖,在判斷任務模糊度以及缺失細節的覆蓋率等指標上表現最佳,而且能夠基于詳細的用戶意圖進行明確而全面的總結。相較于其他開源模型,Mistral-Interact 在詢問模糊任務中的缺失細節方面能提供更加合理的選項,詢問方式更加友好,并與 GPT-4 的表現不相上下。

在指令執行方面,為了評估隱式意圖理解對于智能體任務執行有效性,文章將 Mistral-Interact 作為上游交互模塊整合到 XAgent 框架中進行測試。其中,XAgent 可以在諸如網絡搜索、代碼執行、命令行和文件系統等環境中進行交互。

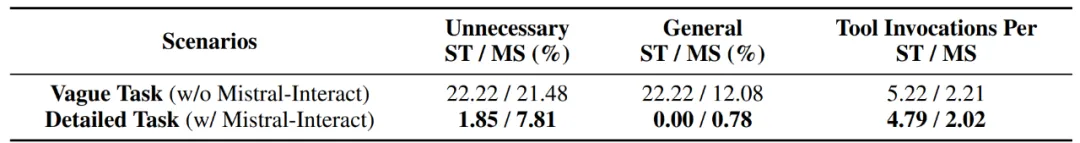

指令執行測試結果 (ST 代表 subtask,MS 代表 milestone)

上表呈現了智能體任務執行的定量評估結果,結果表明整合 Mistral-Interact 有助于:i)在執行過程中避免設定不必要的目標,ii)使智能體的執行過程更加符合詳細的用戶意圖,以及 iii)減少不必要的工具調用,促進智能體工具使用效率。

智能體交互案例分析

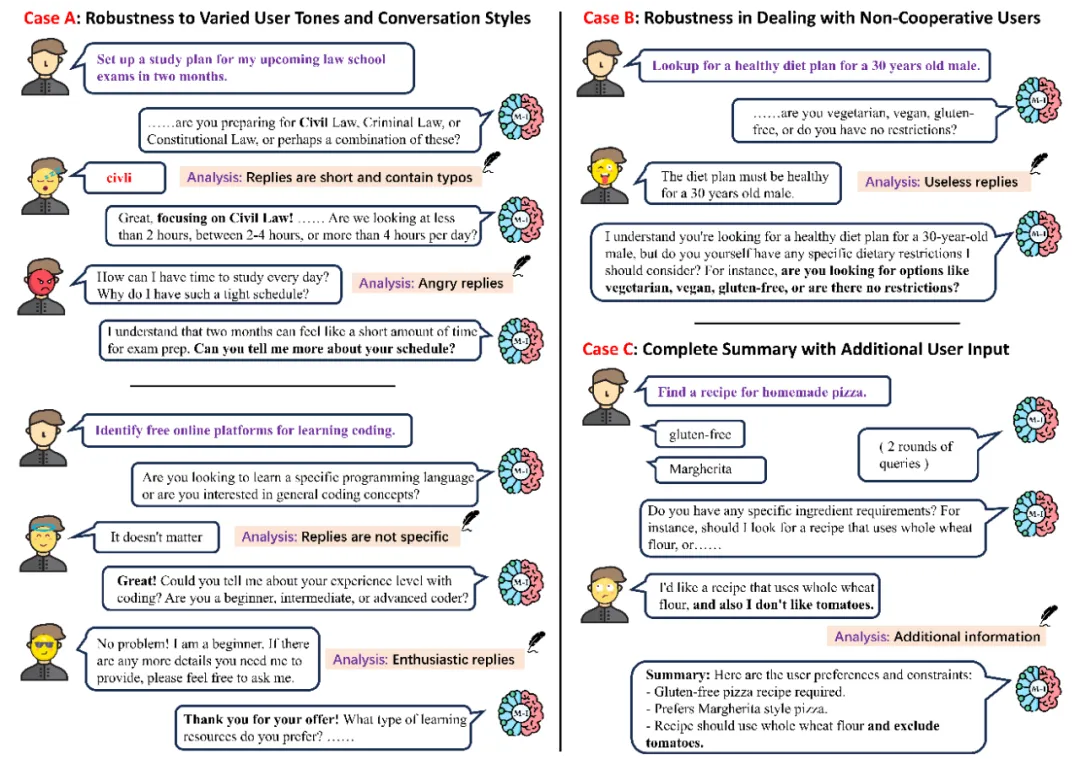

在指令理解方面,為了進一步展示 Mistral-Interact 在不同對話場景下的魯棒性,文章還提供了三個案例分析。

Mistral-Interact 與用戶在不同場景下的案例分析

案例 A 展示了不同用戶語氣和對話風格對 Mistral-Interact 的影響。文章發現,無論用戶的回答是簡短還是詳細,熱情還是冷漠,甚至包含拼寫錯誤,Mistral-Interact 都能準確理解并提供適當的回應,證明了其魯棒性。

在案例 B 測試了當用戶表現出不合作的態度時,Mistral-Interact 是否能夠繼續追問并引導對話回到正軌。結果顯示,即使用戶回避問題,其仍然能夠有效地重新引導對話。

在案例 C 中可以觀察到 Mistral-Interact 可以將用戶提供的額外信息納入總結,而這些信息并沒有被交互模型明確詢問。這表明,當模型的詢問無法完全覆蓋缺失細節或用戶有特定要求時,模型仍然能夠合理而全面地總結所有用戶意圖,從而使其更加用戶友好。

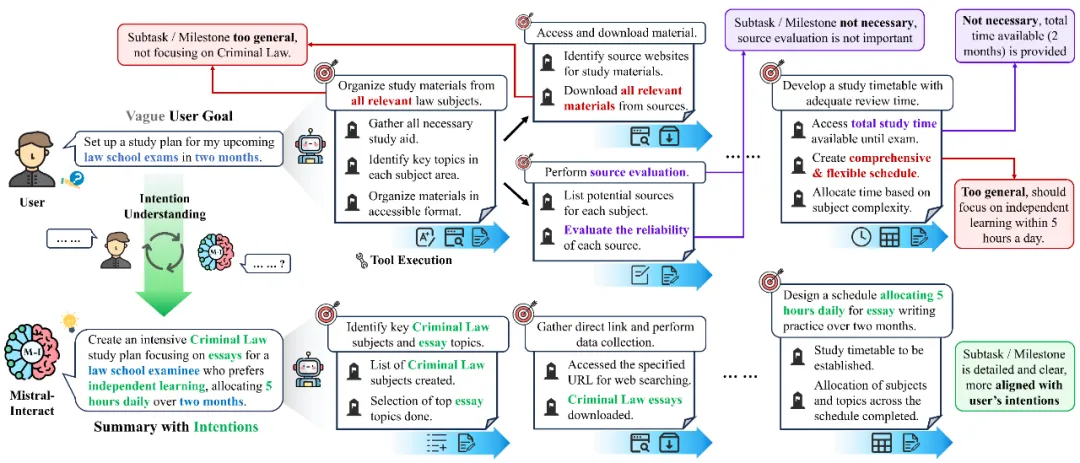

在指令執行方面,為了更清晰闡明 Mistral-Interact 的作用,下圖中提供了一個比較的案例研究。

智能體與 Mistral-Interact 交互前后的執行過程的案例研究

根據上圖中標記為淺紅色的文本,可以發現當用戶的目標模糊時,XAgent 無法準確設定精確反映用戶需求的子任務。根據標記為紫色的文本,可以發現 XAgent 時常會設置一些不必要的子任務。這些均因為用戶的任務過于模糊而無法執行,智能體傾向于虛構一些不必要的細節,從而與用戶的真實意圖不符。

相比之下,在與 Mistral-Interact 進行積極交互后,明確的任務目標能夠讓 XAgent 制定更具體的子任務。圖中標記為綠色的文本展示了這種一致性。同時,智能體執行流程變得更加簡單,工具調用次數也有所減少。所有這些都反映了一個更加高效的智能體執行過程。

結語

我們正站在一個全新的起點,準備見證一個人機協同、相互理解與學習的新篇章。智能體即將不再是冰冷的信息處理器,而是充滿同理心的伙伴,它們能夠通過細膩的交互體驗,深刻理解我們背后可能并沒有最初明確表達的需求和愿望。這場以人為中心的智能體設計革命,將揭示出交互中的無限可能性,進而讓智能體真正成為我們生活中不可或缺的助力。