「AI數據荒」雪上加霜!MIT:網頁數據的公開共享正走向衰落

隨著GenAI產品開發和研究變得越來越廣泛,訓練數據的抓取許可也越來越成為受關注的話題。

最近,吳恩達在網站The Batch上提及了一篇有關數據許可的研究,其結果似乎讓本就迫近的「AI數據荒」雪上加霜。

研究人員發現,C4、RefineWeb、Dolma等開源數據集所爬取的各種網站正在快速在收緊他們的許可協議,曾經觸手可及的開放數據越來越難以獲取。

這不僅會影響商用AI模型的訓練,也會對學術界和非營利機構的研究造成阻礙。

該項目的4位團隊主管分別來自MIT Media Lab、Wellesley學院、AI初創公司Raive等機構。

論文地址:https://www.dataprovenance.org/consent-in-crisis-paper

主持該研究的是非營利組織The Data Provenance Initiative,由來自世界各地的AI研究人員志愿加入組成。論文所涉及的數據標注以及分析全過程已經全部公開在GitHub上,方便未來研究參考使用。

倉庫地址:https://github.com/Data-Provenance-Initiative/Data-Provenance-Collection

具體來說,論文主要有以下幾個方面的結論:

- 對AI數據共享空間的限制正在激增

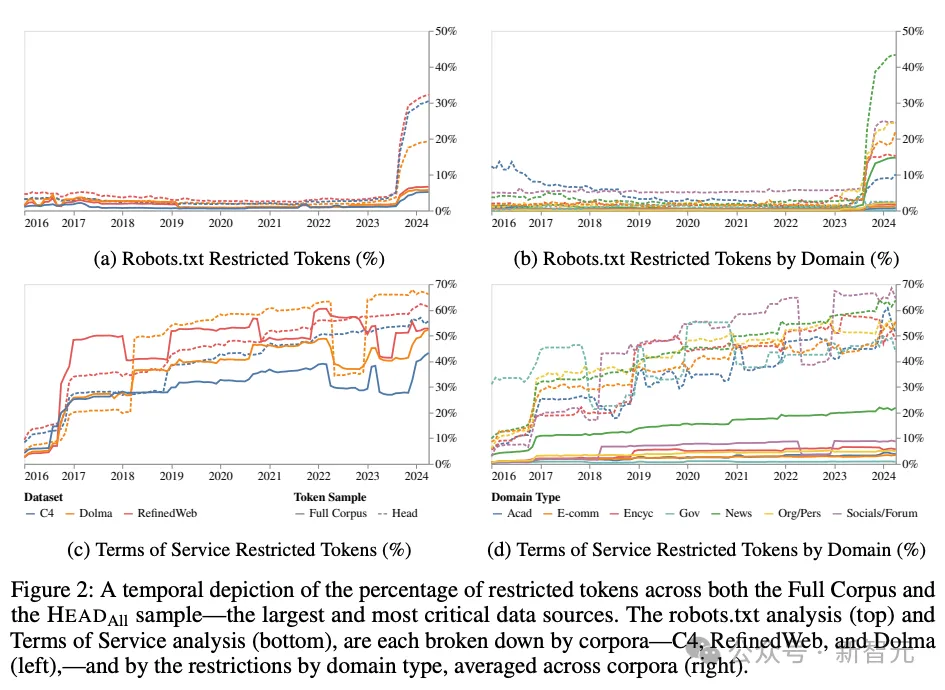

2023.4~2024.4僅一年的時間,C4、RefineWeb、Dolma數據集中就有5%+的token總量、25%+的關鍵網頁在robots.txt做出了限制。

從服務條款的結果來看,C4數據集的45%已被限制。通過這種趨勢可以預測,不受限制的開放網絡數據將會逐年減少。

- 許可的不對稱性與不一致性

相比其他的開發者,OpenAI的爬蟲更加不受歡迎。不一致性體現在,robots.txt和服務條款(Terms of Service, ToS)中經常存在矛盾之處。這表明用于傳達數據使用意圖的工具存在效率低下的問題。

- 從網絡爬取的公開訓練語料中,頭尾內容的特征存在差異

這些語料中有相當高比例的用戶生成內容、多模態內容和商業變現內容(俗稱帶貨廣告),敏感或露骨內容的比例僅僅略少一些。

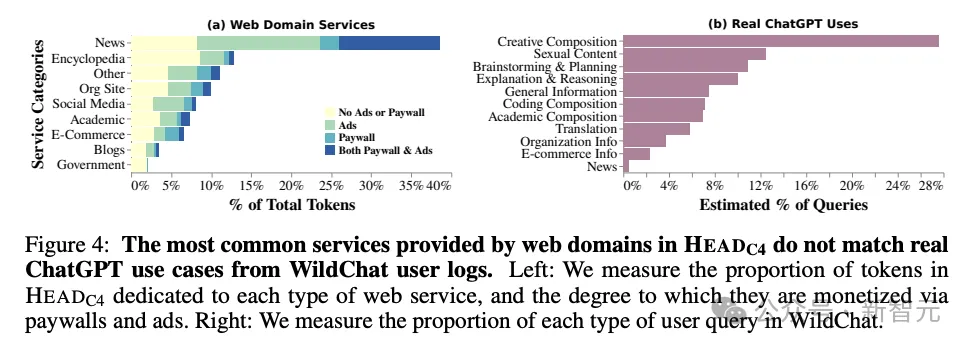

排名靠前的網站域名包括新聞、百科和社交媒體網站,其余的組織機構官網、博客和電子商務網站構成了長尾部分。

- 網絡數據與對話式AI的常見用例的不匹配

網絡上爬取的相當一部分數據與AI模型的訓練用途并不一致,這對模型對齊、未來的數據收集實踐以及版權都會造成影響。

研究方法

通常來說,限制網頁爬蟲的措施有以下兩種:

- 機器人排除協議(Robots Exclusion Protocol, REP)

- 網站的服務條款(Terms of Service, ToS)

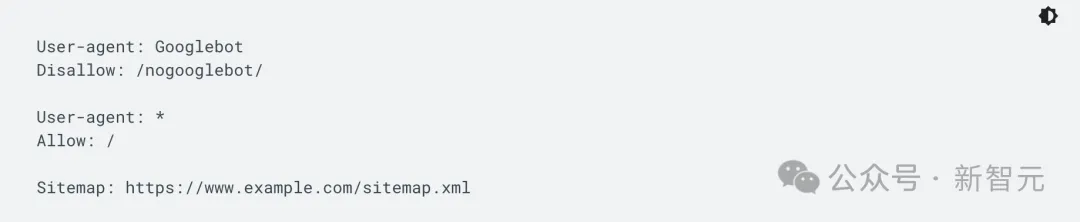

REP的誕生還要追溯到AI時代之前的1995年,這個協議要求在網站源文件中包含robots.txt以管理網絡爬蟲等機器人的活動,比如用戶代理(user agent)或具體文件的訪問權限。

谷歌開發者網站上的robots.txt文件示例

你可以將robots.txt的效力視為張貼在健身房、酒吧或社區中心墻上的「行為準則」標志。它本身沒有任何強制效力,好的機器人會遵循準則,但壞的機器人可以直接無視。

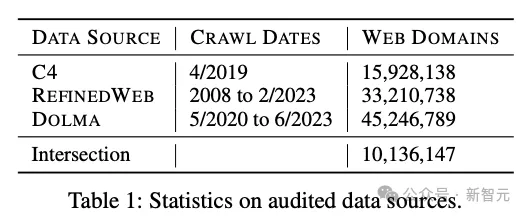

論文共調查了3個數據集的網站來源,具體如表1所示。這些都是有廣泛影響力的開源數據集,下載量在100k~1M+不等。

每個數據來源,token總量排名前2k的網站域名,取并集,共整理出3.95k個網站域名,記為HEADAll,其中僅來源于C4數據集的記為HEADC4,可以看作是體量最大、維護最頻繁、最關鍵領域的AI訓練數據來源。

隨機采樣10k個域名(RANDOM10k),其中再隨機選取2k個進行人工標注(RANDOM2k)。RANDOM10k僅從三個數據集的域名交集中采樣,這意味著他們更可能是質量較高的網頁。

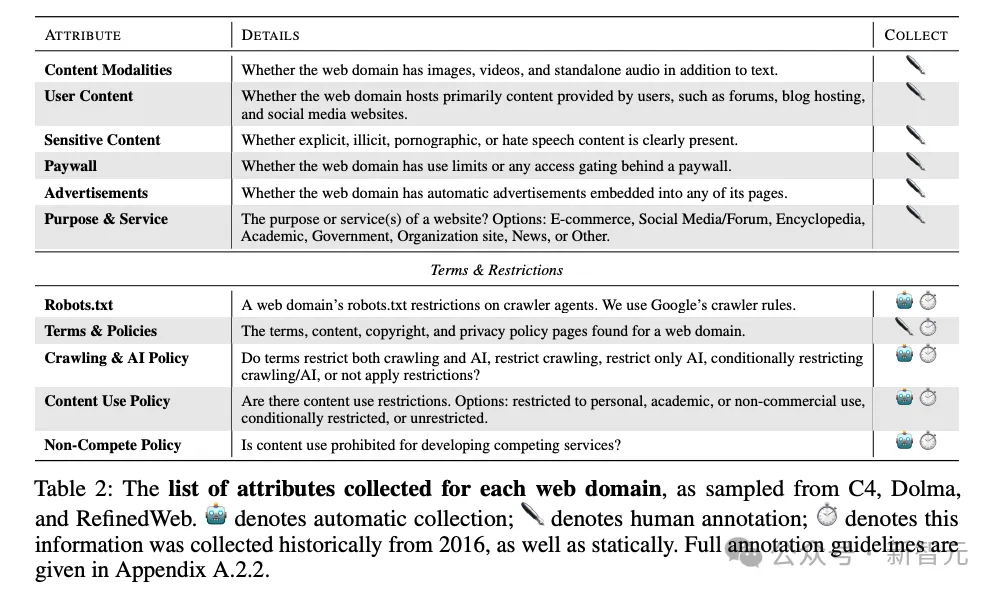

如表2所示,對RANDOM2k進行人工標注時涵蓋了許多方面,包括內容的各種屬性以及訪問權限。為了進行時間上的縱向比對,作者參考了Wayback Machine收錄的網頁歷史數據。

研究所用的人工標注內容都已公開,方便未來研究進行復現。

結果概述

數據限制增加

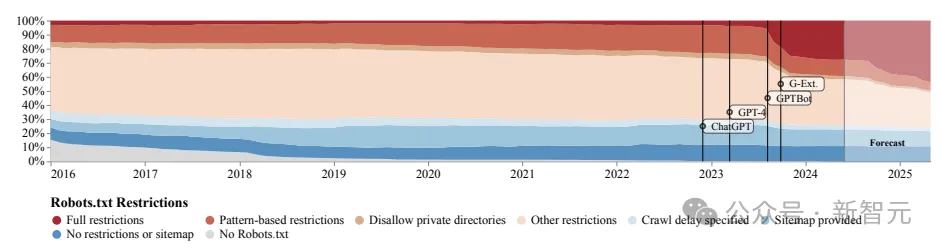

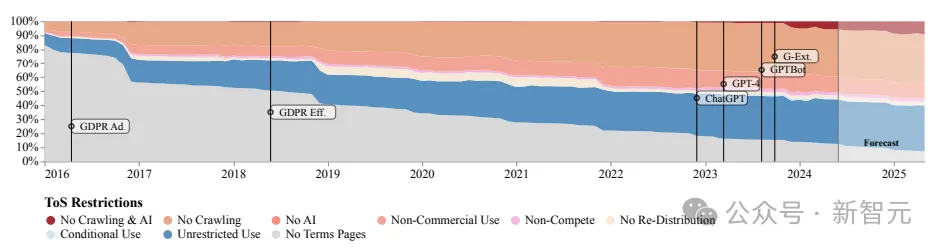

除了收集歷史數據,論文還使用SARIMA方法(Seasonal Autoregressive Integrated Moving Average)對未來趨勢進行了預測。

從robots.txt的限制來看,從GPTBot出現(2023年中期)后,進行完全限制的網站數量激增,但服務條款的限制數量增長較為穩定且均衡,更多關注商業用途。

根據SARIMA模型的預測,無論是robots.txt還是ToS,這種限制數增長的趨勢都會持續下去。

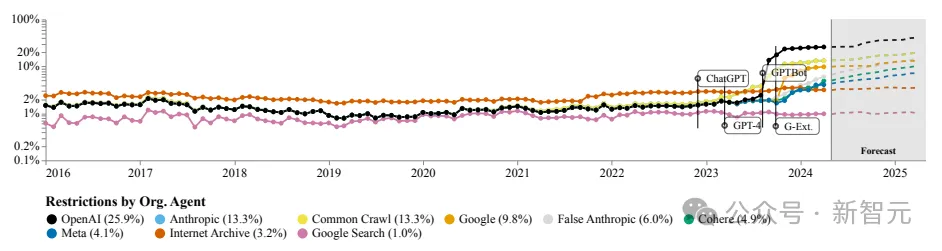

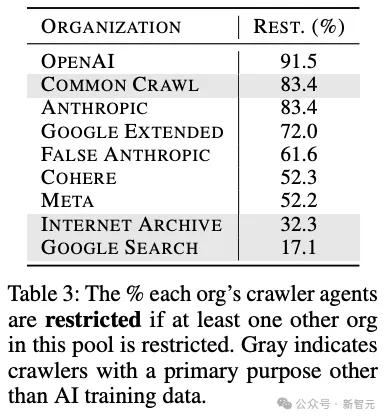

下面這種圖計算了網站限制的特定組織或公司的agent比例,可以看到OpenAI的機器人遙遙領先,其次是Anthropic、谷歌以及開源數據集Common Crawl的爬蟲。

從token數量的角度,也能看到類似的趨勢。

不一致且無效的AI許可

不同組織的AI agent的在各網站上的許可程度存在相當大的差異。

OpenAI、Anthropic和Common Crawl的受限占比位列前三,都達到了80%以上,而網站所有者對Internet Archive或谷歌搜索這類非AI領域的爬蟲通常都比較寬容開放。

robots.txt主要用于規范網頁爬蟲的行為,而網站的服務條款是和使用者之間的法律協議,前者較為機械化、結構化但可執行度高,后者能表達更豐富、細微的策略。

二者本應相互補足,但在實際中,robots.txt常常無法捕捉到服務條款的意圖,甚至常常有互相矛盾的含義(圖3)。

現實用例與網頁數據的不匹配

論文將網頁內容與WildChat數據集中的問題分布進行對比,這是最近收集的ChatGPT的用戶數據,包含約1M份對話。

從圖4中可以發現,二者的差別十分顯著。網頁數據中占比最大的新聞和百科在用戶數據中幾乎微不足道,用戶經常使用的虛構寫作功能在網頁中也很難找到。

討論與結論

近來,很多AI公司都被指責繞過robots.txt來抓取網頁數據。盡管很難確認,但似乎AI系統很難將用于訓練的數據和推理階段用于回答用戶提問的數據分開。

REP協議的復雜性給網頁創建者帶來了很大的壓力,因為他們很難對所有可能的agent及其下游用例做出細致規定,這導致robots.txt的實際內容很難反映真實意圖。

我們需要將用例相關的術語進一步分類并標準化,比如,用于搜索引擎,或非商用AI,或只在AI標明數據出處時才可使用。

總之,這種新的協議需要更靈活地反映網站所有者的意愿,能將有許可和不被允許的用例分開,更好地與服務條款同步。

最為重要的是,從網站數據使用限制的激增中,我們不難看出數據創建者和AI科技公司之間的緊張關系,但背后無辜躺槍的是非營利組織和學術研究人員。

The Batch在轉述這篇文章時表達了這樣的愿望:

「我們希望AI開發人員能夠使用開放網絡上提供的數據進行訓練。我們希望未來的法院判決和立法能夠確認這一點。」