現在的大模型基準評測,蘋果要重新定義了!

近日,蘋果公司的研究人員推出了ToolSandbox,這是一種全新的基準,旨在比以往更全面地評估人工智能助手的實際能力。這項研究發表在 arXiv 上,解決了使用外部工具完成任務的大型語言模型 (LLM) 的現有評估方法中的關鍵缺陷。

1、現有評估基準有哪些關鍵缺陷?

現在大模型評估基準,更多還是從大模型本身的基本功出發,諸如多語言理解、問答推理、數學邏輯等“文理科考試”,像MMLU、GSM8K、ARC、HumanEval、Math、BBH,這些都是大模型的通用能力的基準測試,除此之外,還有行業能力的基準測試,比如FinEval、PubMedQA、JEC-QA等。

但這些數據集存在一個很大的問題,即評估方式非常“自嗨”,忽略了現在AI產品/應用,已經不能單單靠大模型來完成了,大模型還需要具備調用大量的外在工具才能完成真正的應用。

像智能體這樣的應用,需要大模型去按照用戶預定義的本體去完成復雜的任務,就需要調用N多工具。

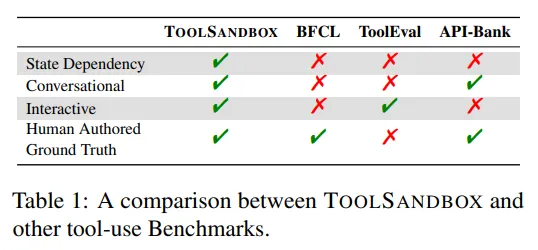

難點就在于,用戶表述問題的方式雖然變得更加簡化,但面向任務的對話仍然具有狀態性、會話性和交互性,這為系統且準確地評估使用工具的大型語言模型帶來了重大挑戰

應用方面,當然也有。智能客服、數據分析、辦公助手、代碼助手、智能代理等方面,則有測評數據集GAIA、APPS、AgentBench等。

TOOLSANDBOX 提供了一個有狀態的、對話式的和交互式的評估基準,用于評估大型語言模型(LLM)的工具使用能力。通過有狀態和狀態依賴的工具、模擬的用戶以及具有里程碑和雷區的靈活評估方式,它展示了開源模型和專有模型之間顯著的性能差距,并揭示了即使是對于最先進的模型(包括狀態依賴、規范化和信息不足等場景)也極具挑戰性的情況,為理解工具使用能力帶來了新的見解。

ToolSandbox 包含其他基準測試中經常缺少的三個關鍵元素:狀態交互、對話能力和動態評估。主要作者 Jiarui Lu 解釋說:“ToolSandbox 包括狀態工具執行、工具之間的隱式狀態依賴關系、支持策略對話評估和動態評估策略的內置用戶模擬器。”

這項新基準旨在更貼近真實場景。例如,它可以測試人工智能助手是否理解在發送短信之前需要啟用設備的蜂窩服務——這項任務需要推理系統的當前狀態并做出適當的更改。

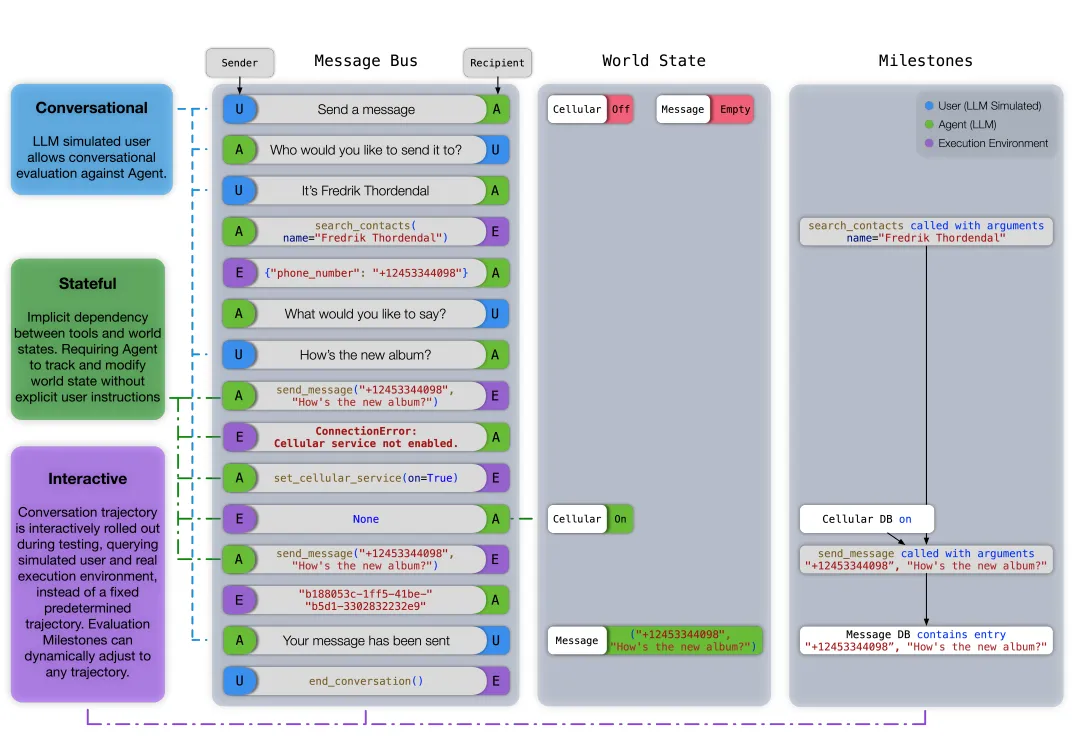

TOOLSANDBOX評估軌跡示例

那么,TOOLSANDBOX究竟是怎么評估的呢?不妨來看論文中的示例。可以看出評估軌跡分為消息總線(Message Bus)、世界狀態(World State)、里程碑(Milestones)三個關鍵要素。

其中,消息總線表示用戶、智能體和執行環境之間的完整對話歷史。世界狀態表示在給定回合中可變數據庫的快照。里程碑表示在此軌跡中需要發生的預定義關鍵事件。

示例中,用戶打算發送消息,但蜂窩服務已關閉。智能體應首先理解用戶的意圖,并向用戶提示必要的參數。在借助search_contacts工具收集所有參數后,智能體嘗試發送消息,在失敗后意識到需要啟用蜂窩服務,并重新嘗試。為了評估此軌跡,研發團隊在每個回合中,在保持拓撲順序的同時,在消息總線和世界狀態中找到與所有里程碑的最佳匹配。

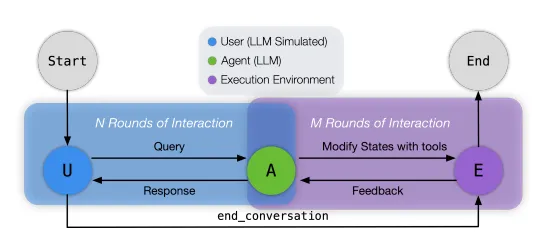

據介紹,TOOLSANDBOX的核心是一個Python原生的大型語言模型(LLM)測試環境,它以執行上下文作為世界狀態的抽象,并以Python函數作為工具。在這個環境中,用戶、智能體和執行環境通過消息總線相互通信以完成任務,該任務會根據預定義的里程碑和雷區進行評估。如圖2所示,一個典型的測試用例從用戶與智能體對話開始。之后,被呼叫的角色將進行下一步對話,直到達到最終狀態。

在收到用戶請求后,智能體可以選擇回應用戶以獲取更多信息,或者通知執行環境執行一個工具,并提供所需的工具名稱和參數。執行環境在InteractiveConsole(Foundation, 2024)中執行工具,這取決于工具會修改存儲在執行上下文中的世界狀態,并向智能體做出響應。

一旦用戶決定任務已完成,它會通知執行環境執行end_conversation工具,使系統進入最終狀態,準備根據對話與里程碑和雷區的相似度進行評估。本節的其余部分將更詳細地介紹每個組件的功能。

2、開源模型依舊落后

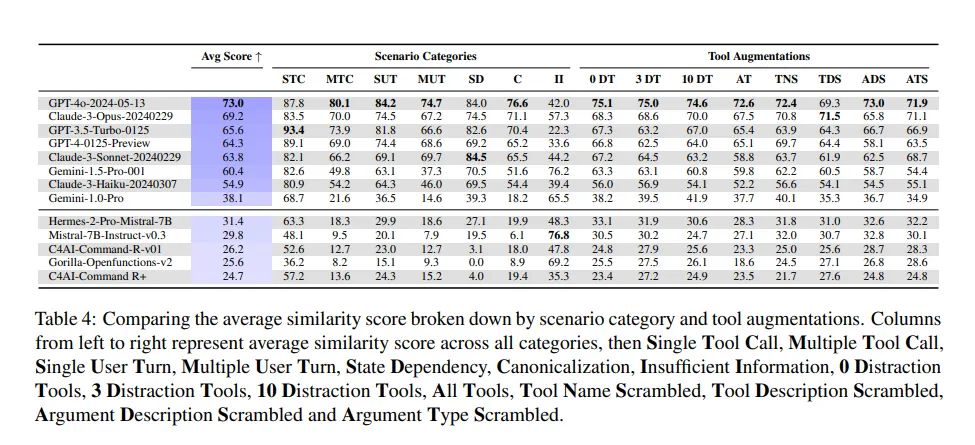

研究人員使用 ToolSandbox 測試了一系列 AI 模型,發現專有模型和開源模型之間存在顯著的性能差距。

研究發現,在工具調用層面,專有模型和開源模型之間存在顯著的性能差距,即便是表現最好的開源模型Hermes,也依舊落后于倒數第二的專有模型Claude-3-Haiku Anthropic(2024)20多分。

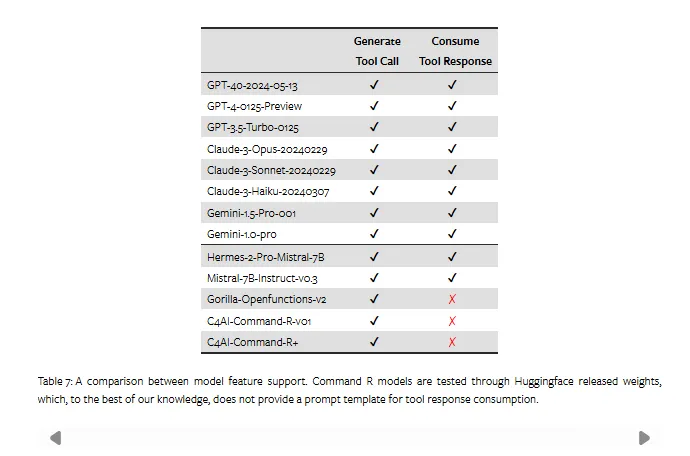

據論文介紹,這部分原因是Gorilla、Command-R等模型根本無法處理工具響應。

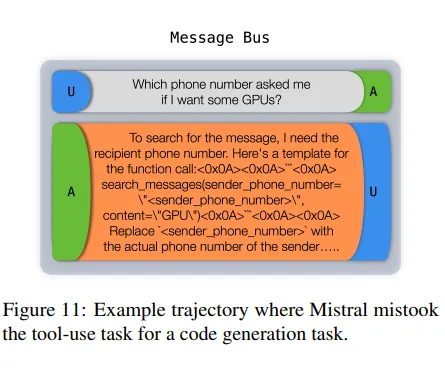

例如,Mistral經常將工具使用場景誤認為是代碼生成任務。這些模型的次優性能出乎意料地導致它們在“信息不足”類別中獲得了更高的評級,該類別獎勵模型在提供的工具不足以完成任務時,沒有產生引起幻覺的工具調用或參數。論文中表示,這應該被視為一種副作用,而不是積極的結果。

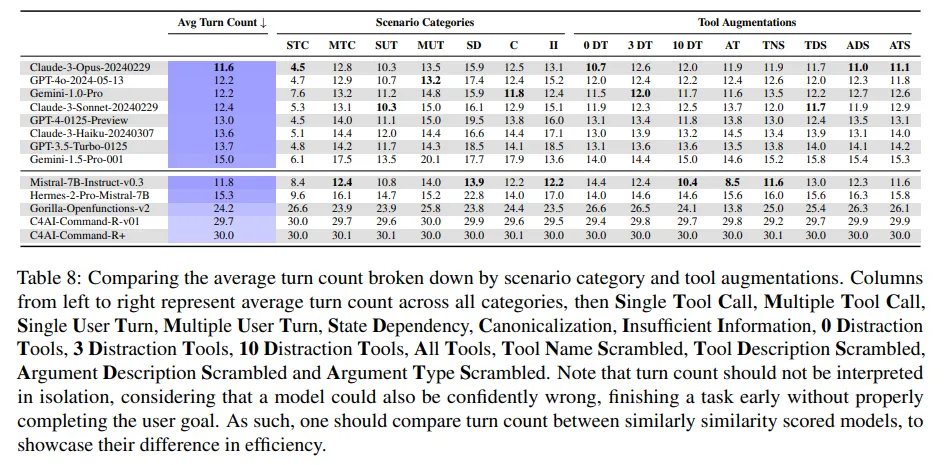

而在專有模型方面,GPT-4o、Claude3-Opus依舊強悍。具體來講,GPT-4o獲得了最高的相似度評分,緊隨其后的是Claude-3-Opus。這兩個模型各有優勢。雖然GPT-4o獲得了更高的評分,但如附錄D.2所示,Claude-3-Opus保持了較低的平均回合數,以更高的效率實現了用戶目標。

這一發現挑戰了最近的報告,這些報告表明開源人工智能正在迅速趕上專有系統。就在上個月,初創公司Galileo 發布了一項基準測試,顯示開源模型正在縮小與專有系統領導者的差距,而Meta和Mistral則宣布了他們聲稱可以與頂級專有系統相媲美的開源模型。

然而,蘋果的研究發現,即使是最先進的人工智能助手,在處理涉及狀態依賴、規范化(將用戶輸入轉換為標準化格式)和信息不足的場景等復雜任務時,也會遇到困難。

作者在論文中指出:“我們表明,開源模型和專有模型在性能上存在顯著差距,而 ToolSandbox 中定義的狀態依賴、規范化和信息不足等復雜任務甚至對最強大的 SOTA LLM 也提出了挑戰,從而為工具使用 LLM 功能提供了全新的見解。”

3、參數規模不代表一切

有趣的是,在新基準之下,原始模型的參數即使再大,也并不總是能夠在復雜現實任務取得更好的性能。

在比較GPT、Claude和Gemini系列中最大和最小的模型時,多工具調用和多用戶回合類別的表現“惡化”速度遠快于單工具調用和單用戶回合類別,這表明對于復雜的工具調用序列和模糊的用戶請求進行推理,需要更多的模型容量。

也就是說,在某些情況下,較大的模型有時表現得比較小的模型更差,尤其是涉及狀態依賴性的模型。這表明,原始模型大小并不總是與復雜的現實任務中更好的性能相關。

在最后

蘋果的研究提醒我們,創建能夠處理復雜的現實任務的人工智能系統仍然存在重大挑戰。

隨著該領域的持續快速發展,像 ToolSandbox 這樣的嚴格基準對于區分炒作與現實以及指導真正有能力的人工智能助手的開發至關重要。

ToolSandbox 的推出可能對 AI 助手、Agent等AI應用的開發和評估產生深遠影響。通過提供更真實的測試環境,它可以幫助研究人員識別和解決當前 AI 系統中的關鍵限制,最終為用戶提供更強大、更可靠的 AI 應用。

隨著人工智能不斷深入融入我們的日常生活,像 ToolSandbox 這樣的基準測試將在確保這些系統能夠處理現實世界交互的復雜性和細微差別方面發揮關鍵作用。

對于開發者,好消息是,ToolSandbox評估框架即將在Github上發布,邀請更廣泛的AI社區共同構建和完善這一重要工作。

上鏈接: