Llama 8B搜索100次超越GPT-4o!推理+搜索即可提升性能,新「Scaling Law」誕生?

強(qiáng)化學(xué)習(xí)先驅(qū)、加拿大阿爾伯塔大學(xué)CS系教授Rich Sutton曾在2019年寫下一篇名為《The Bitter Lesson》的博文,成為AI領(lǐng)域的經(jīng)典論述之一。

甚至,Rich Sutton在字里行間體現(xiàn)出的直覺已經(jīng)頗有Scaling Law的意味。

原文地址:https://www.cs.utexas.edu/~eunsol/courses/data/bitter_lesson.pdf

文章簡(jiǎn)要回顧了AI在象棋、圍棋、語音識(shí)別和視覺等領(lǐng)域的發(fā)展道路,并提出了這樣的觀點(diǎn):

我們應(yīng)該吸取的慘痛教訓(xùn)之一,就是要意識(shí)到通用方法的力量。隨著可用算力猛增帶來計(jì)算量的增加,這種方法可以持續(xù)擴(kuò)展。似乎能以這種方式進(jìn)行任意擴(kuò)展的兩種方法正是搜索(search)和學(xué)習(xí)(learning)。

然而,這個(gè)觀點(diǎn)和Scaling Law并不完全一樣,我們也不能以此為據(jù),認(rèn)為小型模型注定無關(guān)緊要。

正如Sutton所描述的,擴(kuò)展這條路上我們有兩板斧:學(xué)習(xí)和搜索。

OpenAI提出的Scaling Law更強(qiáng)調(diào)前者。在其他條件不變時(shí),較大的模型表現(xiàn)更好,因?yàn)榭梢詮挠?xùn)練集中學(xué)習(xí)到更多知識(shí)和模式。

但我們往往忽略的是后者。搜索方法也可以在推理階段隨算力增長進(jìn)行平滑的擴(kuò)展,以生成更多或者更高質(zhì)量的候選答案。

斯坦福、牛津、DeepMind等機(jī)構(gòu)的學(xué)者最近發(fā)表的一篇文章就關(guān)注到了這一點(diǎn)。

論文地址:https://arxiv.org/abs/2407.21787

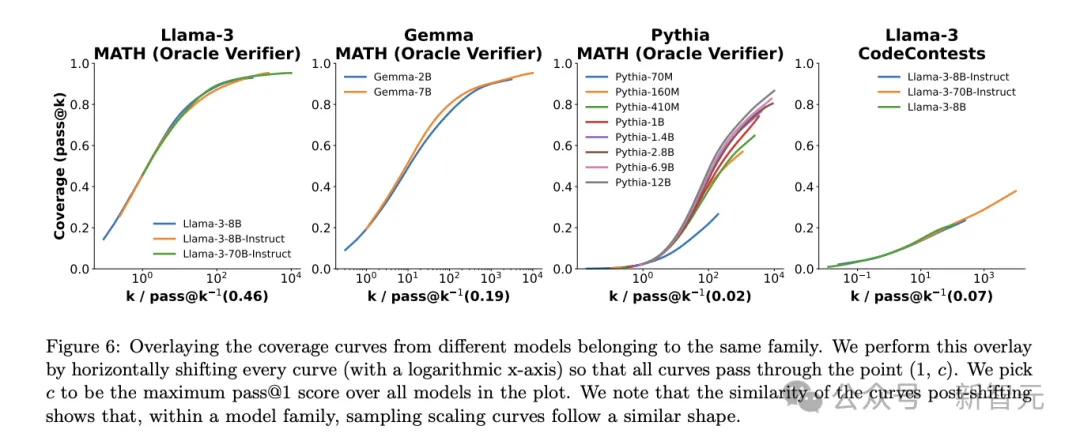

隨著推理階段重復(fù)采樣數(shù)量的提升,模型在GSM8K、MATH、MiniF2F-Math、SWE-bench Lite等數(shù)學(xué)、推理、代碼領(lǐng)域的性能(即問題覆蓋率)都有顯著提升。

甚至,二者之間似乎存在指數(shù)線性關(guān)系,并可以用指數(shù)冪律建模,似乎能說明推理階段縮放定律的存在。

受到這篇論文的啟發(fā),兩位工程師開始嘗試復(fù)現(xiàn)——結(jié)果是,用100個(gè)小Llama模型進(jìn)行搜索,即可在Python編程任務(wù)中追趕甚至打敗GPT-4o。

兩位作者用了一個(gè)形象的比喻:以前,需要一匹馬大小的鴨子才能獲得邊界能力;但現(xiàn)在,我們可以選擇用100只鴨子大小的馬(或者更確切地說,是羊駝Llama)。

實(shí)驗(yàn)所用的源代碼已上傳至GitHub,而且復(fù)現(xiàn)成本相當(dāng)?shù)汀?/span>

https://gist.github.com/charlesfrye/27f25188dbbcfdf20a83c0230020fe05

為了嘗試較高性能,作者使用了vLLM庫實(shí)現(xiàn)批量推理,并將硬件條件擴(kuò)展到10個(gè)A100-40GB GPU,輸出速度達(dá)到40k token/s。

評(píng)估指標(biāo)和結(jié)果

作者選擇了上述的Large Language Monkeys論文中未涵蓋的基準(zhǔn)測(cè)試——HumanEval。

這個(gè)數(shù)據(jù)集的好處在于,使用運(yùn)行測(cè)試對(duì)生成的代碼進(jìn)行評(píng)估,而不需要LLM-as-Judge或人類評(píng)估的參與,能更加客觀地衡量其正確性。

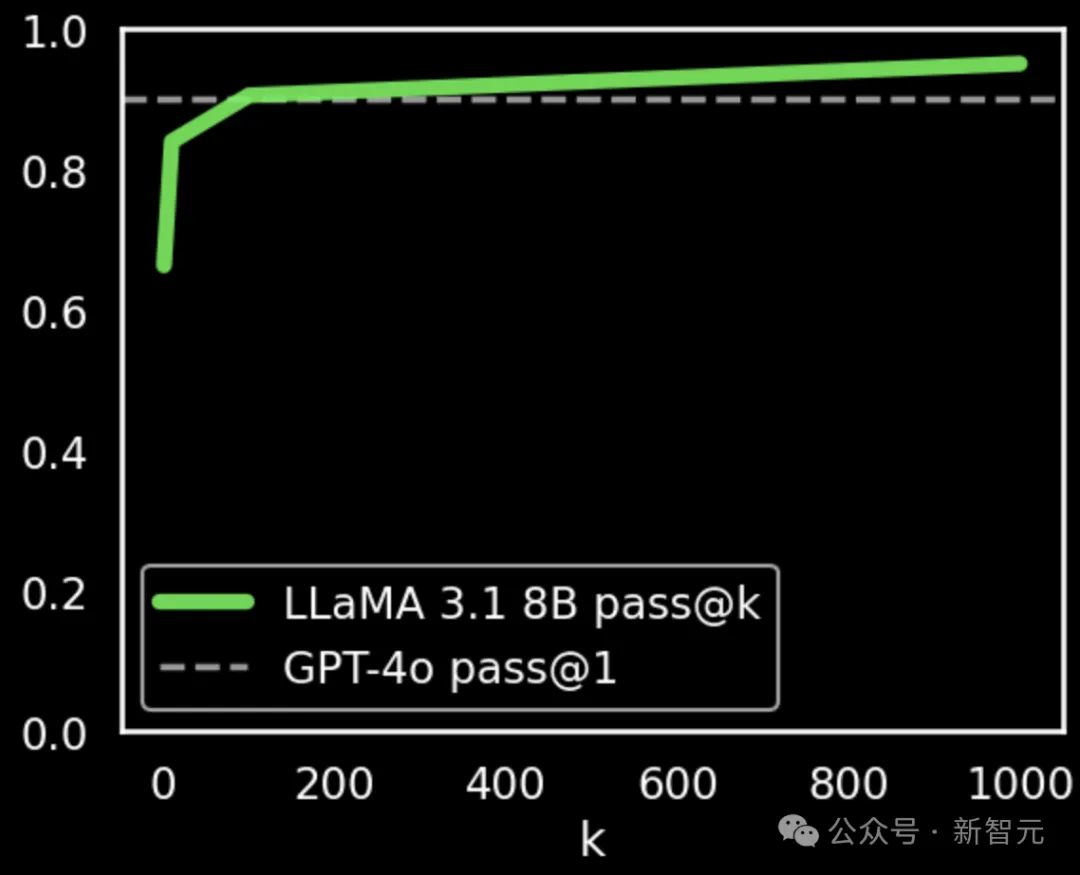

模型的性能通過pass@k和fail@k兩個(gè)指標(biāo)衡量。根據(jù)PapersWithCode的報(bào)告結(jié)果,在零樣本推理時(shí),GPT-4o的pass@1成績(jī)?yōu)?0.2%。

https://paperswithcode.com/sota/code-generation-on-humaneval

使用上述論文提出的方法,加上最少量的prompt微調(diào)(未調(diào)整其他超參數(shù)),Llama 3.1 8B的pass@k分?jǐn)?shù)就有顯著提升。

重復(fù)采樣數(shù)k為100時(shí),性能與GPT-4o相當(dāng)(90.5% vs. 90.2%);k達(dá)到1000時(shí),分?jǐn)?shù)為95.1%,明顯優(yōu)于GPT-4o。

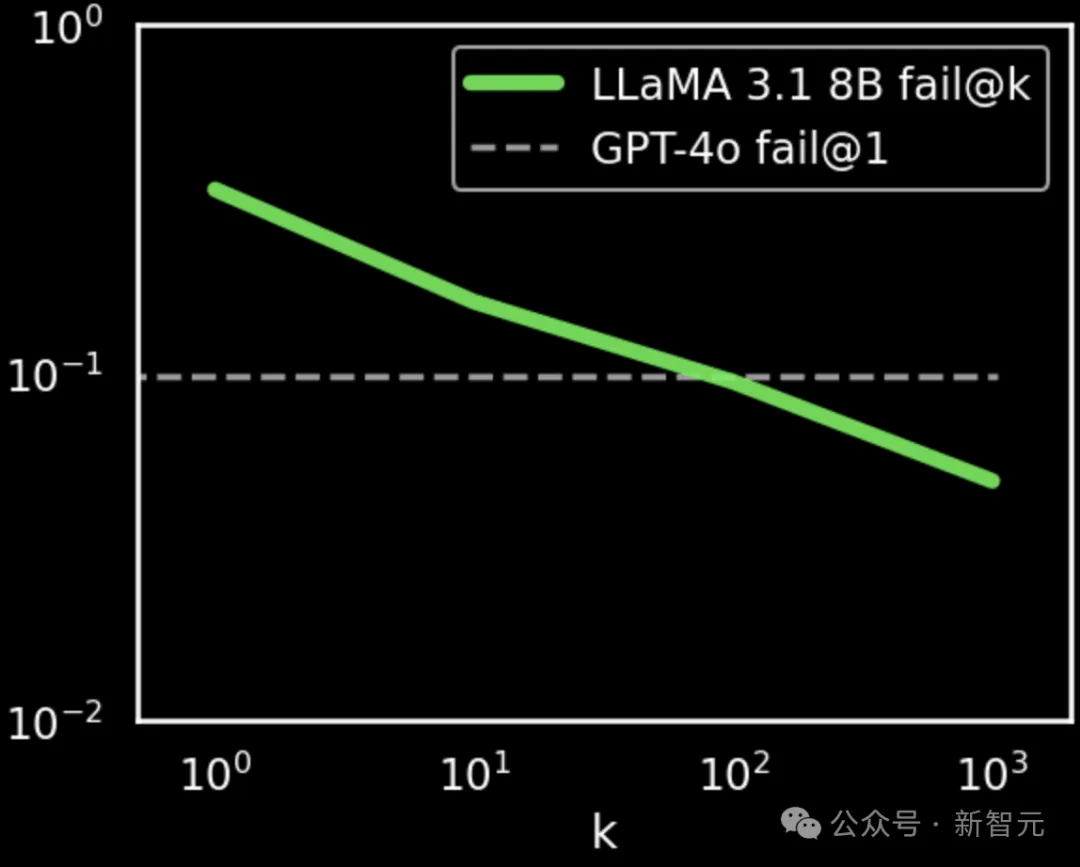

如果使用fail@k指標(biāo)(相當(dāng)于1-pass@k),再將上圖中的兩個(gè)坐標(biāo)軸進(jìn)行對(duì)數(shù)變換,就可以看到下圖所示的曲線,似乎完美符合「縮放定律」。

值得注意的是,這個(gè)小實(shí)驗(yàn)并不是對(duì)論文的嚴(yán)格復(fù)現(xiàn),僅是提取了其中的核心方法。

然而,這些結(jié)果更加強(qiáng)調(diào)了,使用搜索方法進(jìn)行推理階段增強(qiáng)時(shí),較小的模型能以可預(yù)測(cè)的方式勝過GPT-4o這樣的「巨無霸」模型。

「搜索」的未來

搜索方法之所以強(qiáng)大,正是因?yàn)樗茈S著計(jì)算量的增加進(jìn)行「透明」的擴(kuò)展,還可以將資源消耗從內(nèi)存轉(zhuǎn)移至計(jì)算,實(shí)現(xiàn)進(jìn)一步的資源平衡。

最近AI在數(shù)學(xué)方面的重大成果,比如DeepMind的AlphaProof和AlphaGeometry取得了IMO銀牌的水平,以及得到驗(yàn)證的「忙碌海貍」問題,都離不開其中使用的搜索。

然而,搜索的實(shí)現(xiàn)首先需要對(duì)結(jié)果進(jìn)行高質(zhì)量的評(píng)估。DeepMind的模型將自然語言表述的數(shù)學(xué)問題翻譯為形式化表述,從而得到Lean這種編譯器/驗(yàn)證器的詳細(xì)監(jiān)督。

陶哲軒也曾在采訪中不斷強(qiáng)調(diào),「形式化」對(duì)AI在數(shù)學(xué)領(lǐng)域的應(yīng)用十分重要,可以使并行程度和自動(dòng)化程度大大提高。

根據(jù)Curry-Howard-Lambek對(duì)應(yīng)關(guān)系,對(duì)數(shù)學(xué)證明和代碼生成結(jié)果而言,使用計(jì)算機(jī)程序進(jìn)行自動(dòng)化識(shí)別和評(píng)估會(huì)相對(duì)容易。

但類似的方法可能會(huì)在數(shù)學(xué)和編程以外的領(lǐng)域失效。比如,對(duì)于「總結(jié)電子郵件」這類開放式的NLP任務(wù),就很難進(jìn)行有效的搜索。

從這個(gè)角度來看,搜索是評(píng)估的下游。我們可以粗略地預(yù)期,生成模型在特定領(lǐng)域中的性能提升,將和評(píng)估、搜索能力成正比。

為達(dá)到這個(gè)目的,可重復(fù)數(shù)字環(huán)境中的agent似乎是一個(gè)有前景的方向。