加州大學最新!CrossFormer:適用于操作、導航、運動的統一策略

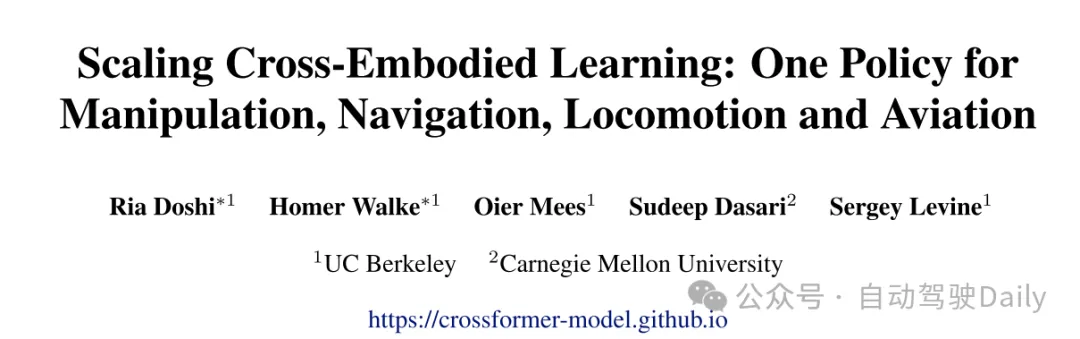

原標題:Scaling Cross-Embodied Learning: One Policy for Manipulation, Navigation, Locomotion and Aviation

論文鏈接:https://arxiv.org/pdf/2408.11812

項目鏈接:https://crossformer-model.github.io/

代碼鏈接:https://github.com/rail-berkeley/crossformer

作者單位:加州大學伯克利分校 卡內基梅隆大學

論文思路:

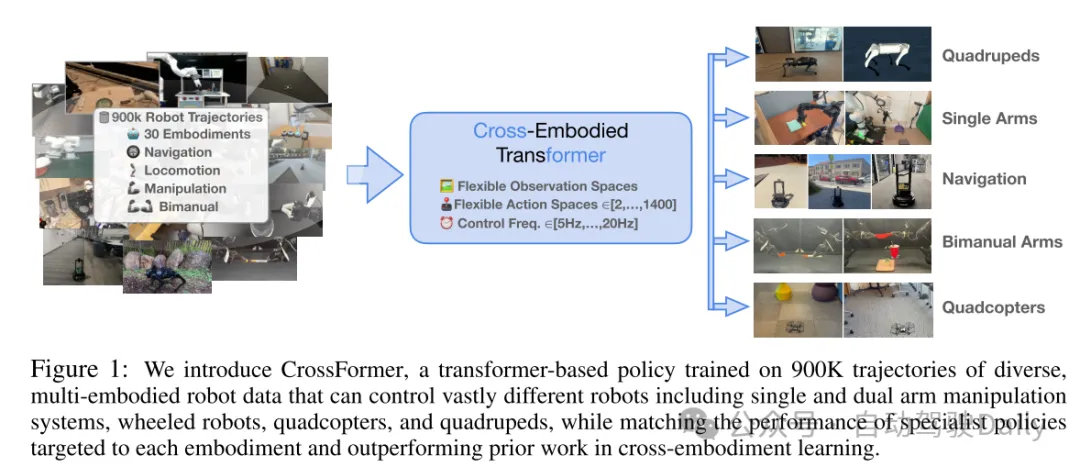

現代機器學習系統依賴于大規模數據集來實現廣泛的泛化,而這在機器人學習中往往是一個挑戰,因為每種機器人平臺和任務可能只有一個小數據集。通過在多種不同類型的機器人上訓練單一策略(single policy),機器人學習方法可以利用更廣泛和多樣化的數據集,從而實現更好的泛化和魯棒性。然而,在多機器人數據(multi-robot data)上訓練單一策略具有挑戰性,因為機器人可能具有截然不同的傳感器、執行器和控制頻率。本文提出了CrossFormer,一種可擴展且靈活的基于Transformer的策略,能夠處理來自任何實體(embodiment)的數據。本文在迄今為止最大和最具多樣性的數據集上訓練了CrossFormer,該數據集包含了來自20種不同機器人實體的90萬條軌跡。本文展示了相同的網絡權重可以控制截然不同的機器人,包括單臂和雙臂操作系統、輪式機器人、四旋翼飛行器和四足機器人。與以往的工作不同,本文的模型不需要手動對齊觀測空間或動作空間。大量現實世界中的實驗表明,本文的方法不僅能匹配為每個實體量身定制的專用策略的性能,還顯著超越了現有的跨實體學習(cross-embodiment learning)的最先進方法。

論文設計:

近年來,機器學習的許多成功都得益于在日益多樣化和多任務數據上訓練通用模型。例如,視覺和語言任務,曾經由特定任務的方法處理,如今通過通用的視覺-語言模型能夠更有效地完成,這些模型可以在任務之間遷移知識 [1, 2, 3, 4]。類似地,在機器人領域,最近的數據聚合工作 [5] 使得可以在跨多個實體、任務和環境的機器人數據上訓練通用策略(general-purpose policies)。這些通用策略通過遷移視覺表示和技能,能夠超越那些僅使用目標機器人和任務數據訓練的狹窄策略(narrow policies) [6, 5]。除了正遷移(positive transfer)帶來的好處之外,訓練通用的跨實體策略還減少了為每個機器人設計和調整策略架構所需的工程工作量。

然而,訓練通用的機器人策略具有獨特的挑戰性,因為機器人系統在相機視角、本體感知輸入(proprioceptive inputs)、關節配置、動作輸出和控制頻率等方面可能存在極大的差異。最初在大規模跨實體策略訓練上的努力通常局限于單一的機械臂或地面導航機器人,這些機器人可以通過單一的相機視角和基座或末端執行器的相對航點動作進行控制 [5, 6, 7, 8]。要進一步增加這些策略所能控制的實體的多樣性,就需要一種支持任意數量的相機視角或本體感知觀測,以及預測任意維度動作的模型架構。遵循以往的工作,本文采用了順序建模的方法來進行跨實體模仿學習 [9, 10]。本文提出了一種基于Transformer的策略,通過將輸入和輸出轉換為序列來支持可變的觀測和動作。本文將這一方法擴展到目前為止能夠用單一策略控制的最為多樣化的實體集,包括單臂和雙臂機器人、地面導航機器人、四旋翼飛行器和四足機器人。

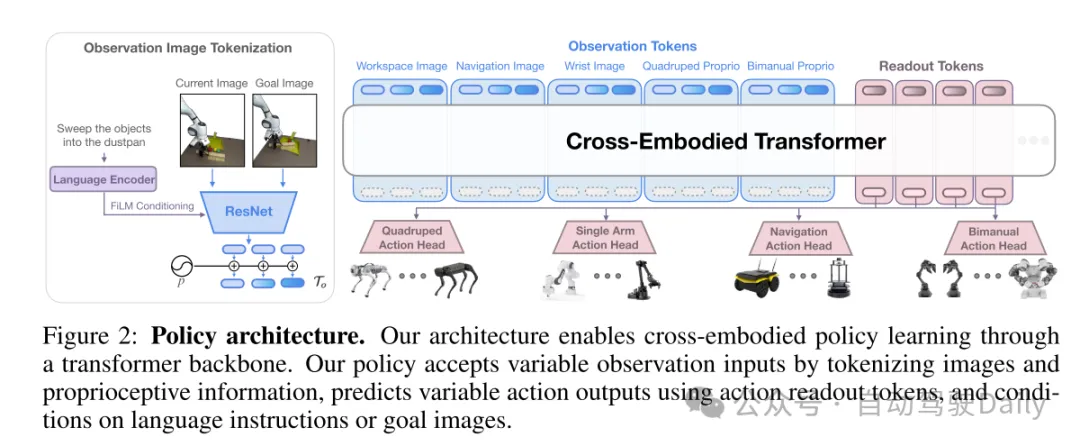

通過本文的Transformer策略,本文可以通過簡單地將觀測數據 tokenizing 并排列成序列,來訓練具有任意數量相機視角或本體感知傳感器的機器人數據。同時,本文可以預測任意維度的動作,關鍵是無需手動對齊不同實體的動作空間 [8]。對于每種動作類型,本文將一組動作讀取tokens(action readout tokens)插入到輸入 token 序列中。然后,本文將相應的輸出嵌入傳遞到特定于動作空間的頭部,以生成正確維度的向量。本文的策略可以接受以語言指令或目標圖像形式呈現的任務,使用戶能夠選擇最適合特定實體的任務模式。

本文的主要貢獻是一種跨實體的機器人策略,該策略在迄今為止最大、最具多樣性的機器人數據集上訓練完成,包含90萬條軌跡和20種不同的實體。本文的策略能夠控制具有不同觀測和動作類型的機器人,從具有本體感知傳感器和12個關節的四足機器人,到配備3個相機和14個關節的雙臂機器人。在大量的現實世界實驗中,本文發現本文的策略能夠匹敵僅在目標機器人數據上訓練的相同架構的性能,以及在每種設置中表現最佳的現有方法,這表明本文的架構能夠吸收異構的機器人數據而不會產生負遷移,同時在性能上可以媲美為每個機器人量身定制的最先進的專用方法。此外,本文還發現,本文的方法在跨實體學習中優于現有的最先進方法,同時減輕了手動對齊觀測空間和動作空間的需求。

在多種實體的機器人學習中,主要挑戰在于處理觀察空間和動作空間的巨大差異,以及控制頻率和機器人系統其他方面的差異。機器人系統可能具有不同數量的相機視角或本體感知傳感器,并且可能通過多種不同的動作表示進行控制,包括關節角度、笛卡爾坐標位置和電機扭矩。為了將數據標準化為統一的格式,以往一些關于跨實體策略訓練的工作忽略了某些觀察類型(例如操作中的腕部視角或第三人稱視角)[5, 7],或在機器人之間對齊了動作空間[8]。而本文則遵循其他相關研究[9, 10, 6],將跨實體模仿學習視為一個序列到序列的問題,并選擇了基于Transformer的策略架構,以處理長度可變的序列輸入和輸出。

由于Transformer策略的序列化特性,本文可以將每種實體的所有可用觀察類型編碼為一個扁平的序列。同樣地,這種方法允許本文解碼可變長度的動作,使本文能夠為每種實體使用最佳的動作類型。利用這種靈活的輸出方式,本文還可以預測不同大小的動作塊。動作塊化(Action Chunking)[48, 47, 49]能夠提高動作的時間一致性,并減少累積誤差,這對于高頻率的精細操作尤為重要。結合Transformer骨干網絡和動作塊化技術,本文的策略能夠控制從使用20Hz關節位置控制的雙臂ALOHA系統,到使用5Hz二維航點控制的地面和空中導航機器人等多種機器人。

從總體上看,本文的Transformer策略遵循了以往在多模態數據上訓練Transformers的研究[9, 10, 6]。具體來說,觀察數據和任務規范首先通過特定模態的分詞器進行分詞處理,然后組裝成一個token序列,并輸入到一個因果性的、僅解碼器的Transformer骨干網絡中,這個網絡在所有實體之間共享。接下來,輸出的嵌入向量會被輸入到為每類實體設計的獨立動作頭中,以生成對應維度的動作。有關本文架構的概覽,請參見圖2。接下來,本文將更詳細地描述本文的訓練數據以及架構的各個組成部分。

圖1:本文介紹了CrossFormer,這是一種基于Transformer的策略,經過在90萬條多樣化、多實體機器人數據軌跡上的訓練,能夠控制截然不同的機器人,包括單臂和雙臂操作系統、輪式機器人、四旋翼飛行器和四足機器人,同時在性能上匹敵針對每個實體的專用策略,并在跨實體學習中優于以往的工作。

圖2:策略架構。本文的架構通過Transformer主干網絡實現跨實體策略學習。本文的策略通過將圖像和本體感知信息 tokenizing 來接收可變的觀測輸入,通過動作讀取tokens(action readout tokens)預測可變的動作輸出,并基于語言指令或目標圖像進行條件判斷。

實驗結果:

圖3:訓練數據組合。本文將訓練數據中的20種實體分為不同類別,并可視化它們在數據組合中的貢獻。餅圖顯示了每個訓練批次中基于采樣權重的平均組成情況。

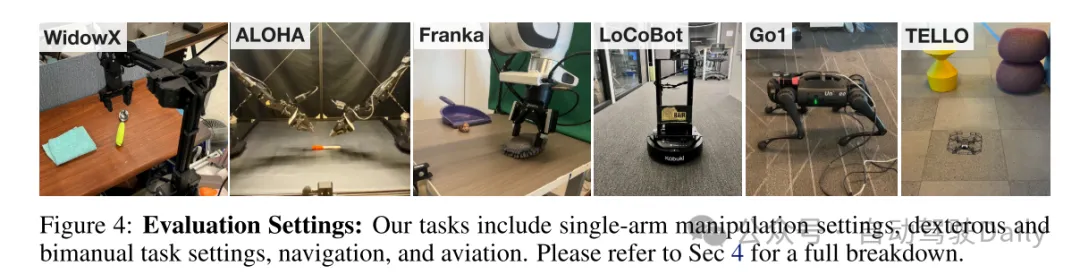

圖4:評估設置。本文的任務包括單臂操作設置、靈巧和雙臂任務設置、導航以及航空任務。詳細分類請參見第4節。

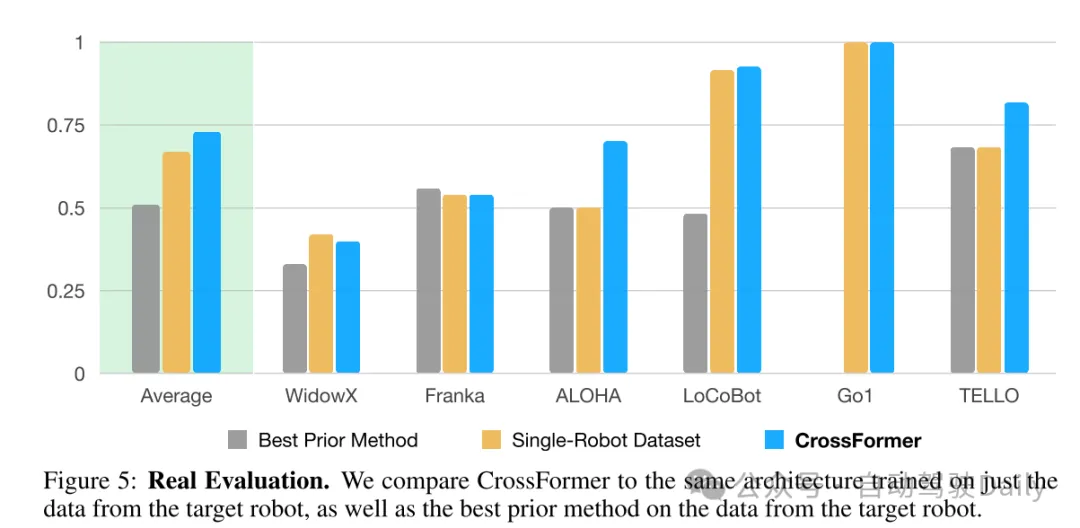

圖5:實際評估。本文將CrossFormer與僅在目標機器人數據上訓練的相同架構進行比較,同時也與在目標機器人數據上表現最佳的現有方法進行對比。

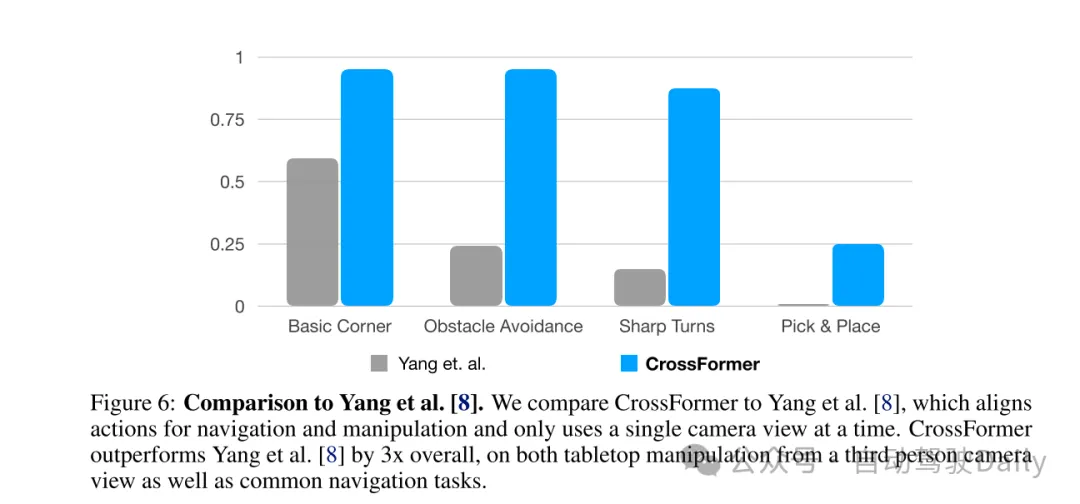

圖6:與Yang等人[8]的比較。本文將CrossFormer與Yang等人[8]的方法進行比較,該方法對導航和操作任務的動作進行對齊,并且一次只使用單一相機視角。CrossFormer在整體表現上優于Yang等人[8]三倍,無論是在使用第三人稱相機視角進行的桌面操作任務上,還是在常見的導航任務中,均表現出色。

總結:

本文引入了CrossFormer,這是一種可擴展且靈活的Transformer策略,基于迄今為止最大且最為多樣化的數據集進行訓練,包括20種不同機器人實體的90萬條軌跡。本文展示了一種系統化的方法來學習單一策略,該策略能夠控制截然不同的實體,包括單臂和雙臂操作系統、輪式機器人、四旋翼飛行器和四足機器人。本文的結果表明,CrossFormer的表現與專門針對單一實體的策略相媲美,同時在跨實體學習中顯著優于當前的最先進方法。

然而,本文的工作也存在一些局限性。本文的結果尚未顯示出在不同實體之間的顯著正遷移效應。本文預計,隨著本文在更大、更具多樣性的機器人數據集上進行訓練,本文將看到更大的正遷移效應。另一項局限性是,本文的數據組合使用了人工挑選的采樣權重,以避免在包含大量重復情節的數據集上過度訓練,或在與本文的評估設置最相關的數據上訓練不足。原則上,隨著模型規模的擴大,策略應具備同等良好地擬合所有數據的能力,而無需進行數據加權。

最后,由于本文需要大型模型來適應大規模的多機器人數據集,模型的推理速度可能成為一個限制因素。在本研究中,本文成功地將本文的策略應用于高頻率、細粒度的雙臂操作任務中,但隨著模型規模的擴大,本文可能無法控制這些高頻率的實體。未來的硬件改進將有助于緩解這一問題,但在如何利用大型模型來控制高頻率機器人方面仍需進一步研究。

未來的工作還可以包括探索技術以實現更大的跨實體正遷移,同時保持本文架構的靈活性、改進數據管理技術,并引入更多樣化的數據源,如次優的機器人數據或無動作的人類視頻。本文希望這項工作能夠為開發更通用且靈活的機器人策略打開大門,使其能夠有效地從在不同機器人實體上收集的經驗中學習并遷移知識。