CPU vs GPU:為什么GPU更適合深度學習?

Hello folks,我是 Luga,今天我們繼續(xù)來聊一下人工智能生態(tài)相關技術 - 用于加速構建 AI 核心算力的 GPU 硬件技術。

眾所周知,深度學習作為一種能夠從海量數(shù)據(jù)中自主學習、提煉知識的技術,正在為各行各業(yè)賦能,成為企業(yè)和機構改變現(xiàn)實的強大工具。這一技術不僅賦予了計算機前所未有的智能能力,更為創(chuàng)新注入了強勁的動力,使得看似無法落地的業(yè)務場景充滿了無限可能。

憑借其卓越的數(shù)據(jù)處理能力,深度學習使得計算機能夠實現(xiàn)多種過去僅為人類所獨有的認知智能。通常而言,深度神經(jīng)網(wǎng)絡的訓練過程極其復雜,通常需要進行大量的并行計算。傳統(tǒng)的計算設備難以滿足這一需求,而 GPU 憑借其大規(guī)模并行計算架構,完美地提供了所需的計算能力。通過 GPU 的加持,深度學習模型得以高效訓練,迅速收斂,從而使得這些復雜的智能任務得以實現(xiàn)。因此,GPU 不僅是深度學習技術的核心算力引擎,更是推動人工智能不斷向前發(fā)展的關鍵力量。

什么是 CPU ?

CPU(中央處理器)是計算機系統(tǒng)中最核心的組件之一,負責執(zhí)行幾乎所有程序運行所需的指令。作為一種通用處理器,旨在處理各種不同類型的任務,從操作系統(tǒng)的運行,到應用程序的執(zhí)行,再到復雜的計算、文檔編輯、播放電影和音樂、網(wǎng)頁瀏覽等。

現(xiàn)代 CPU 通常擁有多個處理核心,每個核心都可以獨立處理指令,從而提高多任務處理的能力。這種多核設計使得 CPU 可以在一定程度上同時處理多個任務,雖然每個任務的執(zhí)行仍然是順序完成的。

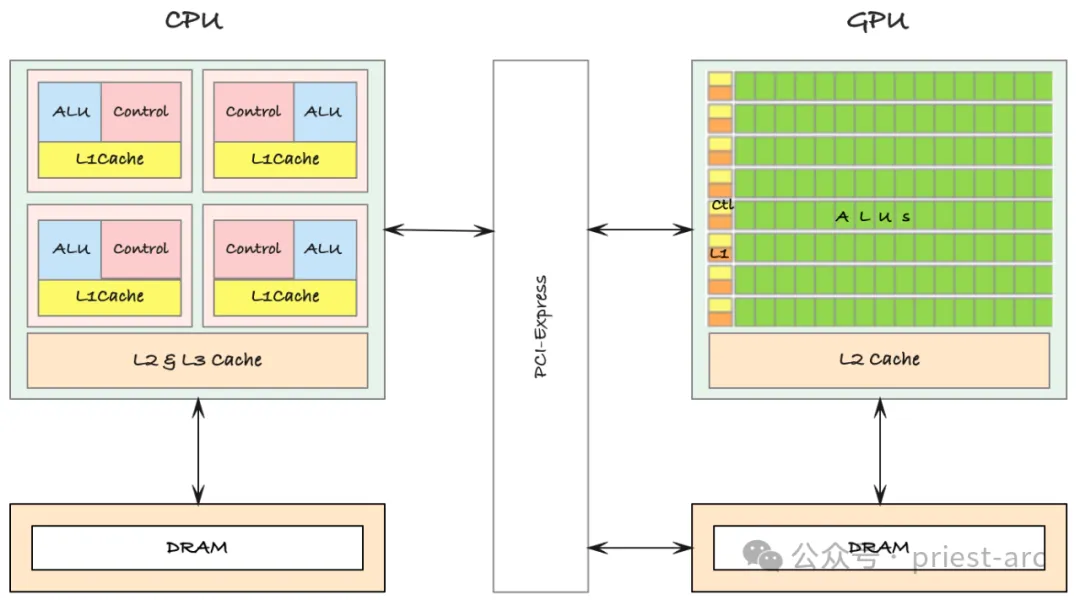

需要注意的是,CPU 的處理方式以“順序處理”為主。也就是說,CPU 會逐步、一條接一條地執(zhí)行指令,這與并行處理不同。雖然多核技術和超線程技術可以在一定程度上緩解這種順序處理的局限,但它并不是為大規(guī)模并行計算設計的。相比于能夠一次處理大量數(shù)據(jù)的圖形處理器(GPU),CPU 更適合處理復雜且需要精確計算的任務。

在 CPU 架構中,有幾個關鍵的標準組件,它們共同協(xié)作,確保中央處理器能夠高效完成各種計算任務。這些組件包括內核、緩存、內存管理單元(MMU)以及 CPU 時鐘和控制單元等。

所有這些組件共同協(xié)作,創(chuàng)建了一個能夠高效執(zhí)行多任務并行的處理環(huán)境。當 CPU 時鐘驅動核心活動時,多個核心之間以極高的速度切換任務,從而使得 CPU 能夠在數(shù)百個不同的任務之間每秒進行快速切換。例如,CPU可 以在后臺處理文件操作的同時,運行應用程序、管理網(wǎng)絡連接,并保持桌面顯示的流暢運行。

總的來說,CPU(中央處理器)是整個計算機系統(tǒng)的核心,協(xié)調和管理所有計算任務。從數(shù)據(jù)輸入到最終的輸出,每一個步驟都依賴于 CPU 的指令處理和計算能力。無論是打開應用程序、運行復雜的模擬、編譯軟件,還是處理圖形、視頻和音頻,CPU 都是確保系統(tǒng)能夠高效運行的關鍵角色。

什么是 GPU ?

GPU(圖形處理單元)的誕生,初衷是為了專門應對渲染復雜圖形和加速視頻處理的需求。隨著計算機圖形技術的發(fā)展,實時 3D 圖形的渲染需求逐漸增多,傳統(tǒng)的CPU(中央處理器)難以高效處理這些繁重的計算任務。GPU 的出現(xiàn)大大緩解了這一負擔,通過其獨特的架構將大量的圖形處理操作從 CPU 中剝離出來,從而極大地提升了系統(tǒng)的圖形處理能力。

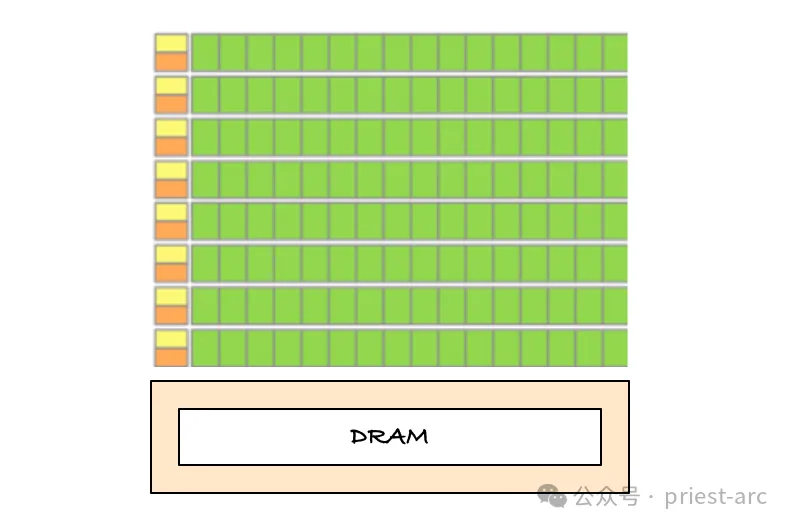

GPU 的架構設計非常獨特,由成百上千個小型處理單元組成,每個處理單元能夠獨立并行執(zhí)行指令。這種高度并行的處理能力使 GPU 能夠同時處理海量數(shù)據(jù),這也是其與多核 CPU 的相似之處。CPU 雖然也有多核設計,但每個核心的任務通常是串行執(zhí)行的。而 GPU 的每個小型處理單元(通常稱為“流處理器”或“CUDA 核心”)則可以相互并行執(zhí)行不同的指令集,使得 GPU 能夠在短時間內處理大量計算任務。

在圖形渲染領域,GPU 的并行計算能力展現(xiàn)得尤為明顯。渲染一個復雜的 3D 場景需要進行大量的數(shù)學計算,這些計算通常涉及到諸如光線追蹤、陰影處理、紋理貼圖和顏色渲染等高復雜度的操作。每個屏幕上顯示的畫面都由數(shù)百甚至數(shù)千個幾何多邊形組成,而每個多邊形都有其獨立的顏色、光照反射、運動軌跡等物理特性。所有這些計算都需要在極短的時間內完成,尤其是在圖形密集型應用(如視頻游戲、3D動畫制作等)中,每秒鐘畫面的刷新和渲染速度要求非常高。

CPU(中央處理器)雖然在邏輯處理和一般計算任務上表現(xiàn)出色,但它并非為這種海量并行處理設計的。圖形渲染的復雜性超出了 CPU 的處理能力,因為它必須在極短的時間內完成大量涉及數(shù)學、幾何和光線計算的操作。為了保證游戲、影視特效、虛擬現(xiàn)實等應用能夠流暢運行,GPU 通過其強大的并行計算架構接管了這些復雜的任務。

GPU vs CPU 類型解析

1. CPU 類型:

CPU(中央處理器) 是計算機的“大腦”,負責執(zhí)行各種指令。目前市場上主要有以下幾種類型的 CPU,具體可參考:

- 英特爾酷睿(Intel Core)處理器: 作為 PC 市場的老牌霸主,英特爾酷睿系列處理器以其出色的性能和廣泛的兼容性而聞名。無論是辦公、娛樂還是專業(yè)創(chuàng)作,酷睿處理器都能勝任。

- AMD Ryzen 處理器: AMD 的 Ryzen 系列處理器憑借出色的性價比和多核性能,近年來迅速崛起。在游戲、內容創(chuàng)作等領域,Ryzen 處理器與酷睿處理器不相上下,甚至在某些方面表現(xiàn)更佳。

- ARM 處理器: ARM 處理器以低功耗、高性能的特點而著稱,廣泛應用于智能手機、平板電腦、物聯(lián)網(wǎng)設備等移動設備中。ARM 架構的能效比使其成為移動設備的首選。

此外,值得一提的是 APU(加速處理單元)。APU 將 CPU 和 GPU 集成到一個芯片上,可以提供更平衡的性能,特別適合對圖形性能要求不高但又需要一定計算能力的設備。

2. GPU 類型

GPU(圖形處理單元) 是專門設計用于處理圖形和圖像的硬件,在游戲、視頻編輯、3D 建模、科學計算等領域發(fā)揮著越來越重要的作用。目前市場上主要有以下幾種類型的 GPU,具體可參考:

- NVIDIA GeForce Cards: NVIDIA 的 GeForce 系列顯卡以其強大的游戲性能和豐富的驅動支持而深受游戲玩家喜愛。在高端游戲市場,GeForce 顯卡一直處于領先地位。其采用 CUDA 核心,支持實時光線追蹤、DLSS 等先進技術,為玩家?guī)肀普娴囊曈X體驗。

- AMD Radeon Cards: AMD 的 Radeo n顯卡在游戲性能和專業(yè)圖形應用方面表現(xiàn)出色,同時價格相對親民。Radeon 顯卡在專業(yè)領域也有一定的市場份額。其采用 RDNA 架構,在游戲和內容創(chuàng)作方面具有競爭力。

- 集成 GPU: 集成 GPU 通常內置于 CPU 中,體積小、功耗低,適合筆記本電腦、平板電腦等移動設備。雖然性能不及獨立顯卡,但對于日常辦公、上網(wǎng)等任務已經(jīng)足夠。

- 人工智能專用 GPU: 隨著人工智能技術的快速發(fā)展,專門針對 AI 計算任務設計的 GPU 應運而生。例如,NVIDIA 的 Tesla 系列和 AMD 的 Radeon Instinct 系列 GPU 在深度學習、機器學習等領域具有強大的加速能力。這些 GPU 擁有大量的 CUDA 核心或計算單元,以及高帶寬的內存,能夠高效處理大規(guī)模并行計算任務。

此外,GPU 的分類還可以從架構上進行劃分,具體:

- 流處理器架構: NVIDIA 的 CUDA 架構和 AMD 的 RDNA 架構都是典型的流處理器架構。流處理器是 GPU 的基本計算單元,它們并行處理大量的線程。

- Tensor 核心架構: 專為深度學習設計的 Tensor 核心能夠高效處理矩陣運算,加速神經(jīng)網(wǎng)絡的訓練和推理。

GPU vs CPU 差異性對比分析

從本質上來講,GPU 在功能上與 CPU 有相似之處:兩者都由內核、內存以及其他關鍵組件組成。然而,盡管二者共享一些基本結構特征,但工作原理卻大相徑庭。 GPU 的設計初衷是為了實現(xiàn)高效的大規(guī)模并行計算,與 CPU 不同的是,它并不注重通過頻繁的上下文切換來管理多個任務。相反,GPU 依賴于其數(shù)百甚至上千個相對較小的處理內核來同時處理大量數(shù)據(jù)。這種并行處理的架構使 GPU 在處理圖形渲染和科學計算等需要同時處理大量數(shù)據(jù)的任務時具備無與倫比的優(yōu)勢。

通常而言,GPU 的每個內核通常沒有 CPU 內核那么強大,在單線程任務上的性能遠不及 CPU。CPU 核心專注于快速、順序地處理復雜指令集,并且在執(zhí)行頻繁切換和多任務操作時表現(xiàn)出色。而 GPU 的內核則更為簡化,每個內核的任務相對獨立和單一,從而使得它們能夠大量并行地執(zhí)行同一類型的簡單操作。正基于此種架構,使得 GPU 可以同時處理海量數(shù)據(jù)并迅速完成計算任務,尤其是在圖形渲染、科學計算以及人工智能訓練中表現(xiàn)出色。

GPU 在其架構上存在的另一限制是與其他硬件的互操作性相對較差。與 CPU 相比,GPU 在與不同硬件 API 或非本地內存的交互上往往效率不高。這意味著在某些需要頻繁的跨設備數(shù)據(jù)交換或非本地內存管理的應用場景中,GPU 的表現(xiàn)不如 CPU 來得靈活高效。

然而,GPU 真正的優(yōu)勢在于并行處理大量數(shù)據(jù)的能力。當面臨需要快速渲染復雜圖像或執(zhí)行大規(guī)模矩陣計算的任務時,GPU 的表現(xiàn)是無可比擬的。它能夠接收大批量的任務指令,并通過數(shù)百上千個內核并行處理這些數(shù)據(jù)。這使得 GPU 可以在短時間內處理和推送大量已經(jīng)處理好的數(shù)據(jù),極大地提升了任務的執(zhí)行速度。在圖形渲染過程中,GPU 不需要像 CPU 那樣逐步處理每個多邊形或像素,而是通過批處理方式接受圖形渲染的指令,并以極快的速度將處理結果推送到顯示設備上。

關于 GPU 應用于深度學習的一點思考

作為一種基于人工神經(jīng)網(wǎng)絡(ANN)的技術,深度學習能夠從龐大的數(shù)據(jù)集中提取出高度精確的預測。這種能力使得深度學習在各個行業(yè)中得到了廣泛應用,無論是自動駕駛、醫(yī)療診斷,還是金融預測,都離不開深度學習模型的支持。

為了從海量信息中提取出有價值的預測,模型訓練需要在盡可能短的時間內處理大量的數(shù)據(jù)。這一過程中,需要極為強大的計算能力來支持,否則將難以在合理的時間范圍內完成訓練任務。簡單來說,深度學習模型的訓練不僅需要高效的算法,還需要充足的計算資源,以應對不斷增長的數(shù)據(jù)量和復雜的計算需求。

當他們嘗試從大規(guī)模訓練模型中提取最佳性能時,往往會遇到計算能力的瓶頸,開始體驗到處理延遲的增加。隨著數(shù)據(jù)集的規(guī)模擴大,過去幾分鐘內就能完成的任務,現(xiàn)在可能需要數(shù)小時、甚至數(shù)周的時間才能完成。這種延遲不僅影響工作效率,還可能阻礙模型的優(yōu)化與迭代。

在過去,單個強大的 CPU 內核曾是高計算任務的首選,但隨著任務復雜度的增加,這一模式已逐漸被擁有并行處理能力的多處理單元所取代。這些單元能夠同時執(zhí)行大量計算任務,并在處理海量數(shù)據(jù)時表現(xiàn)出色。而這種并行計算單元的最佳代表,正是 GPU(圖形處理單元)。

起初,GPU 主要用于加速圖形渲染,生成圖形幀的速度遠超傳統(tǒng)的 CPU,這使得 GPU 成為流暢圖形體驗的核心組件。然而,隨著深度學習的興起,人們發(fā)現(xiàn) GPU 不僅在圖形處理上表現(xiàn)優(yōu)異,其架構也非常適合執(zhí)行需要大規(guī)模并行計算的任務,尤其是神經(jīng)網(wǎng)絡的訓練。

例如,在深度學習中,矩陣運算是神經(jīng)網(wǎng)絡訓練的核心操作,而矩陣運算本質上屬于并行計算。GPU 的架構正好能夠高效地執(zhí)行這些并行計算任務,因此在處理大規(guī)模矩陣運算時,GPU 表現(xiàn)出了極大的優(yōu)勢。這種能力使得 GPU 成為了現(xiàn)代深度學習中不可或缺的計算工具。

綜上所述,隨著人工智能、大數(shù)據(jù)等技術的不斷發(fā)展,對計算能力的需求將持續(xù)增長。GPU 作為加速計算的重要工具,其應用范圍將不斷拓展。未來,我們不僅會在深度學習、機器學習領域看到 GPU 的身影,在自動駕駛、生物醫(yī)藥、金融科技等領域,GPU 也將發(fā)揮關鍵作用。

Reference :

- [1] https://acecloud.ai/resources/blog/why-gpus-for-deep-learning/

- [2] https://www.weka.io/learn/glossary/ai-ml/cpu-vs-gpu/