使用小型語言模型以預算部署AI

SLM 是一種更具成本效益的方法,它允許公司在安全的環境中將模型適應其專有數據。

譯自Use Small Language Models To Deploy AI on a Budget,作者 Emily Freeman。

AI 正在顛覆科技行業。關于通用人工智能(AGI) 及其取代人類的能力的討論無處不在。無論未來是在十年后還是一年后,許多團隊都需要幫助充分利用 AI。

只有少數公司維護我們所知的 LLM——GPT、Claude、Bard、LaMDA、LLaMA 等——因為訓練所需的資源極其昂貴。LLM在海量數據集上進行訓練。

這些模型僅僅是開始。它們提供了一個令人難以置信的平臺來構建更有效、更定制的解決方案:在您的特定數據上訓練的小型語言模型 (SLM)。

是什么讓 SLM 變小?

簡而言之——參數數量。要理解 SLM 對現實世界應用的價值,您必須了解 LLM 的冗長性。OpenAI 的 GPT-3 有 1750 億個參數,而 Meta 的 Llama 3.1 有一個包含 4050 億個參數的版本。但這意味著什么?

LLM 使用 Transformer 模型來標記和分析數據,利用參數來消費、解釋和生成人類語言。如果您閱讀過任何資料,您可能會發現“標記”和“參數”可以互換使用,但它們是不同的。

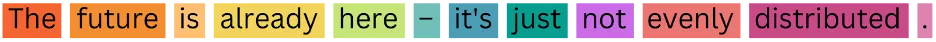

標記是 LLM 的離散數據單元。在下面的示例中,每個詞都被 LLM 作為標記攝取。根據模型的不同,標記可以是詞語、短語、字符等。標記允許 LLM 將數據分解并有效地評估它。例如,LLM 可能將“cats”一詞解釋為與“cat”相同,以標準化信息。

圖片

圖片

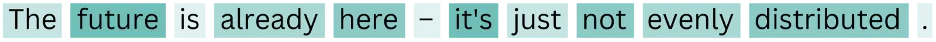

簡而言之,參數是 LLM 用于評估數據的規則——權重和偏差。參數允許 LLM 更強調特定詞語以建立上下文和含義。參數還將詞語鏈接起來;在下面的示例中,“future”和“it’s”指的是同一件事。

圖片

圖片

您可能在問自己,“更多的參數更好嗎?”好吧,就像科技中的所有事物一樣,這取決于情況。如果您需要在墻上掛一幅畫,Home Depot 中的每種工具都比錘子和釘子更好嗎?

LLM 是令人難以置信的技術壯舉,它們計算大量信息的能力越來越好,速度也越來越快。但是,訓練和微調 LLM 所需的成本和時間對于大多數公司來說是不可取的。它們太大了。大多數企業不需要一個萬能工具,而需要一個針對特定任務的特定工具。

這就是 SLM 閃耀的地方。

在您的數據上訓練模型

雖然 LLM 必須使用大量的云資源進行訓練,但訓練 SLM 使用專有數據,并且計算效率高且成本效益高。

假設您是一家政府承包商,負責響應招標書 (RFP) 以獲得合同。通常,您將有一個團隊審查這些 RFP,手動收集響應所需的相關信息,回答有關您的公司如何滿足合同需求的詳細問題,并編寫完整的提案,包括所需的工作角色以及這些工作的相應政府代碼。

RFP 從未公開發布,這意味著 LLM 無法在它們上進行訓練,而您的公司編寫的數百甚至數千份提案都是專有的。

想象一下,如果您可以在所有專有數據上訓練一個 SLM,并讓 SLM 代表您生成詳細的提案。您能想象您的團隊將節省多少時間嗎?您可以通過從基礎模型(如Llama 3.1)開始,并在之前的 RFP 和相應的提案上微調 SLM 來做到這一點。您還可以使用Arcee.AI等工具。

無論哪種情況,為了充分利用您的 SLM,您需要完成四個關鍵步驟:1/ 持續預訓練,2/ 對齊,3/ 模型合并,4/ 檢索增強生成 (RAG) 以及 5/ 持續適應。

了解訓練 SLM 的步驟

想象一下,我們的小型語言模型是 Dominique,一個高中二年級的學生。預訓練是 Dominique 在所有先前年份中學到的所有東西——數學、科學、語言藝術、體育、藝術——所有東西。模型合并是我將擅長數學的 Dominique 與擅長科學的 Asma 配對,讓他們在余下的學年里一起學習和測試。盡管他們在某個特定主題上特別出色,但他們將在兩個主題上都非常出色。

關于對齊和微調,指令調優(對齊的第一部分)可以被描述為 Dominique 在大二時所接受的課程。批評階段(對齊的第二部分)是對 Dominique 作業的反饋。RAG 就像給 Dominique 一場開卷考試;她可以查找相關信息來幫助她取得更好的成績。最后,持續適應會更新 Dominique 的知識,因為信息會發生變化(例如,冥王星不再是行星),所以她擁有最新、最及時信息。

實施您的模型

在政府承包商的例子中,他們想要構建一個 SLM 來撰寫提案。開發人員將使用一個較小的開源模型,例如 Llama 的較小版本之一(70B 或 8B 參數),并使用其先前提案、先前 RFP 和任何其他相關文本數據的專有數據對其進行訓練。

然后可以使用開源工具將該模型合并 - 可能是專門用于語言或其他特定領域的更通用的模型。例如,如果他們有一個專門為軍隊創建提案(使用特定術語和詞匯)的模型,以及另一個專門為建造火箭撰寫提案的模型,則可以將它們合并以撰寫高度專業和準確的建造軍隊火箭的提案。請記住,只有當模型具有相同的架構和大小時,才能將它們合并。

從那里,他們將希望對齊這個新合并的模型,以確保它提供所需的結果。這包括提供預期結果的示例,并與模型交互以測試它是否生成所需類型的內容。

雖然像 Arcee.AI 這樣的工具可以在沒有 RAG 的情況下獲得相同的結果,但如果您是從頭開始構建,則可以使用 RAG 層來允許它準確地檢索特定信息并生成更準確的文本或進行實時數據檢索。例如,政府職位代碼將是保存在 RAG 層中的絕佳數據。

最后,就像人類一樣,SLM 始終在不斷發展和學習。部署后,模型可以隨著業務數據和需求的變化而更新。根據新數據的頻率,計劃每六到十二個月重新訓練您的模型。

充分利用 AI

LLM 只能帶您走這么遠,并且沒有真正的市場差異化。畢竟,您使用的是與其他人相同的數據 - 從(通常是開源)數據收集的通用信息。

SLM 是一種更具成本效益的方法,允許公司在安全的環境中將模型適應其專有數據。更不用說 SLM 對地球更友好,因為它們使用的計算資源明顯更少,并且在能源方面更環保。SLM 提供的響應能力和適應能力水平是當前生成式 AI 技術無法比擬的。它提供了使用生成式 AI 來改善您的業務的最終途徑。