炸裂!本地部署,輕松切換多個 AI 模型

周末一直在耍 AI 本地部署個人知識庫,基本都是基于 OpenAI 的開放接口進行封裝,亦或者你本地部署自己部署一個小模型。

感覺這兩個要求對小白玩家都太高了,一個要求有科學上網能力,一個要求你電腦帶高端顯卡能夠本地部署。

今天給大家帶來一個炸裂產品gpt_academic,你可以玩 GPT-3、GPT-4、Claude-2 等國外模型,也可以玩國內文心一言、星火、通義千文等國產大模型。

一、部署項目

1、前置條件

通過 docker-compose 方式啟動一直有點問題,應該是鏡像有問題,看 issue 也有很多人提問,索性就直接根據源碼進行啟動。

需要我們本地安裝好 Pyhton 環境,這個就不多做介紹,網上有很多教程。

2、下載&安裝

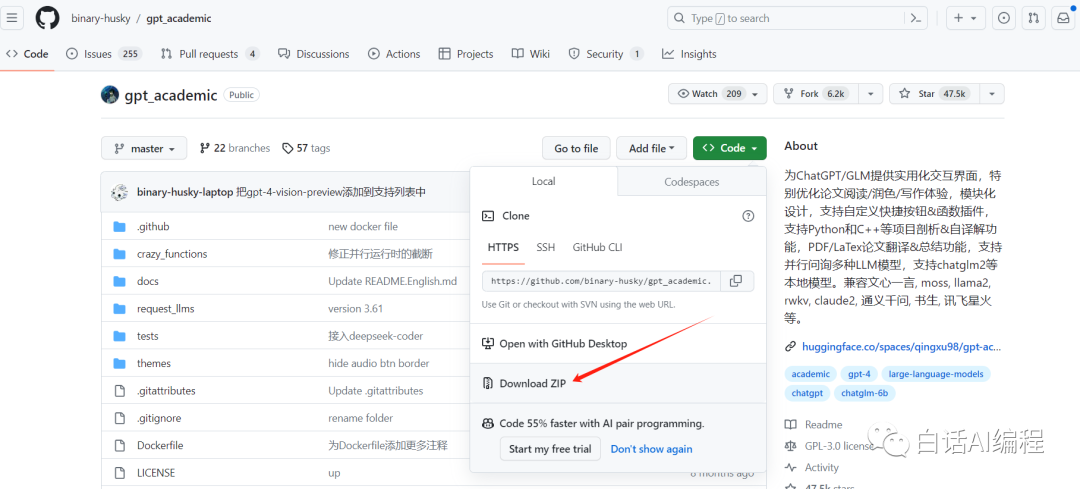

gpt_academic 的 GitHub 地址:https://github.com/binary-husky/gpt_academic

進入到上方網址,直接下載(免去安裝 Git)

圖片

圖片

下載好之后解壓到你對應 Python 項目位置,嘗試啟動時會出現很多組件需要安裝,大家根據提示逐一安裝即可。

3、國內模型配置

如果使用的時國內大模型比較簡單,映射關系如下:

公司 | 模型名稱 |

訊飛星火 | spark、sparkv2、sparkv3 |

通義千問 | qwen |

百度千帆 | qianfan |

智譜 AI | zhipuai |

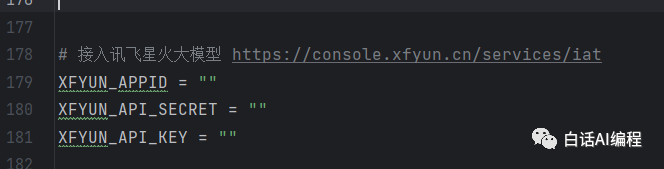

這里我們以使用訊飛星火舉例,主要是訊飛實名注冊即送星火大模型3.0的200萬 token數。

圖片

圖片

實名注冊后拿到星火的 API 信息,將其填充到 config.py 這個文件對應的星火模型配置處。

圖片

圖片

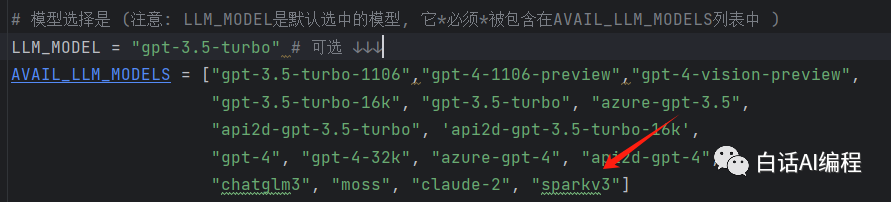

最后將 sparkv3 模型填充到 config.py 的 AVAIL_LLM_MODELS 屬性中:

圖片

圖片

這樣就可以直接啟動項目使用了。

4、國外模型配置

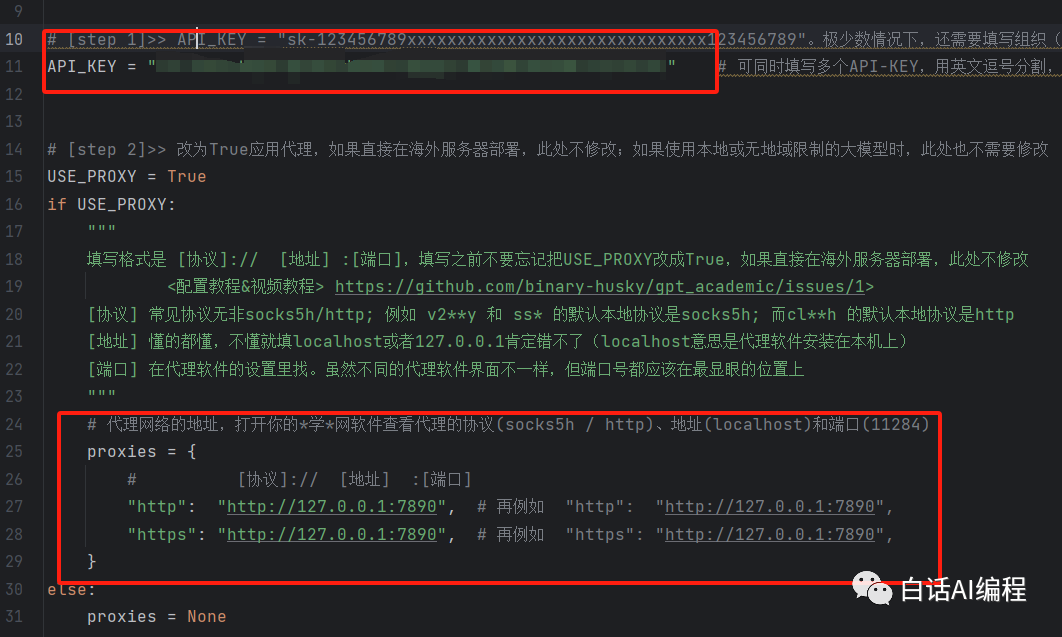

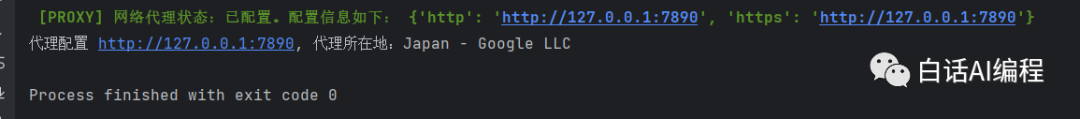

使用國外模型就會比較復雜一些,我們需要配置好代理,運行 check_proxy.py 文件看是否存在問題。

這里以我使用的 Clash 軟件為例,查看代理端口并在代理頁面切換至全局模式:

圖片

圖片

將上面獲取到的本地端口配置到 config.py 文件,修改兩處地方:

- 將你的 OpenAI Key 進行填充進去

- 修改你本地的代理端口,我的就是 http://127.0.0.1:7890

圖片

圖片

運行 check_proxy.py 文件輸出結果如下就表示通過,否則還需要調整配置(使用的軟件不同,大家自行解決):

圖片

圖片

5、應用實戰

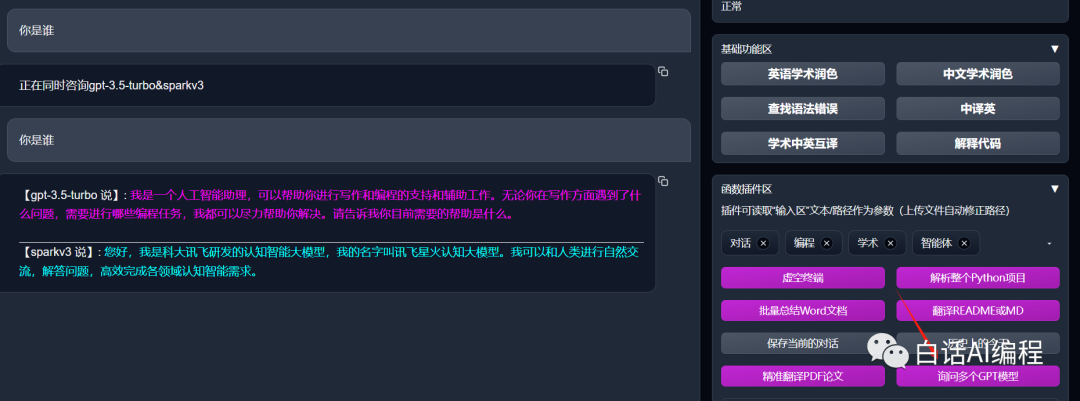

這里如果大家想使用多模型輸出(同時詢問多個 AI 模型),還需要修改一個配置:

# 定義界面上“詢問多個GPT模型”插件應該使用哪些模型,請從AVAIL_LLM_MODELS中選擇,并在不同模型之間用`&`間隔,例如"gpt-3.5-turbo&chatglm3&azure-gpt-4"

# 默認 MULTI_QUERY_LLM_MODELS = "gpt-3.5-turbo&chatglm3"

MULTI_QUERY_LLM_MODELS = "gpt-3.5-turbo&sparkv3這里就配置 gpt-3.5-turbo 和 sparkv3,如果大家有更多模型可以都配置上去。

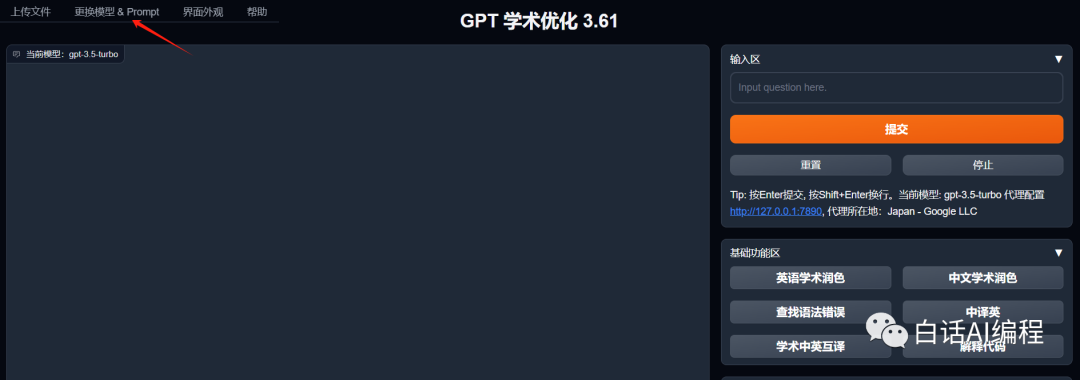

然后我們運行 main.py 文件即可,運行成功會自動彈出頁面 http://localhost:29717,端口每次都是隨機的。

圖片

圖片

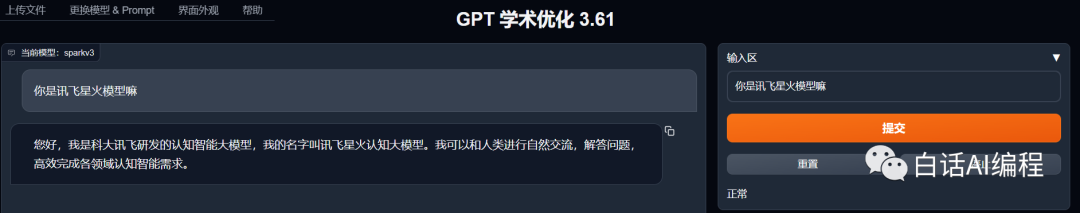

在右上角可以切換不同的模型,默認是使用 gpt-3.5 模型。我們將其切換到星火模型看看,效果如下:

圖片

圖片

在頁面右下角,我們選擇詢問多個模型試下,可以看到同時輸出了結果。

圖片

圖片

這里還可以直接輸入文件內容,有 AI 幫你總結。其實就是將你文件的內容轉換成文本發給模型,最后會返回總結文件給你。

圖片

圖片

二、總結

里面功能還是很多,大家可以挖掘一下。我嘗試將整個 Java 項目導入,結果返回的只是對每個文件代碼的解讀,實際上沒啥大用(花費了我15萬 token 數,心痛~ )。