RCBEVDet++:邁向高精度雷達-攝像頭融合3D感知網絡 !

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

感知周圍環境是自動駕駛的基本任務。為了獲得高度精確和魯棒的感知結果,現代自動駕駛系統通常采用多模態傳感器,如LiDAR、多視角攝像頭和毫米波雷達,來收集全面的環境數據。

在這些傳感器中,雷達與攝像頭多模態感知系統尤其受到青睞,因為其具有出色的傳感能力和成本效益。然而,毫米波雷達與多視角攝像頭傳感器之間的巨大模態差異給從這兩種傳感器融合信息帶來了顯著的挑戰。

為了解決這個問題,本文提出了RGEVDet,一種雷達與攝像頭3D目標檢測框架。具體而言,RGEVDet基于現有的基于相機的3D目標檢測模型,輔以專門設計的雷達特征提取器RadarBEVNet和雷達與攝像頭交叉注意力多層融合(CAMF)模塊。

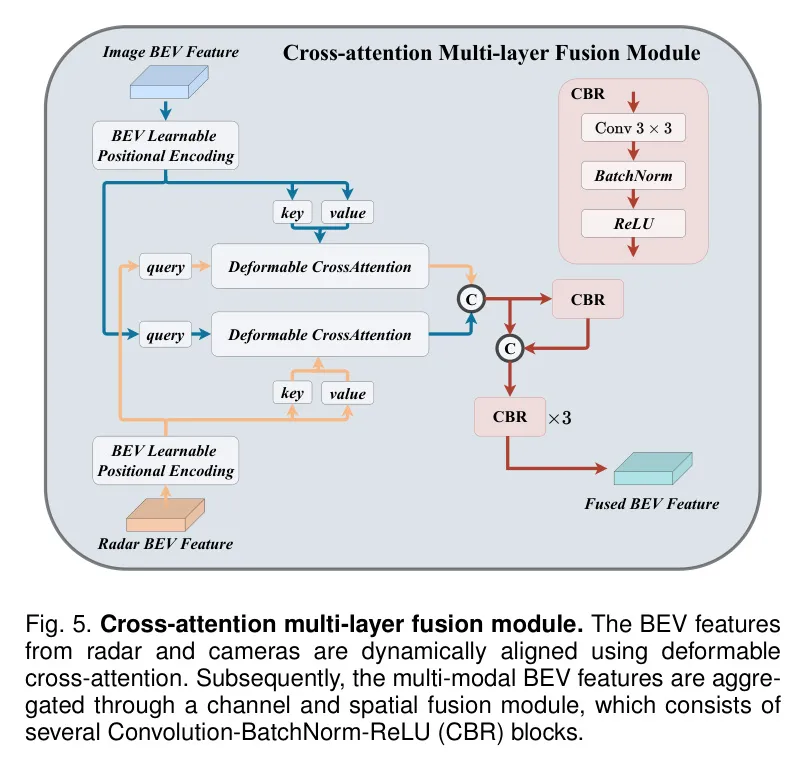

首先,RadarBEVNet使用雙流雷達 Backbone 網絡和Radar Cross Section(RCS)感知的BEV編碼器,將稀疏的雷達點編碼為密集的鳥瞰視圖(BEV)特征。其次,CAMF模塊利用變形注意力機制將雷達和攝像頭的BEV特征對齊,并采用通道和空間融合層來融合這些多模態特征。

為了進一步提高RGEVDet的性能,作者提出了RGEVDet++,該方法在稀疏融合的CAMF上進行改進,支持基于 Query 的多視角攝像頭感知模型,并適應于更廣泛的感知任務。

在nuScenes數據集上的大量實驗表明,作者的方法與現有的基于相機的3D感知模型無縫集成,并在各種感知任務上提高它們的性能。

此外,作者的方法在3D目標檢測、BEV語義分割和3D多目標跟蹤任務中實現了最先進的重疊雷達與攝像頭融合結果。值得一提的是,利用ViT-L作為圖像 Backbone ,RGEVDet++在無需測試時間增強或模型集成的情況下,實現了3D目標檢測的72.73 NDS和67.34 mAP。

源代碼和模型將在https://github.com/VDiGRU/ROGEVDet。

1 Introduction

自動駕駛旨在通過開發無需人工干預的系統來提高交通的安全性、效率和便利性[2, 3]。對于這些系統來說,的一個重要挑戰是像人類一樣全面感知周圍環境,這對于精確軌跡預測和運動規劃至關重要。為了實現這一點,現代自動駕駛系統主要采用三種傳感器,例如多視圖攝像頭、毫米波雷達和激光雷達,以收集周圍環境的信息。

在這些類型的傳感器中,激光雷達傳感器提供詳細的幾何信息,顯著提高了感知過程,導致最佳性能[4]。然而,高質量激光雷達傳感器的價格昂貴,增加了制造成本。相比之下,多視圖攝像頭和毫米波雷達傳感器為制造商和用戶提供了更經濟的選擇。與激光雷達相比,多視圖攝像頭捕獲了復雜的細節,如顏色和紋理,提供了高分辨率的語義信息,而毫米波雷達在測距和速度估計方面具有優勢,在多種天氣和照明條件下都能可靠工作[5] [6]。此外,4D毫米波雷達技術的進步逐漸克服了稀疏雷達點的限制,成為潛在的替代方案[8]。盡管這些具有優勢,但激光雷達與攝像頭或雷達基于的感知模型之間仍存在明顯的性能差距。橋接這個差距的實用且有效的策略是將毫米波雷達與多視圖攝像頭集成在一起,這可以互相補充,從而實現更全面和可靠的環境感知。

為了融合雷達和圖像數據,近年來[9, 10]主要采用將多視圖圖像特征和雷達特征投影到鳥瞰視角(BEV)的BEVFusion Pipeline [4]。然而,像BEVFusion所采用的簡單融合技術(如 ConCat 或求和)無法解決多視圖圖像和雷達輸入之間的空間對齊問題。此外,大多數雷達-攝像頭融合方法[12, 13, 14]仍使用原本用于激光雷達點(如PointPillars)的編碼器來提取雷達特征。雖然這些方法可以產生令人稱贊的結果,但它們所使用的特定激光雷達編碼器并沒有考慮到雷達的獨特特性,如雷達橫截面(RCS),導致性能不佳。

在本文中,作者提出了一種名為RGEVDet的新框架,用于將雷達和相機的特征在BEV空間中有效地融合在一起,進行3D目標檢測任務。針對雷達輸入的獨特特性,作者專門設計了一個名為RadarBEVNet的方案,以實現高效的雷達BEV特征提取。具體而言,RadarBEVNet首先通過雙流雷達解碼器將雷達輸入編碼為不同的點對基和Transformer基表示。此外,作者還實現了一個注入和提取模塊,將這兩個表示整合在一起。接下來,這些特征通過RCS感知的散射轉換為BEV特征,其中RCS被用作目標大小的先驗和分配點特征到BEV空間的任何位置。除了RadarBEVNet之外,RCBEVDet還集成了一個交叉注意力多層融合模塊(CAMF),以在BEV空間內實現雷達和相機的特征融合。CAMF使用多模態交叉注意力自適應校正兩種BEV特征之間的坐標不匹配,然后應用通道和空間融合層來進一步鞏固多模態特征,提高整體檢測性能。

為了充分利用RCBEVDet的功能,作者升級了CAMF模塊,支持稀疏融合以支持基于 Query 的多視相機的感知模型。此外,作者還擴展了RCBEVDet的功能,包括3D目標檢測、BEV語義分割和3D多目標跟蹤等更廣泛的感知任務。這個增強的框架被稱為RCBEVDet++。具體而言,為了適應基于 Query 的多視相機的感知方法,作者用與原始相機BEV特征不同的基于目標3D坐標的相機 Query 進行替換。這開發了一種新的 Query 組件在作者的多模態交叉注意力機制中。接下來,作者進行了一個投影和采樣過程,其中,相機目標 Query 被投影到BEV空間,并與相應的雷達特征進行匹配,以形成雷達目標 Query 。然后,作者使用可變形交叉注意力對多模態 Query 進行對齊。最后,調整后的多模態 Query 被 ConCat 并送入一個簡單的線性層進行有效的特征融合,從而在擴展的任務范圍內提高感知性能。

本文的主要貢獻如下:

- 本文介紹了一種名為RCBEVDet的高度精確和魯棒的3D目標檢測雷達-攝像頭融合框架。該框架包括RadarBEVNet用于雷達BEV特征提取和Cross-Attention Multi-layer Fusion Module (CAMF)用于在BEV空間中進行魯棒雷達-攝像頭特征融合。

- 基于RCBEVDet,作者進一步提出了RCBEVDet++感知框架,該框架擴展了CAMF模塊以容納基于 Query 的多視攝像頭感知模型,并充分發揮了RCBEVDet在各種3D感知任務中的全部潛力。

- 在nuScenes基準測試中,RCBEVDet提高了基于攝像頭的3D目標檢測器的性能,并針對傳感器故障情況展示了魯棒性。此外,RCBEVDet++進一步增強了基于攝像頭的感知模型,在雷達-攝像頭多模態3D目標檢測、BEV語義分割和3D多目標跟蹤任務中實現了最先進的結果。

2 Related Work

Camera-ased 3D Perception

三維目標檢測、BEV語義分割和三維多目標跟蹤是自動駕駛的三個基本感知任務。目前,許多三維多目標跟蹤方法通常采用跟蹤-通過檢測框架,該框架利用三維目標檢測的結果來關聯物體。這些跟蹤方法關注的是物體匹配,而不僅僅是高效處理輸入圖像。此外,更準確的檢測結果可以帶來更高的跟蹤性能。因此,在這一部分,作者將主要討論處理多幀多視角攝像頭輸入的更豐富的三維目標檢測和BEV語義分割方法。具體來說,三維目標檢測旨在預測三維物體的位置和類別,而語義分割則整合了車輛識別、語義車道地圖預測和可行駛區域估計任務。然而,由于三維信息的不足,在三維空間中使用攝像頭圖像檢測物體和分割地圖具有挑戰性。近年來,許多研究已經為解決這個問題做出了很大的努力,包括從圖像中推理深度[21],利用幾何約束和形似先驗[22],設計特定的損失函數[23, 24],以及探索聯合三維檢測和重構優化[25]。最近,多視角傳感器已成為自動駕駛車輛的流行配置,為提供更全面的環境信息。多視角相機數據集的出現[26, 27]導致了多視角三維目標檢測和BEV語義分割方法的發展,可以大致分為基于幾何的方法和基于 Transformer 的方法兩種。

2.1.1 Geometry-based Methods

基于幾何的多視三維目標檢測和BEV語義分割主要利用深度預測網絡來估計圖像的深度分布。這使得可以將從提取的2D圖像特征轉換為3D相機 Frustum 特征。然后,通過 Voxel 池化等操作在 Voxel 或BEV空間構建特征。

具體而言,Lift-Splat-Shoot(LSS)[28] 首次利用輕量級深度預測網絡明確估計每個圖像的深度分布和上下文向量。深度和上下文向量的外積決定了沿視角射線在3D空間中每個點上的特征,從而實現了將圖像特征有效轉換為BEV特征。在 LSS 的基礎上,FIERY[38] 引入了一個基于BEV的未來實例預測模型,能夠預測動態代理的未來實例及其運動。BEVDet[16] 將視角變換技術從 LSS 擴展到使用BEV特征檢測3D物體。此外,BEVDepth[29] 利用 LIDAR 的顯式深度信息作為監督來增強深度估計,并將攝像機的外部參數作為深度估計的先驗參數。基于 BEVDet,BEVDet4D[30] 在歷史幀之間對BEV特征進行空間對齊,顯著提高了檢測性能。此外,SOLOFusion[39] 提出將高分辨率短期和低分辨率長期特征融合,提高具有長期時間輸入的3D檢測的推理速度。

2.1.2 Transformer-based Methods

基于Transformer的方法利用注意力機制將預定義的 Query 投影到多個視圖圖像平面上,使用坐標變換矩陣,并隨后更新 Query 特征和多視圖圖像特征。具體來說,開創性工作DETR3D [31]使用Transformer解碼器進行3D目標檢測,發展了一種自頂向下框架,并利用一套一套的損失來衡量 GT 值和預測之間的差異。

類似地,CVT [35]引入了一個簡單的BEV語義分割基準,該基準使用交叉視圖Transformer架構。在這一點之后,BEVformer [17]構建了密集的BEV Query ,并采用了多尺度變形注意力,將多視圖圖像特征映射到這些密集 Query 。此外,PETR [32]通過將來自3D坐標的顯式位置信息生成多視圖圖像特征。在PETR的基礎上,PETRv2 [40]將時間融合跨多個幀集成,并擴展3D位置嵌入,具有時間感知建模。

此外,Sparse4D [41]為每個3D Anchor 點分配和投影多個4D關鍵點,以生成不同的視圖、 aspect ratio 和時間戳特征,然后將這些特征分層融合以提高整體圖像特征表示。

Sparse4Dv2 [42]擴展了Sparse4D,采用了更高效的時間融合模塊,并引入了攝像機參數編碼和密集深度監督。最近,StreamPETR [34]利用稀疏目標 Query 作為中間表示來捕獲時間信息,并采用了自適應尺度自注意力模塊和自適應空間-時間采樣模塊的SparseBEV [33],以動態捕獲BEV和時間信息。

Radar-camera 3D Perception

毫米波雷達由于其低成本、長距離感知、多普勒速度測量以及對抗惡劣天氣條件的魯棒性,在自主車輛中得到了廣泛應用。盡管毫米波雷達數據通常包括距離、角度和速度信息,但在測量目標的俯仰角方面表現相對較差。此外,毫米波雷達數據固有的稀疏性和缺乏語義信息,對純雷達基于的3D感知提出了挑戰。因此,毫米波雷達通常被用來增強多模態3D感知系統的性能,作為輔助模式。

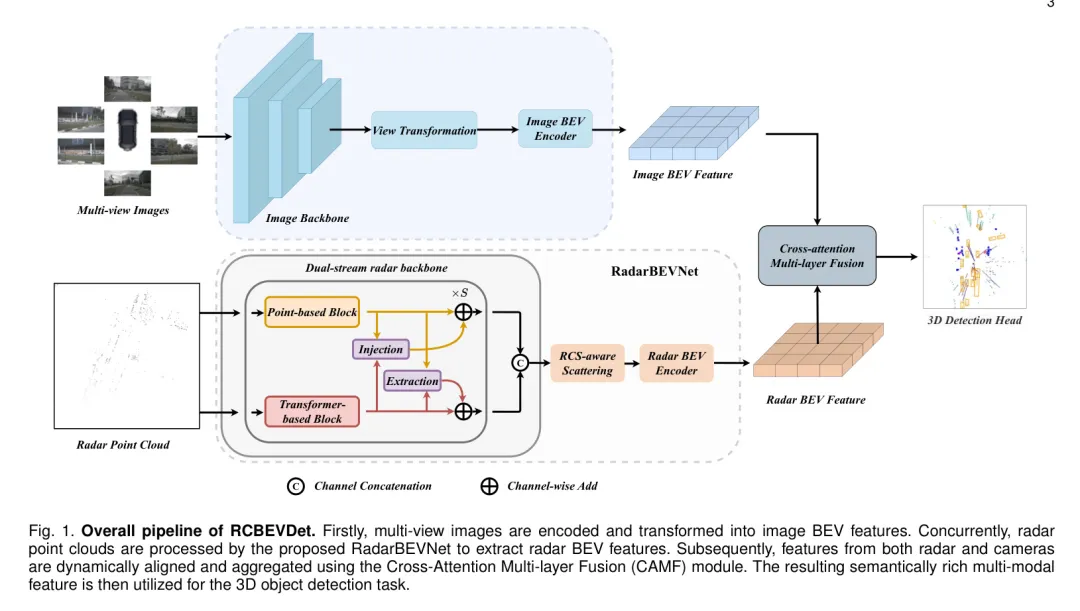

圖1:RCEVDet的整體 Pipeline 。首先,通過圖像編碼器處理多視圖圖像并提取特征,然后使用視圖轉換模塊將這些特征轉換為圖像BEV特征。同時,雷達點云通過提出的RadarBEVNet編碼為雷達BEV特征。接下來,圖像和雷達BEV特征使用Cross-Attention Multi-layer Fusion模塊動態對齊和聚合。最后,將融合后的多模態語義豐富的BEV特征用于3D目標檢測任務。

近年來,由于多視圖攝像頭和毫米波雷達傳感器在3D感知方面的互補性質,其組合引起了廣泛關注。具體來說,RadarNet [43]引入了雷達-攝像頭融合的多級融合 Pipeline ,以提高遠程目標檢測的準確性和減少速度誤差。CenterFusion [14]利用關鍵點檢測網絡從圖像生成初始的3D檢測結果,并將基于柱子的雷達關聯模塊用于通過將雷達特征與相應的檢測框鏈接來細化這些結果。類似地,MVFusion [44]實現了攝像頭和毫米波雷達之間的語義對齊,增強了這兩者之間的交互。

此外,Simple-BEV [45]調查了多傳感器BEV感知系統的體系結構設計和超參數設置。CRAFT [12]提出了一種使用Soft-Polar-Association和Spatio-Contextual Fusion Transformer的 Proposal 級融合框架,用于高效地在攝像頭和毫米波雷達之間交換信息。RADIANT [46]開發了一個網絡來估計雷達回波和物體中心之間的位置偏移,并利用雷達深度信息來增強攝像頭的特征。近年來,CRN [13]為多視圖轉換生成雷達增強圖像特征并采用雷達深度信息,并利用交叉注意機制解決雷達和攝像頭傳感器之間的空間不對齊和信息不匹配問題。

RCFusion [9]利用雷達PillarNet [47]生成雷達偽圖像,并提出了一種加權融合模塊有效地將雷達和攝像頭的BEV特征進行融合。

BEVGuide 基于CVT 框架并提出了一種基于BEV的傳感器無關的關注模塊,有助于BEV表示學習和理解。BEVCar [37]引入了一種創新的雷達-攝像頭融合方法,用于BEV圖和目標分割,并采用基于注意的圖像提升策略。

RadarBEVNet

先前雷達-攝像頭融合方法通常使用設計用于激光雷達點云的雷達編碼器,如PointPillars 。相比之下,作者引入了RadarBEVNet,專為高效雷達BEV特征提取而設計。RadarBEVNet通過雙流雷達 Backbone 網絡和RCS感知的BEV編碼器將稀疏雷達點編碼為密集的BEV特征,其中RCS感知的BEV編碼器利用RCS作為一個物體大小的先驗,將單個雷達點的特征分散到BEV空間中的多個像素中。

3.1.1 Dual-stream radar backbone

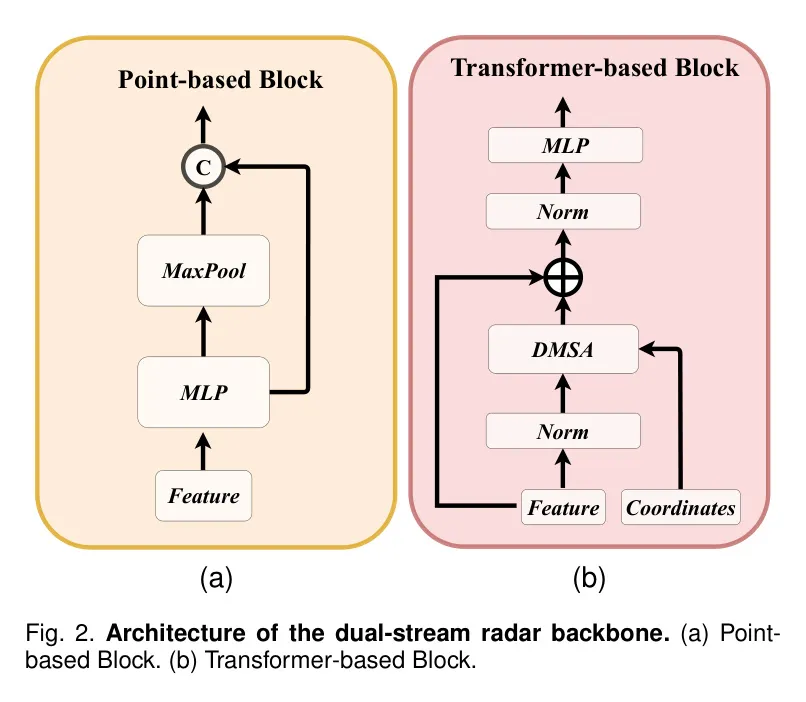

雙流式雷達 Backbone 結構包含兩部分:基于點的 Backbone 結構和基于 Transformer 的 Backbone 結構。

基于點的 Backbone 結構專注于學習局部雷達特征,而基于 Transformer 的 Backbone 結構捕獲全局信息。

對于點型的 Backbone 結構,作者采用類似于PointNet[49]的架構。如圖2a所示,點型的 Backbone 結構由S個塊組成,每個塊中包含一個多層感知機(MLP)和一次池化操作。具體而言,輸入雷達點特征f首先通過MLP增加其特征維數。然后,將高維雷達特征送入MaxPool層,并使用殘差連接。整個過程可以形式化為以下公式:

至于基于 Transformer 的 Backbone 結構,它由S個標準 Transformer 塊[50, 51]組成,其中包含注意力機制、前饋網絡和歸一化層,如圖2b所示。由于自主駕駛場景的廣泛范圍,直接使用標準自注意力優化模型可以具有挑戰性。為了應對這個問題,作者提出了一種距離調制自注意力機制(DMSA),通過在早期訓練迭代階段聚合相鄰信息來促進模型收斂。具體而言,給定N個雷達點的坐標,作者首先計算所有點之間的對距離D∈R^{N×N}。

實際上,高斯樣權重圖G賦予點附近的位置高權重,遠離點的位置低權重。作者可以使用生成的權重G調制注意力機制,如下公式所示:

這里d表示輸入特征維數。

在雙流雷達 Backbone 結構中,作者還引入了密集連接的多尺度特征金字塔以捕捉不同空間范圍的信息,并將點型的 Backbone 結構與基于 Transformer 的 Backbone 結構相結合:

作者在多個數據集(包括PASCAL VOC 2007數據集和其他幾個數據集)上對提出的方法進行了驗證。實驗結果表明,與基于單流的信息融合方式相比,雙流雷達 Backbone 結構可以更好地提取局部雷達特征并利用全局信息。

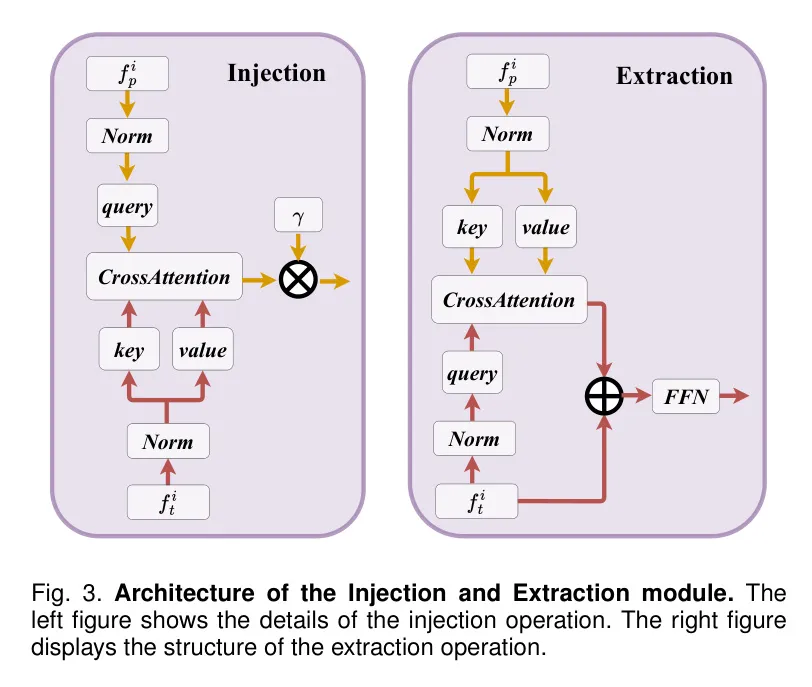

為了增強來自兩種不同后置的雷達特性的交互,作者引入了注入和提取模塊,該模塊基于交叉注意力,如圖3所示。此模塊應用于兩種后置的每個塊。

3.1.2 RCS-aware BEV encoder

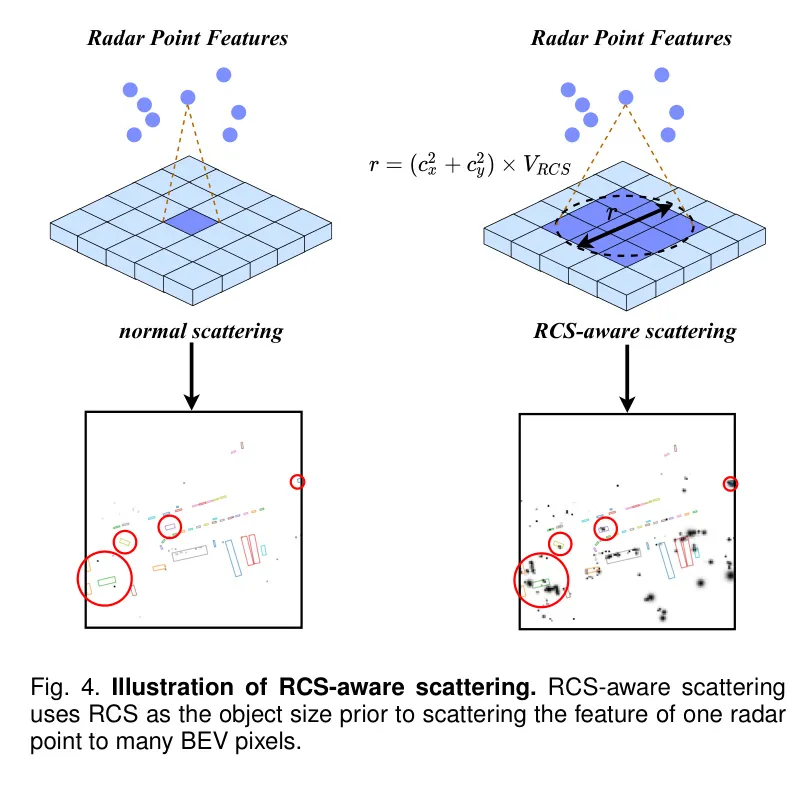

當前的雷達BERV編碼器通常將點特征散射到BERV空間,基于點的3D坐標。然而,這將導致一個稀疏的BERV特征圖,其中大多數像素都包含零值。這種稀疏性使得一些像素有效地聚合特征變得困難,可能會影響檢測性能。一個解決方案是增加BERV編碼器層數,但這也可能導致背景特征將小目標特征平滑掉。為了解決這個問題,作者提出了一種稱為RC-aware的BERV編碼器。雷達橫截面積(RCS)是通過雷達測量目標的可檢測性。例如,較大的物體通常會產生更強的雷達波反射,導致更大的RCS測量。因此,RCS可以提供一個物體的尺寸的粗糙估計。

RC-aware BERV編碼器的關鍵設計是RC-aware散射操作,它利用RCS作為目標的尺寸的先驗估計。利用這個先驗,作者提出的散射操作允許單個雷達點上的特征被散射到BERV空間中的多個像素,而不是局限于一個像素,如圖4所示。

Cross-Attention Multi-layer Fusion Module

在本節開始介紹 交叉注意力多層融合模塊

3.2.1 Multi-modal Feature Alignment with Cross-Attention

3.2.2 Channel and Spatial Fusion

4 Rcbevdet++: Radar-camera sparse fusion for 3D perception

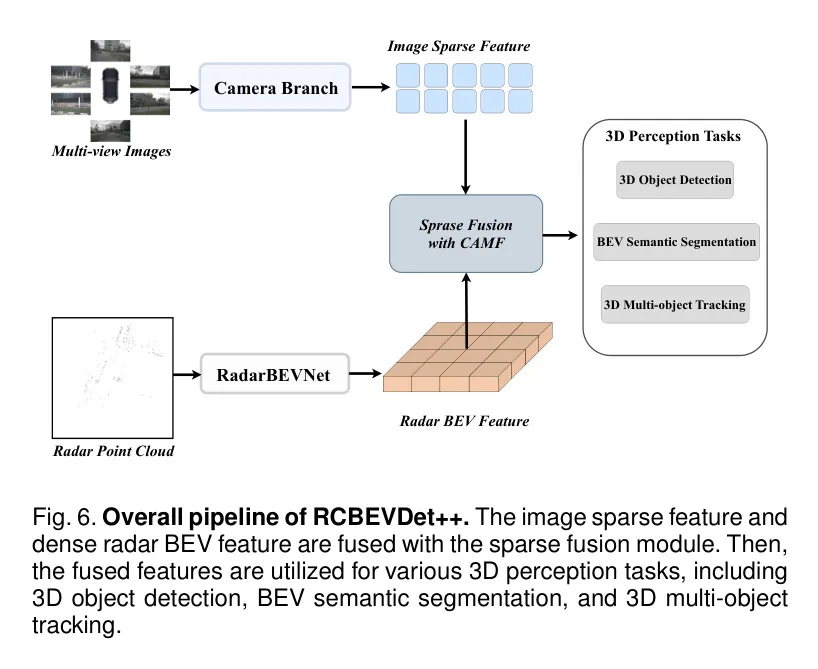

圖6說明了,為了充分挖掘RcbeVDet的潛力,作者將CAMF模塊擴展以支持稀疏融合與基于 Query 的多視點相機感知模型,這種方法比基于BEV的方法獲得了更高的準確度。此外,作者將RcbeVDet應用到了更多的感知任務,包括3D目標檢測,BEV語義分割和3D多目標跟蹤。為了區分這個更新的RcbeVDet版本與原始版本,作者特意將其命名為RcbeVDet++。

Sparse Fusion with CAMF

圖7所示,作者采用CAMF的稀疏融合方法將密集雷達BEV特征和圖像稀疏特征進行融合。具體而言,作者首先用圖像稀疏特征替換原始圖像BEV特征。然后,作者執行一個投影和抽樣過程,使用3D絕對位置將每個圖像稀疏特征與雷達特征關聯。更具體地說,作者將3D絕對位置轉換為BEV,并用雙linear插值采樣相應的雷達特征,以獲得稀疏雷達特征。接下來,作者利用MLP組成的位置編碼網絡將3D絕對位置轉換為3D位置嵌入,并將其添加到多模態 Query 中。然后,為了對齊多模態不匹配,作者采用可變形交叉注意力針對稀疏圖像特征和密集雷達BEV特征,以及針對稀疏雷達特征和稀疏圖像特征采用簡單的交叉注意力。

作者的RCBEVDet++可以生成高質量的多模態特征,這些特征可以用于各種3D感知任務,包括3D目標檢測,3D多目標跟蹤和BEV語義分割。為了預測3D目標的邊框,作者采用 Query 引導的Transformer解碼器[33],并在每個Transformer解碼器層中應用CAMF模塊進行稀疏融合。

然后,作者采用跟蹤檢測框架來進行3D多目標跟蹤任務。具體而言,作者執行基于速度的貪婪距離匹配,即對每個目標在多個幀中計算中心距離,使用預測的加速度補償,并以貪心方式為具有最小中心距離的目標分配相同的ID。

對于BEV語義分割,作者將多模態特征轉換為密集BEV特征,因為這將需要具有類別密度的密集BEV映射。作者遵循CVT[35]解碼器架構來有效地解碼密集BEV特征到具有語義表示的不同圖。此外,作者采用多個頭來執行不同類型的BEV語義分割任務,每個頭處理一個任務,例如車輛分割。最后,作者使用焦損失[54]并采用Sigmoid層作為訓練的監督。

5 Experiments

在本節中,作者通過大量實驗評估 RCBEVDet 和 RCBEVDet++。在第 5.1 節中,作者詳細介紹了實驗設置。在第 5.2 節中,作者將作者的方法與最先進的州界方法在三個任務中進行了比較,這些任務分別是 即 三維目標檢測、BEV語義分割和 3D 多目標跟蹤。在第 5.3 節中,作者進行了一項廣泛的 Ablation 研究,以調查 RCBEVDet 和 RCBEVDet++ 中的單個組件。在第 5.4 節中,作者討論了 RCBEVDet++ 在 BEV 語義分割中的任務權衡。在第 5.5 節中,作者展示了 RCBEVDet 的魯棒性。在第 5.6 節中,作者展示了作者方法的可建模性。

Implementation Details

5.1.1 Datasets and Evaluation Metrics

作者在一項流行的自動駕駛大規模評估標準(nuScenes[26])上進行了實驗,該標準包括美國波士頓和新加坡的1000個駕駛場景。該標準包含850個場景用于訓練和驗證,以及150個場景用于測試。作者在驗證和測試集上報告結果,并與最先進的算法進行比較,同時在驗證集上評估了消融結果。

對于3D目標檢測,nuScenes提供了一組評估指標,包括平均精度(mAP)和五個真陽性(TP)指標:ATE,ASE,AOE,AVE和AAE,分別衡量了轉換、縮放、方向、速度和屬性錯誤。總體性能由nuScenes檢測得分(NDS)衡量,該得分整合了所有錯誤類型:

對于BEV語義分割,作者使用所有分割類別之間的平均交點(mIoU)作為指標,遵循LSS[28]的設置。

對于3D多目標跟蹤,作者遵循nuScenes的官方指標,使用了各種召回閾值下的平均多目標跟蹤精度(AMOTP)和平均多目標跟蹤準確率(AMOTA)。具體來說,AMOTA定義如下:

5.1.2 Architecture and Training Details

本文采用BEVDepth [29]、BEVPoolv2 [55]、SparseBEV [33]作為RCBEVDet和RCBEVDet++的攝像機流。對于BEVDepth,作者遵循BEVDet4D [30]來累積多幀的中間BEV特征,并添加一個額外的BEV編碼器來聚合這些多幀的BEV特征。對于雷達,作者累積多掃雷達點,并以RCS和多普勒速度作為輸入特征,與GRIFNet [56]和CRN [13]相同的方式。作者將雙流雷達骨架中 stages(階段)的數量設置為3。

對于三維目標檢測 Head ,作者使用CenterPoint [57]中的中心 Head 進行RCBEVDet,并使用SparseBEV [33]中的稀疏 Head 進行RCBEVDet++。在BEV語義分割 Head ,作者為每個任務采用單獨的分割 Head 。對于三維多目標跟蹤,作者遵循CenterPoint,以貪心方式跟蹤多幀中的目標中心。

作者的模型分為兩階段訓練。第一階段,作者根據標準實現 [29, 33]訓練基于攝像機的模型。第二階段,作者訓練雷達-攝像機融合模型。攝像機流的權重從第一階段繼承,并在第二階段中凍結攝像機流的參數。所有模型使用AdamW [58]優化器訓練12個周期。為了防止過擬合,作者從圖像旋轉、裁剪、縮放和翻轉以及雷達水平翻轉、水平旋轉和坐標縮放等方面應用了各種數據增強。

Comparison with State-of-the-Art

作者將作者的方法與當前最先進的基于攝像頭的和雷達-攝像頭多模態方法進行了比較,應用于三個任務:3D目標檢測,BEV語義分割,和3D多目標跟蹤。

5.2.1 3D Object Detection

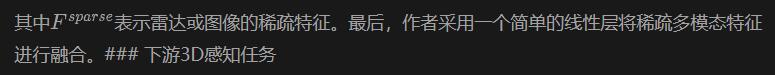

作者在表格I和II中分別提供了在val集和測試集上的3D目標檢測結果。

如表1所示,RCBEVDet在各種backbone上超越了之前的雷達-攝像頭多模態3D目標檢測方法。此外,基于SparseBEV,RCBEVDet++比CRN提高了4.4 NDS,展示了作者融合方法的有效性。另外,與之前的最佳方法相比,RCBEVDet和RCBEVDet++將速度誤差降低了14.6%,證明了作者在利用雷達信息方面的方法效率。

在測試集上,使用V2-99 Backbone 時,RCBEVDet++將SparseBEV Baseline 提高了5.1 NDS和7.0 mAP,并超越了其離線版本(使用未來幀)。值得一提的是,使用較小V2-99 Backbone 的RCBEVDet++與StreamPETR和Far3D使用較大 Backbone Vit-L的性能相當。此外,使用較大Vit-L Backbone 的RCBEVDet++在無測試時數據增強的情況下實現了72.7 NDS和67.3 mAP,為nuScenes上的雷達-攝像頭3D目標檢測設立了新的最先進結果。

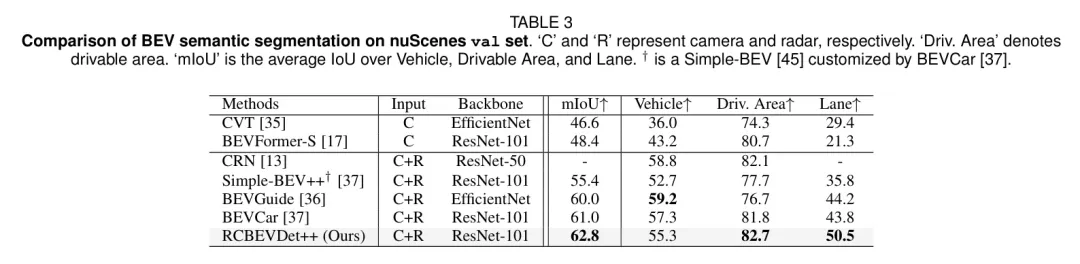

5.2.2 BEV Semantic Segmentation

在Table III的val集上,作者將作者的方法與最先進的BEV語義分割方法進行比較。采用ResNet-101 Backbone 網,RCBEVDet++在"Drivable Area"類別的性能上比CRN有0.6的IoU優勢,同時也比BEVGuide在"Lane"類別的性能上有了6.3的IoU優勢。在所有任務的綜合評估中,RCBEVDet++達到了驚人的62.8 mIoU,比之前的最佳結果提高了1.8 mIoU。這些結果表明了作者在處理BEV語義分割任務時的方法的有效性。

state-of-the-art的性能,mIoU達到62.8,比之前的最佳結果提高了1.8 mIoU。這些結果展示了作者的方法在處理BEV語義分割任務上的有效性。

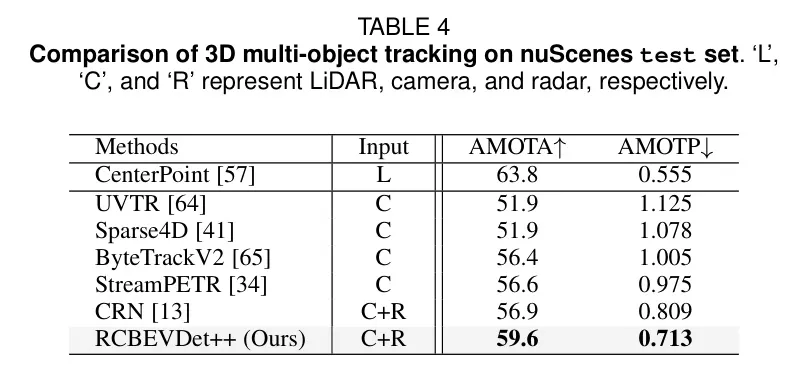

5.2.3 3D Multi-Object Tracking

在表4中,作者總結了在nuScenes測試集上的3D多目標跟蹤結果。由于作者方法在估計物體位置和速度方面的高精度,RGEVDet++同時實現了最佳的AMOTA和AMOTP,與最先進的方法相比。

Ablation Studies

作者對所提出的方法的各個設計選擇進行了評估。為了簡便起見,作者對3D檢測任務進行了評估。所有結果都在nuScenes驗證集上得到,使用了ResNet-50 Backbone 網絡,圖像輸入大小為256X704,BEV大小為128X128,除非另有說明。

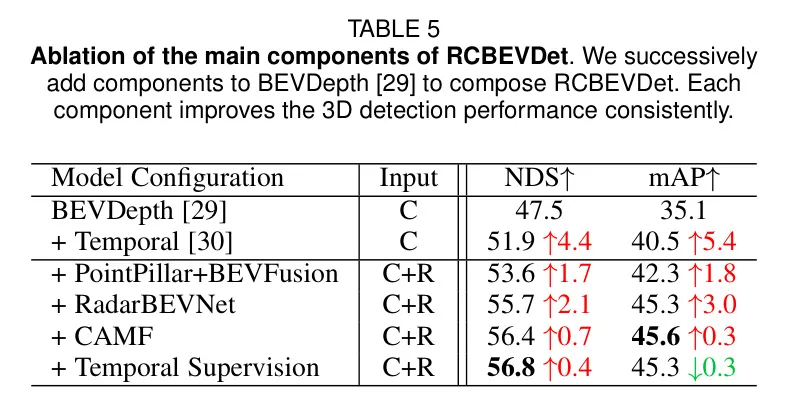

5.3.1 Main Components

在本研究中,作者對第三節中的主要組成部分進行實驗,以便評估它們的有效性,包括RadarBEVNet和CAMF。具體來說,如表5所示,作者逐步向baseline BEVDepth添加組件以創建RGEVDet。首先,基于僅使用相機的模型,作者利用CRN [13]中采用PointPillar作為雷達背骨的單雷達和相機的3D目標檢測 Baseline 。該 Baseline 雷達-相機檢測器 achieve 53.6 NDS和42.3 mAP,相較于僅使用相機的檢測器提高了1.7 NDS和1.8 mAP。接下來,將PointPillar替換為提出的RadarBEVNet,產生了2.1 NDS和3.0 mAP的改進,證明Radar-BEVNet的雷達特征表示能力很強。此外,整合CAMF將3D檢測性能從55.7 NDS提高到56.4 NDS。此外,作者遵循Hop [66]的方法,引入額外的多幀損失,稱為Temporal Supersonic,從而實現0.4 NDS的改進和0.3 mAP的降低。

總的來說,作者觀察到每個組成部分都持續地提升了3D目標檢測性能。同時,結果表明多模塊融合可以顯著提升檢測性能。

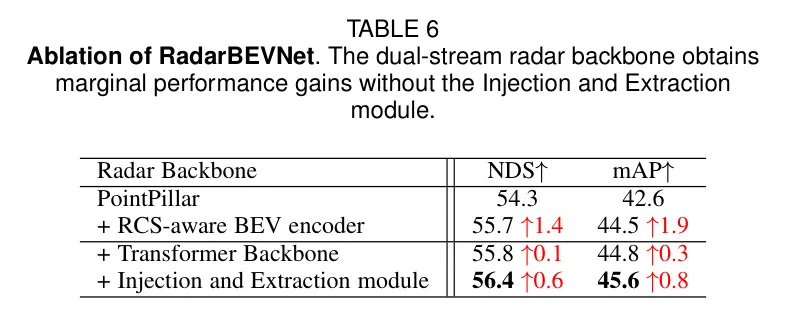

5.3.2 RadarBEVNet

表6中展示了與RadarBEVNet設計相關的實驗結果,包括雙流雷達 Backbone 網絡和了解目標散射截面(RCS)的BEV編碼器。具體而言,使用PointPillar作為雷達 Backbone 的基礎模型實現了54.3 NDS和42.6 mAP。將了解目標散射截面的BEV編碼器集成到模型中,使其在3D目標檢測方面的性能提高了1.4 NDS和1.9 mAP,證明了所提出的了解目標散射截面的BEV特征重建的有效性。此外,作者發現直接將基于Transformer的 Backbone 與BEV Backbone 相結合,其性能僅略有提高。這可以歸因于基于點和小Transformer Backbone 分別對雷達點進行單獨處理,它們各自獨特的雷達特征表示缺乏有效的交互。為了解決這個問題,作者引入了注入和提取模塊,從而提高了0.6 NDS和0.8 mAP的性能。

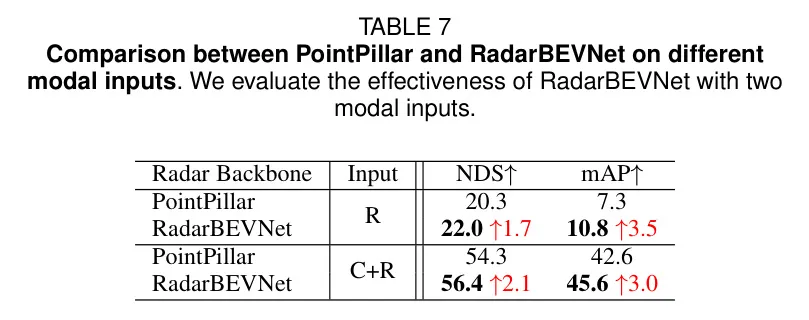

此外,作者在不同的輸入模式下,將所提出的RadarBEVNet與PointPillar進行了比較。如表7所示:

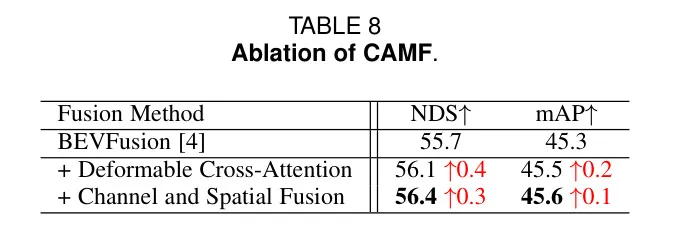

5.3.3 Cross-attention Multi-layer Fusion (CAMF)

在本研究中,作者對CAMF模塊進行了消融實驗,該模塊包括用于對多模態特征進行對齊的可變形交叉注意力機制以及用于BEV特征融合的通道和空間融合模塊,如表8所示。具體而言,使用來自BEVfusion[4]的融合模塊的基準模型在融合模塊上獲得了55.7 NDS和45.3 mAP。當引入可變形交叉注意力機制進行多模態BEV特征對齊時,3D檢測性能從55.7 NDS和45.3 mAP提高到56.1 NDS和45.5 mAP。這突顯了交叉注意力機制在跨模態特征對齊的有效性。此外,作者注意到,在BEVfusion[4]的單層融合之外引入了通道和空間融合模塊進行BEV特征融合,性能提高了0.3 NDS和0.1 mAP。這表明,通道和空間多層融合提供了更好的多模態BEV特征。

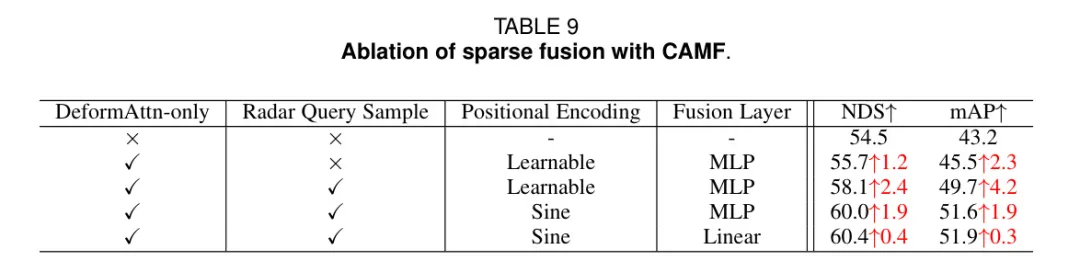

5.3.4 Sparse Fusion with CAMF

九表展示了作者使用CAMF的稀疏融合的消融結果。九表的第一行指的是稀疏BEV Baseline 。僅采用變形注意機制將雷達BEV特征與圖像稀疏特征對齊,得到的性能提升為1.2 NDS和2.3 mAP。在添加雷達 Query 樣本進行多模態特征對齊后,進一步提升了檢測性能2.4 NDS和4.2 mAP。此外,作者觀察到,用非參數編碼(即正弦位置編碼)替代可學習的位編碼,可以提升結果1.9 NDS和1.9 mAP。最后,與RCBEVDet中的CAMF相比,九表中的線性融合在MLP的層疊融合上超過了多層融合。這是因為BEV特征是二維密集特征,需要空間和通道的融合;而稀疏 Query 特征是一維特征,因此,線性融合層是足夠的。

Task Trade-off in BEV semantic segmentation

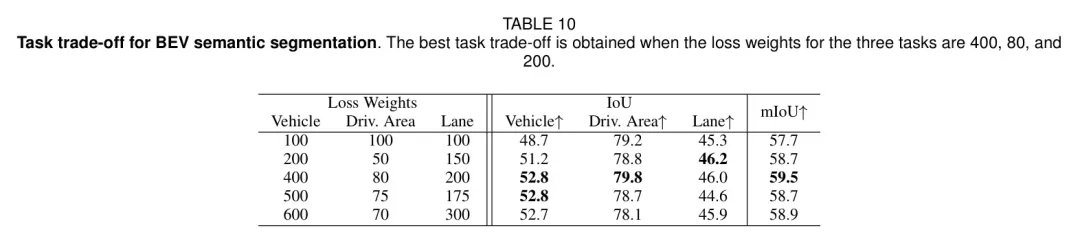

在nuScenes中,BEV語義分割需要完成三個任務,包括車輛、可行駛區域和車道 segmentation。為了在這三個任務之間實現最佳平衡,作者調整了三個任務的損失權重,并將其結果顯示在表10中。作者發現,為每個任務分配相等的損失權重得到57.7 mIoU。隨著車輛和車道的損失權重逐步增加,同時降低可行駛區域的損失權重,分割性能首先從57.7 mIoU增加到59.5 mIoU,達到峰值,然后下降到58.9 mIoU。在車輛、可行駛區域和車道分別采用400、80和200的損失權重時,最佳任務權衡實現。進一步增加車輛和車道的損失權重可能會損害三個任務的所有分割性能。

Analysis of Robustness

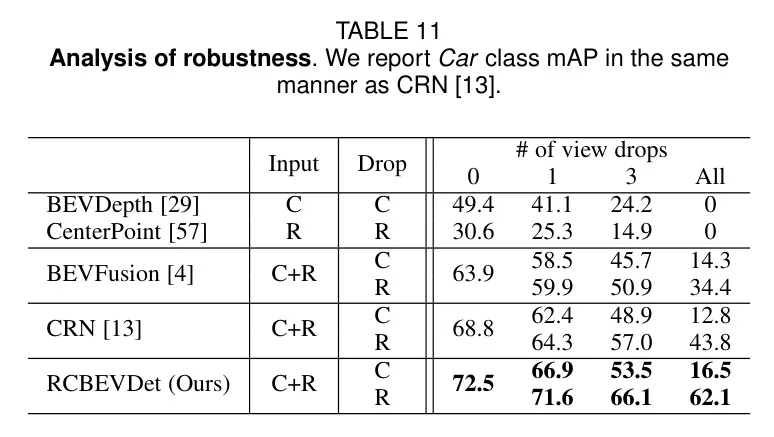

5.5.1 Sensor Failure

為了分析傳感器故障場景下的魯棒性,作者隨機刪除圖像或雷達輸入進行評估。在本實驗中,作者采用dropout訓練策略作為數據增強,用于訓練RCBEVDet,并報告CRN [13]中的_Car_類mAP。具體來說,RCBEVDet在所有傳感器故障情況下都優于CRN和BEVFusion,_Car_類的mAP更高。值得注意的是,CRN在三種雷達傳感器故障案例中的mAP分別下降了4.5、11.8和25.0,而RCBEVDet僅出現0.9、6.4和10.4 mAP的下降。

這些結果強調了所提出的交叉注意力模塊通過動態對齊增強了BEV特征的魯棒性。

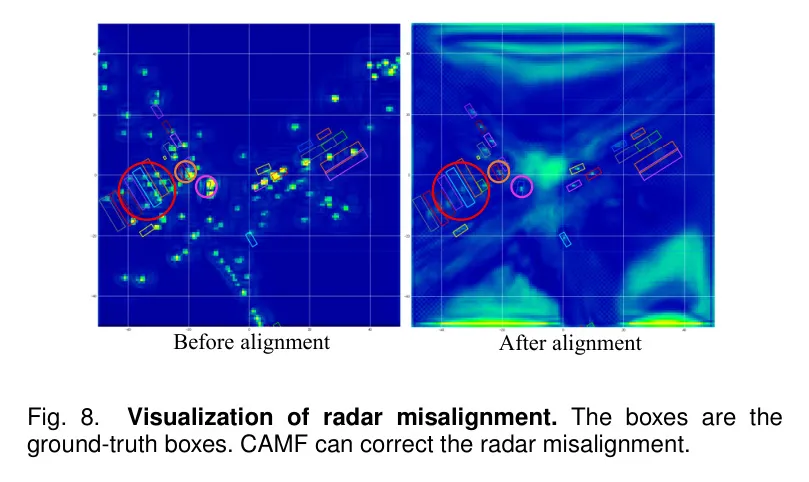

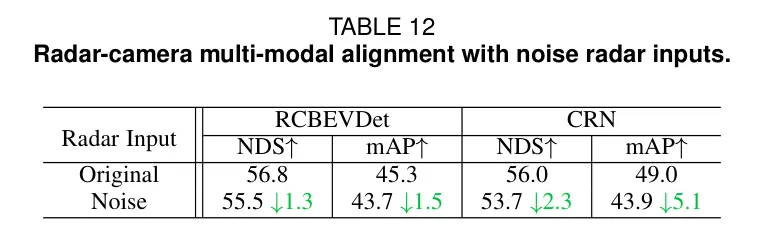

5.5.2 Modal Alignment

為了進一步展示CAMF與雷達校正的效果,作者以隨機擾動的方式對雷達輸入的x軸和y軸坐標進行操作。具體而言,作者將x軸和y軸坐標每個雷達點的噪聲均勻地從-1到1中采樣。如表12所示,RCBEVDet在噪聲雷達輸入下僅降低1.3 NDS和1.5 mAP,而CRN降低2.3 NDS和5.1 mAP。此外,作者通過圖8可視化了CAMF如何解決雷達偏移的問題。如圖8所示,許多雷達特征與 GT 框之間的位置存在偏差。利用CAMF,這些雷達特征得以在真實框內重新對齊,從而有效地校正了雷達的偏移問題。

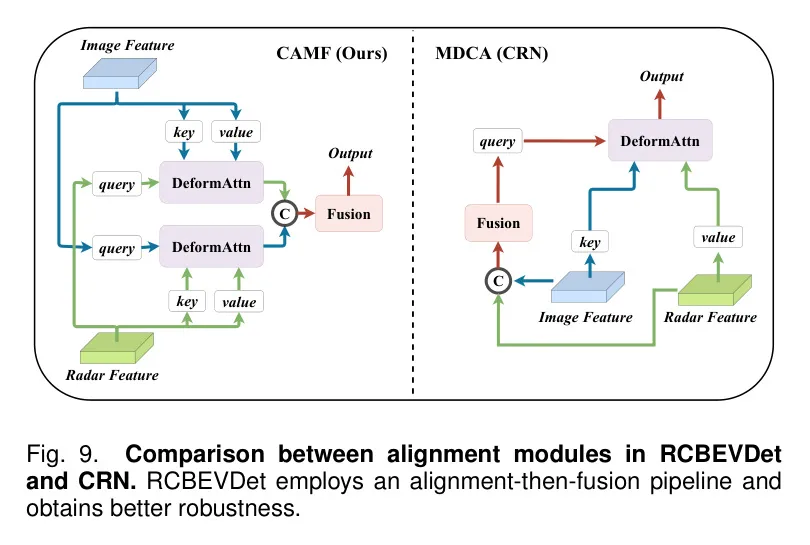

5.5.3 Comparison with CRN

CRN [13] 也利用可變形交叉注意力來解決雷達-相機的匹配問題。表11 和表12 的結果表明,作者的 CAMF 比 CRN 中提出的多模態可變形交叉注意力模塊(MDCA)更魯棒。為了進一步區分作者的方法,作者提出:

Model Generalization

RCBEVDet采用雙分支架構將雷達和多視角相機融合,并將多視角相機基礎方法集成到該模型中,從而提高特征表示。為了證明RCBEVDet模型的泛化能力,作者在3D目標檢測框架中分別使用了不同的 Backbone 網絡和檢測器設計進行實驗。

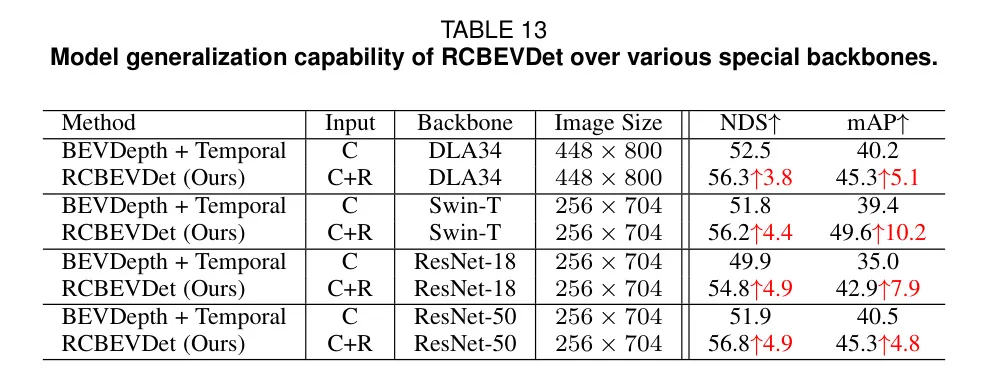

5.6.1 Generalization for Backbone Architectures

為了證明RCBEVDet在backbone架構上的模型泛化能力,作者在BEVDepth上進行了實驗,包括使用基于CNN和Transformer的多種backbone架構。如表13所示,作者的方法在不同backbone上的 Baseline 性能可提高3.8~4.9 NDS和4.8~10.2 mAP。此外,對于大小不同的相同類型的backbone結構(例如,ResNet-18和ResNet-50),RCBEVDet可以實現一致的性能提升4.9 NDS。

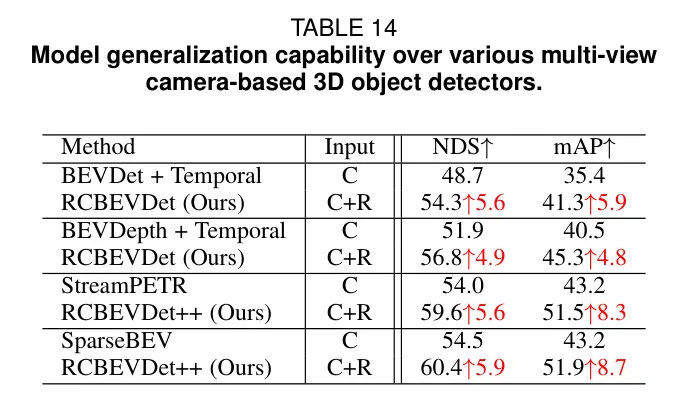

5.6.2 Generalization for 3D Detector Architecture

作者通過將作者的方法集成到各種主流的多視圖攝像頭基的3D目標檢測器中,包括基于LSS的方法(例如,BEVDet和BEVDepth)和基于 Transformer 的方法(例如,StreamPETR和SparseBEV),來評估檢測器的架構通用性。這些方法代表了各種檢測器設計。如表14所示,通過將雷達特征進行融合,作者的方法提高了所有流行的多視圖攝像頭基3D目標檢測器的性能。具體而言,對于基于LSS的方法,RCBEVDet對BEVDet的5.6 NDS和4.9 NDS進行了改進。

表9: 帶噪聲雷達輸入的雷達-攝像頭多模態對齊。BEVDepth,分別。對于基于 Transformer 的方法,RCBEVDet++在NDS方面獲得相似的性能改進,即分別提高了StreamPETR和SparseBEV的5.6 NDS和5.9 NDS。值得注意的是,與基于LSS的方法相比,基于 Transformer 的方法得到的mAP改進更多。原因是基于LSS的方法通常使用LiDAR點提供的深度監督進行更準確的3D位置預測,而基于 Transformer 的方法可以隱式地學習3D位置。因此,基于 Transformer 的方法可以從雷達特征中獲得更多的深度信息。總體而言,這些結果表明作者的方法在各種3D目標檢測器上的檢測器架構通用性。

6 Conclusion

在本文中,作者首先介紹了RCBEVDet,這是一個雷達-攝像頭融合3D檢測器。

它包括一個現有的基于攝像頭的3D檢測模型,一個專門設計的雷達特征提取器,以及CAMF模塊,用于對齊和融合雷達-攝像多模態特征。RCBEVDet在多個backbone上改善了各種基于攝像頭的3D目標檢測器性能,并在nuScenes數據集上展示了對抗傳感器故障情況的強大魯棒性能力。

為了發揮RCBEVDet的潛力,作者提出了RCBEVDet++,它將CAMF模塊擴展到支持基于 Query 的多視相機感知模型,實現稀疏融合,并適應更多的感知任務,包括3D目標檢測、BEV語義分割和3D多目標跟蹤。

在nuScenes數據集上的大量實驗表明,RCBEVDet++進一步提高了基于相機的感知模型性能,并在這三個感知任務上實現了新的最先進的雷達-攝像頭多模態結果。

值得注意的是,無需使用測試時增強或模型集成,RCBEVDet++取得了ViT-L圖像backbone的3D目標檢測72.73 NDS和67.34 mAP。