控制電腦手機的智能體人人都能造,微軟開源OmniParser

最近這幾天,讓大模型具備控制計算機(包括電腦和手機)的相關研究和應用如雨后春筍般不斷涌現。

先是 Anthropic 發布了能控制計算機的新版 Claude 3.5 Sonnet,之后榮耀 MagicOS 9.0 來了個全局智能體,再然后,昨天智譜發布了具備「全棧式工具使用能力」的 AutoGLM,同時華為也公布了一項可讓 AI 像人類一樣操作手機的新研究成果 LiMAC。

很顯然,這股熱潮完全沒有要停息的意思。今天,有網友發現蘋果已經默默發布了 Ferret-UI 的兩個實現版本(分別基于 Gemma 2B 和 Llama 8B),這是蘋果今年五月發布的一個可讓 AI 理解手機屏幕的技術,詳情參閱《讓大模型理解手機屏幕,蘋果多模態 Ferret-UI 用自然語言操控手機》。

來自 X 用戶 Niels Rogge

- Ferret-UI 項目地址:https://huggingface.co/papers/2404.05719

不僅如此,微軟也低調開源了他們的相關研究 OmniParser,這是一個基于大模型的屏幕解析工具,可將 UI 截圖轉換成結構化的元素;據稱其解析和理解 UI 的能力達到了當前最佳水平,甚至超越了 GPT-4V。

- 項目地址:https://huggingface.co/microsoft/OmniParser

- 代碼地址:https://github.com/microsoft/OmniParser

- 論文標題:OmniParser for Pure Vision Based GUI Agent

- 論文地址:https://arxiv.org/abs/2408.00203

有了這個工具,或許每個人都可以創建自己的計算機操控智能體了。

先來看看 OmniParser 的效果。對于一個用戶任務:「將約翰內斯堡提供素食選擇的餐廳保存到我的行程中」。

OmniParser 首先會解析 Tripadvisor 網頁屏幕上的所有元素,然后它成功從中找到了「餐廳」選項。之后它點擊(動作執行需要搭配其它模型)該選項,打開了一個搜索框。OmniParser 繼續解析,這一次沒有在屏幕上找到所需關鍵詞,于是它在搜索框中輸入了「約翰內斯堡」。再次解析后,它打開了相應的搜索項,展開了搜索結果。同樣,繼續解析,它成功定位到了素食選項,然后進行了勾選。最后,點擊篩選出的第一個選項上的相應按鈕將其收藏到行程中。至此,任務完成。

而如果你想看看能否進入布萊斯峽谷國家公園呢?OmniParser 也能助你輕松完成。

整體來看,OmniParser 的解析能力非常出色,過程也還算流暢。

我們知道,不同的操作系統和應用有著大不相同的交互界面。為了穩健地應對各種不同情況,屏幕解析模型需要:

- 可靠地識別交互界面內可交互的圖標;

- 理解屏幕截圖中各種不同元素的含義,并將計劃動作與屏幕上相應的區域準確地關聯起來。

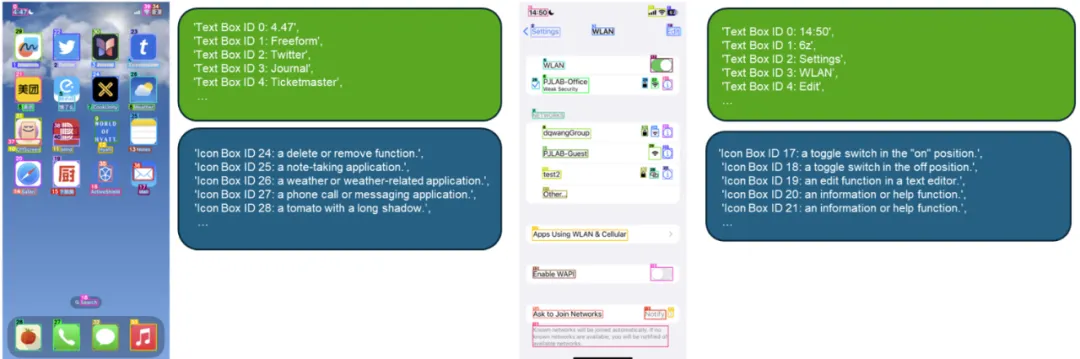

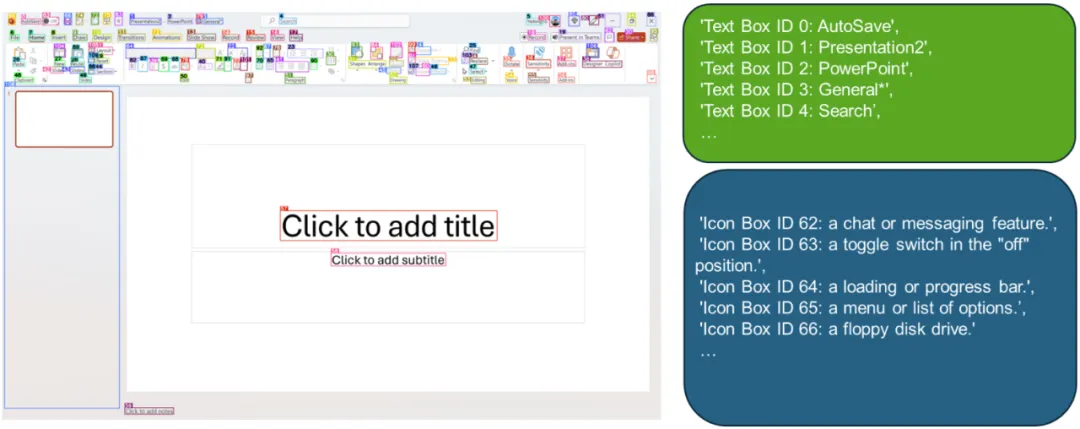

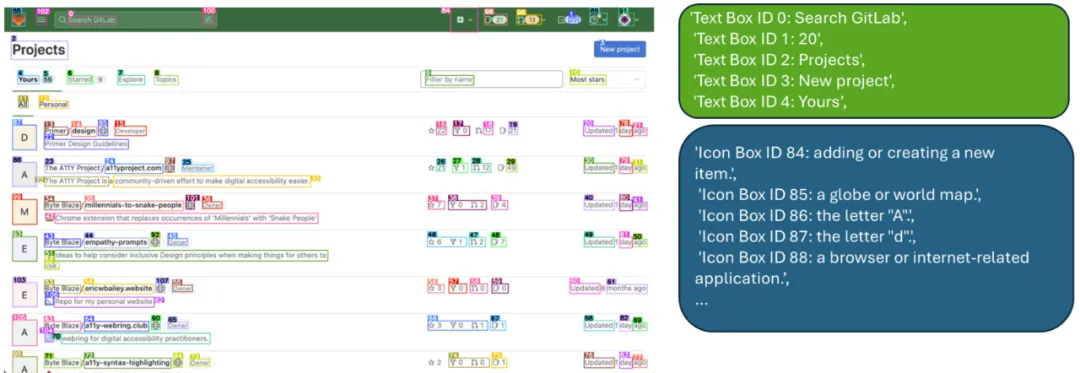

OmniParser 正是為這一目的而生的。OmniParser 可基于用戶任務和 UI 截圖輸出:(1) 解析后的截圖,帶有邊界框和數值 ID,(2) 包含提取出的文本和圖標描述的局部語義。下面展示了幾個例子:

如果再搭配上其它可以基于 UI 采取行動的模型(比如 GPT-4V、Phi-3.5 和 Llama 3.2),便可以創造出可以理解并控制計算機的智能體。

該團隊用 GPT-4V 做了實驗,結果發現 OmniParser 能大幅提升其為界面區域生成精準動作的能力。他們使用 OmniParser 和 GPT-4V 創建的一個智能體在 WindowsAgentArena 基準上達到了最佳水平。

OmniParser 是如何煉成的?

收集和整理專用數據集 ——OmniParser 的開發始于創建兩個數據集:

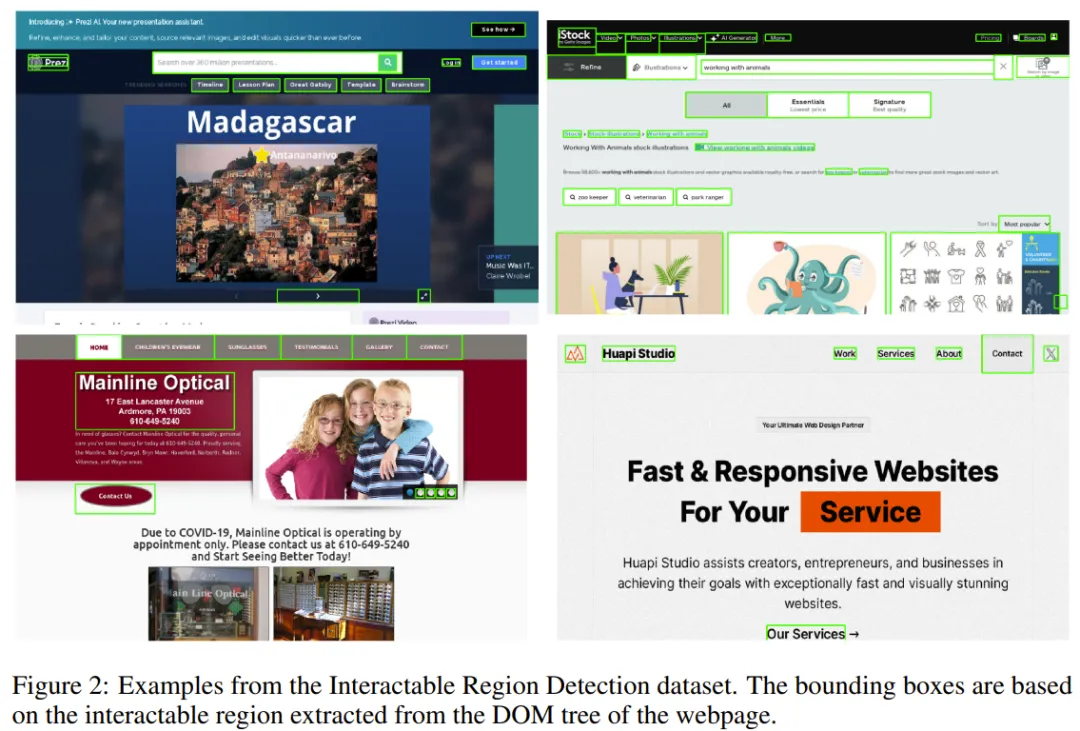

- 一個可交互區域檢測數據集,該數據集收集整理自常見的網頁,其中可點擊和可操作的區域都做了標注。

- 一個圖標描述數據集,旨在將每個 UI 元素與其相應的功能關聯起來。在訓練模型以理解檢測到的元素的語義方面,此數據集非常關鍵。

下面展示了可交互區域檢測數據集的一些樣本示例。

對檢測和描述模型進行微調 ——OmniParser 使用了兩個互補的模型:

- 一個檢測模型,在可交互圖標數據集上進行了微調,其能可靠地識別屏幕截圖中的可操作區域。

- 一個描述模型,在圖標描述數據集上完成了訓練,其作用是提取檢測到的元素的功能語義,為預期操作生成準確符合上下文的描述。

性能表現

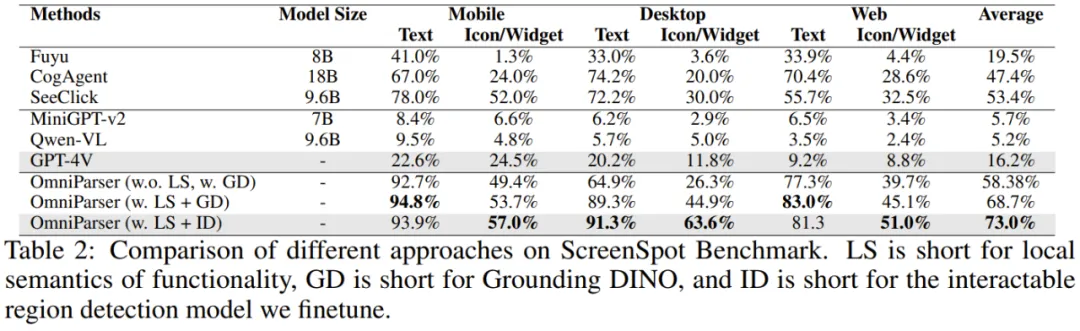

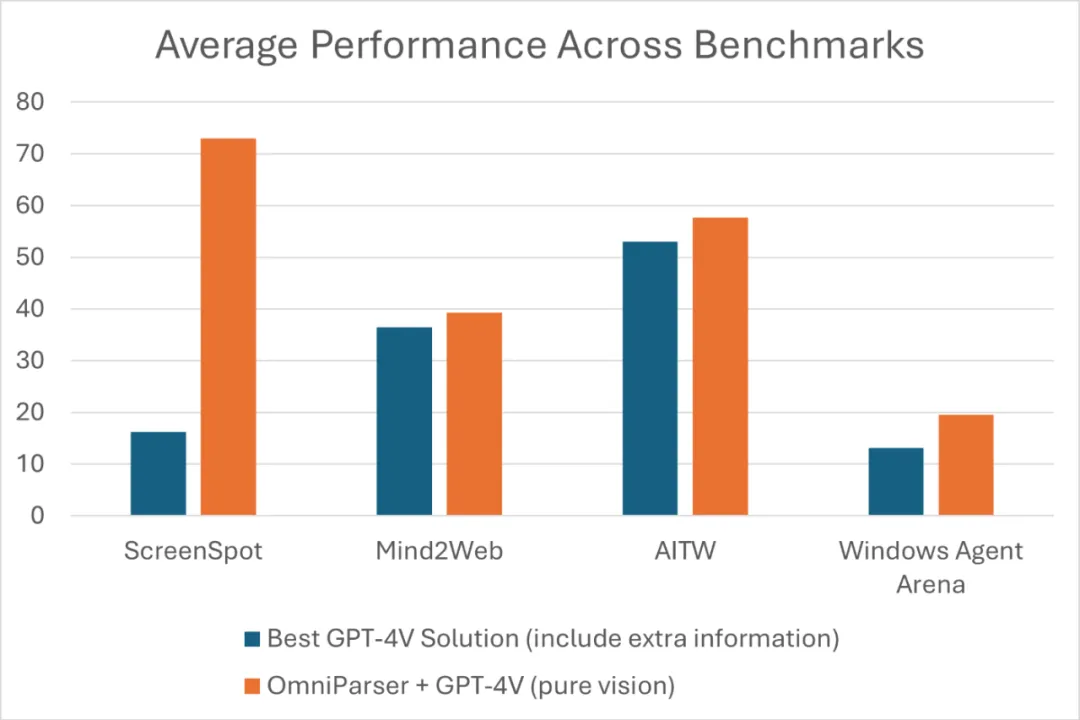

該團隊對自己的方法進行了實驗驗證。結果發現,OmniParser 可大幅提升 GPT-4V 在 ScreenSpot 基準上的性能。

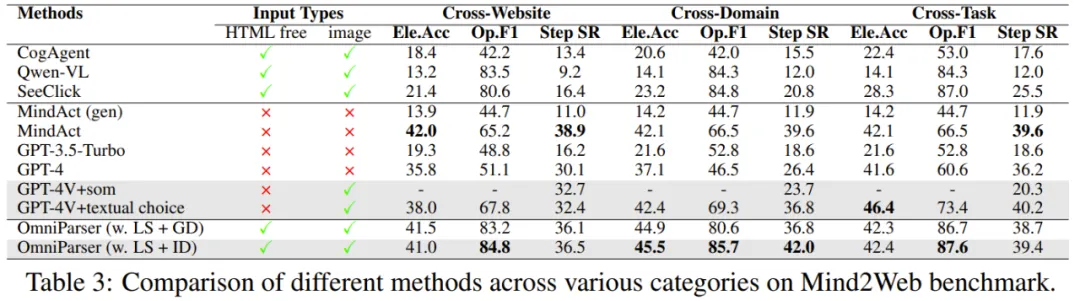

在 Mind2Web 基準上,OmniParser + GPT-4V 的表現也勝過可從 HTML 提取額外信息的 GPT-4V。

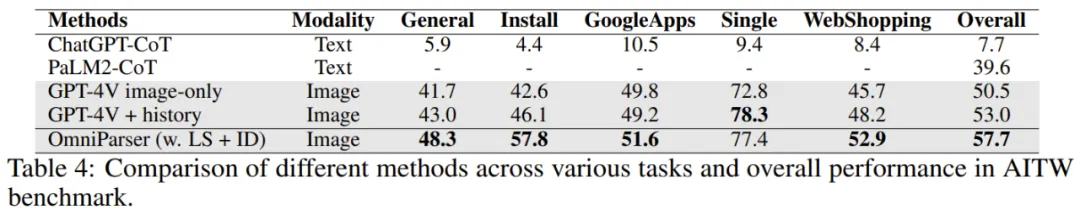

在 AITW 基準上,OmniParser 的表現優于一個經過增強的 GPT-4V—— 附帶了一個使用視圖圖層訓練的專用 Android 圖標檢測模型。

另外,其在新基準 WindowsAgentArena 上也達到了最佳性能。

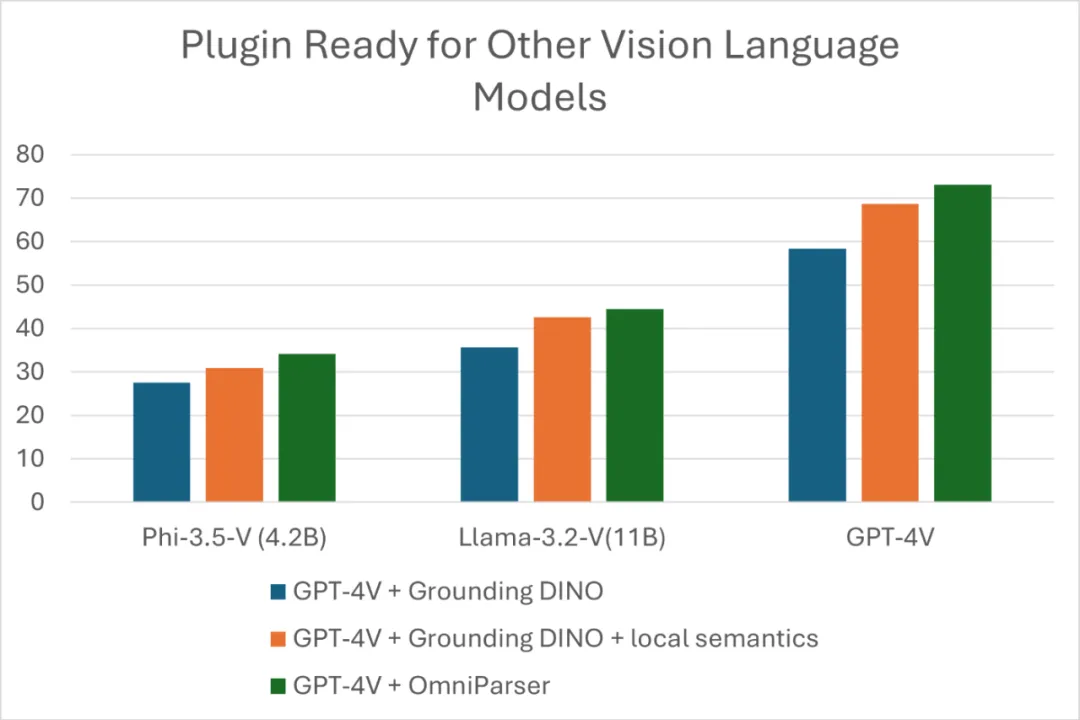

OmniParser 可作為當前各種視覺 - 語言模型(VLM)的插件。為了進一步演示這一點,該團隊也測試了其與 Phi-3.5-V 和 Llama-3.2-V 的組合。

該團隊表示:「我們希望 OmniParser 可以作為一種通用且易于使用的工具,在 PC 和移動平臺上解析用戶的屏幕,而無需依賴 HTML 和 Android 中的視圖圖層等額外信息。」

不知道如果將 OmniParser 與新版 Claude 3.5 Sonnet 的 Computer Use 結合起來會是什么效果?可能會像這位網友說的,很贊吧。