Kafka消費位點管理沒你想的那么簡單

背景

如果你習慣了使用RocketMQ這種自動擋管理消費位點,消息失敗重試的方式。你再來使用kafka,會發現kafka這種手動擋的消費位點管理就沒那么容易了

熟悉RocketMQ的小伙伴都知道RocketMQ已經默認幫我實現好了消息消費失敗重試,消費位點自動提交,死信隊列等功能,那么kafka是否也是如此呢?

kafka消費位點管理

kafka消費位點有兩種管理方式

- 手動提交消費位點

- 自動提交消費位點

自動提交消費位點

想要設置自動提交消費位點我們只需要設置兩個屬性

- ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG 自動提交消費位點

- ConsumerConfig.AUTO_COMMIT_INTERVAL_MS_CONFIG 自動提交消費位點的時間間隔

一個簡單的消費代碼如下

Properties props = new Properties();

props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, BOOTSTRAP_SERVERS);

props.put(ConsumerConfig.GROUP_ID_CONFIG, GROUP_ID);

props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, IntegerDeserializer.class);

props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

props.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, true);

// 自動提交消費位點的時間間隔

props.put(ConsumerConfig.AUTO_COMMIT_INTERVAL_MS_CONFIG, 5000);

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList(TOPIC_NAME));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

try {

handlerMessage(record);

} catch (Exception e) {

log.error("處理消息異常: {}", record, e);

// 循環繼續

}

}

}自動提交消費位點有幾個缺點

- 會出現重復消費:比如Consumer每5秒自動提交一次位移,如果在第4秒時,消費了消息,但是還沒有提交位移,此時Consumer掛掉了,那么下次Consumer啟動時,會從上次提交的位移開始消費,這樣就會導致消息重復消費。 當然比如出現Rebalance也是會出現重復消費的情況

- 無法精準控制消費位點

手動提交消費位點

手動提交消費位點又分兩種

- 同步提交(commitSync)

- 異步提交(commitAsync)

同步提交(commitSync)

同步提交的方式很簡單,就是每次消費完通過調用API consumer.commitSync。

相關的代碼如下:

Properties props = new Properties();

props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, BOOTSTRAP_SERVERS);

props.put(ConsumerConfig.GROUP_ID_CONFIG, GROUP_ID);

props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

props.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, false);

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList(TOPIC_NAME));

while (true) {

ConsumerRecords<String, String> records =

consumer.poll(Duration.ofSeconds(1));

// 注意這里消費業務邏輯上消費失敗后的消息處理

handlerMessage(records);

try {

// 消費成功后手動提交位點

consumer.commitSync();

} catch (CommitFailedException e) {

// 消費位點提交失敗異常處理

handleError(e);

}

}同步提交的方式有一個缺點,調用commitSync()時,Consumer會處于阻塞狀態,直到broker返回提交成功,嚴重影響消費性能。

異步提交(commitAsync)

異步提交的方式很簡單,就是每次消費完通過調用API consumer.commitAsync。

Properties props = new Properties();

props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, BOOTSTRAP_SERVERS);

props.put(ConsumerConfig.GROUP_ID_CONFIG, GROUP_ID);

props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

props.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, false);

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList(TOPIC_NAME));

while (true) {

ConsumerRecords<String, String> records =

consumer.poll(Duration.ofSeconds(1));

handlerMessage(records); // 處理消息

consumer.commitAsync((offsets, exception) -> {

if (exception != null)

handleError(exception);

});

}commitAsync主要是提供了異步回調,通過回調來通知消費位點是否提交成功。

異步提交消費位點也有一些缺點,比如消費位點不能重復提交。因為提交位點失敗后,重新提交位點可能更晚的消費位點已經提交了,這里提交已經是沒有意義的了。

spring-kafka消息消費

可以看到不管是同步提交消費位點還是異步提交消費位點,都有一些問題,想要寫出生產可用的消費代碼,需要注意的細節非常多。

比如消費失敗后的消息如何處理,是停止消費跳出循環,還是說記錄消費失敗的消息,人工處理等。

這里我們可以簡單看看spring-kafka是如何消費消息的。

我們簡單看看主流程代碼:

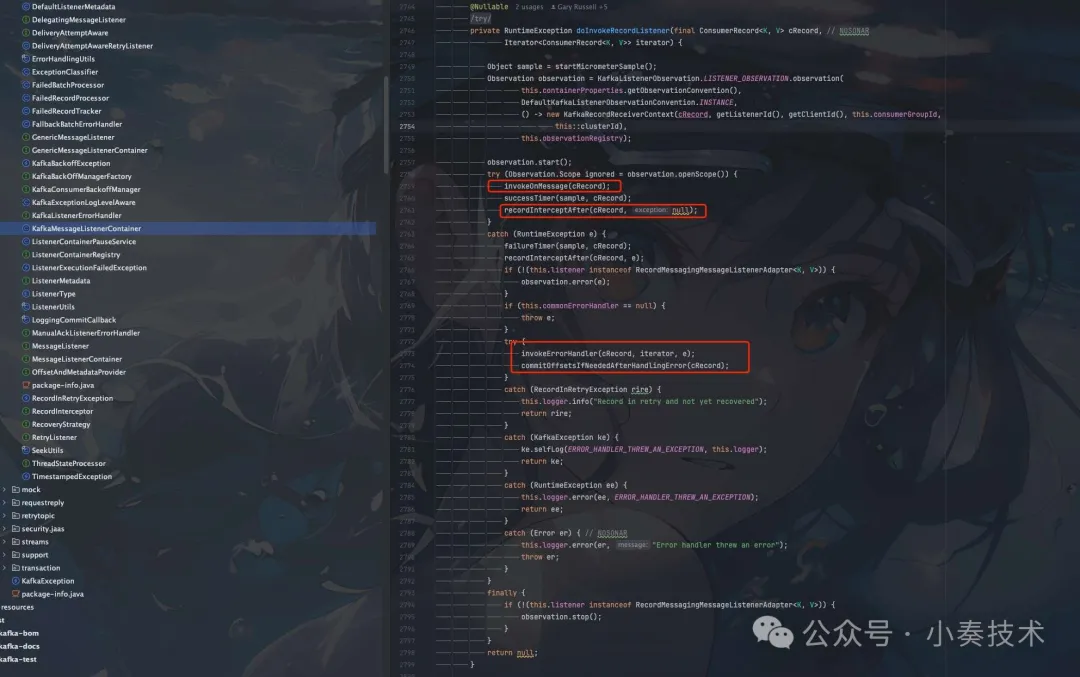

圖片

圖片

這里我們忽略源碼的一些其他細節。只分析主要的消費流程。

- invokeOnMessage(cRecord); 處理消息

可以看到invokeOnMessage是被整個try-catch包裹的,這樣就保證了消費失敗后不會影響整個消費流程。

具體我們先看看消息正常處理的邏輯。

private void invokeOnMessage(final ConsumerRecord<K, V> cRecord) {

if (cRecord.value() instanceof DeserializationException ex) {

throw ex;

}

if (cRecord.key() instanceof DeserializationException ex) {

throw ex;

}

if (cRecord.value() == null && this.checkNullValueForExceptions) {

checkDeser(cRecord, SerializationUtils.VALUE_DESERIALIZER_EXCEPTION_HEADER);

}

if (cRecord.key() == null && this.checkNullKeyForExceptions) {

checkDeser(cRecord, SerializationUtils.KEY_DESERIALIZER_EXCEPTION_HEADER);

}

doInvokeOnMessage(cRecord);

if (this.nackSleepDurationMillis < 0 && !this.isManualImmediateAck) {

ackCurrent(cRecord);

}

if (this.isCountAck || this.isTimeOnlyAck) {

doProcessCommits();

}

}這里主要是一些異常校驗,然后就是判斷是否可以提交消費位點。如果可以則調用doProcessCommits()進行正常的消費位點提交。

- doProcessCommits() 消費位點處理

如果消費位點提交失敗也會進行一些異常處理。

private void doProcessCommits() {

if (!this.autoCommit && !this.isRecordAck) {

try {

processCommits();

}

catch (CommitFailedException cfe) {

if (this.remainingRecords != null && !this.isBatchListener) {

ConsumerRecords<K, V> pending = this.remainingRecords;

this.remainingRecords = null;

List<ConsumerRecord<?, ?>> records = new ArrayList<>();

for (ConsumerRecord<K, V> kvConsumerRecord : pending) {

records.add(kvConsumerRecord);

}

this.commonErrorHandler.handleRemaining(cfe, records, this.consumer,

KafkaMessageListenerContainer.this.thisOrParentContainer);

}

}

}

}如果消費位點提交失敗則會調用commonErrorHandler進行異常處理。

commonErrorHandler有多個實現類,有一個默認實現DefaultErrorHandler

- 消息消費失敗異常處理

如果消息消費失敗,也提供了一個異常處理擴展invokeErrorHandler(cRecord, iterator, e);

里面實際使用的也是DefaultErrorHandler

核心的處理邏輯主要還是在SeekUtils中封裝

- DefaultErrorHandler

public void handleRemaining(Exception thrownException, List<ConsumerRecord<?, ?>> records,

Consumer<?, ?> consumer, MessageListenerContainer container) {

SeekUtils.seekOrRecover(thrownException, records, consumer, container, isCommitRecovered(), // NOSONAR

getFailureTracker(), this.logger, getLogLevel());

}- SeekUtils

public static void seekOrRecover(Exception thrownException, @Nullable List<ConsumerRecord<?, ?>> records,

Consumer<?, ?> consumer, MessageListenerContainer container, boolean commitRecovered,

RecoveryStrategy recovery, LogAccessor logger, Level level) {}可以看到有一個RecoveryStrategy參數,這個是消息消費失敗如何恢復,比如我們需要手動增加一個類似死信隊列的topic,這里消息消費失敗就會自動發送到我們的死信隊列

死信隊列的topic名字生成規則主要是topicName + -dlt

private static final BiFunction<ConsumerRecord<?, ?>, Exception, TopicPartition>

DEFAULT_DESTINATION_RESOLVER = (cr, e) -> new TopicPartition(cr.topic() + "-dlt", cr.partition());總結

可以看到如果我們單純的使用kafka-client原生的sdk來進行消息消費,是非常容易出現問題的。

我們需要很多細節,比如

- 消息消費失敗了如何處理,是否需要重試,如果重試還是失敗怎么辦?丟掉還是手動處理丟到自己創建的死信隊列中。

- 消費位點提交失敗了如何處理。

- 消費位點是使用同步提交還是異步提交?或者混合提交?

所以如果spring boot項目還是建議使用spring相關已經封裝好的kafka sdk。

非必要盡量不要使用原生的kafka-client sdk。