AI開源項目 | FastGPT- 深入解析 FastGPT 的知識庫邏輯與檢索機制:讓 AI 更聰明的秘密

如何讓 AI 更加智能化、精準化,成為了研究者和開發者們關注的焦點。FastGPT 作為一款前沿的 AI 模型,其知識庫邏輯與檢索機制無疑是其成功的關鍵所在。本文將為您詳細解析 FastGPT 的知識庫邏輯與檢索機制,并結合知識庫的特性,提供實用的教學意義,幫助您更好地理解這一技術背后的原理與應用。 @

- 文章價值

- FastGPT 的知識庫邏輯

1. 基礎概念

2. 知識庫構建

3. 知識庫問答

- FastGPT 的知識庫檢索機制

1. 向量方案構建

2. 向量檢索

3. 語義判斷、邏輯推理和歸納總結

4. 數據質量和檢索詞質量

5. 技術實現

實踐教程:如何構建自己的知識庫

步驟 1:數據收集

步驟 2:數據預處理

步驟 3:模型訓練

步驟 4:知識庫問答實現

步驟 5:測試與優化

結尾

文章價值

通過本文,您將了解到:

- FastGPT 的知識庫邏輯是如何構建的

- 向量搜索與大模型的結合如何提升問答精度

- FastGPT 的知識庫檢索機制的工作原理

- 如何優化知識庫以提高檢索效果

- 實踐步驟,幫助您構建自己的知識庫

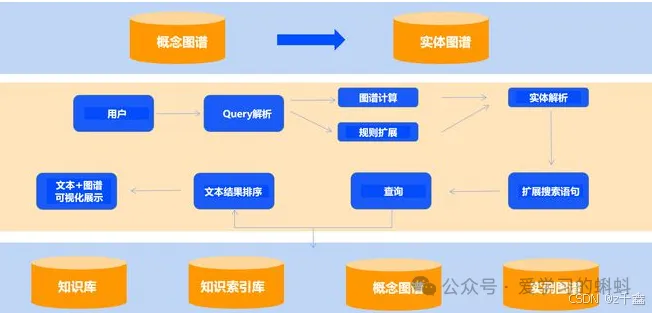

FastGPT 的知識庫邏輯

1. 基礎概念

在探討 FastGPT 的知識庫邏輯之前,我們需要了解一些基礎概念:

- 向量:將人類的語言(如文字、圖片、視頻等)轉換為計算機可識別的語言(數組)。

- 向量相似度:計算兩個向量之間的相似度,表示兩種語言的相似程度。

- 語言大模型的特性:上下文理解、總結和推理。

2. 知識庫構建

FastGPT 的知識庫構建主要包括以下幾個步驟:

- 數據收集:從互聯網上收集大量的文本數據,包括維基百科、新聞文章、論壇帖子等。選擇多樣化的數據源可以提高知識庫的全面性。

- 數據預處理:對收集到的數據進行預處理,如分詞、去除停用詞、標記化等,以便將文本轉換為模型可以理解的形式。此步驟對于提高模型的理解能力至關重要。

- 模型訓練:使用預處理后的數據,將其輸入到 GPT 模型中進行訓練。GPT 模型是一個基于 Transformer 架構的神經網絡模型,通過多層的自注意力機制來學習文本之間的關系和語義信息。確保訓練數據的質量和多樣性將直接影響模型的性能。

3. 知識庫問答

FastGPT 的知識庫問答機制主要包括以下幾個方面:

- QA問答對存儲:FastGPT 采用 QA 問答對進行存儲,而不僅是文本分塊處理。這樣做是為了減少向量化內容的長度,使向量能更好地表達文本的含義,從而提高搜索的精度。

- 搜索與對話測試:FastGPT 提供搜索測試和對話測試兩種途徑對數據進行調整,方便用戶調整自己的數據。通過不斷測試和優化,可以提升用戶體驗。

- 語義判斷與推理:在向量方案構建的知識庫中,通常使用 top-k 召回的方式,即查找前 k 個最相似的內容,然后交給大模型去做更進一步的語義判斷、邏輯推理和歸納總結,從而實現知識庫問答。

FastGPT 的知識庫檢索機制

FastGPT 的知識庫檢索機制是其高效問答能力的核心,主要依賴于向量方案構建的知識庫和相應的檢索技術。

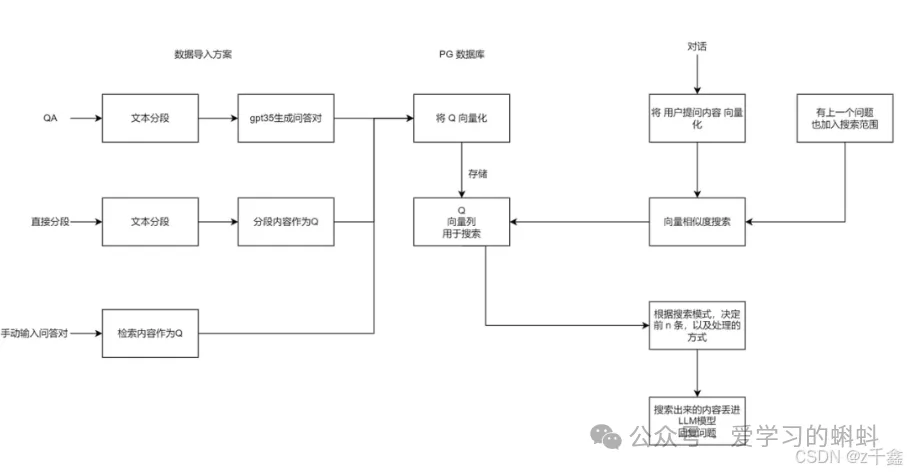

1. 向量方案構建

在 FastGPT 中,知識庫通常使用 top-k 召回的方式,即查找前 k 個最相似的內容。這涉及到向量的使用,其中每個文本或數據點都被表示為一個向量。這些向量通過特定的算法(如詞嵌入或 Transformer 模型)從原始文本中生成,它們捕獲了文本中的語義和上下文信息。

2. 向量檢索

FastGPT 使用向量檢索器來查找與查詢最相似的向量。這通常涉及到一種稱為“最近鄰搜索”的技術,它可以在向量空間中快速找到與查詢向量最接近的向量。在 FastGPT 中,向量檢索器可能基于高效的索引結構(如 HNSW)和算法來實現快速和準確的檢索。

3. 語義判斷、邏輯推理和歸納總結

一旦找到與查詢最相似的向量,FastGPT 會使用大模型進行更進一步的語義判斷、邏輯推理和歸納總結。這些模型已經過訓練,能夠理解文本的深層含義和上下文,從而生成更準確和有用的回答。

4. 數據質量和檢索詞質量

知識庫檢索的精度受到多種因素的影響,包括向量模型的質量、數據的質量(如長度、完整性和多樣性)以及檢索詞的質量。因此,FastGPT 在構建知識庫和進行檢索時,會注重優化這些因素以提高檢索精度。

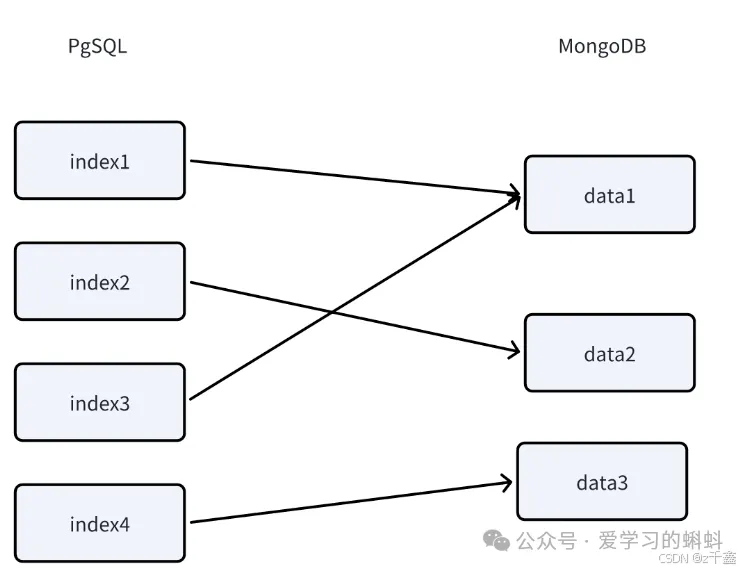

5. 技術實現

FastGPT 可能采用 PostgresSQL 的 PG Vector 插件作為向量檢索器,并使用 HNSW 索引來提高檢索速度。同時,它可能使用 MongoDB 來存儲其他類型的數據,并在需要時與向量檢索器進行交互。

實踐教程:如何構建自己的知識庫

如果希望構建自己的知識庫,以下是一些步驟和代碼示例。

步驟 1:數據收集

首先,您需要確定數據源并收集數據。以下是一個使用 Python 的 requests 庫從維基百科獲取數據的示例:

import requests

from bs4 import BeautifulSoup

def fetch_wikipedia_article(title):

url = f"https://en.wikipedia.org/wiki/{title}"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

return soup.get_text()

# 示例:獲取“Artificial Intelligence”文章

article_text = fetch_wikipedia_article("Artificial_intelligence")

print(article_text[:500]) # 打印前500個字符步驟 2:數據預處理

接下來,您需要對收集到的數據進行預處理。以下是一個使用 NLTK 庫進行文本預處理的示例:

import nltk

from nltk.tokenize import word_tokenize

from nltk.corpus import stopwords

nltk.download('punkt')

nltk.download('stopwords')

def preprocess_text(text):

# 分詞

tokens = word_tokenize(text)

# 去除停用詞

filtered_tokens = [word for word in tokens if word.lower() not in stopwords.words('english')]

return filtered_tokens

# 示例:預處理文章文本

processed_text = preprocess_text(article_text)

print(processed_text[:50]) # 打印前50個處理后的詞步驟 3:模型訓練

使用 Hugging Face 的 Transformers 庫加 GPT 模型并進行訓練。以下是一個簡單的示例:

from transformers import GPT2Tokenizer, GPT2LMHeadModel

import torch

# 加載模型和分詞器

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

model = GPT2LMHeadModel.from_pretrained("gpt2")

# 將文本編碼為輸入格式

inputs = tokenizer.encode(" ".join(processed_text), return_tensors="pt")

# 進行推理

with torch.no_grad():

outputs = model.generate(inputs, max_length=50)

# 解碼生成的文本

generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(generated_text)步驟 4:知識庫問答實現

實現 QA 問答對存儲機制,并使用向量檢索功能。以下是一個簡單的示例:

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.metrics.pairwise import cosine_similarity

# 假設我們有一些問題和答案

questions = ["What is AI?", "How does machine learning work?", "What is deep learning?"]

answers = ["AI is the simulation of human intelligence.",

"Machine learning is a subset of AI that focuses on algorithms.",

"Deep learning is a type of machine learning using neural networks."]

# 使用 TF-IDF 向量化

vectorizer = TfidfVectorizer()

tfidf_matrix = vectorizer.fit_transform(questions)

# 查詢示例

query = "Explain artificial intelligence."

query_vector = vectorizer.transform([query])

# 計算相似度

similarity = cosine_similarity(query_vector, tfidf_matrix)

best_match_index = similarity.argmax()

print(f"Best match answer: {answers[best_match_index]}")步驟 5:測試與優化

最后,進行搜索測試和對話測試,收集用戶反饋,并根據反饋不斷優化數據質量和檢索算法。

FastGPT快速部署:FastGPT- 快速部署FastGPT以及使用知識庫的兩種方式!

結尾

FastGPT 的知識庫邏輯與檢索機制為 AI 的智能化提供了強大的支持。通過向量搜索與大模型的結合,FastGPT 能夠實現高效的知識庫問答,幫助用戶快速獲取所需信息。希望本文的解析與教程能夠為您在 AI 領域的探索提供啟發與幫助!

本文轉載自微信公眾號「愛學習的蝌蚪」,可以通過以下二維碼關注。轉載本文請聯系愛學習的蝌蚪公眾號。