遺憾不?原來百度2017年就研究過Scaling Law,連Anthropic CEO靈感都來自百度

在追求 AGI 的道路上,Scaling Law 是繞不開的一環。

如果 Scaling Law 撞到了天花板,擴大模型規模,增加算力不能大幅提升模型的能力,那么就需要探索新的架構創新、算法優化或跨領域的技術突破。

作為一個學術概念,Scaling Law 為人所熟知,通常歸功于 OpenAI 在 2020 年發的這篇論文:

- 論文標題:Scaling Laws for Neural Language Models

- 論文鏈接:https://arxiv.org/pdf/2001.08361

論文中詳細地論證了模型的性能會隨模型參數量、數據量、計算資源增加而指數提升。后來的幾年里,OpenAI 作為整個大模型領域的技術引領者,也將 Scaling Law 充分地發揚光大。

但關于我們今天所談論的 Scaling law,它是怎么被發現的,誰最早發現的,又是哪個團隊最早驗證的,似乎很少有人去考據。

近日,Anthropic 的 CEO Dario Amodei 在播客中講述了一個出人意料的版本。

圖源:https://xueqiu.com/8973695164/312384612。發布者:@pacificwater

圖源:https://xueqiu.com/8973695164/312384612。發布者:@pacificwater

我們可能更了解 Dario 在 2016 年之后的經歷。他加入了 OpenAI,擔任研究副總裁,負責公司的安全工作,并領導團隊開發了 GPT-2 和 GPT-3。

然而,2020 年底,由于對 OpenAI 的發展方向產生分歧, Dario 選擇離開,并于 2021 年 2 月與妹妹共同創立了 Anthropic。

如今,Anthropic 推出的 Claude 已成為挑戰 GPT 系列霸主地位的最有力競爭者。

不過,Dario 原本的研究方向是神經回路,他第一次真正進入 AI 領域是在百度。

從 2014 年 11 月到 2015 年 10 月,Dario 在百度工作了一年 —— 正好是吳恩達在百度擔任首席科學家,負責「百度大腦」計劃的時期。

他們當時在研發語音識別系統。Dario 表示,盡管深度學習展示了很大潛力,但其他人仍然充滿疑慮,認為深度學習還不足以達到預期的效果,且距離他們所期待的與人類大腦相匹配的框架還有很長的距離。

于是,Dario 開始思考,如果把百度用于語音的循環神經網絡做得更大,增加更多的層數會怎樣?同時擴大數據量又會怎樣呢?

在不斷的嘗試中,Dario 觀察到了隨著給模型投入越多的數據、計算和訓練,它們的表現就越好,「那時我沒有精確地測量,但與同事們一起,我們非常直觀地能感受到。」

但 Dario 和同事們也沒深究,Dario 覺得:「也許這只對語音識別系統有效,也許這只是一個特定領域的特殊情況。」

直到 2017 年,他在 OpenAI 第一次看到 GPT-1 的訓練結果時,他才意識到這種「越多越好」的規則同樣適用于語言數據。而計算資源的增加,托起了 Scaling Law 生效的底層邏輯。

真理是不會只屬于一個人的,最終它會被每個人發現。

當時有一批人都意識到了 Scaling Law 的存在,比如 Ilya Sutskever、「RL 教父」Rich Sutton、Gwern Branwen。

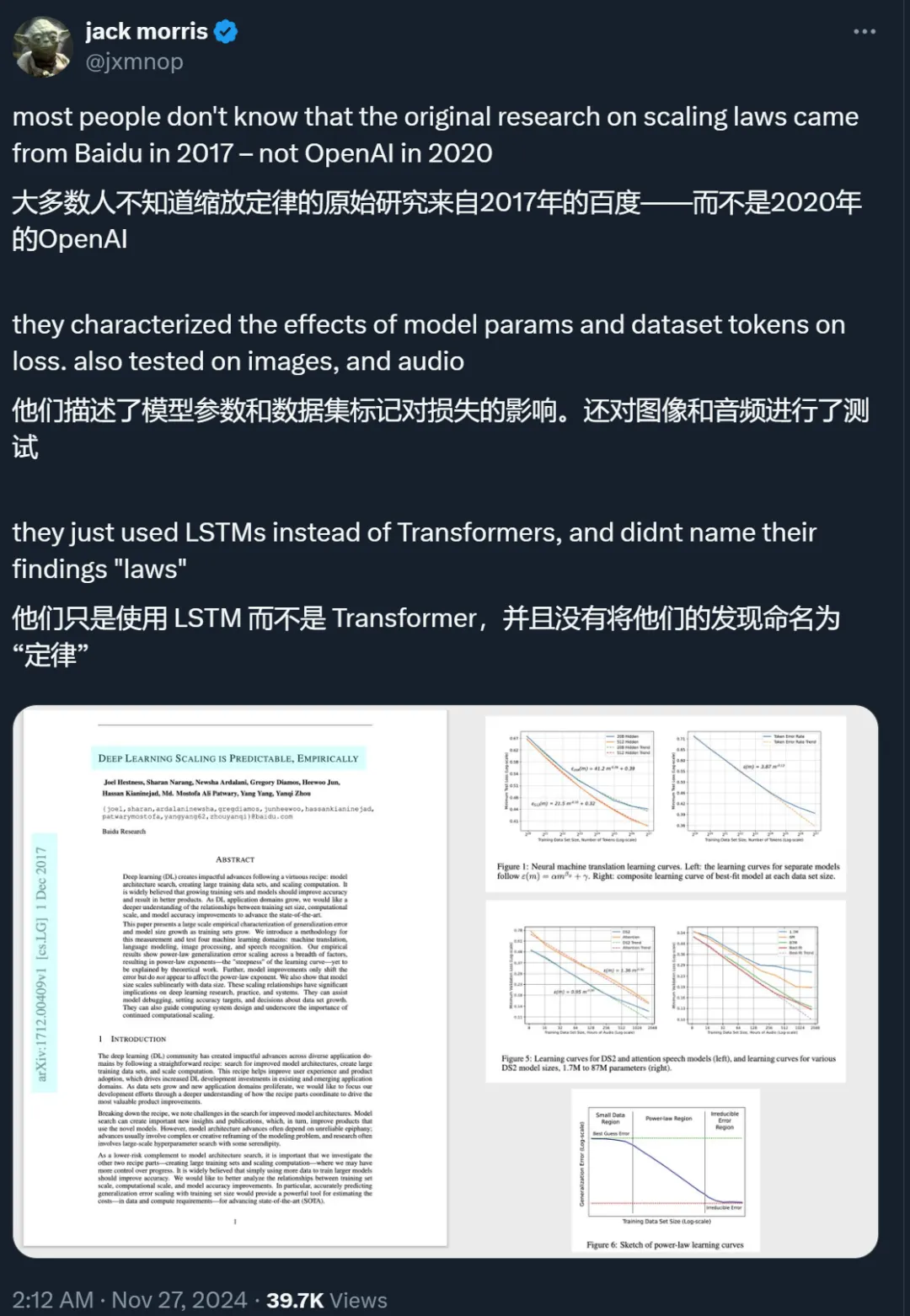

百度也在 2017 年發了一篇論文:「DEEP LEARNING SCALING IS PREDICTABLE, EMPIRICALLY」,展示了在機器翻譯、語言建模、圖像處理和語音識別等四個領域中,隨著訓練集規模的增長,DL 泛化誤差和模型大小呈現出冪律增長模式。

《NLP with Transformers》的作者 Lewis Tunstall 發現,OpenAI 在 2020 發表的《Scaling Laws for Neural Language Models》引用了百度論文一作 Joel Hestness 在 2019 年的后續研究,卻沒發現 Hestness 早在 2017 年就研究過同類問題。

DeepMind 的研究科學家 @SamuelMLSmith 表示,原來在 NeurIPS 和 Hestness 線下交流過。但兩年后 Scaling Laws 論文發表時,他對關注過這個問題,但沒發論文的自己很生氣。

而同期注意到 Scaling Law 的 Gwern Branwen,也經常提起百度的這篇論文確實被忽視了。

百度 2017 年的論文寫了啥?

這篇題為「DEEP LEARNING SCALING IS PREDICTABLE, EMPIRICALLY(深度學習擴展的可預測性:經驗性研究)」發布于 2017 年。當時,機器學習先驅 Rich Sutton 還沒有發布他的經典文章《苦澀的教訓》(發布時間是 2019 年)。

論文鏈接:https://arxiv.org/abs/1712.00409

論文提到,當時,深度學習社區已經通過遵循一個簡單的「配方」在不同的應用領域取得了具有影響力的進展。這個「配方」如今大家已非常熟悉,即尋找更好的模型架構、創建大型訓練數據集以及擴展計算。

通過分解「配方」,百度的研究者注意到,尋找更好的模型架構困難重重,因為你要對建模問題進行復雜或創造性的重構,這就涉及大規模的超參數搜索。所以,架構方面的創新很多時候要依賴「頓悟」,具有極大的偶然性。如果只把精力放在這上面,風險勢必很高。

為了降低風險,百度的研究者提到,「配方」的另外兩個部分 —— 創建大型訓練集和擴展計算 —— 是非常值得去研究的,因為這兩個方面的進展明顯更加可控。而且,「只需使用更多數據來訓練更大的模型,就能提高準確率」已經成為一個共識。不過,百度想更進一步,分析訓練集規模、計算規模和模型準確性提高之間的關系。他們認為,準確預測泛化誤差隨訓練集規模擴大的變化規律,將提供一個強大的工具,以估計推進 SOTA 技術所需的成本,包括數據和計算資源的需求。

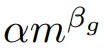

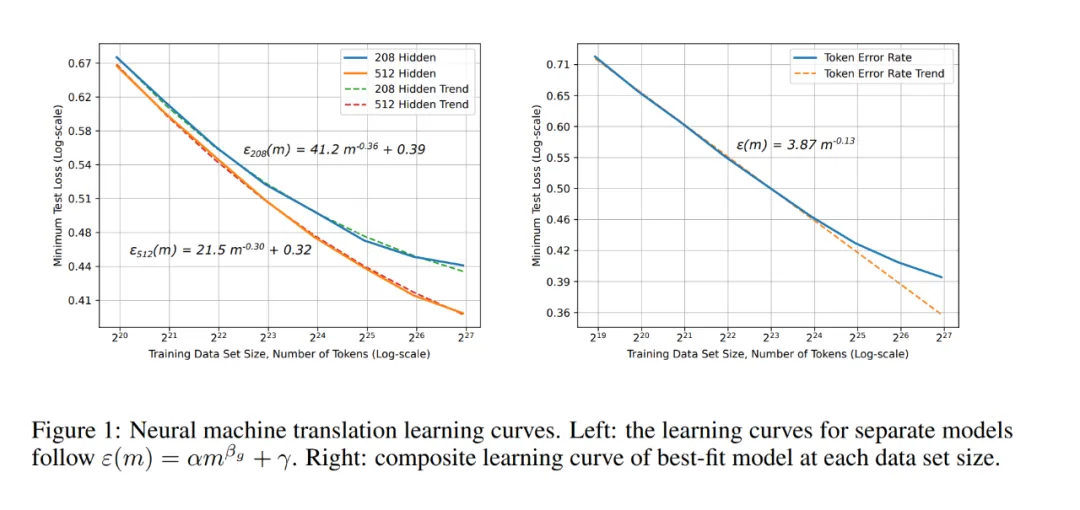

在此之前,也有不少研究者進行了類似研究,分析了達到期望泛化誤差所需的樣本復雜度,但論文中提到,這些結果似乎不足以準確預測實際應用中的誤差 scaling 規律。還有一些研究從理論上預測泛化誤差「學習曲線」呈冪律形式,即 ε(m) ∝ 。在這里,ε 是泛化誤差,m 是訓練集中的樣本數量,α 是問題的一個常數屬性。β_g= ?0.5 或?1 是定義學習曲線陡峭度的 scaling 指數 —— 即通過增加更多的訓練樣本,一個模型家族可以多快地學習。不過,在實際應用中,研究者發現,β_g 通常在?0.07 和?0.35 之間,這些指數是先前理論工作未能解釋的。

。在這里,ε 是泛化誤差,m 是訓練集中的樣本數量,α 是問題的一個常數屬性。β_g= ?0.5 或?1 是定義學習曲線陡峭度的 scaling 指數 —— 即通過增加更多的訓練樣本,一個模型家族可以多快地學習。不過,在實際應用中,研究者發現,β_g 通常在?0.07 和?0.35 之間,這些指數是先前理論工作未能解釋的。

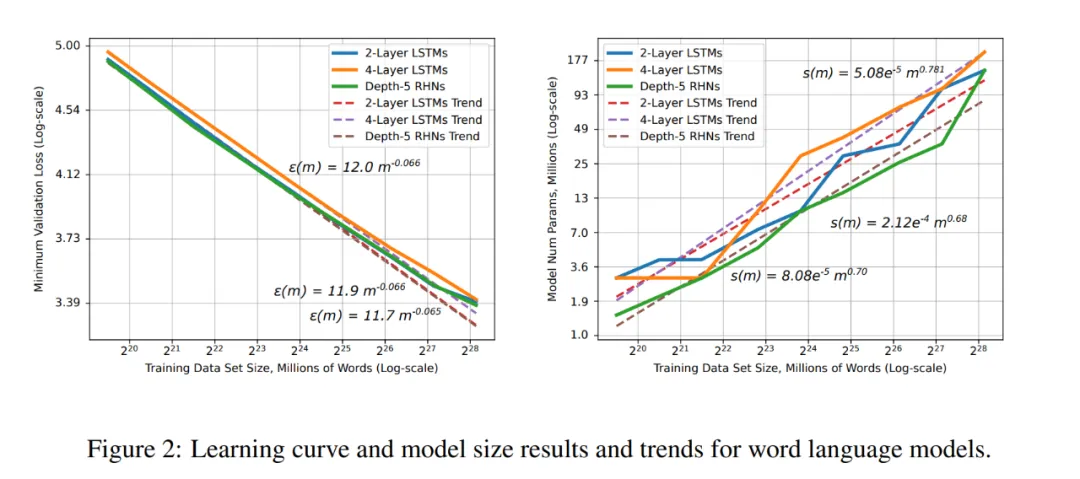

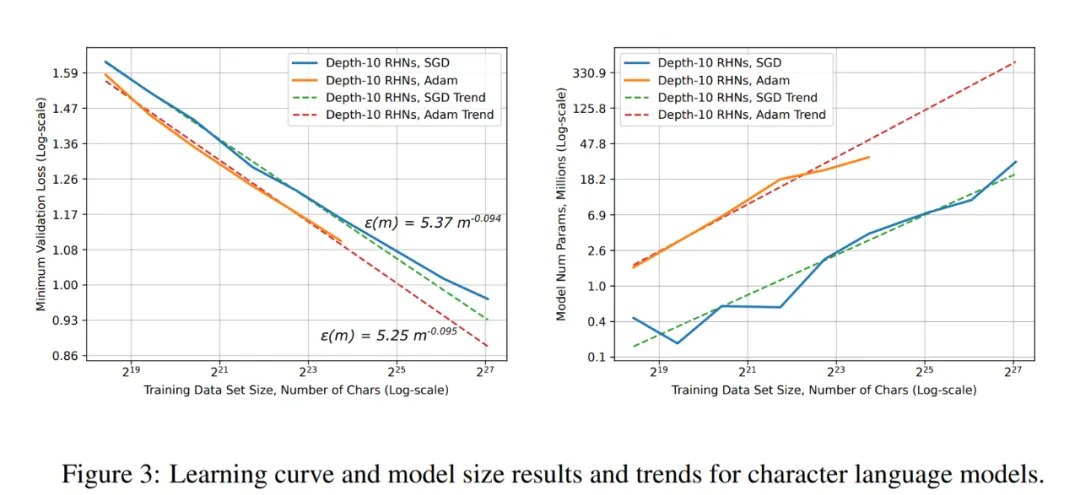

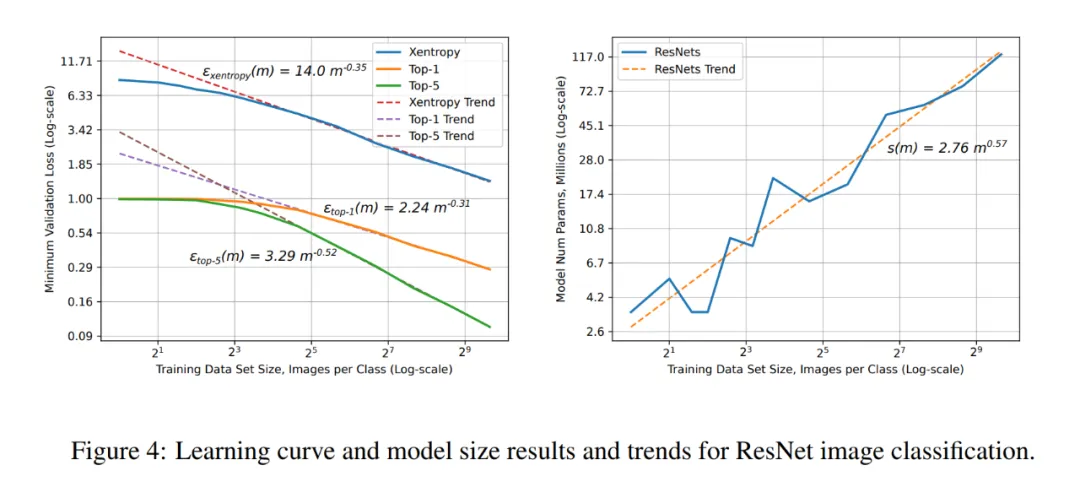

在這篇論文中,百度的研究者提出了當時最大規模的基于實證的學習曲線特征描述,揭示了深度學習泛化誤差確實顯示出冪律改進,但其指數必須通過實證進行預測。作者引入了一種方法,能夠準確預測隨著訓練集規模增加而變化的泛化誤差和模型大小。他們使用這種方法來估計四個應用領域(機器翻譯、語言建模、圖像分類和語音識別)中的六個深度神經網絡模型的 scaling 關系。

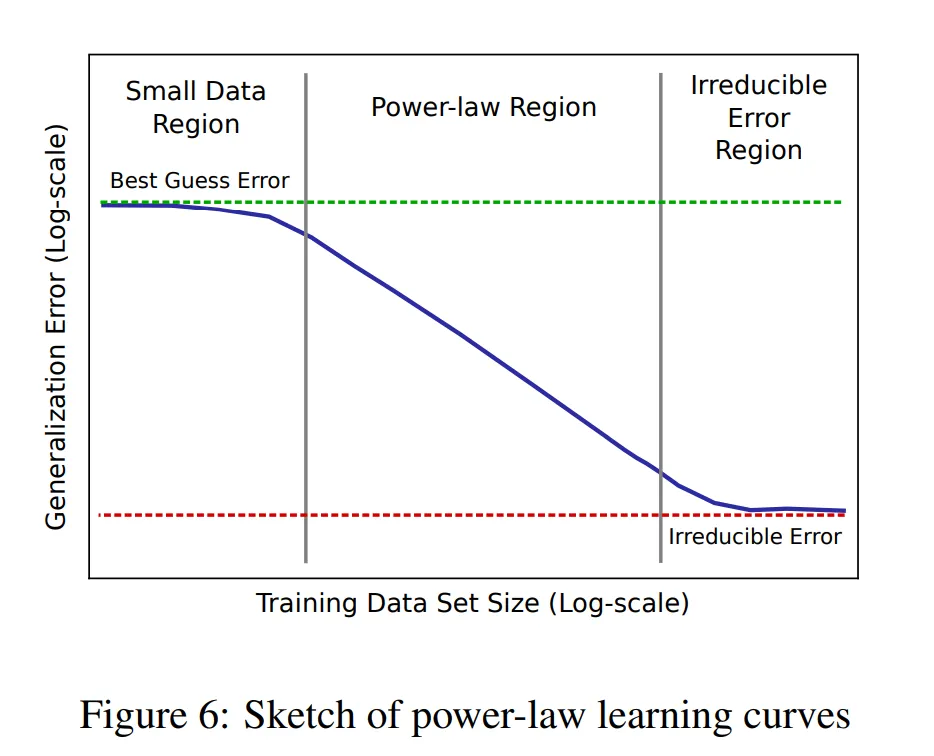

他們的結果顯示,在所有測試的領域中都存在冪律學習曲線。盡管不同的應用產生了不同的冪律指數和截距,但這些學習曲線跨越了廣泛的模型、優化器、正則化器和損失函數。改進的模型架構和優化器可以改善冪律截距,但不影響指數;單一領域的模型顯示出相同的學習曲線陡峭度。最后,他們發現模型從小訓練集區域(主要由最佳猜測主導)過渡到由冪律 scaling 主導的區域。有了足夠大的訓練集,模型將在主要由不可約誤差(例如貝葉斯誤差)主導的區域達到飽和。

此外,他們還描述了可預測的準確度和模型大小 scaling 的重要意義。對于深度學習從業人員和研究人員來說,學習曲線可以幫助調試模型,并為改進的模型架構預測準確性目標。

百度的研究者在論文中表示,他們的研究結果表明,我們有機會加倍努力,從理論上預測或解釋學習曲線指數。在操作上,可預測的學習曲線可以指導一些決策,如是否或如何增加數據集。最后,學習曲線和模型大小曲線可用于指導系統設計和擴展,它們強調了持續擴展計算的重要性。

神經機器翻譯學習曲線。

神經機器翻譯學習曲線。

單詞語言模型的學習曲線和模型大小結果和趨勢。

單詞語言模型的學習曲線和模型大小結果和趨勢。

字符語言模型的學習曲線和模型大小結果和趨勢。

字符語言模型的學習曲線和模型大小結果和趨勢。

ResNet 圖像分類任務上的學習曲線和模型大小結果和趨勢。

ResNet 圖像分類任務上的學習曲線和模型大小結果和趨勢。

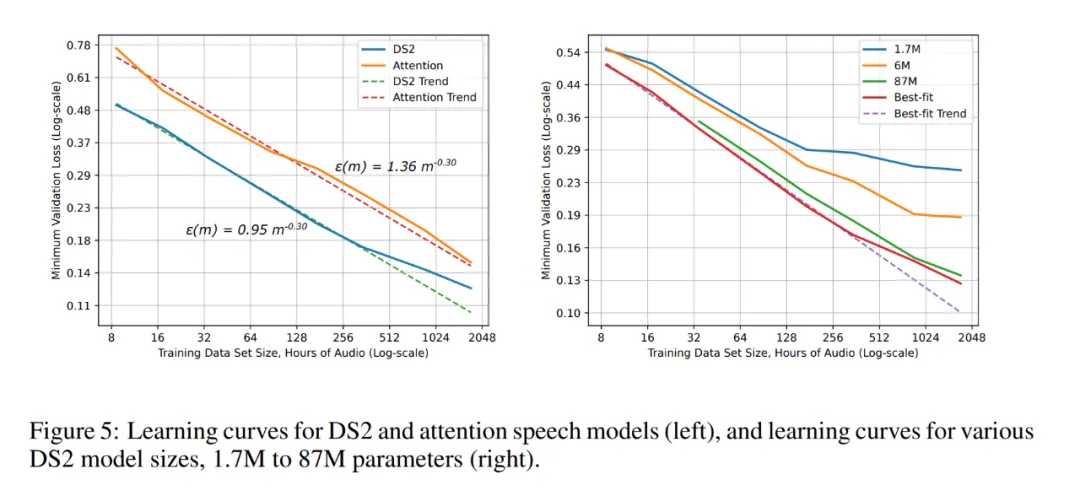

DS2 和注意力語音模型的學習曲線(左),以及不同 DS2 模型尺寸(1.7M ~ 87M 參數)的學習曲線(右)。

DS2 和注意力語音模型的學習曲線(左),以及不同 DS2 模型尺寸(1.7M ~ 87M 參數)的學習曲線(右)。

關于這篇論文的細節,感興趣的讀者可以去閱讀原文。

對于百度而言,早期對 Scaling Law 的研究未能及時轉化為廣泛的實踐應用,這在公司的發展史上或許算得上是一個不小的遺憾。