解讀小模型—SLM

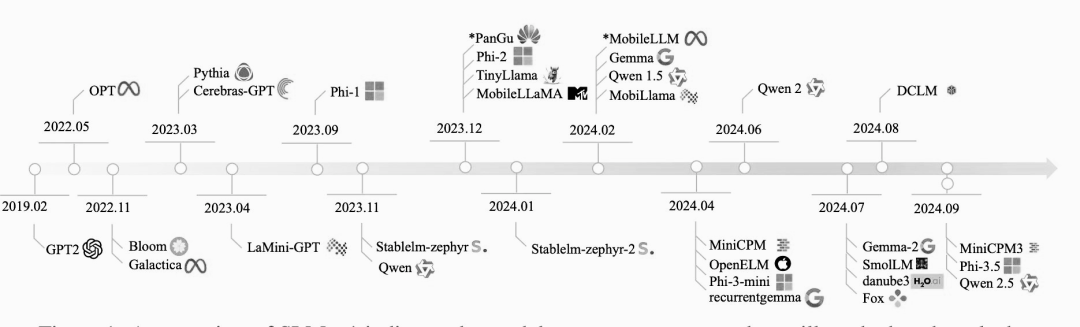

原創大模型的世界幾乎每天都在發生變化。一方面,人們越來越重視開發更大、更強大的語言模型,以實現通用人工智能(AGI)。這些大模型通常位于擁有數十萬GPU的大型數據中心中。科技巨頭之間正在進行一場激烈的競賽,爭奪誰能率先證明機器能夠處理復雜的語言任務,并實現AGI。

另一方面,人們也在創建更小的模型,稱為小型語言模型(SLM),以便高效地部署在設備上,如臺式機、智能手機和可穿戴設備。SLM并不是指傳統的參數較少的模型,而是大模型的小型化版本。創建SLM背后的愿景是使機器智能大眾化,讓每個人都能訪問并負擔得起。盡管SLM具有潛在的重要意義,但與大模型相比,受到的關注較少。

雖然關于SLM的功能或其在設備上運行成本的文獻有限,但這些模型已經被大規模地集成到商業設備中。例如,最新的谷歌/三星智能手機內置了Gemini Nano,使第三方移動應用程序能夠通過提示詞和LoRA模塊利用大模型功能。此外,iPhone和iPad上的最新iOS系統包括一個設備上的本地基礎模型,可以與操作系統無縫集成,從而提高性能和隱私保護。

1. 什么是SLM?

與大模型相比,SLM是一種簡化的、高效的語言模型,參數數量減少,總體規模較小。SLM中的“小”表示與大型語言模型相比,參數數量和模型的總體大小都減少了。雖然大模型可能有數十億甚至數萬億個參數,但 SLM 通常只有幾百萬到幾億個參數。

圖片

圖片

然而,什么是“小”可以根據場景和語言建模的當前技術狀態而變化。隨著近年來模型規模呈指數級增長,曾經被認為是大模型的東西現在可能被認為是小模型。GPT-2就是一個很好的例子。

2. 為什么參數的數量很重要?

語言模型中的參數數量決定了語言模型在訓練期間學習和存儲信息的能力。更多的參數通常允許模型捕獲更復雜的模式和細微差別,從而提高語言任務的性能。

下面是一些SLM的例子,它們展示了這些緊湊而強大的模型功能:

- Phi3 Mini: Phi-3-Mini 是一個擁有38億個參數的語言模型,基于3.3萬億個令牌的龐大數據集進行訓練。盡管它的尺寸較小,但是它可以與更大的模型競爭,比如 Mixtral 8x7B 和 GPT-3.5,在 MMLU (一個語言理解基準)和MT-bench(一個機器翻譯基準)上分別取得了可觀的69% 和8.38分。

- Google Gemma 2B: Google Gemma 2B 是 Gemma 系列的一部分,是一系列為各種文本生成任務設計的輕量級開放模型。Gemma 模型的上下文長度為8192個令牌,非常適合在筆記本電腦、臺式機或云基礎設施等資源有限的環境中部署。

- Databricks Dolly 3B: Databricks 的 Dolly-v2-3B 是在 Databricks 平臺上訓練的商業級指令跟蹤語言模型。它來源于 pythia-2.8B,已經在大約15,000個涵蓋不同領域的指令/響應組上進行了訓練。雖然它可能不是最先進的,但它顯示了非常高質量的指令遵循行為。

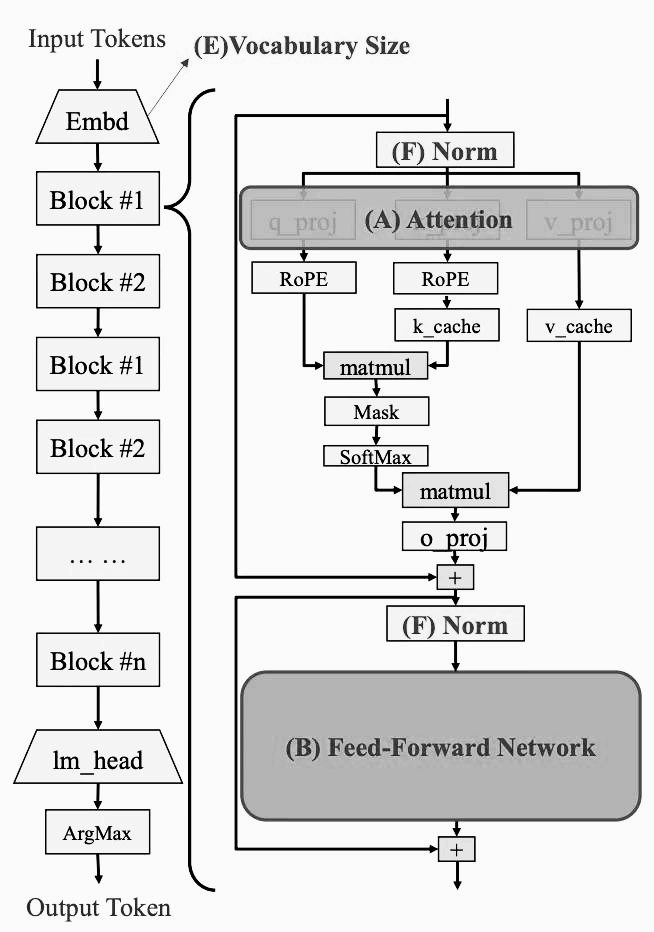

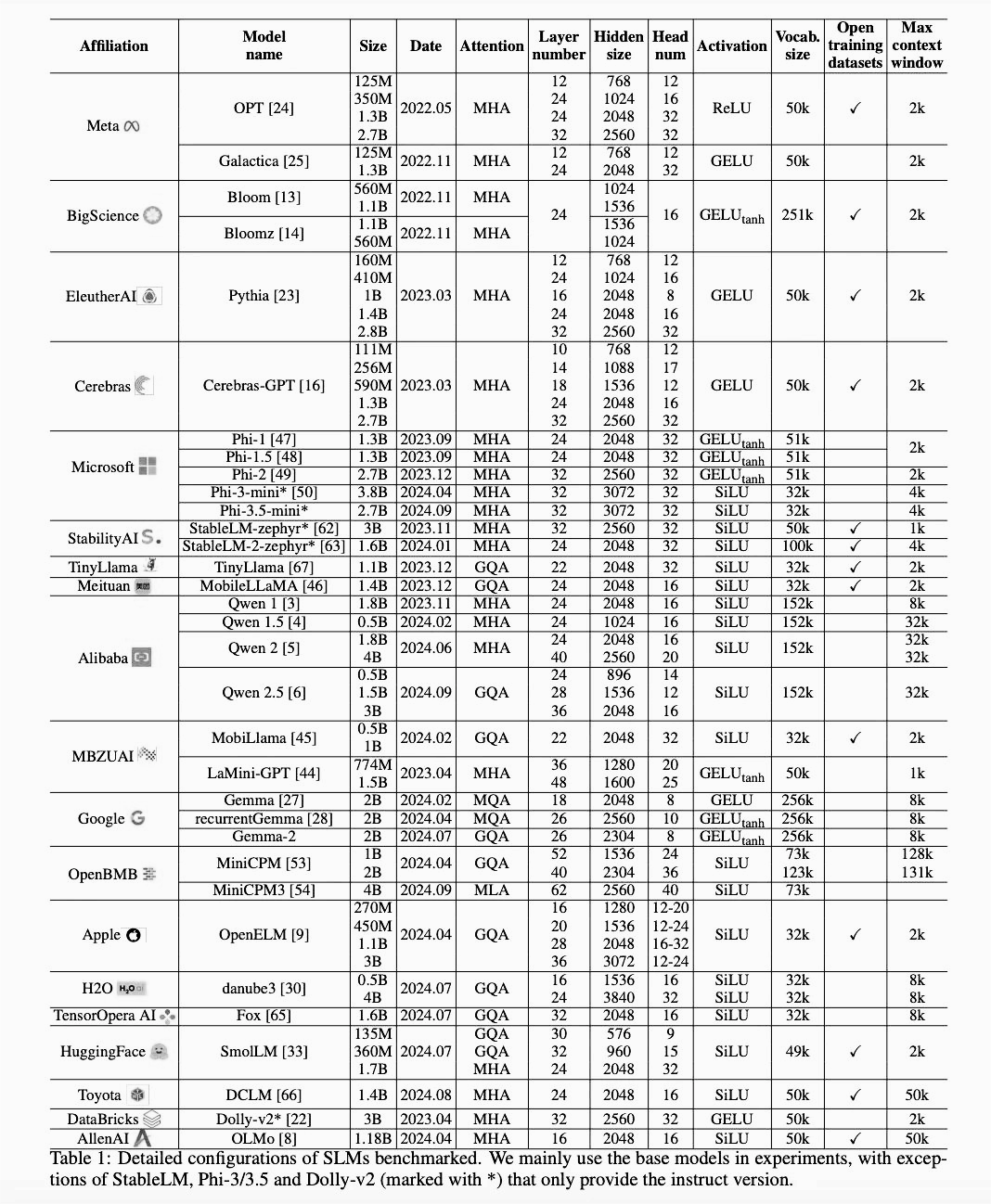

3. SLM 的架構變化

隨著時間的推移,這些SLM的架構發生了變化。

圖片

圖片

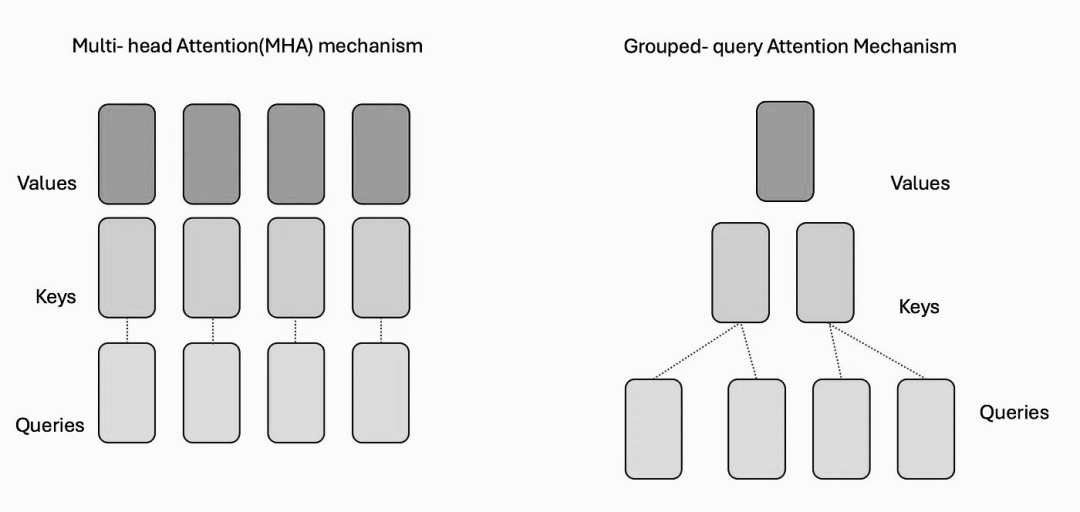

3.1 自注意力機制的類型改變

在Transformer模型中,自注意機制是至關重要的。在SLM中,主要有四種類型的自注意機制: 多頭注意力(MHA)、多查詢注意力(MQA)、群體查詢注意力(GQA)和多頭潛在注意力(MLA)。

圖片

圖片

- 多頭注意力機制: 這種機制允許模型通過利用多頭注意力同時關注輸入數據的不同部分。它是transformer模型中最常用的自注意機制。

- 群組查詢注意力: GQA 是多頭注意力的一種變體,它通過在多頭之間共享查詢表示,同時保持單獨的key-value表示來降低計算復雜性。它的目的是在注意機制的計算效率和多樣性之間取得平衡。

圖片

圖片

- 多查詢注意力: 通過在所有頭之間使用一個共享查詢來簡化多頭注意力,但是允許不同的鍵和值投影。這降低了空間和時間的復雜性。

- 多頭潛在注意力(MLA) : MLA 利用low-rank和KV聯合壓縮獲得比 MHA 更好的效果,需要的鍵值(KV)緩存要少得多。

隨著時間的推移,人們對這些自注意機制的偏好發生了變化。

圖片

圖片

上圖顯示了從2022年到2024年期間自注意力機制的演變趨勢。可以看出,MHA 正在逐步淘汰,并被 GQA 所取代。

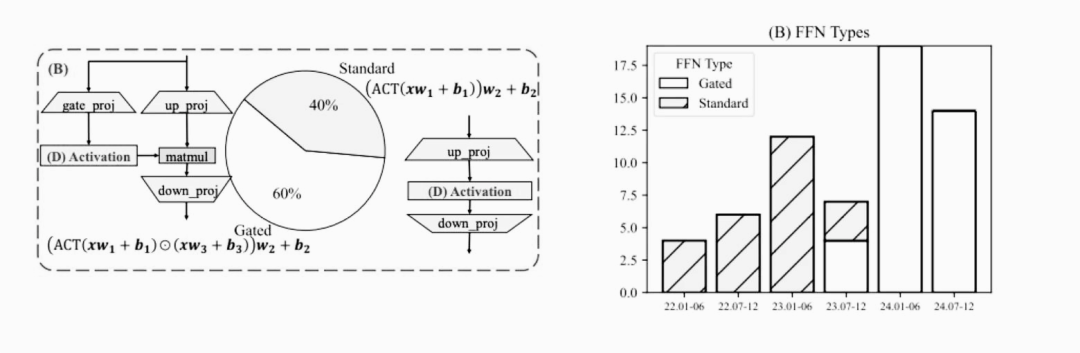

3.2 前饋神經網絡的類型變化

前饋網絡可以分為兩種主要類型: 標準 FFN 和門限 FFN。

圖片

圖片

- 標準 FFN: 這種類型的網絡由兩層組成,利用一個激活函數。這是神經網絡中常用的結構。

- 門限 FFN: 門限 FFN 在標準方法之外進一步采用了門限層,這個層增強了網絡控制和調節信息流的能力。

隨著時間的推移,人們對這些前饋神經網絡類型的偏好也發生了變化。上冊的右側顯示了2022年至2024年SLM使用的前饋網絡類型的趨勢,標準的 FFN 正在逐步淘汰,并被門限 FFN 所取代。

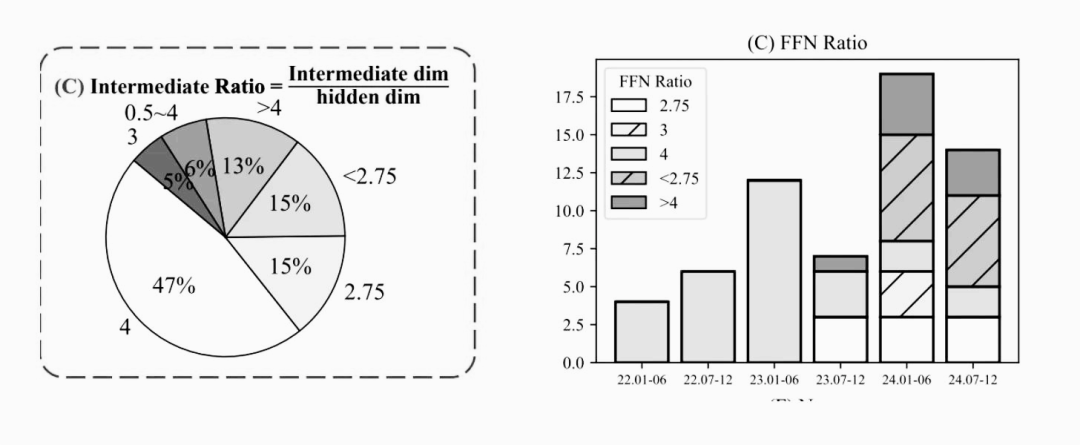

3.3 前饋網絡中間層比率的變化

前饋神經網絡的中間比率是指中間層維數與隱含層維數之間的比值。簡單而言,它決定了中間層相對于整個網絡的大小。對于標準 FFN,它通常設置中間比率為4。這意味著中間層通常比隱藏層小四倍。另一方面,門限 FFN 在中間比值上表現出更大的分集性。它可以是從2到8的任何范圍,表明中間層的大小在不同的模型之間變化。

研究觀察了的有趣模式。下面圖提供了從2022年到2024年不同前饋網絡中間比率的趨勢變化。

圖片

圖片

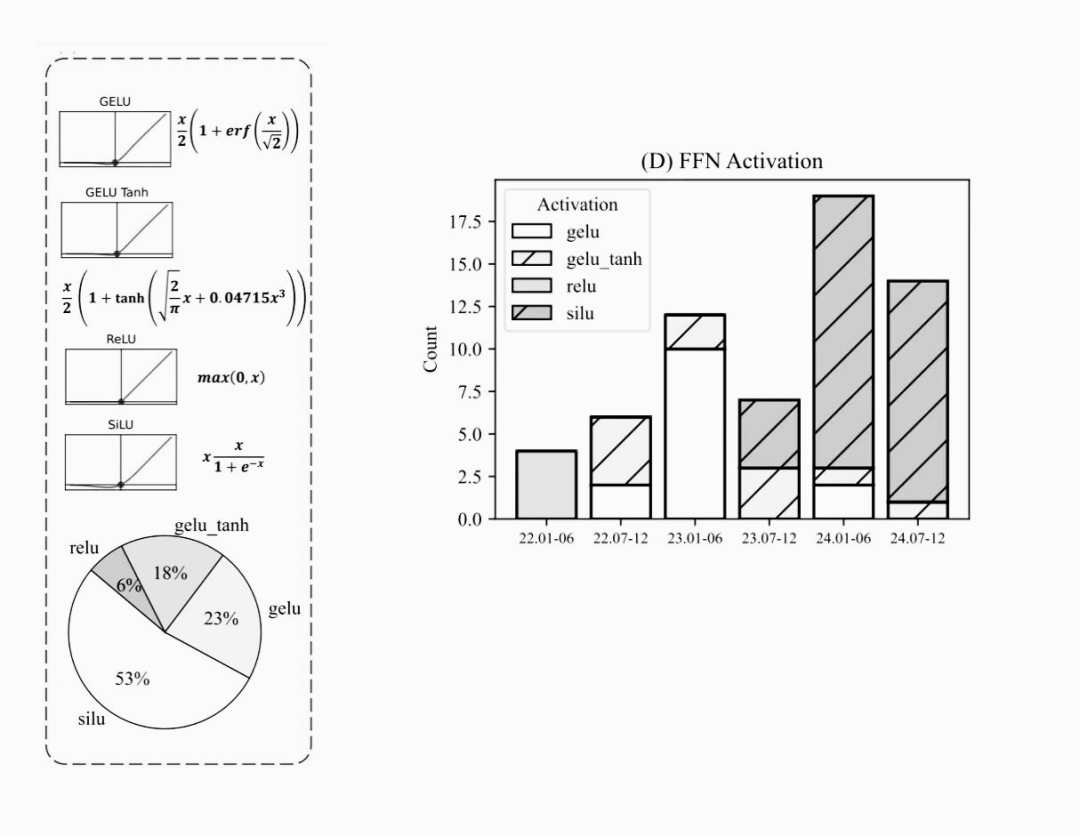

3.4 前饋神經網絡激活函數的改變

在前饋神經網絡(FFN)中,有四種常用的激活函數:

- ReLU (Rectified Linear Unit) : ReLU 就像一個開關,打開或關閉的信息流,它應用廣泛。

- GELU (Gaussian Error Linear Unit): GELU 是一種平滑零值和正值之間轉換的激活函數,而 GELUtanh 是GELU的變體。

- SiLU (Sigmoid Linear Unit): SiLU 是一個結合了 Sigmoid 函數和線性函數特性的激活函數。

圖片

圖片

隨著時間的推移,這些激活函數的使用發生了變化。在2022年,ReLU成為許多 FFN 的首選激活函數。然而,進入2023年,過渡到使用 GELU 及其變體GELUtanh。到2024年,SiLU成為激活函數的主要選擇。

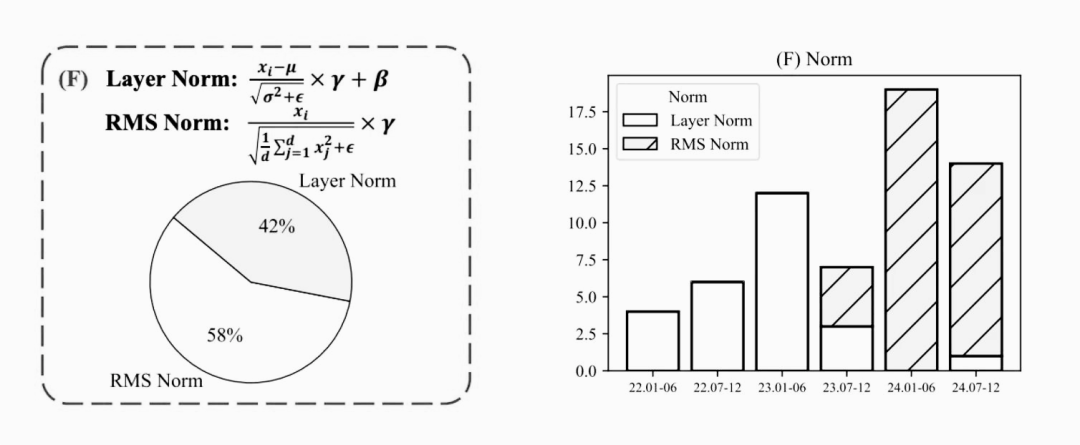

3.5 歸一化類型的變化

當涉及到歸一化層時,有兩種常用的主要類型: LayerNorm 和 RMSNorm。

- LayerNorm是一種歸一化技術,它調整神經網絡每一層的值。它在SLM中得到了廣泛的應用。

- RMSNorm或平方平均數標準化有助于調整和穩定每一層神經網絡的值。

圖片

圖片

在過去的幾年中,LayerNorm是最常用的技術。然而,近幾年已經向采用 RMSNorm的方向轉變了。

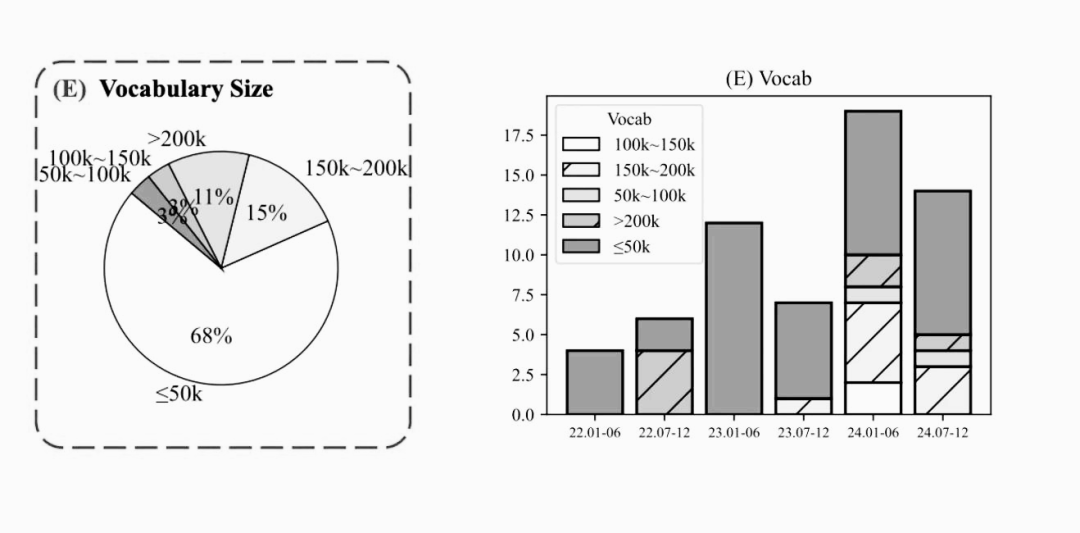

3.6 詞匯表的增加

詞匯表是指SLM能夠理解和識別的唯一單詞或token的總數,從2022年到2024年間詞匯表的變化趨勢。

圖片

圖片

事實上,較新的SLM詞匯表通常超過50,000個單詞或token。詞匯表的擴大使模型能夠處理更廣泛的語言,并提供更準確和更全面的響應。

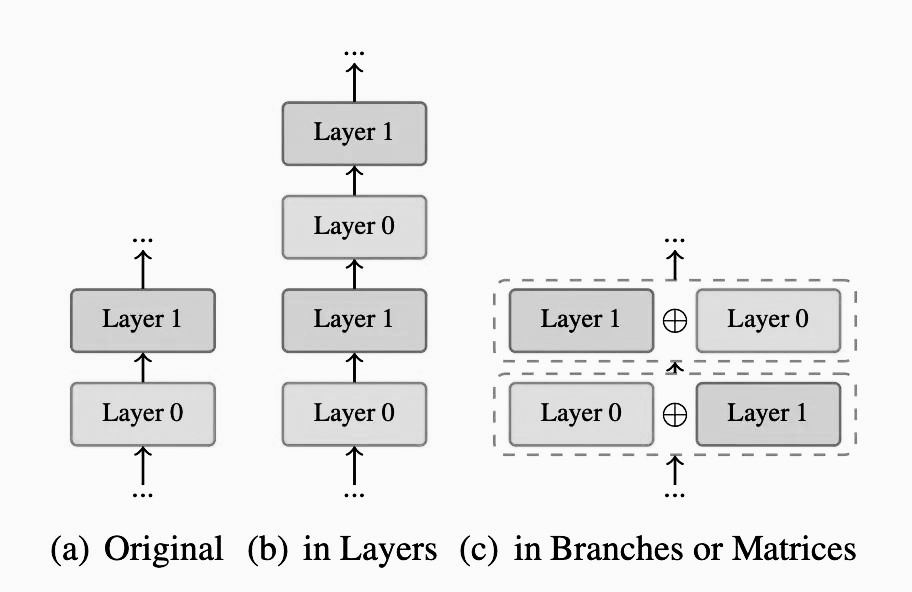

4. SLM 的架構創新

截至2024年10月,SLM的典型架構往往包括GQA、具有SiLU激活的門控前饋網絡(FFN)、2到8之間的FFN中間層比率、RMSNorm和大于50000的詞匯表。

圖片

圖片

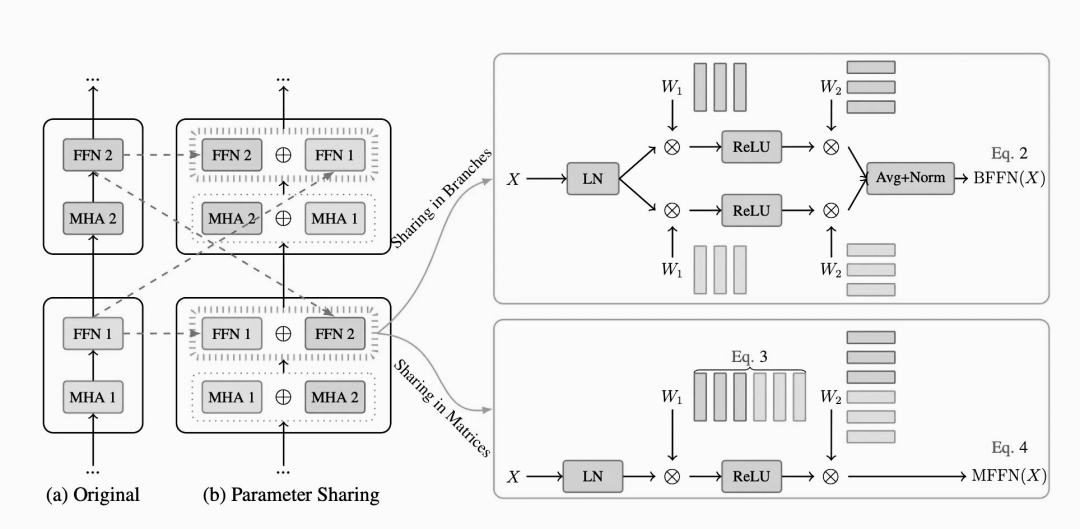

SLM 技術近年來得到了一些創新和發展,其中的關鍵技術包括了參數共享和非線性補償技術。

4.1 參數共享

在大模型中,參數共享技術允許在網絡的不同部分重復使用相同的權重集。這不僅有助于減少參數數量,還能在保持性能的同時提高模型的效率。一種常見的方法是embedding-lm的head共享,即單詞嵌入層與最終語言模型(LM)的head層共享相同的權重。另一個例子是分層注意力/FFN共享,其中在模型的多個層中使用相同的權重。這種共享技術可以在Gemma和Qwen等模型中看到,顯著提升了模型的訓練和推理效率。

圖片

圖片

4.2 分層參數縮放

OpenELM引入了一種創新技術,稱為分層參數縮放。與傳統模型中每個Transformer層具有相同配置不同,OpenELM為每個層分配了不同的配置。這種設計使得每一層中的參數數量發生變化,從而優化了資源分配,提高了模型的整體效率和性能。通過這種方式,OpenELM能夠在保持計算成本可控的同時,實現更高的精度和更強的表達能力。這一技術不僅提升了模型的靈活性,還增強了其在各種任務中的應用效果。

圖片

圖片

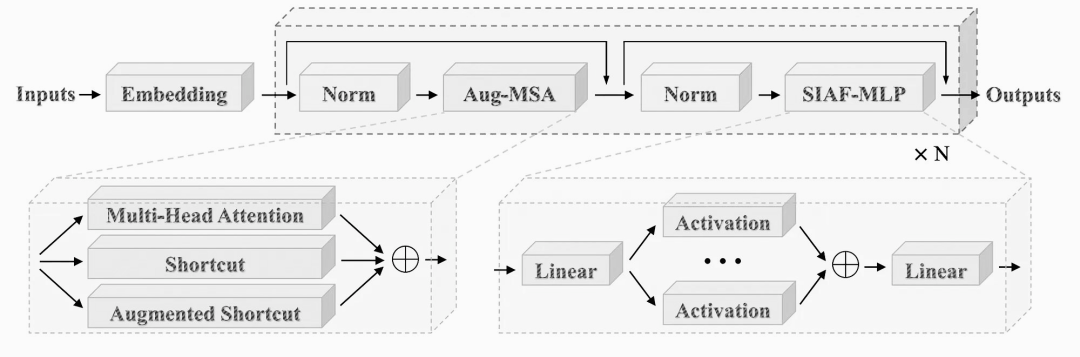

4.3 非線性補償

PanGu-π在分析現有語言模型架構時,注意到了一個稱為特征折疊的問題。這個問題影響了模型的表達能力。為了更直觀地解釋這一點,我們可以深入觀察LLaMA的層結構,發現其學習到的特征(或表示)的多樣性開始減少,特征變得更加相似,這意味著token之間的差異減小。因此,該模型生成多樣化和高質量輸出的能力受到了影響,進而影響了其創造性和整體性能。

為了解決這個問題,PanGu-π采用了兩種非線性補償技術。首先,在前饋網絡(FFN)中引入了一系列激活函數以增加更多的非線性。其次,在多頭注意力機制(MHA)中引入了增強的快捷方式,進一步增強了Transformer結構的非線性。這些架構創新令人興奮,因為它們顯著提高了小型語言模型的效率、性能和有效性,使它們在理解和生成類人文本方面更加強大和有能力。

圖片

圖片

5. SLM 的應用場景

小型的、面向特定任務的語言模型正逐漸成為大型通用模型的強大替代品。在以下場景中,SLM可能成為許多企業更優的選擇。

5.1 降低成本和減少資源使用

大型模型因其龐大的功耗和資源需求而聞名。相比之下,小型語言模型(SLM)雖然也需要一定的計算資源,但由于它們是在更小、更具體的數據集上進行訓練的,因此對系統的要求和成本要低得多。此外,由于所需的計算資源更少,SLM也消耗更少的電力,使其成為一種更加環保的選擇。這種優勢不僅有助于降低企業的運營成本,還能減少對環境的影響,符合可持續發展的理念。

5.2 為特定任務量身定制的性能

當企業應用人工智能技術時,它們尋求的是針對性強、切實可行的解決方案,而非海量但雜亂無章的信息。盡管大型模型具備處理廣泛任務的能力,但在滿足特定業務需求方面,這些模型往往難以做到精準聚焦。試圖以數千億個參數來滿足所有人的所有需求,在企業環境中幾乎毫無意義。

相比之下,專為特定任務設計的小型語言模型(SLM)在知識檢索或客戶支持等場景下表現更佳。例如,像Salesforce xGen這樣的開源模型,通過結合預訓練技術和重點數據,能夠持續提供優秀的結果,擅長于信息匯總、代碼編寫等任務。

5.3 提高準確度

人工智能模型的準確性在很大程度上取決于其訓練數據的質量與相關性。大型通用模型通常使用大量互聯網數據進行訓練,但這些數據中有很多可能與特定的業務需求并不直接相關,導致模型在實際應用中表現不佳。相比之下,像xGen這樣的小型語言模型(SLM)則采用了與企業密切相關的數據進行訓練,例如客戶關系管理(CRM)系統中的信息。這種高度相關的數據使得SLM能夠更好地理解和處理特定領域的任務,從而提高了模型的準確性和實用性。

6. 小結

隨著企業在不斷發展的生成式AI領域中持續前行,SLM正逐漸成為一種實用且強大的解決方案。它巧妙地平衡了能力和效率,使企業能夠以更加可控和定制化的方式利用人工智能。

目前,SLM架構的配置已經發生了顯著變化,包括中間層比率、注意力機制類型以及激活函數等,這些調整對運行時速度產生了顯著影響。盡管在SLM中對Transformer結構的改進相對有限,但為了實現最佳的精度與速度折衷,人們正在積極探索與特定硬件協同設計的方案,并進一步優化SLM架構。

【參考資料】

- ”Small Language Models: Survey, Measurements and Insights”, https://arxiv.org/pdf/2409.15790

- “PanGu-π: Enhancing Language Model Architectures via Nonlinearity Compensation”, https://arxiv.org/abs/2312.17276

- “Understanding Parameter Sharing in Transformers”, https://arxiv.org/pdf/2306.09380