DeepMind悄悄發(fā)布PaliGemma二代,最易微調(diào)「視覺語言全能王」來了,多項任務登頂SOTA

OpenAI的發(fā)布會仿佛連續(xù)劇,讓人眼花繚亂,谷歌也悄悄發(fā)布了PaliGemma 2模型,邁向可調(diào)視覺語言模型的下一代。

今年5月,谷歌發(fā)布PaliGemma,也是Gemma家族中的第一個視覺語言模型,致力于模型民主化,降低視覺模型的使用難度。

PaliGemma 2模型以更高性能的Gemma 2為基座,增加了視覺能力,微調(diào)起來更容易,性能也更好。

技術報告中分析了任務類型、模型尺寸和分辨率之間的相互作用,相比PaliGemma進一步擴大了遷移任務的數(shù)量和范圍,包括與OCR相關的任務,如表格結構識別、分子結構識別、樂譜識別,以及更長、更細粒度的圖像描述和放射學報告生成,并且在這些任務上都取得了最先進的結果。

報告鏈接:https://arxiv.org/pdf/2412.03555

PaliGemma 2的主要特點為:

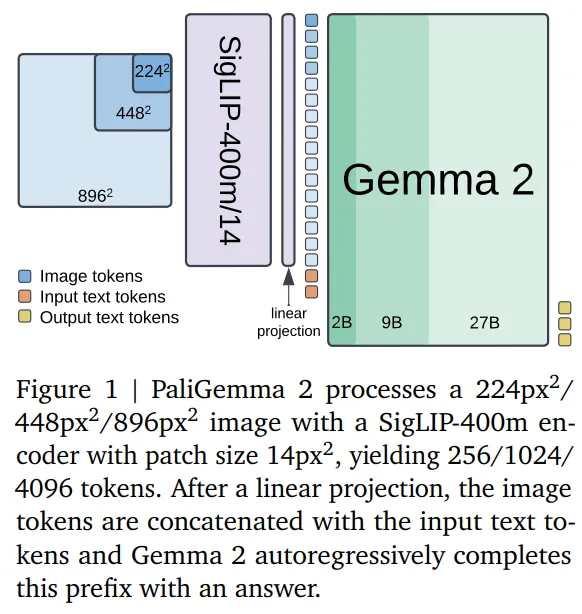

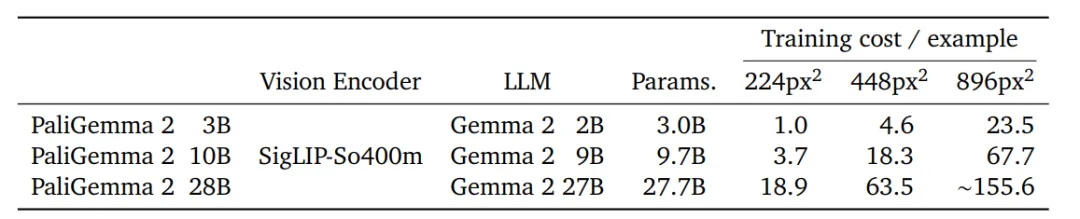

1. 模型尺寸包括3B、10B、28B 參數(shù),可適應任務分辨率為224px、448px、896px的視覺輸入。

2. PaliGemma 2可以為圖像生成詳細的、上下文相關的描述,而不只是簡單的對象識別來描述動作、情感和場景的整體敘述。

3. PaliGemma 2在化學式識別、樂譜識別、空間推理和胸部X光報告生成方面的性能更強。

PaliGemma一代的用戶可以直接升級到PaliGemma 2,無需進行重大代碼修改即可獲得性能提升。

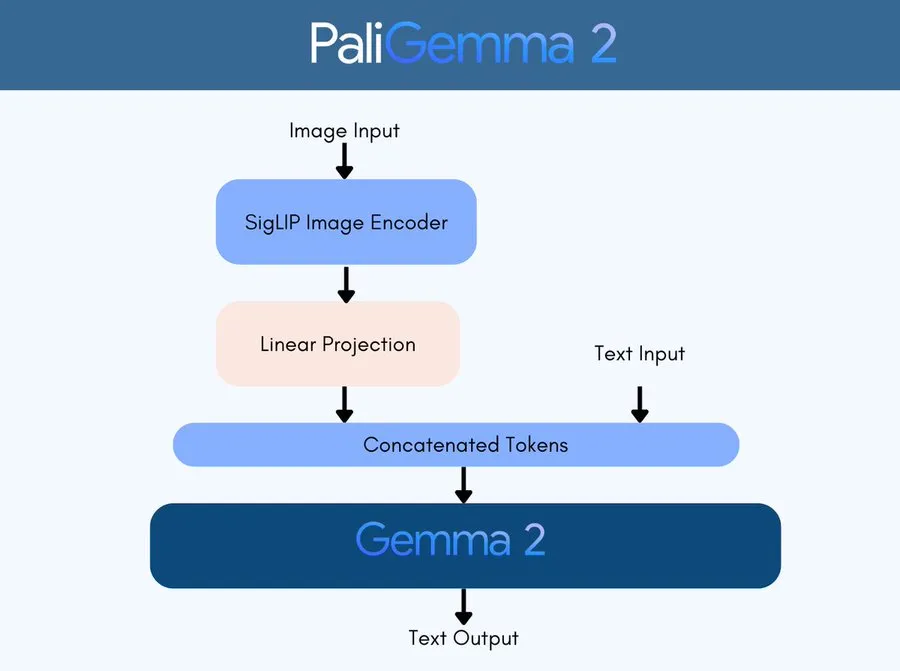

模型架構

研究人員遵循與PaliGemma相同的建模、訓練和數(shù)據(jù)設置:使用預訓練SigLIP-So400m視覺編碼器,通過線性投影將「嵌入序列」映射到Gemma 2的輸入空間;視覺嵌入與文本提示結合后,輸入到Gemma 2語言模型;最后通過自回歸采樣從語言模型中獲得預測。

研究人員將PaliGemma 2的預訓練分為三個階段(不包括對單模態(tài)組件進行預訓練)。

第一階段,結合預訓練的SigLIPSo400m和Gemma 2的原始模型權重,并在超過10億個多模態(tài)任務樣本上進行訓練;圖像分辨率為224*224像素;在此階段沒有凍結任何參數(shù)。

第二階段,先在448*448像素分辨率下對5000萬個樣本進行訓練,然后在896*896像素分辨率下訓練1000萬個樣本。在任務選擇上,增加那些「能從高分辨率圖像中受益的任務」比例,增加輸出序列的長度,以促進長視覺文本序列的OCR等任務的學習。

第三階段,將第一或第二階段的檢查點微調(diào)到目標任務。PaliGemma包括一系列學術基準,包括一些涉及多張圖像和短視頻的基準。

此外,研究人員還探索了文檔的相關任務、長圖像描述生成和醫(yī)學圖像理解的新應用。

實驗結果

研究人員測試了PaliGemma 2在文本檢測和識別、表格結構識別、分子結構識別、光學樂譜識別(optical music score recognition)、長圖像描述生成、空間推理以及放射圖像報告生成(radiography report generation)任務上的性能。

模型尺寸和分辨率

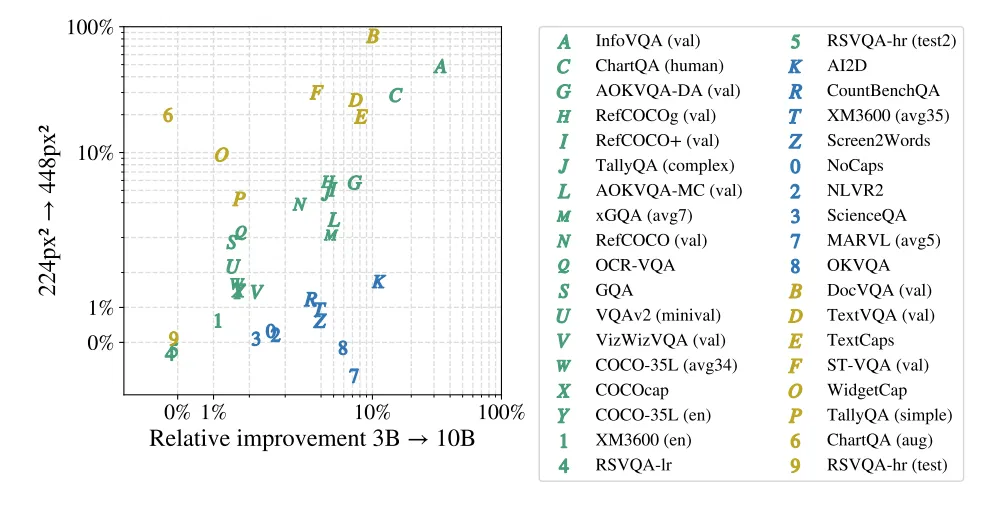

研究人員探索了不同尺寸和分辨率的模型在完成各種任務時的表現(xiàn)如何,主要選擇了三種尺寸(3B、10B和28B),并在兩種不同的圖像清晰度(224像素和448像素)下對模型進行訓練,任務包括了對自然照片、文件、圖表和視頻的圖像描述、視覺問答和指代分割等。

從結果中可以發(fā)現(xiàn),讓模型處理更高清晰度的圖像或者使用更大尺寸的語言模型,都會增加預測時的計算量,但大多數(shù)任務都能從這兩項改進中獲得性能提升。

涉及文本、文檔、屏幕和圖表理解的任務,提高圖像清晰度帶來的收益更大,可能是因為這些任務中使用的圖像原生分辨率就比224像素大,所以提高分辨率后效果更明顯。

涉及多語言數(shù)據(jù)或需要復雜視覺推理的任務,主要從增大模型尺寸中獲益。

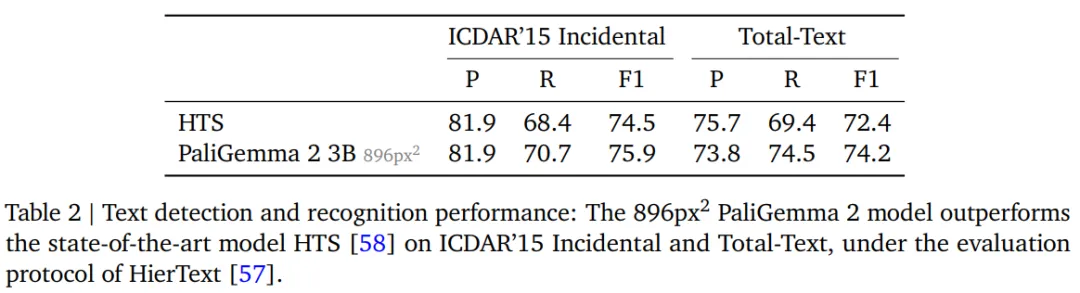

文本檢測和識別

在高級光學字符識別(OCR)任務時,模型需要從圖像中定位和識別出單詞,輸出結果為一個數(shù)據(jù)對「轉(zhuǎn)錄文本,邊界框」,研究人員遵循HierText競賽的規(guī)則,使用單詞級別的精確度、召回率和F1分數(shù)作為評估指標。

如果單詞結果與真實邊界框的交并比(IoU)大于或等于0.5,并且轉(zhuǎn)錄文本與真實文本匹配,則認為該單詞結果是true positive,但HierText協(xié)議不會歸一化字母大小寫、標點符號,也不會根據(jù)文本長度進行過濾,而是直接將預測結果與真實結果進行比較。

研究人員使用常見的OCR基準測試,包括ICDAR’15、Total-Text、MLT17和MLT19、HierText、TextOCR、IntelOCR等多個數(shù)據(jù)集的訓練分割混合上對PaliGemma 2進行了微調(diào),并在ICDAR’15和Total-Text測試集上進行評估。

結果顯示,在896像素分辨率下,PaliGemma 2 3B的性能超過了最先進的HTS模型。

需要注意的是,PaliGemma 2并沒有依賴于OCR專用的架構組件,只通過微調(diào)一個通用的視覺-語言模型(VLM)即實現(xiàn)了sota,展現(xiàn)了PaliGemma 2的多功能性,以及在第2和第3階段進行OCR相關預訓練的優(yōu)勢。

降低分辨率后,預測質(zhì)量大幅下降,并且增大模型尺寸并沒有帶來改進。

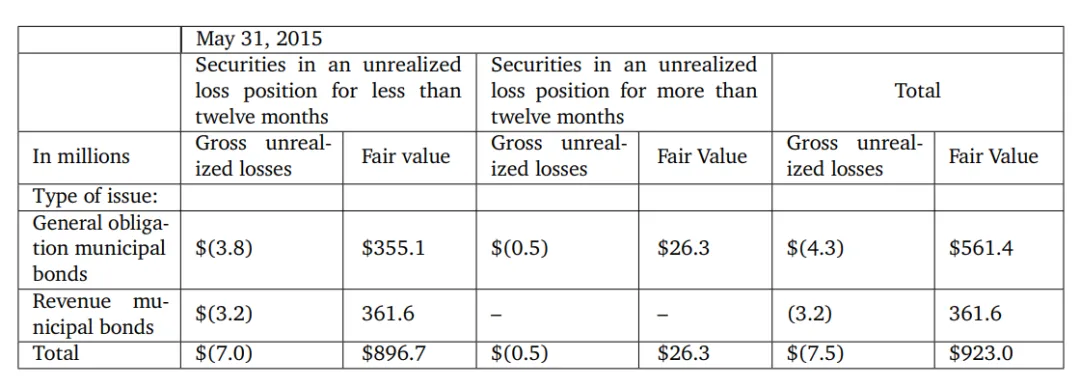

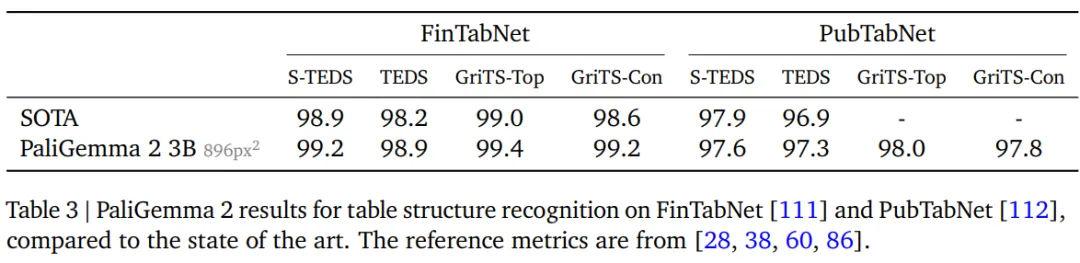

表格結構識別

表格結構識別任務的目標是從文檔圖像中提取表格文本內(nèi)容、相應的邊界框坐標以及HTML格式的表格結構。

研究人員選擇PubTabNet的516k張表格數(shù)據(jù)圖像,和FinTabNet數(shù)據(jù)集中來自標普500公司年報的113k個財務報告表格,去除邊界框超出圖像框架的數(shù)據(jù)后,把圖像填充為正方形以匹配目標輸入分辨率。

研究人員使用樹編輯距離相似度(TEDS)和網(wǎng)格表格相似度(GriTS)兩個指標來評估模型質(zhì)量,主要測量單元格文本內(nèi)容、單元格拓撲/結構和邊界框質(zhì)量。

結果顯示,PaliGemma 2在大多數(shù)指標下都展現(xiàn)出了最高的性能,并且增加模型尺寸也沒有對模型的性能帶來提升,而使用更低的圖像分辨率則會導致質(zhì)量出現(xiàn)小幅下降。

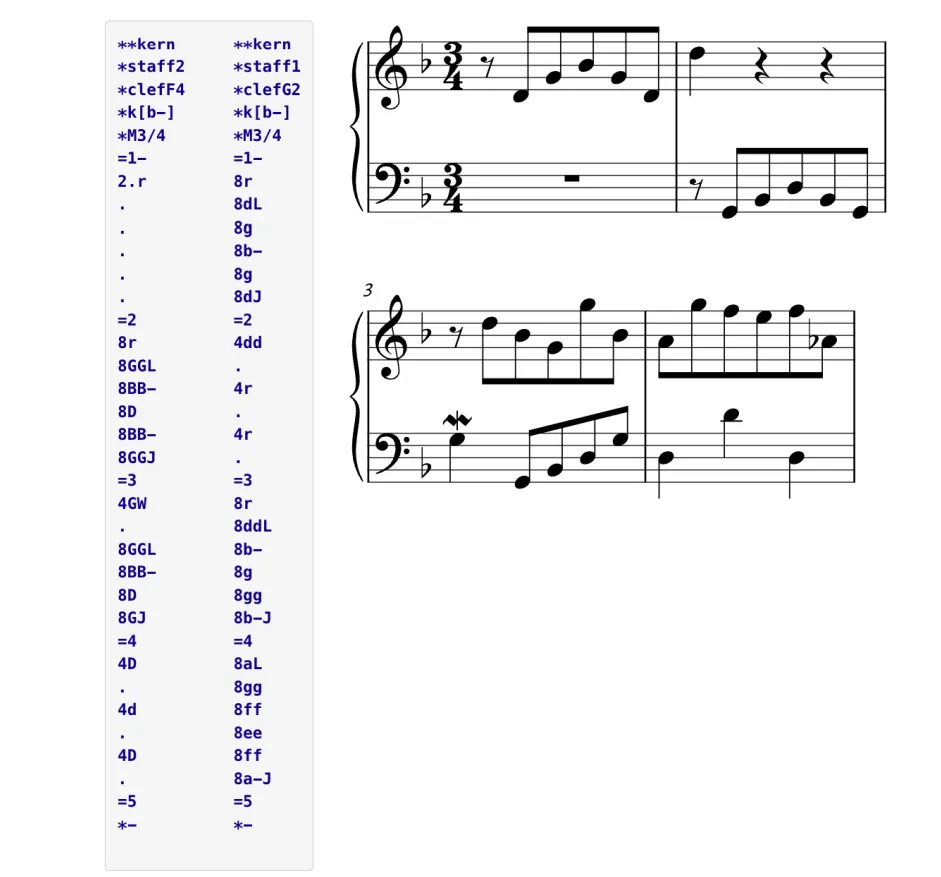

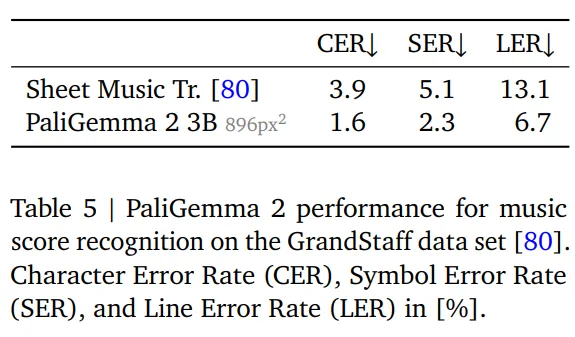

樂譜識別

研究人員使用了GrandStaff數(shù)據(jù)集進行微調(diào),包含53.7k張圖像,基于標準化的平均編輯距離、字符錯誤率(CER)、符號錯誤率(SER)、行錯誤率(LER)進行評估。

結果顯示,隨著分辨率的提高,錯誤率也在逐漸降低,但將模型大小從3B增加到10B并沒有影響性能。

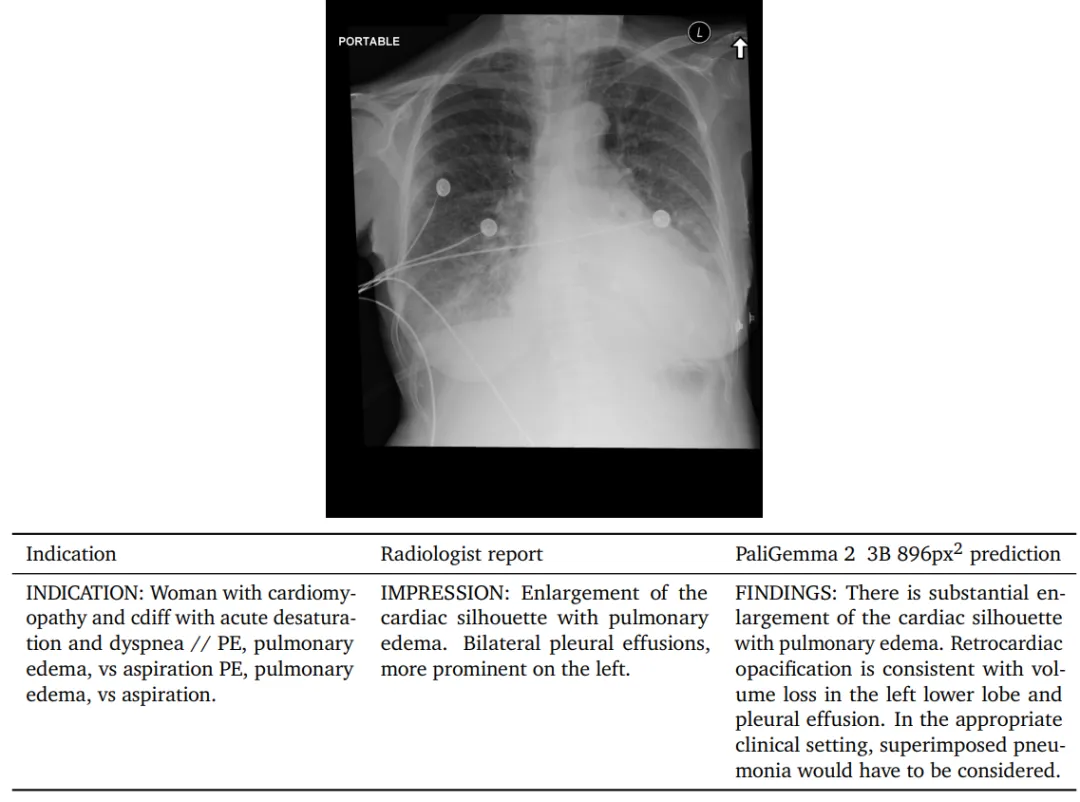

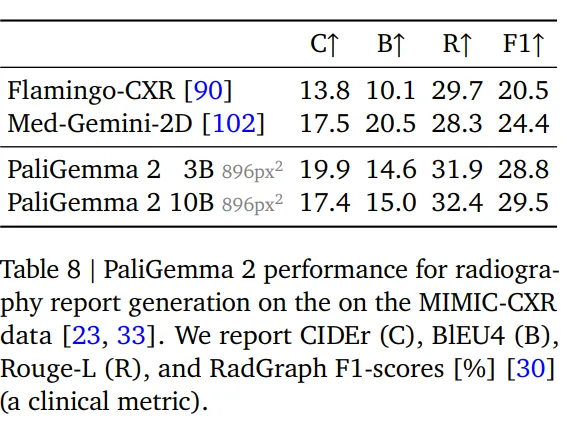

放射報告生成

為了探索PaliGemma 2在醫(yī)學領域的能力,研究人員將其用于自動胸部X光報告生成任務上,相當于對X光圖像進行長描述。

MIMICCXR數(shù)據(jù)集包含37.7萬張圖像,及相應的放射報告;使用Gemini 1.5 pro來移除之前數(shù)據(jù)中涵蓋的X光。

在使用該數(shù)據(jù)進行微調(diào)后,用RadGraph F1分數(shù)評估結果,衡量參考報告中提取的實體與生成報告之間的F1分數(shù),可以反應報告中實體的缺失或召回情況,以及與圖像特征的關系。

可以看到,PaliGemma 2模型的實現(xiàn)了最好的性能,提高分辨率和模型大小都能帶來性能提升。

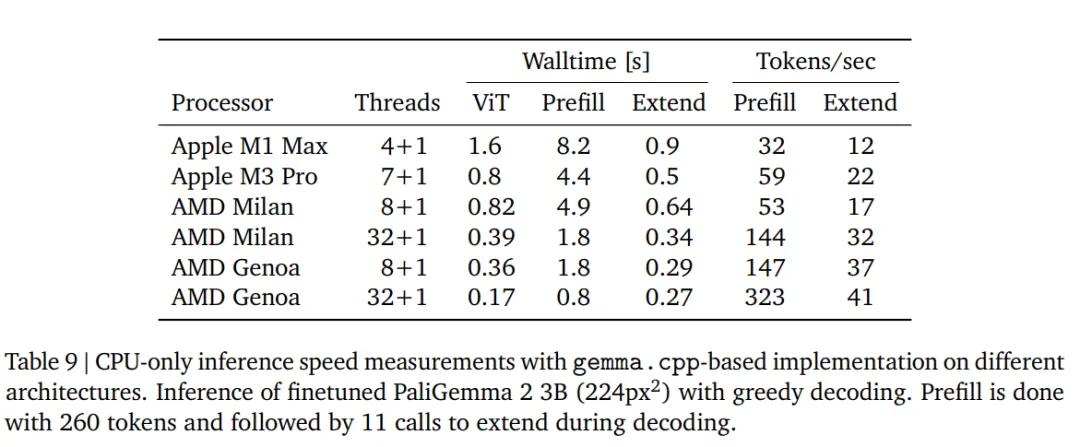

CPU推理和量化

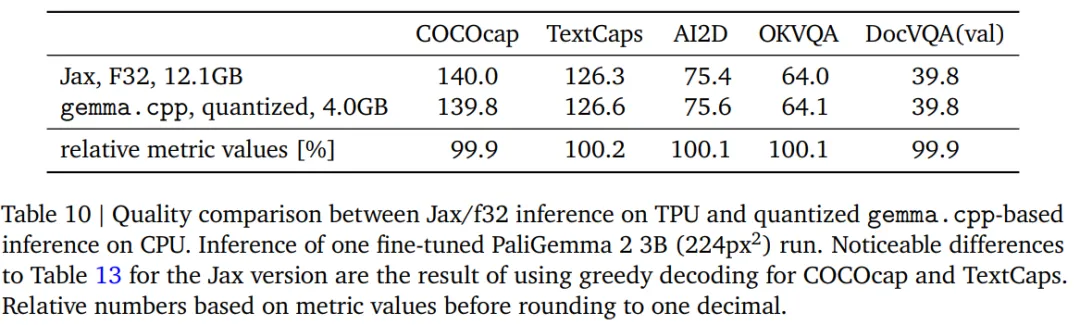

為了評估只用CPU進行推理的速度,研究人員在四種不同的架構上使用gemma.cpp運行PaliGemma 2模型,檢查點使用在COCOcap上微調(diào)過的PaliGemma 2 3B(224像素)模型。

提示詞「描述這幅圖像」的預填充長度為256+4=260個token(圖像+文本),輸出回復「A large building with two towers on the water」為11個token

研究人員還對模型進行了量化實驗,從32位浮點(f32)轉(zhuǎn)換到16位(bf16)權重,結果顯示性能差異并不大。