3D世界的新視角:以O(shè)bject為中心的占用補(bǔ)全技術(shù)(港中文&小米)

寫(xiě)在前面 && 筆者理解

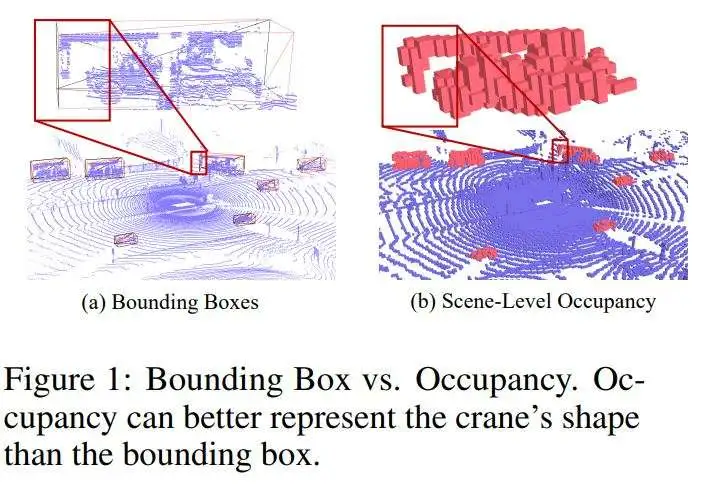

傳統(tǒng)的感知主要采用3D對(duì)象邊界框(bboxes)來(lái)表征感知,但是這樣的表示其實(shí)是有局限性的,它無(wú)法捕捉物體形狀的精確細(xì)節(jié),特別是對(duì)于具有不規(guī)則幾何形狀的物體,因?yàn)樗举|(zhì)上是一個(gè)包含物體的長(zhǎng)方體。比如下圖1(a)所示,起重機(jī)被一個(gè)3D邊界框完美包圍。但是,其相對(duì)于駕駛室的長(zhǎng)突出部分在3D邊界框內(nèi)產(chǎn)生了大量未占用的空間。而感知出來(lái)的結(jié)果是將3D邊界框所包圍的空間視為不可通行的。因此,在處理復(fù)雜和不規(guī)則形狀的物體時(shí),邊界框在提供細(xì)粒度感知結(jié)果方面是不足夠的,這可能會(huì)影響后續(xù)任務(wù)的精度,如規(guī)劃和控制。

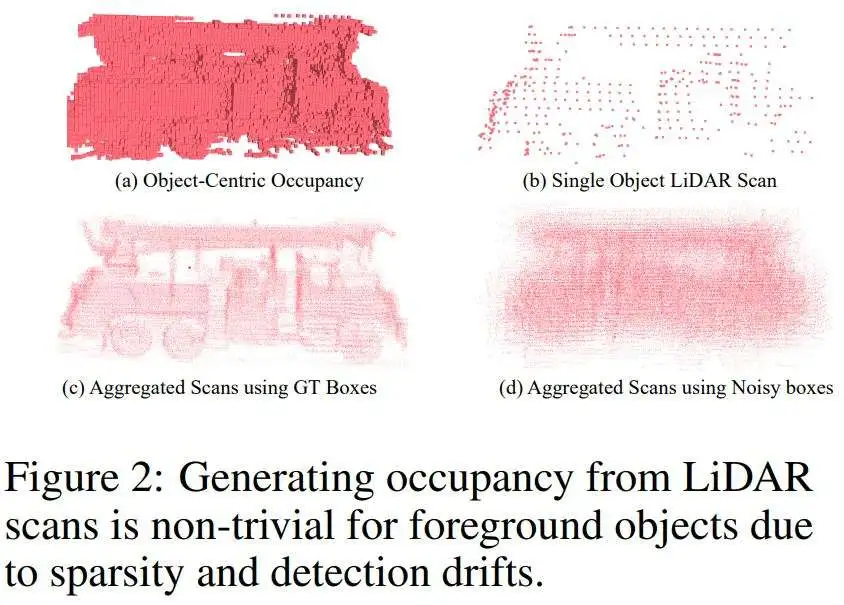

所以,占用空間是一個(gè)比較強(qiáng)有力的替代方法,如圖1(b)所示,占用表示將3D空間離散化為體積網(wǎng)格,其中每個(gè)體素被分類(lèi)為被占用或空閑。與3D邊界框相比,這種表示更有效地捕捉不規(guī)則形狀,從而增強(qiáng)了精確規(guī)劃和控制。然而,從傳感器輸入實(shí)時(shí)生成場(chǎng)景級(jí)占用,無(wú)論是從視覺(jué)中心輸入還是激光雷達(dá)傳感器都非易事,前者是因?yàn)槿鄙偕疃雀兄笳呤且驗(yàn)槊看渭す饫走_(dá)掃描的稀疏性(見(jiàn)圖2(b))。

因此,現(xiàn)有的方法利用神經(jīng)網(wǎng)絡(luò)以數(shù)據(jù)驅(qū)動(dòng)的方式預(yù)測(cè)占用。由于計(jì)算限制,這些方法通常為大場(chǎng)景感知產(chǎn)生低分辨率占用網(wǎng)格或者需要大量的訓(xùn)練來(lái)實(shí)現(xiàn)隱式表示,這在實(shí)際使用中仍然是不夠的和效率低下的。另一種構(gòu)建占用網(wǎng)格的方法是直接體素化激光雷達(dá)點(diǎn)云。為了緩解稀疏性問(wèn)題(圖2(b)),聚合多個(gè)激光雷達(dá)掃描對(duì)于背景是有效的。然而,對(duì)于前景物體,占用構(gòu)造變得具有挑戰(zhàn)性,因?yàn)樗枰獪?zhǔn)確的檢測(cè)和跟蹤來(lái)補(bǔ)償它們的潛在移動(dòng)。在實(shí)時(shí)應(yīng)用中,3D檢測(cè)容易漂移,跟蹤算法可能會(huì)丟失或錯(cuò)配物體,導(dǎo)致不準(zhǔn)確的軌跡。如圖2(d)所示,直接從不準(zhǔn)確的軌跡聚合點(diǎn)云會(huì)導(dǎo)致極其模糊的形狀表示。這些不準(zhǔn)確隨時(shí)間積累,逐漸降低了形狀表示的可靠性。

- 論文鏈接:https://arxiv.org/pdf/2412.05154

基于這些觀察,作者做了本文的工作,主要貢獻(xiàn)總結(jié)如下:

- 引入了以對(duì)象為中心的占用作為對(duì)象邊界框的補(bǔ)充,為物體的內(nèi)在幾何提供了更詳細(xì)的結(jié)構(gòu)描述。與其場(chǎng)景級(jí)對(duì)應(yīng)物不同,以對(duì)象為中心的占用專(zhuān)門(mén)關(guān)注前景物體,允許即使在大場(chǎng)景中也能實(shí)現(xiàn)更高的體素分辨率。

- 為了促進(jìn)以對(duì)象為中心的占用感知的發(fā)展,作者提出了一個(gè)新的以對(duì)象為中心的占用數(shù)據(jù)集,該數(shù)據(jù)集是使用自動(dòng)化流水線從零開(kāi)始構(gòu)建的。

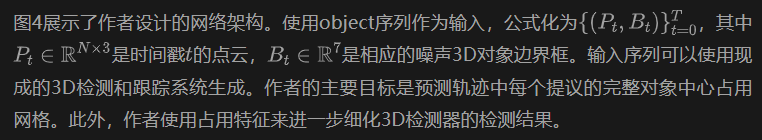

- 提出了一個(gè)魯棒的基于序列的占用完成網(wǎng)絡(luò)。通過(guò)使用注意力機(jī)制聚合歷史觀測(cè)的時(shí)間信息,該網(wǎng)絡(luò)有效地處理檢測(cè)漂移,并準(zhǔn)確預(yù)測(cè)完整的對(duì)象中心占用。

- 采用了隱式形狀解碼器來(lái)生成動(dòng)態(tài)大小的占用,并通過(guò)對(duì)選擇位置的查詢減少訓(xùn)練成本。在Waymo Open Dataset (WOD) 下的實(shí)驗(yàn)表明,即使在嘈雜的檢測(cè)和跟蹤條件下,本文的方法也能展現(xiàn)出魯棒的性能,完成對(duì)象形狀。憑借隱式形狀描述符,作者展示了最先進(jìn)的3D對(duì)象檢測(cè)器的性能也可以得到改善,特別是對(duì)于不完整或遠(yuǎn)距離的物體。

相關(guān)工作

3D占用空間預(yù)測(cè)和形狀補(bǔ)全

3D語(yǔ)義占用預(yù)測(cè)(SOP)已成為以視覺(jué)為中心的自動(dòng)駕駛中的關(guān)鍵任務(wù),其中算法主要使用RGB攝像頭感知環(huán)境。這些以視覺(jué)為中心的模型通常將周?chē)h(huán)境離散化為體積網(wǎng)格,并通過(guò)對(duì)單個(gè)/多視圖RGB圖像的適當(dāng)聚合來(lái)預(yù)測(cè)每個(gè)體素的占用狀態(tài)。對(duì)于被占用的體素,模型還會(huì)額外預(yù)測(cè)相應(yīng)的語(yǔ)義類(lèi)別。另一個(gè)類(lèi)似的任務(wù)是3D語(yǔ)義場(chǎng)景補(bǔ)全(SSC)。與只需要預(yù)測(cè)可見(jiàn)區(qū)域的占用的SOP不同,SSC還要求模型確定未見(jiàn)區(qū)域的占用狀態(tài)。值得注意的是,盡管SOP和SSC主要與以視覺(jué)為中心的方法相關(guān),但它們也適用于稀疏激光雷達(dá)或多模態(tài)輸入。現(xiàn)有的SOP和SSC方法主要關(guān)注場(chǎng)景級(jí)占用,而作者的工作集中在對(duì)象級(jí)占用上,以更好地表示形狀。此外,對(duì)于作者設(shè)置,被占用體素的語(yǔ)義不是必需的,因?yàn)樽髡咧饕P(guān)注的是對(duì)象邊界框內(nèi)的幾何結(jié)構(gòu),其類(lèi)別標(biāo)簽是已知的。與作者基于占用的方法不同,大多數(shù)形狀補(bǔ)全方法專(zhuān)注于對(duì)象的表面重建。然而,基于表面的表示不太適合自動(dòng)駕駛感知,因?yàn)樗鼈儾恢苯又С种T如避碰等任務(wù)。

長(zhǎng)序列做3D目標(biāo)檢測(cè)

對(duì)于單幀檢測(cè)器可以通過(guò)將幾個(gè)歷史幀的連接作為輸入,來(lái)獲得不錯(cuò)的效果。盡管這種簡(jiǎn)單的多幀策略顯示出明顯的改進(jìn),但隨著輸入幀數(shù)的增加,性能容易飽和。此外,隨著輸入幀數(shù)的增加,計(jì)算成本顯著增加,這對(duì)于實(shí)時(shí)應(yīng)用不理想。為了解決這個(gè)問(wèn)題,有的工作采用了殘差點(diǎn)探測(cè)策略來(lái)移除多幀輸入中的冗余點(diǎn),有的工作選擇了一種以對(duì)象為中心的方法,通過(guò)對(duì)軌跡提議進(jìn)行時(shí)間聚合,允許處理更長(zhǎng)的序列以降低計(jì)算成本。此外,還有一些工作通過(guò)利用整個(gè)對(duì)象軌跡的過(guò)去和未來(lái)信息,展示了人類(lèi)級(jí)別的檢測(cè)性能。然而,它們僅限于離線應(yīng)用,因?yàn)樗鼈冃枰L問(wèn)未來(lái)的幀。最近,MoDAR通過(guò)使用從長(zhǎng)歷史子序列預(yù)測(cè)的未來(lái)軌跡點(diǎn)來(lái)增強(qiáng)激光雷達(dá)點(diǎn)云,從而改進(jìn)檢測(cè)。與MoDAR相比,作者的方法能夠通過(guò)緊湊的隱式潛在嵌入聚合所有歷史信息。

隱式表示

隱式形狀表示就是用連續(xù)函數(shù)表示3D形狀。與傳統(tǒng)的顯式表示(例如,點(diǎn)云、網(wǎng)格、體積網(wǎng)格)相比,隱式表示可以在連續(xù)空間中描述形狀結(jié)構(gòu),并且更節(jié)省內(nèi)存。而不是手動(dòng)設(shè)計(jì)隱式函數(shù),最近的一些工作提出從數(shù)據(jù)中學(xué)習(xí)隱式函數(shù)。具體來(lái)說(shuō),他們使用神經(jīng)網(wǎng)絡(luò)來(lái)近似隱式函數(shù),這可以通過(guò)數(shù)據(jù)驅(qū)動(dòng)的方式進(jìn)行訓(xùn)練。這些神經(jīng)函數(shù)通常以連續(xù)的3D坐標(biāo)作為輸入,并在查詢位置輸出相關(guān)的形狀屬性(例如,顏色、密度、有符號(hào)距離等)。作者的隱式形狀解碼器與DeepSDF比較相似。然而,作者不是預(yù)測(cè)查詢位置的有符號(hào)距離,而是預(yù)測(cè)其占用概率。

以O(shè)bject為中心的占用數(shù)據(jù)集

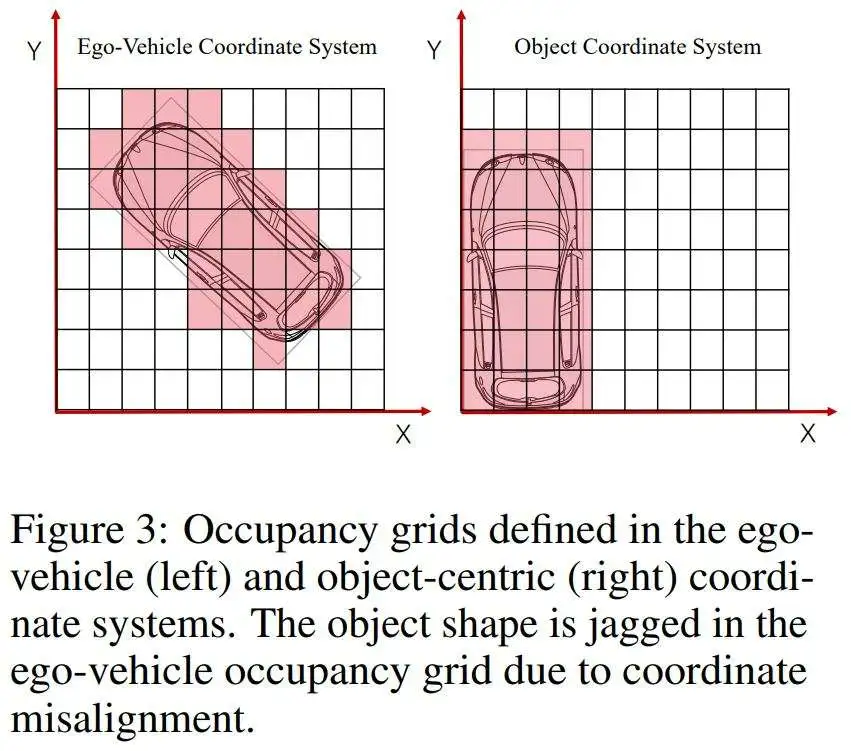

高質(zhì)量的數(shù)據(jù)集對(duì)于基于學(xué)習(xí)的方法至關(guān)重要。然而,現(xiàn)有的數(shù)據(jù)集由于坐標(biāo)系統(tǒng)不對(duì)齊和分辨率不足,無(wú)法滿足作者對(duì)對(duì)象中心占用感知的要求。所以作者根據(jù)現(xiàn)有的3D檢測(cè)數(shù)據(jù)集,用一套自己的pipiline,構(gòu)建對(duì)象中心占用注釋?zhuān)闪艘粋€(gè)數(shù)據(jù)集。坐標(biāo)系的定義見(jiàn)圖3,,詳細(xì)構(gòu)建過(guò)程可以參考原文。

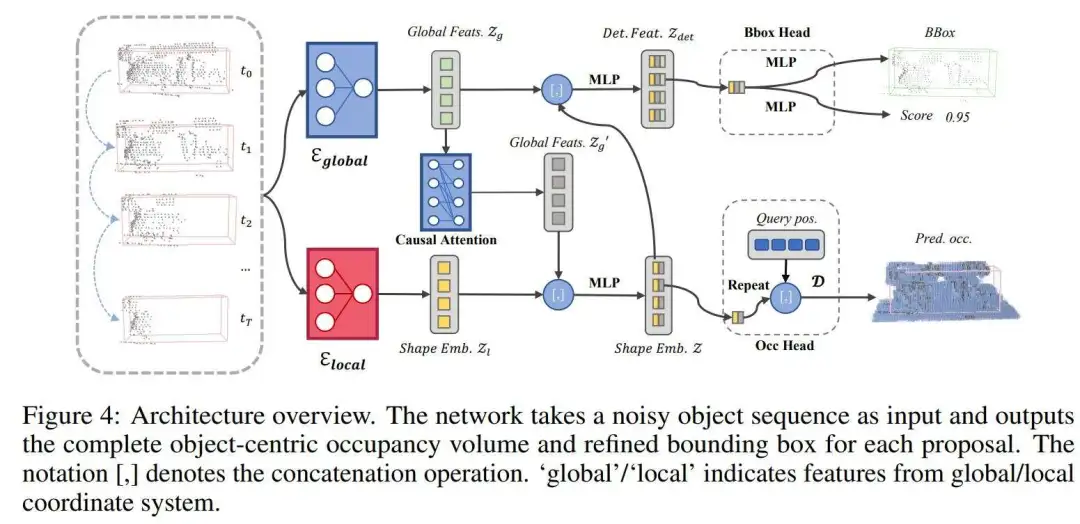

基于序列的占用補(bǔ)全網(wǎng)絡(luò)

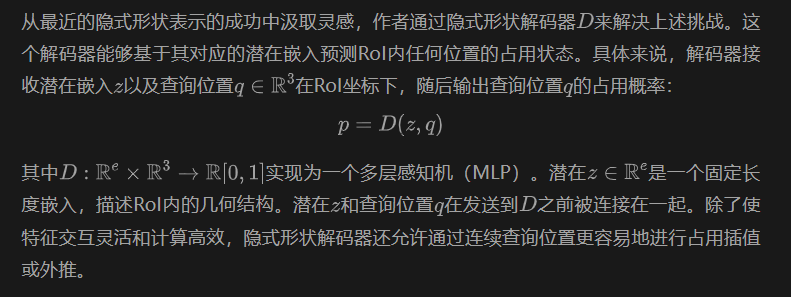

通過(guò)隱式解碼生成動(dòng)態(tài)尺寸占用空間

作者的網(wǎng)絡(luò)主要關(guān)注由對(duì)象提議定義的興趣區(qū)域(RoIs)。鑒于不同對(duì)象的大小不同,且同一對(duì)象的提議可能因檢測(cè)不準(zhǔn)確而異,從特征空間為每個(gè)動(dòng)態(tài)大小的提議高效解碼占用體積是一個(gè)重大挑戰(zhàn)。傳統(tǒng)的場(chǎng)景級(jí)占用感知方法通常應(yīng)用密集卷積層來(lái)解碼占用體積。然而,這種策略在動(dòng)態(tài)大小對(duì)象中心占用的背景下遇到了幾個(gè)限制。首先,由于作者需要跨時(shí)間戳的特征交互,不同提議的特征最好在同一大小。然而,從固定大小的特征圖解碼動(dòng)態(tài)大小的體積對(duì)卷積來(lái)說(shuō)并不簡(jiǎn)單。其次,密集卷積操作對(duì)于高占用分辨率來(lái)說(shuō)計(jì)算成本很高。另一種選擇是稀疏卷積,然而,它無(wú)法用正確的占用狀態(tài)填充未占用的體素。

雙分支 RoI 編碼

有了隱式形狀解碼器,下一步是獲得一個(gè)準(zhǔn)確表示RoI內(nèi)完整對(duì)象形狀的潛在嵌入。為了實(shí)現(xiàn)準(zhǔn)確的形狀補(bǔ)全和檢測(cè),兩個(gè)信息源至關(guān)重要:

- 每個(gè)RoI的部分幾何結(jié)構(gòu)

- 對(duì)象隨時(shí)間的運(yùn)動(dòng)信息。

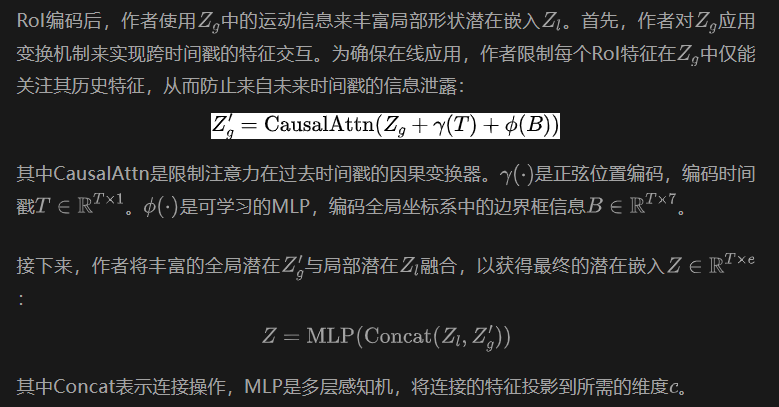

通過(guò)時(shí)間聚合增強(qiáng)特征

占用完成和檢測(cè)細(xì)化

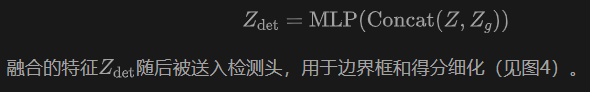

給定最終潛在嵌入Z,作者可以通過(guò)在不同位置查詢隱式形狀解碼器D來(lái)預(yù)測(cè)每個(gè)提議的完整對(duì)象中心占用體積。在訓(xùn)練期間,作者從每個(gè)標(biāo)注的占用中隨機(jī)采樣固定數(shù)量的查詢位置和相應(yīng)的占用狀態(tài)。為確保占用預(yù)測(cè)不受偏差影響,作者采用平衡采樣策略,其中從被占用體素中采樣512個(gè)點(diǎn),從空閑體素中采樣512個(gè)點(diǎn)。對(duì)于與真實(shí)邊界框(GT)匹配的RoI,作者使用RoI和邊界框之間的相對(duì)姿態(tài)將相應(yīng)的查詢集轉(zhuǎn)換到其坐標(biāo)系中。然后,這些位置查詢被發(fā)送到隱式解碼器D以計(jì)算占用損失。在推理期間,作者通過(guò)在RoI的所有體素中心查詢解碼器來(lái)為每個(gè)RoI生成密集的占用體積。由于Z現(xiàn)在編碼了完整對(duì)象形狀的信息,它為更好的檢測(cè)提供了更多的幾何信息。為了保留運(yùn)動(dòng)信息,作者還將Z與Zg全局RoI特征融合:

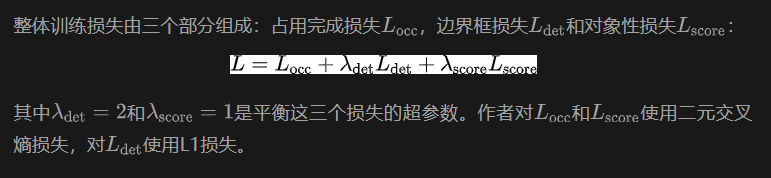

損失函數(shù)

實(shí)驗(yàn)及結(jié)果

實(shí)現(xiàn)細(xì)節(jié)

為了生成網(wǎng)絡(luò)的輸入,作者首先使用FSD 和CenterPoint 作為基礎(chǔ)檢測(cè)器來(lái)生成對(duì)象提議。然后作者利用ImmortalTracker 將檢測(cè)結(jié)果關(guān)聯(lián)成對(duì)象軌跡提議。作者使用生成的對(duì)象軌跡提議以及GT軌跡作為訓(xùn)練序列。為了便于并行訓(xùn)練,作者在訓(xùn)練期間通過(guò)填充或剪切將每個(gè)軌跡規(guī)范為固定長(zhǎng)度的32幀。為了加速收斂,作者在每個(gè)軌跡內(nèi)的所有時(shí)間戳計(jì)算損失,而不僅僅是最后一個(gè)。在推理期間,模型通過(guò)查看所有歷史框來(lái)輸出時(shí)間戳t的精煉框。

作者在Waymo Open Dataset (WOD)上進(jìn)行評(píng)估。使用官方訓(xùn)練集,包括798個(gè)序列進(jìn)行訓(xùn)練,以及202個(gè)序列進(jìn)行評(píng)估。

形狀補(bǔ)全結(jié)果

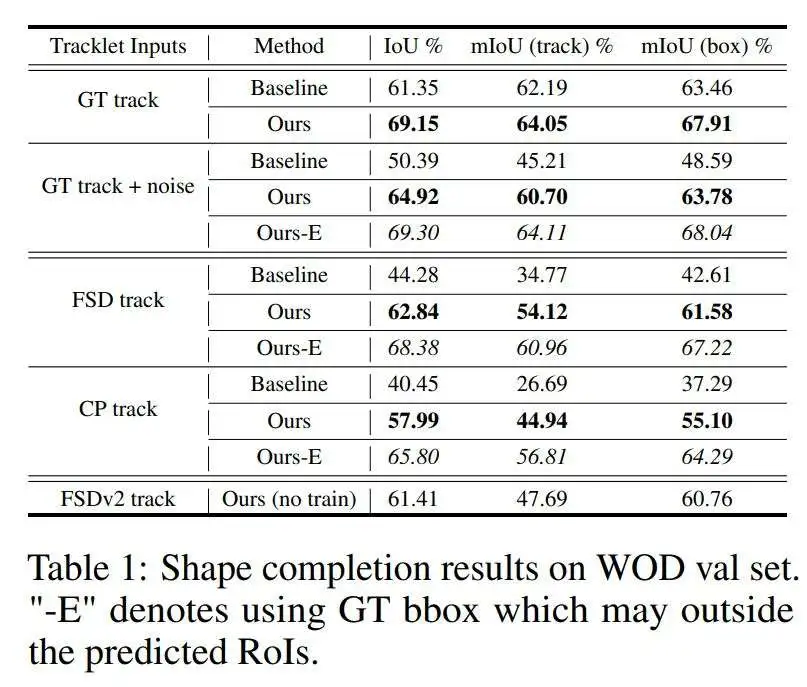

與基線對(duì)比 由于對(duì)象中心占用是一個(gè)新任務(wù),據(jù)作者所知,沒(méi)有現(xiàn)成的基于學(xué)習(xí)的方法可以用于比較。所以,作者將其方法與直接在噪聲軌跡提議中累積和體素化歷史點(diǎn)云的基線進(jìn)行比較。作者在三種類(lèi)型的軌跡輸入上評(píng)估形狀補(bǔ)全性能:真實(shí)軌跡(GT),由CenterPoint(CP)生成的軌跡,以及由FSD生成的軌跡。如表1所示,形狀補(bǔ)全性能與輸入軌跡的質(zhì)量密切相關(guān),更好的軌跡導(dǎo)致更好的形狀補(bǔ)全。在所有情況下,作者的方法都優(yōu)于基線,即使是在輸入軌跡是無(wú)噪聲GT的情況下。這是因?yàn)樵摲椒梢酝ㄟ^(guò)訓(xùn)練數(shù)據(jù)中學(xué)到的知識(shí)有效地完成對(duì)象形狀,即使在早期時(shí)間戳,而基線只有在更多視圖可見(jiàn)的后期時(shí)間戳才變得有效。

魯棒性 為了模擬不滿足檢測(cè)和跟蹤結(jié)果,作者對(duì)GT框提議添加了一些輕微的噪聲。從表1中作者可以發(fā)現(xiàn),基線性能顯著下降(>10% IoU),而作者的方法在這種情況下保持了穩(wěn)定的性能(<5% IoU),證明了其對(duì)這些噪聲和不準(zhǔn)確軌跡的強(qiáng)大魯棒性。

有真值bbox的結(jié)果 由于隱式形狀解碼器,作者的方法有潛力預(yù)測(cè)任何位置的占用狀態(tài)。為了證明這種能力,作者通過(guò)在GT框內(nèi)的所有體素中心查詢隱式解碼器來(lái)進(jìn)行實(shí)驗(yàn)。如表1所示,當(dāng)考慮RoI外的外推結(jié)果時(shí),形狀補(bǔ)全性能得到了進(jìn)一步提高(Ours-E),展示了作者隱式形狀表示的靈活性。

泛化能力 表1的最后一行展示了通過(guò)直接將作者訓(xùn)練好的模型應(yīng)用于FSDv2 生成的軌跡提議所獲得的占用補(bǔ)全結(jié)果。由于更好的檢測(cè),即使沒(méi)有重新訓(xùn)練,作者的方法與CenterPoint相比仍然表現(xiàn)更好。然而,與使用FSD軌跡相比,它的表現(xiàn)略差,盡管FSDv2的檢測(cè)結(jié)果比FSD好。這表明顯著的檢測(cè)改進(jìn)通常會(huì)導(dǎo)致更好的形狀補(bǔ)全(FSDv2與CenterPoint相比)。

目標(biāo)檢測(cè)結(jié)果

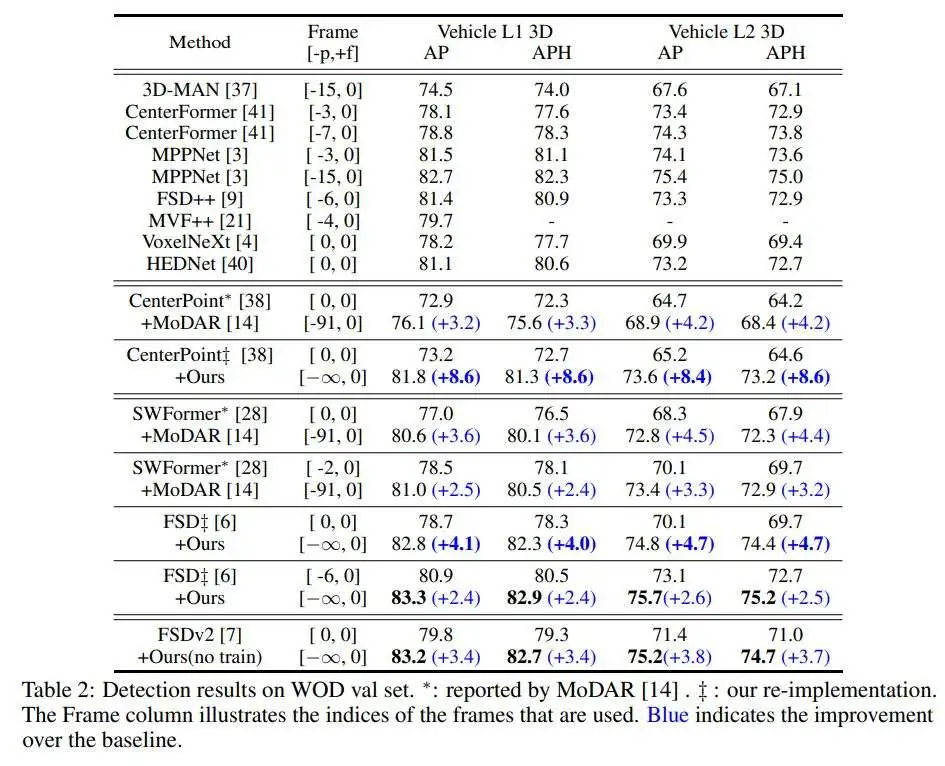

主要結(jié)果 表2展示了在WOD驗(yàn)證集上的3D檢測(cè)結(jié)果。當(dāng)作者的方法應(yīng)用于CenterPoint 和FSD 生成的軌跡提議時(shí),觀察到了顯著的改進(jìn)。與之前的最先進(jìn)方法MoDAR 相比,作者的方法在1幀CenterPoint上取得了更大的提升(例如,8.6%對(duì)3.2%的L1 AP改進(jìn))。將作者的方法應(yīng)用于更先進(jìn)的檢測(cè)器,1幀F(xiàn)SD ,仍然可以獲得顯著的改進(jìn)。這種增強(qiáng)與將MoDAR添加到類(lèi)似性能的檢測(cè)器(即,3幀SWFormer )相比更為顯著。此外,通過(guò)將作者的方法應(yīng)用于7幀F(xiàn)SD,作者實(shí)現(xiàn)了新的在線檢測(cè)最先進(jìn)結(jié)果,在L1和L2上分別達(dá)到了83.3% AP和75.7% APH。這表明作者的方法在對(duì)象檢測(cè)中有效地聚合了長(zhǎng)序列信息,除了形狀補(bǔ)全。此外,作者的方法可以無(wú)縫集成到其他最先進(jìn)的檢測(cè)器中,而無(wú)需在訓(xùn)練數(shù)據(jù)中重新訓(xùn)練它們各自的軌跡。

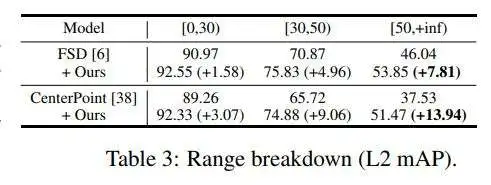

范圍細(xì)分 遠(yuǎn)距離對(duì)象由于稀疏性更難以檢測(cè)。作者進(jìn)一步分析了不同距離范圍的檢測(cè)性能。如表3所示,隨著距離的增加,作者對(duì)基線檢測(cè)器的改進(jìn)變得更加顯著。這表明作者的方法通過(guò)形狀補(bǔ)全有效地解決了遠(yuǎn)距離對(duì)象的稀疏性問(wèn)題。

模型分析

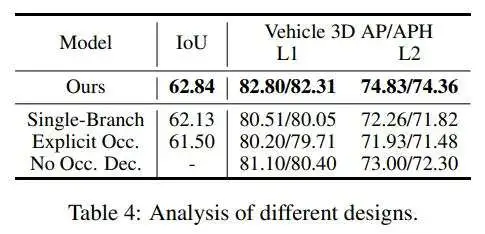

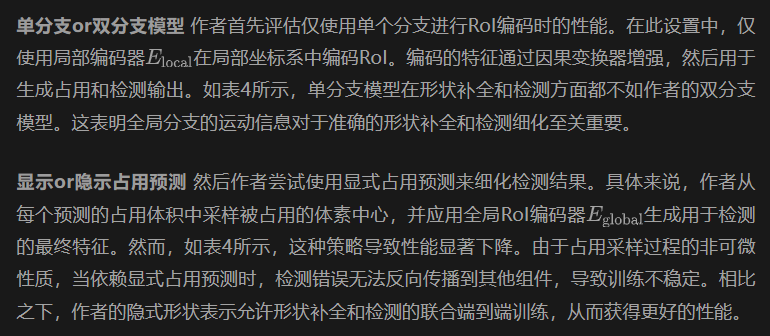

在這一部分,作者評(píng)估了作者方法中不同設(shè)計(jì)選擇的性能,并分析了它們對(duì)形狀補(bǔ)全和檢測(cè)性能的影響。

占用任務(wù)幫助檢測(cè)任務(wù) 最后,作者評(píng)估了占用任務(wù)對(duì)檢測(cè)性能的影響。作者從完整模型中移除了OCC頭,并僅使用檢測(cè)損失重新訓(xùn)練。如表4最后一行所示,缺少占用解碼器會(huì)導(dǎo)致檢測(cè)性能顯著下降。這表明占用補(bǔ)全任務(wù)不僅明確豐富了對(duì)象形狀表示,而且還通過(guò)為潛在空間提供額外的幾何信息來(lái)增強(qiáng)檢測(cè)。

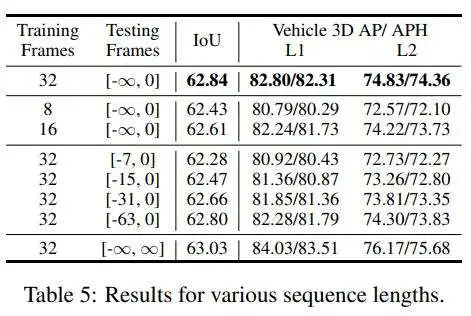

訓(xùn)練和測(cè)試的長(zhǎng)度 表5顯示了序列長(zhǎng)度對(duì)作者方法性能的影響。作者使用8幀和16幀軌跡重新訓(xùn)練作者的方法。如表5的前3行所示,使用更長(zhǎng)的序列進(jìn)行訓(xùn)練可以帶來(lái)更好的結(jié)果。然而,當(dāng)序列長(zhǎng)度翻倍時(shí),性能提升逐漸減少。為了在性能和計(jì)算成本之間取得平衡,作者將默認(rèn)訓(xùn)練長(zhǎng)度設(shè)置為32。

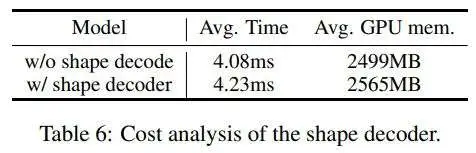

計(jì)算效率 表6顯示了所提出的形態(tài)解碼器的時(shí)間和GPU內(nèi)存成本。由于對(duì)象軌跡的長(zhǎng)度不同,作者方法的運(yùn)行時(shí)間也可能因不同的輸入而異。此外,解碼的對(duì)象中心占用的維度取決于檢測(cè)到的邊界框。為了公平測(cè)試運(yùn)行時(shí)間,作者將輸入長(zhǎng)度標(biāo)準(zhǔn)化為32,并將解碼查詢的數(shù)量設(shè)置為4096。如表6所示,形態(tài)解碼器僅引入了輕微的計(jì)算成本增加,展示了其效率。

總結(jié)和局限

局限

從技術(shù)角度講,作者的自動(dòng)占用注釋依賴(lài)于剛體假設(shè),這可能不適用于可變形物體。因此,作者的實(shí)驗(yàn)專(zhuān)注于車(chē)輛對(duì)象,因?yàn)樗鼈兪莿傂缘摹1M管作者的方法可以應(yīng)用于其他可變形對(duì)象類(lèi)別,但由于真實(shí)數(shù)據(jù)中的大量噪聲,對(duì)可變形物體的準(zhǔn)確評(píng)估無(wú)法得到保證。

總結(jié)

在這項(xiàng)工作中,作者引入了一個(gè)新任務(wù),以對(duì)象為中心的占用,它擴(kuò)展了傳統(tǒng)的對(duì)象邊界框表示,以提供對(duì)對(duì)象形狀的更詳細(xì)描述。與場(chǎng)景級(jí)對(duì)應(yīng)物相比,對(duì)象中心占用通過(guò)關(guān)注前景對(duì)象,在大場(chǎng)景中實(shí)現(xiàn)了更高的體素分辨率。為了促進(jìn)對(duì)象中心占用學(xué)習(xí),作者使用激光雷達(dá)數(shù)據(jù)和Waymo Open Dataset (WOD)中的框注釋構(gòu)建了一個(gè)對(duì)象中心占用數(shù)據(jù)集。進(jìn)一步提出了一個(gè)基于序列的占用補(bǔ)全網(wǎng)絡(luò),該網(wǎng)絡(luò)從作者的數(shù)據(jù)集中學(xué)習(xí),以從不準(zhǔn)確的對(duì)象提議中補(bǔ)全對(duì)象形狀。該方法在WOD上的形狀補(bǔ)全和對(duì)象檢測(cè)任務(wù)上都取得了最先進(jìn)的性能。