Adobe發布TurboEdit:可以通過文本來編輯圖像,編輯時間<0.5秒!

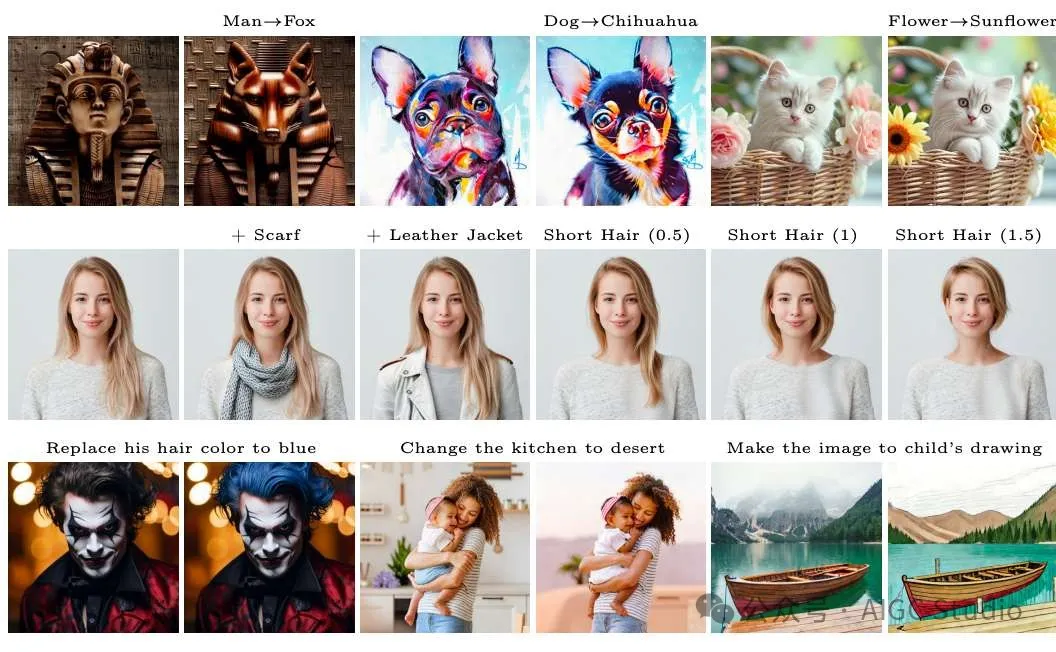

今天給大家介紹Adobe研究院新的研究TurboEdit,可以通過文本來編輯圖像,通過一句話就能改變圖像中的頭發顏色、衣服、帽子、圍巾等等。而且編輯飛快,<0.5秒。簡直是圖像編輯的利器。

相關鏈接

項目:betterze.github.io/TurboEdit

論文:arxiv.org/abs/2408.08332

論文閱讀

TurboEdit: 即時基于文本的圖像編輯

摘要

我們在幾步擴散模型的背景下解決了精確圖像反轉和分離圖像編輯的挑戰。

我們引入了一種基于編碼器的迭代反演技術。反演網絡以輸入圖像和上一步的重建圖像為條件,允許對輸入圖像進行下一次重建校正。我們證明,通過以(自動生成的)詳細文本提示為條件,可以在幾步擴散模型中輕松實現分離控制。

為了操縱反轉圖像,我們凍結噪聲圖并修改文本提示中的一個屬性(手動或通過 LLM 驅動的基于指令的編輯),從而生成與輸入圖像相似的新圖像,但只有一個屬性發生變化。它可以進一步控制編輯強度并接受指導性文本提示。

我們的方法促進了實時的真實文本引導圖像編輯,反轉中只需要 8 個功能評估 (NFE)(一次性成本),每次編輯只需要 4 個 NFE。我們的方法不僅速度快,而且明顯優于最先進的多步擴散編輯技術。

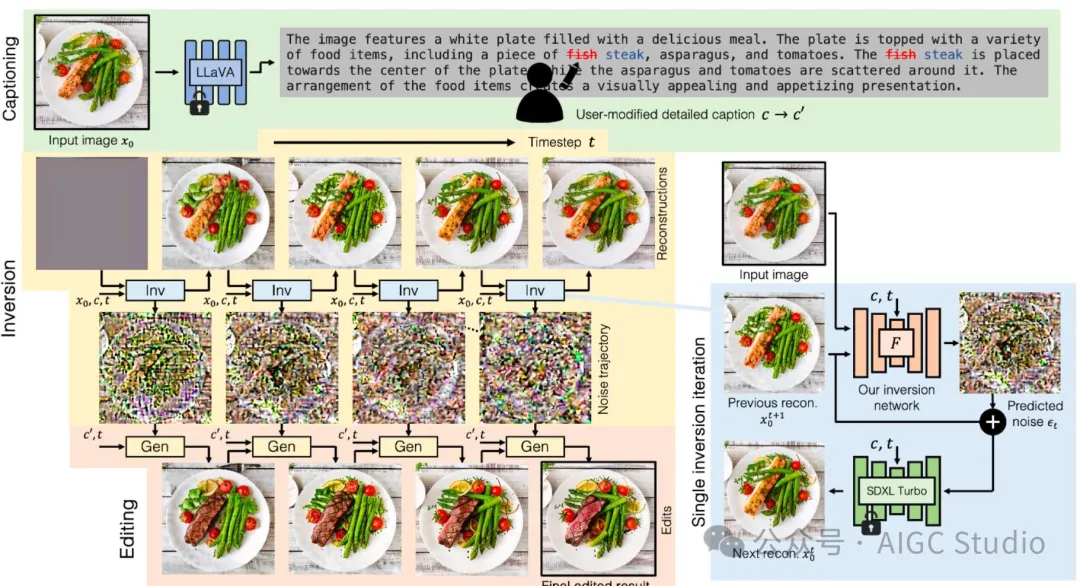

方法

給定一個輸入的真實圖像 x0,我們利用 LLaVA 生成詳細的標題 c。用戶可以修改 c 以創建新的文本提示 c ′。反演過程首先將 x0、c、當前時間步長 t 和之前重建的圖像 x0,t+1(初始化為零矩陣)輸入反演網絡。然后,該網絡預測噪聲 ?t,隨后將其輸入到凍結的 SDXL-Turbo 模型中以生成新的重建圖像 x0,t。給定最終的反演噪聲 ?t 以及 c,我們可以使用 SDXL-Turbo 創建反演軌跡并重建 x0,0,這與 x0 非常相似。使用相同的噪聲 ?t 和略有不同的文本提示 c ′,從 t = T 開始到更小的 t,編輯軌跡將與反演軌跡非常相似,生成的圖像將與輸入圖像非常相似,僅在 c' 中指定的屬性上有所不同。

實驗

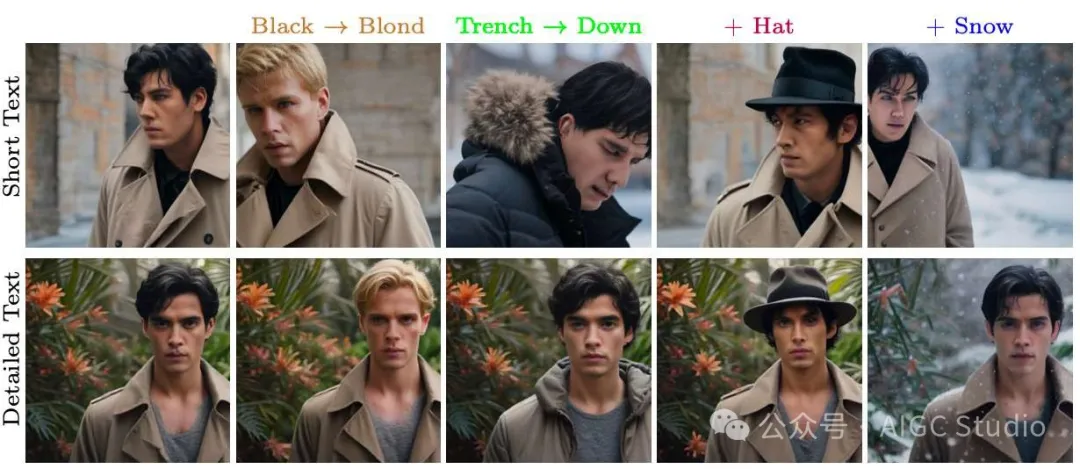

當呈現簡潔的源文本提示時,文本空間中的微小編輯可能導致圖像空間中的布局和結構發生重大變化。相反,在詳細的文本提示中進行小文本編輯往往會導致圖像空間中發生更簡單的變化。結果來自使用相同隨機種子的單步圖像生成。下面提供了標題和顏色編碼的修改區域。

當呈現簡潔的源文本提示時,文本空間中的微小編輯可能導致圖像空間中的布局和結構發生重大變化。相反,在詳細的文本提示中進行小文本編輯往往會導致圖像空間中發生更簡單的變化。結果來自使用相同隨機種子的單步圖像生成。下面提供了標題和顏色編碼的修改區域。

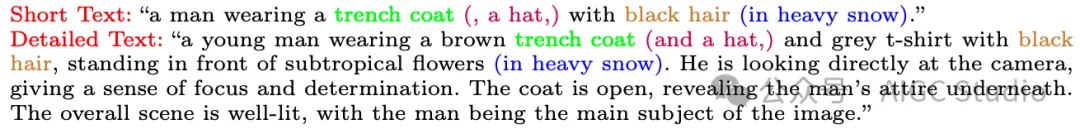

給定詳細的源文本和相應的目標文本,我們可以對文本嵌入進行插值,并在圖像空間中生成平滑的插值,即使對于較大的結構變化也是如此。

給定詳細的源文本和相應的目標文本,我們可以對文本嵌入進行插值,并在圖像空間中生成平滑的插值,即使對于較大的結構變化也是如此。

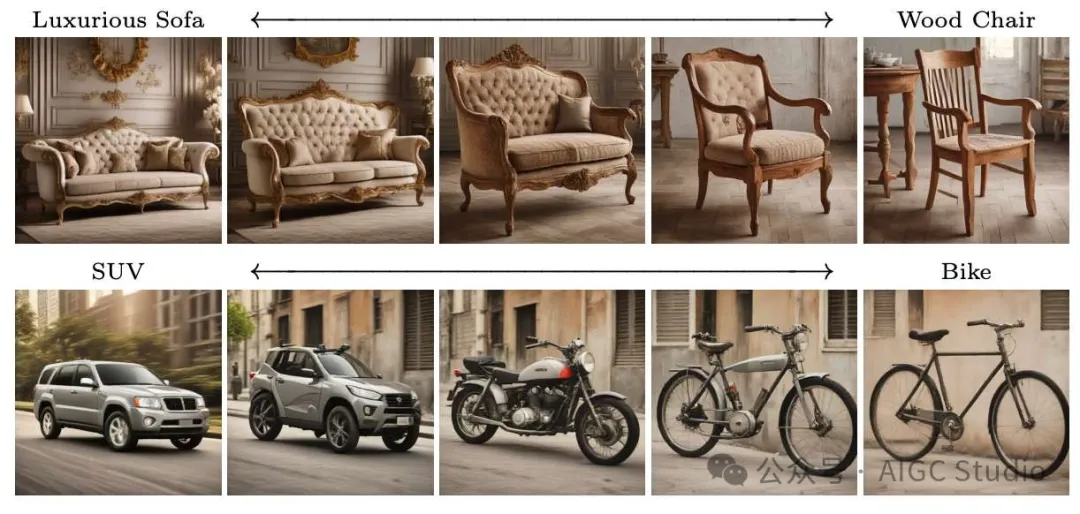

使用 PIE-Bench 數據集中的描述性文本進行圖像編輯比較。效率是在單個 H100 GPU 中測量的。我們的方法實現了最佳的背景保留和剪輯相似性,同時比其他方法快得多(4 步 DDIM 除外)。

使用 PIE-Bench 數據集中的描述性文本進行圖像編輯比較。效率是在單個 H100 GPU 中測量的。我們的方法實現了最佳的背景保留和剪輯相似性,同時比其他方法快得多(4 步 DDIM 除外)。

我們比較了使用描述性文本提示作為指導的方法。盡管我們的方法只需要四個步驟,但它的表現優于多步驟方法,特別是在需要對屬性進行重大結構變化的場景中,例如添加帽子或將男人變成女人。相比之下,InfEdit 和 Pix2PixZero 在背景和身份保存方面遇到了困難。同樣,Ledits 和 Ledits++ 無法有效處理大的結構變化,這一點從它們無法添加高頂禮帽或將男人變成女人就可以看出。

我們比較了使用描述性文本提示作為指導的方法。盡管我們的方法只需要四個步驟,但它的表現優于多步驟方法,特別是在需要對屬性進行重大結構變化的場景中,例如添加帽子或將男人變成女人。相比之下,InfEdit 和 Pix2PixZero 在背景和身份保存方面遇到了困難。同樣,Ledits 和 Ledits++ 無法有效處理大的結構變化,這一點從它們無法添加高頂禮帽或將男人變成女人就可以看出。

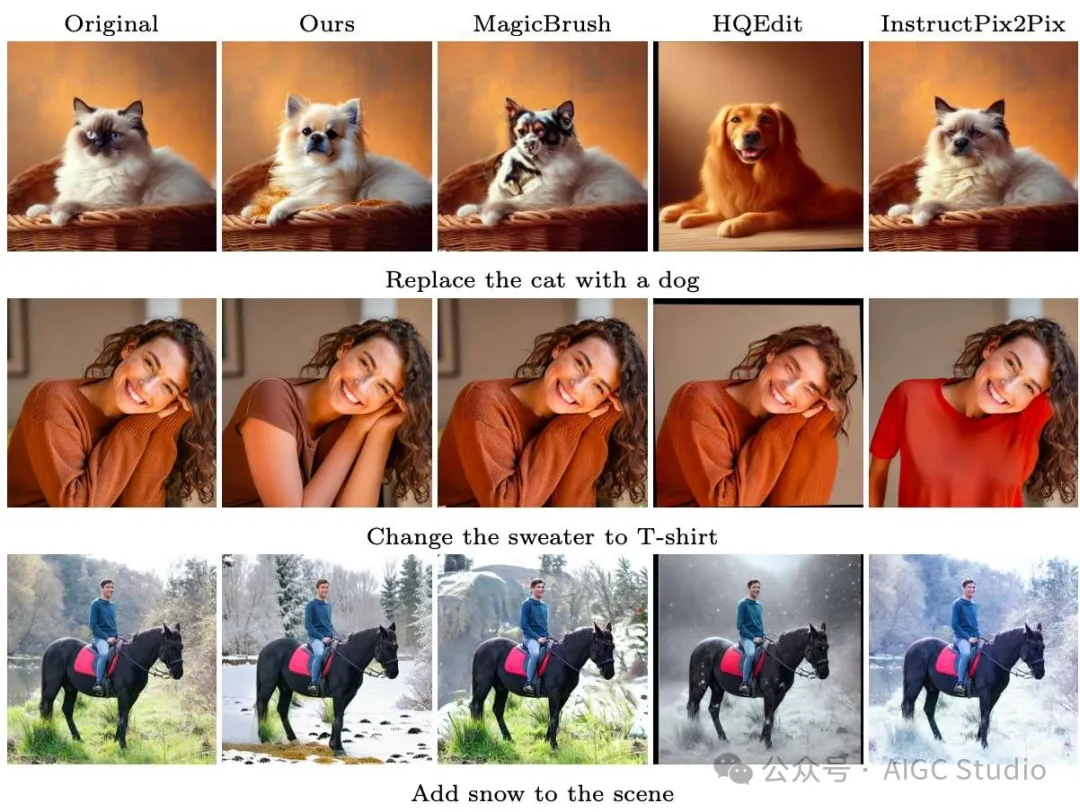

我們評估了利用指導性提示作為指導的方法。雖然我們的方法不需要任何意外訓練,只需要四個采樣步驟,但在身份保存(貓到狗)和文本提示對齊(毛衣到 T 恤)方面,它優于 InstructPix2Pix 及其變體。值得一提的是,InstructPix2pIx 及其變體需要收集大規模意外訓練集、計算密集型訓練和多步驟采樣。

我們評估了利用指導性提示作為指導的方法。雖然我們的方法不需要任何意外訓練,只需要四個采樣步驟,但在身份保存(貓到狗)和文本提示對齊(毛衣到 T 恤)方面,它優于 InstructPix2Pix 及其變體。值得一提的是,InstructPix2pIx 及其變體需要收集大規模意外訓練集、計算密集型訓練和多步驟采樣。

結論

據我們所知,我們的方法是第一個在幾步擴散模型的背景下探索圖像編輯的工作,也是第一個探索擴散模型中基于編碼器的反演的工作。我們證明,通過對(自動生成的)詳細文本提示進行條件處理,可以在幾步擴散模型中輕松實現解纏結控制。我們的方法使用戶能夠以交互速率進行逼真的文本引導圖像編輯,反演和編輯過程都在幾毫秒內完成。