北航 | 第一個多功能即插即用適配器MV-Adapter:輕松實現多視圖一致圖像生成

本文經AIGC Studio公眾號授權轉載,轉載請聯系出處。

北航提出了第一個多功能的即插即用適配器MV-Adapter。可以在不改變原有網絡結構或特征空間的情況下增強T2I模型及其衍生模型。MV-Adapter 在 SDXL 上實現了高達768分辨率的多視圖圖像生成,并展示了出色的適應性和多功能性。它還能擴展到任意視角生成,為更廣泛的應用打開了新大門。

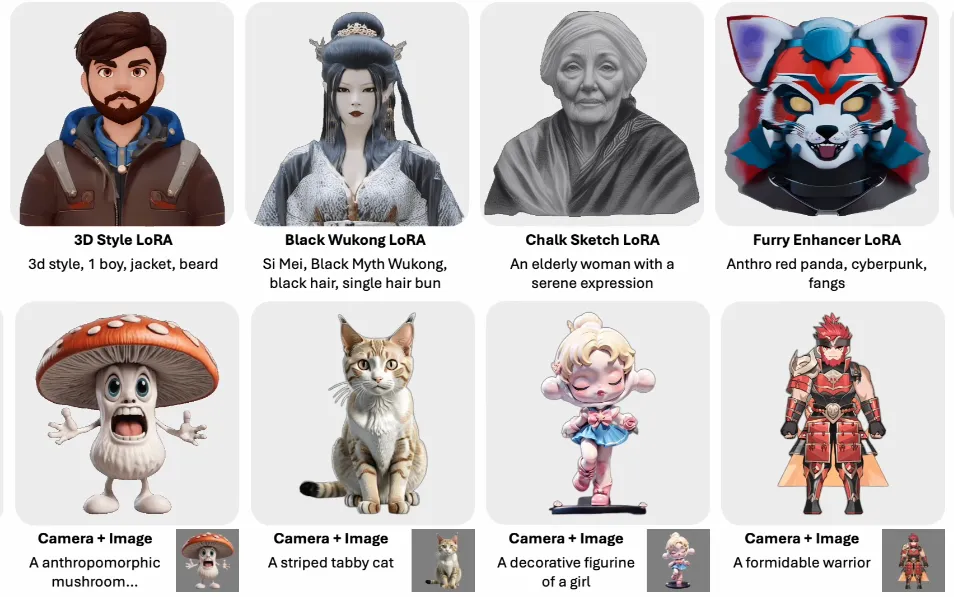

下圖展示的第1行顯示了將 MV-Adapter 與個性化T2I、精煉的少步T2I 和 ControlNet 集成的結果,展示了其適應性。第 2 行顯示了各種控制信號下的結果,包括使用文本或圖像輸入的視圖引導或幾何引導生成,展示了其多功能性。

相關鏈接

- 代碼:https://github.com/huanngzh/MV-Adapter

- 論文:https://arxiv.org/abs/2412.03632

- 主頁:https://huanngzh.github.io/MV-Adapter-Page/

- 試用:https://huggingface.co/spaces/VAST-AI/MV-Adapter-I2MV-SDXL

- ComfyUI:https://github.com/huanngzh/ComfyUI-MVAdapter

論文介紹

MV-Adapter:輕松實現多視圖一致圖像生成

MV-Adapter:輕松實現多視圖一致圖像生成

摘要

現有的多視圖圖像生成方法通常會對預訓練的文本轉圖像 (T2I) 模型進行侵入性修改并需要完全微調,會導致以下問題:

- 計算成本高,尤其是對于大型基礎模型和高分辨率圖像。

- 由于優化困難和高質量 3D 數據稀缺而導致圖像質量下降。

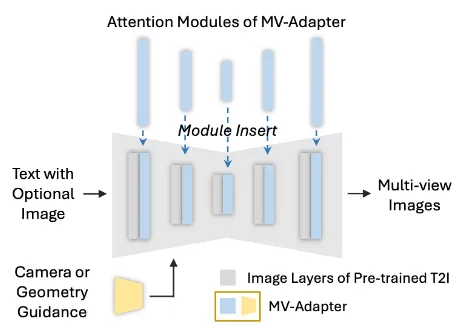

論文提出了第一個基于適配器的多視圖圖像生成解決方案,并介紹了 MV-Adapter,這是一種多功能的即插即用適配器,可在不改變原始網絡結構或特征空間的情況下增強 T2I 模型及其衍生產品。通過更新更少的參數,MV-Adapter 可以實現高效訓練并保留預訓練模型中嵌入的先驗知識,從而降低過度擬合風險。

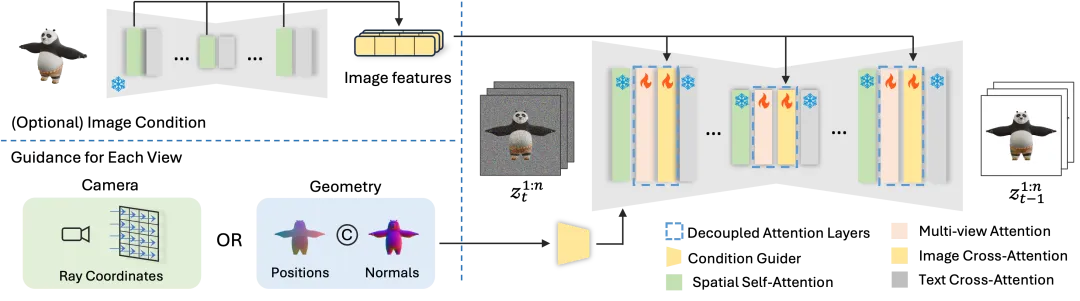

為了在適配器中有效地對 3D 幾何知識進行建模,論文引入了創新設計,包括重復的自注意力層和并行注意力架構,使適配器能夠繼承預訓練模型的強大先驗來對新穎的 3D 知識進行建模。此外還提出了一個統一的條件編碼器,無縫集成了相機參數和幾何信息,促進了基于文本和圖像的 3D 生成和紋理化等應用。

MV-Adapter 在穩定擴散 XL (SDXL) 上實現了 768 分辨率的多視圖生成,并展示了適應性和多功能性。它還可以擴展到任意視圖生成,從而實現更廣泛的應用。MV-Adapter 為多視圖圖像生成設定了新的質量標準,并因其效率、適應性和多功能性開辟了新的可能性。

方法介紹

MV-Adapter 是一個即插即用的適配器,它學習多視圖先驗,無需特殊調整即可轉移到 T2I 模型的衍生物,并使 T2I 能夠 在各種條件下生成多視圖一致的圖像。在推理時,MV-Adapter 包含條件引導器(黃色)和解耦的注意層(藍色),可以直接插入個性化或蒸餾的 T2I 中以構成多視圖生成器。

MV-Adapter 是一個即插即用的適配器,它學習多視圖先驗,無需特殊調整即可轉移到 T2I 模型的衍生物,并使 T2I 能夠 在各種條件下生成多視圖一致的圖像。在推理時,MV-Adapter 包含條件引導器(黃色)和解耦的注意層(藍色),可以直接插入個性化或蒸餾的 T2I 中以構成多視圖生成器。

MV-Adapter 由兩部分組成:

MV-Adapter 由兩部分組成:

- 對相機條件或幾何條件進行編碼的條件引導器;

- 包含多視圖注意層的解耦注意層,用于學習多視圖一致性,以及可選的圖像交叉注意層以支持圖像條件生成

其中使用預先訓練的 U-Net 對參考圖像進行編碼以提取細粒度信息。

結果展示

文本到多視圖

圖像到多視圖

草圖到多視圖 (使用 ControlNet)

文本條件3D生成

圖像條件3D生成

文本條件紋理生成

圖像條件紋理生成

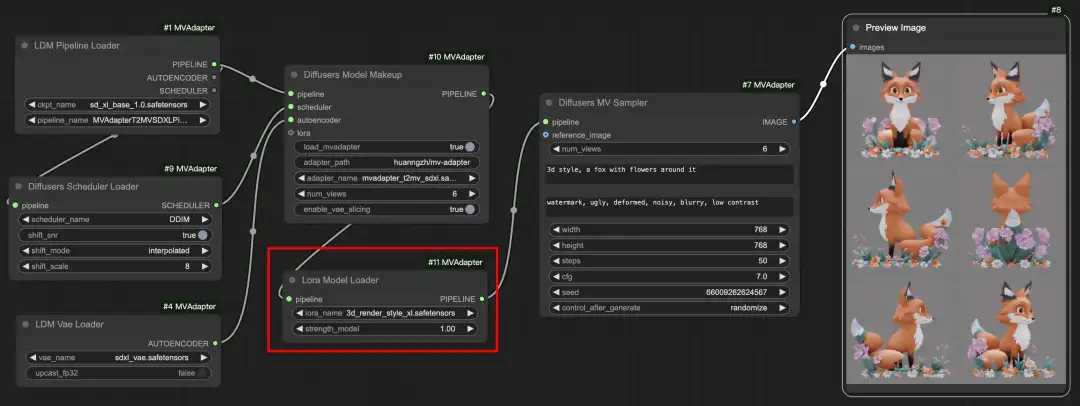

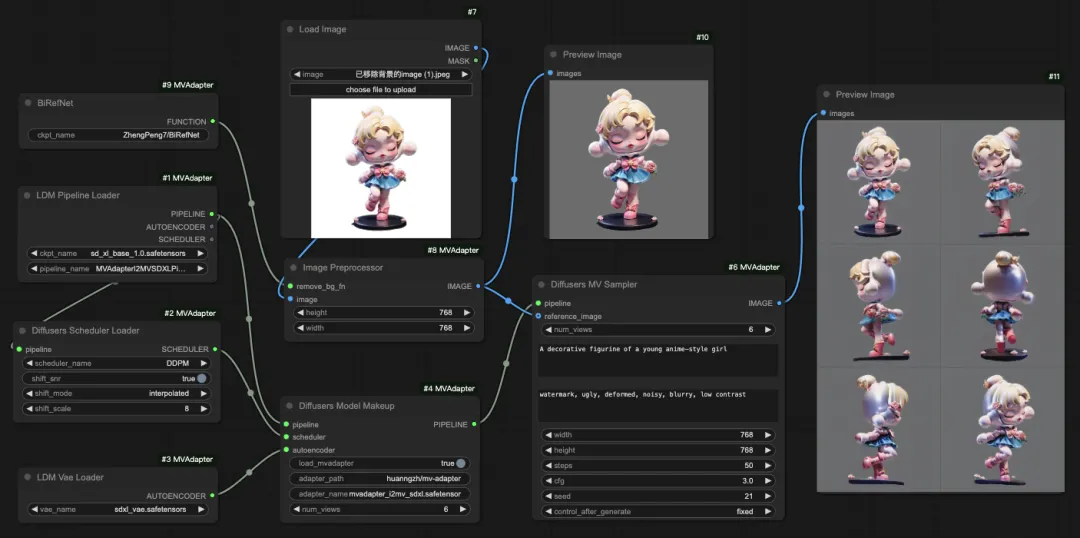

ComfyUI試用

將MV-Adapter集成到 ComfyUI 中,允許用戶直接在 ComfyUI 界面內從文本提示或單個圖像生成多視圖一致的圖像。 具體可以參考上面的鏈接。

- 支持與 SDXL LoRA 集成

- 根據文本提示或單幅圖像生成多視角一致圖像