生成越長(zhǎng)越跑偏?浙大商湯新作StarGen讓場(chǎng)景視頻生成告別「短片魔咒」

本文介紹了一篇由浙江大學(xué)章國(guó)鋒教授和商湯科技研究團(tuán)隊(duì)聯(lián)合撰寫(xiě)的論文《StarGen: A Spatiotemporal Autoregression Framework with Video Diffusion Model for Scalable and Controllable Scene Generation》。

針對(duì)復(fù)雜場(chǎng)景的長(zhǎng)距離場(chǎng)景生成的時(shí)空一致性問(wèn)題,該研究團(tuán)隊(duì)創(chuàng)新提出了一種解決方案 StarGen,其核心創(chuàng)新在于通過(guò)引入空間與時(shí)間雙重條件機(jī)制,將稀疏視圖的 3D 幾何信息與視頻擴(kuò)散模型有機(jī)結(jié)合,緩解誤差累積。

StarGen 實(shí)現(xiàn)了多視一致的長(zhǎng)視頻生成,并且能夠支持稀疏視圖插值、圖生視頻以及布局驅(qū)動(dòng)場(chǎng)景生成等多樣化任務(wù)。實(shí)驗(yàn)結(jié)果表明,StarGen 在生成質(zhì)量、一致性保持和場(chǎng)景擴(kuò)展能力等方面均顯著優(yōu)于現(xiàn)有方法。

- 論文標(biāo)題:StarGen: A Spatiotemporal Autoregression Framework with Video Diffusion Model for Scalable and Controllable Scene Generation

- 論文地址:https://arxiv.org/pdf/2501.05763

- 項(xiàng)目主頁(yè):https://zju3dv.github.io/StarGen/

背景

近年來(lái),隨著大規(guī)模模型的快速發(fā)展,3D 重建與生成技術(shù)取得了顯著進(jìn)展,并逐漸呈現(xiàn)出互補(bǔ)融合的趨勢(shì)。在重建領(lǐng)域,基于大規(guī)模重建模型的方法顯著降低了對(duì)密集多視角數(shù)據(jù)采集的依賴,同時(shí)生成模型被有效應(yīng)用于稀疏輸入視角下不可見(jiàn)區(qū)域的補(bǔ)全任務(wù)。

在生成領(lǐng)域,3D 重建技術(shù)為 2D 生成模型向 3D 生成任務(wù)的遷移提供了重要支撐,具體表現(xiàn)為兩種技術(shù)路徑:其一是通過(guò)將 2D 概率分布蒸餾為 3D 表示,其二是基于 2D 生成圖像重建 3D 表示。

然而,這些大規(guī)模重建與生成模型面臨一個(gè)關(guān)鍵性挑戰(zhàn):在有限計(jì)算資源約束下,單次推理過(guò)程僅能處理有限數(shù)量的 Token。

盡管現(xiàn)有一些研究提出了時(shí)間自回歸方法,通過(guò)將當(dāng)前視頻片段的初始幀與前一生成片段的末尾幀進(jìn)行條件關(guān)聯(lián)以實(shí)現(xiàn)長(zhǎng)視頻生成,但這類(lèi)方法僅能在較短時(shí)間跨度內(nèi)維持時(shí)序一致性。隨著生成過(guò)程的推進(jìn),誤差累積問(wèn)題將導(dǎo)致空間一致性難以有效保持。

相關(guān)工作

目前與本文工作相關(guān)的新視角生成方法主要分為三類(lèi):重建模型和生成模型,以及結(jié)合重建與生成的混合方法。

重建模型

重建模型主要通過(guò)從多視角輸入中重建場(chǎng)景的幾何結(jié)構(gòu)和外觀信息來(lái)實(shí)現(xiàn)新視角生成。傳統(tǒng)幾何重建方法,如 NeRF 和 3D-GS,通過(guò)隱式或顯式表示對(duì)場(chǎng)景進(jìn)行建模,在生成高質(zhì)量新視角方面表現(xiàn)優(yōu)異,但其對(duì)密集視角輸入的依賴限制了其適用性。

基于前饋網(wǎng)絡(luò)的重建方法,如 PixelNeRF 和 PixelSplat,通過(guò)從稀疏視圖直接推斷 3D 表示,降低了對(duì)密集輸入的需求,顯著提升了重建效率。

然而,這類(lèi)方法本質(zhì)上仍局限于重建任務(wù),缺乏生成能力,仍然需要輸入圖像覆蓋充分才能獲得完整的場(chǎng)景表達(dá)。

生成模型

生成模型通過(guò)學(xué)習(xí)輸入數(shù)據(jù)的分布來(lái)生成圖像或視頻,主要包括生成對(duì)抗網(wǎng)絡(luò)(GAN)和擴(kuò)散模型的兩類(lèi)方法。

GAN 在早期取得了一定成功,但在跨幀或跨片段的全局一致性方面表現(xiàn)不足。擴(kuò)散模型通過(guò)逆向擴(kuò)散過(guò)程生成高質(zhì)量圖像,并結(jié)合控制條件(如 ControlNet)實(shí)現(xiàn)對(duì)生成內(nèi)容的精確約束。

盡管擴(kuò)散模型在視頻生成任務(wù)中表現(xiàn)出色,通過(guò)全注意力機(jī)制(Full-Attention)能夠?qū)崿F(xiàn)單段視頻內(nèi)的多視圖一致性,但由于計(jì)算資源的限制,現(xiàn)有方法難以實(shí)現(xiàn)長(zhǎng)距離、高質(zhì)量且多視一致的視頻生成。

結(jié)合重建與生成的混合方法

近年來(lái),重建與生成方法的結(jié)合逐漸受到關(guān)注,通過(guò)互補(bǔ)方式提升生成質(zhì)量和一致性。代表性方法如 ViewCrafter,利用 Dust3r 從稀疏視圖中生成點(diǎn)云,并將所有點(diǎn)云投影到當(dāng)前片段作為空間約束,從而實(shí)現(xiàn)多段生成視頻的幾何一致性。

然而,這種以點(diǎn)云作為空間約束的方法會(huì)隨著生成視頻的增長(zhǎng)而累積點(diǎn)云重建誤差,最終導(dǎo)致生成內(nèi)容出現(xiàn)顯著偏差。此外,該方法需要訓(xùn)練視頻生成模型本身,限制了其擴(kuò)展性和通用性。

方法

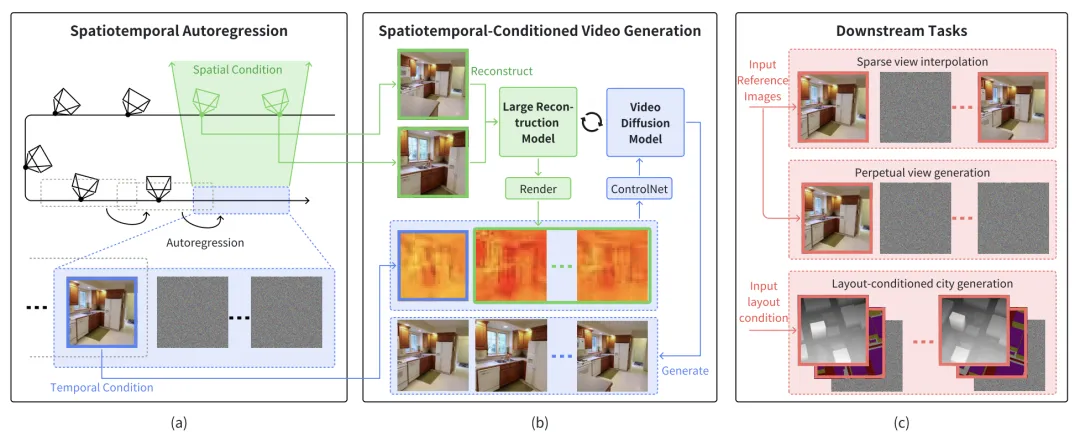

圖 1. 系統(tǒng)框架

系統(tǒng)概述

如圖 1 所示,StarGen 框架主要包括三部分:時(shí)空自回歸框架、時(shí)空條件視頻生成和下游任務(wù)實(shí)現(xiàn)。

時(shí)空自回歸框架

StarGen 通過(guò)滑動(dòng)窗口的方式逐步實(shí)現(xiàn)長(zhǎng)距離場(chǎng)景生成,每個(gè)窗口的生成既依賴于上一窗口的時(shí)間條件圖像,也依賴于與當(dāng)前窗口具有共視關(guān)系的空間相鄰圖像。

具體而言,StarGen 從前一窗口生成的關(guān)鍵幀中選擇圖像作為時(shí)間條件,來(lái)保證當(dāng)前生成結(jié)果和上一段視頻在時(shí)間上的連續(xù)性。

同時(shí),從歷史窗口中提取與當(dāng)前窗口具有最大共視區(qū)域的圖像集合作為空間條件,保證長(zhǎng)距離生成過(guò)程中各個(gè)視頻間的多視一致。

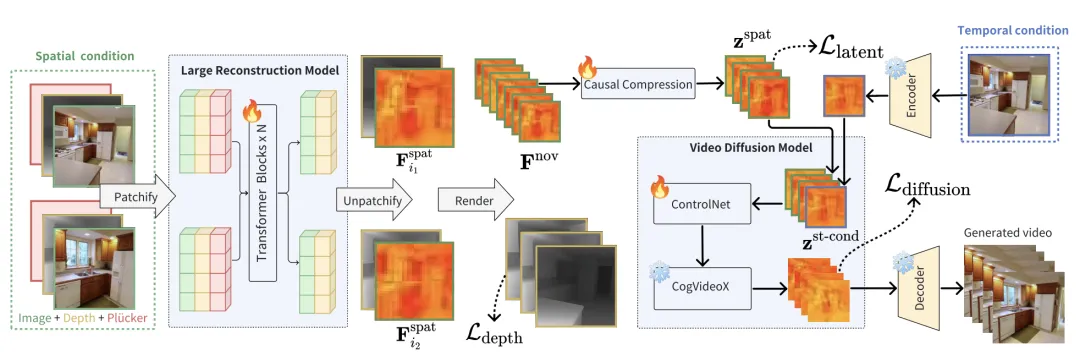

圖 2. 時(shí)空條件視頻生成

時(shí)空條件視頻生成

StarGen 通過(guò)引入大型重建模型(LRM)和視頻擴(kuò)散模型(VDM)實(shí)現(xiàn)高質(zhì)量可控視頻生成。具體流程如圖 2 所示:

1. 空間條件處理:從空間條件圖像中提取 3D 幾何信息,并通過(guò)基于多視幾何的渲染方法生成目標(biāo)視角的特征圖。這些特征圖隨后被壓縮到 VDM 的潛在空間中。

2. 時(shí)間條件處理:將時(shí)間條件圖像通過(guò)變分自編碼器(VAE)編碼為隱特征,并與空間條件特征融合,生成結(jié)合時(shí)空信息的綜合特征。

3. 視頻擴(kuò)散生成:將融合后的時(shí)空特征輸入視頻擴(kuò)散模型,通過(guò) ControlNet 進(jìn)行條件控制生成,生成當(dāng)前窗口的高質(zhì)量圖像序列。

下游任務(wù)實(shí)現(xiàn)

StarGen 框架支持多種場(chǎng)景生成任務(wù):

- 稀疏視圖插值:通過(guò)結(jié)合時(shí)空條件,生成輸入圖像之間的中間幀,同時(shí)支持精確的姿態(tài)控制;

- 圖生視頻:以單張輸入圖像為起點(diǎn),逐幀生成實(shí)現(xiàn)長(zhǎng)距離視角變化;

- 基于布局的城市生成:結(jié)合深度圖和語(yǔ)義圖,通過(guò) ControlNet 對(duì)布局信息進(jìn)行精準(zhǔn)約束,生成具有大規(guī)模場(chǎng)景一致性的城市場(chǎng)景。

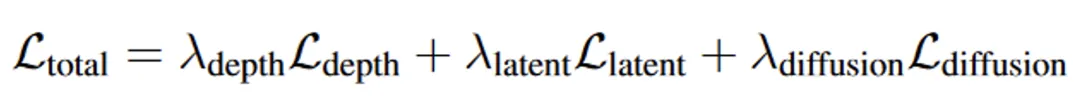

損失函數(shù)設(shè)計(jì)

為了確保生成內(nèi)容的一致性和質(zhì)量,StarGen 框架設(shè)計(jì)了三種損失函數(shù):

圖 3. 損失函數(shù)

1. 深度損失:通過(guò)多視角約束優(yōu)化重建深度圖的精度,從而提升空間條件的幾何一致性。

2. 潛在損失:監(jiān)督空間條件生成的潛在特征與真實(shí)視圖特征之間的差異,確保特征空間的一致性。

3. 擴(kuò)散損失:優(yōu)化擴(kuò)散模型生成的潛在特征與噪聲潛在變量之間的差異,增強(qiáng)生成序列的質(zhì)量。

結(jié)果

稀疏視圖插值

在 RealEstate-10K 和 ACID 數(shù)據(jù)集上,StarGen 在 PSNR 指標(biāo)上優(yōu)于其他基于重建和生成的方法,同時(shí)在其他指標(biāo)上達(dá)到了當(dāng)前最先進(jìn)的水平:

表 1. 稀疏視角插值的定量對(duì)比

特別是在輸入視圖幾乎無(wú)重疊的情況下,仍能生成合理的中間內(nèi)容:

圖 4. 稀疏視角插值的定性對(duì)比

圖生視頻

1. 短視頻生成:在測(cè)試集上生成 25 幀視頻,StarGen 在所有指標(biāo)(PSNR、SSIM、LPIPS)上表現(xiàn)最好。

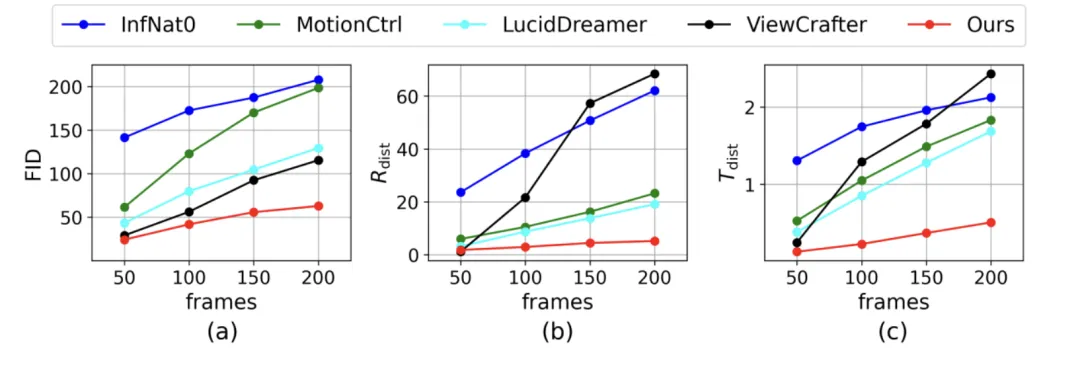

2. 長(zhǎng)視頻生成:與其他方法相比,StarGen 生成的長(zhǎng)視頻在視覺(jué)保真度和姿態(tài)精度上退化更少。

表 2. 圖生短視頻的定量對(duì)比

圖 5. 圖生長(zhǎng)視頻的定量對(duì)比

圖 6. 圖生長(zhǎng)視頻的定性對(duì)比

基于布局的城市生成

實(shí)驗(yàn)基于 OpenStreetMap 布局?jǐn)?shù)據(jù)生成城市場(chǎng)景,與 CityDreamer 方法相比,StarGen 生成的內(nèi)容在布局一致性和細(xì)節(jié)保真度上更優(yōu):

圖 7. 基于布局的城市生成定性對(duì)比

消融實(shí)驗(yàn)

通過(guò)逐步移除空間或時(shí)間條件等模塊進(jìn)行消融實(shí)驗(yàn),結(jié)果表明這兩種條件的結(jié)合對(duì)生成質(zhì)量和一致性有顯著貢獻(xiàn):

表 3. 消融實(shí)驗(yàn)