大模型量化訓練極限在哪?騰訊混元提出低比特浮點數訓練Scaling Laws

大模型低精度訓練和推理是大模型領域中的重要研究方向,旨在通過降低模型精度來減少計算和存儲成本,同時保持模型的性能。因為在大模型研發成本降低上的巨大價值而受到行業廣泛關注 。近期,業界對低精度訓練和推理的廣泛關注與討論。在實際的研發過程中,特別是模型訓練方面,經驗表明浮點數量化方案相比整數量化方案對模型效果造成的損失更小,所以浮點數常常被用作量化訓練的類型。這就引出了一些問題:整數類型量化訓練的經驗能否直接應用到浮點數類型的量化訓練任務中?如果不能,浮點數類型又會有怎樣的結論?量化訓練到底有沒有極限?

大模型社區亟需一個更加適合實際浮點數量化訓練的 Scaling Laws,指導大模型量化的實際選擇和未來探索方向。為了回答這些問題,騰訊混元團隊進行了 366 組不同參數規模和精度的浮點數量化訓練,對浮點數量化訓練進行詳細分析后提出了浮點數量化的 Scaling Laws。

- 論文標題:《Scaling Laws for Floating–Point Quantization Training》

- 論文鏈接:https://huggingface.co/papers/2501.02423

引言

大模型(Large Language Model, LLM)如今已經融入到我們生產生活的各個層面。大模型的參數規模不斷增大,調用量也持續升高,這使得大模型的訓練和推理成本成為 LLM 社區極為關注的重要問題。低比特量化技術能夠在一定程度上降低大模型訓練和推理的成本。鑒于此,這一技術在主流大模型的訓練和推理過程中得到了廣泛應用。前沿研究工作對 8 比特、4 比特甚至更低比特的量化策略進行了嘗試,并對這些策略予以驗證。

近期,論文《Scaling Laws for Precision》深入探討了整數類型量化策略下的精度對模型 loss 的影響,不過僅在附錄中簡略提及了浮點數類型量化策略的表現,并未深入探究。然而,在實際的生產過程中,特別是模型訓練方面,經驗表明浮點數量化(floating–point quantization)方案相比整數量化方案對模型效果造成的損失更小,所以浮點數更常被用于超低精度量化訓練。

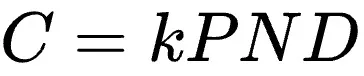

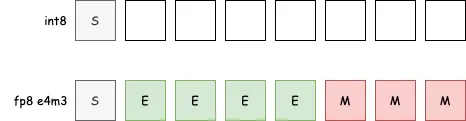

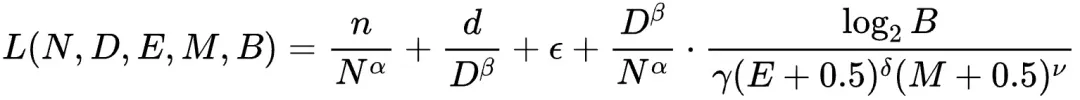

騰訊混元團隊的新工作《Scaling Laws for Floating–Point Quantization Training》系統全面地研究了浮點數量化訓練的 Scaling Laws,填補了這一領域的空白。具體地,他們在大模型 Scaling Law 的經典要素:模型大小(簡稱 N)和訓練數據量(簡稱 D)之外,聯合考慮浮點數量化訓練中重要的量化目標,指數位(Exponent,簡稱 E),尾數位(Mantissa,簡稱 M),以及量化時放縮因子共享粒度(Block-size,簡稱 B)對于大模型訓練損失的影響。他們進行了 366 組不同參數規模和精度設置的浮點數量化訓練,得出最終的浮點數量化的統一 Scaling Law 形式如下:

并且依據這一 Scaling Law 深入分析與推導之后,能夠得出如下一些重要結論:

- 在任意低精度大模型浮點數量化訓練中,都存在一個模型極限效果及對應的最佳數據量。超過此最佳數據量時繼續增加數據,反而會對模型效果產生負面影響;

- 限定計算資源下,在一個非常大的算力范圍內,理論預測的最佳性價比的浮點數量化訓練精度落在 4-8 比特之間;

- 在實際工作中,借助我們的 Scaling Laws 及其推論,同時結合計算資源

,可以明確得出不同計算資源下具有最佳性價比的浮點數量化訓練精度設置、模型參數量以及訓練數據量的配置策略。

,可以明確得出不同計算資源下具有最佳性價比的浮點數量化訓練精度設置、模型參數量以及訓練數據量的配置策略。

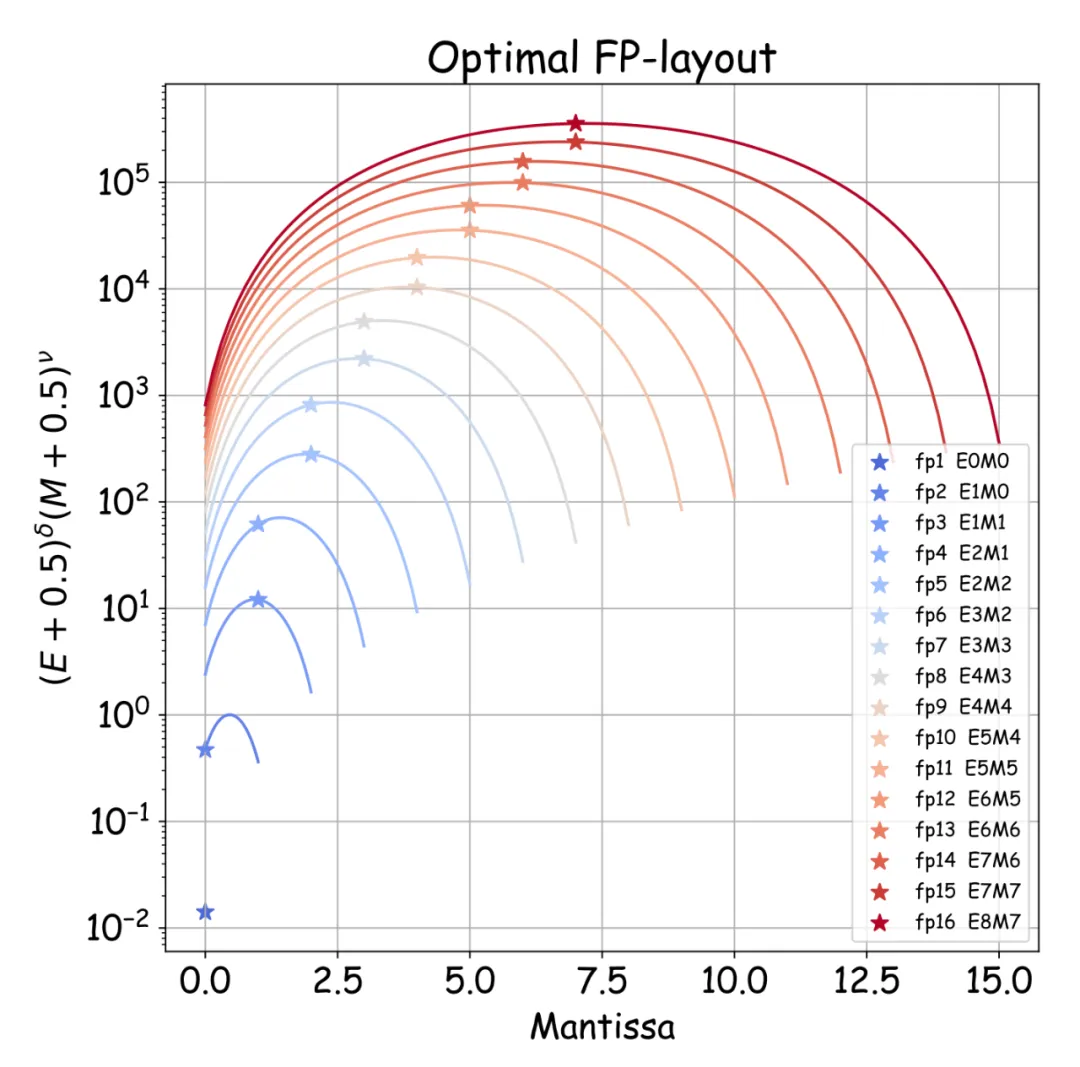

最佳的浮點數

與整數類型只有符號位(Signal,簡稱 S)和整數位相比,參考 IEEE 754 標準,浮點數顯得復雜許多。它由符號位、指數位(Exponent,簡稱 E)和尾數位(Mantissa,簡稱 M)共同作用決定最終取值。

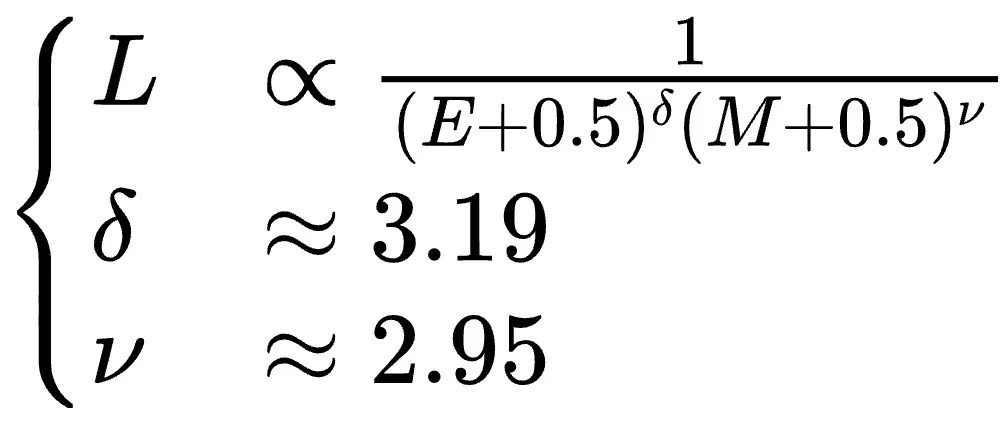

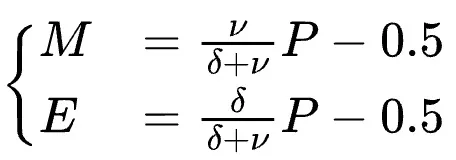

通過大量實驗與理論分析,騰訊混元團隊推導出了指數位和尾數位對最終模型效果之間的定量關系:

同時還得出給定精度(Precision,簡稱 P)P=1+E+M 情況下,指數位與尾數位的最佳配比規律需滿足:

未來硬件制造商也可以參考此結論,提供在不同精度下的浮點運算能力支持:

精細量化

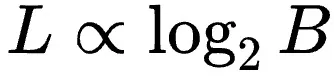

量化過程中,為了減少精度損失會對需量化 Tensor 進行放縮(Scaling)。同時,為節省放縮因子(Scaling Factor)的存儲空間,通常會讓 Tensor 中的若干元素共享一個放縮因子。顯然,放縮因子共享粒度越大,其存儲空間越小,但由此帶來的量化損失也會越大。混元團隊定量地研究了放縮因子共享粒度(Block-size,簡稱 B)對模型效果的影響,發現訓練時的驗證損失(Validate Loss)與 B 的對數成正比例關系: 。

。

Scaling Law

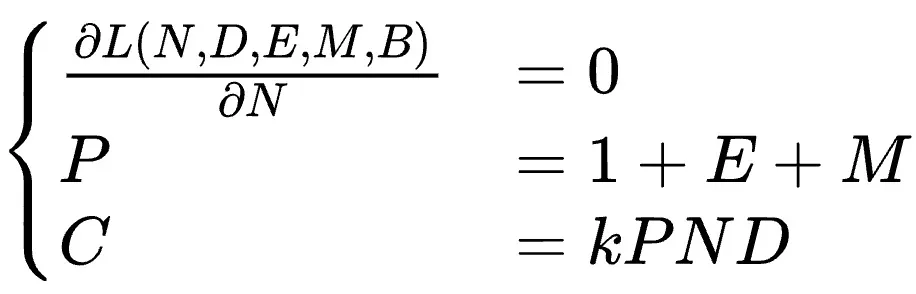

在綜合了所有浮點數量化訓練中影響模型效果的因素(如參數量 N,數據量 D,指數位 E,尾數位 M 和量化粒度 B)后,混元團隊最終得出了浮點數量化訓練的 Scaling Law:

前三項基于經典的 Chinchilla Scaling Law 的形式,第四項可以看做浮點數量化對于模型的額外損失。有意思的是, 可以被看作某種形式的 “知識密度”,而 E, M 和 B 的聯合項可以被看作某種形式的精度表示。直觀地分析,大模型過低精度下無法承載過高的知識密度,導致了額外損失。另外值得注意的是,我們 Scaling Law 中 N 和 D 的指數參數 α 和 β,在第一項 / 第二項 / 第四項都是完全相同的,形式更加統一。

可以被看作某種形式的 “知識密度”,而 E, M 和 B 的聯合項可以被看作某種形式的精度表示。直觀地分析,大模型過低精度下無法承載過高的知識密度,導致了額外損失。另外值得注意的是,我們 Scaling Law 中 N 和 D 的指數參數 α 和 β,在第一項 / 第二項 / 第四項都是完全相同的,形式更加統一。

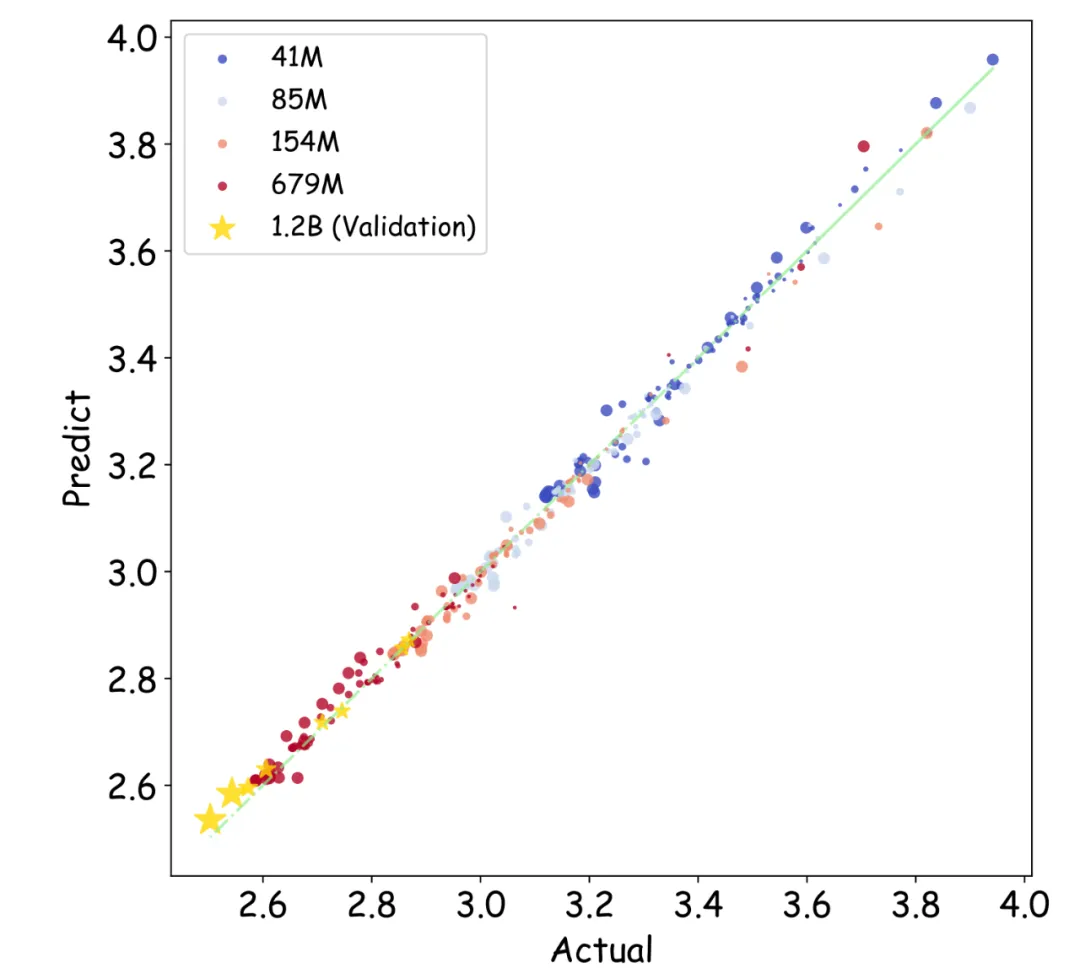

為了判斷最終統一形式的泛化能力,騰訊混元團隊在小模型(41M - 679M)上擬合估算出 n, d, α, β, γ, δ, ν 以及 ? 等參數的取值后:

在更大的模型(1.2B)上也驗證了不同量化配置下的預測效果。

無法跨越的效果屏障

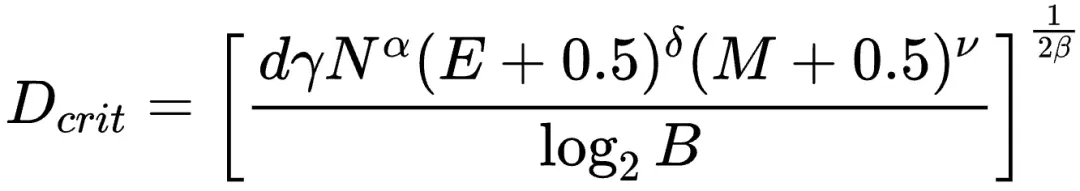

在上面 Scaling Law 公式里,第二項和第四項關于數據量(D)的部分構成一個有最值的函數,即存在一個關于 D 的 loss 最低點,這個最值點在:

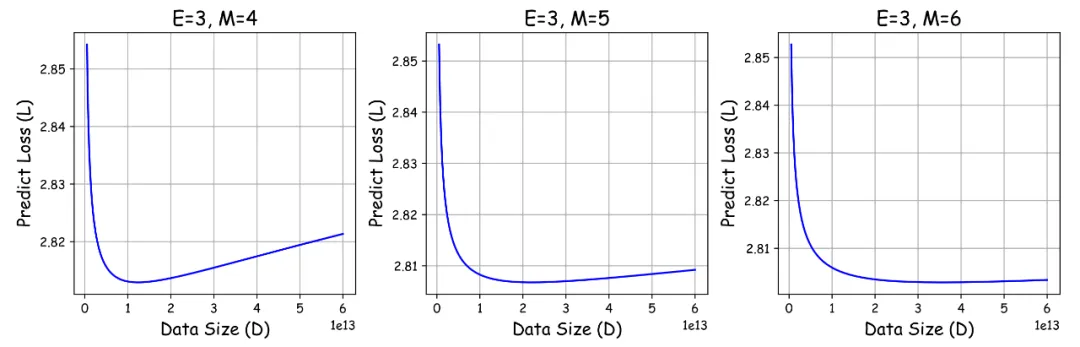

注意此時這里并沒有給 Scaling Law 添加任何限制條件,這意味著當訓練某個模型時,每個精度都存在一個對應的極限效果,無論使用多少數據都無法超越。并且當使用的數據量超過 Dcrit 時,繼續增加數據反而對模型效果是有害的。

從公式中,我們發現,模型越小,精度越低,那么這個極限數據量就會越早到來,增加數據導致模型效果變差越明顯。因此,越小的模型越需要越大的精度才能保證給定數據的有效訓練。

這一隨著訓練進行損失不降反升的現象,也得到了混元團隊的真實訓練結果支持。但是,經過計算當采用 BF16 訓練 1B 參數量模型時,會發現這一極限數據量高達 1730T,這可能也是之前沒有人發現這一現象的原因。然而,隨著精度降低,比如采用 FP8-E4M3 時這一數值降低至 27T,而使用 FP4-E2M1 時則只有 0.4T。

限定資源下的最優解

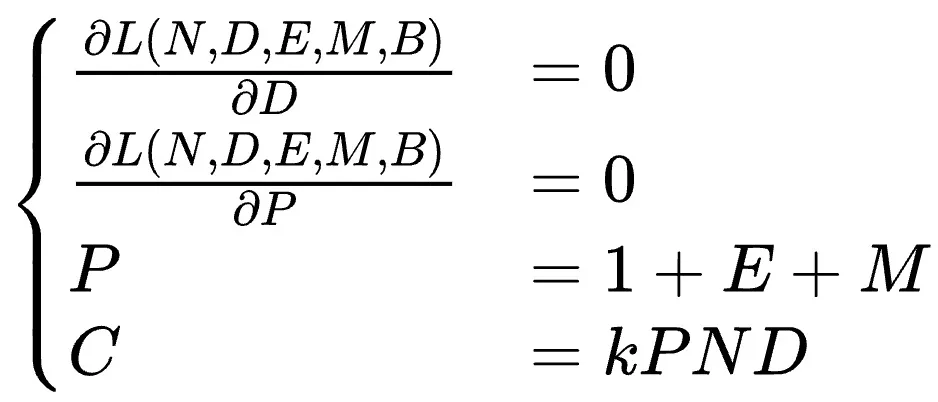

于是可以得知,即使在無限資源下,由于效果屏障存在的原因,訓練模型時使用的數據量也不應該超過 Dcrit。那么在限定資源下,通過求解方程組:

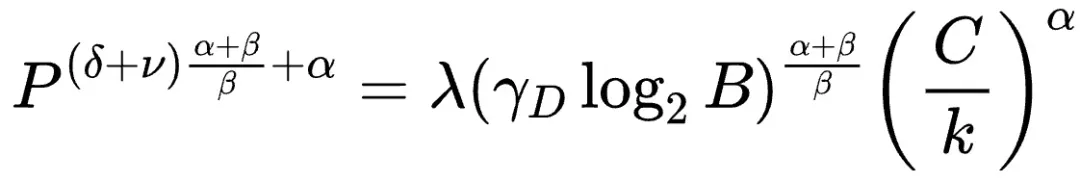

可以得出一個符合經典冪律關系(Power-law)的最佳性價比精度配方:

根據實驗結果推算,在一個非常大的算力范圍內,理論預測的最佳性價比落在 4-8 比特之間。

精度與參數量的匯率

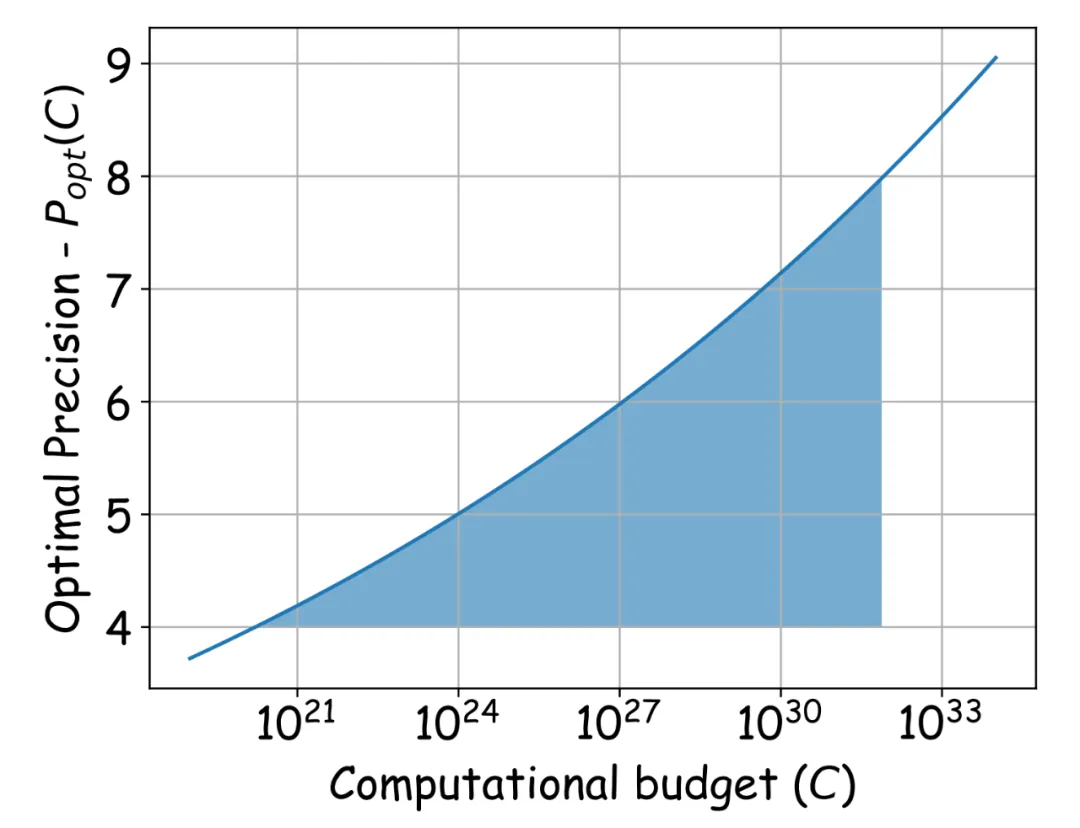

在資源受限的情況下,盡管我們已知在最佳性價比時精度應如何選取,然而參數量 N 與數據量 D 究竟該如何搭配這一問題依舊尚未得到解決。通過對方程組:

進行求解能夠發現,在限定資源的情況下,若要保持性價比,精度 P 和參數量 N 之間存在著一個類似于 “匯率” 的關系:

所以,在實際工作當中,可以借助 “精度 —— 參數量的匯率”,并且結合,進一步明確在最佳性價比下的精度 P、參數量 N 以及數據量 D 的配置策略。

這項研究為大模型訓練中的浮點數量化提供了重要的理論指導。其價值不僅在于明確了在給定資源和精度下的最優參數配置策略,幫助提高訓練效率和降低成本,而且對于推動大模型在實際應用中的更廣泛部署具有關鍵意義。通過揭示浮點數量化訓練的極限和規律,為硬件制造商優化浮點運算能力提供了依據,也為研究人員在大模型的優化和創新方面開辟了新的思路和方向。